Fabric Runtime 1.3 (GA)

El entorno de ejecución de Fabric ofrece una integración completa con Azure. Proporciona un entorno sofisticado para proyectos de ingeniería de datos y ciencia de datos que usan Apache Spark. En este artículo se proporciona información general sobre las características y componentes esenciales Fabric Runtime 1.3, el entorno de ejecución más reciente para los cálculos de macrodatos.

Microsoft Fabric Runtime 1.3 es la versión más reciente del entorno de ejecución de disponibilidad general e incorpora los siguientes componentes y actualizaciones diseñados para mejorar las funcionalidades de procesamiento de datos:

- Apache Spark 3.5

- Sistema operativo: Mariner 2.0

- Java: 11

- Scala: 2.12.17

- Python: 3.11

- Delta Lake: 3.2

- R: 4.4.1

Sugerencia

Fabric Runtime 1.3 incluye compatibilidad con el motor de ejecución nativo, que puede mejorar significativamente el rendimiento sin costes adicionales. Para habilitar el motor de ejecución nativo en todos los trabajos y cuadernos del entorno, vaya a la configuración del entorno, seleccione Proceso de Spark, vaya a la pestaña Aceleración y active Habilitar motor de ejecución nativo. Después de guardar y publicar, esta configuración se aplica en todo el entorno, por lo que todos los nuevos trabajos y cuadernos heredan automáticamente las capacidades de rendimiento mejoradas y se benefician de ellas.

Sigue estas instrucciones para integrar tiempo de ejecución 1.3 en el área de trabajo y usa sus nuevas características:

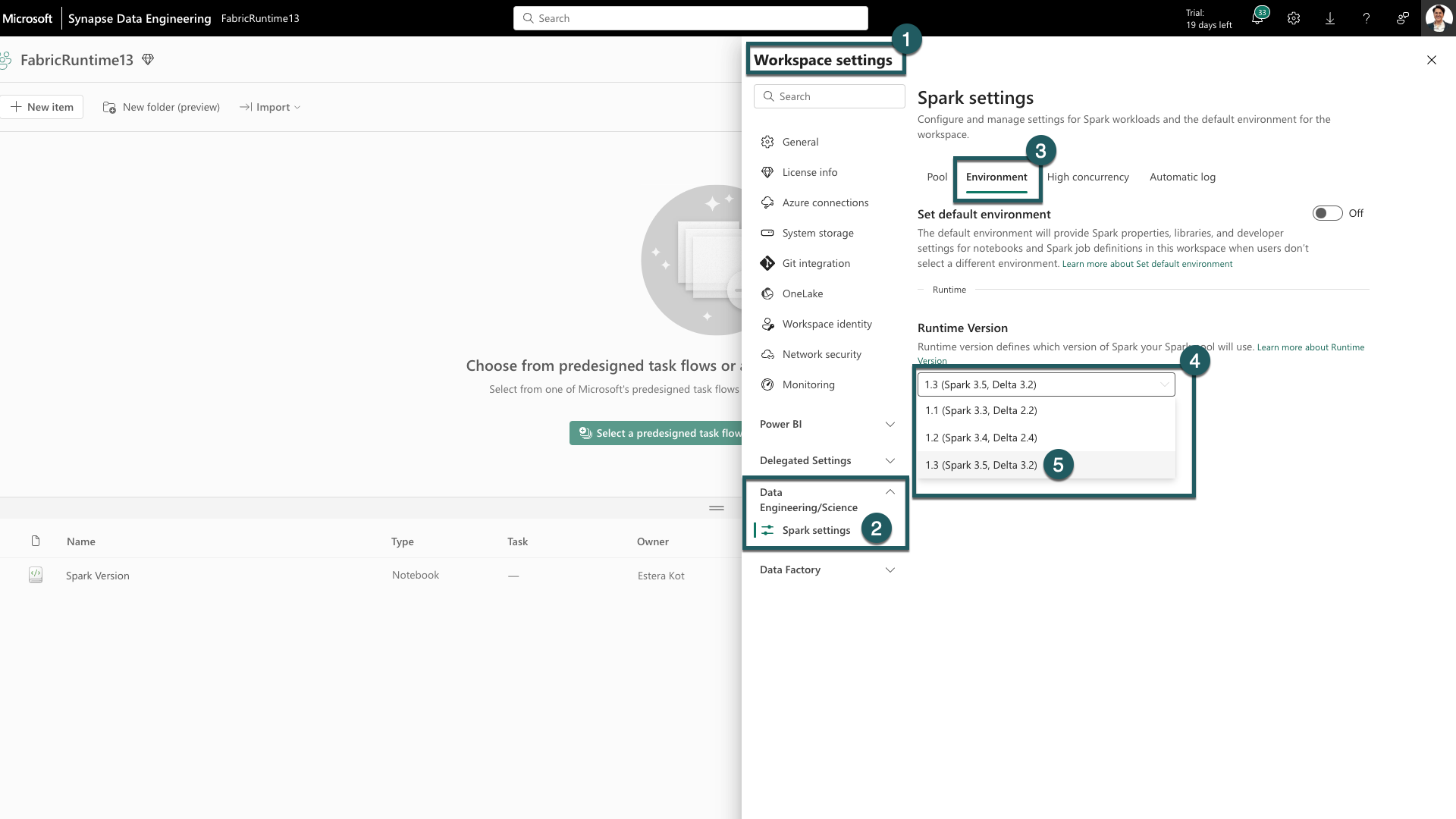

- Ve a la pestaña Configuración del área de trabajo dentro de tu espacio de trabajo de Fabric.

- Ve a la pestaña Ingeniería de datos/ciencia y selecciona Configuración de Spark.

- Seleccione la pestaña Entorno.

- En Versiones de runtime expanda la lista desplegable.

- Seleccione 1.3 (Spark 3.5, Delta 3.2) y guarde los cambios. Esta acción establece la versión 1.3 como tiempo de ejecución predeterminado para el área de trabajo.

Ya puede empezar a trabajar con las nuevas mejoras y funcionalidades introducidas en el runtime de Fabric 1.3 (Spark 3.5 y Delta Lake 3.2).

Aspectos destacados

Apache Spark 3.5

Apache Spark 3.5.0 es la sexta versión de la serie 3.x. Esta versión es un producto de una amplia colaboración dentro de la comunidad de código abierto, que aborda más de 1300 problemas, tal como se registra en Jira.

En esta versión, hay una actualización en compatibilidad para el flujo estructurado. Además, esta versión amplía la funcionalidad en PySpark y SQL. Agrega características como la cláusula de identificador SQL, los argumentos con nombre en las llamadas a funciones SQL y la inclusión de funciones SQL para agregaciones aproximadas de HyperLogLog. Otras nuevas funcionalidades también incluyen funciones de tabla definidas por el usuario de Python, la simplificación del entrenamiento distribuido a través de DeepSpeed y nuevas funcionalidades de flujo estructurado, como la propagación de marcas de agua y la operación dropDuplicatesWithinWatermark.

Puedes consultar la lista completa y los cambios detallados aquí: https://spark.apache.org/releases/spark-release-3-5-0.html.

Delta Spark

Delta Lake 3.2 marca un compromiso colectivo de hacer que Delta Lake sea interoperable entre formatos, más fácil de trabajar con y más rendimiento. Delta Spark 3.2 se basa en Apache Spark™ 3.5. Se ha cambiado el nombre del artefacto maven de Delta Spark de delta-core a delta-spark.

Puedes consultar la lista completa y los cambios detallados aquí: https://docs.delta.io/3.2.0/index.html.

Sugerencia

Para obtener información actualizada, una lista detallada de cambios y notas de la versión específicas de los entornos de ejecución de Fabric, comprueba y suscríbete a Versiones y actualizaciones de Spark Runtimes.

Contenido relacionado

- Lea sobreApache Spark Runtimes en Fabric: información general, control de versiones, soporte de múltiples runtimes y Actualización del protocolo Delta Lake

- Guía de migración de Spark Core

- Guías de migración de SQL, DataSets y DataFrame

- Guía de migración de Structured Streaming

- Guía de migración de MLlib (Machine Learning)

- Guía de migración de PySpark (Python en Spark)

- Guía de migración de SparkR (R en Spark)