Opciones para obtener datos en el almacén de lago de Fabric

La experiencia de obtención de datos cubre todos los escenarios del usuario para incorporar datos al lago de datos, como:

- Conectar a un SQL Server existente y copiar datos en la tabla delta del lago de datos.

- Cargando archivos desde el equipo.

- Copiar y combinar varias tablas de otros lagos de datos en una nueva tabla delta.

- Conexión a un origen de streaming para aterrizar datos en un almacén de lago.

- Hacer referencia a datos sin copiarlos desde otros almacenes de lago internos u orígenes externos.

Diferentes formas de cargar datos en un lago de datos

En Microsoft Fabric, hay varias maneras de meter datos en un almacén de lago:

- Cargar archivos desde el equipo local

- Ejecutar una herramienta de copia en las canalizaciones

- Configurar un flujo de datos

- Bibliotecas de Apache Spark en el código del cuaderno

- Transmisión de eventos en tiempo real con Eventstream

- Obtención de datos de Eventhouse

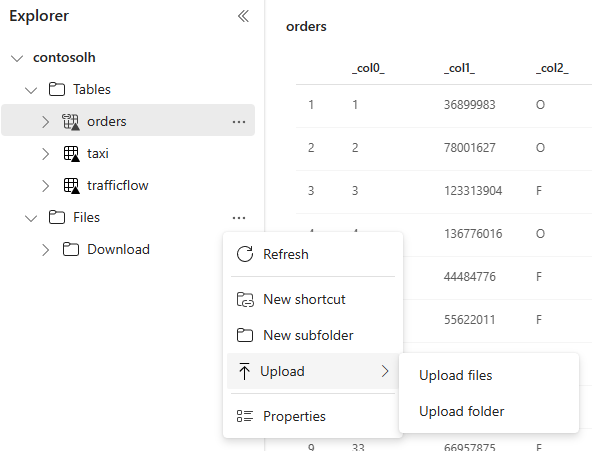

Carga de archivos local

También puede cargar datos almacenados en el equipo local. Puede hacerlo directamente en el explorador del lago de datos.

Herramienta Copiar en canalizaciones

La herramienta Copiar es una solución de Integración de datos altamente escalable que le permite conectarse a diferentes orígenes de datos y cargar los datos en formato original o convertirlos en una tabla delta. La herramienta de copia es una parte de las actividades de canalización que se pueden orquestar de varias maneras, como la programación o el desencadenamiento en función del evento. Para obtener más información, consulte Cómo copiar datos mediante la actividad de copia.

Flujos de datos

Para los usuarios que están familiarizados con los flujos de datos de Power BI, la misma herramienta está disponible para cargar datos en el lago de datos. Es posible acceder de forma rápida desde la opción "Obtener datos" del explorador del lago de datos y obtener datos de más de 200 conectores. Para obtener más información, consulte Inicio rápido: Creación del primer flujo de datos para obtener y transformar datos.

Código del cuaderno

Puede usar las bibliotecas de Spark disponibles para conectarse directamente a un origen de datos, cargar datos en un marco de datos y, a continuación, guardarlos en un lago de datos. Este método es la forma más abierta de cargar datos en un lago de datos que el código de usuario administra por completo.

Nota:

Las tablas Delta externas creadas con el código de Spark no serán visibles para un punto de conexión de SQL Analytics. Use accesos directos en el espacio Tabla para hacer que las tablas Delta externas sean visibles para un punto de conexión de SQL Analytics. Para obtener información sobre cómo crear un acceso directo, consulte Crear un acceso directo a archivos o tablas.

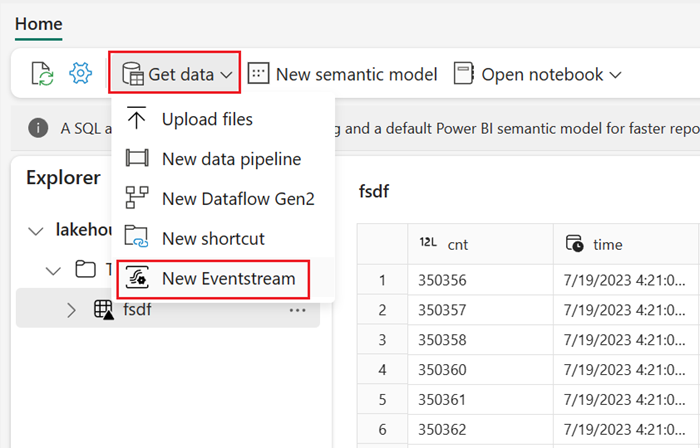

Transmisión de eventos en tiempo real con Eventstream

Con Eventstream, puede obtener, procesar y redirigir eventos en tiempo real de gran volumen desde una amplia variedad de orígenes.

Para ver cómo agregar un almacén de lago de datos como destino para Eventstream, vea Obtención de datos de Eventstream en un almacén de lago de datos.

Para obtener un rendimiento óptimo de streaming, puede transmitir datos de Eventstream a un centro de eventos y, después, habilitar la disponibilidad de OneLake.

Obtención de datos de Eventhouse

Al habilitar la disponibilidad de OneLake en los datos de un centro de eventos, se crea una tabla Delta en OneLake. Un almacén de lago de datos puede acceder a esta tabla Delta mediante un acceso directo. Para más información, consulte Accesos directos de OneLake. Para más información, vea Disponibilidad de OneLake en Eventhouse.

Consideraciones al elegir el enfoque para cargar datos

| Caso de uso | Recomendación |

|---|---|

| Carga de archivos pequeña desde la máquina local | Uso de la carga de archivos local |

| Datos pequeños o conectores específicos | Uso de flujos de datos |

| Origen de datos grande | Uso de la herramienta Copiar en canalizaciones |

| Transformaciones de datos complejas | Uso de código del cuaderno |

| Streaming de datos | Uso de Eventstream para transmitir datos a Eventhouse; habilitar la disponibilidad de OneLake y crear un acceso directo desde un almacén de lago de datos |

| Datos de serie temporal | Obtención de datos de Eventhouse |

Contenido relacionado

- Explorar los datos de lago de datos con un cuaderno

- Inicio rápido: Cree su primera canalización para copiar datos

- Cómo copiar datos mediante la actividad de copia

- Traslado de datos de la base de datos de Azure SQL al almacén de lago mediante el asistente de copia

- Adición de un destino de almacén de lago de datos a una secuencia de eventos

- Disponibilidad de Eventhouse OneLake