Obtenga datos de streaming en el almacén de lago y acceda con el punto de conexión de análisis SQL

En este inicio rápido se explica cómo crear una definición de trabajo de Spark que contenga código de Python con Flujo estructurado de Spark para colocar datos en un almacén de lago y, a continuación, servirlos a través de un punto de conexión de SQL. Después de completar este inicio rápido, tendrá una definición de trabajo de Spark que se ejecuta continuamente y el punto de conexión de análisis SQL puede ver los datos entrantes.

Creación de un script de Python

Use el siguiente código de Python que usa el streaming estructurado de Spark para obtener datos en una tabla de Lakehouse.

import sys from pyspark.sql import SparkSession if __name__ == "__main__": spark = SparkSession.builder.appName("MyApp").getOrCreate() tableName = "streamingtable" deltaTablePath = "Tables/" + tableName df = spark.readStream.format("rate").option("rowsPerSecond", 1).load() query = df.writeStream.outputMode("append").format("delta").option("path", deltaTablePath).option("checkpointLocation", deltaTablePath + "/checkpoint").start() query.awaitTermination()Guarde el script como archivo de Python (.py) en el equipo local.

Creación de un almacén de lago

Use los siguientes pasos para crear un cliente:

Inicie sesión en el Portal de Microsoft Fabric.

Cambie a la experiencia Ingeniería de datos.

Vaya al área de trabajo deseada o cree una nueva si es necesario.

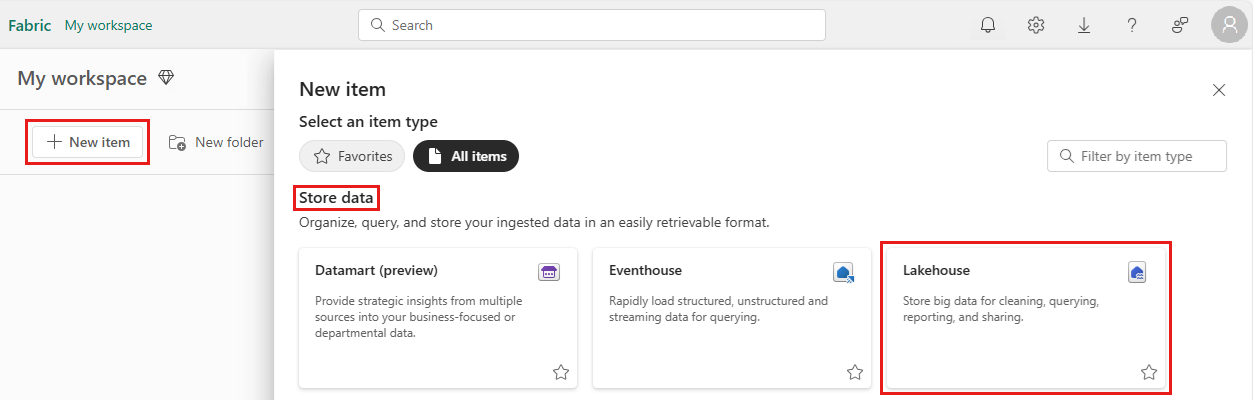

Para crear un almacén de lago de datos, seleccione Nuevo elemento en el área de trabajo y elija Almacén de lago de datos.

Escriba el nombre de su instancia de Lakehouse y seleccione Crear.

Creación de una definición de trabajo de Spark

Siga estos pasos para crear una definición de trabajo de Spark:

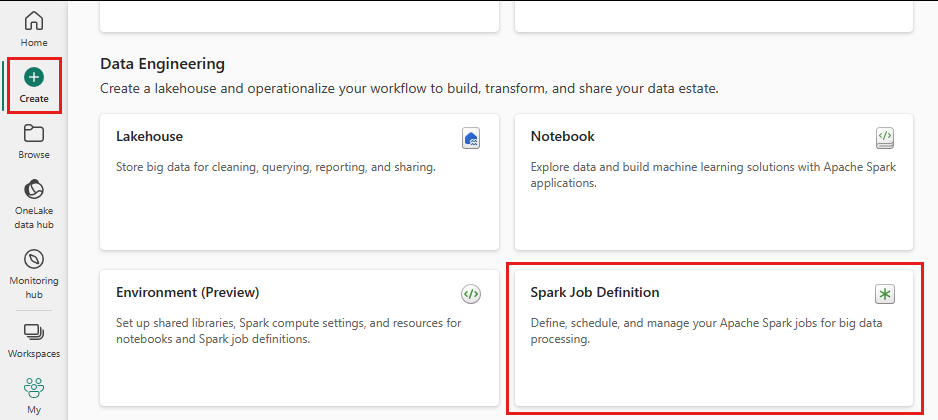

En la misma área de trabajo en la que creó una instancia de LakeHouse, seleccione el icono Crear en el menú de la izquierda.

En "Ingeniería de datos", seleccione Definición de trabajo de Spark.

Escriba el nombre de la definición del trabajo de Spark y seleccione Crear.

Seleccione Cargar y seleccione el archivo Python que creó en el paso anterior.

En Referencia de Lakehouse , elija la instancia de Lakehouse que ha creado.

Establecer política de reintentos para la definición de trabajos Spark

Siga estos pasos para establecer la directiva de reintento para la definición del trabajo de Spark:

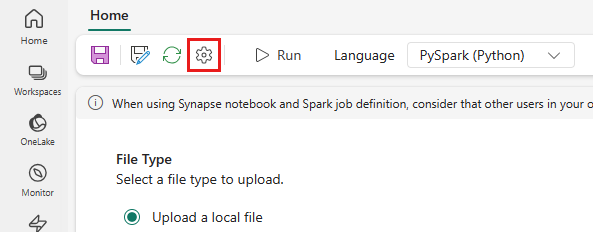

En el menú superior, seleccione el icono Configuración .

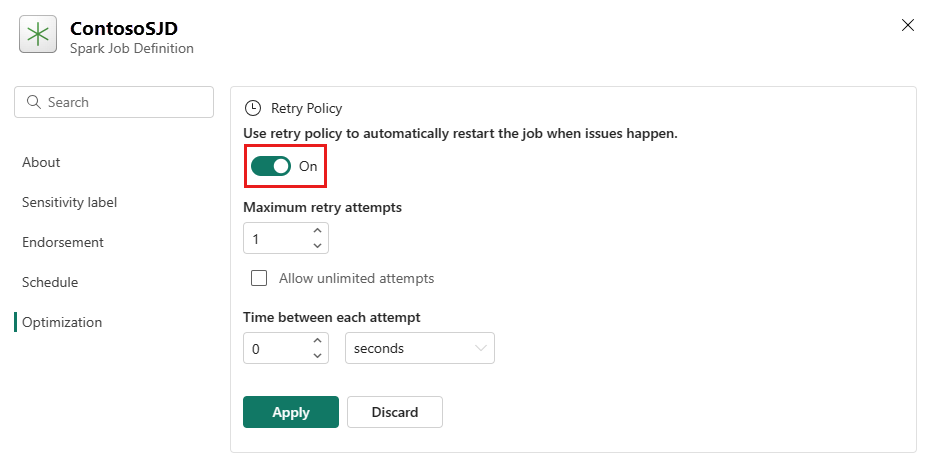

Abra la pestaña Optimización y establezca el desencadenador de la política de reintentos en Activado.

Defina el número máximo de reintentos o active Permitir intentos ilimitados.

Especifique el tiempo entre cada intento de reintento y seleccione Aplicar.

Nota:

Hay un límite de duración de 90 días para la configuración de la directiva de reintento. Una vez habilitada la directiva de reintento, el trabajo se reiniciará según la directiva en un plazo de 90 días. Después de este período, la directiva de reintento dejará de funcionar automáticamente y el trabajo se finalizará. A continuación, los usuarios deberán reiniciar manualmente el trabajo, lo que, a su vez, volverá a habilitar la directiva de reintento.

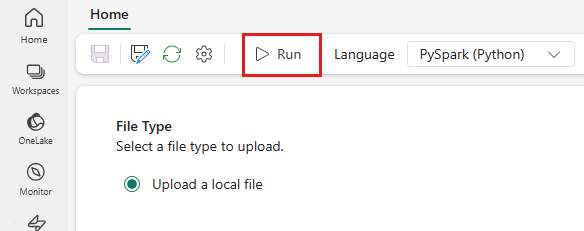

Ejecutar y supervisar la definición de trabajo de Spark

En el menú superior, seleccione el icono Ejecutar.

Compruebe si la definición del trabajo de Spark se envió correctamente y se ejecutó.

Visualización de datos mediante un punto de conexión de análisis SQL

En la vista del área de trabajo, seleccione su instancia de Lakehouse.

En la esquina derecha, seleccione Lakehouse y seleccione punto de conexión de análisis SQL.

En la vista punto de conexión de análisis SQL, en Tablas, seleccione la tabla que el script usa para colocar datos. A continuación, puede obtener una vista previa de los datos desde el punto de conexión de análisis SQL.