Trabajos o ejecutores con errores quitados

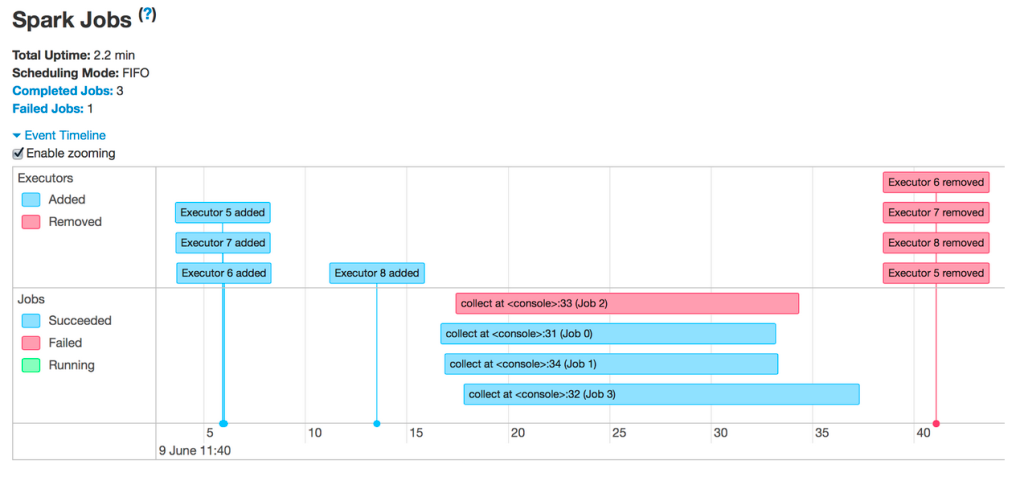

Por lo tanto, verá trabajos con errores o ejecutores quitados:

Las razones más comunes para quitar ejecutores son:

- Escalado automático: en este caso se espera y no se produce un error. Consulte Habilitar el escalado automático.

- Pérdidas de instancias de acceso puntual: el proveedor de nube está reclamando las máquinas virtuales. Puede obtener más información sobre las instancias de acceso puntual aquí.

- Ejecutores que se están quedando sin memoria

Trabajos con errores

Si ves algún trabajo con errores, haz clic en ellos para acceder a sus páginas. A continuación, desplácese hacia abajo para ver la fase con errores y un motivo de error:

Puede obtener un error genérico. Haga clic en el vínculo de la descripción para ver si puede obtener más información:

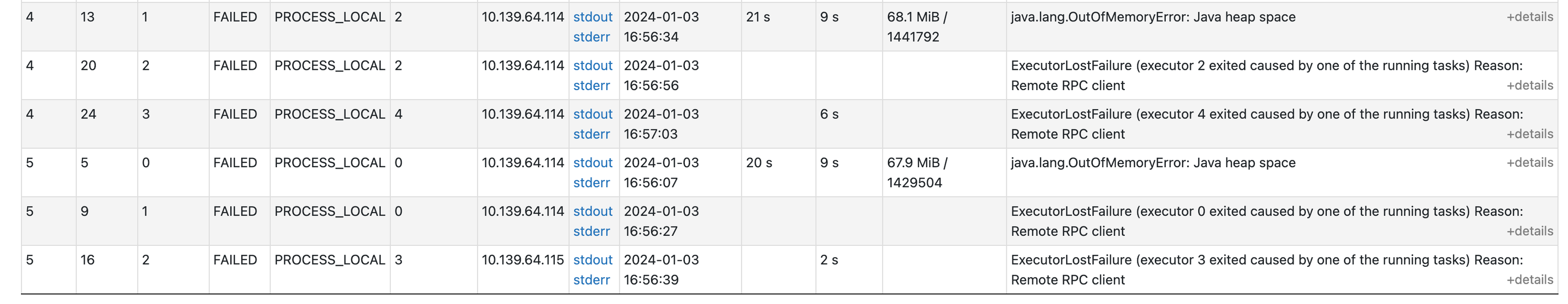

Si se desplaza hacia abajo en esta página, podrá ver por qué se produjo un error en cada tarea. En este caso, queda claro que hay un problema de memoria:

Ejecutores con errores

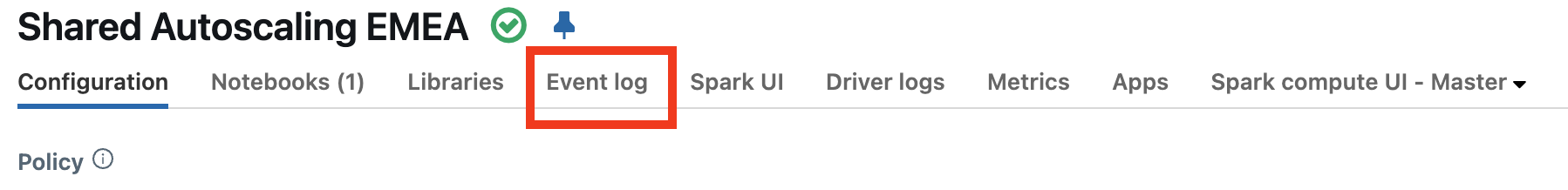

Para averiguar por qué se producen errores en los ejecutores, primero querrá comprobar el registro de eventos del proceso para ver si hay alguna explicación de por qué se produjo un error en los ejecutores. Por ejemplo, es posible que use instancias de acceso puntual y el proveedor de nube los devuelva.

Vea si hay algún evento que explique la pérdida de ejecutores. Por ejemplo, puede ver mensajes que indican que se está perdiendo el tamaño del clúster o que se pierden instancias de acceso puntual.

- Si usa instancias de acceso puntual, consulte Pérdida de instancias de acceso puntual.

- Si el proceso se redimensionó con escalado automático, es lo esperado y no un error. Consulte Más información sobre el cambio de tamaño del clúster.

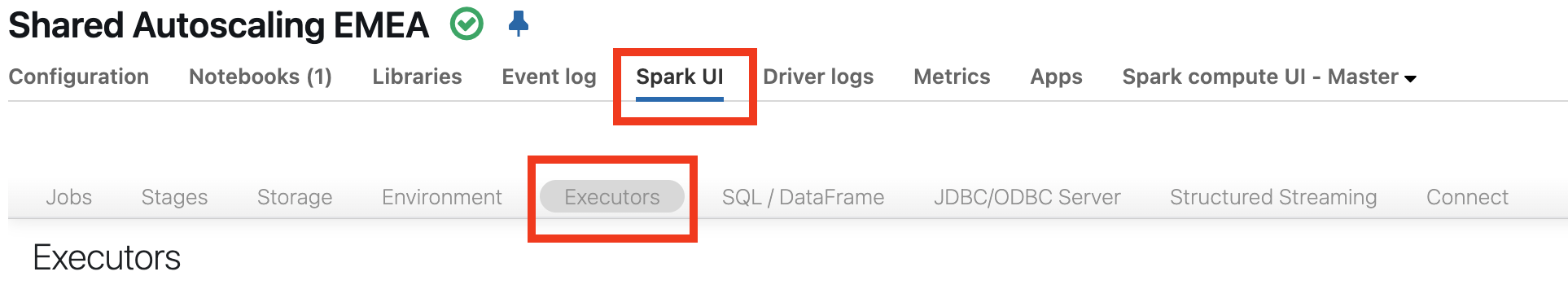

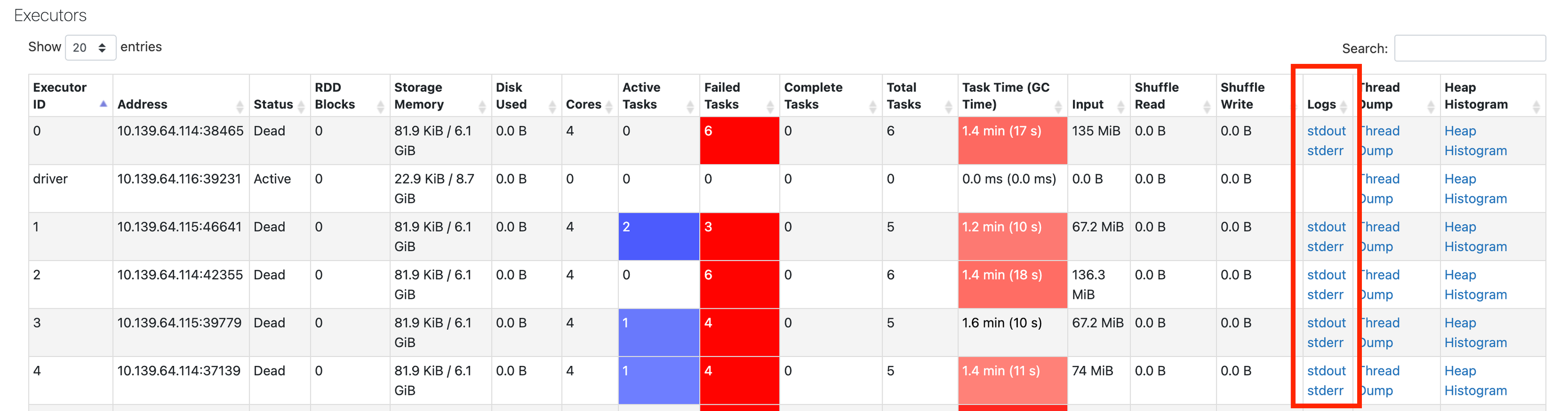

Si no ve información en el registro de eventos, vuelva a la interfaz de usuario de Spark y haga clic en la pestaña Ejecutores:

Aquí puede obtener los registros de los ejecutores con errores:

Paso siguiente

Si ha llegado hasta aquí, la explicación más probable es un problema de memoria. El siguiente paso es profundizar en los problemas de memoria. Consulte Problemas de memoria de Spark.