Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Nota:

La versión de código abierto de Hyperopt ya no se mantiene.

Hyperopt se quitará en la siguiente versión principal de DBR ML. Azure Databricks recomienda usar Optuna para la optimización de un solo nodo o rayTune para una experiencia similar a la funcionalidad de optimización de hiperparámetros distribuidos de Hyperopt en desuso. Obtén más información sobre el uso de RayTune en Azure Databricks.

En este cuaderno se muestra cómo usar Hyperopt para paralelizar los cálculos de ajuste de hiperparámetros. Se usa la clase SparkTrials para distribuir automáticamente los cálculos entre los trabajadores del clúster. También se muestra el seguimiento automatizado de MLflow para las ejecuciones de Hyperopt, de modo que pueda guardar los resultados para más adelante.

Paralelización del ajuste de hiperparámetros con el cuaderno de seguimiento de MLflow automatizado

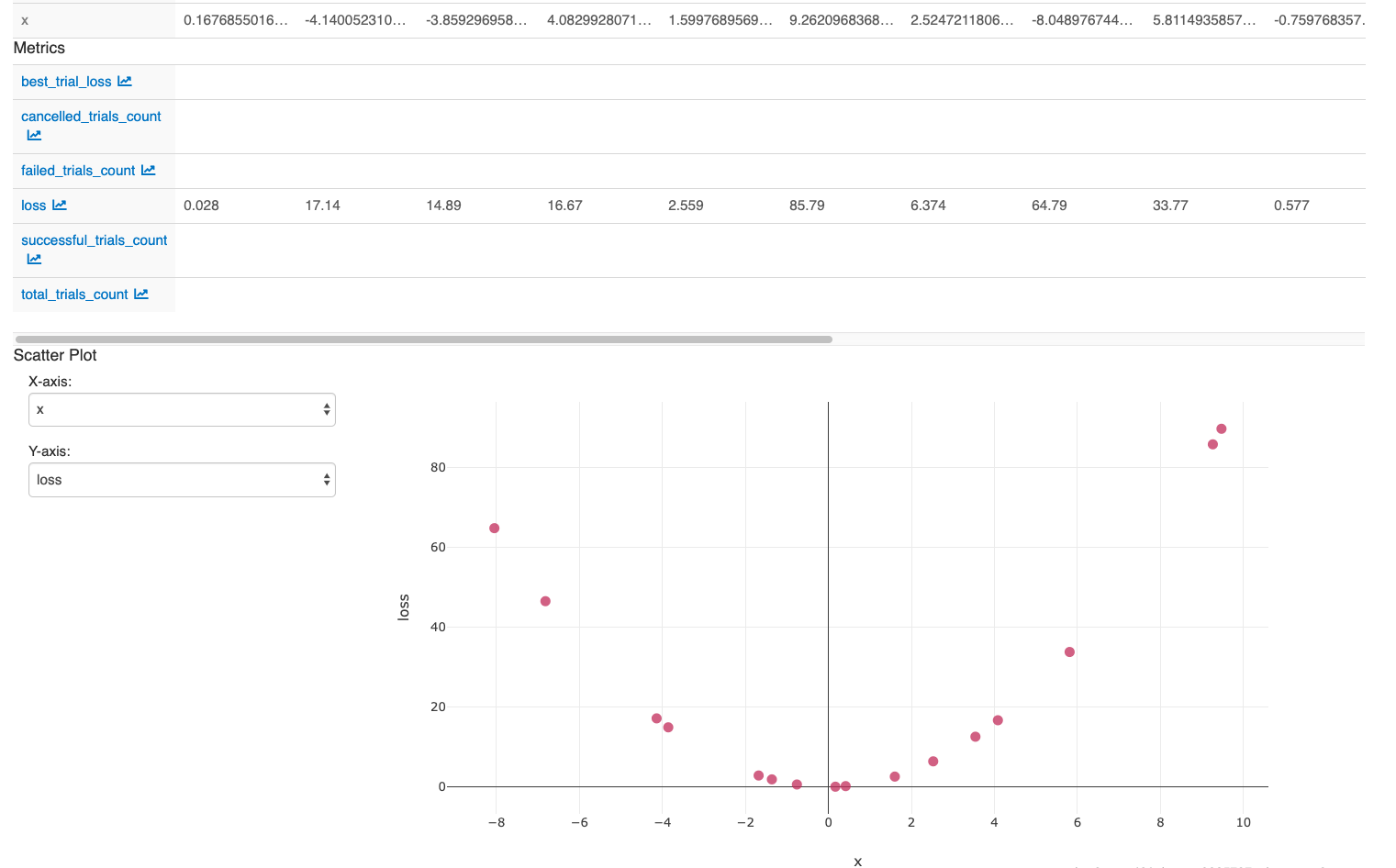

Después de llevar a cabo las acciones en la última celda del cuaderno, la interfaz de usuario de MLflow debe mostrar esto: