Ámbito de la plataforma del lago de datos

Un marco de plataforma de inteligencia artificial y datos modernos

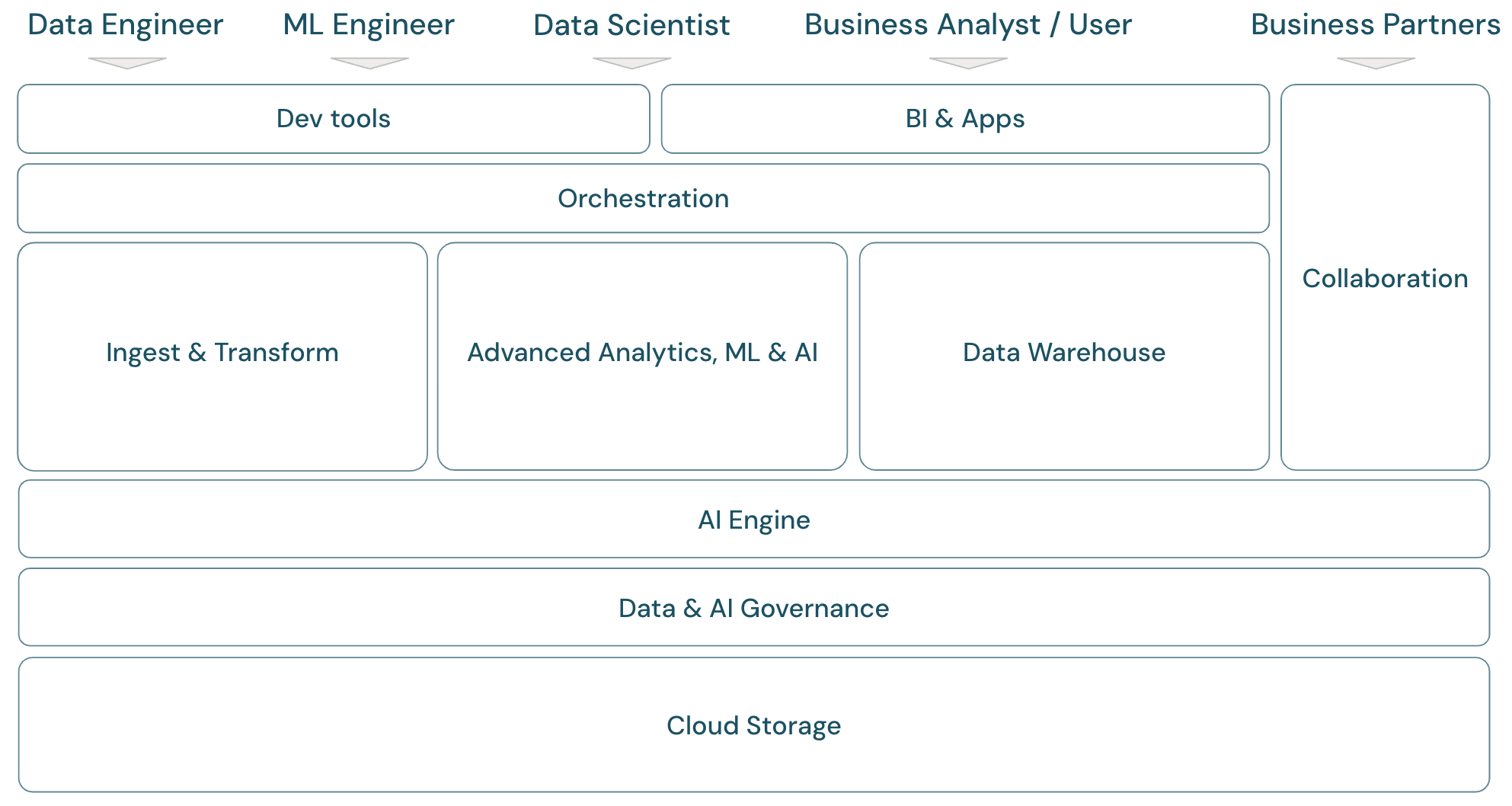

Para analizar el ámbito de la plataforma de inteligencia de datos de Databricks, es útil definir primero un marco básico para la plataforma moderna de datos e inteligencia artificial:

Información general sobre el ámbito del lago de datos

Databricks Data Intelligence Platform cubre el marco de plataforma de datos moderno completo. Se basa en la arquitectura de lago de datos y se basa en un motor de inteligencia de datos que comprende las cualidades únicas de los datos. Es una base abierta y unificada para las cargas de trabajo ETL, ML/AI y DWH/BI, y tiene Unity Catalog como solución central de gobernanza de datos e inteligencia artificial.

Roles del marco de plataforma

En el marco se tratan los miembros del equipo de datos principales (personas) que trabajan con las aplicaciones del marco:

- Los ingenieros de datos proporcionan a los científicos de datos y analistas de negocios datos precisos y reproducibles para la toma de decisiones oportuna y la información en tiempo real. Implementan procesos ETL altamente coherentes y confiables para aumentar la confianza del usuario y la confianza en los datos. Garantizan que los datos están bien integrados con los distintos pilares de la empresa y suelen seguir los procedimientos recomendados de ingeniería de software.

- Los científicos de datos combinan conocimientos analíticos y conocimientos empresariales para transformar los datos en información estratégica y modelos predictivos. Son expertos en traducir desafíos empresariales en soluciones controladas por datos, ya sea a través de conclusiones analíticas retrospectivas o modelado predictivo de futuro. Aprovechando las técnicas de modelado de datos y aprendizaje automático, diseñan, desarrollan e implementan modelos que desvelan patrones, tendencias y previsiones de datos. Actúan como puente, convirtiendo narrativas de datos complejas en historias comprensibles, lo que garantiza que las partes interesadas de la empresa no solo comprendan, sino que también puedan actuar basándose en las recomendaciones controladas por datos, a su vez impulsando un enfoque centrado en los datos para resolver problemas dentro de una organización.

- Los ingenieros de ML (ingenieros de aprendizaje automático) dirigen la aplicación práctica de la ciencia de datos en productos y soluciones mediante la creación, implementación y mantenimiento de modelos de aprendizaje automático. Su principal enfoque se centra en el aspecto de ingeniería del desarrollo y la implementación de modelos. Los ingenieros de ML garantizan la solidez, la confiabilidad y la escalabilidad de los sistemas de aprendizaje automático en entornos activos, abordando los desafíos relacionados con la calidad de los datos, la infraestructura y el rendimiento. Al integrar modelos de inteligencia artificial y aprendizaje automático en procesos empresariales operativos y productos orientados al usuario, facilitan el uso de la ciencia de datos en la resolución de desafíos empresariales, lo que garantiza que los modelos no solo sigan investigándose, sino que impulsan el valor empresarial tangible.

- analistas de negocios y usuarios empresariales: los analistas de negocios proporcionan a las partes interesadas y a los equipos empresariales datos accionables. A menudo interpretan los datos y crean informes u otra documentación para la administración mediante herramientas de BI estándar. Normalmente son el primer punto de contacto para los usuarios empresariales y compañeros de operaciones no técnicos para preguntas de análisis rápidos. Los paneles y aplicaciones empresariales entregados en la plataforma de Databricks pueden ser utilizados directamente por los usuarios empresariales.

- Los socios comerciales son una parte interesada importante en un mundo empresarial cada vez más interconectado. Se definen como una empresa o personas con la que una empresa tiene una relación formal para lograr un objetivo común y pueden incluir proveedores, vendedores, distribuidores y otros asociados de terceros. El uso compartido de datos es un aspecto importante de las asociaciones empresariales, ya que permite la transferencia y el intercambio de datos para mejorar la colaboración y la toma de decisiones controladas por datos.

Dominios del marco de plataforma

La plataforma consta de varios dominios:

Storage: En la nube, los datos se almacenan principalmente en almacenamiento de objetos escalable, eficaz y resistente en la nube providers.

Gobernanza: funcionalidades relacionadas con la gobernanza de datos, por ejemplo, control de acceso, auditoría, administración de metadatos, seguimiento de linaje y supervisión de todos los recursos de datos e IA.

Motor de IA: el motor de IA proporciona funcionalidades de IA generativa para toda la plataforma.

Ingesta y transformación: las funcionalidades de las cargas de trabajo de ETL.

Análisis avanzado, ML e IA:: todas las funcionalidades relacionadas con el aprendizaje automático, la IA, la IA generativa y también el análisis de streaming.

Almacenamiento de datos: El dominio que admite casos de uso de DWH y BI.

Automation: administración de flujos de trabajo para el procesamiento de datos, el aprendizaje automático, las canalizaciones de análisis, incluida la compatibilidad con CI/CD y MLOps.

Herramientas de ETL & DS: las herramientas de front-end que los ingenieros de datos, los científicos de datos y los ingenieros de ML usan principalmente para el trabajo.

Herramientas de BI: las herramientas de front-end que los analistas de BI usan principalmente para el trabajo.

Colaboración: funcionalidades para compartir datos entre dos o más partes.

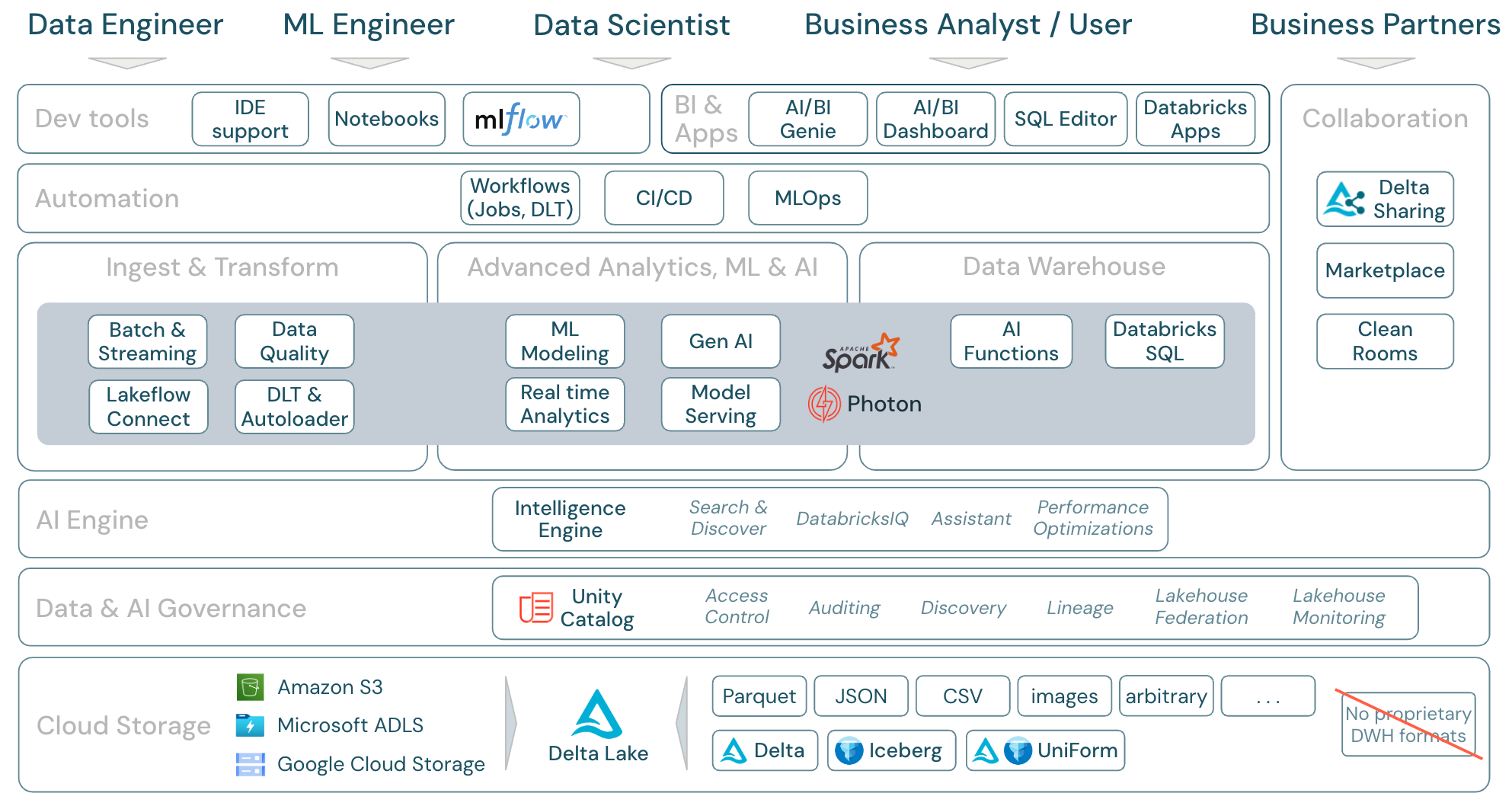

Ámbito de la plataforma de Databricks

Databricks Data Intelligence Platform y sus componentes se pueden asignar al marco de trabajo de la siguiente manera:

Descarga: Ámbito de los componentes del lago de datos: Databricks

Cargas de trabajo de datos en Azure Databricks

Lo más importante es que Databricks Data Intelligence Platform cubre todas las cargas de trabajo pertinentes para el dominio de datos en una plataforma, con Apache Spark/Photon como motor:

Ingesta y transformación

Databricks ofrece varias formas de ingesta de datos:

- Databricks LakeFlow Connect ofrece conectores integrados para la ingesta de aplicaciones y bases de datos empresariales. La canalización de ingesta resultante se rige por Unity Catalog y cuenta con tecnología de proceso sin servidor y Delta Live Tables.

- Auto Loader procesa automáticamente e incrementalmente los archivos que llegan al almacenamiento en la nube en trabajos programados o continuos, sin necesidad de administrar la información de estado. Una vez ingeridos, es necesario transformar los datos sin procesar para que estén listos para BI y ML/AI. Databricks proporciona eficaces funcionalidades ETL para ingenieros de datos, científicos de datos y analistas.

Delta Live Tables (DLT) permite escribir trabajos ETL de forma declarativa, lo que simplifica todo el proceso de implementación. La calidad de los datos se puede mejorar definiendo las expectativas de los datos.

Análisis avanzado, ML e IA

La plataforma incluye Databricks Mosaic AI, un set de herramientas de aprendizaje automático e inteligencia artificial totalmente integradas para aprendizaje automático clásico y aprendizaje profundo, así como inteligencia artificial generativa y modelos de lenguaje de gran escala (LLM). Abarca todo el flujo de trabajo, desde la preparación de datos a la creación de modelos de aprendizaje automático y aprendizaje profundo, y al servicio de modelos de Mosaic AI.

Spark Structured Streaming y DLT permiten el análisis en tiempo real.

Almacenamiento de datos

Databricks Data Intelligence Platform también tiene una solución de almacenamiento de datos completa con Databricks SQL, que se rige centralmente por Unity Catalog con control de acceso específico.

las funciones de inteligencia artificial son funciones SQL integradas que permiten aplicar inteligencia artificial en los datos directamente desde SQL. La integración de la inteligencia artificial en flujos de trabajo de análisis proporciona acceso a la información inaccesible a los analistas y les permite tomar decisiones más informadas, administrar riesgos y mantener una ventaja competitiva a través de la innovación y eficiencia controladas por datos.

Resumen de las áreas de características de Azure Databricks

Esta es una asignación de las características de Databricks Data Intelligence Platform a las demás capas del marco, de abajo a arriba:

Almacenamiento en la nube

Todos los datos del lago de datos se almacenan en el almacenamiento de objetos del proveedor de nube. Databricks admite tres providersen la nube: AWS, Azure y GCP. Los archivos en varios formatos estructurados y semiestructurados (por ejemplo, Parquet, CSV, JSON y Avro), así como formatos no estructurados (como imágenes y documentos), se ingieren y transforman mediante procesos por lotes o de streaming.

Delta Lake es el formato de datos recomendado para lagos de datos (transacciones de archivos, confiabilidad, coherencia, actualizaciones, etc.) y es un completamente de código abierto para proporcionar así alternativas. Y el formato universal Delta (UniForm) permite leer tablas Delta tables con clientes lectores de Iceberg.

No se usan formatos de datos de propiedad en Databricks Data Intelligence Platform.

gobernanza de datos e inteligencia artificial

Además de la capa de almacenamiento, Unity Catalog ofrece una amplia gama de funcionalidades de gobernanza de datos y de inteligencia artificial, como la administración de metadatos en el metastore, el control de acceso , la auditoría , la detección de datos y el linaje de datos .

La supervisión del lago de datos proporciona métricas de calidad integradas para los recursos de datos e inteligencia artificial y paneles generados automáticamente para visualizar estas métricas.

Los orígenes SQL externos se pueden integrar en el lago de datos y en Unity Catalog mediante la federación de lago de datos.

Motor de IA

La plataforma de inteligencia de datos se basa en la arquitectura de lago de datos y se mejora mediante el motor de inteligencia de datos DatabricksIQ. DatabricksIQ combina inteligencia artificial generativa con las ventajas de unificación de la arquitectura de lago de datos para comprender la semántica única de los datos. Búsqueda inteligente y Databricks Assistant son ejemplos de servicios con tecnología de IA que simplifican el trabajo con la plataforma para cada usuario.

Orquestación

Los trabajos de Databricks permiten ejecutar diversas cargas de trabajo durante el ciclo de vida completo de los datos y la inteligencia artificial en cualquier nube. Permiten organizar trabajos, así como Delta Live Tables para SQL, Spark, cuadernos, DBT, modelos de ML, etc.

Herramientas de ETL y DS

En la capa de consumo, los ingenieros de datos y los ingenieros de ML suelen trabajar con la plataforma mediante IDE. Los científicos de datos suelen preferir cuadernos y usar los entornos de ejecución de ML e IA, y el sistema de flujo de trabajo de aprendizaje automático MLflow para realizar un seguimiento de los experimentos y administrar el ciclo de vida del modelo.

Herramientas de BI

Normalmente, los analistas de negocios usan su herramienta de BI preferida para acceder al almacenamiento de datos de Databricks. Databricks SQL se puede consultar mediante diferentes herramientas de análisis y BI, consulte BI y visualización

Además, la plataforma ofrece herramientas de consulta y análisis lista para usar:

- Paneles de IA/BI para arrastrar y colocar visualizaciones de datos y compartir información.

- Expertos en dominios, como analistas de datos, configuran espacios de Genie de IA/BI con conjuntos de datos, consultas de ejemplo y directrices de texto para ayudar a Genie a traducir preguntas empresariales en consultas analíticas. Una vez set configurado, los usuarios empresariales pueden formular preguntas y generate visualizaciones para comprender los datos operativos.

- Databricks Apps permite a los desarrolladores crear aplicaciones de inteligencia artificial y datos seguros en la plataforma de Databricks y compartir esas aplicaciones con los usuarios.

- Editor de SQL para analistas de SQL para analizar datos.

Colaboración

Delta Sharing es un protocolo abierto desarrollado por Databricks para proteger el uso compartido de datos con otras organizaciones, independientemente de las plataformas informáticas que usen.

Databricks Marketplace, es un foro abierto para intercambiar productos de datos. Se aprovecha de Delta Sharing para proporcionar a los datos providers las herramientas necesarias para compartir productos de datos de forma segura, y otorga a los consumidores de datos la capacidad de explorar y expandir su acceso a los datos y los servicios de datos que necesitan.

Clean Rooms usa Delta Sharing y proceso sin servidor para proporcionar un entorno seguro y de protección de la privacidad where varias partes pueden trabajar de forma conjunta en datos empresariales confidenciales sin acceso directo entre sí.