Paso 3. Mantener un conjunto de evaluación de los comentarios de las partes interesadas

Consulte el repositorio de GitHub para ver el código de ejemplo de esta sección.

Tiempo esperado: de 10 a 60 minutos. El tiempo varía en función de la calidad de las respuestas proporcionadas por las partes interesadas. Si las respuestas son desordenadas o contienen una gran cantidad de consultas irrelevantes, deberá dedicar más tiempo a filtrar y limpiar los datos.

Información general y resultado esperado

Este paso arrancará un conjunto de evaluación con los comentarios que las partes interesadas han proporcionado mediante la aplicación de revisión. Tenga en cuenta que puede arrancar un conjunto de evaluación con solo preguntas, por lo que incluso si las partes interesadas solo chatearon con la aplicación frente a proporcionar comentarios, puede seguir este paso.

Para ver el esquema del conjunto de evaluación de evaluación del agente, consulte Esquema de entrada de evaluación del agente. En el resto de esta sección se hace referencia a los campos de este esquema.

Al final de este paso, tendrá un conjunto de evaluación que contiene lo siguiente:

- Solicitudes con un pulgar hacia arriba 👍:

request: tal y como ha escrito el usuario.expected_response: respuesta tal y como ha editado el usuario. Si el usuario no editó la respuesta, la respuesta generada por el modelo.

- Solicitudes con un pulgar hacia abajo 👎:

request: tal y como ha escrito el usuario.expected_response: respuesta tal y como ha editado el usuario. Si el usuario no editó la respuesta, la respuesta es null.

- Solicitudes sin comentarios (sin pulgares hacia arriba 👍 o pulgares hacia abajo 👎)

request: tal y como ha escrito el usuario.

Para todas las solicitudes, si el usuario selecciona pulgares hacia arriba 👍 para un fragmento de retrieved_context, el doc_uri de ese fragmento se incluye en expected_retrieved_context para la pregunta.

Importante

Databricks recomienda que el conjunto de evaluación contenga al menos 30 preguntas para empezar. Lea el análisis detallado del conjunto de evaluación para obtener más información sobre lo que es un “buen” conjunto de evaluación.

Requisitos

- Las partes interesadas han usado su POC y han proporcionado comentarios.

- Todos los requisitos de los pasos anteriores.

Instrucciones

- Abra el cuaderno 04_create_evaluation_set y haga clic en Ejecutar todo.

- Inspeccione el conjunto de evaluación para comprender los datos que se incluyen. Debe validar que el conjunto de evaluación contiene un conjunto representativo y desafiante de preguntas. Ajuste el conjunto de evaluación según sea necesario.

- De forma predeterminada, el conjunto de evaluación se guarda en la tabla Delta configurada en

EVALUATION_SET_FQNen el cuaderno 00_global_config.

Paso siguiente

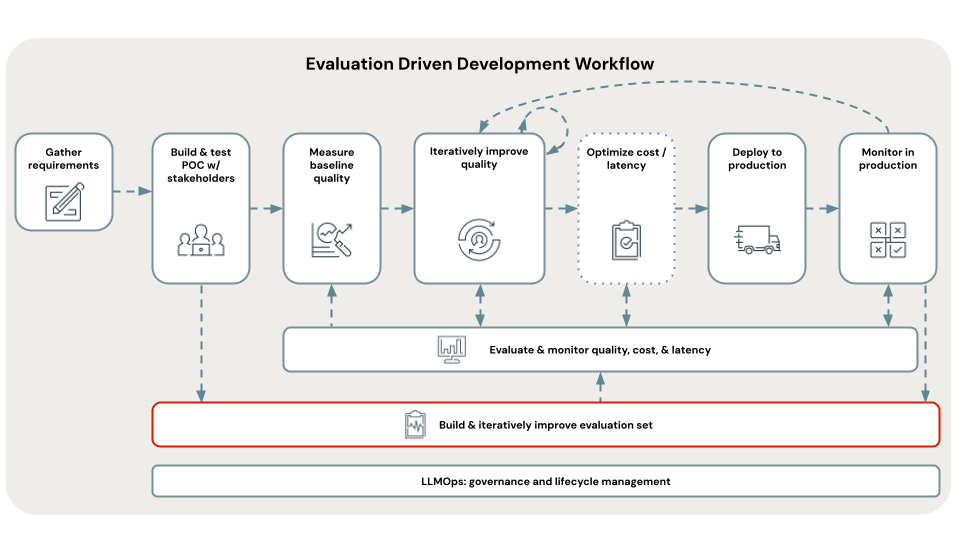

Ahora que tiene un conjunto de evaluación, úselo para evaluar la calidad, el coste y la latencia de la POC de la aplicación. Consulte el paso 4. Evaluación de la calidad de la POC.

< Anterior: Paso 2. Implementación de POC y recopilación de comentarios