Databricks Runtime 6.0 (EoS)

Nota:

El soporte técnico con esta versión de Databricks Runtime ha finalizado. Para obtener la fecha de finalización del soporte técnico, consulte Historial de finalización del soporte técnico. Para ver todas las versiones de Databricks Runtime con soporte técnico, consulte las notas de la versión de Databricks Runtime versiones y compatibilidad.

Databricks publicó esta versión en octubre de 2019.

Las notas de la versión siguientes proporcionan información sobre Databricks Runtime 6.0, con tecnología de Apache Spark.

Nuevas características

Entorno de Python

Databricks Runtime 6.0 incluye cambios importantes en Python y la forma en que se configuran los entornos de Python, incluida la actualización de Python a 3.7.3, la refinación de la lista de paquetes de Python instalados y la actualización de esos paquetes instalados a versiones más recientes. Para más información, consulte bibliotecas de Python instaladas.

Además, como se anunció anteriormente, Databricks Runtime 6.0 no admite Python 2.

Los cambios principales incluyen:

- Actualización de Python de 3.5.2 a 3.7.3. Es posible que algunas versiones anteriores de los paquetes de Python no sean compatibles con Python 3.7 porque dependen de versiones anteriores de Cython que no son compatibles con esta versión de Python. La instalación de este tipo de paquete puede desencadenar errores similares a

‘PyThreadState’ {‘struct _ts’} has no member named ‘exc_type’(consulte el problema de GitHub 1978 para más información). Instale en su lugar versiones compatibles de paquetes de Python compatibles con Python 3.7. - Actualizaciones de paquetes principales:

- boto3 a 1.9.162

- ipython a 7.4.0

- matplotlib a 3.0.3

- numpy a 1.16.2

- pandas a 0.24.2

- pyarrow a 0.13.0

- En comparación con Databricks Runtime 5.5 LTS (EoS), se incluyen recientemente los siguientes paquetes de Python: asn1crypto, backcall, jedi, packssolver, parso y PySocks.

- En comparación con Databricks Runtime 5.5 LTS (EoS), no se instalan los siguientes paquetes de Python: ansi2html, brewer2mpl, colorama, configobj, enum34, et-xmlfile, freetype-py, funcsigs, fusepy, ggplot, html5lib, ipaddress, jdcal, Jinja2, llvmlite, lxml, MarkupSafe, mpld3, msgpack-python, ndg-httpsclient, numba, openpyxl, pathlib2, Pillow, ply, pyasn1, pypng, python-geohash, scour, simplejson y singledispatch.

- La función

displayen objetos ggplot de Python ya no se admite porque el paquete ggplot no es compatible con la versión más reciente de Pandas. - Establecer

PYSPARK_PYTHONen/databricks/python2/bin/pythonno se admite porque Databricks Runtime 6.0 no admite Python 2. Un clúster con esta configuración todavía puede iniciarse. Sin embargo, los cuadernos de Python y los comandos de Python no funcionarán, es decir, las celdas de comandos de Python producirán un error "Canceled" (Cancelado) y aparecerá un errorPython shell failed to starten los registros de controladores. - Si

PYSPARK_PYTHONapunta a un ejecutable de Python que se encuentra en un entorno administrado por Virtualenv, este entorno se activará para los scripts de inicialización y los cuadernos. Puede usar los comandospythonypipque se definen en el entorno activado directamente sin tener que especificar las ubicaciones absolutas de estos comandos. De manera predeterminada,PYSPARK_PYTHONse establece en/databricks/python3/bin/python. Por lo tanto, de forma predeterminada,pythonapunta a/databricks/python3/bin/pythonypipapunta a/databricks/python3/bin/pippara los scripts de inicialización y los cuadernos. SiPYSPARK_PYTHONapunta a un archivo ejecutable de Python que no está en un entorno administrado por Virtualenv o si está escribiendo un script de inicialización para crear el código Python especificado porPYSPARK_PYTHON, deberá usar rutas de acceso absolutas para acceder a los elementospythonypipcorrectos. Cuando el aislamiento de la biblioteca de Python está habilitado (lo está de forma predeterminada), el entorno activado sigue siendo el entorno al que está asociadoPYSPARK_PYTHON. Se recomienda usar la utilidad de biblioteca (dbutils.library) (heredada) para modificar el entorno aislado asociado a un cuaderno de Python.

API de Scala y Java para comandos DML de Delta Lake

Ahora puede modificar datos en tablas Delta mediante las API de programación para eliminarlas, actualizarlas y combinarlas. Estas API reflejan la sintaxis y la semántica de sus comandos de SQL correspondientes y son excelentes para muchas cargas de trabajo, por ejemplo, operaciones de dimensiones que cambian lentamente (SCD), combinación de datos de cambios para la replicación y operaciones de actualización/inserción (upsert) de consultas de streaming.

Para más información, consulte ¿Qué es Delta Lake?

API de Scala y Java para comandos de la utilidad Delta Lake

Databricks Runtime ahora tiene API de programación para los comandos de utilidad vacuum y history. Estas API reflejan la sintaxis y la semántica de sus comandos SQL correspondientes disponibles en versiones anteriores de Databricks Runtime.

Para limpiar archivos a los que una tabla Delta ya no hace referencia y que son anteriores al umbral de retención, ejecute vacuum en la tabla. Al ejecutar el comando vacuum en la tabla, se limpian de forma recursiva los directorios asociados a la tabla Delta. El umbral de retención predeterminado para los archivos es de 7 días. La capacidad de volver a una versión anterior al período de retención se pierde después de ejecutar vacuum. vacuum no se desencadena automáticamente.

Puede recuperar información sobre las operaciones, el usuario, la marca de tiempo, etc., para cada escritura en una tabla Delta mediante la ejecución del comando history. Las operaciones se devuelven en orden cronológico inverso. De forma predeterminada, el historial de tablas se conserva durante 30 días.

Para más información, consulte ¿Qué es Delta Lake?

Almacenamiento en caché de disco disponible para instancias Lsv2 de Azure

[Almacenamiento en caché de disco]](../../optimizations/disk-cache.md) ahora está habilitada de manera predeterminada en todas las instancias Lsv2.

Almacenamiento optimizado mediante las API de archivos locales

Las API de archivos locales son útiles, ya que permiten acceder a los archivos desde el almacenamiento de objetos distribuidos subyacente como archivos locales. En Databricks Runtime 6.0, se ha mejorado el montaje FUSE que permite a las API de archivos locales solucionar limitaciones importantes. Databricks Runtime 6.0 mejora significativamente la velocidad de lectura y escritura y admite archivos de más de 2 GB. Si necesita lecturas y escrituras más rápidas y confiables, por ejemplo, para el entrenamiento de modelos distribuidos, esta mejora resulta especialmente útil. Además, no tiene que cargar datos de las cargas de trabajo en un almacenamiento local, con lo que se ahorran costos y se mejora la productividad.

Para más información, consulte ¿Qué es DBFS?

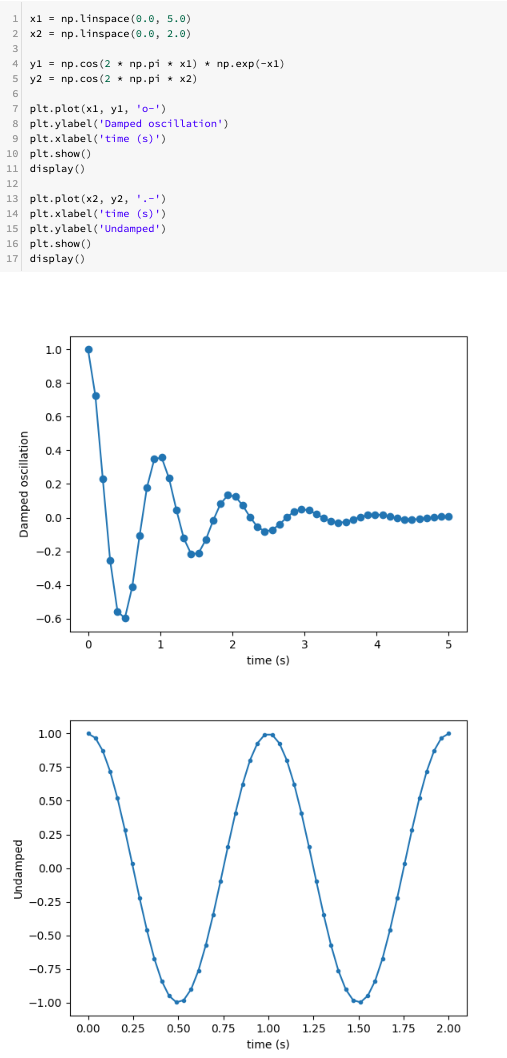

Varios trazados matplotlib por celda de cuaderno

Ahora puede mostrar varios trazados matplotlib por celda de cuaderno:

Credenciales de servicio para varias cuentas de Azure Data Lake Storage Gen1

Ahora, es posible configurar credenciales de servicio para varias cuentas de Acceso a Azure Data Lake Storage Gen1 desde Azure Databricks de forma que puedan usarse en una sola sesión de Apache Spark. Para ello, agregue a account.<account-name> a las claves de configuración. Por ejemplo, si quiere configurar credenciales para que las cuentas accedan a adl://example1.azuredatalakestore.net y adl://example2.azuredatalakestore.net, puede hacerlo de la siguiente manera:

spark.conf.set("fs.adl.oauth2.access.token.provider.type", "ClientCredential")

spark.conf.set("fs.adl.account.example1.oauth2.client.id", "<application-id-example1>")

spark.conf.set("fs.adl.account.example1.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example1>"))

spark.conf.set("fs.adl.account.example1.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example1>/oauth2/token")

spark.conf.set("fs.adl.account.example2.oauth2.client.id", "<application-id-example2>")

spark.conf.set("fs.adl.account.example2.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example2>"))

spark.conf.set("fs.adl.account.example2.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example2>/oauth2/token")

Mejoras

- Se ha actualizado el SDK de AWS a la versión 1.11.596.

- Se ha actualizado el SDK de Azure Storage en el controlador WASB a la versión 7.0.

OPTIMIZEahora proporciona un resumen de métricas, como el número de archivos agregados, el número de archivos quitados y el tamaño de archivo máximo y mínimo. Consulte Optimización del diseño del archivo de datos.

Eliminación

Se ha quitado la exportación de modelos de ML de Databricks. Use MLeap en su lugar para importar y exportar modelos.

Spark de Apache

Nota:

Este artículo contiene referencias al término esclavo, un término que Azure Databricks no utiliza. Cuando se quite el término del software, se quitará también del artículo.

Databricks Runtime 6.0 incluye Apache Spark 2.4.3. Esta versión incluye todas las correcciones y mejoras de Spark incluidas en Databricks Runtime 5.5 LTS (EoS), así como las siguientes correcciones de errores y mejoras adicionales realizadas en Spark:

- [SPARK-27992][SPARK-28881][PYTHON] Permiso para que Python se combine con el subproceso de conexión para propagar errores.

- [SPARK-27330][SS]Anulación de tarea de soporte en ForeachWriter (6.0, 5.x)

- [SPARK-28642][SQL] Ocultar credenciales en SHOW CREATE TABLE

- [SPARK-28699][CORE] Corrección de un caso especial para anular una fase indeterminada.

- [SPARK-28647][WEBUI] Recuperación de la característica de métrica adicional

- [SPARK-28766][R][DOC] Corrección de la advertencia de viabilidad entrante de CRAN en una dirección URL no válida

- [SPARK-28486][CORE][PYTHON] Asignación del archivo de datos de PythonBroadcast a BroadcastBlock para evitar la eliminación por GC

- [SPARK-25035][CORE] Evitar la asignación de memoria en la replicación de bloques almacenados en disco

- [SPARK-27234][SS][PYTHON] Uso de InheritableThreadLocal para la época actual en EpochTracker (para admitir las funciones definidas por el usuario de Python)

- [SPARK-28638][WEBUI] El resumen de tareas solo debe contener métricas de tareas correctas

- [SPARK-28153][PYTHON] Uso de AtomicReference en InputFileBlockHolder (para admitir input_file_name con la función definida por el usuario de Python)

- [SPARK-28564][CORE] La aplicación del historial de acceso tiene como valor predeterminado el último identificador de intento

- [SPARK-28260] El clúster puede finalizar automáticamente mientras la consulta thriftserver sigue capturando resultados

- [SPARK-26152][CORE] Sincronización de la limpieza de trabajos con el apagado de trabajos

- [SPARK-28545][SQL] Adición del tamaño de asignación de hash al registro direccional de ObjectAggregationIterator.

- [SPARK-28489][SS] Corrección de un error que provocaba que KafkaOffsetRangeCalculator.getRanges quitara desplazamientos.

- [SPARK-28421][ML] Optimización de rendimiento de SparseVector.apply

- [SPARK-28156][SQL] La autocombinación no debe perder la vista almacenada en caché

- [SPARK-28152][SQL] Asignación de ShortType a SMALLINT y de FloatType a REAL para MsSqlServerDialect.

- [SPARK-28054][SQL] Corrección del error al insertar dinámicamente tablas con particiones de Hive donde el nombre de la partición está en mayúsculas

- [SPARK-27159][SQL] Actualización del dialecto del servidor mssql para admitir el tipo binario

- [SPARK-28355][CORE][PYTHON] Uso de la configuración de Spark para el umbral al que…

- [SPARK-27989][CORE] Se han agregado reintentos en la conexión al controlador para k8s

- [SPARK-27416][SQL] Serialización de Kyro de UnsafeMapData y UnsafeArrayData…

- [SPARK-28430][UI] Corrección de la representación de tablas de fases cuando faltan métricas de algunas tareas

- [SPARK-27485] EnsureRequirements.reorder debe controlar correctamente las expresiones duplicadas

- [SPARK-28404][SS] Corrección del valor de tiempo de espera negativo en RateStreamContinuousPartitionReader

- [SPARK-28378][PYTHON] Eliminación del uso de cgi.escape

- [SPARK-28371][SQL] Hacer que el filtro "StartsWith" de Parquet sea seguro para valores NULL

- [SPARK-28015][SQL] Check stringToDate() consume la entrada completa para los formatos yyyy y yyyy-[m]m

- [SPARK-28302][CORE] Asegurarse de generar un archivo de salida único para SparkLauncher en Windows

- [SPARK-28308][CORE] Se debe agregar la parte del subsegundo CalendarInterval antes del análisis

- [SPARK-28170][ML][PYTHON] Documentación sobre vectores y matrices uniformes

- [SPARK-28160][CORE] Se ha corregido un error que provocaba que la función de devolución de llamada se bloqueara cuando faltaba una excepción sin comprobar

- [SPARK-27839][SQL] Cambio de UTF8String.replace() para que funcione en bytes UTF8

- [SPARK-28157][CORE] Hacer que SHS borre KVStore LogInfo para las entradas de la lista de no permitidos

- [SPARK-28128][PYTHON][SQL] Las UDF agrupadas por Pandas omiten las particiones vacías

- [SPARK-28012][SQL] La UDF de Hive admite una expresión de tipo de estructura que se puede plegar

- [SPARK-28164] Corrección de la descripción de uso de start-slave.sh

- [SPARK-27100][SQL] Use Array en lugar de Seq en FilePartition para impedir StackOverflowError

- [SPARK-28154][ML] Corrección del doble almacenamiento en caché de GMM

Actualizaciones de mantenimiento

Consulte Actualizaciones de mantenimiento de Databricks Runtime 6.0.

Entorno del sistema

- Sistema operativo: Ubuntu 16.04.6 LTS

- Java: 1.8.0_232

- Scala: 2.11.12

- Python: 3.7.3

- R: versión de R 3.6.1 (2019-07-05)

- Delta Lake: 0.3.0

Nota:

Aunque Scala 2.12 está disponible como característica experimental en Apache Spark 2.4, no se admite en Databricks Runtime 6.0.

Bibliotecas de Python instaladas

| Biblioteca | Versión | Biblioteca | Versión | Biblioteca | Versión |

|---|---|---|---|---|---|

| asn1crypto | 0.24.0 | backcall | 0.1.0 | boto | 2.49.0 |

| boto3 | 1.9.162 | botocore | 1.12.163 | certifi | 2019.3.9 |

| cffi | 1.12.2 | chardet | 3.0.4 | criptografía | 2.6.1 |

| cycler | 0.10.0 | Cython | 0.29.6 | decorator | 4.4.0 |

| docutils | 0.14 | idna | 2.8 | ipython | 7.4.0 |

| ipython-genutils | 0.2.0 | jedi | 0.13.3 | jmespath | 0.9.4 |

| kiwisolver | 1.1.0 | matplotlib | 3.0.3 | numpy | 1.16.2 |

| pandas | 0.24.2 | parso | 0.3.4 | patsy | 0.5.1 |

| pexpect | 4.6.0 | pickleshare | 0.7.5 | pip | 19.0.3 |

| prompt-toolkit | 2.0.9 | psycopg2 | 2.7.6.1 | ptyprocess | 0.6.0 |

| pyarrow | 0.13.0 | pycparser | 2.19 | pycurl | 7.43.0 |

| Pygments | 2.3.1 | PyGObject | 3.20.0 | pyOpenSSL | 19.0.0 |

| pyparsing | 2.4.2 | PySocks | 1.6.8 | python-apt | 1.1.0.b1+ubuntu0.16.04.5 |

| Python-dateutil | 2.8.0 | pytz | 2018.9 | Solicitudes | 2.21.0 |

| s3transfer | 0.2.1 | scikit-learn | 0.20.3 | scipy | 1.2.1 |

| seaborn | 0.9.0 | setuptools | 40.8.0 | six (seis) | 1.12.0 |

| ssh-import-id | 5.5 | statsmodels | 0.9.0 | traitlets | 4.3.2 |

| unattended-upgrades | 0,1 | urllib3 | 1.24.1 | virtualenv | 16.4.1 |

| wcwidth | 0.1.7 | wheel | 0.33.1 |

Bibliotecas de R instaladas

| Biblioteca | Versión | Biblioteca | Versión | Biblioteca | Versión |

|---|---|---|---|---|---|

| abind | 1.4-5 | askpass | 1.1 | assertthat | 0.2.1 |

| backports | 1.1.3 | base | 3.6.1 | base64enc | 0.1-3 |

| BH | 1.69.0-1 | bit | 1.1-14 | bit64 | 0.9-7 |

| bitops | 1.0-6 | blob | 1.1.1 | boot | 1.3-23 |

| brew | 1.0-6 | callr | 3.2.0 | automóvil | 3.0-2 |

| carData | 3.0-2 | caret | 6.0-82 | cellranger | 1.1.0 |

| chron | 2.3-53 | clase | 7.3-15 | cli | 1.1.0 |

| clipr | 0.5.0 | clisymbols | 1.2.0 | cluster | 2.1.0 |

| codetools | 0.2-16 | colorspace | 1.4-1 | commonmark | 1.7 |

| compiler | 3.6.1 | config | 0,3 | crayon | 1.3.4 |

| curl | 3.3 | data.table | 1.12.0 | conjuntos de datos | 3.6.1 |

| DBI | 1.0.0 | dbplyr | 1.3.0 | desc | 1.2.0 |

| devtools | 2.0.1 | digest | 0.6.18 | doMC | 1.3.5 |

| dplyr | 0.8.0.1 | ellipsis | 0.1.0 | fansi | 0.4.0 |

| forcats | 0.4.0 | foreach | 1.4.4 | foreign | 0.8-72 |

| forge | 0.2.0 | fs | 1.2.7 | gbm | 2.1.5 |

| generics | 0.0.2 | ggplot2 | 3.1.0 | gh | 1.0.1 |

| git2r | 0.25.2 | glmnet | 2.0-16 | glue | 1.3.1 |

| gower | 0.2.0 | elementos gráficos | 3.6.1 | grDevices | 3.6.1 |

| grid | 3.6.1 | gridExtra | 2.3 | gsubfn | 0.7 |

| gtable | 0.3.0 | h2o | 3.22.1.1 | haven | 2.1.0 |

| hms | 0.4.2 | htmltools | 0.3.6 | htmlwidgets | 1.3 |

| httr | 1.4.0 | hwriter | 1.3.2 | hwriterPlus | 1.0-3 |

| ini | 0.3.1 | ipred | 0.9-8 | iterators | 1.0.10 |

| jsonlite | 1.6 | KernSmooth | 2.23-15 | labeling | 0,3 |

| lattice | 0.20-38 | lava | 1.6.5 | lazyeval | 0.2.2 |

| littler | 0.3.7 | lme4 | 1.1-21 | lubridate | 1.7.4 |

| magrittr | 1.5 | mapproj | 1.2.6 | maps | 3.3.0 |

| maptools | 0.9-5 | MASS | 7.3-51.4 | Matriz | 1.2-17 |

| MatrixModels | 0.4-1 | memoise | 1.1.0 | methods | 3.6.1 |

| mgcv | 1.8-28 | mime | 0.6 | minqa | 1.2.4 |

| ModelMetrics | 1.2.2 | munsell | 0.5.0 | mvtnorm | 1.0-10 |

| nlme | 3.1-141 | nloptr | 1.2.1 | nnet | 7.3-12 |

| numDeriv | 2016.8-1 | openssl | 1.3 | openxlsx | 4.1.0 |

| parallel | 3.6.1 | pbkrtest | 0.4-7 | pillar | 1.3.1 |

| pkgbuild | 1.0.3 | pkgconfig | 2.0.2 | pkgKitten | 0.1.4 |

| pkgload | 1.0.2 | plogr | 0.2.0 | plyr | 1.8.4 |

| praise | 1.0.0 | prettyunits | 1.0.2 | pROC | 1.14.0 |

| processx | 3.3.0 | prodlim | 2018.04.18 | progreso | 1.2.0 |

| proto | 1.0.0 | ps | 1.3.0 | purrr | 0.3.2 |

| quantreg | 5.38 | R.methodsS3 | 1.7.1 | R.oo | 1.22.0 |

| R.utils | 2.8.0 | r2d3 | 0.2.3 | R6 | 2.4.0 |

| randomForest | 4.6-14 | rappdirs | 0.3.1 | rcmdcheck | 1.3.2 |

| RColorBrewer | 1.1-2 | Rcpp | 1.0.1 | RcppEigen | 0.3.3.5.0 |

| RcppRoll | 0.3.0 | RCurl | 1.95-4.12 | readr | 1.3.1 |

| readxl | 1.3.1 | recipes | 0.1.5 | rematch | 1.0.1 |

| remotes | 2.0.2 | reshape2 | 1.4.3 | rio | 0.5.16 |

| rlang | 0.3.3 | RODBC | 1.3-15 | roxygen2 | 6.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-6 |

| RSQLite | 2.1.1 | rstudioapi | 0,10 | scales | 1.0.0 |

| sessioninfo | 1.1.1 | sp | 1.3-1 | sparklyr | 1.0.0 |

| SparkR | 2.4.4 | SparseM | 1.77 | spatial | 7.3-11 |

| splines | 3.6.1 | sqldf | 0.4-11 | SQUAREM | 2017.10-1 |

| statmod | 1.4.30 | stats | 3.6.1 | stats4 | 3.6.1 |

| stringi | 1.4.3 | stringr | 1.4.0 | survival | 2.44-1.1 |

| sys | 3.1 | tcltk | 3.6.1 | TeachingDemos | 2,10 |

| testthat | 2.0.1 | tibble | 2.1.1 | tidyr | 0.8.3 |

| tidyselect | 0.2.5 | timeDate | 3043.102 | tools | 3.6.1 |

| usethis | 1.4.0 | utf8 | 1.1.4 | utils | 3.6.1 |

| viridisLite | 0.3.0 | whisker | 0.3-2 | withr | 2.1.2 |

| xml2 | 1.2.0 | xopen | 1.0.0 | yaml | 2.2.0 |

| zip | 2.0.1 |

Bibliotecas de Java y Scala instaladas (versión de clúster de Scala 2.11)

| Identificador de grupo | Identificador de artefacto | Versión |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-kinesis-client | 1.8.10 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.595 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.595 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.595 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.595 |

| com.amazonaws | aws-java-sdk-config | 1.11.595 |

| com.amazonaws | aws-java-sdk-core | 1.11.595 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.595 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.595 |

| com.amazonaws | aws-java-sdk-directory | 1.11.595 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.595 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.595 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.595 |

| com.amazonaws | aws-java-sdk-efs | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.595 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.595 |

| com.amazonaws | aws-java-sdk-emr | 1.11.595 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.595 |

| com.amazonaws | aws-java-sdk-glue | 1.11.595 |

| com.amazonaws | aws-java-sdk-iam | 1.11.595 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.595 |

| com.amazonaws | aws-java-sdk-kinesis | 1.11.595 |

| com.amazonaws | aws-java-sdk-kms | 1.11.595 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.595 |

| com.amazonaws | aws-java-sdk-logs | 1.11.595 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.595 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.595 |

| com.amazonaws | aws-java-sdk-rds | 1.11.595 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.595 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.595 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.595 |

| com.amazonaws | aws-java-sdk-ses | 1.11.595 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.595 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.595 |

| com.amazonaws | aws-java-sdk-sns | 1.11.595 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.595 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.595 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.595 |

| com.amazonaws | aws-java-sdk-sts | 1.11.595 |

| com.amazonaws | aws-java-sdk-support | 1.11.595 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.595 |

| com.amazonaws | jmespath-java | 1.11.595 |

| com.carrotsearch | hppc | 0.7.2 |

| com.chuusai | shapeless_2.11 | 2.3.2 |

| com.clearspring.analytics | flujo | 2.7.0 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | dbml-local_2.11 | 0.5.0-db8-spark2.4 |

| com.databricks | dbml-local_2.11-tests | 0.5.0-db8-spark2.4 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.11 | 0.4.15-9 |

| com.databricks.scalapb | scalapb-runtime_2.11 | 0.4.15-9 |

| com.esotericsoftware | kryo-shaded | 4.0.2 |

| com.esotericsoftware | minlog | 1.3.0 |

| com.fasterxml | classmate | 1.0.0 |

| com.fasterxml.jackson.core | jackson-annotations | 2.6.7 |

| com.fasterxml.jackson.core | jackson-core | 2.6.7 |

| com.fasterxml.jackson.core | jackson-databind | 2.6.7.1 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.6.7 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.6.7 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.6.7 |

| com.fasterxml.jackson.module | jackson-module-scala_2.11 | 2.6.7.1 |

| com.github.fommil | jniloader | 1.1 |

| com.github.fommil.netlib | core | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1.1 |

| com.github.fommil.netlib | native_ref-java-natives | 1.1 |

| com.github.fommil.netlib | native_system-java | 1.1 |

| com.github.fommil.netlib | native_system-java-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

| com.github.luben | zstd-jni | 1.3.2-2 |

| com.github.rwl | jtransforms | 2.4.0 |

| com.google.code.findbugs | jsr305 | 2.0.1 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.guava | guava | 15.0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.googlecode.javaewah | JavaEWAH | 0.3.2 |

| com.h2database | h2 | 1.3.174 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEASE |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.azure | azure-storage | 7.0.0 |

| com.microsoft.sqlserver | mssql-jdbc | 6.2.2.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.11 | 0,3 |

| com.twitter | chill-java | 0.9.3 |

| com.twitter | chill_2.11 | 0.9.3 |

| com.twitter | parquet-hadoop-bundle | 1.6.0 |

| com.twitter | util-app_2.11 | 6.23.0 |

| com.twitter | util-core_2.11 | 6.23.0 |

| com.twitter | util-jvm_2.11 | 6.23.0 |

| com.typesafe | config | 1.2.1 |

| com.typesafe.scala-logging | scala-logging-api_2.11 | 2.1.2 |

| com.typesafe.scala-logging | scala-logging-slf4j_2.11 | 2.1.2 |

| com.univocity | univocity-parsers | 2.7.3 |

| com.vlkan | flatbuffers | 1.2.0-3f79e055 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.3 |

| commons-cli | commons-cli | 1.2 |

| commons-codec | commons-codec | 1.10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuration | commons-configuration | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2.4 |

| commons-lang | commons-lang | 2.6 |

| commons-logging | commons-logging | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.7 |

| io.airlift | aircompressor | 0,10 |

| io.dropwizard.metrics | metrics-core | 3.1.5 |

| io.dropwizard.metrics | metrics-ganglia | 3.1.5 |

| io.dropwizard.metrics | metrics-graphite | 3.1.5 |

| io.dropwizard.metrics | metrics-healthchecks | 3.1.5 |

| io.dropwizard.metrics | metrics-jetty9 | 3.1.5 |

| io.dropwizard.metrics | metrics-json | 3.1.5 |

| io.dropwizard.metrics | metrics-jvm | 3.1.5 |

| io.dropwizard.metrics | metrics-log4j | 3.1.5 |

| io.dropwizard.metrics | metrics-servlets | 3.1.5 |

| io.netty | netty | 3.9.9.Final |

| io.netty | netty-all | 4.1.17.Final |

| javax.activation | activation | 1.1.1 |

| javax.annotation | javax.annotation-api | 1.2 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1.1 |

| javax.validation | validation-api | 1.1.0.Final |

| javax.ws.rs | javax.ws.rs-api | 2.0.1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.9.3 |

| junit | junit | 4,12 |

| log4j | apache-log4j-extras | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.hydromatic | eigenbase-properties | 1.1.5 |

| net.razorvine | pyrolite | 4.13 |

| net.sf.jpam | jpam | 1.1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-csv | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.5 |

| net.snowflake | snowflake-jdbc | 3.6.15 |

| net.snowflake | spark-snowflake_2.11 | 2.4.10-spark_2.4 |

| net.sourceforge.f2j | arpack_combined_all | 0,1 |

| org.acplt | oncrpc | 1.0.7 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.4 |

| org.antlr | antlr4-runtime | 4,7 |

| org.antlr | stringtemplate | 3.2.1 |

| org.apache.ant | ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | arrow-format | 0.10.0 |

| org.apache.arrow | arrow-memory | 0.10.0 |

| org.apache.arrow | arrow-vector | 0.10.0 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.calcite | calcite-avatica | 1.2.0-incubating |

| org.apache.calcite | calcite-core | 1.2.0-incubating |

| org.apache.calcite | calcite-linq4j | 1.2.0-incubating |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3,5 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.curator | curator-client | 2.7.1 |

| org.apache.curator | curator-framework | 2.7.1 |

| org.apache.curator | curator-recipes | 2.7.1 |

| org.apache.derby | derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-annotations | 2.7.3 |

| org.apache.hadoop | hadoop-auth | 2.7.3 |

| org.apache.hadoop | hadoop-client | 2.7.3 |

| org.apache.hadoop | hadoop-common | 2.7.3 |

| org.apache.hadoop | hadoop-hdfs | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.3 |

| org.apache.htrace | htrace-core | 3.1.0-incubating |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.10 |

| org.apache.ivy | ivy | 2.4.0 |

| org.apache.orc | orc-core-nohive | 1.5.5 |

| org.apache.orc | orc-mapreduce-nohive | 1.5.5 |

| org.apache.orc | orc-shims | 1.5.5 |

| org.apache.parquet | parquet-column | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-common | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-encoding | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-format | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-jackson | 1.10.1.2-databricks3 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.9.3 |

| org.apache.xbean | xbean-asm6-shaded | 4.8 |

| org.apache.zookeeper | zookeeper | 3.4.6 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.10 |

| org.codehaus.janino | janino | 3.0.10 |

| org.datanucleus | datanucleus-api-jdo | 3.2.6 |

| org.datanucleus | datanucleus-core | 3.2.10 |

| org.datanucleus | datanucleus-rdbms | 3.2.9 |

| org.eclipse.jetty | jetty-client | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-continuation | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-http | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-io | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-jndi | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-plus | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-proxy | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-security | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-server | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-servlet | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-servlets | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-util | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-webapp | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-xml | 9.3.27.v20190418 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.4.0-b34 |

| org.glassfish.hk2 | hk2-locator | 2.4.0-b34 |

| org.glassfish.hk2 | hk2-utils | 2.4.0-b34 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.1 |

| org.glassfish.hk2.external | aopalliance-repackaged | 2.4.0-b34 |

| org.glassfish.hk2.external | javax.inject | 2.4.0-b34 |

| org.glassfish.jersey.bundles.repackaged | jersey-guava | 2.22.2 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.22.2 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.22.2 |

| org.glassfish.jersey.core | jersey-client | 2.22.2 |

| org.glassfish.jersey.core | jersey-common | 2.22.2 |

| org.glassfish.jersey.core | jersey-server | 2.22.2 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.22.2 |

| org.hamcrest | hamcrest-core | 1.3 |

| org.hamcrest | hamcrest-library | 1.3 |

| org.hibernate | hibernate-validator | 5.1.1.Final |

| org.iq80.snappy | snappy | 0,2 |

| org.javassist | javassist | 3.18.1-GA |

| org.jboss.logging | jboss-logging | 3.1.3.GA |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1.7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.11 | 3.5.3 |

| org.json4s | json4s-core_2.11 | 3.5.3 |

| org.json4s | json4s-jackson_2.11 | 3.5.3 |

| org.json4s | json4s-scalap_2.11 | 3.5.3 |

| org.lz4 | lz4-java | 1.4.0 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.mockito | mockito-core | 1.10.19 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | shims | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.11 | 2.11.12 |

| org.scala-lang | scala-library_2.11 | 2.11.12 |

| org.scala-lang | scala-reflect_2.11 | 2.11.12 |

| org.scala-lang.modules | scala-parser-combinators_2.11 | 1.1.0 |

| org.scala-lang.modules | scala-xml_2.11 | 1.0.5 |

| org.scala-sbt | test-interface | 1,0 |

| org.scalacheck | scalacheck_2.11 | 1.12.5 |

| org.scalactic | scalactic_2.11 | 3.0.3 |

| org.scalanlp | breeze-macros_2.11 | 0.13.2 |

| org.scalanlp | breeze_2.11 | 0.13.2 |

| org.scalatest | scalatest_2.11 | 3.0.3 |

| org.slf4j | jcl-over-slf4j | 1.7.16 |

| org.slf4j | jul-to-slf4j | 1.7.16 |

| org.slf4j | slf4j-api | 1.7.16 |

| org.slf4j | slf4j-log4j12 | 1.7.16 |

| org.spark-project.hive | hive-beeline | 1.2.1.spark2 |

| org.spark-project.hive | hive-cli | 1.2.1.spark2 |

| org.spark-project.hive | hive-jdbc | 1.2.1.spark2 |

| org.spark-project.hive | hive-metastore | 1.2.1.spark2 |

| org.spark-project.spark | unused | 1.0.0 |

| org.spire-math | spire-macros_2.11 | 0.13.0 |

| org.spire-math | spire_2.11 | 0.13.0 |

| org.springframework | spring-core | 4.1.4.RELEASE |

| org.springframework | spring-test | 4.1.4.RELEASE |

| org.tukaani | xz | 1.5 |

| org.typelevel | machinist_2.11 | 0.6.1 |

| org.typelevel | macro-compat_2.11 | 1.1.1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.3 |

| org.yaml | snakeyaml | 1.16 |

| oro | oro | 2.0.8 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0,52 |