Supervisa los modelos servidos mediante tablas de inferencia habilitadas para AI Gateway

Importante

Esta característica está en versión preliminar pública.

Importante

En este artículo se describen los temas que se aplican a las tablas de inferencia para modelos externos, cargas de trabajo de rendimiento aprovisionadas o modelos de agente. Para modelos personalizados, consulta las tablas de inferencia a fin de supervisar y depurar modelos.

En este artículo se describen las tablas de inferencia habilitadas por la pasarela de IA para supervisar los modelos servidos. La tabla de inferencia captura automáticamente las solicitudes entrantes y las respuestas salientes para un punto de conexión y las registra como una tabla de Unity Catalog Delta. Puede usar los datos de esta tabla para supervisar, evaluar, comparar y ajustar modelos de aprendizaje automático.

¿Qué son las tablas de inferencia habilitadas por la puerta de enlace de IA?

Las tablas de inferencia habilitadas para AI Gateway simplifican la supervisión y el diagnóstico de los modelos registrando continuamente las entradas y respuestas de solicitud (predicciones) de los puntos de conexión de Servicio del modelo de IA de Mosaic y guardándolos en una tabla Delta en Unity Catalog. Después, puede usar todas las funcionalidades de la plataforma de Databricks, como consultas y cuadernos SQL de Databricks para supervisar, depurar y optimizar los modelos.

Puede habilitar las tablas de inferencia en un punto de conexión existente o recién creado y las solicitudes a ese punto de conexión se registran automáticamente en una tabla en el Unity Catalog.

Algunas aplicaciones comunes para las tablas de inferencia son las siguientes:

- Cree un corpus de entrenamiento. Al unir tablas de inferencia con etiquetas de verdad básica, puede crear un corpus de entrenamiento que puede usar para volver a entrenar o ajustar y mejorar el modelo. Usando los trabajos de Databricks, puede configurar un bucle de retroalimentación continuo y automatizar el reentrenamiento.

- Supervisar la calidad de los datos y del modelo. Puede supervisar continuamente el rendimiento del modelo y el desfase de datos mediante la supervisión de Lakehouse. Lakehouse Monitoring genera automáticamente paneles de calidad de datos y modelos que puede compartir con las partes interesadas. Además, puede habilitar las alertas para saber cuándo necesita volver a entrenar el modelo en función de los cambios en los datos entrantes o las reducciones en el rendimiento del modelo.

- Depuración de problemas de producción. Las tablas de inferencia registran datos como códigos de estado HTTP, código JSON de solicitud y respuesta, tiempos de ejecución del modelo y salida de seguimientos durante los tiempos de ejecución del modelo. Puede usar estos datos de rendimiento con fines de depuración. También puede usar las tablas de inferencia de datos históricos para comparar el rendimiento del modelo en las solicitudes históricas.

Requisitos

Las tablas de inferencia habilitadas para AI Gateway solo se admiten para los puntos de conexión que usan rendimiento aprovisionado o sirven modelos externos.

Un área de trabajo de Databricks en cualquiera de las siguientes opciones:

En el caso de las áreas de trabajo que tienen conectividad privada configurada en la cuenta de almacenamiento del catálogo de Unity, siga los pasos descritos en Configurar conectividad privada desde la computación sin servidor.

Databricks recomienda habilitar la optimización predictiva para optimizar el rendimiento de las tablas de inferencia.

Su área de trabajo debe estar habilitada para Unity Catalog.

Tanto el creador del punto de conexión como el modificador deben tener el permiso Puede administrar en el punto de conexión. Consulte las Listas de control de acceso.

Tanto el creador del punto de conexión como el modificador deben tener los permisos siguientes en Unity Catalog:

- Permisos

USE CATALOGen el catálogo especificado. USE SCHEMApermisos en el esquema especificado.- Permisos

CREATE TABLEen el esquema.

- Permisos

Advertencia

La tabla de inferencia podría detener el registro de datos o dañarse si realiza alguna de las acciones siguientes:

- Se cambia el esquema de la tabla.

- Cambie el nombre de la tabla.

- Se elimina la tabla.

- Se pierden permisos en el catálogo o esquema de Unity Catalog.

Se habilitan y deshabilitan las tablas de inferencia

En esta sección se muestra cómo habilitar o deshabilitar tablas de inferencia mediante la interfaz de usuario de servicio. El propietario de las tablas de inferencia es el usuario que creó el punto de conexión. Todas las listas de control de acceso (ACL) de la tabla siguen los permisos estándar de Unity Catalog y el propietario de la tabla puede modificarlos.

Para habilitar tablas de inferencia durante la creación de puntos de conexión, siga estos pasos:

- Haz clic en Servir en la interfaz de usuario de Databricks Mosaic AI.

- Haga clic en Crear punto de conexión de servicio.

- En la sección AI Gateway, selecciona Habilitar tablas de inferencia.

También puede habilitar tablas de inferencia en un punto de conexión existente. Para editar una configuración de punto de conexión existente, haga lo siguiente:

- En la sección AI Gateway, haz clic en Editar AI Gateway.

- Seleccione Habilitar tablas de inferencia.

Siga estas instrucciones para deshabilitar las tablas de inferencia:

- Vaya a la página del punto de conexión.

- Haz clic en Editar AI Gateway.

- Haga clic en Habilitar tabla de inferencia para quitar la marca de verificación.

- Una vez que esté satisfecho con las especificaciones de AI Gateway, haga clic en Actualizar.

Consulta y análisis de resultados en la tabla de inferencia

Una vez que los modelos servidos estén listos, todas las solicitudes realizadas a los modelos se registran automáticamente en la tabla de inferencia, junto con las respuestas. Puede ver la tabla en la interfaz de usuario, consultar la tabla desde Databricks SQL o un cuaderno, o consultar la tabla mediante la API REST.

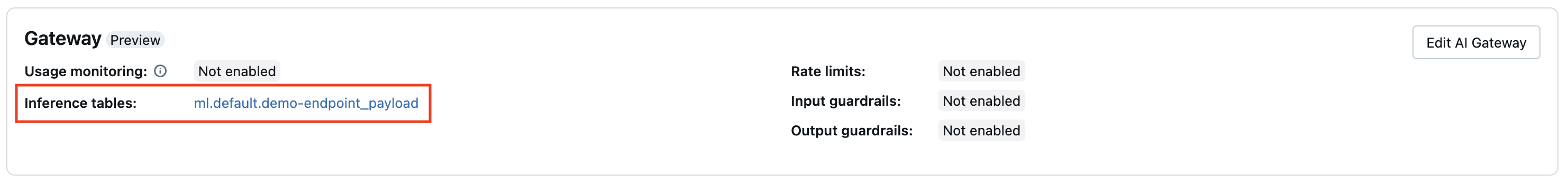

Para ver la tabla en la interfaz de usuario: en la página del punto de conexión, haga clic en el nombre de la tabla de inferencia para abrir la tabla en el Explorador de catálogos.

Para consultar la tabla desde Databricks SQL o un cuaderno de Databricks: puede ejecutar código similar al siguiente para consultar la tabla de inferencia.

SELECT * FROM <catalog>.<schema>.<payload_table>

** Para unir los datos de la tabla de inferencia con detalles sobre el modelo fundamental subyacente que se proporciona en el punto de conexión:** Los detalles del modelo fundamental se capturan en la tabla del sistema system.serving.served_entities.

SELECT * FROM <catalog>.<schema>.<payload_table> payload

JOIN system.serving.served_entities se on payload.served_entity_id = se.served_entity_id

Esquema de tabla de inferencia habilitada para AI Gateway

Las tablas de inferencia habilitadas mediante AI Gateway tienen el esquema siguiente:

| Nombre de la columna | Descripción | Tipo |

|---|---|---|

request_date |

Fecha UTC en la que se recibió la solicitud de servicio del modelo. | DATE |

databricks_request_id |

Identificador de solicitud generado por Azure Databricks adjunto a todas las solicitudes de servicio del modelo. | STRING |

request_time |

Marca de tiempo en la que se recibe la solicitud. | TIMESTAMP |

status_code |

El código de estado HTTP que se devolvió desde el modelo. | INT |

sampling_fraction |

La fracción de muestreo usada en caso de que la solicitud se muestree de forma descendente. Este valor está comprendido entre 0 y 1, donde 1 representa que se incluyeron el 100 % de las solicitudes entrantes. | DOUBLE |

execution_duration_ms |

Tiempo en milisegundos para el que el modelo realizó la inferencia. Esto no incluye latencias de red de sobrecarga y solo representa el tiempo necesario para que el modelo genere predicciones. | BIGINT |

request |

Cuerpo JSON de solicitud sin procesar que se envió al punto de conexión de servicio del modelo. | STRING |

response |

Cuerpo JSON de solicitud sin procesar que se envió al punto de conexión de servicio del modelo. | STRING |

served_entity_id |

Identificador único de la entidad atendida. | STRING |

logging_error_codes |

Errores que se produjeron cuando no se pudieron registrar los datos. Los códigos de error incluyen MAX_REQUEST_SIZE_EXCEEDED y MAX_RESPONSE_SIZE_EXCEEDED. |

ARRAY |

requester |

Identificador del usuario o principal de servicio cuyos permisos se utilizan para la solicitud de invocación del punto de servicio. | STRING |

Limitaciones

Cargas de trabajo de capacidad aprovisionada:

- Si creas un modelo de puntos de conexión de servicio que utiliza rendimiento aprovisionado, solo se admiten tablas de inferencia habilitadas para AI Gateway.

- Si tiene un modelo de puntos de conexión de servicio existente que usa el rendimiento aprovisionado y no tenía tablas de inferencia configuradas anteriormente, puede actualizarla para usar tablas de inferencia habilitadas para AI Gateway.

- Si tiene un modelo de puntos de conexión de servicio existente que usa el rendimiento aprovisionado y tiene tablas de inferencia actual o previamente configuradas, puede no actualizarla a fin de usar tablas de inferencia habilitadas para AI Gateway.

- Para los registros de respuesta del agente de IA en streaming, solo se agregan los campos y trazados compatibles con ChatCompletion.

La entrega de registros de tablas de inferencia es el mejor esfuerzo actualmente, pero puede esperar que los registros estén disponibles en un plazo de 1 hora a partir del momento de la solicitud. Póngase en contacto con el equipo de la cuenta de Databricks para obtener más información.

El tamaño máximo de solicitud y respuesta registrado es 1 MiB (1 048 576 bytes). Las cargas de solicitud y respuesta que superan esto se registran como

nullylogging_error_codesse rellenan conMAX_REQUEST_SIZE_EXCEEDEDoMAX_RESPONSE_SIZE_EXCEEDED.

Para conocer las limitaciones específicas de AI Gateway, consulte Limitaciones. Para conocer las limitaciones generales del modelo de puntos de conexión de servicio, consulta Límites y regiones del Modelo de servicio.