Transformación de datos mediante la ejecución de una definición de trabajo de Spark en Synapse

SE APLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

La actividad de definición de trabajo de Spark de Azure Synapse en una canalización ejecuta una definición de trabajo de Spark de Synapse en el área de trabajo de Azure Synapse Analytics. Este artículo se basa en el artículo sobre actividades de transformación de datos , que presenta información general de la transformación de datos y las actividades de transformación admitidas.

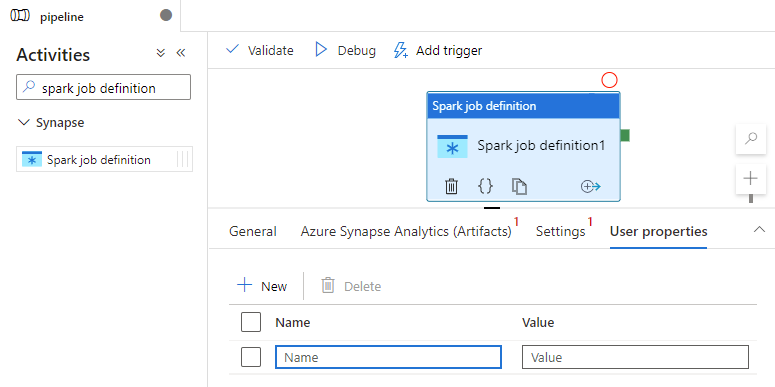

Establecimiento del lienzo de la definición de trabajo de Apache Spark

Para usar una actividad de definición de trabajo de Spark para Synapse en una canalización, complete los pasos siguientes:

Configuración general

Busque la definición de trabajo de Spark en el panel Actividades y arrastre una actividad de definición de trabajo de Spark en Synapse al lienzo de canalización.

Seleccione la nueva actividad de definición de trabajo de Spark en el lienzo si aún no lo ha hecho.

En la pestaña General, escriba “ejemplo” en el cuadro Nombre.

(Opción) También puede escribir una descripción.

Tiempo de espera: cantidad máxima de tiempo que se puede ejecutar una actividad. El valor predeterminado es siete días, que también es la cantidad máxima de tiempo permitida. El formato es D.HH:MM:SS.

Reintento: número máximo de reintentos.

Intervalo de reintento: número de segundos entre cada reintento.

Secure output (Salida segura): cuando se selecciona, no se captura en el registro la salida de la actividad.

Secure input (Entrada segura): cuando se selecciona, no se captura en el registro la entrada de la actividad.

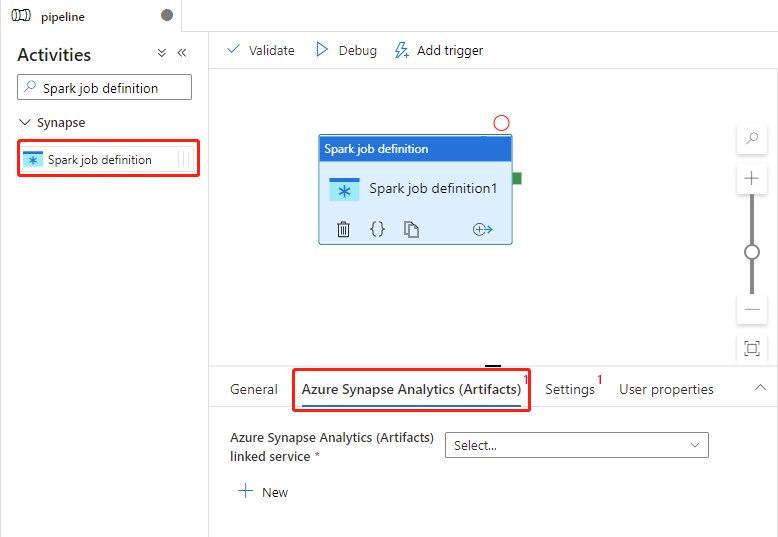

Configuración de Azure Synapse Analytics (Artifacts)

Seleccione la nueva actividad de definición de trabajo de Spark en el lienzo si aún no lo ha hecho.

Seleccione la pestaña Azure Synapse Analytics (Artifacts) para seleccionar o crear un nuevo servicio vinculado a Azure Synapse Analytics que ejecutará la actividad de definición de trabajo de Spark.

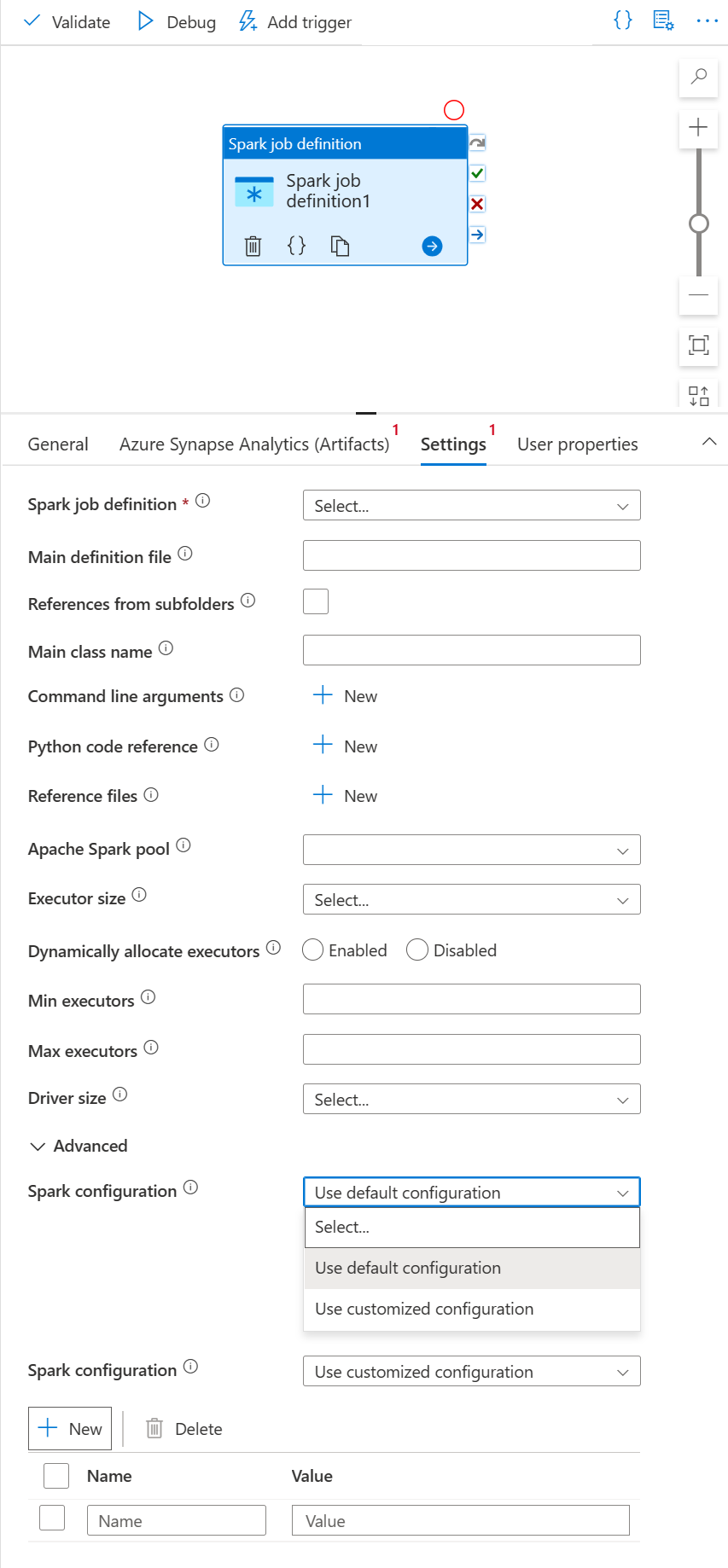

Pestaña Settings

Seleccione la nueva actividad de definición de trabajo de Spark en el lienzo si aún no lo ha hecho.

Seleccione la pestaña Configuración.

Expanda la lista definición de trabajo de Spark; puede seleccionar una definición de trabajo de Apache Spark existente en el área de trabajo de Azure Synapse Analytics vinculada.

(Opcional) Se puede rellenar la información de la definición de trabajo de Apache Spark. Si la configuración siguiente está vacía, se usará la configuración de la propia definición de trabajo de Spark para ejecutarse. Si la configuración siguiente no está vacía, esta configuración reemplazará la configuración de la propia definición de trabajo de Spark.

Propiedad Descripción Main definition file (Archivo de definición principal) Archivo principal usado para el trabajo. Seleccione un archivo PY/JAR/ZIP en el almacenamiento. Puede seleccionar Upload file (Cargar archivo) para cargar un archivo en una cuenta de almacenamiento.

Ejemplo:abfss://…/path/to/wordcount.jarReferencias de subcarpetas Examinar subcarpetas desde la carpeta raíz del archivo de definición principal, estos archivos se agregarán como archivos de referencia. Se analizarán las carpetas denominadas "jars", "pyFiles", "files" o "archives" y el nombre de las carpetas distingue mayúsculas de minúsculas. Nombre de clase principal Identificador completo o clase principal que se encuentra en el archivo de definición principal.

Ejemplo:WordCountArgumentos de la línea de comandos Puede agregar argumentos de línea de comandos al hacer clic en el botón Nuevo. Debe tener en cuenta que, al agregar argumentos de la línea de comandos, invalida los argumentos que establece la definición de trabajo de Spark.

Ejemplo:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultGrupo de Apache Spark Puede seleccionar el grupo de Apache Spark en la lista. Referencia de código de Python Archivos de código Python adicionales que se utilizan como referencia en el archivo de definición principal.

Admite pasar archivos (.py, .py3, .zip) a la propiedad "pyFiles". Invalidará la propiedad "pyFiles" definida en la definición de trabajo de Spark.Reference files (Archivos de referencia) Archivos adicionales usados como referencia en el archivo de definición principal. Grupo de Apache Spark Puede seleccionar el grupo de Apache Spark en la lista. Asignación dinámica de ejecutores Esta configuración se asigna a la propiedad de asignación dinámica de la configuración de Spark para la asignación de ejecutores de aplicaciones de Spark. Mínimo de ejecutores Número mínimo de ejecutores que se asignarán en el grupo de Spark especificado para el trabajo. Máximo de ejecutores Número máximo de ejecutores que se asignarán en el grupo de Spark especificado para el trabajo. Driver size (Tamaño del controlador) Número de núcleos y memoria que se van a usar para el controlador proporcionado en el grupo de Apache Spark especificado para el trabajo. Configuración de Spark Especifique valores para las propiedades de configuración de Spark indicadas en el tema: Spark Configuration - Application properties (Configuración de Spark: Propiedades de aplicación). Los usuarios pueden usar la configuración predeterminada y la configuración personalizada.

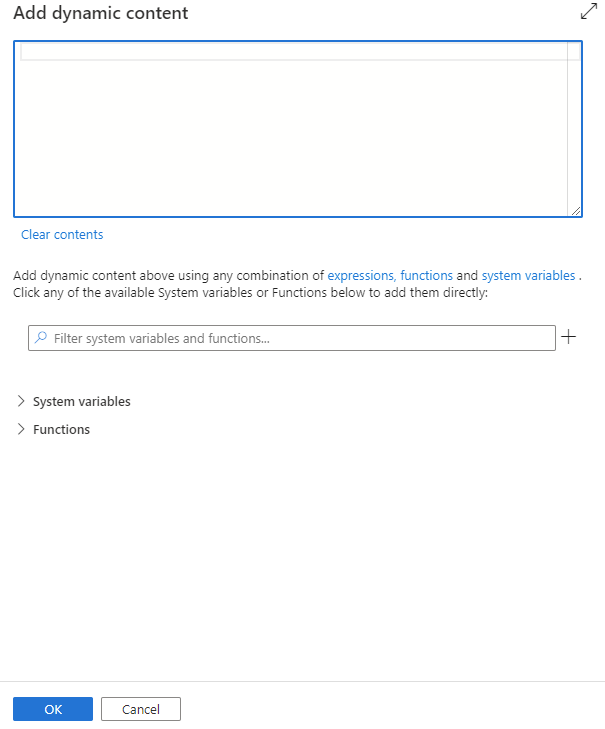

Puede agregar contenido dinámico haciendo clic en el botón Agregar contenido dinámico o presionando la tecla de método abreviado Alt+Mayús+D. En la página Agregar contenido dinámico, puede usar cualquier combinación de expresiones, funciones y variables del sistema para agregar contenido dinámico.

Pestaña Propiedades de usuario

Puede agregar propiedades para la actividad de definición de trabajo de Apache Spark en este panel.

Definición de la actividad de definición de trabajo de Spark en Azure Synapse

Esta es la definición JSON de ejemplo de una actividad de cuaderno de Azure Synapse Analytics:

{

"activities": [

{

"name": "Spark job definition1",

"type": "SparkJob",

"dependsOn": [],

"policy": {

"timeout": "7.00:00:00",

"retry": 0,

"retryIntervalInSeconds": 30,

"secureOutput": false,

"secureInput": false

},

"typeProperties": {

"sparkJob": {

"referenceName": {

"value": "Spark job definition 1",

"type": "Expression"

},

"type": "SparkJobDefinitionReference"

}

},

"linkedServiceName": {

"referenceName": "AzureSynapseArtifacts1",

"type": "LinkedServiceReference"

}

}

],

}

Propiedades de la definición de trabajo de Spark en Azure Synapse

En la siguiente tabla se describen las propiedades JSON que se usan en la definición de JSON:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| name | Nombre de la actividad en la canalización. | Sí |

| description | Texto que describe para qué se usa la actividad. | No |

| type | Para una actividad de definición de trabajo de Spark en Azure Synapse el tipo de actividad es SparkJob. | Sí |

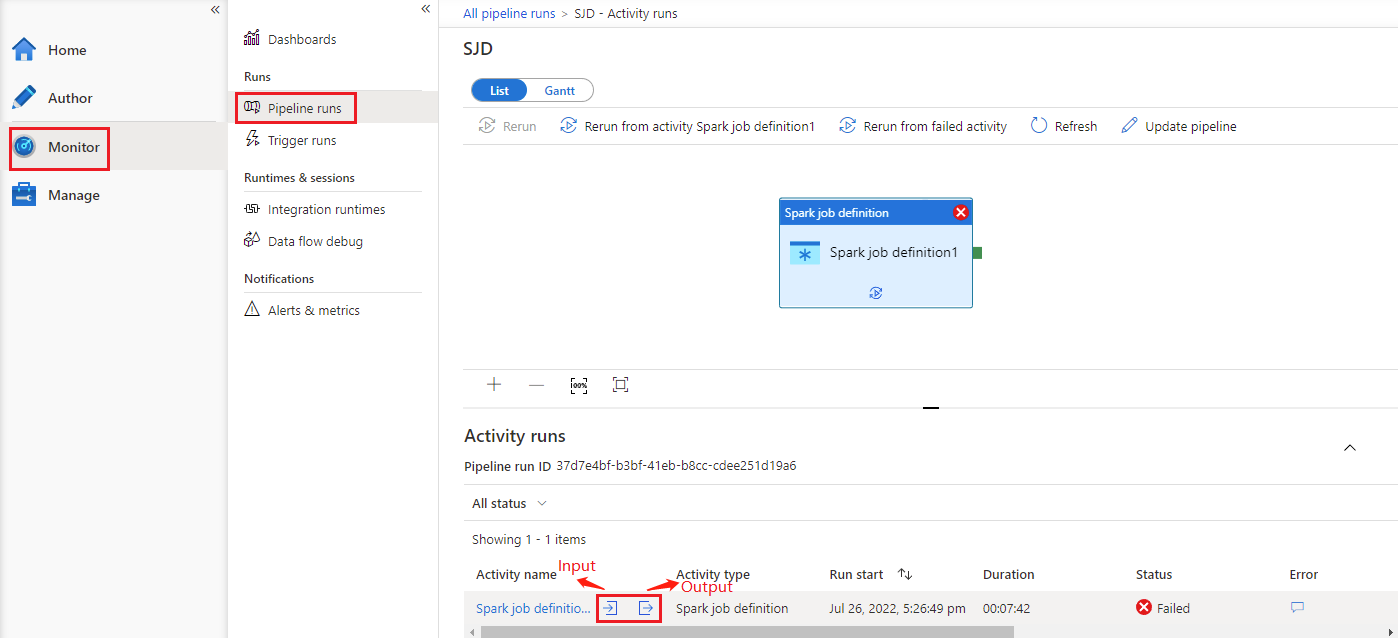

Consulte el historial de ejecución de la actividad de definición de trabajos de Spark en Azure Synapse.

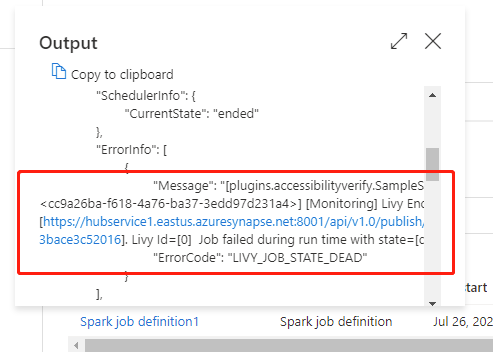

Vaya a Ejecuciones de canalización en la pestaña Supervisión; verá la canalización que ha desencadenado. Abra la canalización que contiene la actividad de definición de trabajo de Spark en Azure Synapse para ver el historial de ejecución.

Para ver la entrada o la salida de la actividad del cuaderno, seleccione los botones de entrada o salida. Si se produce un error de usuario en la canalización, seleccione la salida para comprobar el campo result (resultado) y ver el seguimiento de errores de usuario detallado.