Solución de problemas de los conectores de Azure Data Lake Storage en Azure Data Factory y Azure Synapse

SE APLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

En este artículo se proporcionan sugerencias para solucionar problemas comunes con los conectores de Azure Data Lake Storage Gen1 y Gen2 en Azure Data Factory y Azure Synapse.

Azure Data Lake Storage Gen1

Mensaje de error: Se ha cerrado la conexión subyacente: No se ha podido establecer la relación de confianza para el canal seguro SSL/TLS.

Síntomas: Se produce el siguiente error en la actividad de copia:

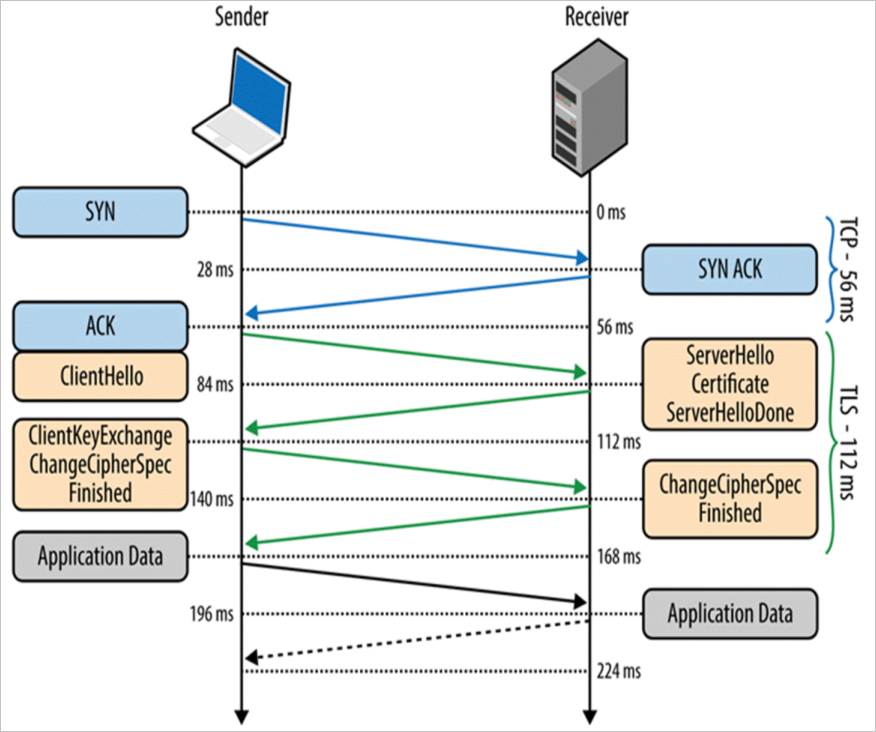

Message: ErrorCode = UserErrorFailedFileOperation, Error Message = The underlying connection was closed: Could not establish trust relationship for the SSL/TLS secure channel.Causa: Error de validación de certificado durante el protocolo de enlace TLS.

Solución: Como solución alternativa, use la copia almacenada provisionalmente para omitir la validación de seguridad de la capa de transporte (TLS) en Azure Data Lake Storage Gen1. Debe reproducir este problema y recopilar el seguimiento de supervisión de la red (netmon) y, luego, que el equipo de red participe en la comprobación de la configuración de la red local.

Mensaje de error: Error en el servidor remoto: (403) Prohibido

Síntomas: Se produce el siguiente error en la actividad de copia:

Message: The remote server returned an error: (403) Forbidden. Response details: {"RemoteException":{"exception":"AccessControlException""message":"CREATE failed with error 0x83090aa2 (Forbidden. ACL verification failed. Either the resource does not exist or the user is not authorized to perform the requested operation.)....Causa: Una posible causa es que la entidad de servicio o la identidad administrada que usa no tengan permiso para acceder a determinadas carpetas o archivos.

Solución: Conceda los permisos correspondientes a todas las carpetas y subcarpetas que necesite copiar. Para obtener más información, consulte Copia de datos hacia o desde Azure Data Lake Storage Gen1.

Mensaje de error: No se pudo obtener el token de acceso mediante la entidad de servicio. Error de ADAL: service_unavailable

Síntomas: Se produce el siguiente error en la actividad de copia:

Failed to get access token by using service principal. ADAL Error: service_unavailable, The remote server returned an error: (503) Server Unavailable.Causa: cuando el servicio de token de seguridad (STS) propiedad de Microsoft Entra ID no está disponible, significa que está demasiado ocupado para administrar las solicitudes y devuelve un error HTTP 503.

Solución: Vuelva a ejecutar la actividad de copia después de unos minutos.

Azure Data Lake Storage Gen2

Código de error: ADLSGen2OperationFailed

Mensaje:

ADLS Gen2 operation failed for: %adlsGen2Message;.%exceptionData;.Causas y recomendaciones: diversas causas pueden provocar este error. Busque en la lista siguiente el análisis de las posibles causas y la recomendación relacionada.

Análisis de las causas Recomendación Si Azure Data Lake Storage Gen2 genera un error que indica que alguna operación no funcionó. Compruebe el mensaje de error detallado que ha generado Azure Data Lake Storage Gen2. Si el error es transitorio, vuelva a intentar la operación. Si necesita más ayuda, póngase en contacto con el soporte técnico de Azure Storage y proporcione el identificador de la solicitud del mensaje de error. Si el mensaje de error contiene la cadena "Prohibido", es posible que la entidad de servicio o la identidad administrada que está usando no tengan permisos suficientes para acceder a Azure Data Lake Storage Gen2. Para solucionar este error, consulte Copia y transformación de los datos de Azure Data Lake Storage Gen2. Si el mensaje de error contiene la cadena "InternalServerError", Azure Data Lake Storage Gen2 devuelve el error. El error podría deberse a un problema temporal. Si es así, vuelva a intentar la operación. Si el problema persiste, póngase en contacto con el soporte técnico de Azure Storage y proporcione el identificador de solicitud del mensaje de error. Si el mensaje de error es Unable to read data from the transport connection: An existing connection was forcibly closed by the remote host, el entorno de ejecución de integración tiene un problema de red al conectarse a Azure Data Lake Storage Gen2.En la configuración de la regla de firewall de Azure Data Lake Storage Gen2, asegúrese de que las direcciones IP de Azure Data Factory están en la lista de permitidos. Para más información, vea Configuración de Firewalls y redes virtuales de Azure Storage. Si el mensaje de error es This endpoint does not support BlobStorageEvents or SoftDelete, está utilizando un servicio vinculado de Azure Data Lake Storage Gen2 para conectarse a una cuenta de Azure Blob Storage que habilita eventos o eliminación temporal de Blob Storage.Pruebe lo siguiente:

1. Si aún quiere usar un servicio vinculado de Azure Data Lake Storage Gen2, actualice la instancia de Azure Blob Storage a Azure Data Lake Storage Gen2. Para más información, consulte Actualización de Azure Blob Storage con funcionalidades de Azure Data Lake Storage Gen2.

2. Cambie el servicio vinculado a Azure Blob Storage.

3. Deshabilite eventos o eliminación temporal de Blob Storage en su cuenta de Azure Blob Storage.

Al realizar una solicitud a la cuenta de Azure Data Lake Storage Gen2, se produce un error de tiempo de espera

Message:

- Código de error =

UserErrorFailedBlobFSOperation - Mensaje de error =

BlobFS operation failed for: A task was canceled.

- Código de error =

Causa: El problema se debe al error de tiempo de espera del receptor de Azure Data Lake Storage Gen2, que suele producirse en la máquina del entorno de ejecución de integración autohospedado.

Recomendación:

Si es posible, coloque la máquina del entorno de ejecución de integración autohospedado y la cuenta de Azure Data Lake Storage Gen2 de destino en la misma región. Esta solución puede ayudar a evitar errores de tiempo de espera aleatorios y produce un mejor rendimiento.

Compruebe si hay una configuración de red especial, como ExpressRoute, y asegúrese de que la red tenga suficiente ancho de banda. Cuando el ancho de banda total sea bajo, se recomienda reducir la configuración de trabajos simultáneos del entorno de ejecución de integración autohospedado. Esto puede ayudar a evitar la competencia por los recursos de red en varios trabajos simultáneos.

Si el tamaño de archivo es moderado o pequeño, use un tamaño de bloque menor para la copia no binaria a fin de mitigar este error de tiempo de espera. Para más información, consulte Operación Put Block de Blob Storage.

Para especificar el tamaño de bloque personalizado, edite la propiedad en el editor de archivos JSON como se muestra aquí:

"sink": { "type": "DelimitedTextSink", "storeSettings": { "type": "AzureBlobFSWriteSettings", "blockSizeInMB": 8 } }

La actividad de copia no puede seleccionar archivos de Azure Data Lake Storage Gen2

Síntomas: la actividad de copia no puede seleccionar archivos de Azure Data Lake Storage Gen2 cuando el nombre de archivo es "Asset_Metadata". El problema solo se produce en el conjunto de datos de tipo Parquet. Otros tipos de conjuntos de datos con el mismo nombre de archivo funcionan correctamente.

Causa: por compatibilidad con versiones anteriores,

_metadatase trata como una subcadena reservada en el nombre de archivo.Recomendación: cambie el nombre de archivo para evitar la lista reservada para Parquet que se incluye a continuación:

- El nombre de archivo contiene

_metadata. - El nombre de archivo comienza por

.(punto).

- El nombre de archivo contiene

Código de error: ADLSGen2ForbiddenError

Mensaje:

ADLS Gen2 failed for forbidden: Storage operation % on % get failed with 'Operation returned an invalid status code 'Forbidden'.Causa: Hay dos causas posibles:

- El acceso a la red bloquea el entorno de ejecución de integración en la configuración del firewall de la cuenta de almacenamiento de Azure.

- La entidad de servicio o la identidad administrada no tienen permisos suficientes para acceder a los datos.

Recomendación:

Compruebe la configuración de red de la cuenta de almacenamiento de Azure para ver si está deshabilitado el acceso a la red pública. Si está deshabilitado, use un entorno de ejecución de integración de red virtual administrada y cree un punto de conexión privado para acceder. Para obtener más información, consulte Red virtual administrada de Azure Data Factory y Copia de datos de forma segura desde Azure Blob Storage a SQL Database mediante puntos de conexión privados.

Si ha habilitado algunas redes virtuales y direcciones IP en la configuración de red de su cuenta de almacenamiento de Azure:

Es posible porque la configuración del firewall de la cuenta de almacenamiento no permite algunos intervalos de direcciones IP del entorno de ejecución de integración. Agregue las direcciones IP de Azure Integration Runtime o la dirección IP del entorno de ejecución de integración autohospedado al firewall de la cuenta de almacenamiento. Para las direcciones IP de Azure Integration Runtime, consulte Direcciones IP de Azure Integration Runtime, y para saber cómo agregar intervalos IP al firewall de la cuenta de almacenamiento, consulte Administración de reglas de red IP.

Si permite que los servicios de Azure de confianza accedan a esta cuenta de almacenamiento en el firewall, debe usar la autenticación con identidad administrada en la actividad de copia.

Para obtener más información sobre la configuración de los firewalls de cuentas de almacenamiento de Azure, consulte Configuración de redes virtuales y firewalls de Azure Storage.

Si usa la autenticación con entidad de servicio o con identidad administrada, conceda los permisos adecuados a la entidad de servicio o a la identidad administrada para realizar la copia. Para el origen, al menos el rol Lector de datos de Storage Blob. Para el receptor, al menos el rol Colaborador de datos de Storage Blob. Para obtener más información, consulte Copia y transformación de datos en Azure Data Lake Storage Gen2 mediante Azure Data Factory o Azure Synapse Analytics.

Contenido relacionado

Para obtener ayuda para solucionar problemas, pruebe estos recursos: