Inicio rápido: Adición de llamadas de vídeo 1:1 a la aplicación

Puede empezar a usar Azure Communication Services con Calling SDK de Azure Communication Services para agregar llamadas individuales de vídeo a la aplicación. Aprenderá a iniciar videollamadas y a responder a ellas con el SDK de llamada de Azure Communication Services para JavaScript.

Código de ejemplo

Si quiere ir directamente al final, puede descargar esta guía de inicio rápido como ejemplo desde GitHub.

Nota

Se puede acceder a las llamadas salientes a un usuario de Azure Communication Services mediante la biblioteca de interfaz de usuario de Azure Communication Services. La biblioteca de interfaz de usuario permite a los desarrolladores agregar un cliente de llamada habilitado para VoIP en su aplicación con solo un par de líneas de código.

Prerrequisitos

Obtenga una cuenta de Azure con una suscripción activa. Cree una cuenta gratuita.

Necesita tener Node.js 18. Puede usar el instalador msi para instalarlo.

Cree un recurso activo de Communication Services. Cree un recurso de Communication Services. Debe registrar la cadena de conexión para esta guía de inicio rápido.

Cree un token de acceso de usuario para crear una instancia del cliente de llamada. Creación y administración de tokens de acceso. También puede usar la CLI de Azure y ejecutar el comando siguiente con la cadena de conexión para crear un usuario y un token de acceso.

az communication identity token issue --scope voip --connection-string "yourConnectionString"Para más información, consulte Uso de la CLI de Azure para crear y administrar tokens de acceso.

Instalación

Creación de una aplicación Node.js

Abra la ventana de comandos o de terminal, cree un nuevo directorio para la aplicación y navegue hasta este.

mkdir calling-quickstart && cd calling-quickstart

Ejecute npm init -y para crear un archivo package.json con la configuración predeterminada.

npm init -y

Instalar el paquete

Use el comando npm install para instalar el SDK de llamadas de Azure Communication Services para JavaScript.

npm install @azure/communication-common --save

npm install @azure/communication-calling --save

Instalación del marco de la aplicación

Esta guía de inicio rápido usa webpack para agrupar los recursos de la aplicación. Ejecute el siguiente comando para instalar los paquetes npm webpack, webpack-cli y webpack-dev-server, y los enumera como dependencias de desarrollo en el archivo package.json:

npm install copy-webpack-plugin@^11.0.0 webpack@^5.88.2 webpack-cli@^5.1.4 webpack-dev-server@^4.15.1 --save-dev

Este es el código:

Cree un archivo index.html en el directorio raíz del proyecto. Este archivo lo usamos para configurar un diseño básico que permitirá al usuario realizar una llamada de video 1:1.

<!-- index.html -->

<!DOCTYPE html>

<html>

<head>

<title>Azure Communication Services - Calling Web SDK</title>

<link rel="stylesheet" type="text/css" href="styles.css"/>

</head>

<body>

<h4>Azure Communication Services - Calling Web SDK</h4>

<input id="user-access-token"

type="text"

placeholder="User access token"

style="margin-bottom:1em; width: 500px;"/>

<button id="initialize-call-agent" type="button">Initialize Call Agent</button>

<br>

<br>

<input id="callee-acs-user-id"

type="text"

placeholder="Enter callee's Azure Communication Services user identity in format: '8:acs:resourceId_userId'"

style="margin-bottom:1em; width: 500px; display: block;"/>

<button id="start-call-button" type="button" disabled="true">Start Call</button>

<button id="hangup-call-button" type="button" disabled="true">Hang up Call</button>

<button id="accept-call-button" type="button" disabled="true">Accept Call</button>

<button id="start-video-button" type="button" disabled="true">Start Video</button>

<button id="stop-video-button" type="button" disabled="true">Stop Video</button>

<br>

<br>

<div id="connectedLabel" style="color: #13bb13;" hidden>Call is connected!</div>

<br>

<div id="remoteVideosGallery" style="width: 40%;" hidden>Remote participants' video streams:</div>

<br>

<div id="localVideoContainer" style="width: 30%;" hidden>Local video stream:</div>

<!-- points to the bundle generated from client.js -->

<script src="./main.js"></script>

</body>

</html>

Las siguientes clases e interfaces controlan algunas de las características principales del SDK de llamadas de Azure Communication Services:

| Nombre | Descripción |

|---|---|

CallClient |

El punto de entrada principal al SDK de llamadas. |

AzureCommunicationTokenCredential |

Implementa la interfaz de CommunicationTokenCredential, que se usa para crear instancias de callAgent. |

CallAgent |

Se utiliza para iniciar y administrar las llamadas. |

DeviceManager |

Se usa para administrar dispositivos multimedia. |

Call |

Se usa para representar una llamada. |

LocalVideoStream |

Se usa para crear una secuencia de vídeo local para un dispositivo de cámara en el sistema local. |

RemoteParticipant |

Se usa para representar a un participante remoto de la llamada. |

RemoteVideoStream |

Se usa para representar una secuencia de vídeo remota desde un participante remoto. |

Cree un archivo en el directorio raíz del proyecto denominado index.js que contendrá la lógica de la aplicación para esta guía de inicio rápido. Agregue el código siguiente a index.js:

// Make sure to install the necessary dependencies

const { CallClient, VideoStreamRenderer, LocalVideoStream } = require('@azure/communication-calling');

const { AzureCommunicationTokenCredential } = require('@azure/communication-common');

const { AzureLogger, setLogLevel } = require("@azure/logger");

// Set the log level and output

setLogLevel('verbose');

AzureLogger.log = (...args) => {

console.log(...args);

};

// Calling web sdk objects

let callAgent;

let deviceManager;

let call;

let incomingCall;

let localVideoStream;

let localVideoStreamRenderer;

// UI widgets

let userAccessToken = document.getElementById('user-access-token');

let calleeAcsUserId = document.getElementById('callee-acs-user-id');

let initializeCallAgentButton = document.getElementById('initialize-call-agent');

let startCallButton = document.getElementById('start-call-button');

let hangUpCallButton = document.getElementById('hangup-call-button');

let acceptCallButton = document.getElementById('accept-call-button');

let startVideoButton = document.getElementById('start-video-button');

let stopVideoButton = document.getElementById('stop-video-button');

let connectedLabel = document.getElementById('connectedLabel');

let remoteVideosGallery = document.getElementById('remoteVideosGallery');

let localVideoContainer = document.getElementById('localVideoContainer');

/**

* Using the CallClient, initialize a CallAgent instance with a CommunicationUserCredential which will enable us to make outgoing calls and receive incoming calls.

* You can then use the CallClient.getDeviceManager() API instance to get the DeviceManager.

*/

initializeCallAgentButton.onclick = async () => {

try {

const callClient = new CallClient();

tokenCredential = new AzureCommunicationTokenCredential(userAccessToken.value.trim());

callAgent = await callClient.createCallAgent(tokenCredential)

// Set up a camera device to use.

deviceManager = await callClient.getDeviceManager();

await deviceManager.askDevicePermission({ video: true });

await deviceManager.askDevicePermission({ audio: true });

// Listen for an incoming call to accept.

callAgent.on('incomingCall', async (args) => {

try {

incomingCall = args.incomingCall;

acceptCallButton.disabled = false;

startCallButton.disabled = true;

} catch (error) {

console.error(error);

}

});

startCallButton.disabled = false;

initializeCallAgentButton.disabled = true;

} catch(error) {

console.error(error);

}

}

/**

* Place a 1:1 outgoing video call to a user

* Add an event listener to initiate a call when the `startCallButton` is clicked:

* First you have to enumerate local cameras using the deviceManager `getCameraList` API.

* In this quickstart we're using the first camera in the collection. Once the desired camera is selected, a

* LocalVideoStream instance will be constructed and passed within `videoOptions` as an item within the

* localVideoStream array to the call method. Once your call connects it will automatically start sending a video stream to the other participant.

*/

startCallButton.onclick = async () => {

try {

const localVideoStream = await createLocalVideoStream();

const videoOptions = localVideoStream ? { localVideoStreams: [localVideoStream] } : undefined;

call = callAgent.startCall([{ communicationUserId: calleeAcsUserId.value.trim() }], { videoOptions });

// Subscribe to the call's properties and events.

subscribeToCall(call);

} catch (error) {

console.error(error);

}

}

/**

* Accepting an incoming call with video

* Add an event listener to accept a call when the `acceptCallButton` is clicked:

* After subscribing to the `CallAgent.on('incomingCall')` event, you can accept the incoming call.

* You can pass the local video stream which you want to use to accept the call with.

*/

acceptCallButton.onclick = async () => {

try {

const localVideoStream = await createLocalVideoStream();

const videoOptions = localVideoStream ? { localVideoStreams: [localVideoStream] } : undefined;

call = await incomingCall.accept({ videoOptions });

// Subscribe to the call's properties and events.

subscribeToCall(call);

} catch (error) {

console.error(error);

}

}

/**

* Subscribe to a call obj.

* Listen for property changes and collection updates.

*/

subscribeToCall = (call) => {

try {

// Inspect the initial call.id value.

console.log(`Call Id: ${call.id}`);

//Subscribe to call's 'idChanged' event for value changes.

call.on('idChanged', () => {

console.log(`Call Id changed: ${call.id}`);

});

// Inspect the initial call.state value.

console.log(`Call state: ${call.state}`);

// Subscribe to call's 'stateChanged' event for value changes.

call.on('stateChanged', async () => {

console.log(`Call state changed: ${call.state}`);

if(call.state === 'Connected') {

connectedLabel.hidden = false;

acceptCallButton.disabled = true;

startCallButton.disabled = true;

hangUpCallButton.disabled = false;

startVideoButton.disabled = false;

stopVideoButton.disabled = false;

remoteVideosGallery.hidden = false;

} else if (call.state === 'Disconnected') {

connectedLabel.hidden = true;

startCallButton.disabled = false;

hangUpCallButton.disabled = true;

startVideoButton.disabled = true;

stopVideoButton.disabled = true;

console.log(`Call ended, call end reason={code=${call.callEndReason.code}, subCode=${call.callEndReason.subCode}}`);

}

});

call.on('isLocalVideoStartedChanged', () => {

console.log(`isLocalVideoStarted changed: ${call.isLocalVideoStarted}`);

});

console.log(`isLocalVideoStarted: ${call.isLocalVideoStarted}`);

call.localVideoStreams.forEach(async (lvs) => {

localVideoStream = lvs;

await displayLocalVideoStream();

});

call.on('localVideoStreamsUpdated', e => {

e.added.forEach(async (lvs) => {

localVideoStream = lvs;

await displayLocalVideoStream();

});

e.removed.forEach(lvs => {

removeLocalVideoStream();

});

});

// Inspect the call's current remote participants and subscribe to them.

call.remoteParticipants.forEach(remoteParticipant => {

subscribeToRemoteParticipant(remoteParticipant);

});

// Subscribe to the call's 'remoteParticipantsUpdated' event to be

// notified when new participants are added to the call or removed from the call.

call.on('remoteParticipantsUpdated', e => {

// Subscribe to new remote participants that are added to the call.

e.added.forEach(remoteParticipant => {

subscribeToRemoteParticipant(remoteParticipant)

});

// Unsubscribe from participants that are removed from the call

e.removed.forEach(remoteParticipant => {

console.log('Remote participant removed from the call.');

});

});

} catch (error) {

console.error(error);

}

}

/**

* Subscribe to a remote participant obj.

* Listen for property changes and collection updates.

*/

subscribeToRemoteParticipant = (remoteParticipant) => {

try {

// Inspect the initial remoteParticipant.state value.

console.log(`Remote participant state: ${remoteParticipant.state}`);

// Subscribe to remoteParticipant's 'stateChanged' event for value changes.

remoteParticipant.on('stateChanged', () => {

console.log(`Remote participant state changed: ${remoteParticipant.state}`);

});

// Inspect the remoteParticipants's current videoStreams and subscribe to them.

remoteParticipant.videoStreams.forEach(remoteVideoStream => {

subscribeToRemoteVideoStream(remoteVideoStream)

});

// Subscribe to the remoteParticipant's 'videoStreamsUpdated' event to be

// notified when the remoteParticipant adds new videoStreams and removes video streams.

remoteParticipant.on('videoStreamsUpdated', e => {

// Subscribe to new remote participant's video streams that were added.

e.added.forEach(remoteVideoStream => {

subscribeToRemoteVideoStream(remoteVideoStream)

});

// Unsubscribe from remote participant's video streams that were removed.

e.removed.forEach(remoteVideoStream => {

console.log('Remote participant video stream was removed.');

})

});

} catch (error) {

console.error(error);

}

}

/**

* Subscribe to a remote participant's remote video stream obj.

* You have to subscribe to the 'isAvailableChanged' event to render the remoteVideoStream. If the 'isAvailable' property

* changes to 'true', a remote participant is sending a stream. Whenever availability of a remote stream changes

* you can choose to destroy the whole 'Renderer', a specific 'RendererView' or keep them, but this will result in displaying blank video frame.

*/

subscribeToRemoteVideoStream = async (remoteVideoStream) => {

let renderer = new VideoStreamRenderer(remoteVideoStream);

let view;

let remoteVideoContainer = document.createElement('div');

remoteVideoContainer.className = 'remote-video-container';

let loadingSpinner = document.createElement('div');

loadingSpinner.className = 'loading-spinner';

remoteVideoStream.on('isReceivingChanged', () => {

try {

if (remoteVideoStream.isAvailable) {

const isReceiving = remoteVideoStream.isReceiving;

const isLoadingSpinnerActive = remoteVideoContainer.contains(loadingSpinner);

if (!isReceiving && !isLoadingSpinnerActive) {

remoteVideoContainer.appendChild(loadingSpinner);

} else if (isReceiving && isLoadingSpinnerActive) {

remoteVideoContainer.removeChild(loadingSpinner);

}

}

} catch (e) {

console.error(e);

}

});

const createView = async () => {

// Create a renderer view for the remote video stream.

view = await renderer.createView();

// Attach the renderer view to the UI.

remoteVideoContainer.appendChild(view.target);

remoteVideosGallery.appendChild(remoteVideoContainer);

}

// Remote participant has switched video on/off

remoteVideoStream.on('isAvailableChanged', async () => {

try {

if (remoteVideoStream.isAvailable) {

await createView();

} else {

view.dispose();

remoteVideosGallery.removeChild(remoteVideoContainer);

}

} catch (e) {

console.error(e);

}

});

// Remote participant has video on initially.

if (remoteVideoStream.isAvailable) {

try {

await createView();

} catch (e) {

console.error(e);

}

}

}

/**

* Start your local video stream.

* This will send your local video stream to remote participants so they can view it.

*/

startVideoButton.onclick = async () => {

try {

const localVideoStream = await createLocalVideoStream();

await call.startVideo(localVideoStream);

} catch (error) {

console.error(error);

}

}

/**

* Stop your local video stream.

* This will stop your local video stream from being sent to remote participants.

*/

stopVideoButton.onclick = async () => {

try {

await call.stopVideo(localVideoStream);

} catch (error) {

console.error(error);

}

}

/**

* To render a LocalVideoStream, you need to create a new instance of VideoStreamRenderer, and then

* create a new VideoStreamRendererView instance using the asynchronous createView() method.

* You may then attach view.target to any UI element.

*/

createLocalVideoStream = async () => {

const camera = (await deviceManager.getCameras())[0];

if (camera) {

return new LocalVideoStream(camera);

} else {

console.error(`No camera device found on the system`);

}

}

/**

* Display your local video stream preview in your UI

*/

displayLocalVideoStream = async () => {

try {

localVideoStreamRenderer = new VideoStreamRenderer(localVideoStream);

const view = await localVideoStreamRenderer.createView();

localVideoContainer.hidden = false;

localVideoContainer.appendChild(view.target);

} catch (error) {

console.error(error);

}

}

/**

* Remove your local video stream preview from your UI

*/

removeLocalVideoStream = async() => {

try {

localVideoStreamRenderer.dispose();

localVideoContainer.hidden = true;

} catch (error) {

console.error(error);

}

}

/**

* End current call

*/

hangUpCallButton.addEventListener("click", async () => {

// end the current call

await call.hangUp();

});

Cree un archivo en el directorio raíz del proyecto denominado styles.css que contendrá el estilo de la aplicación para esta guía de inicio rápido. Agregue el código siguiente a styles.css:

/**

* CSS for styling the loading spinner over the remote video stream

*/

.remote-video-container {

position: relative;

}

.loading-spinner {

border: 12px solid #f3f3f3;

border-radius: 50%;

border-top: 12px solid #ca5010;

width: 100px;

height: 100px;

-webkit-animation: spin 2s linear infinite; /* Safari */

animation: spin 2s linear infinite;

position: absolute;

margin: auto;

top: 0;

bottom: 0;

left: 0;

right: 0;

transform: translate(-50%, -50%);

}

@keyframes spin {

0% { transform: rotate(0deg); }

100% { transform: rotate(360deg); }

}

/* Safari */

@-webkit-keyframes spin {

0% { -webkit-transform: rotate(0deg); }

100% { -webkit-transform: rotate(360deg); }

}

Agregar el código del servidor local del paquete web

Cree un archivo en el directorio raíz del proyecto denominado webpack.config.js que contendrá la lógica de la aplicación para esta guía de inicio rápido. Agregue el siguiente código a webpack.config.js:

const path = require('path');

const CopyPlugin = require("copy-webpack-plugin");

module.exports = {

mode: 'development',

entry: './index.js',

output: {

filename: 'main.js',

path: path.resolve(__dirname, 'dist'),

},

devServer: {

static: {

directory: path.join(__dirname, './')

},

},

plugins: [

new CopyPlugin({

patterns: [

'./index.html'

]

}),

]

};

Ejecución del código

Utilice webpack-dev-server para compilar y ejecutar la aplicación. Ejecute el siguiente comando para agrupar el host de aplicación en un servidor web local:

npx webpack serve --config webpack.config.js

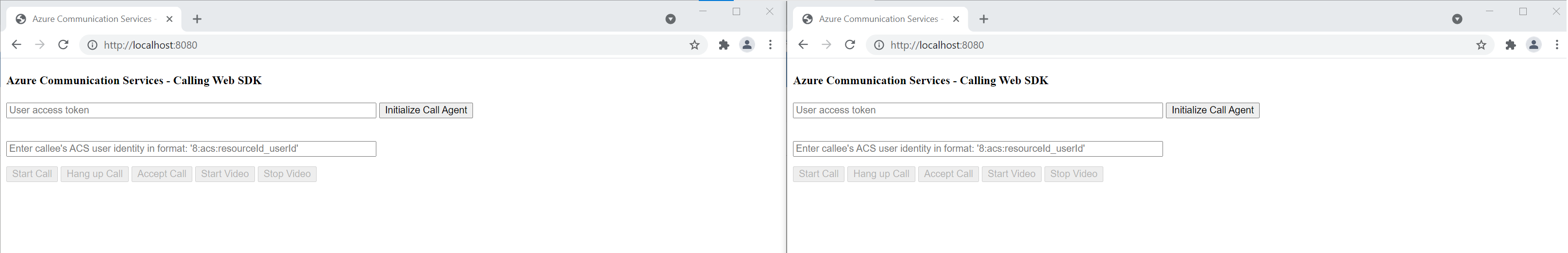

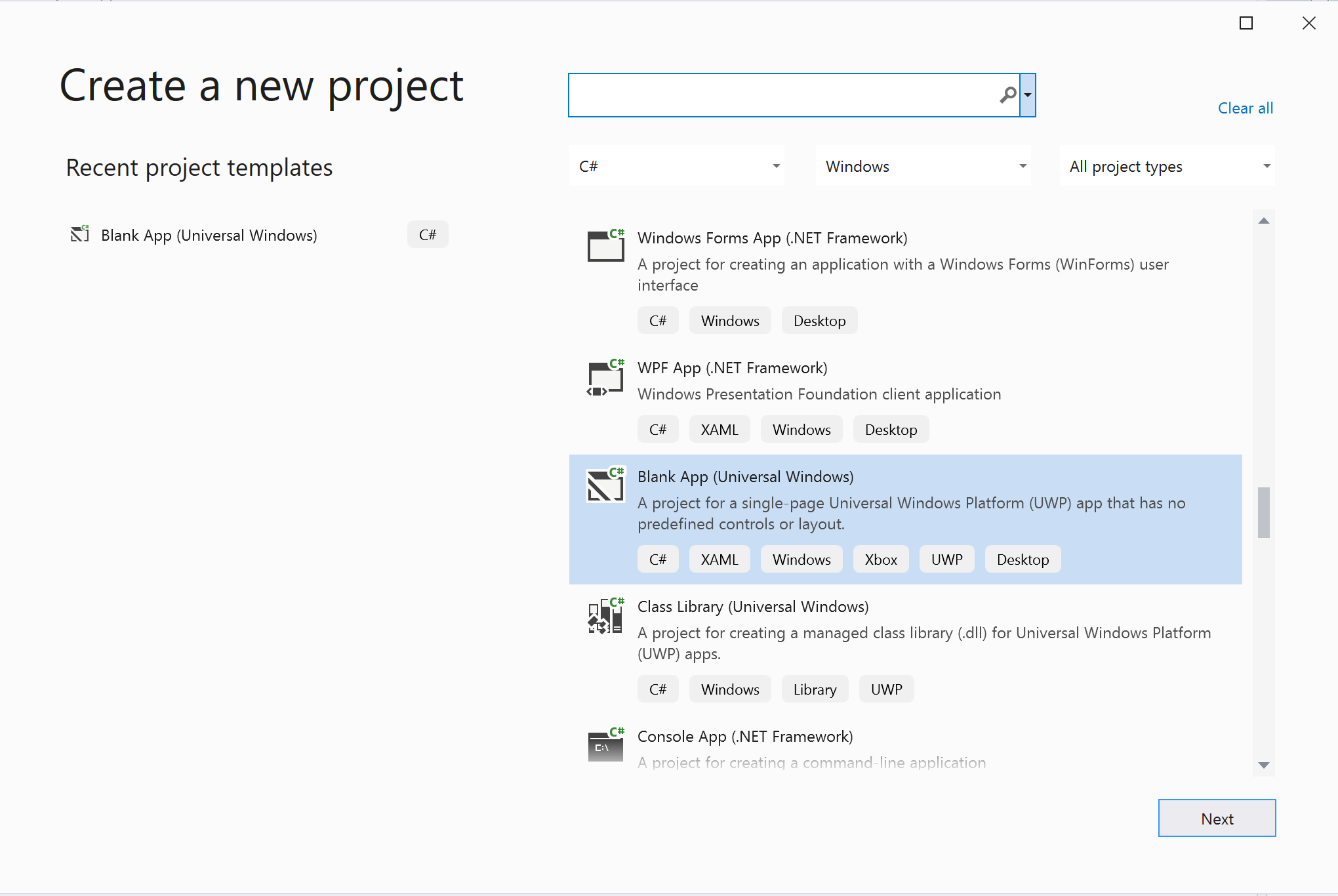

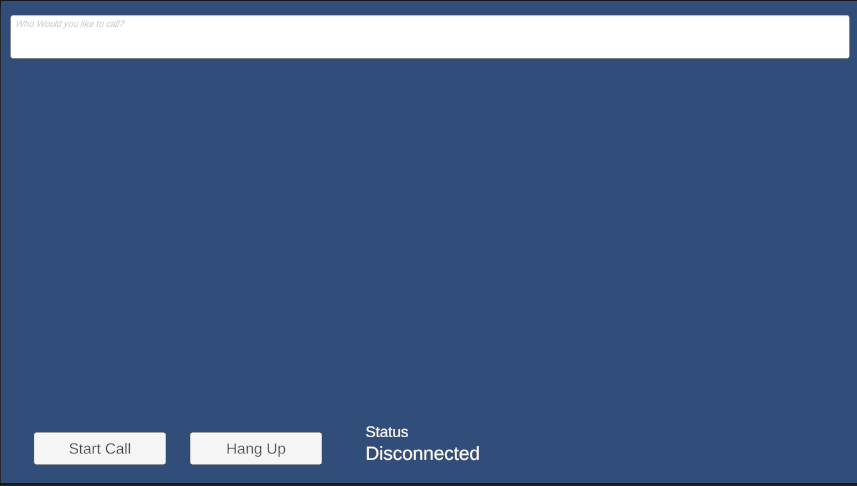

Abra el explorador y, en dos pestañas, vaya a http://localhost:8080/.You donde debería ver la siguiente pantalla:

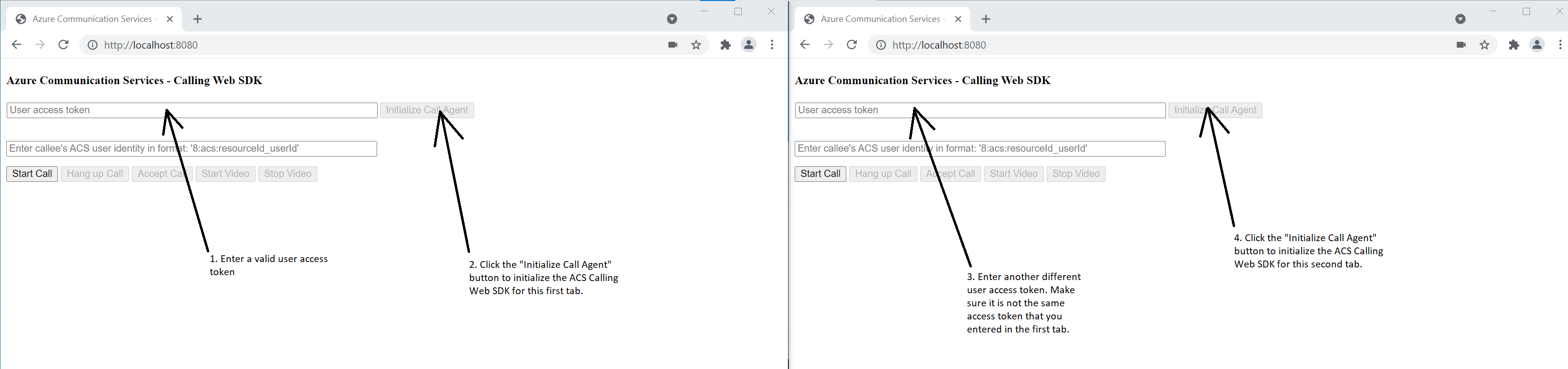

En la primera pestaña, ingrese un token de acceso de usuario válido y, en la otra pestaña, ingrese otro token de acceso de usuario válido diferente.

Consulte la documentación sobre el token de acceso de usuario si aún no tiene ningún token disponible para utilizarlo.

En ambas pestañas, haga clic en los botones "Inicializar agente de llamada". Deberías ver la siguiente pantalla:

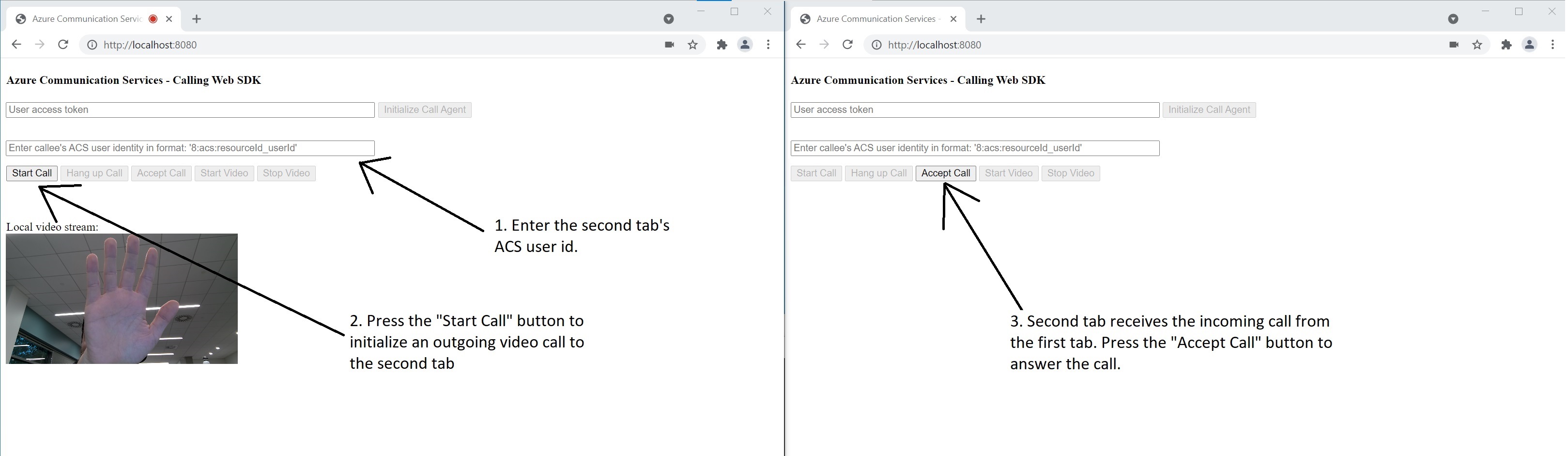

En la primera pestaña, escriba la identidad de usuario de Azure Communication Services de la segunda pestaña y haga clic en el botón "Iniciar llamada". La primera pestaña iniciará la llamada saliente a la segunda pestaña, y el botón "Aceptar llamada" de la segunda pestaña se habilita:

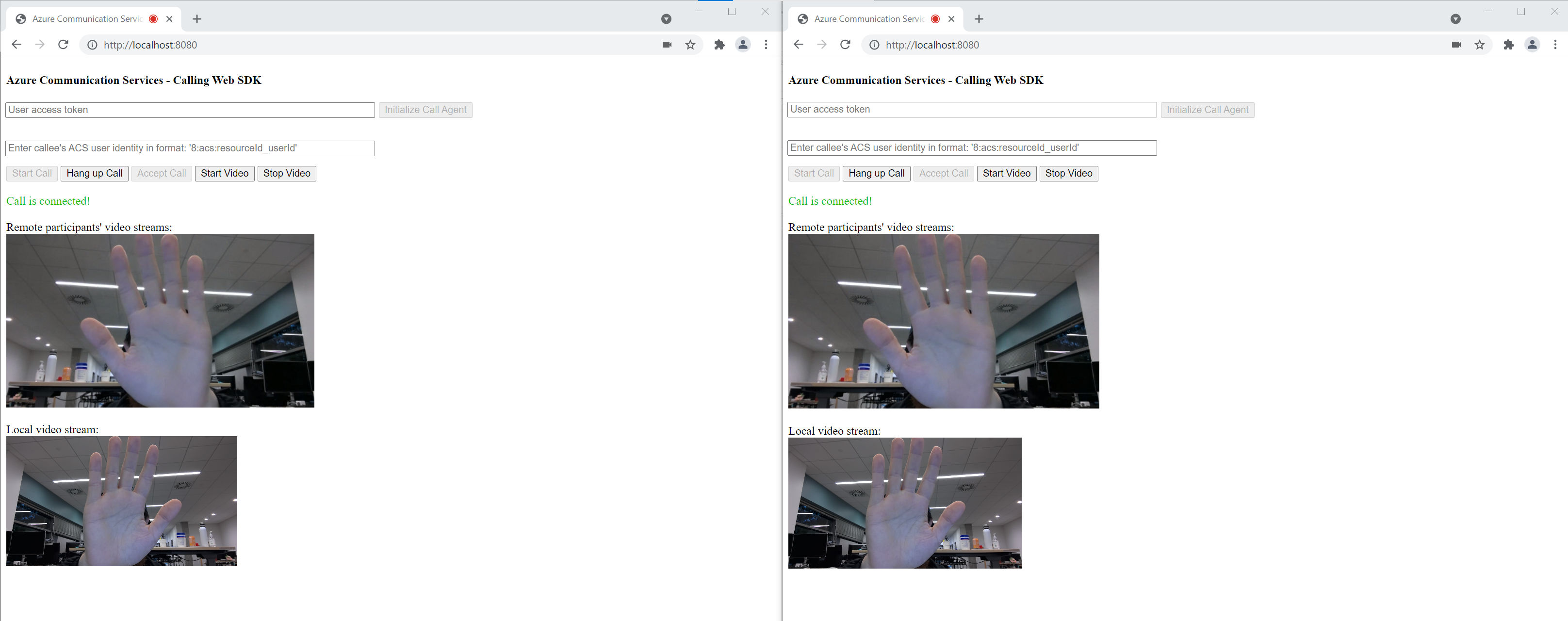

En la segunda pestaña, haga clic en el botón "Aceptar llamada" y la llamada se responde y se conecta. Debería ver la siguiente pantalla:

Ambas pestañas se encuentran ahora correctamente en una videollamada de uno a uno. Ambas pestañas pueden escuchar el audio de las demás y verse entre sí en secuencia de vídeo.

Para empezar a usar Azure Communication Services, utilice la biblioteca cliente de llamadas de Communication Services para agregar videollamadas a la aplicación. Obtenga información sobre cómo incluir videollamadas 1:1 y cómo crear o unirse a llamadas de grupo. Además, puede iniciar, responder y unirse a una videollamada con el SDK de llamadas de Azure Communication Services para Android.

Si quiere empezar a trabajar con código de ejemplo, puede descargar la aplicación de ejemplo.

Requisitos previos

Una cuenta de Azure con una suscripción activa. Cree una cuenta gratuita.

Android Studio, para crear la aplicación de Android.

Un recurso de Communication Services implementado. Cree un recurso de Communication Services. Debe registrar la cadena de conexión para esta guía de inicio rápido.

Un token de acceso de usuario para su instancia de Azure Communication Services. También puede usar la CLI de Azure y ejecutar el comando siguiente con la cadena de conexión para crear un usuario y un token de acceso.

az communication identity token issue --scope voip --connection-string "yourConnectionString"Para más información, consulte Uso de la CLI de Azure para crear y administrar tokens de acceso.

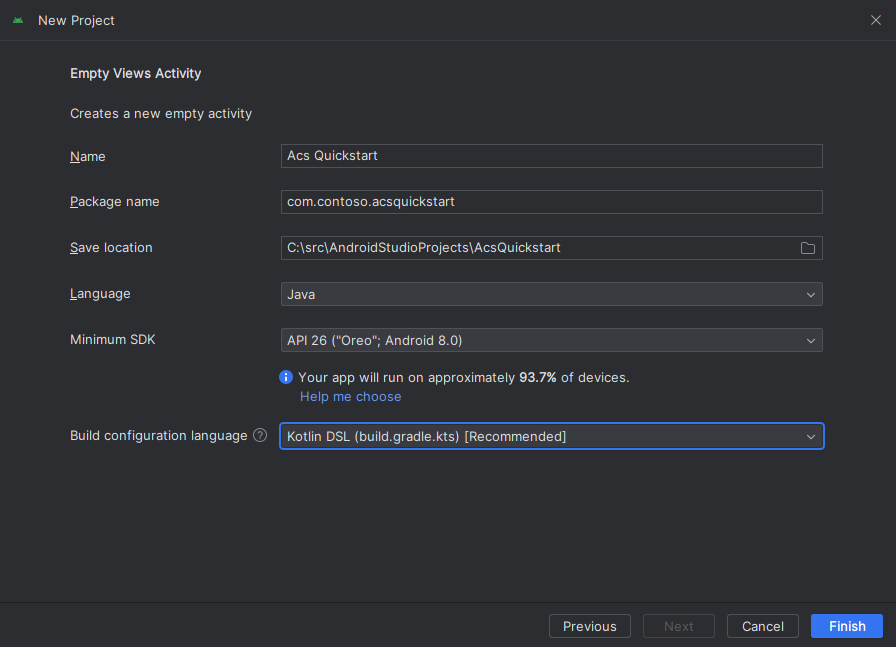

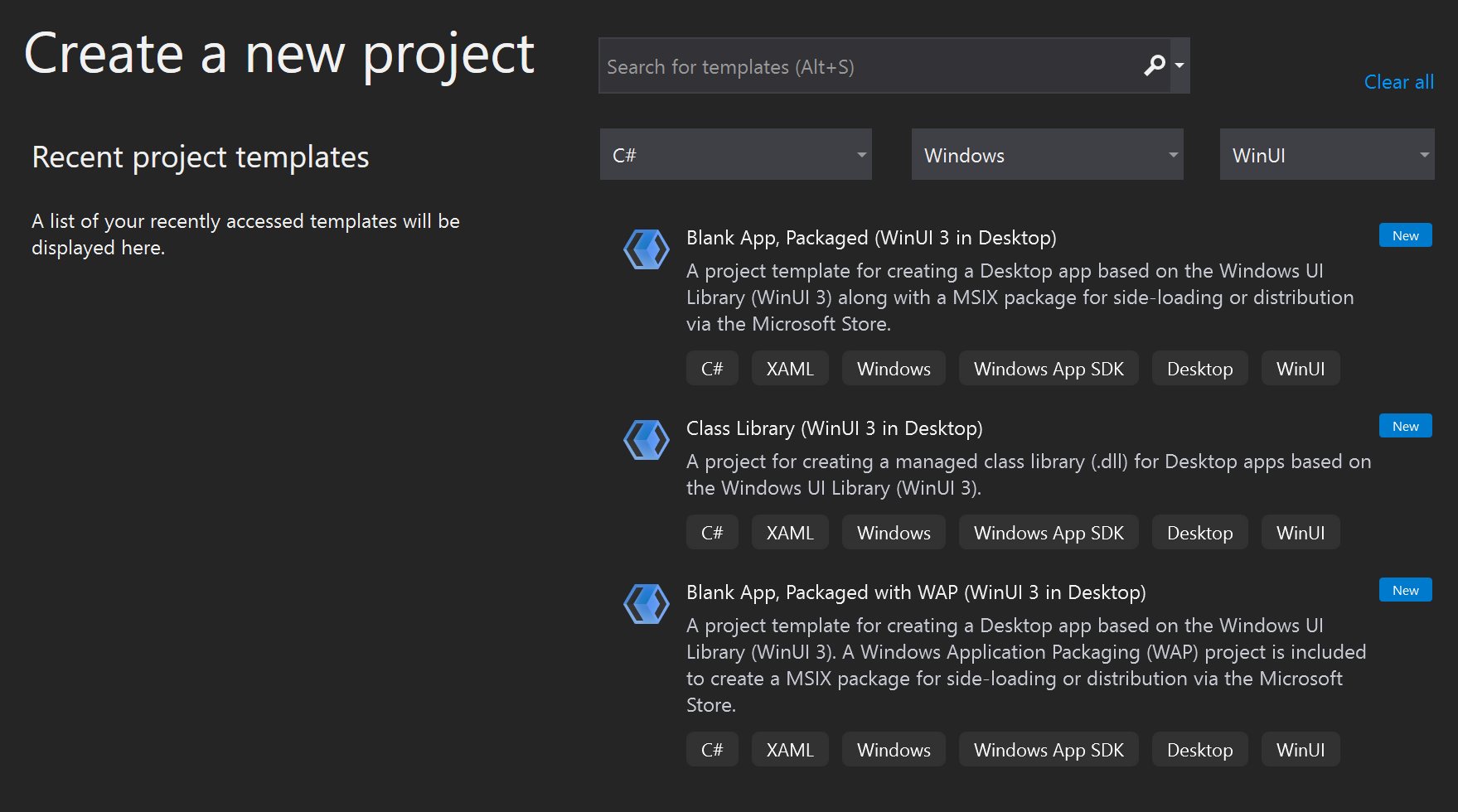

Creación de una aplicación de Android con una actividad vacía

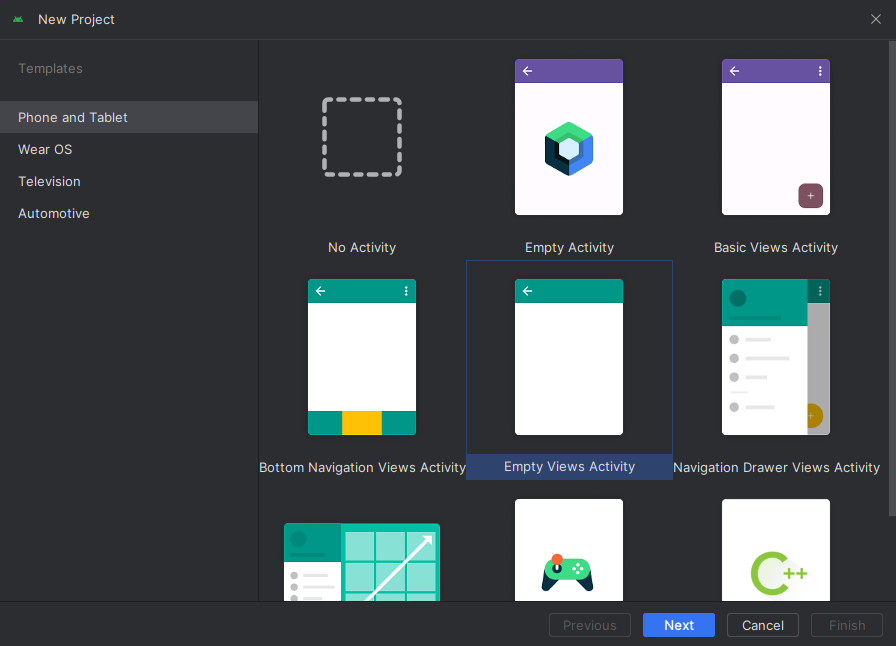

En Android Studio, seleccione Start a new Android Studio project.

En Phone and Tablet, seleccione la plantilla de proyecto Empty Activity.

En Minimum SDK, seleccione API 26: Android 8.0 (Oreo) o una versión posterior. Consulte las versiones de soporte técnico del SDK.

Instalar el paquete

Busque el archivo build.gradle de nivel de proyecto y agregue mavenCentral() a la lista de repositorios en buildscript y allprojects.

buildscript {

repositories {

...

mavenCentral()

...

}

}

allprojects {

repositories {

...

mavenCentral()

...

}

}

Luego, en el archivo build.gradle de nivel de módulo, agregue las siguientes líneas a las secciones dependencies y android.

android {

...

packagingOptions {

pickFirst 'META-INF/*'

}

compileOptions {

sourceCompatibility JavaVersion.VERSION_1_8

targetCompatibility JavaVersion.VERSION_1_8

}

}

dependencies {

...

implementation 'com.azure.android:azure-communication-calling:2.0.0'

...

}

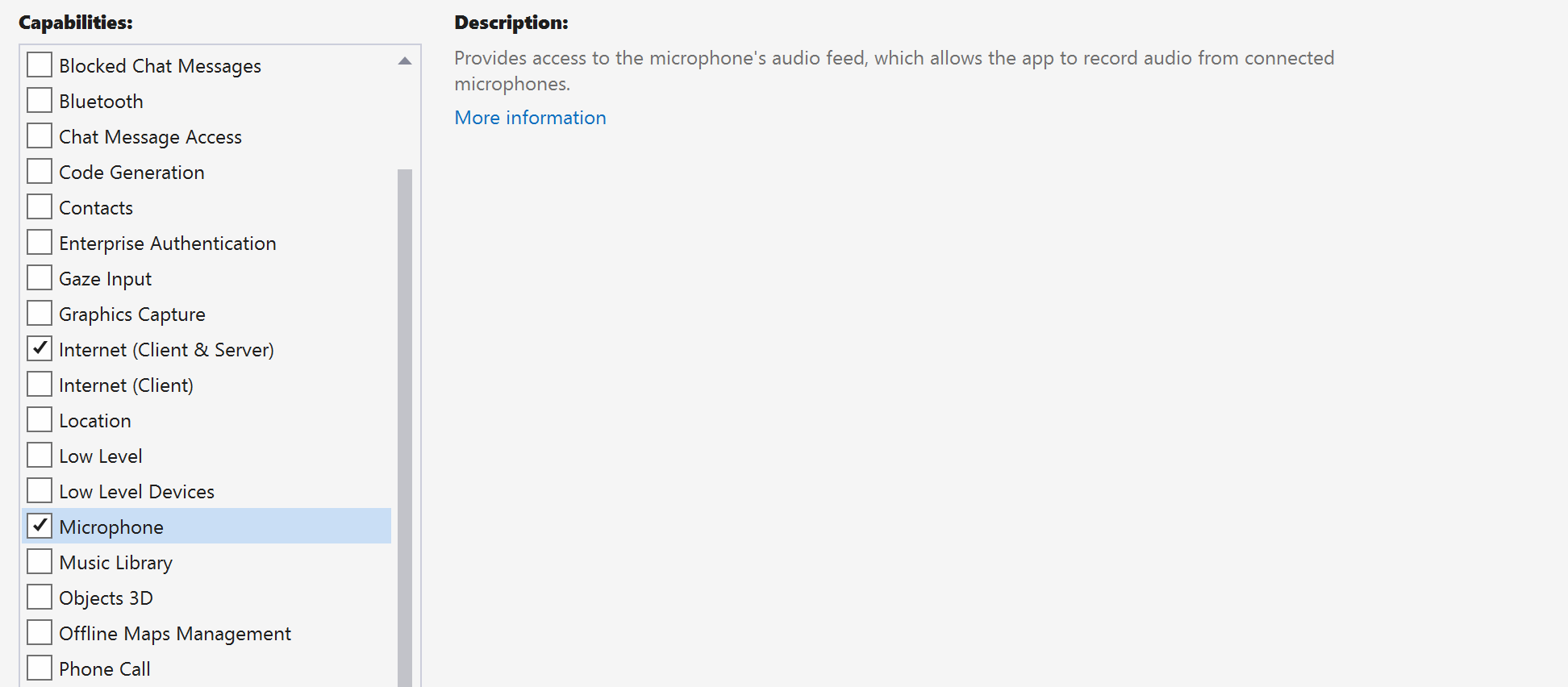

Adición de permisos al manifiesto de aplicación

Para solicitar los permisos necesarios para realizar una llamada, primero se deben declarar los permisos en el manifiesto de aplicación (app/src/main/AndroidManifest.xml). Reemplace el contenido del archivo con el código siguiente:

<?xml version="1.0" encoding="utf-8"?>

<manifest xmlns:android="http://schemas.android.com/apk/res/android"

package="com.contoso.acsquickstart">

<uses-permission android:name="android.permission.INTERNET" />

<uses-permission android:name="android.permission.ACCESS_NETWORK_STATE" />

<uses-permission android:name="android.permission.ACCESS_WIFI_STATE" />

<uses-permission android:name="android.permission.RECORD_AUDIO" />

<uses-permission android:name="android.permission.CAMERA" />

<application

android:allowBackup="true"

android:icon="@mipmap/ic_launcher"

android:label="@string/app_name"

android:roundIcon="@mipmap/ic_launcher_round"

android:supportsRtl="true"

android:theme="@style/AppTheme">

<!--Our Calling SDK depends on the Apache HTTP SDK.

When targeting Android SDK 28+, this library needs to be explicitly referenced.

See https://developer.android.com/about/versions/pie/android-9.0-changes-28#apache-p-->

<uses-library android:name="org.apache.http.legacy" android:required="false"/>

<activity android:name=".MainActivity">

<intent-filter>

<action android:name="android.intent.action.MAIN" />

<category android:name="android.intent.category.LAUNCHER" />

</intent-filter>

</activity>

</application>

</manifest>

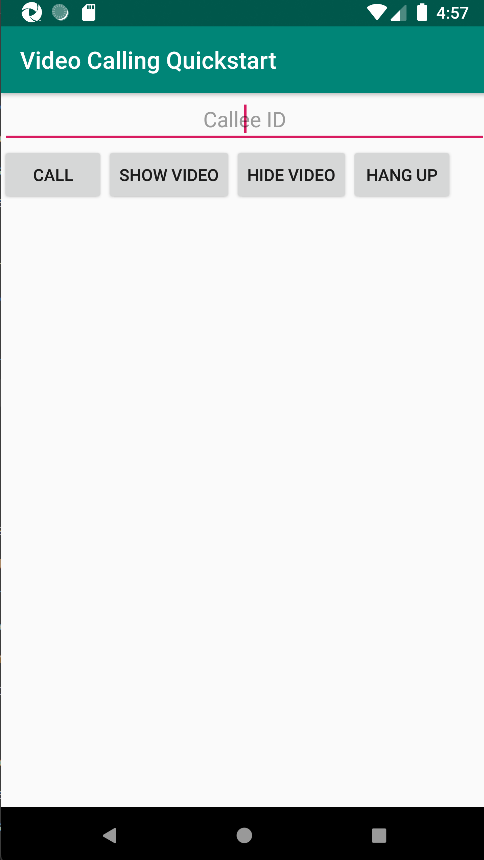

Configuración del diseño de la aplicación

Necesita una entrada de texto para el identificador del destinatario o el identificador de la llamada de grupo, un botón para realizar la llamada y otro botón para colgarla.

También se necesitan dos botones para activar y desactivar el vídeo local. Debe colocar dos contenedores para las secuencias de vídeo locales y remotas. Puede agregar estos botones mediante el diseñador o mediante la edición del archivo XML de diseño.

Vaya al archivo app/src/main/res/layout/activity_main.xml y reemplace el contenido del archivo por el siguiente código:

<?xml version="1.0" encoding="utf-8"?>

<androidx.constraintlayout.widget.ConstraintLayout xmlns:android="http://schemas.android.com/apk/res/android"

xmlns:app="http://schemas.android.com/apk/res-auto"

xmlns:tools="http://schemas.android.com/tools"

android:layout_width="match_parent"

android:layout_height="match_parent"

tools:context=".MainActivity">

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:orientation="vertical">

<EditText

android:id="@+id/call_id"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:ems="10"

android:gravity="center"

android:hint="Callee ID"

android:inputType="textPersonName"

app:layout_constraintBottom_toTopOf="@+id/call_button"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent"

app:layout_constraintTop_toTopOf="parent"

app:layout_constraintVertical_bias="0.064" />

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content">

<Button

android:id="@+id/call_button"

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_marginBottom="16dp"

android:gravity="center"

android:text="Call"

app:layout_constraintBottom_toBottomOf="parent"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent" />

<Button

android:id="@+id/show_preview"

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_marginBottom="16dp"

android:gravity="center"

android:text="Show Video"

app:layout_constraintBottom_toBottomOf="parent"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent" />

<Button

android:id="@+id/hide_preview"

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_marginBottom="16dp"

android:gravity="center"

android:text="Hide Video"

app:layout_constraintBottom_toBottomOf="parent"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent" />

<Button

android:id="@+id/hang_up"

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_marginBottom="16dp"

android:gravity="center"

android:text="Hang Up"

app:layout_constraintBottom_toBottomOf="parent"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent" />

</LinearLayout>

<ScrollView

android:layout_width="match_parent"

android:layout_height="wrap_content">

<GridLayout

android:id="@+id/remotevideocontainer"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:columnCount="2"

android:rowCount="2"

android:padding="10dp"></GridLayout>

</ScrollView>

</LinearLayout>

<FrameLayout

android:layout_width="match_parent"

android:layout_height="match_parent">

<LinearLayout

android:id="@+id/localvideocontainer"

android:layout_width="180dp"

android:layout_height="300dp"

android:layout_gravity="right|bottom"

android:orientation="vertical"

android:padding="10dp">

<Button

android:id="@+id/switch_source"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:gravity="center"

android:text="Switch Source"

android:visibility="invisible" />

</LinearLayout>

</FrameLayout>

</androidx.constraintlayout.widget.ConstraintLayout>

Creación de los enlaces y scaffolding de actividades principales

Con el diseño creado, puede agregar los enlaces y el scaffolding básico de la actividad. La actividad administra la solicitud de los permisos en tiempo de ejecución, la creación del agente de llamadas y la realización de llamadas cuando se presione el botón.

El método onCreate se reemplaza para invocar getAllPermissions y createAgent, así como para agregar los enlaces para el botón de llamada. Este evento solo ocurre una vez cuando se crea la actividad. Para más información sobre onCreate, consulte la guía Descripción del ciclo de vida de la actividad.

Vaya al archivo MainActivity.java y reemplace el contenido por el siguiente código:

package com.example.videocallingquickstart;

import androidx.appcompat.app.AppCompatActivity;

import androidx.core.app.ActivityCompat;

import android.Manifest;

import android.content.pm.PackageManager;

import android.media.AudioManager;

import android.os.Bundle;

import android.util.DisplayMetrics;

import android.util.Log;

import android.view.View;

import android.widget.Button;

import android.widget.EditText;

import android.widget.GridLayout;

import android.widget.Toast;

import android.widget.LinearLayout;

import android.content.Context;

import com.azure.android.communication.calling.CallState;

import com.azure.android.communication.calling.CallingCommunicationException;

import com.azure.android.communication.calling.ParticipantsUpdatedListener;

import com.azure.android.communication.calling.PropertyChangedEvent;

import com.azure.android.communication.calling.PropertyChangedListener;

import com.azure.android.communication.calling.StartCallOptions;

import com.azure.android.communication.calling.VideoDeviceInfo;

import com.azure.android.communication.common.CommunicationIdentifier;

import com.azure.android.communication.common.CommunicationTokenCredential;

import com.azure.android.communication.calling.CallAgent;

import com.azure.android.communication.calling.CallClient;

import com.azure.android.communication.calling.DeviceManager;

import com.azure.android.communication.calling.VideoOptions;

import com.azure.android.communication.calling.LocalVideoStream;

import com.azure.android.communication.calling.VideoStreamRenderer;

import com.azure.android.communication.calling.VideoStreamRendererView;

import com.azure.android.communication.calling.CreateViewOptions;

import com.azure.android.communication.calling.ScalingMode;

import com.azure.android.communication.calling.IncomingCall;

import com.azure.android.communication.calling.Call;

import com.azure.android.communication.calling.AcceptCallOptions;

import com.azure.android.communication.calling.ParticipantsUpdatedEvent;

import com.azure.android.communication.calling.RemoteParticipant;

import com.azure.android.communication.calling.RemoteVideoStream;

import com.azure.android.communication.calling.RemoteVideoStreamsEvent;

import com.azure.android.communication.calling.RendererListener;

import com.azure.android.communication.common.CommunicationUserIdentifier;

import com.azure.android.communication.common.MicrosoftTeamsUserIdentifier;

import com.azure.android.communication.common.PhoneNumberIdentifier;

import com.azure.android.communication.common.UnknownIdentifier;

import java.util.ArrayList;

import java.util.HashSet;

import java.util.List;

import java.util.HashMap;

import java.util.Map;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.Executors;

import java.util.ArrayList;

import java.util.HashSet;

import java.util.List;

import java.util.HashMap;

import java.util.Map;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.Executors;

public class MainActivity extends AppCompatActivity {

private CallAgent callAgent;

private VideoDeviceInfo currentCamera;

private LocalVideoStream currentVideoStream;

private DeviceManager deviceManager;

private IncomingCall incomingCall;

private Call call;

VideoStreamRenderer previewRenderer;

VideoStreamRendererView preview;

final Map<Integer, StreamData> streamData = new HashMap<>();

private boolean renderRemoteVideo = true;

private ParticipantsUpdatedListener remoteParticipantUpdatedListener;

private PropertyChangedListener onStateChangedListener;

final HashSet<String> joinedParticipants = new HashSet<>();

Button switchSourceButton;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

getAllPermissions();

createAgent();

handleIncomingCall();

Button callButton = findViewById(R.id.call_button);

callButton.setOnClickListener(l -> startCall());

Button hangupButton = findViewById(R.id.hang_up);

hangupButton.setOnClickListener(l -> hangUp());

Button startVideo = findViewById(R.id.show_preview);

startVideo.setOnClickListener(l -> turnOnLocalVideo());

Button stopVideo = findViewById(R.id.hide_preview);

stopVideo.setOnClickListener(l -> turnOffLocalVideo());

switchSourceButton = findViewById(R.id.switch_source);

switchSourceButton.setOnClickListener(l -> switchSource());

setVolumeControlStream(AudioManager.STREAM_VOICE_CALL);

}

/**

* Request each required permission if the app doesn't already have it.

*/

private void getAllPermissions() {

// See section on requesting permissions

}

/**

* Create the call agent for placing calls

*/

private void createAgent() {

// See section on creating the call agent

}

/**

* Handle incoming calls

*/

private void handleIncomingCall() {

// See section on answering incoming call

}

/**

* Place a call to the callee id provided in `callee_id` text input.

*/

private void startCall() {

// See section on starting the call

}

/**

* End calls

*/

private void hangUp() {

// See section on ending the call

}

/**

* Mid-call operations

*/

public void turnOnLocalVideo() {

// See section

}

public void turnOffLocalVideo() {

// See section

}

/**

* Change the active camera for the next available

*/

public void switchSource() {

// See section

}

}

Solicitud de permisos en tiempo de ejecución

Para Android 6.0 y versiones posteriores (nivel de API 23) y targetSdkVersion 23 o versiones posteriores, los permisos se conceden en tiempo de ejecución en lugar de cuando se instala la aplicación. A fin de admitirlo, se puede implementar getAllPermissions para llamar a ActivityCompat.checkSelfPermission y ActivityCompat.requestPermissions para cada permiso necesario.

/**

* Request each required permission if the app doesn't already have it.

*/

private void getAllPermissions() {

String[] requiredPermissions = new String[]{Manifest.permission.RECORD_AUDIO, Manifest.permission.CAMERA, Manifest.permission.WRITE_EXTERNAL_STORAGE, Manifest.permission.READ_PHONE_STATE};

ArrayList<String> permissionsToAskFor = new ArrayList<>();

for (String permission : requiredPermissions) {

if (ActivityCompat.checkSelfPermission(this, permission) != PackageManager.PERMISSION_GRANTED) {

permissionsToAskFor.add(permission);

}

}

if (!permissionsToAskFor.isEmpty()) {

ActivityCompat.requestPermissions(this, permissionsToAskFor.toArray(new String[0]), 1);

}

}

Nota

Al diseñar la aplicación, tenga en cuenta cuándo se deben solicitar estos permisos. Se deben solicitar a medida que sean necesarios, pero no con anterioridad. Para más información, consulte la Guía de permisos de Android.

Modelo de objetos

Las siguientes clases e interfaces controlan algunas de las características principales del SDK de llamadas de Azure Communication Services:

| Nombre | Descripción |

|---|---|

CallClient |

El punto de entrada principal al SDK de llamadas. |

CallAgent |

Se utiliza para iniciar y administrar las llamadas. |

CommunicationTokenCredential |

Se usa como la credencial del token para crear una instancia de CallAgent. |

CommunicationIdentifier |

Se usa como otro tipo de participante que podría formar parte de una llamada. |

Creación de un agente a partir del token de acceso de usuario

Necesita un token de usuario para crear un agente de llamada autenticado. Por lo general, este token se genera desde un servicio con autenticación específica de la aplicación. Para más información sobre los tokens de acceso de usuario, consulte Inicio rápido: Creación y administración de tokens de acceso.

Para este inicio rápido, reemplace <User_Access_Token> por un token de acceso de usuario generado para el recurso de Azure Communication Services.

/**

* Create the call agent for placing calls

*/

private void createAgent() {

Context context = this.getApplicationContext();

String userToken = "<USER_ACCESS_TOKEN>";

try {

CommunicationTokenCredential credential = new CommunicationTokenCredential(userToken);

CallClient callClient = new CallClient();

deviceManager = callClient.getDeviceManager(context).get();

callAgent = callClient.createCallAgent(getApplicationContext(), credential).get();

} catch (Exception ex) {

Toast.makeText(context, "Failed to create call agent.", Toast.LENGTH_SHORT).show();

}

}

Inicio de una videollamada mediante el agente de llamadas

Puede realizar la llamada mediante el agente de llamadas. Lo único que necesita hacer es proporcionar una lista de identificadores de destinatario y las opciones de la llamada.

Para realizar una videollamada, debe enumerar las cámaras locales mediante la API getCameras de deviceManager. Después de seleccionar la cámara deseada, úsela para construir una instancia de LocalVideoStream. A continuación, pásela a videoOptions como un elemento de la matriz localVideoStream a un método de llamada. Cuando la llamada se conecta, iniciará automáticamente el envío de una secuencia de vídeo desde la cámara seleccionada hasta los demás participantes.

private void startCall() {

Context context = this.getApplicationContext();

EditText callIdView = findViewById(R.id.call_id);

String callId = callIdView.getText().toString();

ArrayList<CommunicationIdentifier> participants = new ArrayList<CommunicationIdentifier>();

List<VideoDeviceInfo> cameras = deviceManager.getCameras();

StartCallOptions options = new StartCallOptions();

if(!cameras.isEmpty()) {

currentCamera = getNextAvailableCamera(null);

currentVideoStream = new LocalVideoStream(currentCamera, context);

LocalVideoStream[] videoStreams = new LocalVideoStream[1];

videoStreams[0] = currentVideoStream;

VideoOptions videoOptions = new VideoOptions(videoStreams);

options.setVideoOptions(videoOptions);

showPreview(currentVideoStream);

}

participants.add(new CommunicationUserIdentifier(callId));

call = callAgent.startCall(

context,

participants,

options);

//Subscribe to events on updates of call state and remote participants

remoteParticipantUpdatedListener = this::handleRemoteParticipantsUpdate;

onStateChangedListener = this::handleCallOnStateChanged;

call.addOnRemoteParticipantsUpdatedListener(remoteParticipantUpdatedListener);

call.addOnStateChangedListener(onStateChangedListener);

}

Este inicio rápido se basa en la función getNextAvailableCamera para elegir la cámara que usa la llamada. La función toma la enumeración de cámaras como entrada y recorre en iteración la lista para obtener la siguiente cámara disponible. Si el argumento es null, la función elige el primer dispositivo de la lista. Si no hay cámaras disponibles al seleccionar Iniciar llamada, se inicia en su lugar una llamada de audio. Sin embargo, si el participante remoto respondió con vídeo, todavía puede ver la secuencia de vídeo remota.

private VideoDeviceInfo getNextAvailableCamera(VideoDeviceInfo camera) {

List<VideoDeviceInfo> cameras = deviceManager.getCameras();

int currentIndex = 0;

if (camera == null) {

return cameras.isEmpty() ? null : cameras.get(0);

}

for (int i = 0; i < cameras.size(); i++) {

if (camera.getId().equals(cameras.get(i).getId())) {

currentIndex = i;

break;

}

}

int newIndex = (currentIndex + 1) % cameras.size();

return cameras.get(newIndex);

}

Después de crear una instancia de LocalVideoStream, puede crear un representador para mostrarla en la interfaz de usuario.

private void showPreview(LocalVideoStream stream) {

previewRenderer = new VideoStreamRenderer(stream, this);

LinearLayout layout = findViewById(R.id.localvideocontainer);

preview = previewRenderer.createView(new CreateViewOptions(ScalingMode.FIT));

preview.setTag(0);

runOnUiThread(() -> {

layout.addView(preview);

switchSourceButton.setVisibility(View.VISIBLE);

});

}

Para permitir al usuario alternar el origen de vídeo local, use switchSource. Este método elige la siguiente cámara disponible y la define como la secuencia local.

public void switchSource() {

if (currentVideoStream != null) {

try {

currentCamera = getNextAvailableCamera(currentCamera);

currentVideoStream.switchSource(currentCamera).get();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

e.printStackTrace();

}

}

}

Aceptar una llamada entrante

Para obtener una llamada entrante, suscríbase a addOnIncomingCallListener en callAgent.

private void handleIncomingCall() {

callAgent.addOnIncomingCallListener((incomingCall) -> {

this.incomingCall = incomingCall;

Executors.newCachedThreadPool().submit(this::answerIncomingCall);

});

}

Para aceptar una llamada con la cámara de vídeo activada, enumere las cámaras locales mediante la API getCameras de deviceManager. Elija una cámara y construya una instancia de LocalVideoStream. Pásela a acceptCallOptions antes de llamar al método accept en un objeto call.

private void answerIncomingCall() {

Context context = this.getApplicationContext();

if (incomingCall == null){

return;

}

AcceptCallOptions acceptCallOptions = new AcceptCallOptions();

List<VideoDeviceInfo> cameras = deviceManager.getCameras();

if(!cameras.isEmpty()) {

currentCamera = getNextAvailableCamera(null);

currentVideoStream = new LocalVideoStream(currentCamera, context);

LocalVideoStream[] videoStreams = new LocalVideoStream[1];

videoStreams[0] = currentVideoStream;

VideoOptions videoOptions = new VideoOptions(videoStreams);

acceptCallOptions.setVideoOptions(videoOptions);

showPreview(currentVideoStream);

}

try {

call = incomingCall.accept(context, acceptCallOptions).get();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

e.printStackTrace();

}

//Subscribe to events on updates of call state and remote participants

remoteParticipantUpdatedListener = this::handleRemoteParticipantsUpdate;

onStateChangedListener = this::handleCallOnStateChanged;

call.addOnRemoteParticipantsUpdatedListener(remoteParticipantUpdatedListener);

call.addOnStateChangedListener(onStateChangedListener);

}

Secuencias de vídeo remotas y participantes remotos

Todos los participantes remotos están disponibles a través del método getRemoteParticipants() en una instancia de llamada. Cuando la llamada se conecta (CallState.CONNECTED), podemos acceder a los participantes remotos de la llamada y controlar las secuencias de vídeo remotas.

Cuando inicia una llamada o responde a una llamada entrante, debe suscribirse al evento addOnRemoteParticipantsUpdatedListener para controlar los participantes remotos.

remoteParticipantUpdatedListener = this::handleRemoteParticipantsUpdate;

call.addOnRemoteParticipantsUpdatedListener(remoteParticipantUpdatedListener);

Cuando use clientes de escucha de eventos definidos dentro de la misma clase, enlace el cliente de escucha a una variable. Pase la variable como argumento para agregar y quitar métodos del cliente de escucha.

Si intenta pasar el cliente de escucha directamente como un argumento, perderá la referencia a ese cliente de escucha. Java crea nuevas instancias de estos clientes de escucha y no hace referencia a las creadas anteriormente. No puede quitar instancias anteriores, porque no tiene una referencia a ellas.

Nota:

Cuando un usuario se une a una llamada, puede acceder a los participantes remotos actuales a través del método getRemoteParticipants(). El evento addOnRemoteParticipantsUpdatedListener no se desencadenará para estos participantes existentes. Este evento solo se desencadenará cuando un participante remoto se una o salga de la llamada mientras el usuario ya está en la llamada.

Actualizaciones de la secuencia de vídeo remoto

Para llamadas 1:1, debe controlar los participantes agregados. Cuando se quita el participante remoto, finaliza la llamada. Para los participantes agregados, suscríbase a addOnVideoStreamsUpdatedListener para controlar las actualizaciones de la secuencia de vídeo.

public void handleRemoteParticipantsUpdate(ParticipantsUpdatedEvent args) {

handleAddedParticipants(args.getAddedParticipants());

}

private void handleAddedParticipants(List<RemoteParticipant> participants) {

for (RemoteParticipant remoteParticipant : participants) {

if(!joinedParticipants.contains(getId(remoteParticipant))) {

joinedParticipants.add(getId(remoteParticipant));

if (renderRemoteVideo) {

for (RemoteVideoStream stream : remoteParticipant.getVideoStreams()) {

StreamData data = new StreamData(stream, null, null);

streamData.put(stream.getId(), data);

startRenderingVideo(data);

}

}

remoteParticipant.addOnVideoStreamsUpdatedListener(videoStreamsEventArgs -> videoStreamsUpdated(videoStreamsEventArgs));

}

}

}

private void videoStreamsUpdated(RemoteVideoStreamsEvent videoStreamsEventArgs) {

for(RemoteVideoStream stream : videoStreamsEventArgs.getAddedRemoteVideoStreams()) {

StreamData data = new StreamData(stream, null, null);

streamData.put(stream.getId(), data);

if (renderRemoteVideo) {

startRenderingVideo(data);

}

}

for(RemoteVideoStream stream : videoStreamsEventArgs.getRemovedRemoteVideoStreams()) {

stopRenderingVideo(stream);

}

}

public String getId(final RemoteParticipant remoteParticipant) {

final CommunicationIdentifier identifier = remoteParticipant.getIdentifier();

if (identifier instanceof PhoneNumberIdentifier) {

return ((PhoneNumberIdentifier) identifier).getPhoneNumber();

} else if (identifier instanceof MicrosoftTeamsUserIdentifier) {

return ((MicrosoftTeamsUserIdentifier) identifier).getUserId();

} else if (identifier instanceof CommunicationUserIdentifier) {

return ((CommunicationUserIdentifier) identifier).getId();

} else {

return ((UnknownIdentifier) identifier).getId();

}

}

Representación de vídeos remotos

Cree un representador de la secuencia de vídeo remoto y asócielo a la vista para empezar a representar la vista remota. Deseche la vista para dejar de representarla.

void startRenderingVideo(StreamData data){

if (data.renderer != null) {

return;

}

GridLayout layout = ((GridLayout)findViewById(R.id.remotevideocontainer));

data.renderer = new VideoStreamRenderer(data.stream, this);

data.renderer.addRendererListener(new RendererListener() {

@Override

public void onFirstFrameRendered() {

String text = data.renderer.getSize().toString();

Log.i("MainActivity", "Video rendering at: " + text);

}

@Override

public void onRendererFailedToStart() {

String text = "Video failed to render";

Log.i("MainActivity", text);

}

});

data.rendererView = data.renderer.createView(new CreateViewOptions(ScalingMode.FIT));

data.rendererView.setTag(data.stream.getId());

runOnUiThread(() -> {

GridLayout.LayoutParams params = new GridLayout.LayoutParams(layout.getLayoutParams());

DisplayMetrics displayMetrics = new DisplayMetrics();

getWindowManager().getDefaultDisplay().getMetrics(displayMetrics);

params.height = (int)(displayMetrics.heightPixels / 2.5);

params.width = displayMetrics.widthPixels / 2;

layout.addView(data.rendererView, params);

});

}

void stopRenderingVideo(RemoteVideoStream stream) {

StreamData data = streamData.get(stream.getId());

if (data == null || data.renderer == null) {

return;

}

runOnUiThread(() -> {

GridLayout layout = findViewById(R.id.remotevideocontainer);

for(int i = 0; i < layout.getChildCount(); ++ i) {

View childView = layout.getChildAt(i);

if ((int)childView.getTag() == data.stream.getId()) {

layout.removeViewAt(i);

}

}

});

data.rendererView = null;

// Dispose renderer

data.renderer.dispose();

data.renderer = null;

}

static class StreamData {

RemoteVideoStream stream;

VideoStreamRenderer renderer;

VideoStreamRendererView rendererView;

StreamData(RemoteVideoStream stream, VideoStreamRenderer renderer, VideoStreamRendererView rendererView) {

this.stream = stream;

this.renderer = renderer;

this.rendererView = rendererView;

}

}

Actualización del estado de la llamada

El estado de una llamada puede cambiar de conectado a desconectado. Cuando la llamada está conectada, controle el participante remoto y, cuando está desconectada, deseche previewRenderer para detener el vídeo local.

private void handleCallOnStateChanged(PropertyChangedEvent args) {

if (call.getState() == CallState.CONNECTED) {

runOnUiThread(() -> Toast.makeText(this, "Call is CONNECTED", Toast.LENGTH_SHORT).show());

handleCallState();

}

if (call.getState() == CallState.DISCONNECTED) {

runOnUiThread(() -> Toast.makeText(this, "Call is DISCONNECTED", Toast.LENGTH_SHORT).show());

if (previewRenderer != null) {

previewRenderer.dispose();

}

switchSourceButton.setVisibility(View.INVISIBLE);

}

}

Finalizar una llamada

Para finalizar la llamada, llame a la función hangUp() en la instancia de llamada. Elimine previewRenderer para detener el vídeo local.

private void hangUp() {

try {

call.hangUp().get();

switchSourceButton.setVisibility(View.INVISIBLE);

} catch (ExecutionException | InterruptedException e) {

e.printStackTrace();

}

if (previewRenderer != null) {

previewRenderer.dispose();

}

}

Ocultar y mostrar vídeo local

Cuando se haya iniciado la llamada, puede detener la representación y el streaming del vídeo local con turnOffLocalVideo(); este método quita la vista que encapsula la representación local y elimina la secuencia actual. Para reanudar la transmisión y volver a representar la vista preliminar local, utilice turnOnLocalVideo(); este método muestra la vista previa del vídeo y se inicia el streaming.

public void turnOnLocalVideo() {

List<VideoDeviceInfo> cameras = deviceManager.getCameras();

if(!cameras.isEmpty()) {

try {

currentVideoStream = new LocalVideoStream(currentCamera, this);

showPreview(currentVideoStream);

call.startVideo(this, currentVideoStream).get();

switchSourceButton.setVisibility(View.VISIBLE);

} catch (CallingCommunicationException acsException) {

acsException.printStackTrace();

} catch (ExecutionException | InterruptedException e) {

e.printStackTrace();

}

}

}

public void turnOffLocalVideo() {

try {

LinearLayout container = findViewById(R.id.localvideocontainer);

for (int i = 0; i < container.getChildCount(); ++i) {

Object tag = container.getChildAt(i).getTag();

if (tag != null && (int)tag == 0) {

container.removeViewAt(i);

}

}

switchSourceButton.setVisibility(View.INVISIBLE);

previewRenderer.dispose();

previewRenderer = null;

call.stopVideo(this, currentVideoStream).get();

} catch (CallingCommunicationException acsException) {

acsException.printStackTrace();

} catch (ExecutionException | InterruptedException e) {

e.printStackTrace();

}

}

Ejecución del código

Ahora puede iniciar la aplicación mediante el botón Run App de la barra de herramientas de Android Studio.

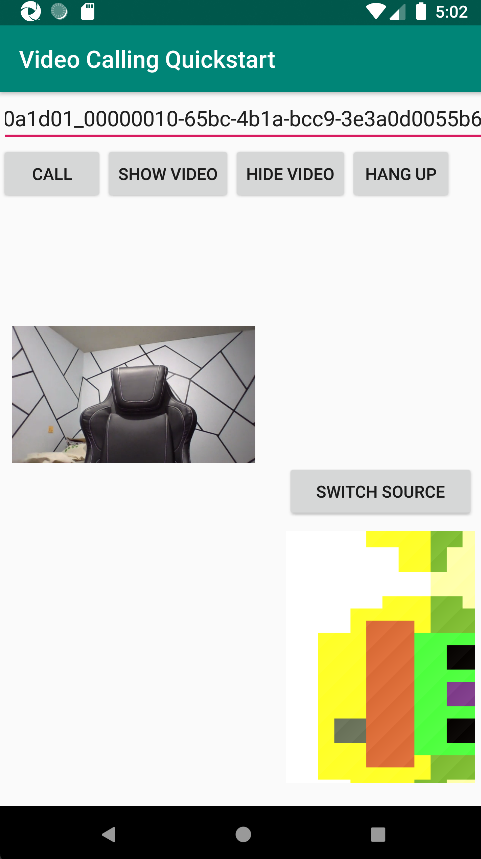

| Aplicación completada | Llamada 1:1 |

|---|---|

|

|

Agregar funcionalidad de llamada de grupo

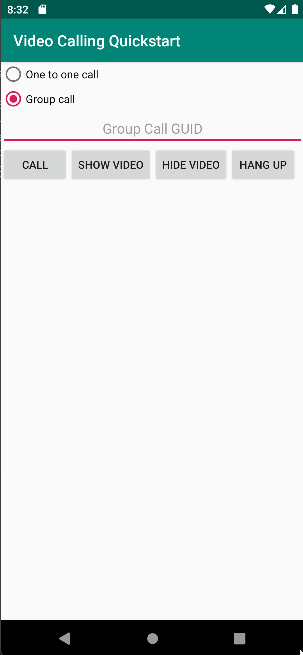

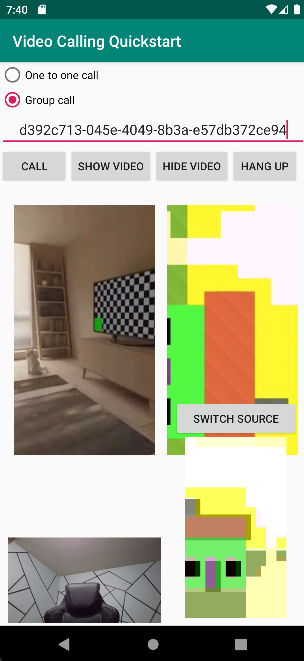

Ahora puede actualizar la aplicación para permitir que el usuario elija entre llamadas 1:1 o llamadas de grupo.

Actualización del diseño

Use botones de radio para seleccionar si el SDK crea una llamada 1:1 o se une a una llamada de grupo. Los botones de radio están en la parte superior, por lo que la primera sección del archivo app/src/main/res/layout/activity_main.xml finaliza de la siguiente manera.

<?xml version="1.0" encoding="utf-8"?>

<androidx.constraintlayout.widget.ConstraintLayout xmlns:android="http://schemas.android.com/apk/res/android"

xmlns:app="http://schemas.android.com/apk/res-auto"

xmlns:tools="http://schemas.android.com/tools"

android:layout_width="match_parent"

android:layout_height="match_parent"

tools:context=".MainActivity">

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:orientation="vertical">

<RadioGroup

android:layout_width="match_parent"

android:layout_height="wrap_content">

<RadioButton

android:id="@+id/one_to_one_call"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:text="One to one call" />

<RadioButton

android:id="@+id/group_call"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:text="Group call" />

</RadioGroup>

<EditText

android:id="@+id/call_id"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:ems="10"

android:gravity="center"

android:hint="Callee ID"

android:inputType="textPersonName"

app:layout_constraintBottom_toTopOf="@+id/call_button"

app:layout_constraintEnd_toEndOf="parent"

app:layout_constraintStart_toStartOf="parent"

app:layout_constraintTop_toTopOf="parent"

app:layout_constraintVertical_bias="0.064" />

.

.

.

</androidx.constraintlayout.widget.ConstraintLayout>

Update MainActivity.Java

Ahora puede actualizar los elementos y la lógica para decidir cuándo crear una llamada 1:1 y cuándo unirse a una llamada de grupo. La primera parte del código requiere actualizaciones para agregar dependencias, elementos y otras configuraciones.

Dependencias:

import android.widget.RadioButton;

import com.azure.android.communication.calling.GroupCallLocator;

import com.azure.android.communication.calling.JoinCallOptions;

import java.util.UUID;

Elementos globales:

RadioButton oneToOneCall, groupCall;

Actualice onCreate():

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

getAllPermissions();

createAgent();

handleIncomingCall();

Button callButton = findViewById(R.id.call_button);

callButton.setOnClickListener(l -> startCall());

Button hangupButton = findViewById(R.id.hang_up);

hangupButton.setOnClickListener(l -> hangUp());

Button startVideo = findViewById(R.id.show_preview);

startVideo.setOnClickListener(l -> turnOnLocalVideo());

Button stopVideo = findViewById(R.id.hide_preview);

stopVideo.setOnClickListener(l -> turnOffLocalVideo());

switchSourceButton = findViewById(R.id.switch_source);

switchSourceButton.setOnClickListener(l -> switchSource());

setVolumeControlStream(AudioManager.STREAM_VOICE_CALL);

oneToOneCall = findViewById(R.id.one_to_one_call);

oneToOneCall.setOnClickListener(this::onCallTypeSelected);

oneToOneCall.setChecked(true);

groupCall = findViewById(R.id.group_call);

groupCall.setOnClickListener(this::onCallTypeSelected);

}

Actualice startCall():

private void startCall() {

Context context = this.getApplicationContext();

EditText callIdView = findViewById(R.id.call_id);

String callId = callIdView.getText().toString();

ArrayList<CommunicationIdentifier> participants = new ArrayList<CommunicationIdentifier>();

List<VideoDeviceInfo> cameras = deviceManager.getCameras();

if(oneToOneCall.isChecked()){

StartCallOptions options = new StartCallOptions();

if(!cameras.isEmpty()) {

currentCamera = getNextAvailableCamera(null);

currentVideoStream = new LocalVideoStream(currentCamera, context);

LocalVideoStream[] videoStreams = new LocalVideoStream[1];

videoStreams[0] = currentVideoStream;

VideoOptions videoOptions = new VideoOptions(videoStreams);

options.setVideoOptions(videoOptions);

showPreview(currentVideoStream);

}

participants.add(new CommunicationUserIdentifier(callId));

call = callAgent.startCall(

context,

participants,

options);

}

else{

JoinCallOptions options = new JoinCallOptions();

if(!cameras.isEmpty()) {

currentCamera = getNextAvailableCamera(null);

currentVideoStream = new LocalVideoStream(currentCamera, context);

LocalVideoStream[] videoStreams = new LocalVideoStream[1];

videoStreams[0] = currentVideoStream;

VideoOptions videoOptions = new VideoOptions(videoStreams);

options.setVideoOptions(videoOptions);

showPreview(currentVideoStream);

}

GroupCallLocator groupCallLocator = new GroupCallLocator(UUID.fromString(callId));

call = callAgent.join(

context,

groupCallLocator,

options);

}

remoteParticipantUpdatedListener = this::handleRemoteParticipantsUpdate;

onStateChangedListener = this::handleCallOnStateChanged;

call.addOnRemoteParticipantsUpdatedListener(remoteParticipantUpdatedListener);

call.addOnStateChangedListener(onStateChangedListener);

}

Agregue onCallTypeSelected():

public void onCallTypeSelected(View view) {

boolean checked = ((RadioButton) view).isChecked();

EditText callIdView = findViewById(R.id.call_id);

switch(view.getId()) {

case R.id.one_to_one_call:

if (checked){

callIdView.setHint("Callee id");

}

break;

case R.id.group_call:

if (checked){

callIdView.setHint("Group Call GUID");

}

break;

}

}

Ejecute la aplicación actualizada

En este momento, puede iniciar la aplicación mediante el botón Run App de la barra de herramientas de Android Studio.

| Actualización de pantalla | Llamada grupal |

|---|---|

|

|

Puede empezar a usar Azure Communication Services con Calling SDK de Azure Communication Services para agregar llamadas de voz y vídeo una a una a la aplicación. Aprenderá a iniciar videollamadas y a responder a ellas con el SDK de llamada de Azure Communication Services para iOS.

Código de ejemplo

Si quiere ir directamente al final, puede descargar esta guía de inicio rápido como ejemplo desde GitHub.

Requisitos previos

Obtenga una cuenta de Azure con una suscripción activa. Cree una cuenta gratuita.

Mac con Xcode, junto con un certificado de desarrollador válido instalado en el Llavero.

Cree un recurso activo de Communication Services. Cree un recurso de Communication Services. Debe registrar la cadena de conexión para esta guía de inicio rápido.

Un token de acceso de usuario para su instancia de Azure Communication Services. También puede usar la CLI de Azure y ejecutar el comando siguiente con la cadena de conexión para crear un usuario y un token de acceso.

az communication identity token issue --scope voip --connection-string "yourConnectionString"Para más información, consulte Uso de la CLI de Azure para crear y administrar tokens de acceso.

Instalación

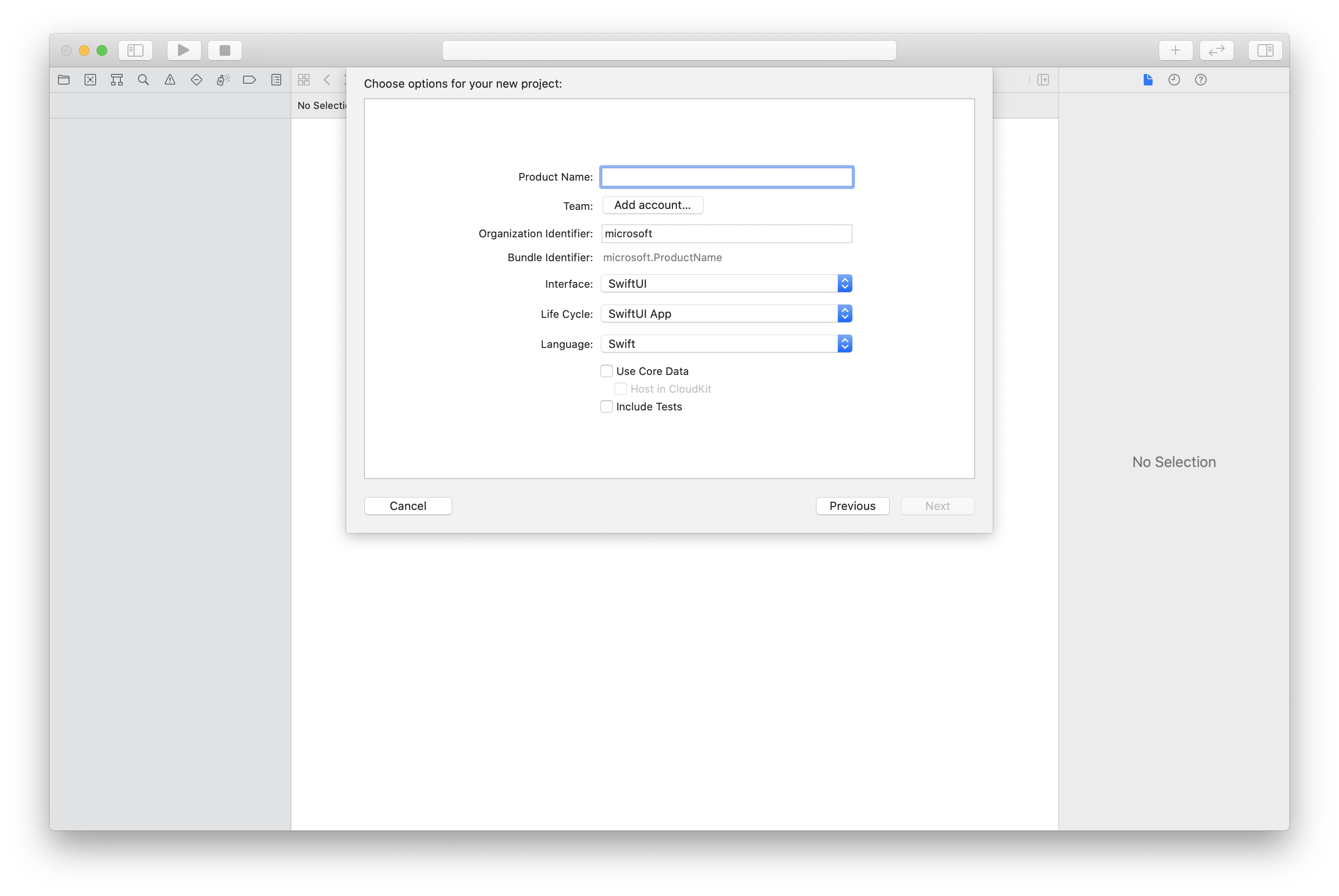

Creación del proyecto de Xcode

En Xcode, cree un nuevo proyecto de iOS y seleccione la plantilla Aplicación de una vista. En este tutorial se usa el marco SwiftUI, por lo que debe establecer el lenguaje en Swift y la interfaz de usuario en SwiftUI. Durante este inicio rápido, no va a crear pruebas. No dude en desactivar Incluir pruebas.

Instalación de CocoaPods

Utilice esta guía para instalar CocoaPods en su Mac.

Instalación del paquete y las dependencias con CocoaPods

Para crear un

Podfilepara la aplicación, abra el terminal, vaya a la carpeta del proyecto y ejecute el archivo init del pod.Agregue el siguiente código al

Podfiley guarde los cambios. Consulte las versiones de soporte técnico del SDK.

platform :ios, '13.0'

use_frameworks!

target 'VideoCallingQuickstart' do

pod 'AzureCommunicationCalling', '~> 1.0.0'

end

Ejecute la instalación del pod.

Abra

.xcworkspacecon Xcode.

Uso de XCFramework directamente

Si no usa CocoaPods como administrador de dependencias, puede descargar directamente AzureCommunicationCalling.xcframework de nuestra página de versión.

Es importante saber que AzureCommunicationCalling tiene una dependencia de AzureCommunicationCommon, por lo que debe instalarlo también en el proyecto.

Nota:

Aunque AzureCommunicationCommon es un paquete Swift puro, no se puede instalar con Swift Package Manager para utilizarlo con AzureCommunicationCalling porque este último es un marco de Objective-C y Swift Package Manager deliberadamente no admite encabezados de interfaz de Swift ObjC de manera intencionada, lo que significa que no es posible trabajar junto con AzureCommunicationCalling si se instala mediante Swift Package Manager. Tendría que instalarlo a través de otro administrador de dependencias o generar un xcframework a partir de orígenes de AzureCommunicationCommon e importarlo en el proyecto.

Solicite acceso al micrófono y a la cámara.

Para acceder al micrófono y a la cámara del dispositivo, debe actualizar la lista de propiedades de información de la aplicación con NSMicrophoneUsageDescription y NSCameraUsageDescription. Usted establece el valor asociado a una cadena que incluye el cuadro de diálogo empleado por el sistema para solicitar acceso al usuario.

Haga clic con el botón derecho en la entrada Info.plist del árbol del proyecto y seleccione Open As > Source Code (Abrir como > Código fuente). Agregue las líneas siguientes a la sección <dict> de nivel superior y guarde el archivo.

<key>NSMicrophoneUsageDescription</key>

<string>Need microphone access for VOIP calling.</string>

<key>NSCameraUsageDescription</key>

<string>Need camera access for video calling</string>

Instalación del marco de la aplicación

Abra el archivo ContentView.swift del proyecto y agregue una declaración de importación en la parte superior del archivo para importar la biblioteca AzureCommunicationCalling y AVFoundation. AVFoundation se usa para capturar el permiso de audio del código.

import AzureCommunicationCalling

import AVFoundation

Modelo de objetos

Las siguientes clases e interfaces controlan algunas de las características principales del SDK de llamadas de Azure Communication Services para iOS.

| Nombre | Descripción |

|---|---|

CallClient |

CallClient es el punto de entrada principal al SDK de llamada. |

CallAgent |

CallAgent se utiliza para iniciar y administrar las llamadas. |

CommunicationTokenCredential |

CommunicationTokenCredential se usa como la credencial del token para crear una instancia de CallAgent. |

CommunicationIdentifier |

CommunicationIdentifier se usa para representar la identidad del usuario, que puede ser una de las opciones siguientes: CommunicationUserIdentifier, PhoneNumberIdentifier o CallingApplication. |

Creación del agente de llamadas

Reemplace la implementación de struct de ContentView por algunos controles simples de la interfaz de usuario que permitan a los usuarios iniciar y finalizar una llamada. En este inicio rápido, agregaremos la lógica de negocios a estos controles.

struct ContentView: View {

@State var callee: String = ""

@State var callClient: CallClient?

@State var callAgent: CallAgent?

@State var call: Call?

@State var deviceManager: DeviceManager?

@State var localVideoStream:[LocalVideoStream]?

@State var incomingCall: IncomingCall?

@State var sendingVideo:Bool = false

@State var errorMessage:String = "Unknown"

@State var remoteVideoStreamData:[Int32:RemoteVideoStreamData] = [:]

@State var previewRenderer:VideoStreamRenderer? = nil

@State var previewView:RendererView? = nil

@State var remoteRenderer:VideoStreamRenderer? = nil

@State var remoteViews:[RendererView] = []

@State var remoteParticipant: RemoteParticipant?

@State var remoteVideoSize:String = "Unknown"

@State var isIncomingCall:Bool = false

@State var callObserver:CallObserver?

@State var remoteParticipantObserver:RemoteParticipantObserver?

var body: some View {

NavigationView {

ZStack{

Form {

Section {

TextField("Who would you like to call?", text: $callee)

Button(action: startCall) {

Text("Start Call")

}.disabled(callAgent == nil)

Button(action: endCall) {

Text("End Call")

}.disabled(call == nil)

Button(action: toggleLocalVideo) {

HStack {

Text(sendingVideo ? "Turn Off Video" : "Turn On Video")

}

}

}

}

// Show incoming call banner

if (isIncomingCall) {

HStack() {

VStack {

Text("Incoming call")

.padding(10)

.frame(maxWidth: .infinity, alignment: .topLeading)

}

Button(action: answerIncomingCall) {

HStack {

Text("Answer")

}

.frame(width:80)

.padding(.vertical, 10)

.background(Color(.green))

}

Button(action: declineIncomingCall) {

HStack {

Text("Decline")

}

.frame(width:80)

.padding(.vertical, 10)

.background(Color(.red))

}

}

.frame(maxWidth: .infinity, alignment: .topLeading)

.padding(10)

.background(Color.gray)

}

ZStack{

VStack{

ForEach(remoteViews, id:\.self) { renderer in

ZStack{

VStack{

RemoteVideoView(view: renderer)

.frame(width: .infinity, height: .infinity)

.background(Color(.lightGray))

}

}

Button(action: endCall) {

Text("End Call")

}.disabled(call == nil)

Button(action: toggleLocalVideo) {

HStack {

Text(sendingVideo ? "Turn Off Video" : "Turn On Video")

}

}

}

}.frame(maxWidth: .infinity, maxHeight: .infinity, alignment: .topLeading)

VStack{

if(sendingVideo)

{

VStack{

PreviewVideoStream(view: previewView!)

.frame(width: 135, height: 240)

.background(Color(.lightGray))

}

}

}.frame(maxWidth:.infinity, maxHeight:.infinity,alignment: .bottomTrailing)

}

}

.navigationBarTitle("Video Calling Quickstart")

}.onAppear{

// Authenticate the client

// Initialize the CallAgent and access Device Manager

// Ask for permissions

}

}

}

//Functions and Observers

struct PreviewVideoStream: UIViewRepresentable {

let view:RendererView

func makeUIView(context: Context) -> UIView {

return view

}

func updateUIView(_ uiView: UIView, context: Context) {}

}

struct RemoteVideoView: UIViewRepresentable {

let view:RendererView

func makeUIView(context: Context) -> UIView {

return view

}

func updateUIView(_ uiView: UIView, context: Context) {}

}

struct ContentView_Previews: PreviewProvider {

static var previews: some View {

ContentView()

}

}

Autenticar el cliente

Para poder inicializar una instancia de CallAgent, necesita un token de acceso de usuario que permita realizar y recibir llamadas. Consulte la documentación sobre el token de acceso de usuario si no tiene ningún token disponible.

Una vez que tenga un token, agregue el código siguiente a la devolución de llamada onAppear en el archivo ContentView.swift. Debe reemplazar <USER ACCESS TOKEN> por un token de acceso de usuario válido para el recurso:

var userCredential: CommunicationTokenCredential?

do {

userCredential = try CommunicationTokenCredential(token: "<USER ACCESS TOKEN>")

} catch {

print("ERROR: It was not possible to create user credential.")

return

}

Inicialice CallAgent y acceda al Administrador de dispositivos

Para crear una instancia de CallAgent desde una instancia de CallClient, utilice el método callClient.createCallAgent que devuelva asincrónicamente un objeto CallAgent cuando se inicialice. El Administrador de dispositivos permite enumerar los dispositivos locales que se pueden usar en una llamada para transmitir secuencias de audio o vídeo. También permite solicitar permiso a un usuario para acceder al micrófono o a la cámara.

self.callClient = CallClient()

self.callClient?.createCallAgent(userCredential: userCredential!) { (agent, error) in

if error != nil {

print("ERROR: It was not possible to create a call agent.")

return

}

else {

self.callAgent = agent

print("Call agent successfully created.")

self.callAgent!.delegate = incomingCallHandler

self.callClient?.getDeviceManager { (deviceManager, error) in

if (error == nil) {

print("Got device manager instance")

self.deviceManager = deviceManager

} else {

print("Failed to get device manager instance")

}

}

}

}

Solicitud de permisos

Para solicitar permisos de audio y vídeo, es necesario agregar el código siguiente a la devolución de llamada onAppear.

AVAudioSession.sharedInstance().requestRecordPermission { (granted) in

if granted {

AVCaptureDevice.requestAccess(for: .video) { (videoGranted) in

/* NO OPERATION */

}

}

}

Configuración de la sesión de audio

Use un objeto AVAudioSession para configurar la sesión de audio de la aplicación. Este es un ejemplo de habilitación del dispositivo de audio Bluetooth para la aplicación:

func configureAudioSession() -> Error? {

// Retrieve the audio session.

let audioSession: AVAudioSession = AVAudioSession.sharedInstance()

// set options to allow bluetooth device

let options: AVAudioSession.CategoryOptions = .allowBluetooth

var configError: Error?

do {

// Set the audio session category.

try audioSession.setCategory(.playAndRecord, options: options)

print("configureAudioSession successfully")

} catch {

print("configureAudioSession failed")

configError = error

}

return configError

}

Visualización de un vídeo local

Antes de iniciar una llamada, puede administrar la configuración relacionada con el vídeo. En este inicio rápido, implementaremos la capacidad de activar o desactivar un vídeo local antes o durante una llamada.

En primer lugar, tenemos que acceder a las cámaras locales con deviceManager. Una vez que se haya seleccionado la cámara que queramos, podemos construir LocalVideoStream, crear un objeto VideoStreamRenderer y asociarlo a previewView. Durante la llamada, podemos usar startVideo o stopVideo para iniciar o detener el envío de LocalVideoStream a participantes remotos. Esta función también puede utilizarse con el control de llamadas entrantes.

func toggleLocalVideo() {

// toggling video before call starts

if (call == nil)

{

if(!sendingVideo)

{

self.callClient = CallClient()

self.callClient?.getDeviceManager { (deviceManager, error) in

if (error == nil) {

print("Got device manager instance")

self.deviceManager = deviceManager

} else {

print("Failed to get device manager instance")

}

}

guard let deviceManager = deviceManager else {

return

}

let camera = deviceManager.cameras.first

let scalingMode = ScalingMode.fit

if (self.localVideoStream == nil) {

self.localVideoStream = [LocalVideoStream]()

}

localVideoStream!.append(LocalVideoStream(camera: camera!))

previewRenderer = try! VideoStreamRenderer(localVideoStream: localVideoStream!.first!)

previewView = try! previewRenderer!.createView(withOptions: CreateViewOptions(scalingMode:scalingMode))

self.sendingVideo = true

}

else{

self.sendingVideo = false

self.previewView = nil

self.previewRenderer!.dispose()

self.previewRenderer = nil

}

}

// toggle local video during the call

else{

if (sendingVideo) {

call!.stopVideo(stream: localVideoStream!.first!) { (error) in

if (error != nil) {

print("cannot stop video")

}

else {

self.sendingVideo = false

self.previewView = nil

self.previewRenderer!.dispose()

self.previewRenderer = nil

}

}

}

else {

guard let deviceManager = deviceManager else {

return

}

let camera = deviceManager.cameras.first

let scalingMode = ScalingMode.fit

if (self.localVideoStream == nil) {

self.localVideoStream = [LocalVideoStream]()

}

localVideoStream!.append(LocalVideoStream(camera: camera!))

previewRenderer = try! VideoStreamRenderer(localVideoStream: localVideoStream!.first!)

previewView = try! previewRenderer!.createView(withOptions: CreateViewOptions(scalingMode:scalingMode))

call!.startVideo(stream:(localVideoStream?.first)!) { (error) in

if (error != nil) {

print("cannot start video")

}

else {

self.sendingVideo = true

}

}

}

}

}

Realización de una llamada saliente

El método startCall se establece como la acción que se lleva a cabo cuando se toca el botón de Iniciar llamada. En este inicio rápido, de manera predeterminada, las llamadas salientes son solo de audio. Para iniciar una llamada con vídeo, debemos establecer VideoOptions con LocalVideoStream y pasarlo con startCallOptions para definir las opciones iniciales de la llamada.

func startCall() {

let startCallOptions = StartCallOptions()

if(sendingVideo)

{

if (self.localVideoStream == nil) {

self.localVideoStream = [LocalVideoStream]()