Descripción de grandes volúmenes en Azure NetApp Files

Los volúmenes de Azure NetApp Files son la forma en que presenta un almacenamiento de alto rendimiento y rentable a los clientes de almacenamiento conectado a la red (NAS) en la nube de Azure. Los volúmenes actúan como sistemas de archivos independientes con su propia capacidad, recuentos de archivos, ACL, instantáneas e identificadores de sistema de archivos. Estas cualidades proporcionan una manera de separar los conjuntos de datos en inquilinos seguros individuales.

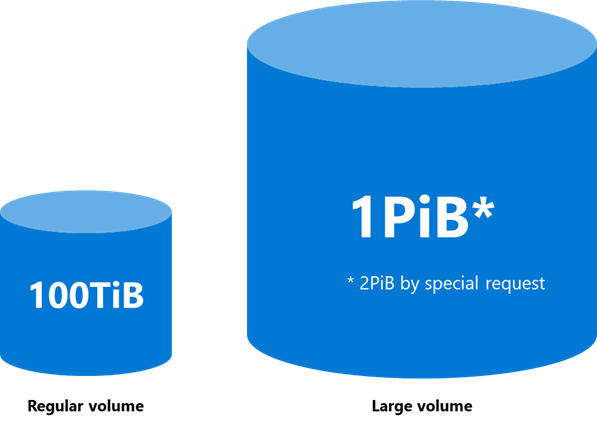

Todos los recursos de Azure NetApp Files tienen límites. Los volúmenes normales tienen las siguientes limitaciones:

| Tipo de límite | Límites |

|---|---|

| Capacity |

|

| Número de archivos | 2 147 483 632 |

| Rendimiento |

|

Los volúmenes grandes tienen las siguientes limitaciones:

| Tipo de límite | Valores |

|---|---|

| Capacity |

|

| Número de archivos | 15 938 355 048 |

| Rendimiento |

|

Los grandes volúmenes afectan al rendimiento

En muchos casos, un volumen normal puede gestionar las necesidades de rendimiento para una carga de trabajo de producción, especialmente cuando se trata de cargas de trabajo de bases de datos, archivos compartidos generales y cargas de trabajo de infraestructura de escritorio virtual (VDI) o Azure VMware Service. Cuando las cargas de trabajo tienen muchos metadatos o requieren una escala superior a la que puede admitir un volumen normal, un volumen grande puede aumentar las necesidades de rendimiento con un impacto mínimo en los costes.

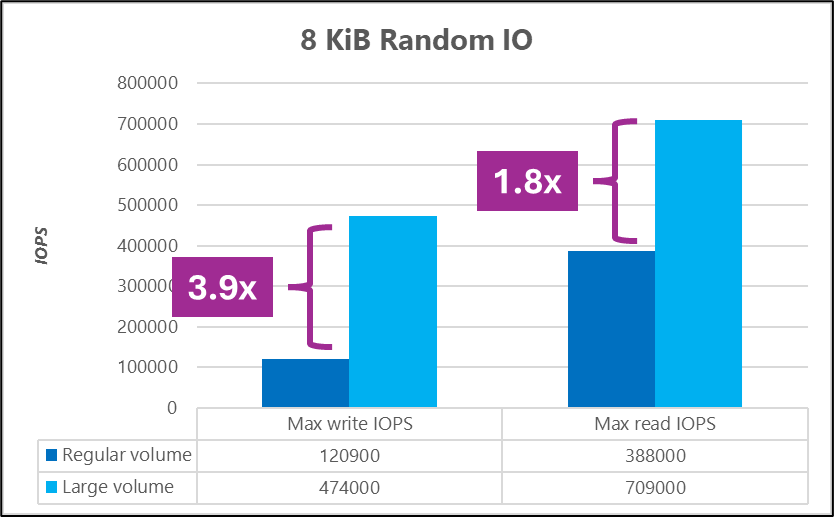

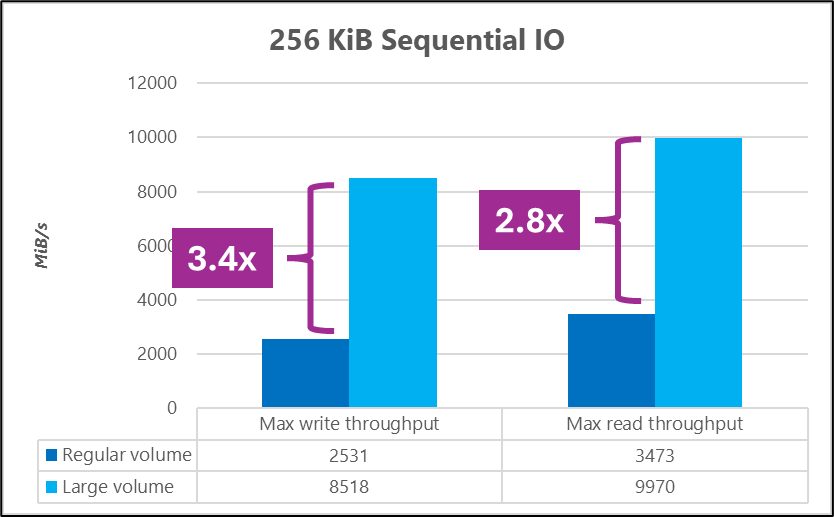

Por ejemplo, los siguientes gráficos muestran que un gran volumen puede ofrecer de dos a tres veces más rendimiento a escala que un volumen normal.

Para obtener más información sobre las pruebas de rendimiento, consulte Pruebas comparativas de rendimiento de gran volumen para Linux y Pruebas comparativas de rendimiento de volumen normal para Linux.

Por ejemplo, en las pruebas comparativas realizadas con FIO (Evaluador de E/S flexible), un volumen de gran tamaño alcanzó mayores I/OPS y rendimiento que un volumen normal.

Tipos de carga de trabajo y casos de uso

Los volúmenes normales pueden controlar la mayoría de las cargas de trabajo. Una vez alcanzada la capacidad, el recuento de archivos, el rendimiento o los límites de escala, se deben crear nuevos volúmenes. Esta condición agrega complejidad innecesaria a una solución.

Los grandes volúmenes permiten que las cargas de trabajo se extiendan más allá de las limitaciones actuales de los volúmenes normales. En la tabla siguiente se muestran algunos ejemplos de casos de uso para cada tipo de volumen.

| Volume type | Casos de uso principales |

|---|---|

| Volúmenes normales |

|

| Volúmenes grandes |

|