Configuración del bucle de aprendizaje de Personalizer

Importante

A partir del 20 de septiembre de 2023, no podrá crear nuevos recursos de Personalizer. El servicio Personalizer se va a retirar el 1 de octubre de 2026.

La configuración del servicio incluye la forma en que el servicio trata las recompensas, la frecuencia con el servicio realiza las exploraciones, la frecuencia con que se vuelve a entrenar al modelo y la cantidad de datos que se almacenan.

Configure el bucle de aprendizaje en la página Configuración de Azure Portal para ese recurso de Personalizer.

Planificación de los cambios de configuración

Dado que algunos cambios de configuración restablecen el modelo, debe planear los cambios de configuración.

Si tiene previsto usar el modo de aprendiz, asegúrese de revisar la configuración de Personalizer antes de cambiar al modo de aprendiz.

Configuración que incluye el restablecimiento del modelo

Las siguientes acciones desencadenan un nuevo aprendizaje del modelo mediante los datos disponibles hasta los dos últimos días.

- Recompensa

- Exploración

Para borrar todos los datos, use la página Configuración de modelo y aprendizaje.

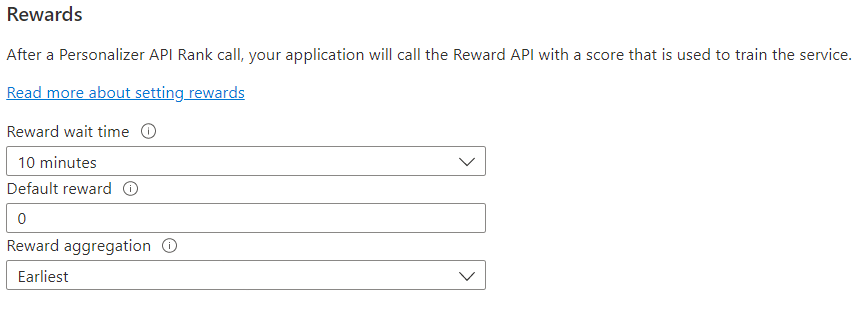

Configuración de recompensas para el bucle de comentarios

Configure el servicio para el uso de recompensas del bucle de aprendizaje. Los cambios que se realicen en los valores siguientes restablecerán el modelo actual de Personalizer y volverán a entrenarlo con los datos de los dos últimos días.

| Value | Propósito |

|---|---|

| Tiempo de espera de las recompensas | Establece el período durante el que Personalizer recopilará los valores de recompensa de una llamada a Rank, desde el momento en que se produce dicha llamada. Para definir este valor, se pregunta: "¿Cuánto tiempo debe esperar Personalizer las llamadas de recompensa?" Cualquier recompensa que llegue después de este intervalo se registrará, pero no se usará para el aprendizaje. |

| Recompensa predeterminada | Si Personalizer no recibe ninguna llamada de recompensa por durante el período de tiempo de espera de las recompensas asociado a una llamada a Rank, Personalizer asignará la recompensa predeterminada. De forma predeterminada y en la mayoría de los escenarios, la recompensa predeterminada es cero (0). |

| Agregación de recompensas | Si se reciben varias recompensas para la misma llamada de la API Rank, se usa este método de agregación: suma o más antiguo. El primero elige la primera puntuación recibida y descarta el resto. Esto es útil si desea una única recompensa para las posibles llamadas duplicadas. |

Después de cambiar estos valores, asegúrese de seleccionar Guardar.

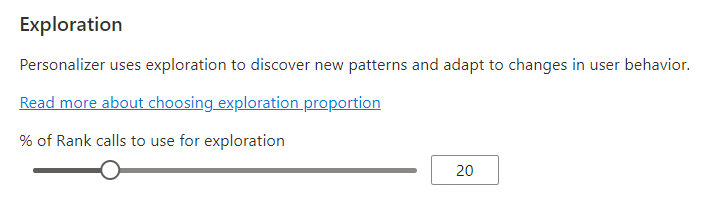

Configuración de la exploración para permitir la adaptación del bucle de aprendizaje

Personalization puede detectar nuevos patrones y adaptarlos a los cambios de comportamiento de los usuarios con el paso del tiempo mediante la exploración de alternativas, en lugar de usar la predicción del modelo entrenado. El valor Exploration determina qué porcentaje de las llamadas a Rank se responden con una exploración.

Los cambios que se realicen en este valor restablecerán el modelo actual de Personalizer y lo volverán a entrenar con los datos de los dos últimos días.

Después de cambiar este valor, asegúrese de seleccionar Guardar.

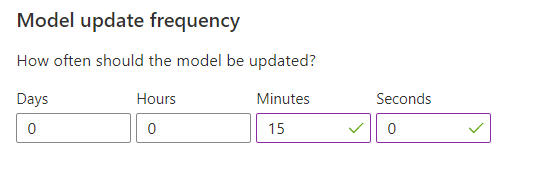

Configuración de la frecuencia de actualización del modelo para el entrenamiento del modelo

La Frecuencia de actualización del modelo establece la frecuencia con qué se entrena el modelo.

| Valor de frecuencia | Propósito |

|---|---|

| 1 minuto. | Las frecuencias de actualización de un minuto son útiles cuando se depura el código de una aplicación mediante Personalizer, se realizan demostraciones o se prueban de forma interactiva ciertos aspectos del aprendizaje automático. |

| 15 minutos | Las frecuencias elevadas de actualización del modelo son útiles en aquellas situaciones en las que se desea hacer un estrecho seguimiento de los cambios en los comportamientos de los usuarios. Algunos ejemplos incluyen sitios que ofrecen noticias en vivo, contenido viral o pujas en vivo. En estos escenarios se puede usar una frecuencia de 15 minutos. |

| 1 hora | Sin embargo, en la mayor parte de los casos una menor frecuencia de actualización resulta muy efectiva. |

Después de cambiar este valor, asegúrese de seleccionar Guardar.

Retención de datos

Período de retención de datos establece el número de días que Personalizer conserva los registros de datos. Los registros de datos anteriores se necesitan para realizar evaluaciones sin conexión, que se usan para medir la eficacia de Personalizer y optimizar la directiva de aprendizaje.

Después de cambiar este valor, asegúrese de seleccionar Guardar.