Inicio rápido: Studio de Seguridad del contenido de Azure AI

Este artículo explica cómo empezar a utilizar el servicio de Seguridad del contenido de Azure AI con el Estudio de Seguridad del contenido en su navegador.

Precaución

Algunos de los contenidos de ejemplo proporcionados por Content Safety Studio pueden ser ofensivos. Las imágenes de ejemplo están difuminadas de manera predeterminada. Se recomienda discreción al usuario.

Requisitos previos

- Una cuenta de Azure. Si no tiene ninguna, puede crearla gratis.

- Un recurso de Azure de seguridad del contenido.

- Asigne el rol de usuario de Cognitive Services a su cuenta. Vaya a Azure Portal, desplácese al recurso de Seguridad de contenido o al recurso de Servicios de Azure AI y seleccione Control de acceso en la barra de navegación izquierda y, a continuación, haga clic en + Agregar asignación de roles, elija el rol Usuario de Cognitive Services y seleccione el miembro de la cuenta a la que necesita asignar este rol y, a continuación, realice la revisión y la asignación. La asignación puede tardar unos minutos en surtir efecto.

- Inicie sesión en Content Safety Studio con la suscripción de Azure y el recurso de seguridad del contenido.

Importante

Debe asignar el rol de Usuario de Cognitive Services a su cuenta de Azure para usar la experiencia de Studio. Vaya a Azure Portal, desplácese al recurso de Seguridad de contenido o al recurso de Servicios de Azure AI y seleccione Control de acceso en la barra de navegación izquierda y, a continuación, haga clic en + Agregar asignación de roles, elija el rol Usuario de Cognitive Services y seleccione el miembro de la cuenta a la que necesita asignar este rol y, a continuación, realice la revisión y la asignación. La asignación puede tardar unos minutos en surtir efecto.

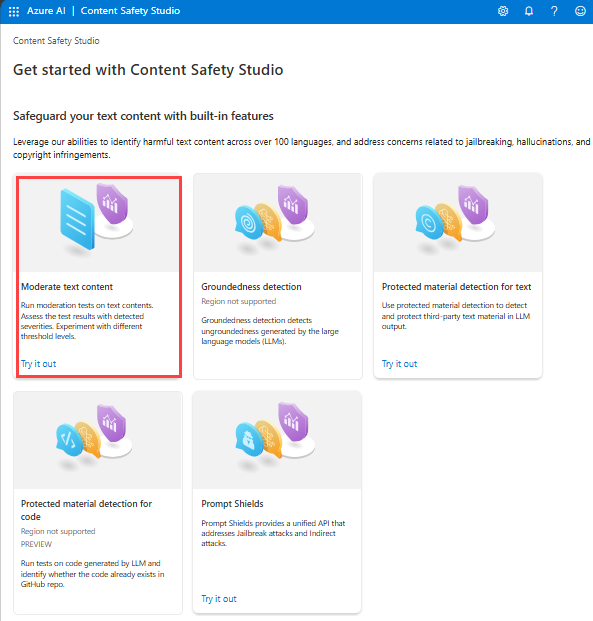

Análisis de contenido de texto

La página Moderación de contenido de texto proporciona funcionalidad para que pueda probar rápidamente la moderación de texto.

- Seleccione el panel Moderate text content.

- Agregue texto al campo de entrada o seleccione texto de ejemplo en los paneles de la página.

Sugerencia

Tamaño y granularidad del texto: consulte Requisitos de entrada para conocer las limitaciones de longitud máxima del texto.

- Haga clic en Ejecutar prueba.

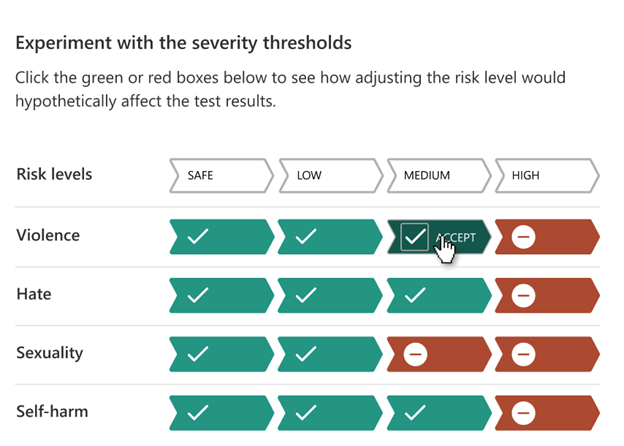

El servicio devuelve todas las categorías detectadas con el nivel de gravedad de cada una (0-Seguro, 2-Bajo, 4-Medio, 6-Alto). También devuelve un resultado binario Aceptado/Rechazado en función de los filtros que configure. Use la matriz de la pestaña Configure filters de la derecha para establecer los niveles de gravedad permitidos o prohibidos para cada categoría. A continuación, puede volver a ejecutar el texto para ver cómo funciona el filtro.

La pestaña Usar lista de bloqueados le permite crear, editar y agregar una lista de bloqueados al flujo de trabajo de moderación. Si tiene habilitada una lista de bloqueados al ejecutar la prueba, obtendrá el panel Blocklist detection en Results. Notifica cualquier coincidencia con la lista de bloqueados.

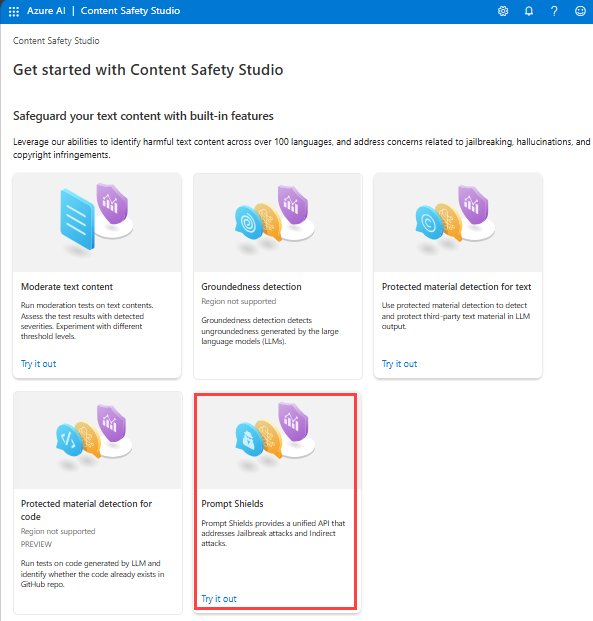

Detección de ataques de entrada de usuario

El panel Escudos de avisos permite probar la detección de riesgo de entrada de usuario. Detecte aquellos mensajes de usuario diseñados para provocar que el modelo de IA generativa muestre comportamientos que fue entrenado para evitar o infringir las reglas establecidas en el mensaje del sistema. Estos ataques pueden variar desde un intrincado juego de roles a una subversión sutil del objetivo de seguridad.

- Seleccione el panel Escudos de avisos.

- Seleccione un texto de ejemplo en la página o escriba su propio contenido para realizar pruebas. También puede cargar un archivo CSV para realizar una prueba por lotes.

- Haga clic en Ejecutar prueba.

El servicio devuelve la marca de riesgo y el tipo para cada ejemplo.

Para obtener más información, consulte la guía conceptual de Escudos de avisos.

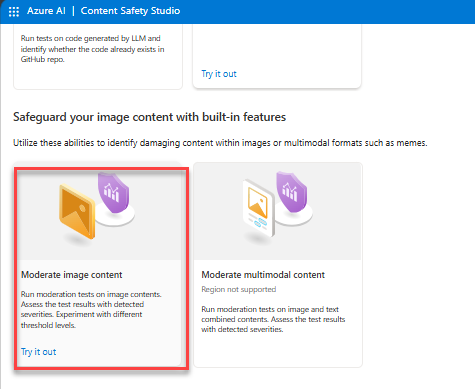

Análisis de contenido de imágenes

La página Moderate image content proporciona funcionalidad para que pueda probar rápidamente la moderación de texto.

- Seleccione el panel Moderate image content.

- Seleccione una imagen de ejemplo de los paneles de la página o cargue su propia imagen. El tamaño máximo de los envíos de imágenes es de 4 MB y las dimensiones de la imagen deben estar entre 50 x 50 píxeles y 2048 x 2048 píxeles. Las imágenes pueden estar en formato JPEG, PNG, GIF, BMP, TIFF o WEBP.

- Haga clic en Ejecutar prueba.

El servicio devuelve todas las categorías detectadas con el nivel de gravedad de cada una (0-Seguro, 2-Bajo, 4-Medio, 6-Alto). También devuelve un resultado binario Aceptado/Rechazado en función de los filtros que configure. Use la matriz de la pestaña Configure filters de la derecha para establecer los niveles de gravedad permitidos o prohibidos para cada categoría. A continuación, puede volver a ejecutar el texto para ver cómo funciona el filtro.

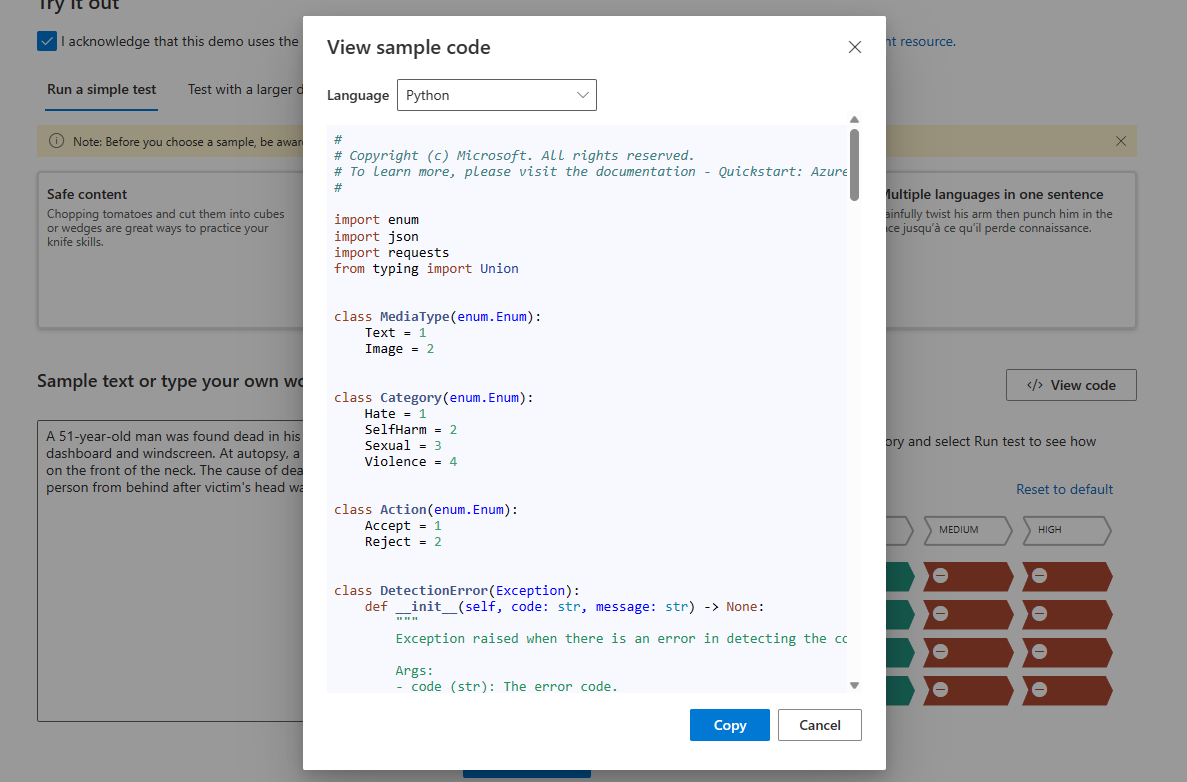

Visualización y exportación de código

Puede usar la característica View Code en la página Analyze text content o Analyze image content para ver y copiar el código de ejemplo, que incluye la configuración de las funciones de filtrado de gravedad, listas de bloqueados y moderación. A continuación, puede implementar el código en su extremo.

Supervisión de la actividad en línea

La página Monitor online activity le permite ver el uso de la API y las tendencias.

Puede elegir qué tipo de elementos multimedia se va a supervisar. También puede especificar el intervalo de tiempo que desea comprobar si selecciona Show data for the last __.

En el gráfico Reject rate per category, también puede ajustar los umbrales de gravedad de cada categoría.

También puede editar listas de bloqueados si desea cambiar algunos términos, en función del gráfico Top 10 blocked terms.

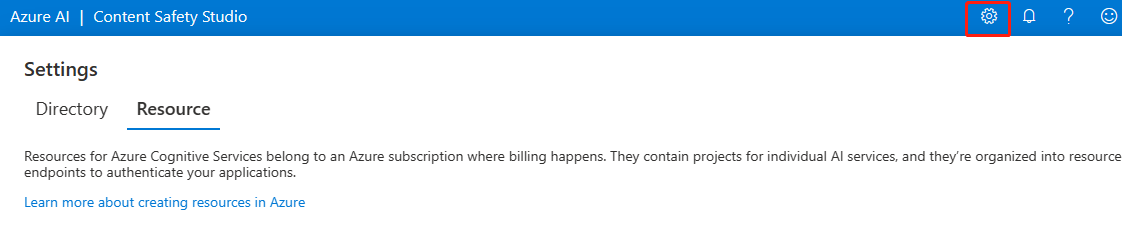

Administración de recursos

Para ver los detalles del recurso, como el nombre y el plan de tarifa, seleccione el icono Settings en la esquina superior derecha de la página principal de Content Safety Studio y seleccione la pestaña Resource. Si tiene otros recursos, también puede cambiar de recurso aquí.

Limpieza de recursos

Si quiere limpiar y eliminar un recurso de servicios de Azure AI, puede eliminar el recurso o el grupo de recursos. Al eliminar el grupo de recursos, también se elimina cualquier otro recurso que esté asociado a él.

Paso siguiente

A continuación, empiece a usar la Seguridad del contenido de Azure AI mediante las API de REST o un SDK de cliente para que pueda integrar sin problemas el servicio en la aplicación.