Implementación de un modelo de voz personalizada

En este artículo, aprenderá a implementar un punto de conexión para un modelo de voz personalizada. Excepto con la transcripción por lotes, tiene que implementar un punto de conexión personalizado para usar un modelo de voz personalizada.

Sugerencia

No se requiere un punto de conexión de implementación hospedado para usar la voz personalizada con la API de transcripción de Batch. Es posible conservar los recursos si el modelo de voz personalizado solo se usa para la transcripción por lotes. Para más información, consulte Precios del servicio de voz.

Puede implementar un punto de conexión para un modelo base o personalizado y, luego, actualizar el punto de conexión para usar un modelo mejor entrenado.

Nota

Los puntos de conexión usados por los recursos de Voz F0 se eliminan después de siete días.

Incorporación de un extremo de implementación

Para crear un punto de conexión privado, siga estos pasos:

Inicie sesión en Speech Studio.

Seleccione Voz personalizada> El nombre del proyecto >Implementación de modelos.

Si se trata del primer punto de conexión, observará que no aparece ningún punto de conexión en la tabla. Después de crear un punto de conexión, usará esta página para realizar el seguimiento de cada punto de conexión implementado.

Seleccione Implementar modelo para iniciar el asistente para el nuevo punto de conexión.

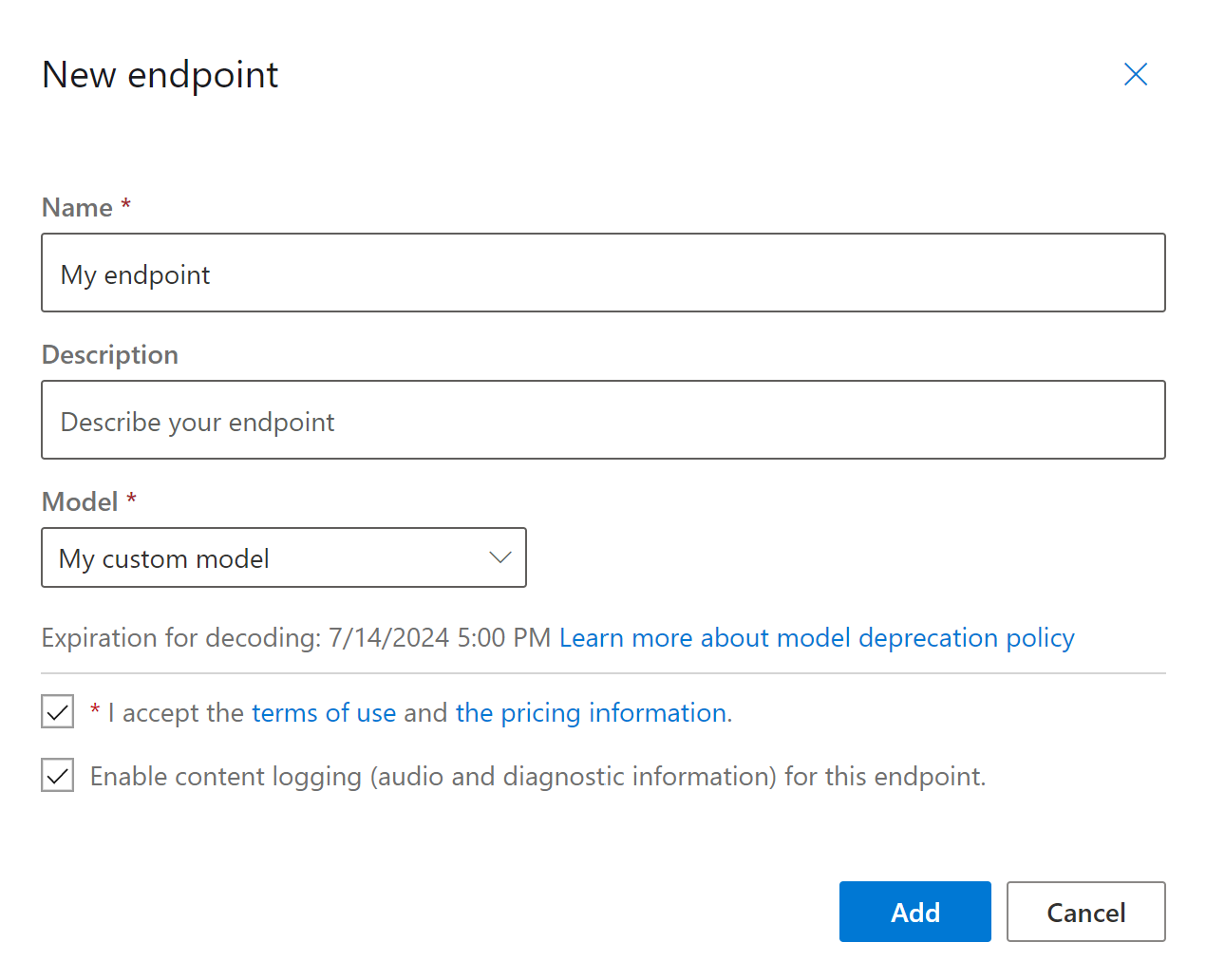

Seleccione Nuevo punto de conexión, escriba un nombre y una descripción para el punto de conexión personalizado.

Seleccione el modelo personalizado que desea asociar al punto de conexión.

Opcionalmente, puede activar la casilla para habilitar el registro de audio y diagnóstico del tráfico del punto de conexión.

Seleccione Agregar para guardar e implementar el punto de conexión.

En la página principal Implementar modelos, los detalles sobre el nuevo punto de conexión se muestran en una tabla, como el nombre, la descripción, el estado y la fecha de expiración. Se puede tardar hasta 30 minutos en crear una instancia de un nuevo punto de conexión que use los modelos personalizados. Cuando el estado de la implementación cambie a Correcta, el punto de conexión estará listo para su uso.

Importante

Tome nota de la fecha de expiración del modelo. Esta es la última fecha en la que puede usar el modelo personalizado para el reconocimiento de voz. Para más información, consulte Ciclo de vida del modelo y el punto de conexión.

Seleccione el vínculo del punto de conexión para ver información específica de él, como la clave de punto de conexión, la dirección URL del punto de conexión y el código de ejemplo.

Para crear un punto de conexión e implementar un modelo, use el comando spx csr endpoint create. Construya los parámetros de solicitud según las instrucciones siguientes:

- Establezca el parámetro

projecten el identificador de un proyecto existente. Esto se recomienda para que también pueda ver y administrar el punto de conexión en Speech Studio. Puede ejecutar el comandospx csr project listpara obtener los proyectos disponibles. - Establezca el parámetro

modelobligatorio en el identificador del modelo que quiere implementar en el punto de conexión. - Establezca el parámetro

languagenecesario. La configuración regional del punto de conexión tiene que coincidir con la configuración regional del modelo. Esta configuración regional no se podrá modificar más adelante. El parámetrolanguagede la CLI de Voz corresponde a la propiedadlocalede la solicitud y respuesta JSON. - Establezca el parámetro

namenecesario. Este es el nombre que se mostrará en Speech Studio. El parámetronamede la CLI de Voz corresponde a la propiedaddisplayNamede la solicitud y respuesta JSON. - También tiene la opción de definir el parámetro

logging. Establézcalo enenabledpara habilitar el registro de audio y diagnóstico del tráfico del punto de conexión. El valor predeterminado esfalse.

Este es un ejemplo del comando de la CLI de Voz para crear un punto de conexión e implementar un modelo:

spx csr endpoint create --api-version v3.2 --project YourProjectId --model YourModelId --name "My Endpoint" --description "My Endpoint Description" --language "en-US"

Debe recibir un cuerpo de respuesta en el formato siguiente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

La propiedad self de nivel superior del cuerpo de la respuesta es el URI del punto de conexión. Use este URI para obtener detalles sobre el proyecto, el modelo y los registros del punto de conexión. También usará este URI para actualizar el punto de conexión.

Para obtener ayuda de la CLI de Voz con puntos de conexión, ejecute el siguiente comando:

spx help csr endpoint

Para crear un punto de conexión e implementar un modelo, use la operación Endpoints_Create de la API REST de conversión de voz en texto. Construya el cuerpo de la solicitud según las instrucciones siguientes:

- Establezca la propiedad

projecten el URI de un proyecto existente. Esto se recomienda para que también pueda ver y administrar el punto de conexión en Speech Studio. Puede realizar una solicitud Projects_List para obtener proyectos disponibles. - Establezca la propiedad

modelobligatoria en el URI del modelo que quiere implementar en el punto de conexión. - Establezca la propiedad

localeobligatoria. La configuración regional del punto de conexión tiene que coincidir con la configuración regional del modelo. Esta configuración regional no se podrá modificar más adelante. - Establezca la propiedad

displayNamerequerida. Este es el nombre que se mostrará en Speech Studio. - También tiene la opción de definir la propiedad

loggingEnabledenproperties. Establézcalo entruepara habilitar el registro de audio y diagnóstico del tráfico del punto de conexión. El valor predeterminado esfalse.

Haga una solicitud HTTP POST con el URI como se muestra en el siguiente ejemplo de Endpoints_Create. Reemplace YourSubscriptionKey por la clave de recurso de Voz, YourServiceRegion por la región del recurso de Voz, y establezca las propiedades del cuerpo de la solicitud como se ha descrito anteriormente.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"displayName": "My Endpoint",

"description": "My Endpoint Description",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"locale": "en-US",

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints"

Debe recibir un cuerpo de respuesta en el formato siguiente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

La propiedad self de nivel superior del cuerpo de la respuesta es el URI del punto de conexión. Use este URI para obtener detalles sobre el proyecto, el modelo y los registros del punto de conexión. Use también este URI para actualizar o eliminar el punto de conexión.

Cambio del modelo y reimplementación del punto de conexión

Un punto de conexión se puede actualizar para usar otro modelo creado por el mismo recurso de Voz. Como se mencionó anteriormente, debe actualizar el modelo del punto de conexión antes de que expire el modelo.

Para usar un nuevo modelo y volver a implementar el punto de conexión personalizado:

- Inicie sesión en Speech Studio.

- Seleccione Voz personalizada> El nombre del proyecto >Implementación de modelos.

- Seleccione el vínculo a un punto de conexión por nombre y luego seleccione Cambiar modelo.

- Seleccione el nuevo modelo que desea que use el punto de conexión.

- Seleccione Listo para guardar y volver a implementar el punto de conexión.

Para volver a implementar el punto de conexión personalizado con un nuevo modelo, use el comando spx csr model update. Construya los parámetros de solicitud según las instrucciones siguientes:

- Establezca el parámetro

endpointobligatorio en el identificador del punto de conexión que quiere implementar. - Establezca el parámetro

modelobligatorio en el identificador del modelo que quiere implementar en el punto de conexión.

Este es un ejemplo de comando de la CLI de Voz que vuelve a implementar el punto de conexión personalizado con un nuevo modelo:

spx csr endpoint update --api-version v3.2 --endpoint YourEndpointId --model YourModelId

Debe recibir un cuerpo de respuesta en el formato siguiente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Para obtener ayuda de la CLI de Voz con puntos de conexión, ejecute el siguiente comando:

spx help csr endpoint

Para volver a implementar el punto de conexión personalizado con un nuevo modelo, use la operación Endpoints_Update de la API REST de conversión de voz en texto. Construya el cuerpo de la solicitud según las instrucciones siguientes:

- Establezca la propiedad

modelen el URI del modelo que quiere implementar en el punto de conexión.

Realice una solicitud HTTP PATCH con el URI, como se muestra en el ejemplo siguiente. Reemplace YourSubscriptionKey por la clave de recurso de Voz, reemplace YourServiceRegion por la región del recurso de Voz, reemplace YourEndpointId por el identificador del punto de conexión, y establezca las propiedades del cuerpo de la solicitud como se ha descrito anteriormente.

curl -v -X PATCH -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId"

Debe recibir un cuerpo de respuesta en el formato siguiente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

La reimplementación tarda varios minutos en completarse. Mientras tanto, el punto de conexión usa el modelo anterior sin interrupción del servicio.

Visualización de datos de registro

Los datos de registro están disponibles para su exportación si los configuró al crear el punto de conexión.

Para descargar los registros del punto de conexión:

- Inicie sesión en Speech Studio.

- Seleccione Voz personalizada> El nombre del proyecto >Implementación de modelos.

- Seleccione el vínculo por nombre de punto de conexión.

- En Registro de contenido, seleccione Descargar registro.

Para obtener los registros de un punto de conexión, use el comando spx csr endpoint list. Construya los parámetros de solicitud según las instrucciones siguientes:

- Establezca el parámetro

endpointobligatorio en el identificador del punto de conexión para el que quiere obtener los registros.

Este es un ejemplo de comando de la CLI de Voz que obtiene los registros de un punto de conexión:

spx csr endpoint list --api-version v3.2 --endpoint YourEndpointId

Las ubicaciones de cada archivo de registro con más detalles se devuelven en el cuerpo de la respuesta.

Para obtener registros de un punto de conexión, empiece por usar la operación Endpoints_Get de la API REST de conversión de voz en texto.

Haga una solicitud HTTP GET con el URI, tal como se muestra en el ejemplo siguiente. Reemplace YourEndpointId por el identificador del punto de conexión, YourSubscriptionKey por la clave del recurso de Voz y YourServiceRegion por la región del recurso de Voz.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Debe recibir un cuerpo de respuesta en el formato siguiente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Haga una solicitud HTTP GET con el URI de "logs" del cuerpo de respuesta anterior. Reemplace YourEndpointId por el identificador del punto de conexión, YourSubscriptionKey por la clave del recurso de Voz y YourServiceRegion por la región del recurso de Voz.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId/files/logs" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Las ubicaciones de cada archivo de registro con más detalles se devuelven en el cuerpo de la respuesta.

Los datos de registro están disponibles en el almacenamiento propiedad de Microsoft durante 30 días, tras los cuales se quitan. Si su propia cuenta de almacenamiento está vinculada a la suscripción a los servicios de Azure AI, los datos de registro no se eliminan automáticamente.