Note

Access to this page requires authorization. You can try signing in or changing directories.

Access to this page requires authorization. You can try changing directories.

Article d’origine publié le samedi 15 septembre 2012

Public : Administrateur de recherche/professionnel de l’informatique

Conditions préalables : ce billet suppose que le lecteur a des connaissances de base dans l’administration de la recherche en ce qui concerne la topologie de recherche, le mécanisme d’analyse et les principes planification de l’analyse dans SharePoint.

Remarque : il s’agit d’une nouvelle fonctionnalité dans SharePoint 2013.

Qu’est ce que l’actualisation des résultats de la recherche ?

Quand un utilisateur télécharge un document vers son site SharePoint, la période précédant la mise à disposition de ce document pour « faire l’objet d’une recherche » via le portail de recherche SharePoint indique le temps de latence de l’actualisation.

De quels éléments dépend l’actualisation ?

De plusieurs facteurs : de la taille du référentiel, du taux de modification, du délai entre la requête et l’obtention d’une réponse du référentiel, de la planification de l’analyse, des types de modifications. La principale raison est que, pour qu’un document puisse « faire l’objet d’une recherche », une analyse doit être déclenchée (manuellement ou automatiquement par planification). La modification doit donc être identifiée, demandée et traitée.

Quel est donc le problème ?

Normalement, deux options de planification nous étaient proposées dans le service de recherche SharePoint : l’analyse complète et l’analyse incrémentielle. Une analyse complète démarre la découverte de l’ensemble de l’hôte, tandis qu’une analyse incrémentielle ne traite que les éléments de l’hôte qui ont changé depuis la dernière analyse, soit en comparant les horodatages des documents, soit en réutilisant un journal de modifications préexistant pour ce référentiel qui effectue le suivi les documents modifiés. Pour garantir une actualisation optimale, l’approche recommandée est d’utiliser une recherche incrémentielle plus agressive (c’est-à-dire toutes les 30 min chaque jour).

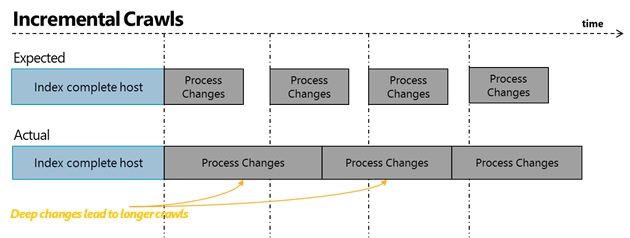

L’une des limitations des analyses complète et incrémentielle est que vous ne pouvez pas les exécuter en parallèle, c’est-à-dire, si l’une de ces deux analyses est en cours d’exécution, l’administrateur ne peut pas démarrer une autre analyse sur cette source de contenu. Par conséquent, vous devez adopter une approche « premier entré, premier sorti » par rapport à la manière dont les éléments sont indexés. Par ailleurs, certains types de modifications entraînent des temps d’exécution prolongés (par exemple, la modification d’une stratégie au niveau de la racine d’un hôte implique que l’hôte entier doit être réindexé afin de mettre à jour le

descripteur de sécurité de chaque élément indexé). La combinaison de ces deux facteurs entraîne une actualisation inconstante, même lorsque vous configurez l’exécution d’une analyse incrémentielle à intervalles fréquents. Pour illustrer ce point, vous trouverez ci-dessous une comparaison du déroulement attendu d’une analyse incrémentielle par rapport à un scénario réel, suivi par le niveau d’actualisation de ce système.

Quelle est donc la correction apportée ? Présentation de l’analyse continue

Je vous recommande l’utilisation d’une option d’analyse pour les sources de contenu de type SharePoint qui offre une alternative pour la gestion d’une source de contenu. L’architecture sous-jacente est conçue pour garantir un niveau d’actualisation cohérent en dépassant les deux principales limitations des analyses complète/incrémentielle :

- elles peuvent être exécutées en parallèle ;

- une modification profonde n’entraîne pas une baisse du niveau d’actualisation de toutes les modifications sous-jacentes.

Pour en savoir plus…

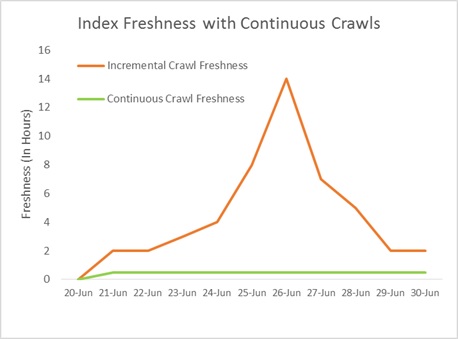

En coulisse, la sélection de l’analyse continue entraîne le démarrage d’une analyse toutes les 15 minutes, que la session précédente ait terminé ou pas. Cela signifie qu’une modification apportée à la suite d’une modification majeure ne doit pas « faire la queue ». Les nouvelles modifications continueront à être traitées en parallèle, car une modification de stratégie majeure est en train d’être traitée par une autre session d’analyse continue. Voici une illustration de la façon dont les analyses continues sont exécutées en parallèle toutes les 15 minutes, permettant ainsi de gérer l’apparition soudaine de pics de contenu sans affecter le niveau d’actualisation global. Le graphique suivant illustre l’impact sur le niveau d’actualisation atteint à l’aide de l’analyse continue et de l’analyse incrémentielle.

Et maintenant, quoi d’autre ?

Dans des prochains billets, nous aborderons plus en détail la manière dont l’analyse continue peut gérer plusieurs types de scénarios (erreurs, sécurité, etc.) et comment vous pouvez tirer parti du journal d’analyse et de l’historique des analyses pour mieux comprendre ce qui se passe en coulisse.

Forum Aux Questions :

Est-ce que je peux utiliser l’analyse continue pour tous les types de sources de contenu ?

Non. Les analyses continues sont disponibles uniquement pour une source de contenu de type SharePoint. Tous les autres types de sources de contenu ne pourront utiliser que les options d’analyse incrémentielle et d’analyse complète.

Est-ce que l’exécution d’une analyse continue ajoute une charge supplémentaire sur le référentiel ?

La charge d’une analyse continue est semblable à celle d’une analyse incrémentielle. Bien que la fréquence à laquelle les requêtes sont envoyées ont augmenté, le nombre maximal de requêtes simultanées sur un référentiel/hôte sera toujours contrôlé par des *règles d’impact d’analyse* (qui définissent le nombre maximal de threads simultanés qui peuvent envoyer des requêtes (12 threads par défaut, mais cette valeur peut être modifiée en fonction des besoins professionnels et/ou du plan de capacité)).

Est-ce que je dois paramétrer une analyse incrémentielle ou complète quand j’utilise une analyse continue ?

Vous n’avez pas besoin de configurer une analyse incrémentielle si vous exécutez une analyse continue.

Est-ce que l’analyse continue ajoute une charge supplémentaire sur le référentiel/l’hôte ?

L’analyse continue augmente légèrement la charge sur l’hôte étant donné qu’il peut exécuter en parallèle plusieurs sessions d’analyse simultanées. Cependant, n’oubliez pas qu’il est limité par le paramètre « Règle d’impact d’analyse » qui contrôle le nombre maximal de requêtes simultanées pouvant être envoyées vers un hôte (défini par défaut sur 12 threads, mais cette valeur peut être modifiée).

Est-ce que je peux tirer parti de l’analyse continue pour analyser les versions précédentes du contenu SharePoint ?

Oui. Bien que vous deviez disposer de la version 2013 de l’application de recherche, vous pouvez configurer les batteries de serveurs de contenu exécutant des versions antérieures de SharePoint pour faire l’objet d’une analyse continue.

Ce billet de blog a été traduit de l’anglais. Vous trouverez la version originale à la page How can I achieve the best freshness of search results? Introducing Continuous Crawls for SharePoint