Lab Azure Big Data (1): création d’un cluster HDInsight

Dans le cadre d’un programme de “readiness” interne, j’ai participé à la création de contenu autour du Big Data. Comme j’ai eu de nombreuses demandes pour récupérer le contenu que j’ai créé, je me suis dit que ça pourrait peut-être intéresser d’autres personnes. Donc je partage sur mon blog ![]() !

!

Ce contenu est constitué d’une série d’articles qui va de la création d’un cluster HDInsight à l’exploitation des données.

Sommaire des articles

- Création d’un cluster HDInsight

- Utilisation de MapReduce

- Utilisation de Hive

- Utilisation de Pig

- Analyses des données avec Power BI

Dans ce premier article, nous allons créer un cluster HDInsight de type Spark, auquel nous rattacherons un stockage de type “Data Lake”

Création du « Data Lake Store »

Création du service

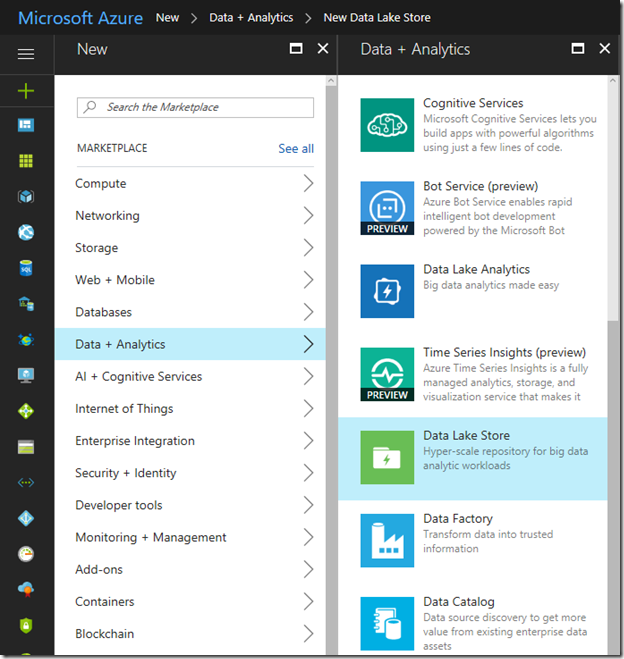

Depuis le portail Azure, cliquez sur « Intelligence + analytics » => « Data Lake Store »

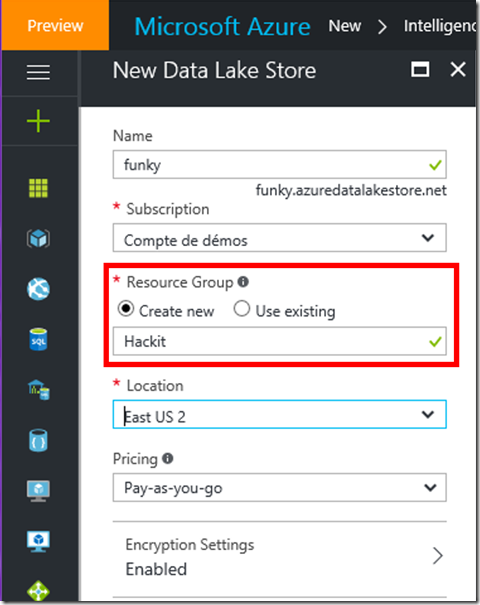

Remplissez le formulaire de création. Pour cet exemple, nous allons créer le groupe de ressources “Hackit”.

Puis cliquez sur le bouton « Create ».

Création d’un dossier de stockage dans de Data Lake Store (optionel)

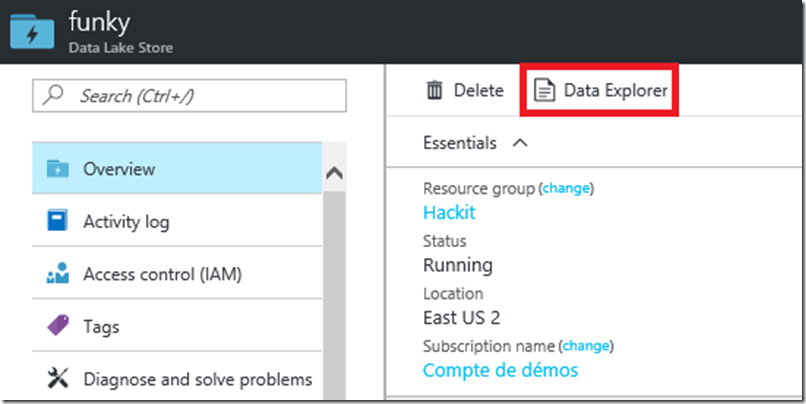

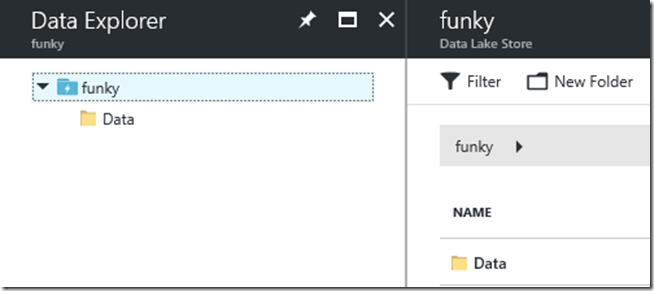

Une fois le Data lake Store créé, allez dans la vue générale du « Data Lake Store »

Cliquez sur « Overview »

Cliquez sur le bouton « Data Explorer »

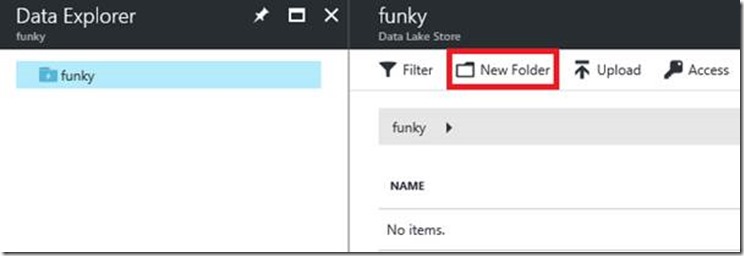

Cliquez sur le bouton « New Folder »

Voici une vue après la création du dossier

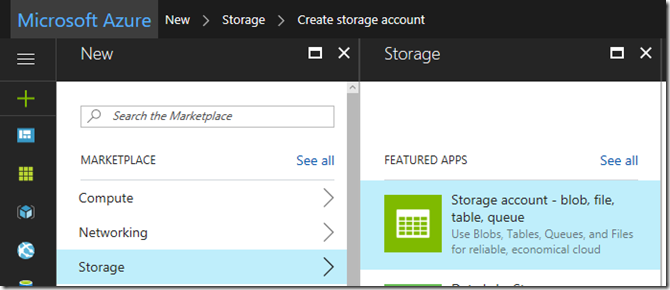

Création d’un Blob Storage (si besoin)

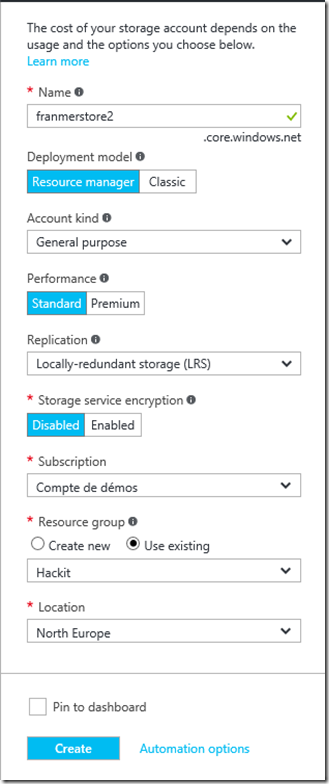

Depuis le portail Azure, cliquez sur « Storage » => « Storage Account »

Un stockage « Standard » avec une réplication locale « LRS » sera suffisant pour le lab.

Sélectionnez un groupe de ressource. Ici, nous allons prendre celui qui héberge le Data Lake Store créé précédemment (Hackit).

Dans la champ « Location », sélectionnez la zone souhaitée.

Cliquez sur le bouton « Create »

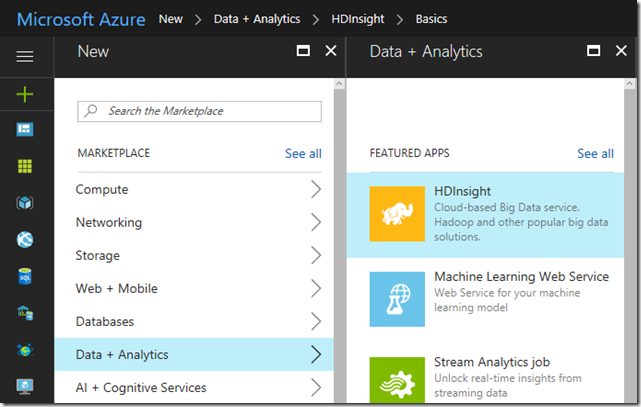

Création du Cluster HDInsight (HDI)

« Intelligence + analytics » => « HDInsight »

Choix du type de cluster HDI

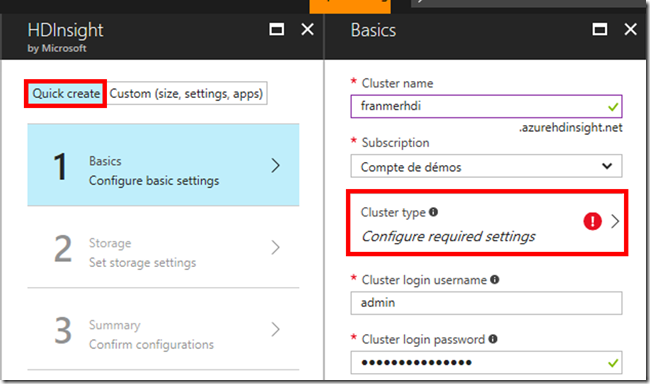

Cliquez sur “Quick create”. Puis dans la rubrique “Basics”, donnez un nom à votre cluster HDI.

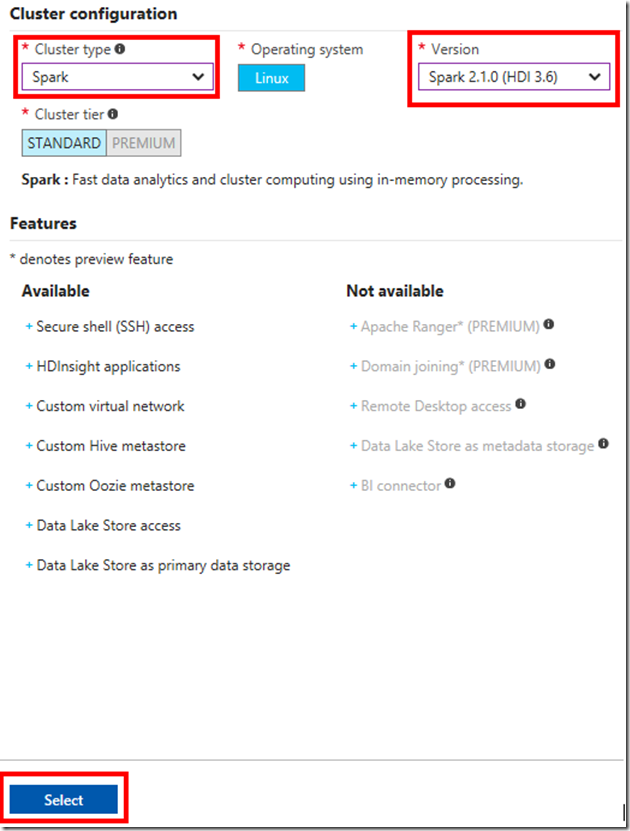

Cliquez sur « Cluster configuration ».

Définissez la création de cluster de type Spark, en version 2.0.1.

Cliquez sur le bouton « Select ».

Terminez de renseigner les informations de connexion.

Création de la source de données

Selection de la source de données

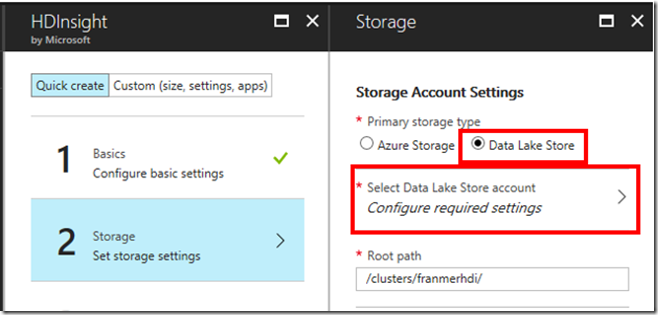

Dans la rubrique “Storage”.

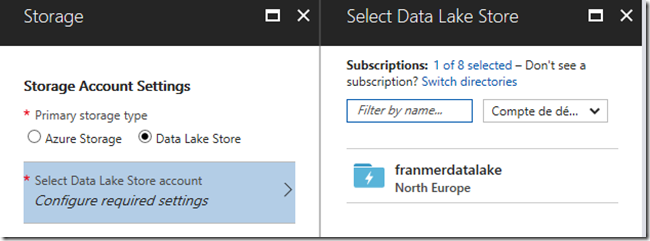

Sous « Primary storage type », sélectionnez « Data Lake Store ».

Sélectionnez le « Data lake Store » créé précédemment.

Définition des droits d’accès à la source de données

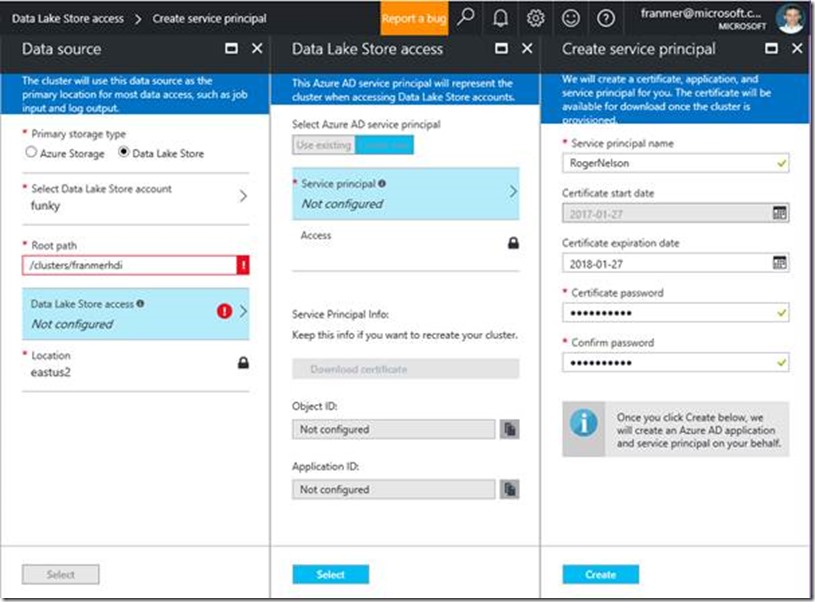

Création du service principal

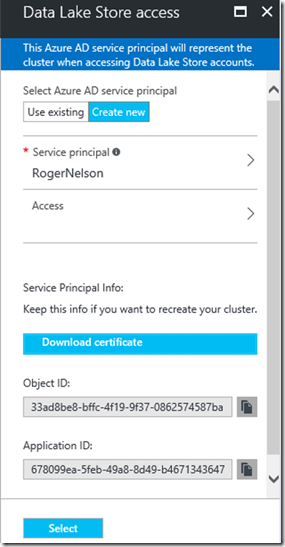

Cliquez sur « Data Lake Store access »

Sous “Select Azure AD service principal” cliquez sur “Create new”

Cliquez sur “Service principal”

Dans le “blade” “Create service principal », définissez les propriétés de votre nouveau “service principal”

Cliquez sur le bouton « Create »

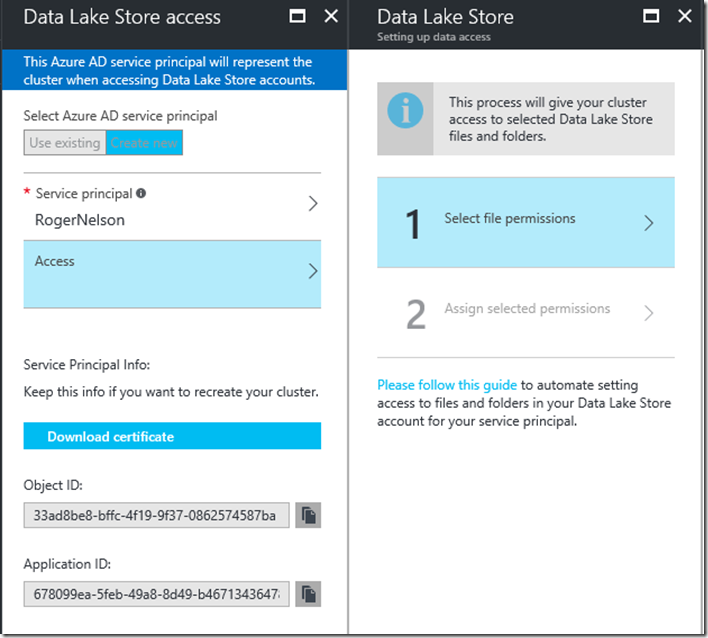

Définition des accès du service principal

Sous le nom du « Service principal » crée, cliquez sur « Access »

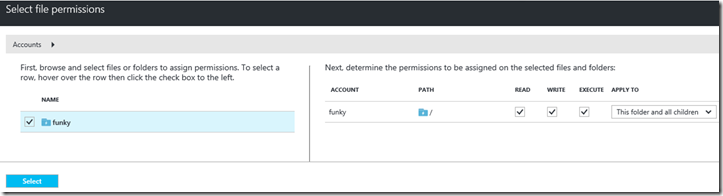

Cliquez sur « Select file permissions »

Cochez la case à gauche du Data Lake Store avant d’avoir accès à la définition des droits. Vérifiez que toutes les cases soient bien cochées. Cliquez sur le bouton « Select »

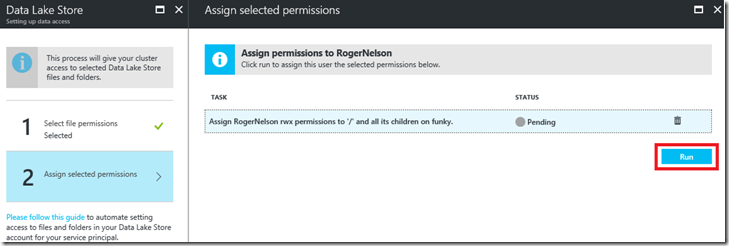

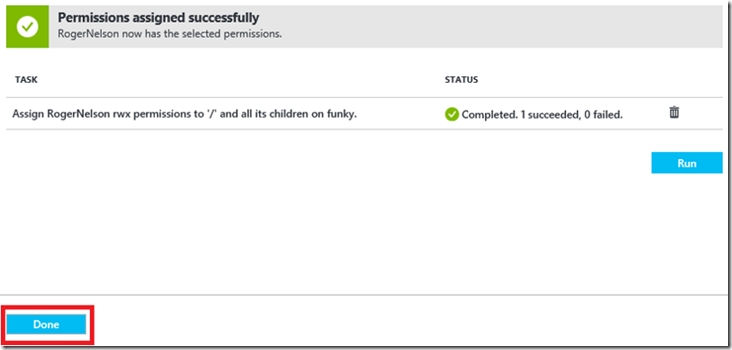

Cliquez sur « Assign selected permissions ». Puis cliquez sur le bouton « Run »

Si tout va bien ![]()

Cliquez sur le bouton « Done »

Dans le Balde « Data Lake Store access », cliquez sur « Select »

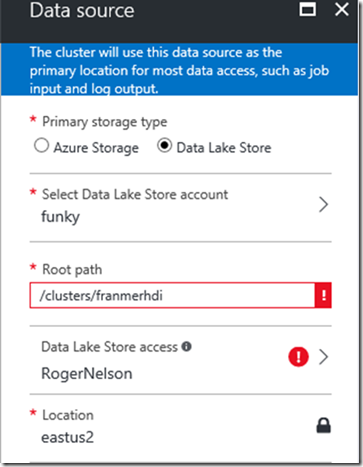

Dans le blade « Data Source », il devrait rester une erreur

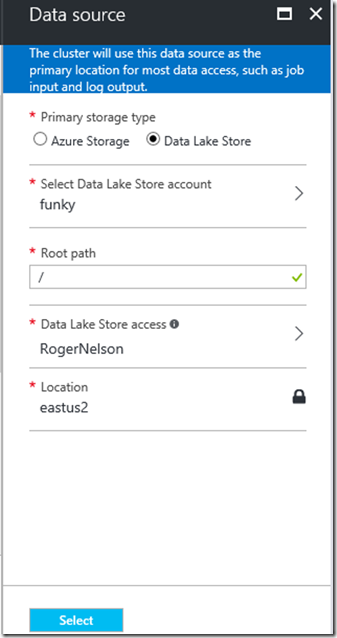

Modifiez le champ « Root path ». Indiquez simplement la racine du stockage avec « / ». Cliquez sur le bouton « Select »

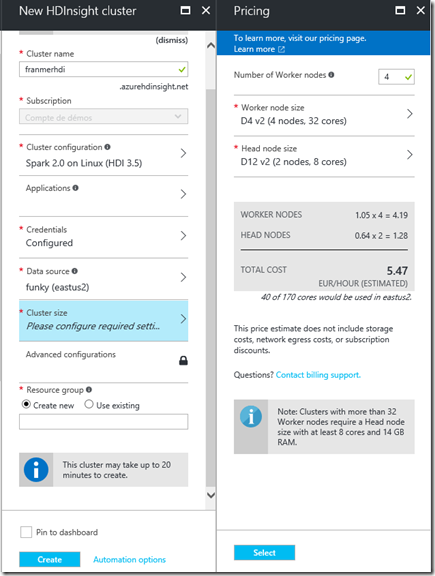

Taille du cluster

Cliquez sur « Cluster size »

Définissez le nombre de Woker nodes. Pour ce lab, nous pouvons conserver 4 Worker nodes.

Cliquez sur le bouton « Select »

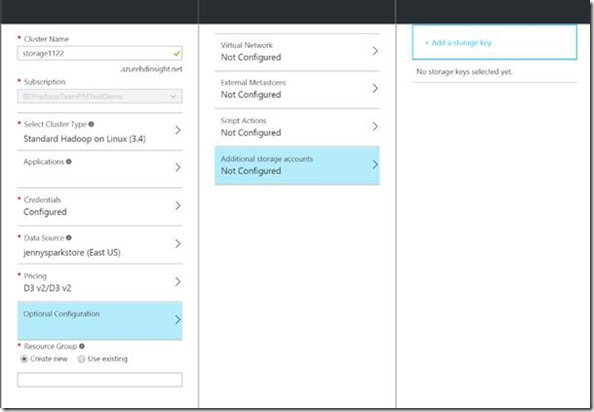

Ajout d’un compte de stockage additionnel (optionnel)

Si besoin, il est possible de rajouter un compte de stockage au cluster

Dans « Optionnal Configuration », cliquez sur « Additional storage accounts ».

De l’information détaillée est disponible ici.

Création du cluster

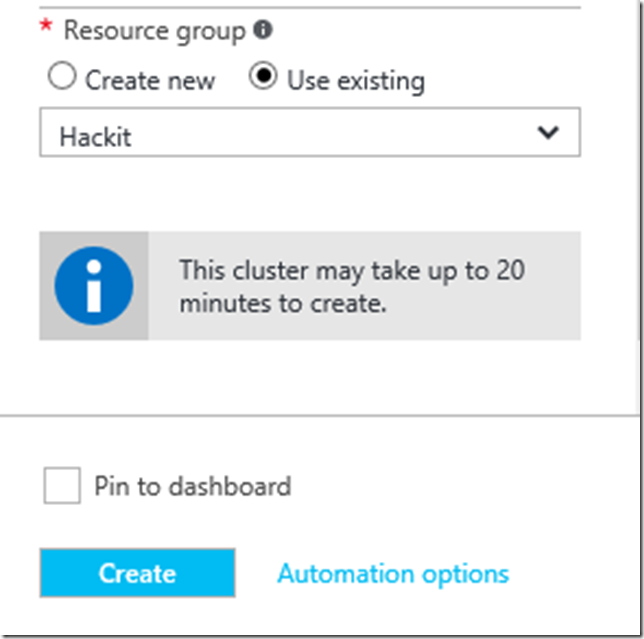

Sélectionnez le groupe de ressource créé précédemment. Pour cet exemple, je sélectionne le groupe de ressource « Hackit ».

Cliquez sur le bouton « Create ». La création du cluster prend environ 20 minutes.

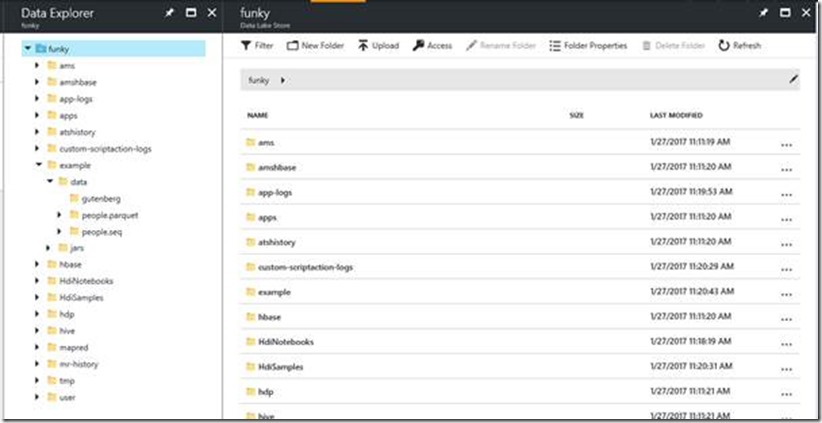

Après création du cluster, il est possible de vérifier la structure des données dans le Data Lake Store avec la fonction « Data Explorer ». Pour la seconde partie, nous allons utiliser des données qui se trouvent dans dossier « Example »

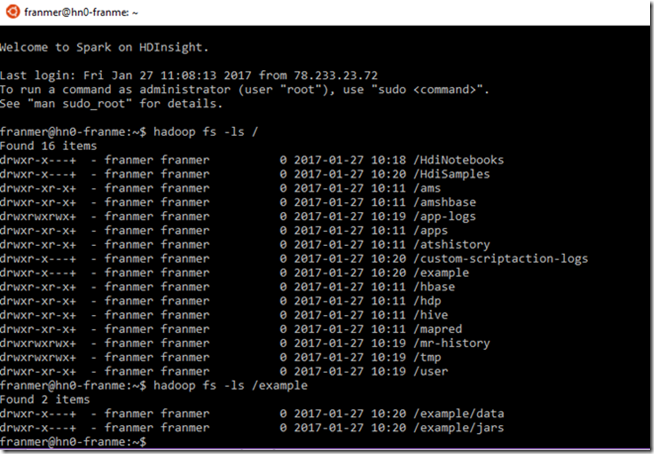

Connexion au cluster

Il est possible de se connecter au cluster. Ici, nous avons un cluster sous Linux, il est possible de s’y connecter, par exemple, via « Putty » ou directement depuis Windows 10 avec « Bash on Ubuntu on Windows ».

Pour cet exemple nous allons utiliser « Bash on Ubuntu on Windows ».

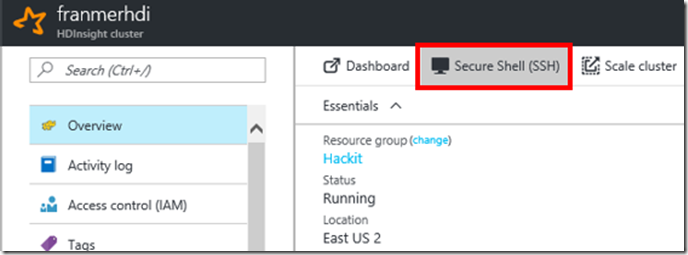

Récupérez la chaîne de connexion depuis le portail Azure. Cliquez sur « Secure Shell (SSH) »

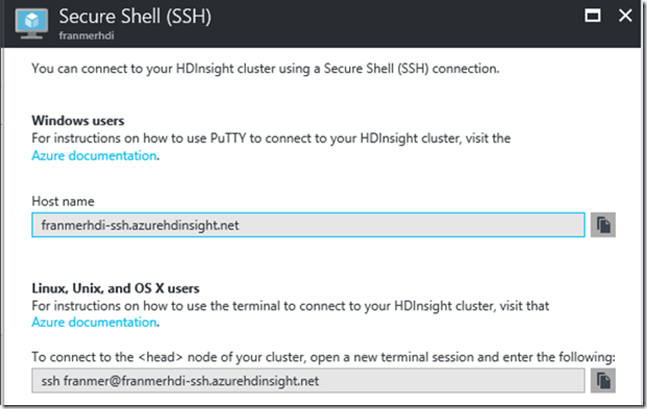

Puis copiez la chaîne de connexion en fonction de l’outil utilisé :

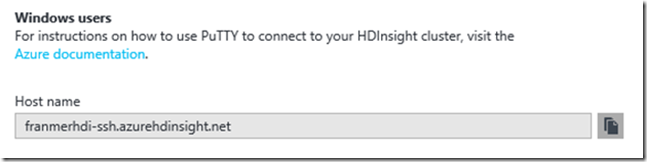

Avec « Putty » utilisez :

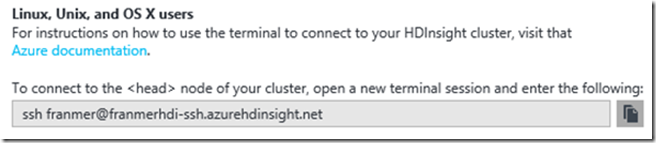

Avec « Bash on Ubuntu on Windows » utilisez :

Ci-dessous un exemple avec « Bash on Ubuntu on Windows »

Voilà pour cette première partie. Dans le second article, nous allons commencer à utiliser notre cluster fraîchement configuré.