Δημιουργία και διαχείριση ορισμών εργασίας Apache Spark στο Visual Studio Code

Η επέκταση κώδικα Visual Studio (VS) για Synapse υποστηρίζει πλήρως τις λειτουργίες ορισμού εργασίας Spark (δημιουργία, ενημέρωση, ανάγνωση και διαγραφή) ΤΟΥ CURD στο Fabric. Αφού δημιουργήσετε έναν ορισμό εργασίας Spark, μπορείτε να αποστείλετε περισσότερες αναφερόμενες βιβλιοθήκες, να υποβάλετε μια αίτηση για να εκτελέσετε τον ορισμό της εργασίας Spark και να ελέγξετε το ιστορικό εκτέλεσης.

Δημιουργία ορισμού εργασίας Spark

Για να δημιουργήσετε έναν νέο ορισμό εργασίας Spark:

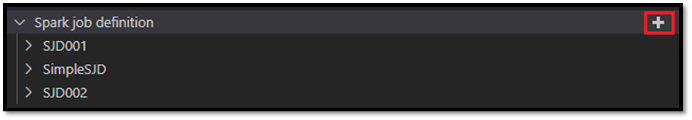

Στην Εξερεύνηση κώδικα VS, επιλέξτε Δημιουργία ορισμού εργασίας Spark.

Εισαγάγετε τα αρχικά απαιτούμενα πεδία: όνομα, αναφερόμενη λίμνη και προεπιλεγμένη λίμνη.

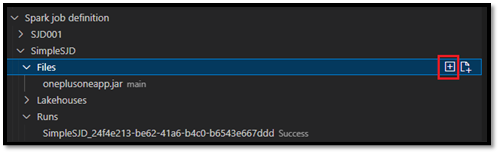

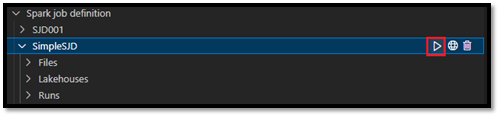

Οι διαδικασίες αίτησης και το όνομα του ορισμού εργασίας Spark που μόλις δημιουργήσατε εμφανίζονται στον ριζικό κόμβο Ορισμός εργασίας Spark στην Εξερεύνηση κώδικα VS. Κάτω από τον κόμβο ονόματος ορισμού εργασίας Spark, βλέπετε τρεις υπο-κόμβους:

- Αρχεία: Λίστα του αρχείου κύριου ορισμού και άλλων βιβλιοθηκών που αναφέρονται. Μπορείτε να αποστείλετε νέα αρχεία από αυτήν τη λίστα.

- Lakehouse: Λίστα όλων των λιμνοθάφτων που αναφέρονται από αυτόν τον ορισμό εργασίας Spark. Η προεπιλεγμένη λίμνη επισημαίνεται στη λίστα και μπορείτε να αποκτήσετε πρόσβαση σε αυτή μέσω της σχετικής διαδρομής

Files/…, Tables/…. - Εκτέλεση: Λίστα του ιστορικού εκτέλεσης αυτού του ορισμού εργασίας Spark και της κατάστασης εργασίας κάθε εκτέλεσης.

Αποστολή αρχείου κύριου ορισμού σε μια αναφερόμενη βιβλιοθήκη

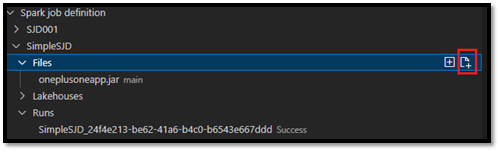

Για να αποστείλετε ή αντικαταστήσετε το αρχείο κύριου ορισμού, επιλέξτε Προσθήκη κύριου αρχείου .

Για να αποστείλετε το αρχείο βιβλιοθήκης στο οποίο αναφέρεται το αρχείο κύριου ορισμού, επιλέξτε Προσθήκη αρχείου lib.

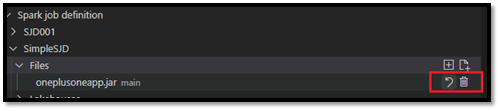

Αφού αποστείλετε ένα αρχείο, μπορείτε να το παρακάμψετε κάνοντας κλικ στην επιλογή Ενημέρωση αρχείου και αποστέλλοντας ένα νέο αρχείο ή μπορείτε να διαγράψετε το αρχείο μέσω της επιλογής Διαγραφή .

Υποβολή αίτησης εκτέλεσης

Για να υποβάλετε μια αίτηση για να εκτελέσετε τον ορισμό εργασίας Spark από τον κώδικα VS:

Από τις επιλογές στα δεξιά του ονόματος του ορισμού εργασίας Spark που θέλετε να εκτελέσετε, επιλέξτε Εκτέλεση spark job .

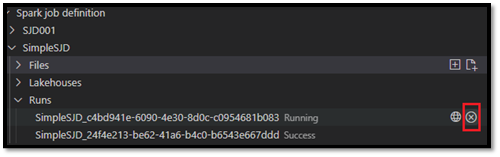

Μετά την υποβολή της αίτησης, εμφανίζεται μια νέα εφαρμογή Apache Spark στον κόμβο Εκτελέσεις στη λίστα Explorer. Μπορείτε να ακυρώσετε την εργασία που εκτελείται, επιλέγοντας Άκυρο spark job .

Ανοίξτε έναν ορισμό εργασίας Spark στην πύλη Fabric

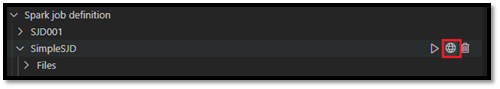

Μπορείτε να ανοίξετε τη σελίδα σύνταξης ορισμού εργασίας Spark στην πύλη Fabric, επιλέγοντας Άνοιγμα στο πρόγραμμα περιήγησης .

Μπορείτε επίσης να επιλέξετε Άνοιγμα στο Πρόγραμμα περιήγησης δίπλα σε μια ολοκληρωμένη εκτέλεση για να δείτε τη σελίδα παρακολούθησης λεπτομερειών αυτής της εκτέλεσης.

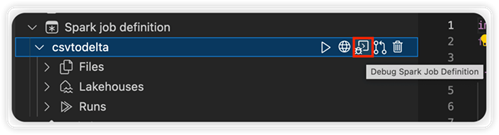

Εντοπισμός σφαλμάτων πηγαίου κώδικα ορισμού εργασίας Spark (Python)

Εάν ο ορισμός εργασίας Spark δημιουργηθεί με το PySpark (Python), μπορείτε να κάνετε λήψη της .py δέσμης ενεργειών του αρχείου κύριου ορισμού και του αρχείου στο οποίο γίνεται αναφορά και να εντοπίσετε σφάλματα στη δέσμη ενεργειών προέλευσης στον κώδικα VS.

Για να κάνετε λήψη του πηγαίου κώδικα, επιλέξτε Εντοπισμός σφαλμάτων Spark Job Definition στα δεξιά του ορισμού εργασίας Spark.

Αφού ολοκληρωθεί η λήψη, ανοίγει αυτόματα ο φάκελος του πηγαίου κώδικα.

Επιλέξτε Να θεωρείται αξιόπιστη οι συντάκτες όταν σας ζητηθεί. (Αυτή η επιλογή εμφανίζεται μόνο την πρώτη φορά που ανοίγετε τον φάκελο. Εάν δεν ενεργοποιήσετε αυτή την επιλογή, δεν μπορείτε να εντοπίσετε σφάλματα ή να εκτελέσετε τη δέσμη ενεργειών προέλευσης. Για περισσότερες πληροφορίες, ανατρέξτε στο θέμα Ασφάλεια αξιοπιστίας χώρου εργασίας του Visual Studio Code.)

Εάν έχετε κάνει λήψη του πηγαίου κώδικα στο παρελθόν, θα σας ζητηθεί να επιβεβαιώσετε ότι θέλετε να αντικαταστήσετε την τοπική έκδοση με τη νέα λήψη.

Σημείωση

Στον ριζικό φάκελο της δέσμης ενεργειών προέλευσης, το σύστημα δημιουργεί έναν υποφάκελο με το όνομα conf. Μέσα σε αυτόν τον φάκελο, ένα αρχείο με την ονομασία lighter-config.json περιέχει ορισμένα μετα-δεδομένα συστήματος που απαιτούνται για την απομακρυσμένη εκτέλεση. Μην κάνετε καμία αλλαγή σε αυτό.

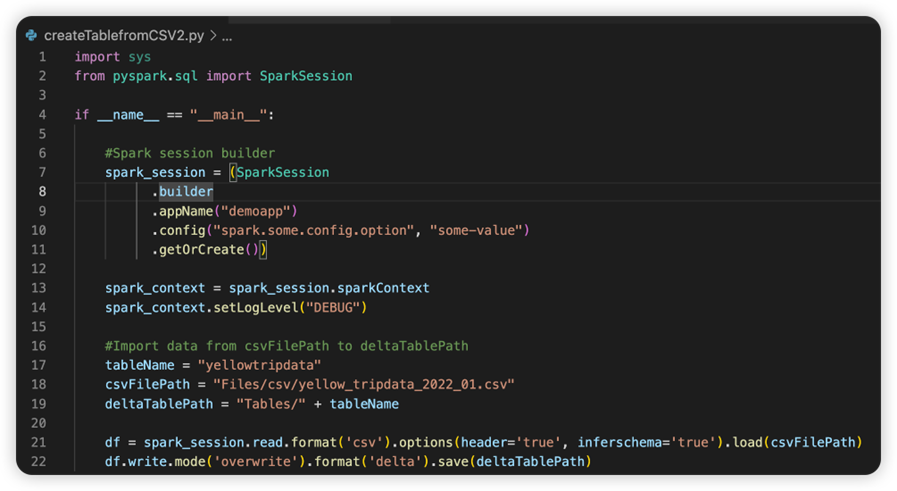

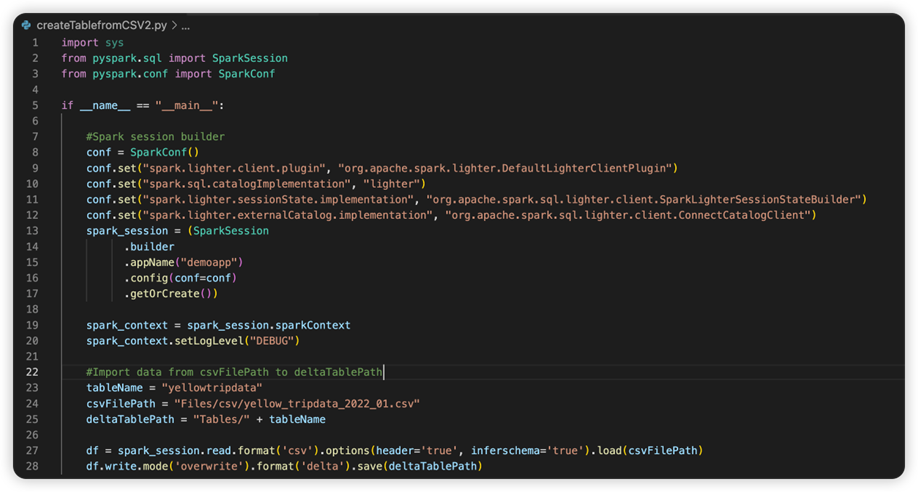

Το αρχείο με ονομασία sparkconf.py περιέχει ένα τμήμα κώδικα που πρέπει να προσθέσετε για να ρυθμίσετε το αντικείμενο SparkConf . Για να ενεργοποιήσετε τον απομακρυσμένο εντοπισμό σφαλμάτων, βεβαιωθείτε ότι το αντικείμενο SparkConf έχει ρυθμιστεί σωστά. Η παρακάτω εικόνα εμφανίζει την αρχική έκδοση του πηγαίου κώδικα.

Η επόμενη εικόνα είναι ο ενημερωμένος πηγαίος κώδικας αφού αντιγράψετε και επικολλήσετε το τμήμα κώδικα.

Αφού ενημερώσετε τον πηγαίο κώδικα με το απαραίτητο conf, πρέπει να επιλέξετε τον σωστό Python Interpreter. Βεβαιωθείτε ότι έχετε επιλέξει εκείνο που εγκαταστάθηκε από το περιβάλλον conda synapse-spark-kernel .

Επεξεργασία ιδιοτήτων ορισμού εργασίας Spark

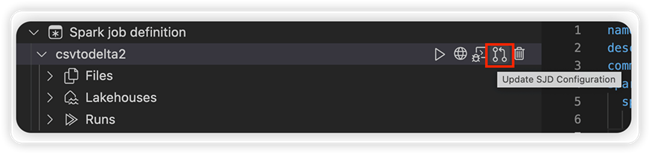

Μπορείτε να επεξεργαστείτε τις ιδιότητες λεπτομερειών των ορισμών εργασίας Spark, όπως τα ορίσματα γραμμής εντολών.

Επιλέξτε Ενημέρωση ρύθμισης παραμέτρων SJD για να ανοίξετε ένα αρχείο settings.yml. Οι υπάρχουσες ιδιότητες συμπληρώνουν τα περιεχόμενα αυτού του αρχείου.

Ενημερώστε και αποθηκεύστε το αρχείο .yml.

Επιλέξτε Δημοσίευση ιδιότητας SJD στην επάνω δεξιά γωνία για να συγχρονίσετε την αλλαγή ξανά στον απομακρυσμένο χώρο εργασίας.