Testen von Modellen im Playground von Azure KI Studio

Playgrounds sind nützliche Oberflächen in Azure KI Studio, auf denen Sie mit Ihren bereitgestellten Modellen experimentieren können, ohne eine eigene Clientanwendung entwickeln zu müssen. Azure KI Studio bietet mehrere Playgrounds mit verschiedenen Optionen zur Parameteroptimierung.

Playground für Vervollständigungen

Im Playground für Vervollständigungen können Sie über eine Oberfläche mit Texteingabe und -ausgabe Aufrufe in Ihren bereitgestellten Modellen ausführen und Parameter anpassen. Sie müssen unter „Bereitstellungen“ den Bereitstellungsnamen Ihres Modells auswählen. Optional können Sie die bereitgestellten Beispiele zum Einstieg verwenden und dann Ihre eigenen Eingabeaufforderungen eingeben.

Parameter im Playground für Vervollständigungen

Es gibt viele Parameter, die Sie anpassen können, um die Leistung Ihres Modells zu ändern:

- Temperatur: steuert Zufälligkeit. Eine Senkung der Temperatur bedeutet, dass das Modell mehr wiederholte und deterministische Antworten erzeugt. Eine Erhöhung der Temperatur führt zu unerwarteten oder kreativen Antworten. Versuchen Sie, die Temperatur oder Top P anzupassen, aber nicht beides.

- Maximale Länge (Token): Legen Sie einen Grenzwert für die Anzahl der Token pro Modellantwort fest. Die API unterstützt maximal 4.000 Token, die zwischen der Eingabeaufforderung (einschließlich Systemmeldung, Beispielen, Nachrichtenverlauf und Benutzerabfrage) und der Antwort des Modells ausgetauscht werden. Ein Token für typisch englischen Text besteht aus ungefähr vier Zeichen.

- Sequenzen beenden: Lassen Sie die Antworten an einer gewünschten Stelle enden, z. B. am Ende eines Satzes oder einer Liste. Geben Sie bis zu vier Sequenzen an, bei denen das Modell die Generierung weiterer Token in einer Antwort beendet. Der zurückgegebene Text wird die Beendigungssequenz nicht enthalten.

- Höchste Wahrscheinlichkeiten (Top P): Ähnlich wie bei „Temperatur“ wird hiermit die Zufälligkeit gesteuert, jedoch mit einer anderen Methode. Eine Senkung von Top P schränkt die Token-Auswahl des Modells auf wahrscheinlichere Token ein. Bei einer Erhöhung von Top P kann das Modell aus Token mit hoher und niedriger Wahrscheinlichkeit auswählen. Versuchen Sie, die Temperatur oder Top P anzupassen, aber nicht beides.

- Häufigkeitsstrafe: Verringern Sie die Wahrscheinlichkeit, dass ein Token proportional wiederholt wird, je nachdem, wie oft es bisher im Text vorkam. Dies verringert die Wahrscheinlichkeit, dass genau derselbe Text in einer Antwort wiederholt wird.

- Anwesenheitsstrafe: Verringern Sie die Wahrscheinlichkeit, dass ein Token wiederholt wird, das bis jetzt schon im Text vorkam. Dies erhöht die Wahrscheinlichkeit, dass neue Themen in eine Antwort eingeführt werden.

- Text vor der Antwort: Fügen Sie Text nach der Eingabe des Benutzers und vor der Antwort des Modells ein. Dadurch kann das Modell auf eine Antwort vorbereitet werden.

- Text nach der Antwort: Fügen Sie Text nach der generierten Antwort des Modells ein, um weitere Benutzereingaben anzuregen, z. B. bei Modellierung einer Unterhaltung.

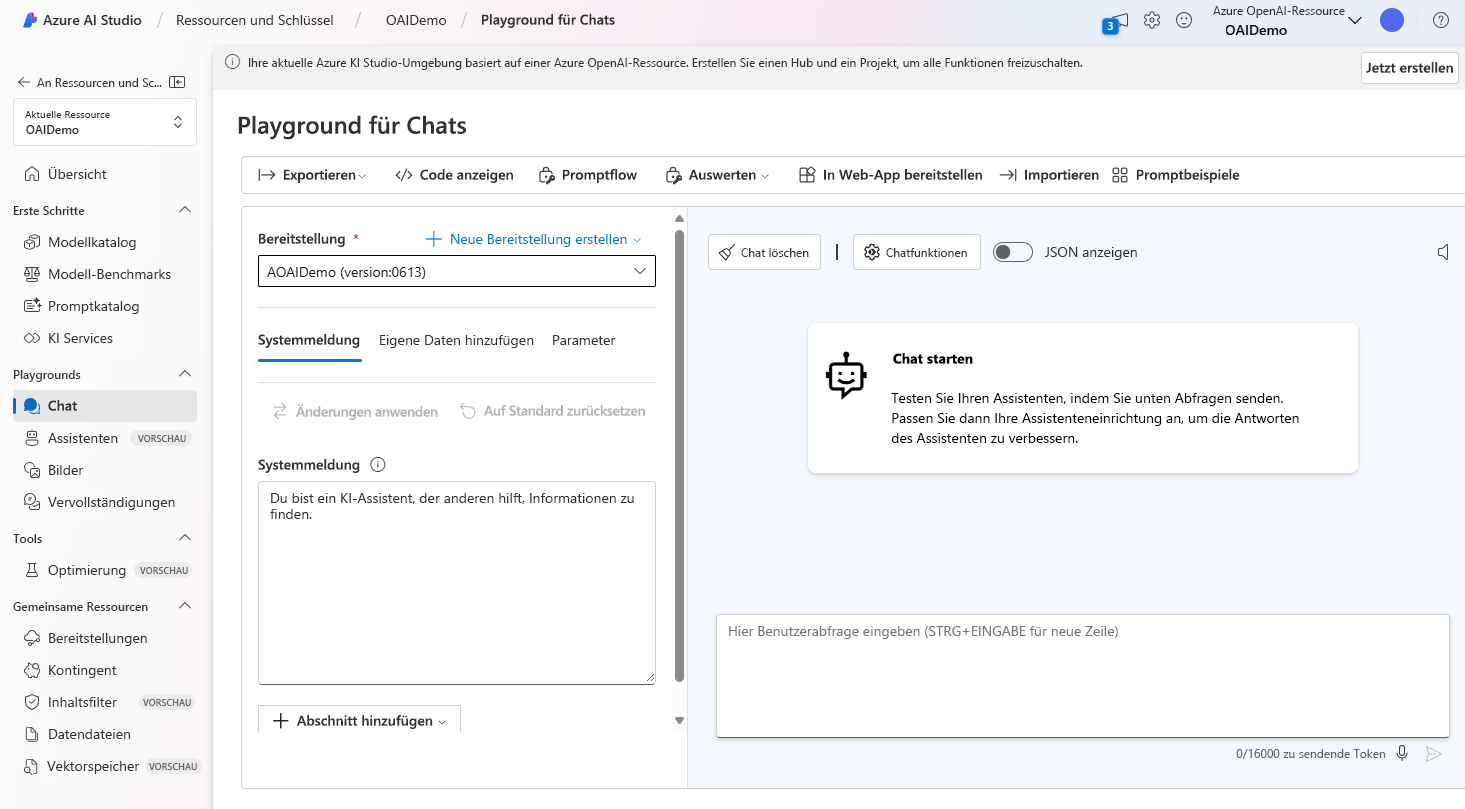

Playground für Chats

Der Playground für Chats basiert auf einer Oberfläche zur Eingabe von Unterhaltungen und Ausgabe von Nachrichten. Sie können die Sitzung mit einer Systemnachricht initialisieren, um den Chatkontext einzurichten.

Im Chat-Playground können Sie Few-Shot-Beispiele hinzufügen. Der Begriff „Few-Shot“ bezieht sich auf die Bereitstellung einiger Beispiele, die dem Modell helfen zu lernen, was es tun muss. Sie können es sich als Gegensatz zu „Zero-Shot“ vorstellen, was bedeutet, das keine Beispiele bereitgestellt werden.

Bei Einrichtung mit dem Assistenten können Sie Few-Shot-Beispiele dafür bereitstellen, was die Benutzereingabe sein kann und wie die Antwort des Assistenten aussehen soll. Der Assistent versucht, die Antworten nachzuahmen, die Sie hier hinsichtlich Ton, Regeln und Format entsprechend Ihren Vorgaben in Ihre Systemnachricht einbeziehen.

Parameter für Chat-Playground

Der Chat-Playground, z. B. der Playground "Completions", enthält auch Parameter zum Anpassen des Modellverhaltens. Der Chat-Playground unterstützt auch weitere Parameter, die im Playground „Completions“ nicht verfügbar sind. Dazu gehören:

- Max. Antwort: Legen Sie einen Grenzwert für die Anzahl von Token pro Modellantwort fest. Die API unterstützt maximal 4.000 Token, die zwischen der Eingabeaufforderung (einschließlich Systemmeldung, Beispielen, Nachrichtenverlauf und Benutzerabfrage) und der Antwort des Modells ausgetauscht werden. Ein Token für typisch englischen Text besteht aus ungefähr vier Zeichen.

- Bisherige Nachrichten eingeschlossen: Wählen Sie die Anzahl der bisherigen Nachrichten aus, die in jede neue API-Anforderung eingeschlossen werden sollen. Das Einschließen bisheriger Nachrichten hilft, dem Modell einen Kontext für neue Benutzerabfragen zu liefern. Wenn Sie diesen Wert auf 10 festlegen, werden fünf Benutzerabfragen und fünf Systemantworten eingeschlossen.

Die aktuelle Tokenanzahl kann im Chat-Playground angezeigt werden. Da die API-Aufrufe nach Token abgerechnet werden und es möglich ist, eine Obergrenze für Antworttoken festzulegen, sollten Sie die aktuelle Anzahl der Token im Auge behalten, um sicherzustellen, dass die Unterhaltungseingabe die maximale Anzahl der Antworttoken nicht überschreitet.