Erkunden der Sprachmodelle im Modellkatalog

Die Auswahl eines Sprachmodells für Ihre generative KI-App ist wichtig, da sie sich darauf auswirkt, wie gut Ihre App funktioniert. Wenn Sie eine generative KI-App mit Azure KI Foundry entwickeln, erstellen Sie eine Chatanwendung, die Sprachmodelle für mehrere Zwecke verwenden kann:

- Verstehen der Frage des Benutzers

- Suchen nach relevantem Kontext

- Generieren einer Antwort auf die Frage des Benutzers

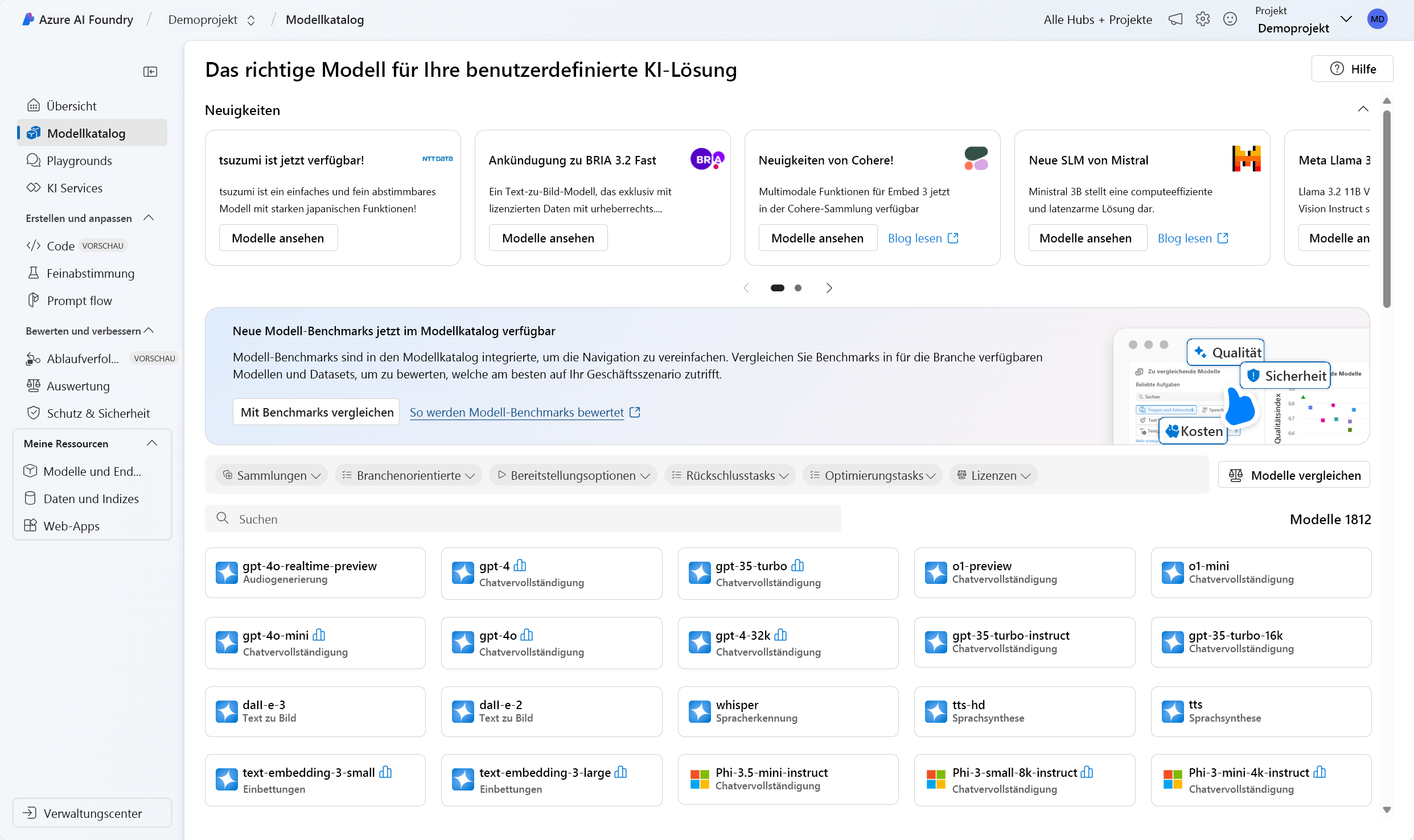

Im Azure KI Foundry-Portal können Sie die verfügbaren Sprachmodelle im Modellkatalog durchsuchen. Sehen wir uns den Modellkatalog und die Arten von Sprachmodellen an, die über Azure KI verfügbar sind.

Erkunden des Modellkatalogs

Im Azure KI Foundry-Portal können Sie zum Modellkatalog navigieren, um sich alle verfügbaren Sprachmodelle näher anzusehen. Darüber hinaus können Sie jedes Modell aus der Open-Source-Bibliothek „Hugging Face“ in den Modellkatalog importieren.

Tipp

Hugging Face ist eine Open-Source-Community, die der Öffentlichkeit Modelle zur Verfügung stellt. Sie finden alle Modelle in ihrem Katalog. Außerdem können Sie in der Dokumentation mehr zur Funktionsweise einzelner Modelle wie z. B. BERT erfahren.

Der Azure KI Foundry-Modellkatalog lässt sich in Modelle von Hugging Face und anderen Quellen integrieren. Über den Modellkatalog können Sie Modelle erkunden, optimieren und bereitstellen.

Wichtig

Die Modellverfügbarkeit variiert je nach Standort (Region). Ihr Standort wird auf der Ebene des KI-Hubs angegeben. Wenn Sie einen neuen KI-Hub erstellen, können Sie das Standorthilfsprogramm (Location Helper) verwenden. Dort geben Sie das gewünschte Modell an, um eine Liste der Standorte abzurufen, an denen Sie das Modell bereitstellen können. Weitere Informationen finden Sie auch in der Tabelle mit der Modellzusammenfassung und den Informationen zur regionalen Verfügbarkeit.

Erkunden der Sprachmodelle

Die im Modellkatalog verfügbaren Basis- oder Sprachmodelle sind bereits vortrainiert. Sie können ein Sprachmodell auf einem Endpunkt bereitstellen oder ein Modell optimieren, damit es für eine bestimmte Aufgabe oder fachspezifisches Wissen besser funktioniert.

Welches Modell Sie auswählen, hängt von Ihrem Anwendungsfall und Ihren Bereitstellungspräferenzen ab. Zunächst müssen Sie entscheiden, welche Aufgabe das Modell ausführen soll. Zum Beispiel:

- Textklassifizierung

- Tokenklassifizierung

- Fragen und Antworten

- Zusammenfassung

- Sprachübersetzung

Folgende Sprachmodelle werden z. B. häufig für verschiedene Aufgaben verwendet:

| Modell | Beschreibung |

|---|---|

| BERT (Bidirectional Encoder Representations from Transformers) | Hier liegt der Schwerpunkt auf der Codierung von Informationen mithilfe des Kontexts vor und nach einem Token (bidirektional). Wird häufig zum Optimieren eines Modells für eine bestimmte Aufgabe verwendet, z. B. zur Textklassifizierung und zur Beantwortung von Fragen. |

| GPT (Generative Pretrained Transformer) | Ist für die Erstellung kohärenter und im Kontext relevanter Texte trainiert und wird am häufigsten für Aufgaben wie Textgenerierung und Chatvervollständigungen verwendet. |

| LLaMA (Large Language Model Meta AI) | Eine Produktfamilie mit von Meta erstellten Modellen. Beim Trainieren von LLaMA-Modellen lag der Schwerpunkt eher auf der Bereitstellung von mehr Trainingsdaten als auf der Erhöhung der Komplexität der Modelle. Sie können LLaMA-Modelle für die Textgenerierung und für Chatvervollständigungen verwenden. |

| Phi-3-mini (3,8B-Parametervariation von Phi-Modellen) | Ein einfaches, hochmodernes Modell, das für Umgebungen mit eingeschränkten Ressourcen und lokale Rückschlüsse (z. B. auf einem Smartphone) optimiert ist und Prompts mit langem Kontext mit bis zu 128.000 Token unterstützt. Das Modell wurde mit Schwerpunkt auf Sicherheit, Ausrichtung und vertiefendem Lernen auf Grundlage von menschlichem Feedback entwickelt. |

Nachdem Sie eine Aufgabe ausgewählt und die für Ihre Zielsetzung geeigneten verfügbaren Modelle gefiltert haben, können Sie sich die Modellzusammenfassung in Azure KI Foundry ansehen, um einige weitere Aspekte zu berücksichtigen:

- Modellfunktionen: Bewerten Sie die Funktionen des Sprachmodells und deren Eignung für Ihre Aufgabe. Beispielsweise ist ein Modell wie BERT besser darin, kurze Texte zu verstehen.

- Daten zum Vortrainieren: Berücksichtigen Sie das Dataset, das zum Vortrainieren des Sprachmodells verwendet wird. GPT-2 wird beispielsweise mit ungefilterten Inhalten aus dem Internet trainiert, was zu Bias führen kann.

- Einschränkungen und Verzerrungen: Beachten Sie alle Einschränkungen oder Verzerrungen, die das Sprachmodell möglicherweise aufweist.

- Sprachunterstützung: Überprüfen Sie, welche Modelle die spezifische Sprachunterstützung oder mehrsprachige Funktionen bieten, die Sie für Ihren Anwendungsfall benötigen.

Tipp

Azure KI Foundry stellt zwar Beschreibungen für alle Sprachmodelle im Modellkatalog bereit, auf den Modellkarten finden Sie jedoch noch weitere Informationen zu den einzelnen Modellen. Die Modellkarten sind in der Übersicht der einzelnen Modelle aufgeführt und auf der Website von Hugging Face zu finden.

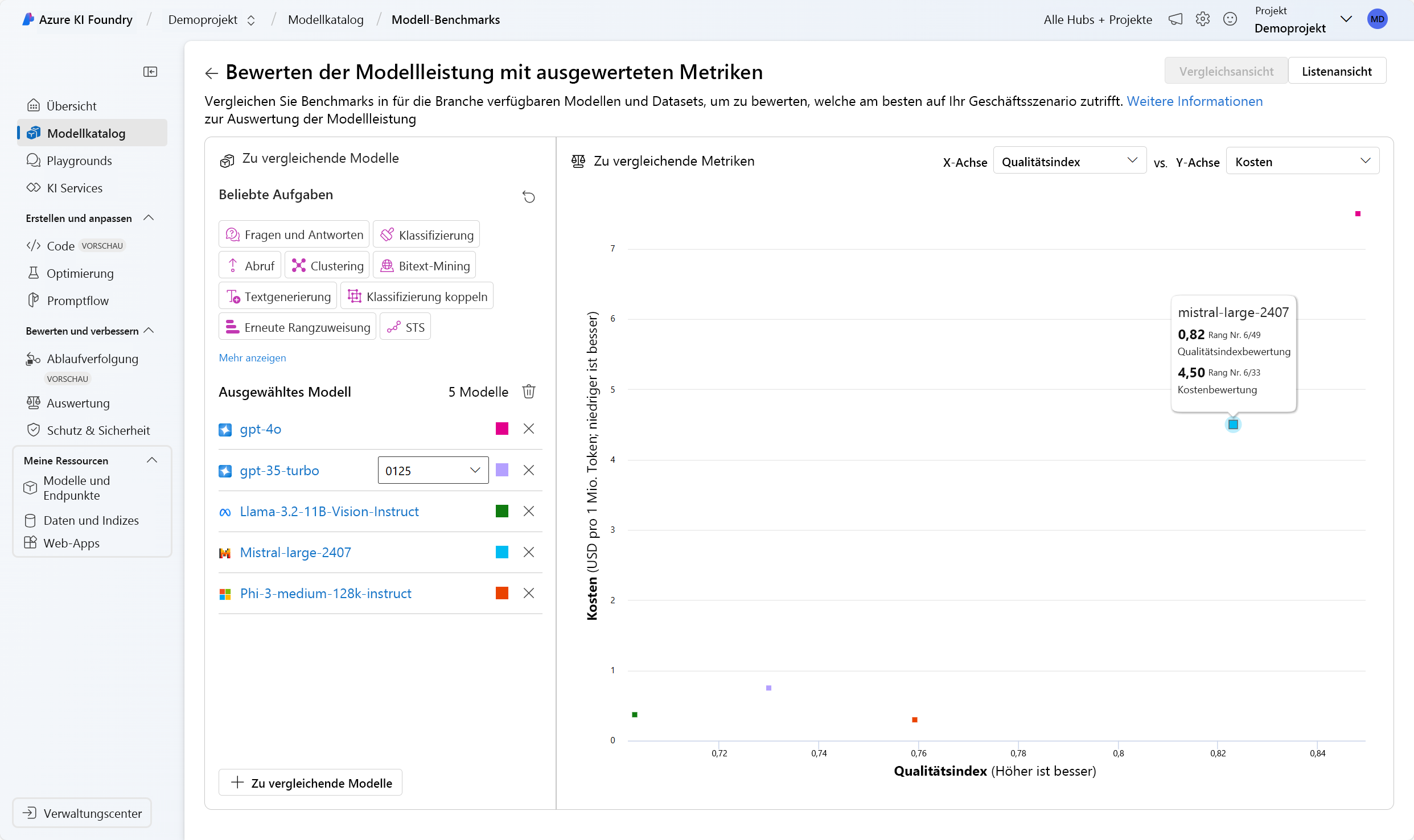

Vergleich von Benchmarks über Modelle hinweg

Beim Erkunden der Sprachmodelle können Sie auch die verfügbaren Modell-Benchmarks vergleichen, um die Qualität der Modelle zu bewerten, bevor Sie ein Modell bereitstellen und integrieren. Benchmarks sind wie Berichtskarten für Sprachmodelle. Benchmarks helfen Ihnen, die Leistung eines Modells zu verstehen, indem Sie es anhand bestimmter Tests oder Aufgaben mit anderen Modellen vergleichen. Die Modell-Benchmarks im Azure KI Foundry-Portal bieten basierend auf Benchmarkmetriken eine kuratierte Liste der Modelle, die die beste Leistung für eine bestimmte Aufgabe bieten.

Folgende Metriken werden z. B. häufig zum Bewerten der Leistung von Sprachmodellen verwendet:

| Metrik | Beschreibung |

|---|---|

| Genauigkeit | Genauigkeitsbewertungen sind im Dataset und auf Modellebenen verfügbar. Auf Datasetebene ist die Bewertung der Mittelwert einer Genauigkeitsmetrik, die über alle Beispiele im Dataset berechnet wird. Die verwendete Metrik für die Genauigkeit ist in allen Fällen eine exakte Übereinstimmung, mit Ausnahme des HumanEval-DataSets, der eine pass@1-Metrik verwendet. Der exakte Wertevergleich vergleicht einfach den vom Modell generierten Text mit der richtigen Antwort gemäß dem Dataset und meldet eine Eins, wenn der generierte Text genau mit der Antwort übereinstimmt, und ansonsten eine Null. Pass@1 misst den Anteil der Modelllösungen, die eine Reihe von Komponententests in einer Codegenerierungsaufgabe bestehen. Auf Modellebene ist die Genauigkeitsbewertung der Mittelwert der Genauigkeit auf Datasetebene für jedes Modell. |

| Kohärenz | Kohärenz bewertet, wie gut das Sprachmodell eine Ausgabe erzeugen kann, die sich flüssig und natürlich liest und der menschlichen Sprache ähnelt. |

| Geläufigkeit | Geläufigkeit bewertet die Sprachkompetenz der vorhergesagten Antwort einer generativen KI. Sie bewertet, wie gut der generierte Text grammatikalische Regeln, syntaktische Strukturen und die angemessene Verwendung des Vokabulars einhält, was zu sprachlich korrekten und natürlich klingenden Antworten führt. |

| GPTSimilarity | GPTSimilarity ist ein Measure, das die Ähnlichkeit zwischen einem Ground-Truth-Satz (oder Dokument) und dem Vorhersagesatz, der von einem KI-Modell generiert wird, quantifiziert. Sie wird berechnet, indem zunächst Einbettungen auf Satzebene unter Verwendung der Einbettungs-API sowohl für die Grundwahrheit als auch für die Vorhersage des Modells berechnet werden. Diese Einbettungen stellen hochdimensionale Vektordarstellungen der Sätze dar, die ihre semantische Bedeutung und ihren Kontext erfassen. |

| Quellenübereinstimmung | Quellenübereinstimmung misst, wie gut die vom Sprachmodell generierten Antworten mit den Informationen aus der Eingabequelle zusammenpassen. |

| Relevanz | Relevanz misst das Ausmaß, in dem die vom Sprachmodell generierten Antworten relevant sind und in direktem Zusammenhang mit den vorgegebenen Fragen stehen. |

Hinweis

Beim Entwickeln und Auswerten von Anwendungen, die Sprachmodelle verwenden, ist es wichtig, die Leistung des Modells und der Anwendung mithilfe von Metriken zu messen. Die Metriken, die für Benchmarks zum Vergleichen verschiedener Modelle verwendet werden, können auch genutzt werden, um während der Entwicklung die Leistung eines einzelnen Modells zu bewerten. Anhand dieser Metriken können Sie nachvollziehen, wie gut Ihr Modell funktioniert, und Bereiche mit Verbesserungsbedarf identifizieren.

Die Auswahl des geeigneten Modells für Ihre Anforderungen kann ein iterativer Prozess sein. Als Nächstes erfahren Sie, wie Sie ein Modell bereitstellen, damit Sie Tests und Experimente durchführen können, um es für Ihren Anwendungsfall zu optimieren.