Verstehen und Erstellen von Batchendpunkten

Um ein Modell zum Generieren von Batchvorhersagen abzurufen, können Sie das Modell auf einem Batchendpunkt bereitstellen.

Sie lernen, wie Sie Batchendpunkte für die asynchrone Batch-Auswertung verwenden.

Batchvorhersagen

Um Batchvorhersagen zu erhalten, können Sie ein Modell auf einem Endpunkt bereitstellen. Ein Endpunkt ist ein HTTPS-Endpunkt, den Sie aufrufen können, um einen Batch-Scoring-Auftrag auszulösen. Der Vorteil eines solchen Endpunkts besteht darin, dass Sie den Batchbewertungsauftrag von einem anderen Dienst auslösen können, z. B. Azure Synapse Analytics oder Azure Databricks. Mit einem Batchendpunkt können Sie die Batchverarbeitung in einen vorhandenen Datenaufnahmeprozess und eine Transformationspipeline integrieren.

Wenn der Endpunkt aufgerufen wird, wird ein Batchbewertungsauftrag an den Azure Machine Learning-Arbeitsbereich übermittelt. Der Auftrag verwendet in der Regel einen -Computecluster-, um mehrere Eingaben zu bewerten. Die Ergebnisse können in einem Datenspeicher gespeichert werden, der mit dem Azure Machine Learning-Arbeitsbereich verbunden ist.

Batchendpunkt erstellen

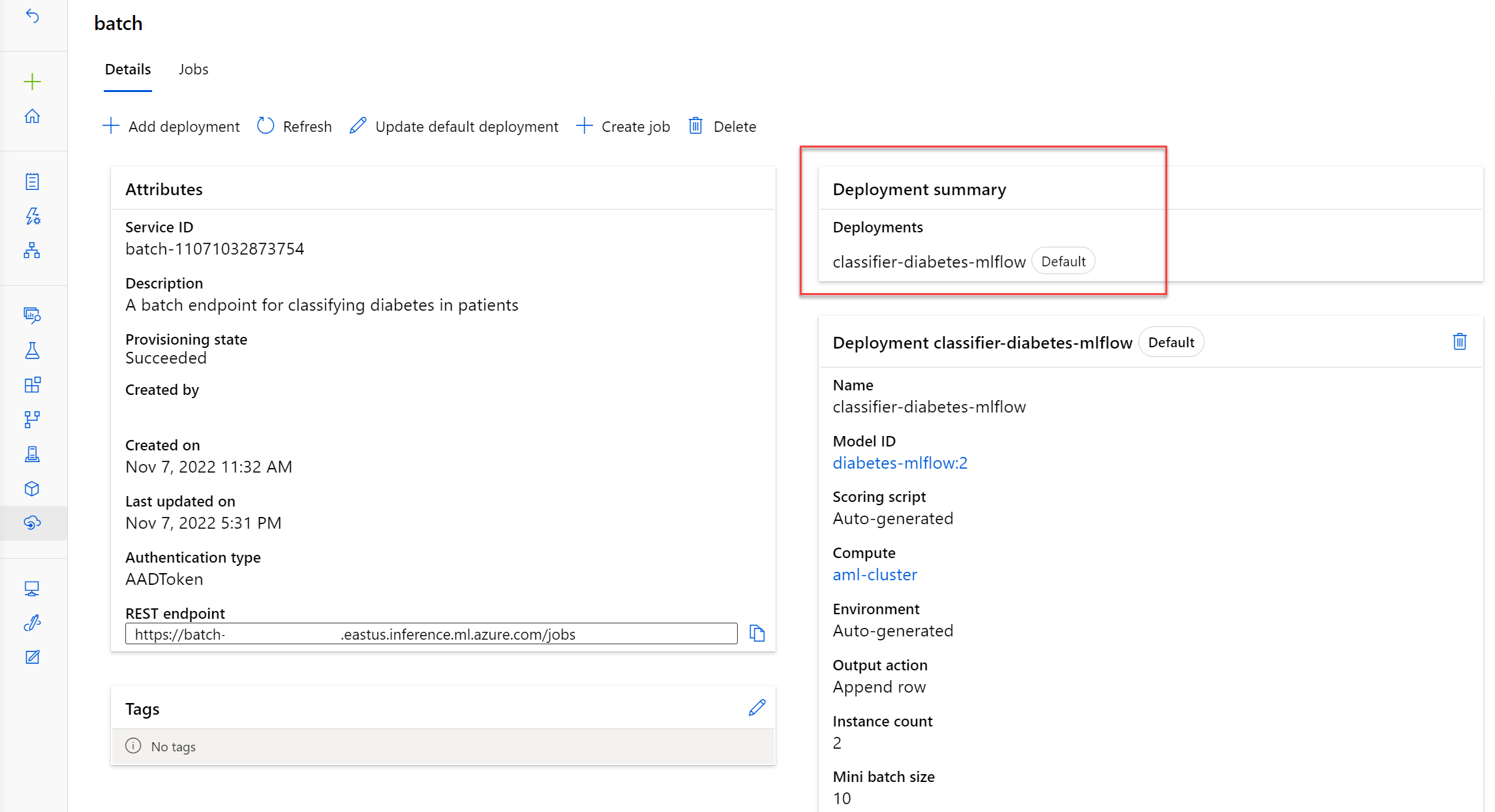

Um ein Modell auf einem Batchendpunkt bereitzustellen, müssen Sie zuerst den Batchendpunkt erstellen.

Zum Erstellen eines Batch-Endpunkts verwenden Sie die BatchEndpoint-Klasse. Batch-Endpunktnamen müssen innerhalb einer Azure-Region eindeutig sein.

Verwenden Sie zum Erstellen eines Endpunkts den folgenden Befehl:

# create a batch endpoint

endpoint = BatchEndpoint(

name="endpoint-example",

description="A batch endpoint",

)

ml_client.batch_endpoints.begin_create_or_update(endpoint)

Trinkgeld

In der Referenzdokumentation erfahren Sie, einen Batchendpunkt mit dem Python SDK v2-erstellen.

Bereitstellung eines Modells auf einem Batch-Endpunkt

Sie können mehrere Modelle auf einem Batchendpunkt bereitstellen. Wenn Sie den Stapel-Endpunkt aufrufen, der einen Stapelbewertungsauftrag auslöst, wird die Standardbereitstellung verwendet, sofern nicht anders vorgesehen.

Verwenden von Computeclustern für Batchbereitstellungen

Der ideale Compute für Batchbereitstellungen ist der Azure Machine Learning-Computecluster. Wenn der Batchbewertungsauftrag die neuen Daten in parallelen Batches verarbeiten soll, müssen Sie einen Computecluster mit mehr als einer maximalen Instanz bereitstellen.

Zum Erstellen eines Computeclusters können Sie die AMLCompute Klasse verwenden.

from azure.ai.ml.entities import AmlCompute

cpu_cluster = AmlCompute(

name="aml-cluster",

type="amlcompute",

size="STANDARD_DS11_V2",

min_instances=0,

max_instances=4,

idle_time_before_scale_down=120,

tier="Dedicated",

)

cpu_cluster = ml_client.compute.begin_create_or_update(cpu_cluster)