Grundlegendes zu Azure Data Factory

Die Notwendigkeit, die Batchverschiebung von Daten auszulösen oder einen regelmäßigen Zeitplan einzurichten, ist eine Voraussetzung für die meisten Analyselösungen. Azure Data Factory (ADF) ist der Dienst, der verwendet werden kann, um eine solche Anforderung zu erfüllen. ADF bietet einen cloudbasierten Datenintegrationsdienst, der die Verschiebung und Transformation von Daten zwischen verschiedenen Datenspeichern und Computeressourcen orchestriert.

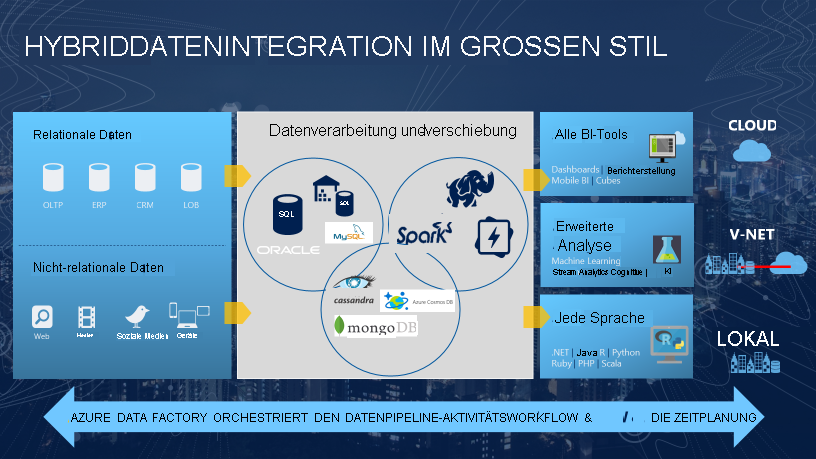

Azure Data Factory ist der cloudbasierte ETL- und Datenintegrationsdienst, mit dem Sie datengesteuerte Workflows für die Orchestrierung von Datenverschiebungen und die Datentransformationen im großen Stil erstellen können. Mit Azure Data Factory können Sie datengesteuerte Workflows (so genannte Pipelines) erstellen und planen, die Daten aus unterschiedlichen Datenspeichern erfassen. Sie können komplexe ETL-Prozesse erstellen, die Daten visuell mit Datenflüssen oder unter Verwendung von Computediensten wie Azure HDInsight Hadoop, Azure Databricks und Azure Synapse Analytics transformieren.

Ein Großteil der Funktionalität von Azure Data Factory erscheint in Azure Synapse Analytics als eine Funktion, die als Pipelines bezeichnet wird und die es Ihnen ermöglicht, Datenpipelines zwischen SQL-Pools, Spark-Pools und SQL Serverless zu integrieren und so eine zentrale Anlaufstelle für alle Ihre Analysebedürfnisse zu schaffen.

Was ist mit Orchestrierung gemeint?

Um eine Analogie zu verwenden: Denken Sie an ein Sinfonieorchester. Das zentrale Mitglied des Orchesters ist der Dirigent. Der Dirigent spielt nicht die Instrumente, er führt die Sinfoniker einfach durch das gesamte Musikstück, das sie aufführen. Die Musiker nutzen ihre eigenen Fähigkeiten, um bestimmte Klänge an verschiedenen Stellen der Sinfonie zu erzeugen, sodass sie eventuell auch nur bestimmte Teile des Musikstücks lernen. Der Dirigent orchestriert das gesamte Musikstück und ist sich daher der gesamten Partitur, die aufgeführt wird, bewusst. Er verwendet auch spezifische Armbewegungen, die den Musikern Anweisungen geben, wie eine Stelle des Musikstücks zu spielen ist.

ADF kann einen ähnlichen Ansatz verwenden. Während es über native Funktionen zum Erfassen und Transformieren von Daten verfügt, wird es manchmal einen anderen Dienst anweisen, die tatsächlich erforderliche Arbeit in seinem Auftrag auszuführen, z. B. Databricks, um eine Transformationsabfrage durchzuführen. In diesem Fall würde also Databricks die Arbeit ausführen, nicht ADF. ADF orchestriert die Ausführung der Abfrage lediglich und stellt dann die Pipelines bereit, um die Daten zum nächsten Schritt oder Ziel zu bewegen.

Darüber hinaus stehen umfangreiche Visualisierungen zur Verfügung, um Herkunft und Abhängigkeiten zwischen Ihren Datenpipelines anzuzeigen und alle Ihre Datenpipelines über eine zentrale, einheitliche Ansicht zu überwachen. Dadurch können Sie nicht nur mühelos Probleme lokalisieren, sondern auch Überwachungswarnungen einrichten.