Übung: Integrieren und Verwenden der Spracherkennung und Transkription

In diesem Modul werden Sie eine Mixed Reality-Anwendung erstellen, um sich mit der Verwendung der Azure Speech-Dienste mit HoloLens 2 vertraut zu machen. Nach Absolvieren diese Reihe können Sie mithilfe Ihres Gerätemikrofons in Echtzeit Sprache in Text transkribieren, Ihre Äußerungen in andere Sprachen übersetzen und mithilfe des Absichtserkennungsfeatures Sprachbefehle mithilfe künstlicher Intelligenz verstehen.

Erstellen und Vorbereiten des Unity-Projekts

In diesem Abschnitt erstellen Sie ein neues Unity-Projekt und bereiten es für die MRTK-Entwicklung vor.

Stellen Sie als Voraussetzung sicher, dass Sie die folgenden Schritte ausgeführt haben, um Ihr Projekt und Ihre Anwendung zu initialisieren:

- Erstellen eines neuen Unity-Projekts, das mit einem passenden Namen bezeichnet wird, beispielsweise MRTK-Tutorials

- Wechseln der Buildplattform

- Importieren der TextMeshPro Essential-Ressourcen

- Importieren des Mixed Reality-Toolkits

- Konfigurieren des Unity-Projekts

- Erstellen und Konfigurieren der Szene und Vergabe eines geeigneten Namens; zum Beispiel: AzureSpeechServices

Hinweis

Informationen zum Einrichten Ihres Mixed Reality-Projekts finden Sie im Modul Einführung in das Mixed Reality-Toolkit.

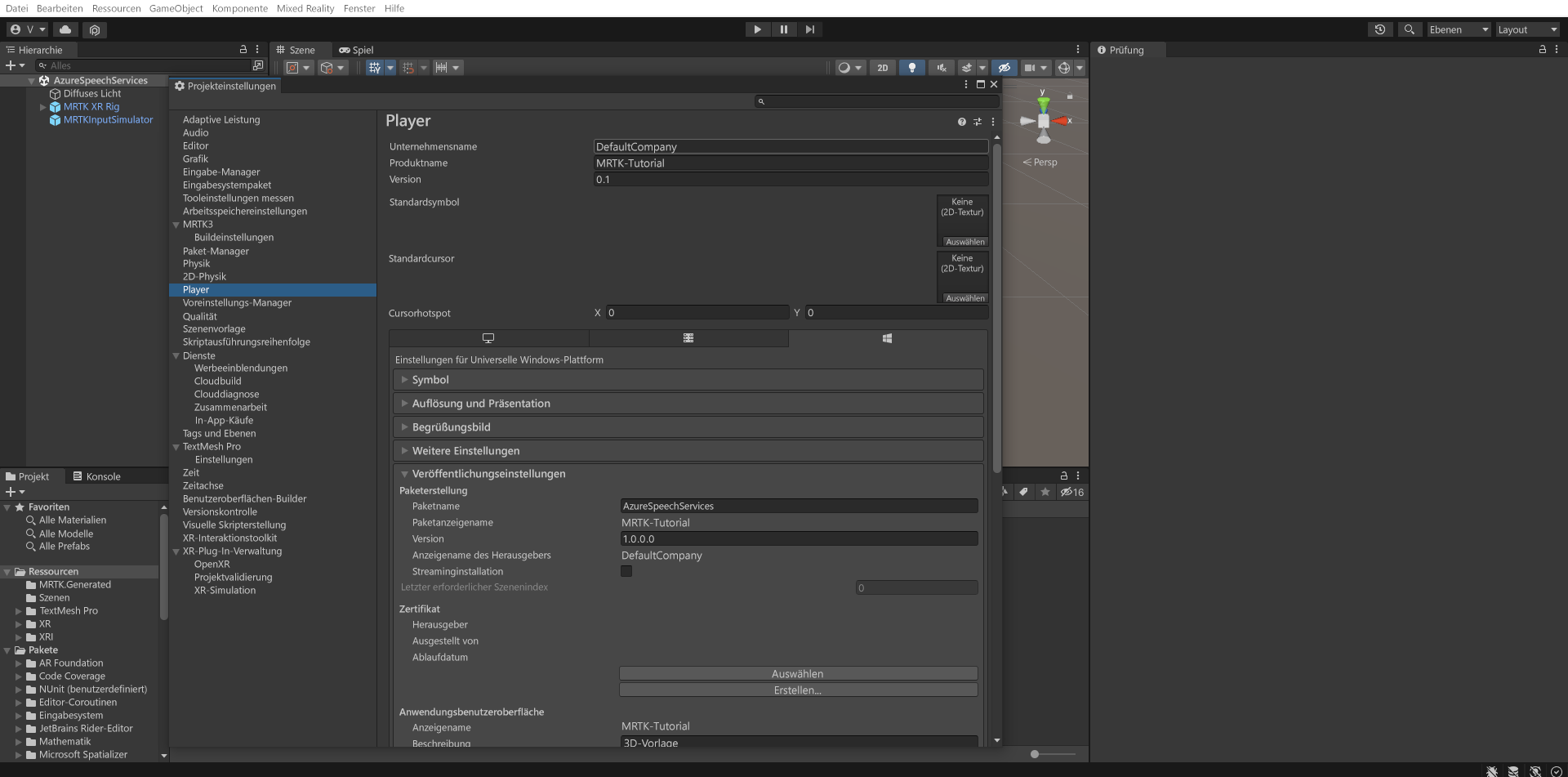

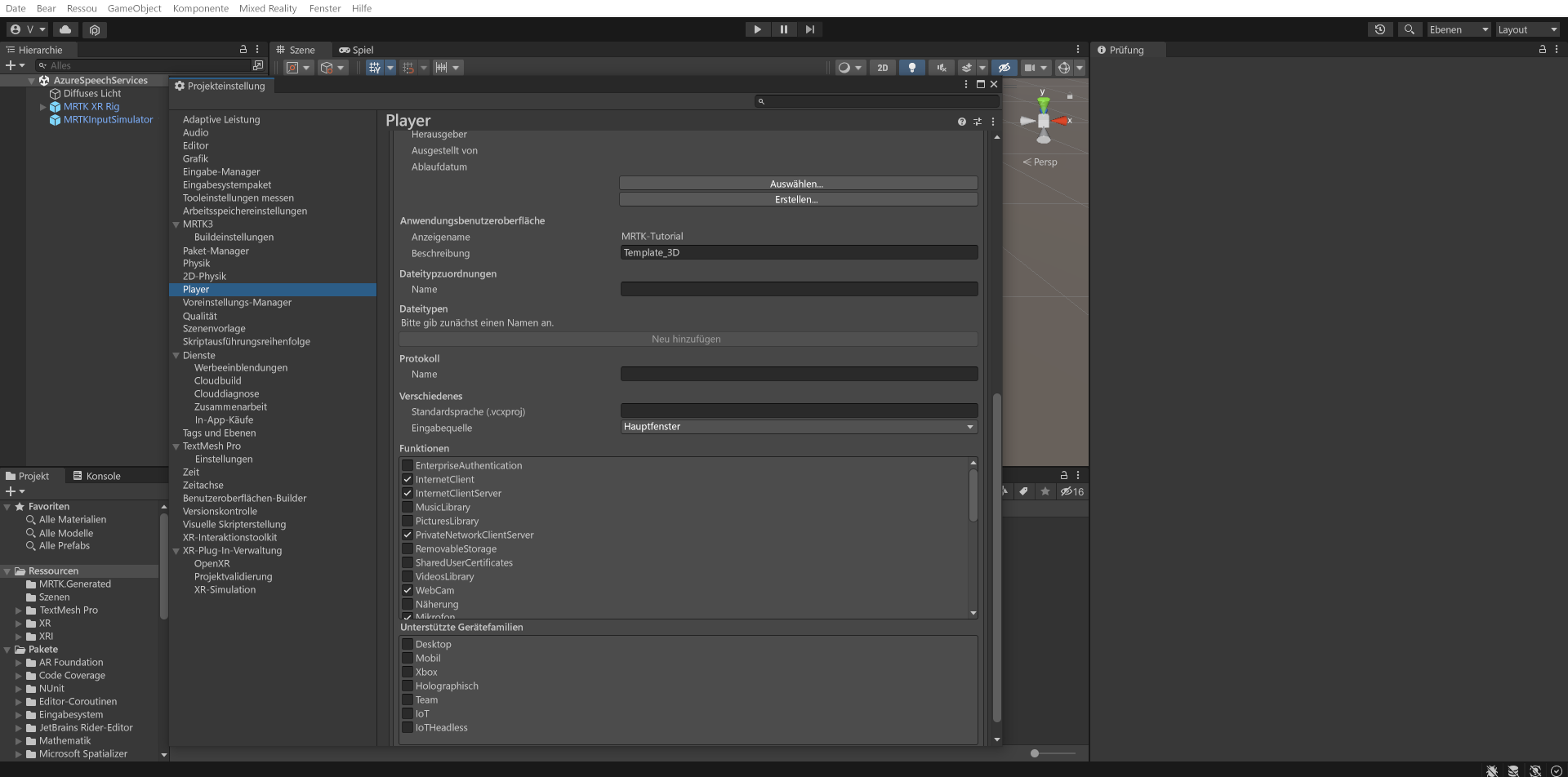

Konfigurieren der Funktionen

Wählen Sie im Unity-Menü Edit>Project Settings... (Bearbeiten > Projekteinstellungen) aus, um das Fenster mit den Player-Einstellungen zu öffnen, und suchen Sie dann den Abschnitt Player>Publishing Settings (Player > Veröffentlichungseinstellungen):

Scrollen Sie in den Veröffentlichungseinstellungen nach unten zum Abschnitt Funktionen, und überprüfen Sie, ob die Funktionen InternetClient, Mikrofon und SpatialPerception (die Sie bei der Erstellung des Projekts zu Beginn des Tutorials festgelegt haben) noch aktiviert sind. Aktivieren Sie dann die Funktionen InternetClientServer und PrivateNetworkClientServer.

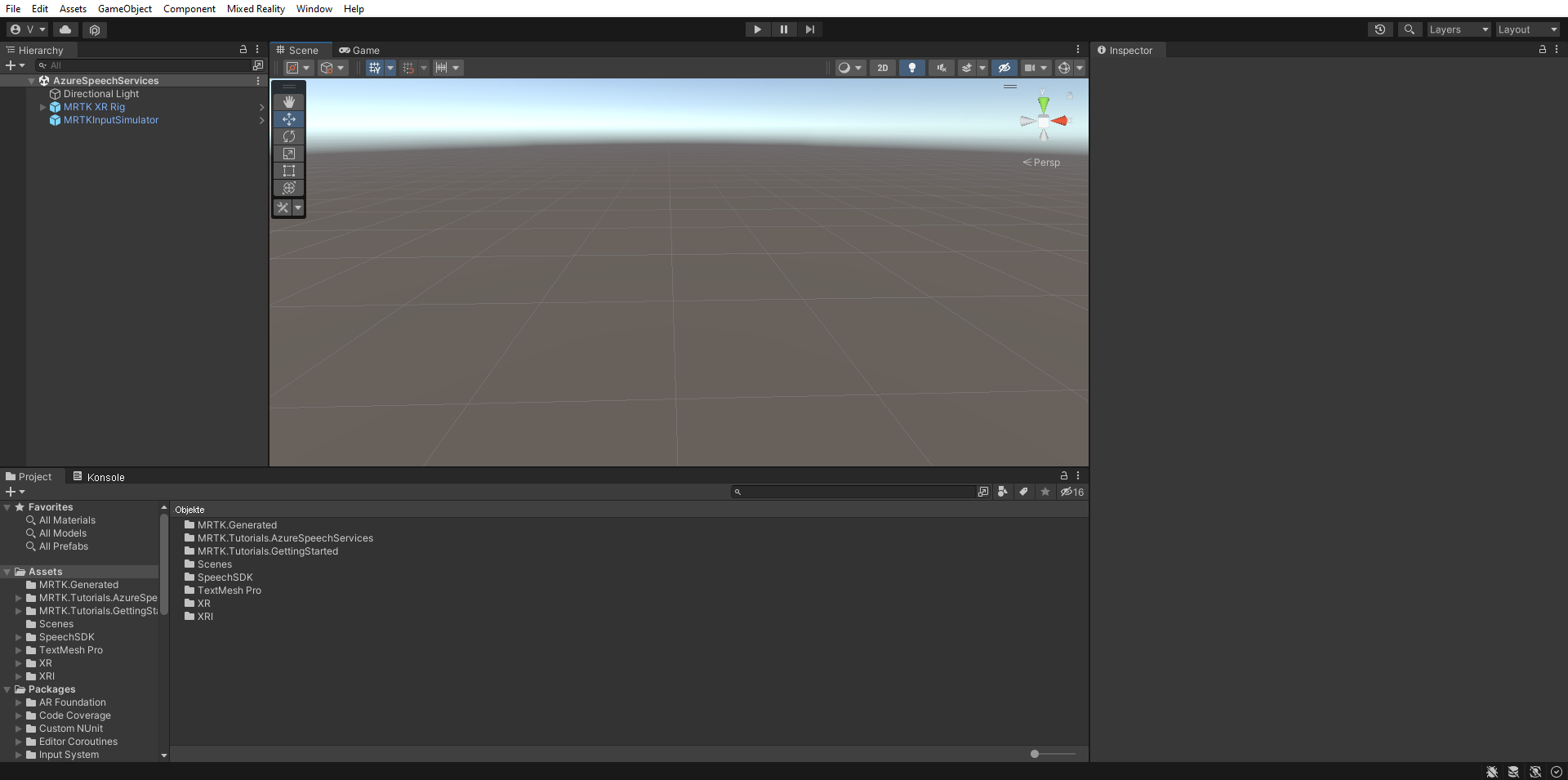

Importieren der Tutorialressourcen

Laden Sie die folgenden benutzerdefinierten Unity-Pakete herunter, und importieren Sie sie in der Reihenfolge, in der sie hier aufgeführt sind:

Nachdem Sie die Tutorialressourcen importiert haben, sollte ihr Projekt wie im folgenden Fenster aussehen:

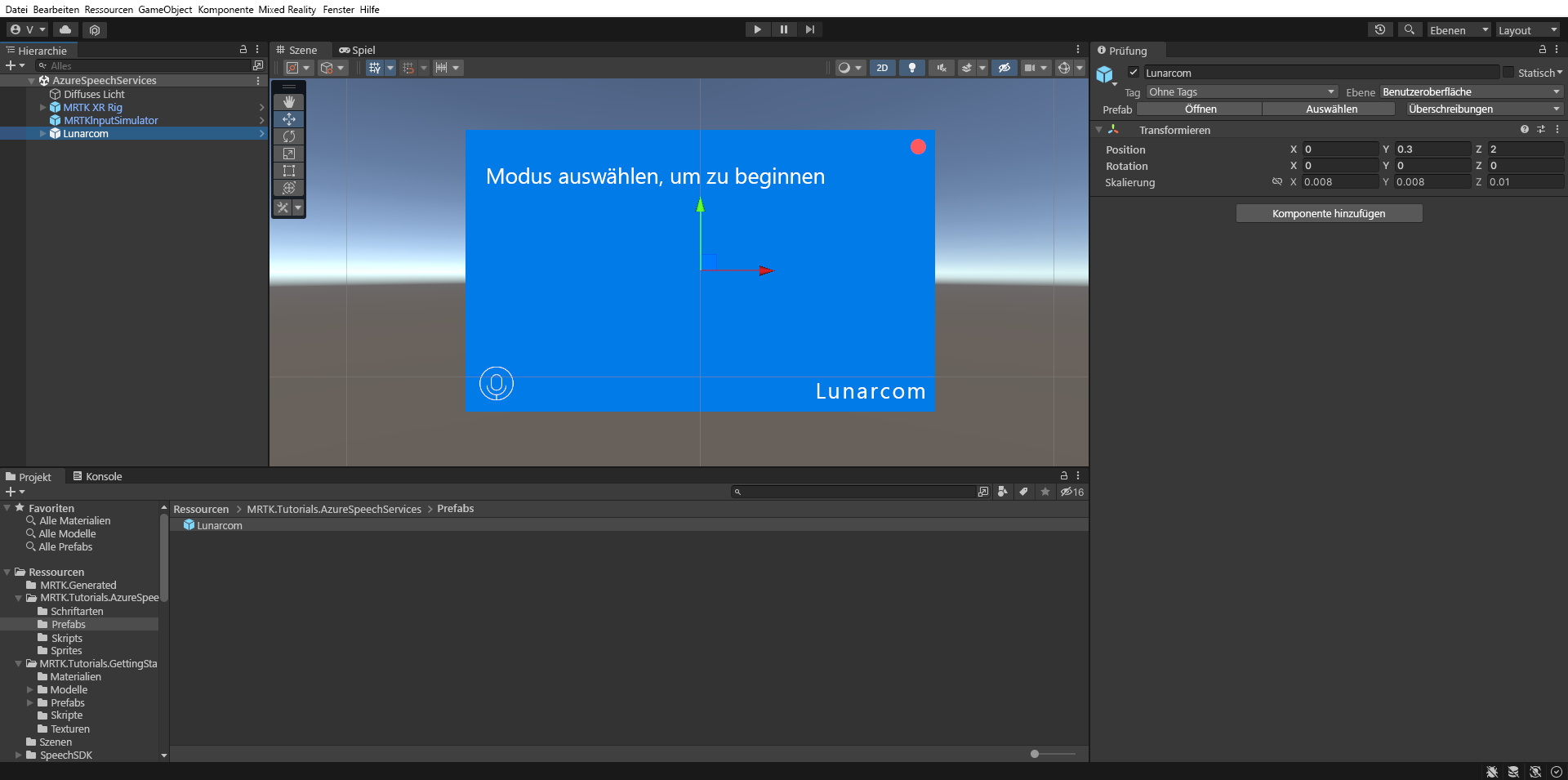

Vorbereiten der Szene

In diesem Abschnitt bereiten Sie die Szene vor, indem Sie das Tutorialprefab hinzufügen und die Lunarcom Controller (Skript)-Komponente konfigurieren, um Ihre Szene zu steuern.

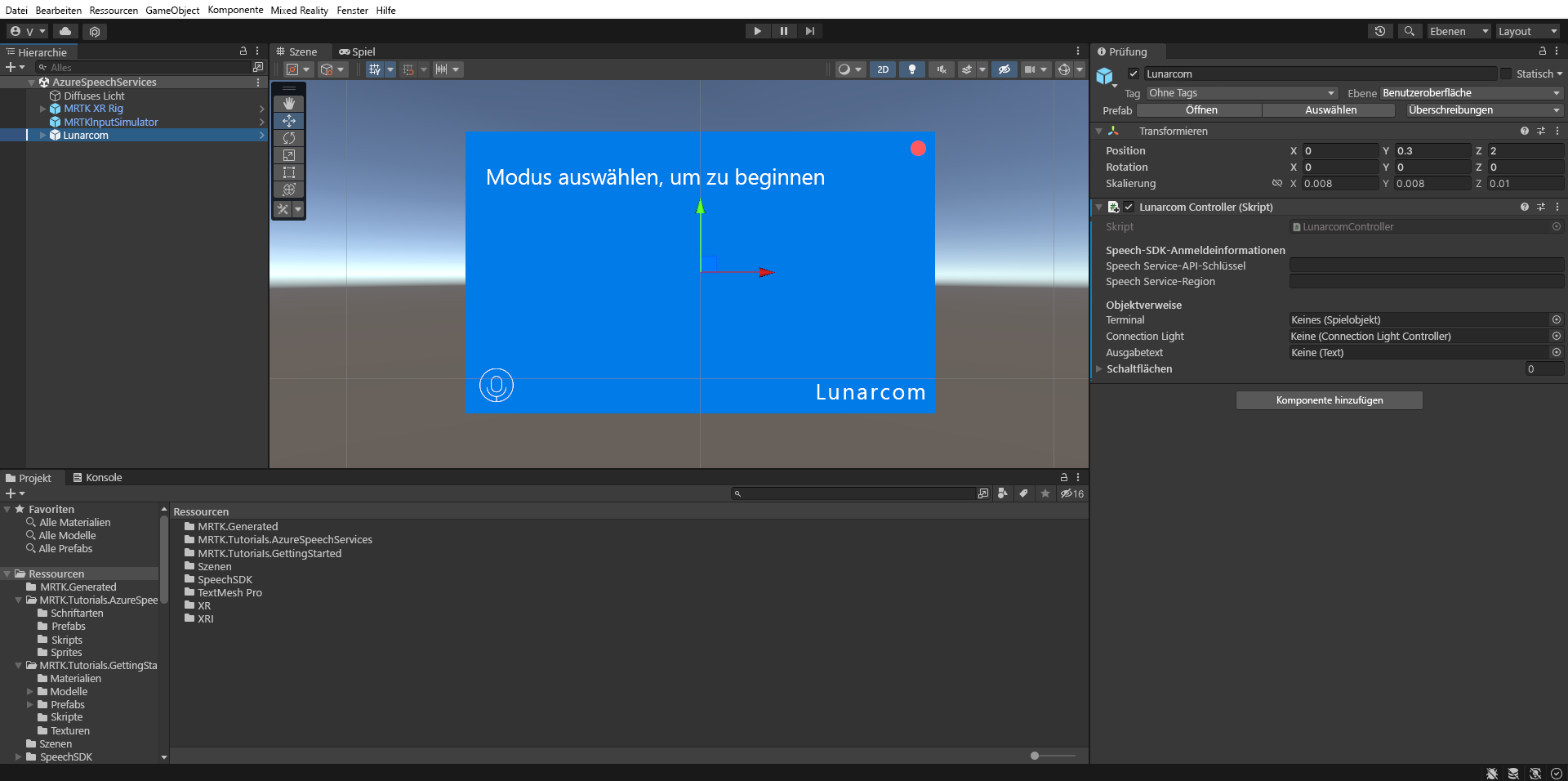

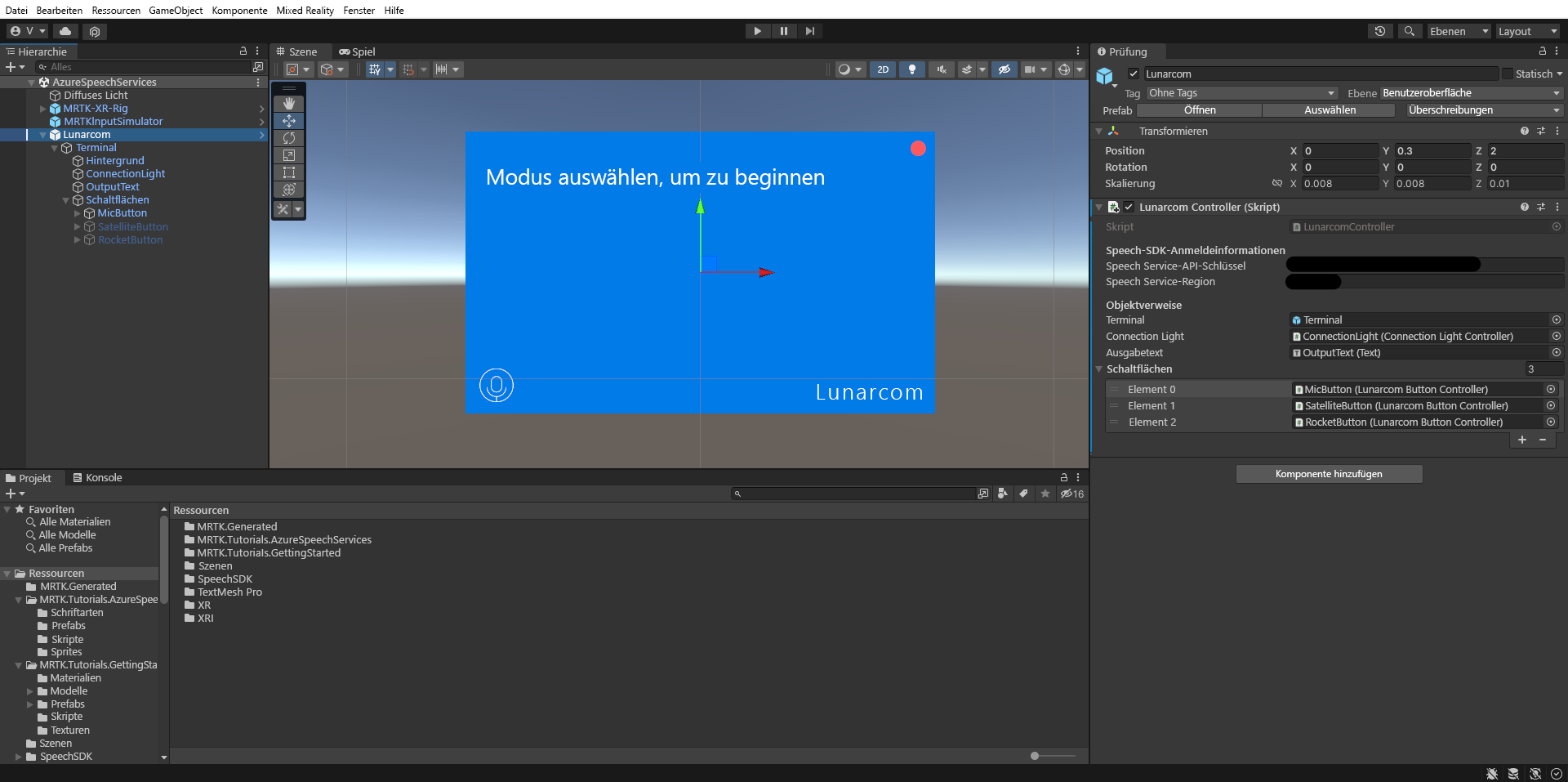

Navigieren Sie im Fenster „Projekt“ zum Ordner Assets>MRTK.Tutorials.AzureSpeechServices>Prefabs, und ziehen Sie das Prefab Lunarcom in das Fenster „Hierarchie“, um es Ihrer Szene hinzuzufügen.

Wenn das Lunarcom-Objekt weiterhin im Hierarchiefenster ausgewählt ist, verwenden Sie im Inspektor-Fenster die Schaltfläche Komponente hinzufügen, um die Lunarcom Controller (Skript)-Komponente zum Lunarcom-Objekt hinzuzufügen.

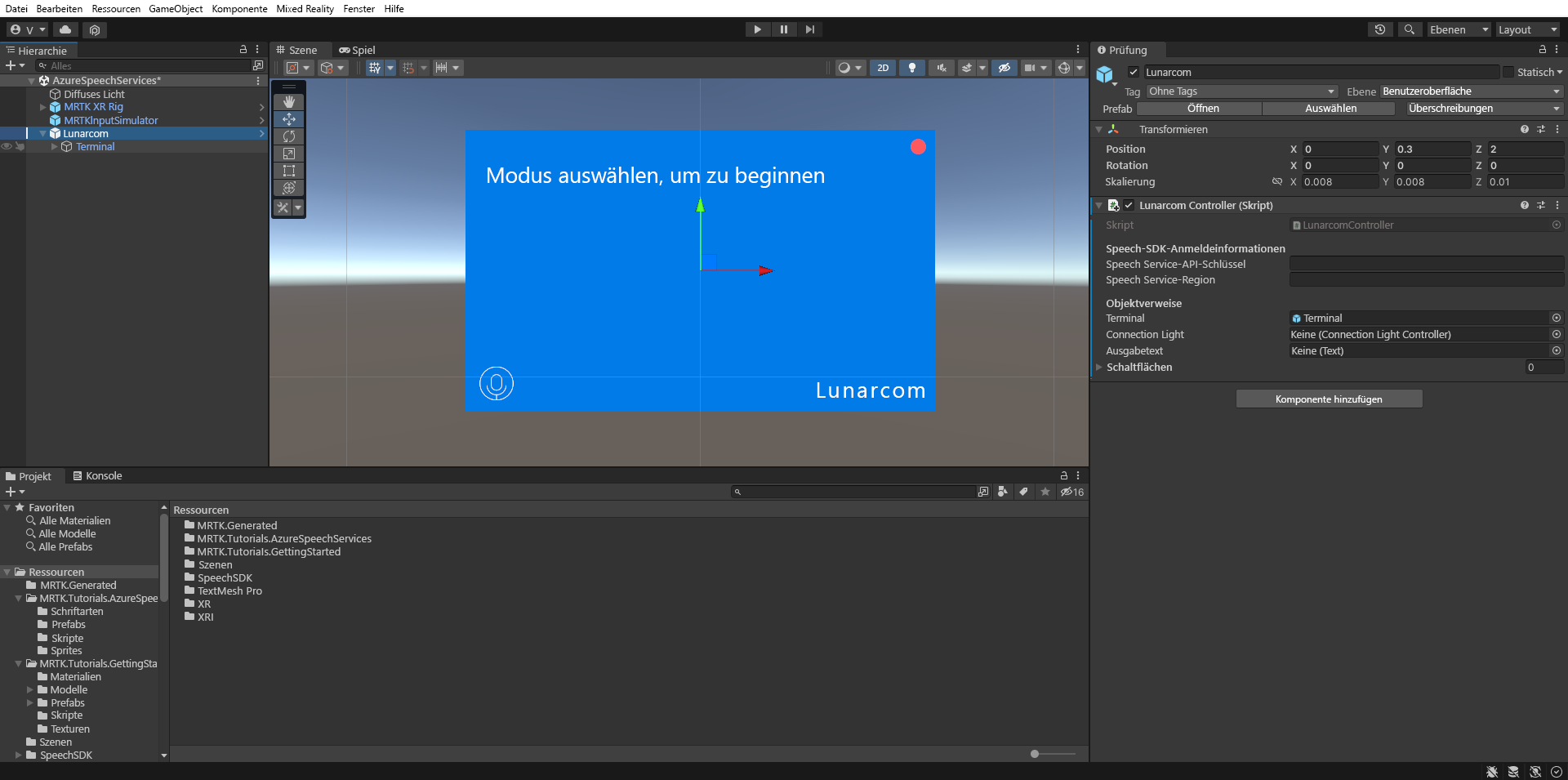

Wenn das Lunarcom-Objekt weiterhin ausgewählt ist, erweitern Sie es, um seine untergeordneten Objekte anzuzeigen, und ziehen Sie dann das Objekt Terminal in das Feld Terminal der Lunarcom Controller (Script)-Komponente.

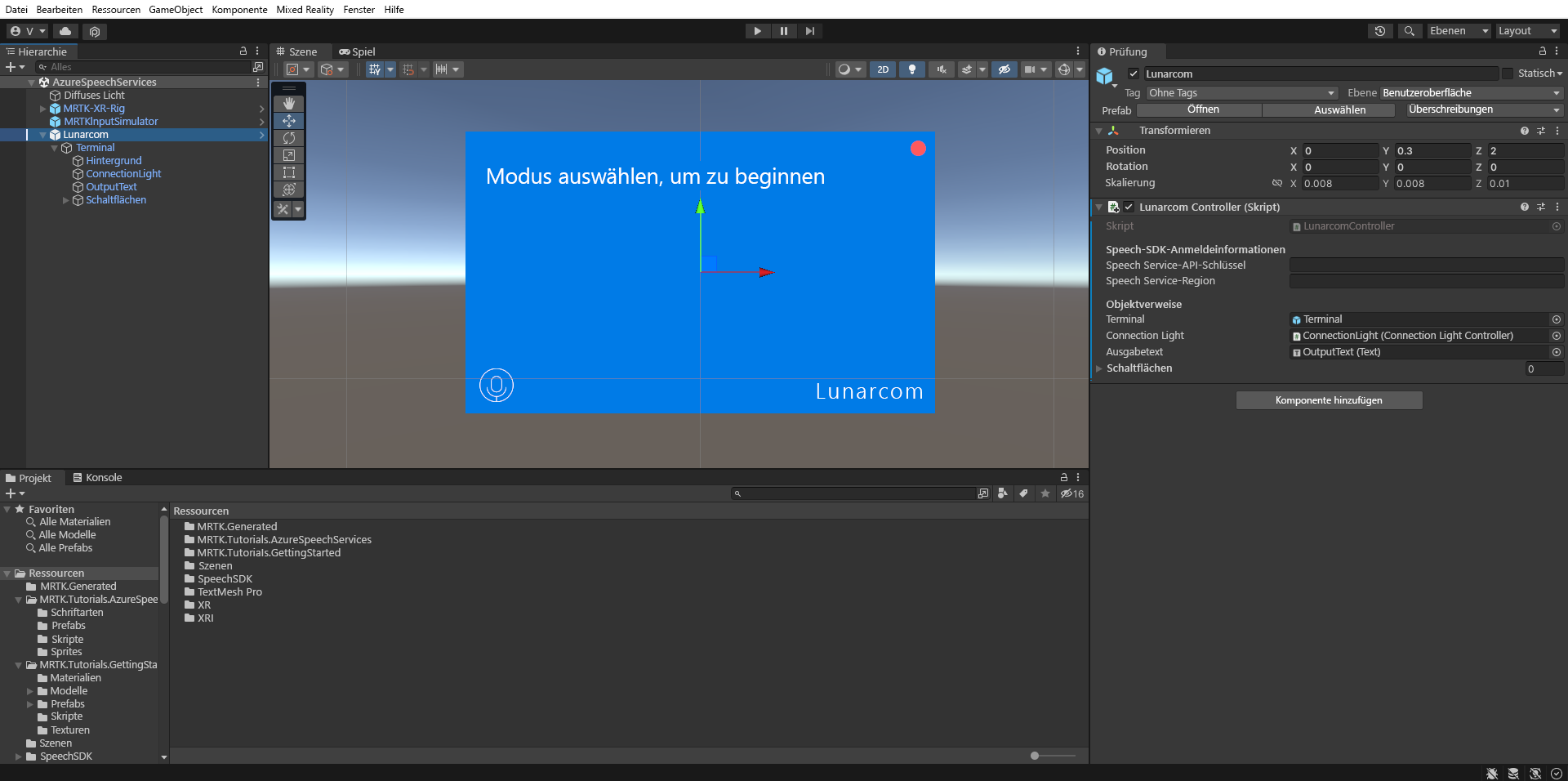

Wenn das Lunarcom-Objekt weiterhin ausgewählt ist, erweitern Sie das Terminal-Objekt, um seine untergeordneten Objekte anzuzeigen, und ziehen Sie dann das Objekt ConnectionLight in das Feld Connection Light der Connection Light (Script)-Komponente und das OutputText-Objekt in das Feld Ausgabetext.

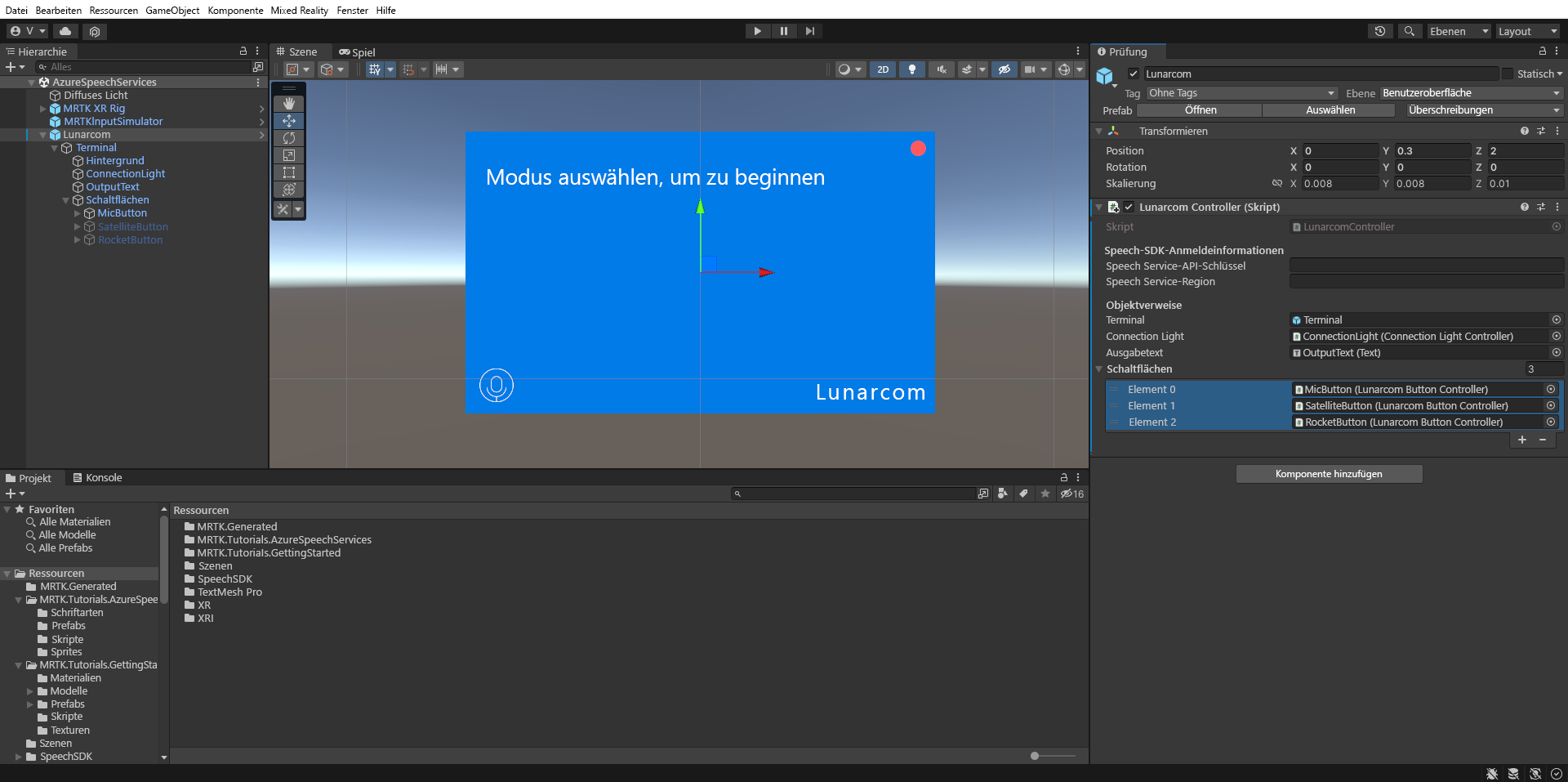

Wenn das Lunarcom-Objekt weiterhin ausgewählt ist, erweitern Sie das Schaltflächen-Objekt, um seine untergeordneten Objekte anzuzeigen, und erweitern Sie dann im Inspektorfenster die Liste Schaltflächen, legen Sie das Feld Schaltflächen auf 3 fest, und ziehen Sie die MicButton-, SatelliteButton- und RocketButton-Objekte jeweils in die Felder Element 0, 1 und 2.

Verbinden des Unity-Projekts mit der Azure-Ressource

Um Azure Speech Services zu verwenden, müssen Sie eine Azure-Ressource erstellen und einen API-Schlüssel für den Speech Service abrufen. Befolgen Sie die Anweisungen im Schnellstart, und notieren Sie sich Ihre Dienstregion (auch Standort genannt) sowie den API-Schlüssel (auch Schlüssel1 oder Schlüssel2 genannt).

Wählen Sie in Ihrem Hierarchiefenster das Lunarcom-Objekt aus, suchen Sie dann im Inspektorfenster den Abschnitt Speech SDK Credentials der Lunarcom Controller (Script) -Komponente, und konfigurieren Sie ihn wie folgt:

- Geben Sie im Feld Sprachdienst-API-Schlüssel Ihren API-Schlüssel (Schlüssel1 oder Schlüssel2) ein.

- Geben Sie im Feld Region des Spracherkennungsdiensts Ihre Dienstregion (Standort) mit Kleinbuchstaben und Leerzeichen ein.

Transkribieren von Sprache mithilfe der Spracherkennung

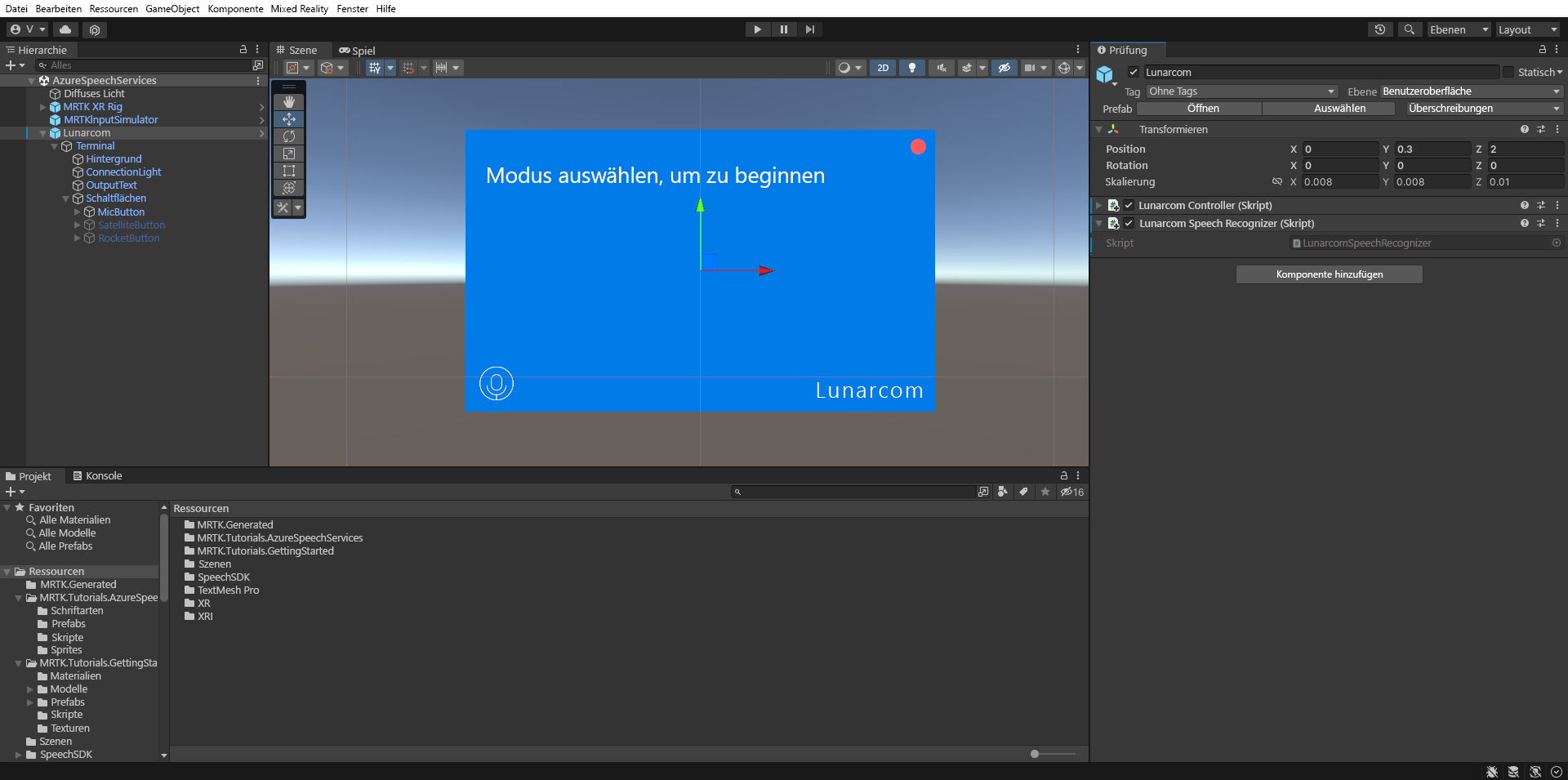

Wählen Sie im Fenster „Hierarchie“ das Lunarcom-Objekt aus, und verwenden Sie dann im Inspektorfenster die Schaltfläche Komponente hinzufügen, um die Lunarcom Speech Recognizer (Skript)-Komponente zum Lunarcom-Objekt hinzuzufügen.

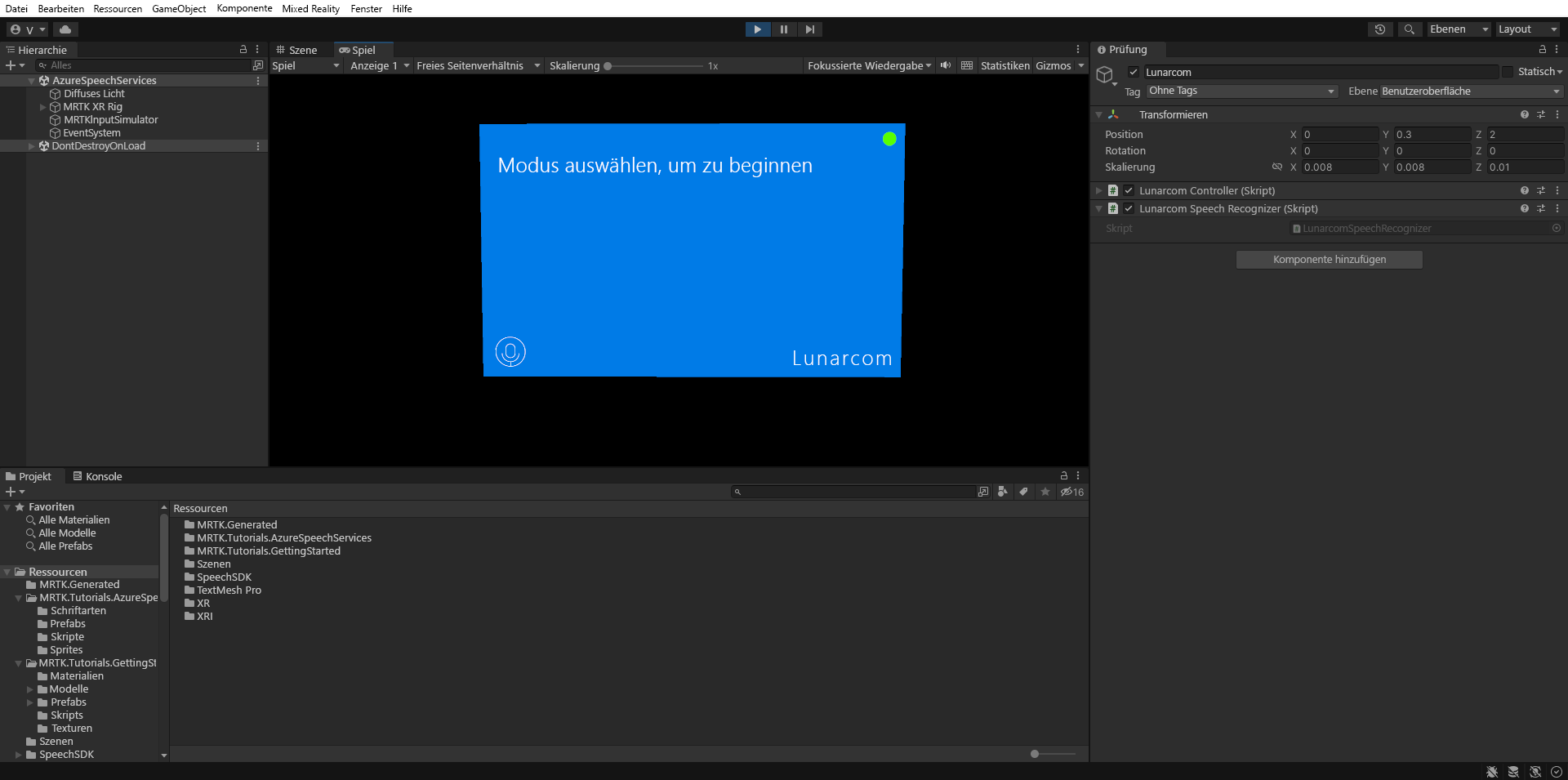

Wenn Sie jetzt in den Spielmodus wechseln und die Schaltfläche Wiedergeben auswählen, können Sie die Spracherkennung testen, indem Sie zuerst die Mikrofonschaltfläche drücken:

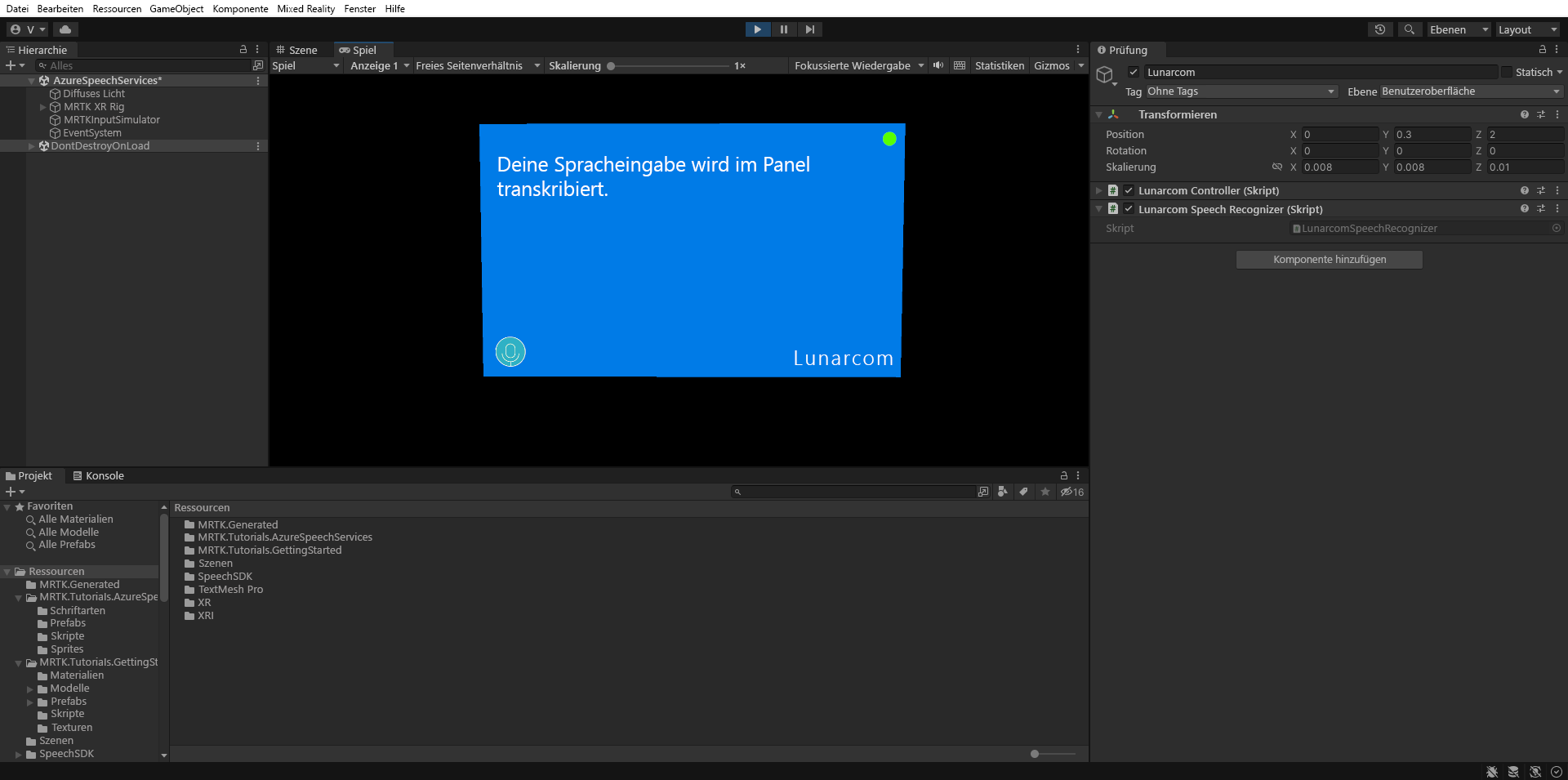

Falls Ihr Computer über ein Mikrofon verfügt, wird Ihre Sprache dann, wenn Sie etwas sagen, im Terminalbereich transkribiert:

Achtung

Die Anwendung muss eine Verbindung mit Azure herstellen, achten Sie also darauf, dass Ihr Computer/Gerät mit dem Internet verbunden ist.