CNTK v2.7 Versionshinweise

Liebe Gemeinschaft,

Mit unseren laufenden Beiträgen zu ONNX und der ONNX-Runtime haben wir es einfacher gemacht, innerhalb des KI-Framework-Ökosystems zu arbeiten und auf leistungsstarke, plattformübergreifende Ableitungsfunktionen sowohl für herkömmliche ML-Modelle als auch für tiefe neurale Netzwerke zuzugreifen. In den letzten Jahren haben wir uns zum Privilegierten gemacht, solche wichtigen Open-Source-Machine Learning-Projekte zu entwickeln, einschließlich des Microsoft Cognitive Toolkit, das es seinen Benutzern ermöglicht hat, branchenweite Fortschritte in Deep Learning im Großen und Ganzen zu nutzen.

Die heutige Version 2.7 ist die letzte Hauptversion von CNTK. Möglicherweise haben wir einige nachfolgende Nebenversionen für Fehlerbehebungen, aber diese werden fallweise ausgewertet. Nach dieser Version sind keine Pläne für die Entwicklung neuer Features geplant.

Die CNTK 2.7-Version hat vollständige Unterstützung für ONNX 1.4.1, und wir empfehlen, ihre CNTK-Modelle zu operationalisieren, um ONNX und die ONNX-Runtime zu nutzen. In Zukunft können Benutzer die weiter entwickelnden ONNX-Innovationen über die Anzahl der Frameworks nutzen, die sie unterstützen. Beispielsweise können Benutzer ONNX-Modelle nativ aus PyTorch exportieren oder TensorFlow-Modelle mit dem TensorFlow-ONNX-Konverter in ONNX konvertieren.

Wir sind unglaublich dankbar für alle Unterstützung, die wir seit der ersten Open-Source-Version von CNTK von Mitwirkenden und Benutzern erhalten haben. CNTK hat es Microsoft Teams und externen Benutzern ermöglicht, komplexe und umfangreiche Workloads in allen Arten von Deep Learning-Anwendungen auszuführen, z. B. historische Durchbrüche bei der Spracherkennung, die von Microsoft Speech-Forschern, den Ursprung des Frameworks, erzielt wurden.

Da ONNX zunehmend in der Bereitstellung von Modellen eingesetzt wird, die in Microsoft-Produkten wie Bing und Office verwendet werden, widmen wir uns der Synthesierung von Innovationen aus der Forschung mit den strengen Anforderungen der Produktion, um das Ökosystem vorwärts voranzutreiben.

Vor allem ist unser Ziel, Innovationen im Bereich Deep Learning in den Software- und Hardwarestapeln so offen und zugänglich wie möglich zu machen. Wir werden hart daran arbeiten, sowohl die bestehenden Stärken von CNTK als auch die neue hochmoderne Forschung in andere Open Source-Projekte zu bringen, um die Reichweite dieser Technologien wirklich zu erweitern.

Mit Dankbarkeit,

-- Das CNTK-Team

Highlights dieser Version

- Wechselt zu CUDA 10 für Windows und Linux.

- Unterstützen Sie die vorherige RNN-Schleife im ONNX-Export.

- Exportieren Sie größer als 2 GB Modelle im ONNX-Format.

- Unterstützen Sie FP16 in Brain Script Train-Aktion.

CNTK-Unterstützung für CUDA 10

CNTK unterstützt jetzt CUDA 10. Dies erfordert ein Update für die Buildumgebung auf Visual Studio 2017 v15.9 für Windows.

So richten Sie Build- und Laufzeitumgebung unter Windows ein:

- Installieren Sie Visual Studio 2017. Hinweis: Für CUDA 10 und darüber hinaus ist es nicht mehr erforderlich, mit der spezifischen VC Tools Version 14.11 zu installieren und auszuführen.

- Installieren Nvidia CUDA 10

- Führen Sie in PowerShell Folgendes aus: DevInstall.ps1

- Starten Sie Visual Studio 2017, und öffnen Sie CNTK.sln.

Um Build- und Laufzeitumgebung unter Linux mit Docker einzurichten, erstellen Sie bitte unbuntu 16.04 Docker Image mit Dockerfiles hier. Weitere Linux-Systeme finden Sie in den Dockerfiles zum Einrichten abhängiger Bibliotheken für CNTK.

Unterstützung der vorausgestellten RNN-Schleife im ONNX-Export

CNTK-Modelle mit rekursiven Schleifen können mit Scan-Vorgängen in ONNX-Modelle exportiert werden.

Exportieren von größer als 2 GB Modellen im ONNX-Format

Verwenden Sie Cntk, um Modelle zu exportieren, die größer als 2 GB im ONNX-Format sind. Funktions-API: save(self, filename, format=ModelFormat.CNTKv2, use_external_files_to_store_parameters=False) with 'format' set to ModelFormat.ONNX and use_external_files_to_store_parameters set to True. In diesem Fall werden Modellparameter in externen Dateien gespeichert. Exportierte Modelle müssen bei der Modellauswertung mit onnxruntime mit externen Parameterdateien verwendet werden.

2018-11-26.

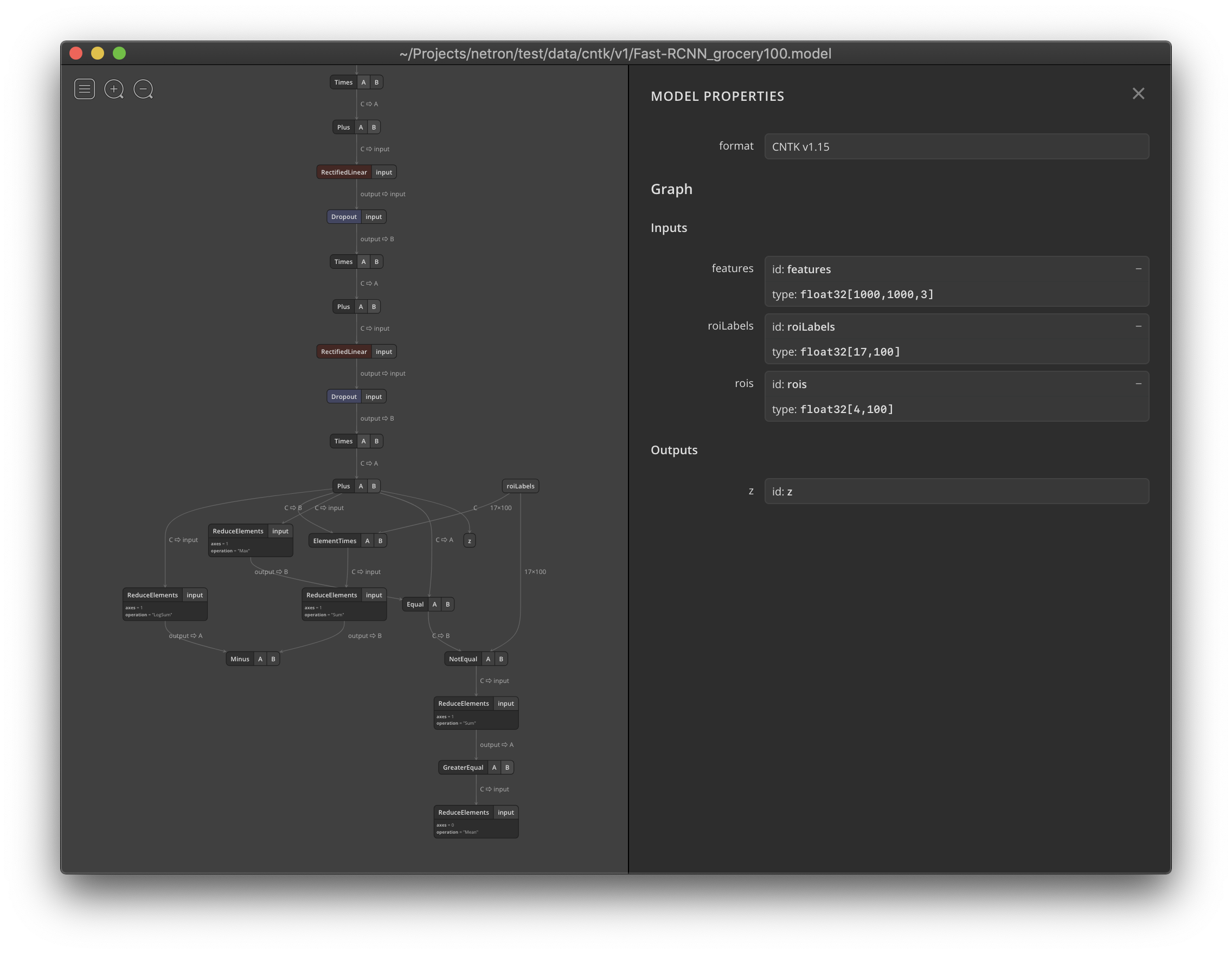

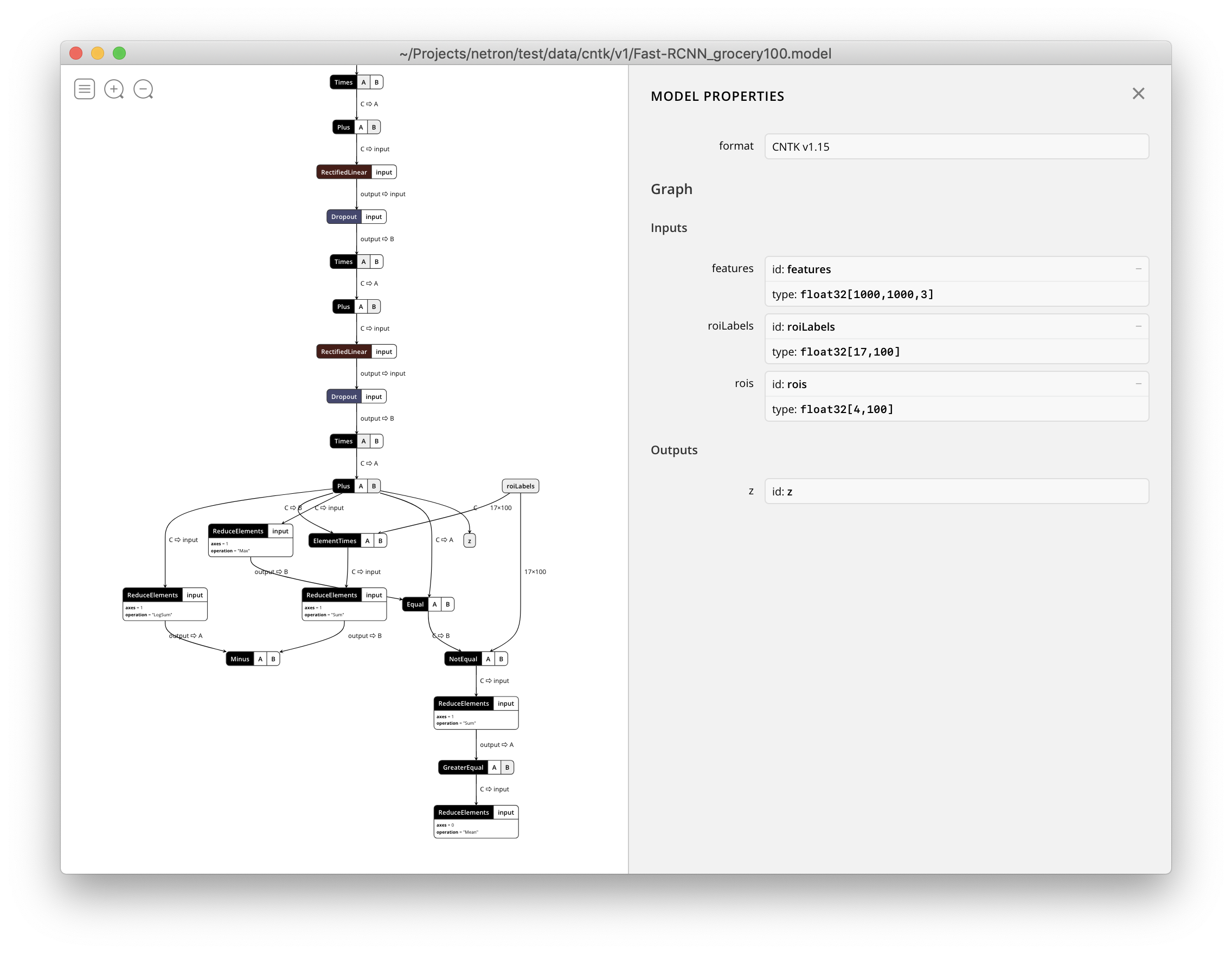

Netron unterstützt jetzt die Visualisierung von CNTK v1- und CNTK v2-.model-Dateien.