Simulieren der Azure OpenAI-API

Wenn Sie Mit Azure OpenAI verbundene Apps erstellen, interagiert häufig nur ein Teil der App mit der Azure OpenAI-API. Wenn Sie an den Teilen der App arbeiten, für die keine echten Antworten aus der Azure OpenAI-API erforderlich sind, können Sie die Antworten mithilfe von Dev Proxy simulieren. Mit simulierten Antworten können Sie unnötige Kosten vermeiden. Das OpenAIMockResponsePlugin verwendet ein lokales Sprachmodell, das auf Ollama ausgeführt wird, um Antworten aus der Azure OpenAI-API zu simulieren.

Vor der Installation

Um Azure OpenAI-API-Antworten mit Dev Proxy zu simulieren, benötigen Sie Ollama auf Ihrem Computer installiert. Um Ollama zu installieren, befolgen Sie die Anweisungen in der Ollama-Dokumentation.

Standardmäßig verwendet Dev Proxy das phi-3-Sprachmodell. Um ein anderes Modell zu verwenden, aktualisieren Sie die model Eigenschaft in der Dev Proxy-Konfigurationsdatei.

Konfigurieren von Dev Proxy zum Simulieren von Azure OpenAI-API-Antworten

Tipp

Die in diesem Lernprogramm beschriebenen Schritte sind in einer einsatzbereiten Dev-Proxyvoreinstellung verfügbar. Um die Voreinstellung zu verwenden, führen Sie in der Befehlszeile die devproxy preset get simulate-azure-openaiAnweisungen aus, und folgen Sie den Anweisungen.

Um Azure OpenAI-API-Antworten mit Dev Proxy zu simulieren, müssen Sie die OpenAIMockResponsePlugin devproxyrc.json Datei aktivieren.

{

"$schema": "https://raw.githubusercontent.com/microsoft/dev-proxy/main/schemas/v0.19.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/dev-proxy-plugins.dll"

}

]

}

Konfigurieren Sie als Nächstes Dev Proxy, um Anforderungen an die Azure OpenAI-API abzufangen. Verwenden Sie aus Gründen der Einfachheit Wildcards, um Anforderungen an alle Bereitstellungen abzufangen.

{

// [...] trimmed for brevity

"urlsToWatch": [

"https://*.openai.azure.com/openai/deployments/*/completions*"

]

}

Konfigurieren Sie schließlich Dev Proxy für die Verwendung eines lokalen Sprachmodells.

{

// [...] trimmed for brevity

"languageModel": {

"enabled": true

}

}

Die vollständige Konfigurationsdatei sieht wie folgt aus.

{

"$schema": "https://raw.githubusercontent.com/microsoft/dev-proxy/main/schemas/v0.19.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/dev-proxy-plugins.dll"

}

],

"urlsToWatch": [

"https://*.openai.azure.com/openai/deployments/*/completions*"

],

"languageModel": {

"enabled": true

}

}

Simulieren von Azure OpenAI-API-Antworten

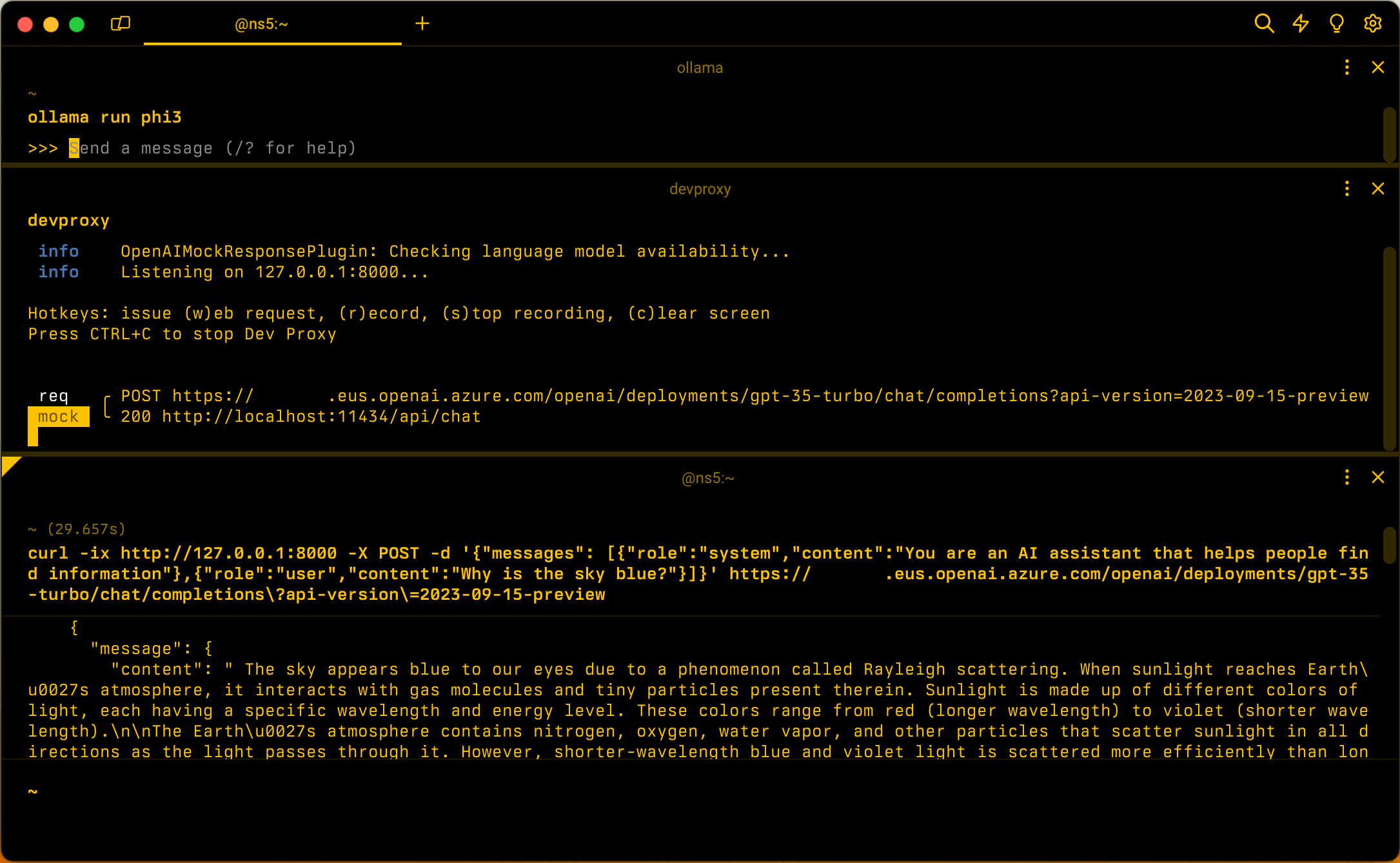

Starten Sie Ollama mit dem phi-3-Sprachmodell. Führen Sie in der Befehlszeile den Befehl aus ollama run phi3.

Starten Sie als Nächstes Dev Proxy. Wenn Sie die Voreinstellung verwenden, führen Sie sie aus devproxy -c "~appFolder/presets/simulate-azure-openai/simulate-azure-openai.json. Wenn Sie eine benutzerdefinierte Konfigurationsdatei mit dem Namen devproxyrc.jsonverwenden, die im aktuellen Arbeitsverzeichnis gespeichert ist, führen Sie die Datei aus devproxy. Dev Proxy überprüft, ob er auf das Ollama-Sprachmodell zugreifen kann, und bestätigt, dass er bereit ist, Azure OpenAI-API-Antworten zu simulieren.

info OpenAIMockResponsePlugin: Checking language model availability...

info Listening on 127.0.0.1:8000...

Hotkeys: issue (w)eb request, (r)ecord, (s)top recording, (c)lear screen

Press CTRL+C to stop Dev Proxy

Führen Sie Ihre Anwendung aus, und stellen Sie Anforderungen an die Azure OpenAI-API. Dev Proxy fängt die Anforderungen ab und simuliert Antworten mithilfe des lokalen Sprachmodells.

Nächster Schritt

Erfahren Sie mehr über das OpenAIMockResponsePlugin.

Beispiele

Siehe auch die zugehörigen Dev Proxy-Beispiele: