Was ist Data Factory in Microsoft Fabric?

Data Factory ermöglicht Ihnen eine moderne Datenintegrationsumgebung zum Erfassen, Vorbereiten und Transformieren von Daten aus einer Vielzahl von Datenquellen (z. B. Datenbanken, Data Warehouses, Lakehouses, Echtzeitdaten usw.). Unabhängig davon, ob Sie ein normaler Benutzer oder ein professioneller Entwickler sind, können Sie die Daten mit intelligenten Transformationen transformieren und eine Vielzahl von Aktivitäten nutzen. Wir können Pipelines erstellen, um eine oder mehrere Aktivitäten auszuführen, über Verbindungen auf Datenquellen oder Dienste zuzugreifen, und nach dem Erstellen einer Pipeline können wir Trigger hinzufügen, um unsere Prozesse zu bestimmten Zeiten oder als Reaktion auf änderungsszenarien automatisch auszuführen. Mit Data Factory in Microsoft Fabric bieten wir Funktionen für schnelles Kopieren (Datenverschiebung) sowohl in Dataflows als auch in Datenpipelines. Mit Fast Copy können Sie Daten blitzschnell zwischen Ihren bevorzugten Datenspeichern verschieben. Am wichtigsten ist, dass Sie mit Fast Copy Daten in Ihr Lakehouse und Data Warehouse in Microsoft Fabric für Analysen übertragen können.

Data Factory implementiert zwei Hauptfunktionen auf hoher Ebene: Dataflows und Pipelines.

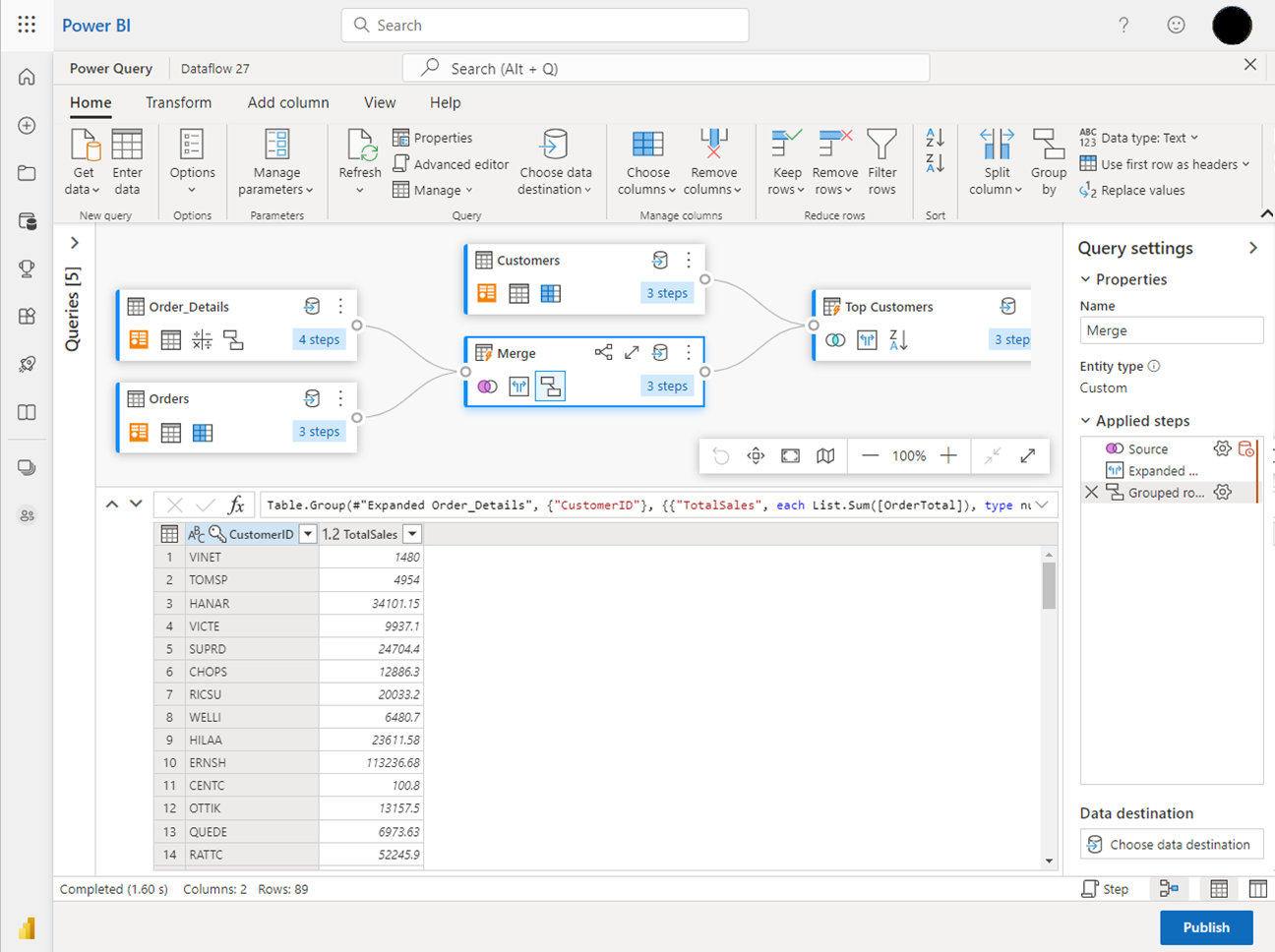

- Mit Dataflows können Sie mehr als 300 Transformationen im Dataflow-Designer nutzen, sodass Sie Daten einfacher und flexibler transformieren können als mit jedem anderen Tool – einschließlich intelligenter KI-basierter Datentransformationen.

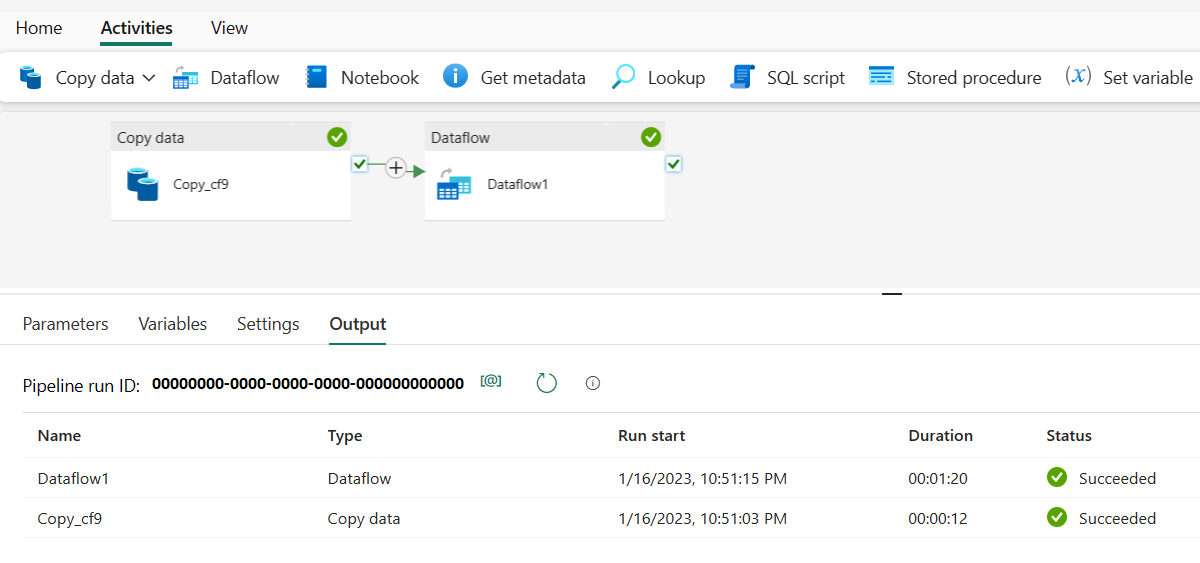

- Mit Datenpipelines können Sie die sofort einsatzbereiten umfangreichen Datenorchestrierungsfunktionen nutzen, um flexible Datenworkflows zu erstellen, die Ihren Unternehmensanforderungen entsprechen.

Dataflows

Dataflows bieten eine Schnittstelle mit wenig Code zum Erfassen von Daten aus Hunderten von Datenquellen und transformieren Ihre Daten mithilfe von mehr als 300 Datentransformationen. Anschließend können Sie die sichergebenden Daten in mehrere Ziele laden, z. B. in Azure SQL-Datenbank-Instanzen und vieles mehr. Dataflows können wiederholt mit manueller oder geplanter Aktualisierung oder als Teil einer Datenpipelineorchestrierung ausgeführt werden.

Dataflows werden mit der vertrauten Benutzeroberfläche Power Query erstellt, die heute in verschiedenen Microsoft-Produkten und -Diensten wie Excel, Power BI, Power Platform, Dynamics 365 Insights-Anwendungen und mehr verfügbar ist. Power Query ermöglicht allen Benutzer*innen, von normalen Benutzer*innen bis hin zu Profis, Datenerfassungsaktivitäten und Datentransformationen in ihrem gesamten Datenbestand durchzuführen. Führen Sie Joins, Aggregationen, Datenbereinigungen, benutzerdefinierte Transformationen und vieles mehr über eine benutzerfreundliche, hochgradig visuelle Benutzeroberfläche mit wenig Code aus.

Datenpipelines

Datenpipelines ermöglichen leistungsstarke Workflowfunktionen im Cloudmaßstab. Mit Datenpipelines können Sie komplexe Workflows erstellen, mit denen Sie Ihren Dataflow aktualisieren, Daten in PB-Größe verschieben und komplexe Ablaufsteuerungspipelines definieren können.

Verwenden Sie Datenpipelines, um komplexe ETL- und Data Factory-Workflows zu erstellen, die viele verschiedene Aufgaben im großen Stil ausführen können. Ablaufsteuerungsfunktionen sind in Datenpipelines integriert, mit denen Sie Workflowlogik erstellen können, die Schleifen und Bedingungen bereitstellt.

Fügen Sie eine konfigurationsgesteuerte Copy-Aktivität zusammen mit Ihrer Dataflowaktualisierung mit wenig Code in einer einzigen Pipeline für eine End-to-End-ETL-Datenpipeline hinzu. Sie können sogar Code-First-Aktivitäten für Spark-Notebooks, SQL-Skripts, gespeicherte Procs und mehr hinzufügen.

Zugehöriger Inhalt

Um erste Schritte mit Microsoft Fabric auszuführen, navigieren Sie zu Schnellstart: Erstellen Ihres ersten Dataflow Gen2 zum Abrufen und Transformieren von Daten.