Durchsuchen der Apache Spark-Anwendungen im Fabric-Überwachungshub

Der Überwachungshub dient als zentrales Portal zum elementübergreifenden Durchsuchen von Apache Spark-Aktivitäten. Wenn Sie sich in der Datentechnik- oder Data Science-Umgebung befinden, können Sie laufende Apache Spark-Anwendungen anzeigen, die von Notebooks, Apache Spark-Auftragsdefinitionen und Pipelines ausgelöst wurden. Außerdem können Sie Apache Spark-Anwendungen auf der Grundlage verschiedener Kriterien durchsuchen und filtern. Darüber hinaus können Sie Ihre laufenden Apache Spark-Anwendungen abbrechen und einen Drilldown durchführen, um weitere Ausführungsdetails einer Apache Spark-Anwendung anzuzeigen.

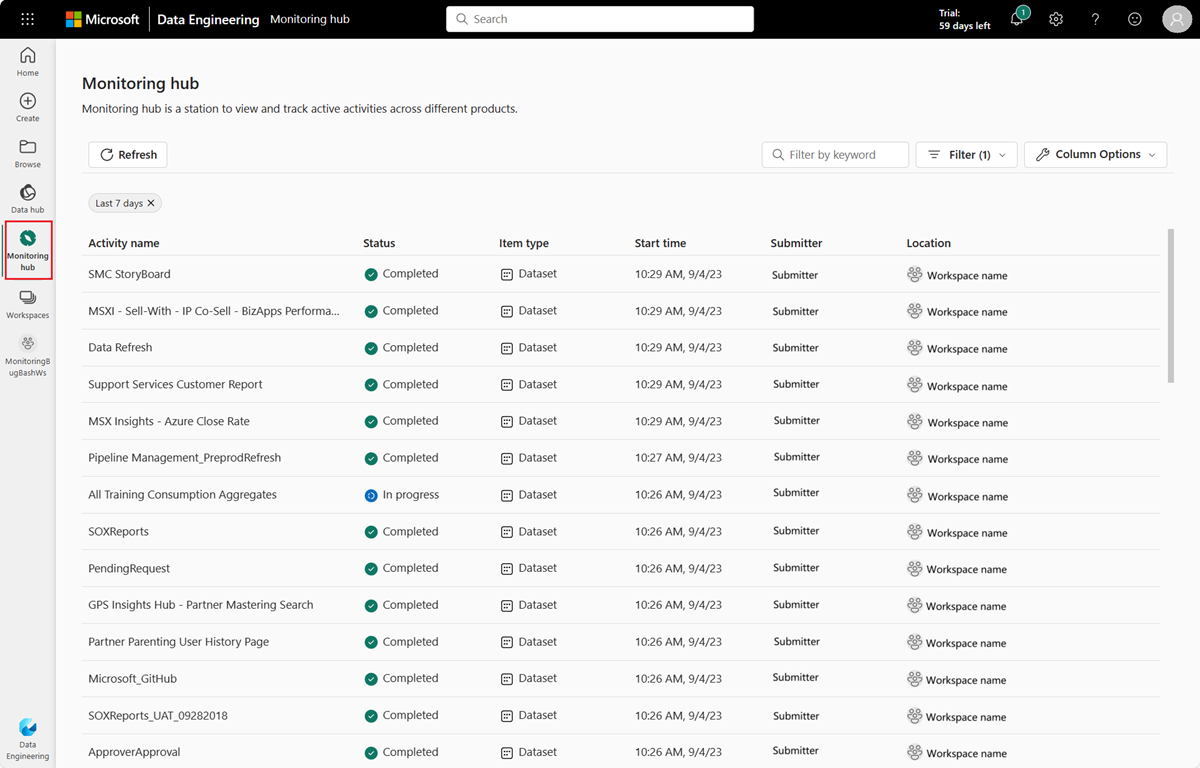

Zugreifen auf den Überwachungshub

Sie können auf den Überwachungshub zugreifen, um verschiedene Apache Spark-Aktivitäten anzuzeigen, indem Sie in den Navigationslinks auf der linken Seite Überwachungshub auswählen.

Sortier-, Such-, Filter- und Spaltenoptionen für Apache Spark-Anwendungen

Um die Benutzerfreundlichkeit und Auffindbarkeit zu verbessern, können Sie die Apache Spark-Anwendungen sortieren, indem Sie auf der Benutzeroberfläche verschiedene Spalten auswählen. Sie können die Anwendungen auch auf der Grundlage verschiedener Spalten filtern und nach bestimmten Anwendungen suchen. Sie können auch die Anzeige- und Sortierreihenfolge der Spalten unabhängig voneinander über die Spaltenoptionen anpassen.

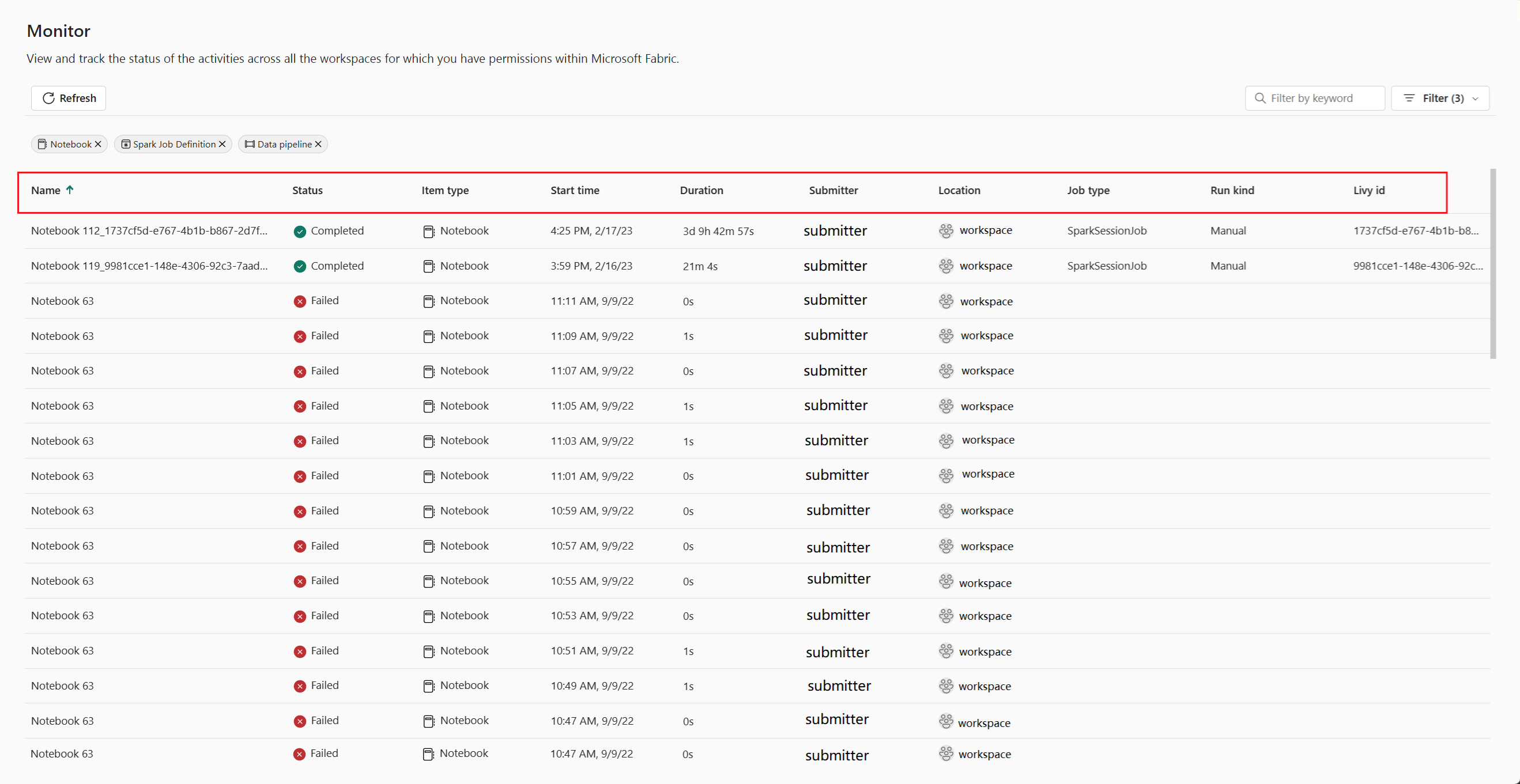

Sortieren von Apache Spark-Anwendungen

Zum Sortieren von Apache Spark-Anwendungen können Sie jede Spaltenüberschrift auswählen, z. B. Name, Status, Elementtyp, Startzeit, Speicherort usw.

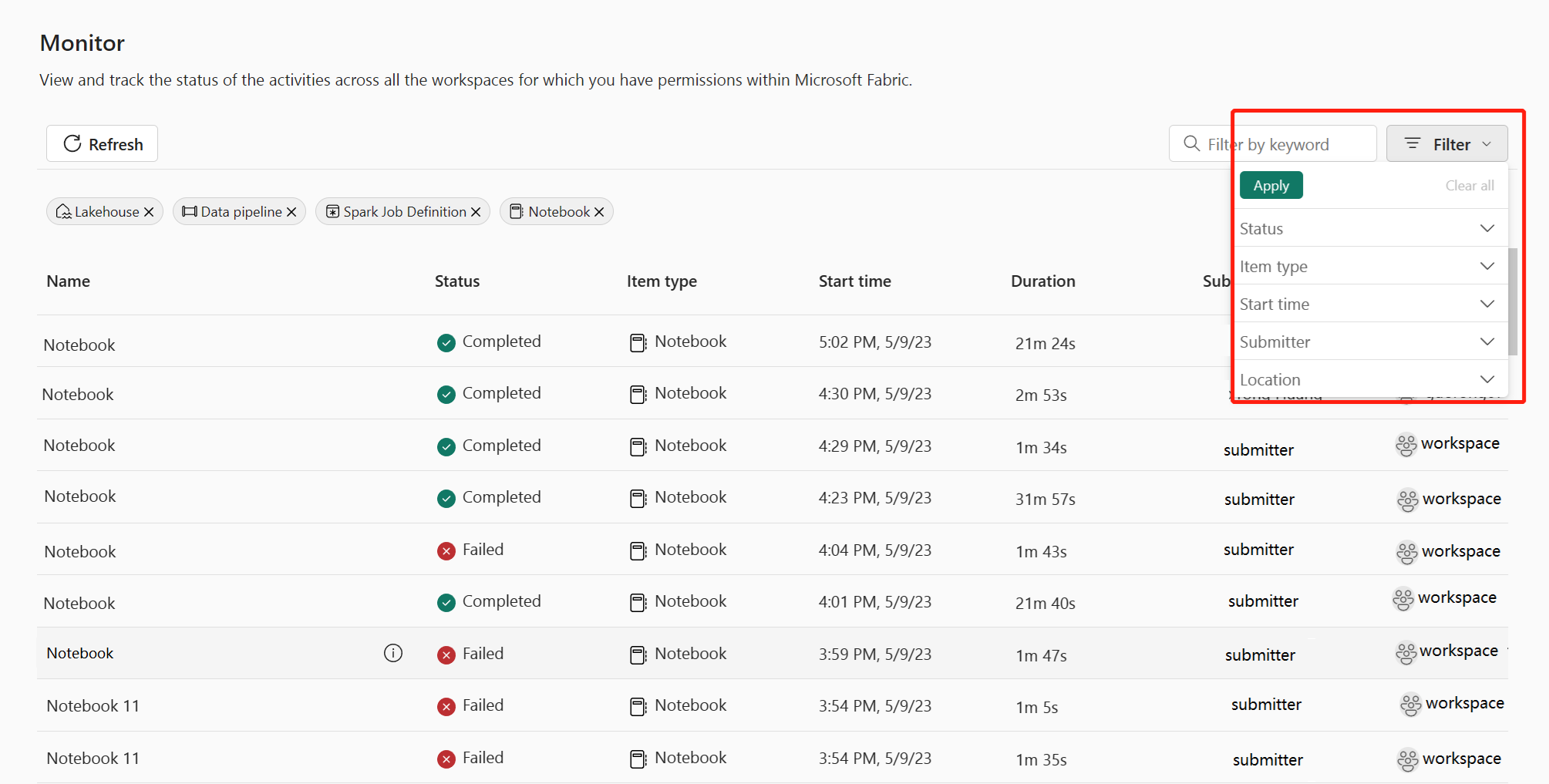

Filtern von Apache Spark-Anwendungen

Sie können Apache Spark-Anwendungen nach Status, Elementtyp, Startzeit, Übermittler und Speicherort filtern, indem Sie den Bereich „Filter“ in der oberen rechten Ecke verwenden.

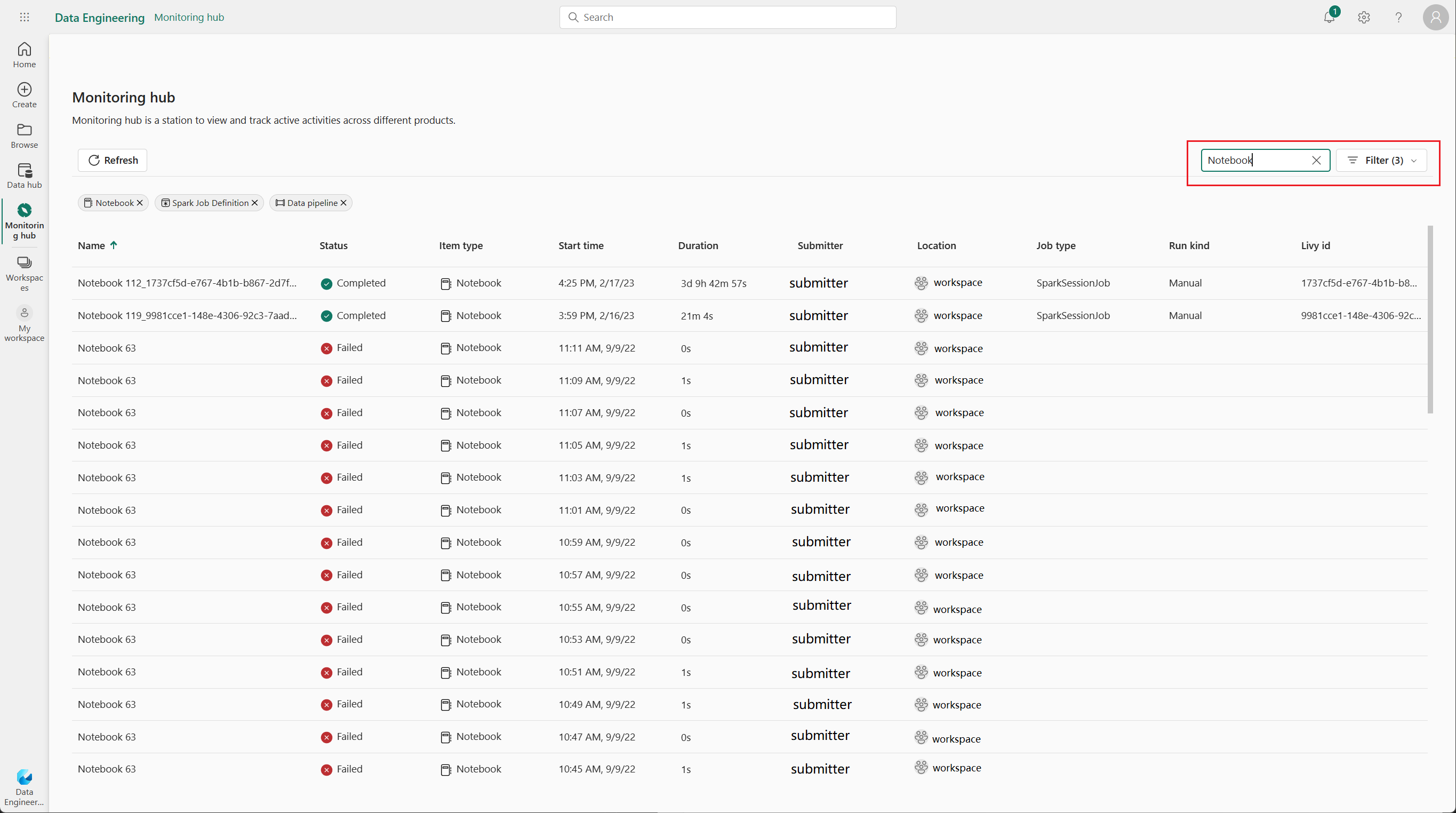

Durchsuchen von Apache Spark-Anwendungen

Um nach bestimmten Apache Spark-Anwendungen zu suchen, können Sie bestimmte Schlüsselwörter in das Suchfeld in der oberen rechten Ecke eingeben.

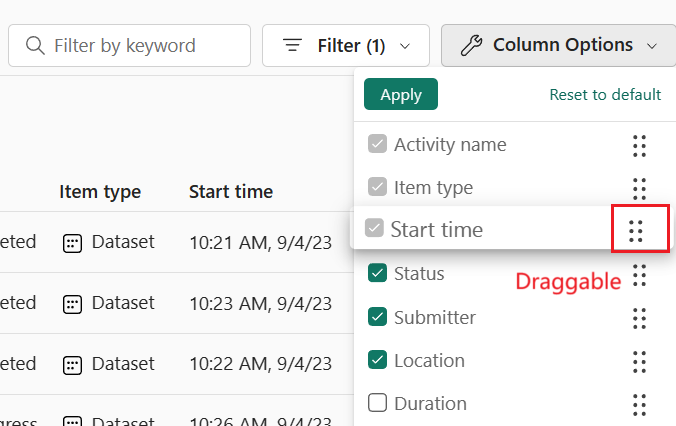

Spaltenoptionen für Apache Spark-Anwendungen

Sie können die Reihenfolge ändern, in der die Listen angezeigt werden, indem Sie die anzuzeigende Liste auswählen und dann die Listenoptionen ziehen.

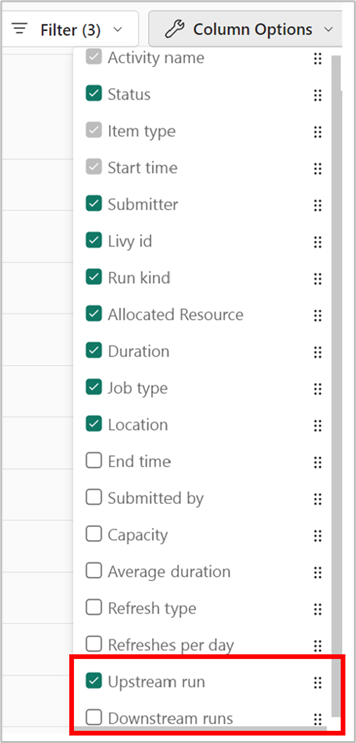

Aktivieren der Upstream-Ansicht für zugehörige Pipelines

Wenn Notebook- und Spark-Auftragsdefinitionen zur Ausführung in Pipelines geplant sind, können Sie die Spark-Aktivitäten dieser Notebooks und Spark-Auftragsdefinitionen im Überwachungshub anzeigen. Darüber hinaus können Sie auch die entsprechende übergeordnete Pipeline und alle ihre Aktivitäten im Überwachungshub anzeigen.

- Wählen Sie die Spaltenoption Upstream-Ausführung aus.

- Zeigen Sie die zugehörige übergeordnete Pipelineausführung in der Spalte Upstream-Ausführung an und klicken Sie auf die Pipelineausführung, damit alle ihre Aktivitäten angezeigt werden.

Verwalten einer Apache Spark-Anwendung

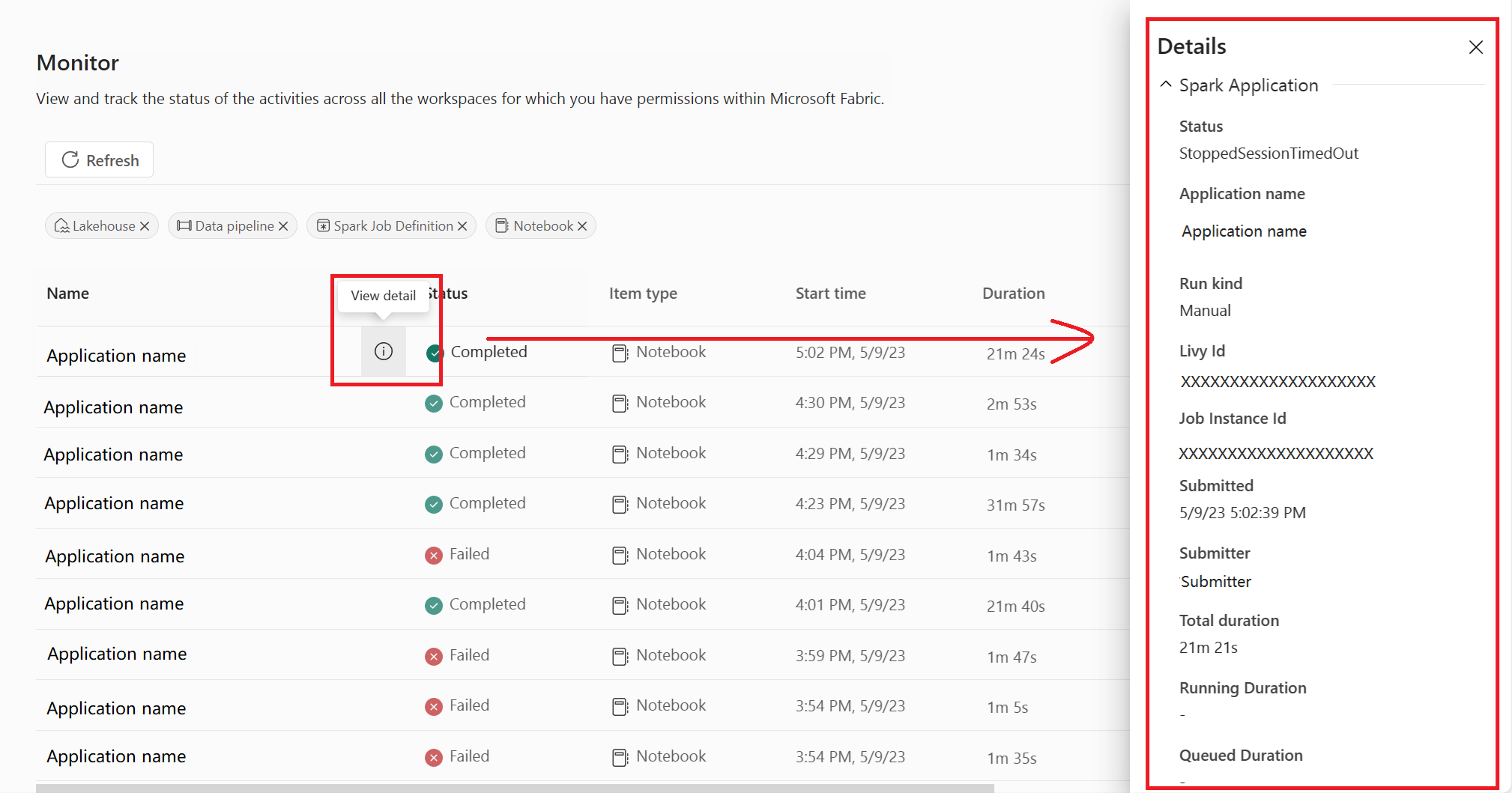

Wenn Sie mit dem Mauszeiger auf eine Apache Spark-Anwendungszeile zeigen, werden verschiedene Aktionen auf Zeilenebene angezeigt, mit denen Sie eine bestimmte Apache Spark-Anwendung verwalten können.

Anzeigen des Detailbereichs von Apache Spark-Anwendungen

Sie können mit der Maus auf eine Apache Spark-Anwendungszeile zeigen und auf das Symbol Details anzeigen klicken, um den Detailbereich zu öffnen und weitere Details zu einer Apache Spark-Anwendung anzuzeigen.

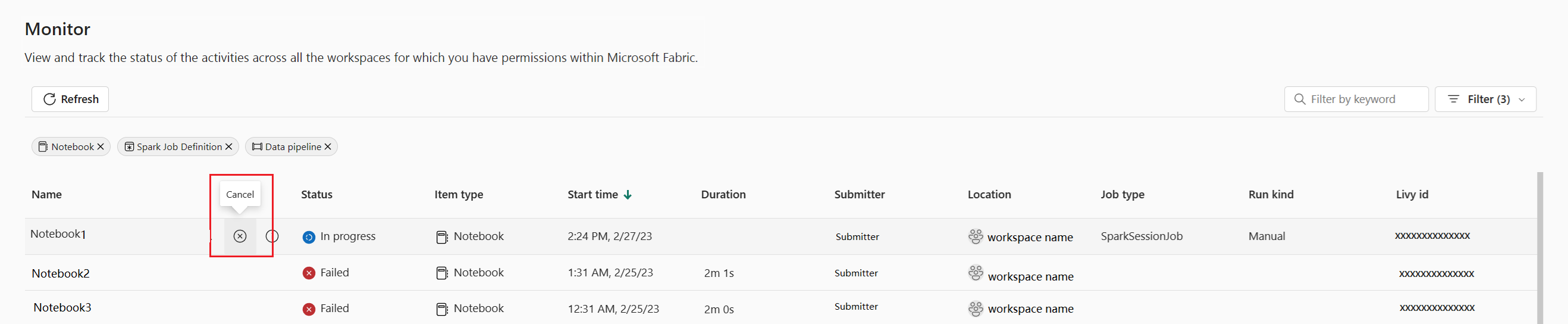

Abbrechen einer Apache Spark-Anwendung

Wenn Sie eine laufende Apache Spark-Anwendung abbrechen müssen, zeigen Sie mit der Maus auf ihre Zeile, und klicken Sie auf das Symbol Abbrechen.

Navigieren zur Anwendungsdetailansicht von Apache Spark

Wenn Sie weitere Informationen zu Apache Spark-Ausführungsstatistiken benötigen, auf Apache Spark-Protokolle zugreifen oder Eingabe- und Ausgabedaten überprüfen möchten, können Sie auf den Namen einer Apache Spark-Anwendung klicken, um zur entsprechenden Apache Spark-Anwendungsdetailseite zu navigieren.