Verantwortungsvolle KI in Azure-Workloads

Das Ziel der verantwortungsvollen KI im Workload-Design ist es, sicherzustellen, dass der Einsatz von KI-Algorithmen fair, transparent und inklusiv ist. Die Sicherheitsprinzipien von Microsoft Azure Well-Architected Framework sind miteinander verknüpft und konzentrieren sich auf Vertraulichkeit und Integrität. Sicherheitsmaßnahmen müssen eingerichtet sein, um den Datenschutz des Benutzers aufrechtzuerhalten, Daten zu schützen und die Integrität des Designs zu schützen. Das Design sollte nicht für unbeabsichtigte Zwecke missbraucht werden.

In KI-Workloads verwenden Modelle häufig undurchsichtige Logik, um Entscheidungen zu treffen. Die Benutzer sollten der Funktionalität des Systems vertrauen und sich sicher fühlen, dass Modelle diese Entscheidungen verantwortungsbewusst treffen. Inakzeptable Verhaltensweisen wie Manipulation, Inhaltstoxizität, IP-Verstöße und erstellte Reaktionen müssen verhindert werden.

Berücksichtigen Sie einen Anwendungsfall, in dem ein Medienunterhaltungsunternehmen Empfehlungen mithilfe von KI-Modellen bereitstellen möchte. Wenn das Unternehmen keine verantwortungsvolle KI und ordnungsgemäße Sicherheitsprotokolle implementiert, kann ein schlechter Akteur die Kontrolle über die Modelle übernehmen. Das Modell empfiehlt möglicherweise Inhalte, die Schaden verursachen. Für die Organisation kann dieses Verhalten zu Markenschäden, unsicheren Umgebungen und rechtlichen Problemen führen. Daher ist die Aufrechterhaltung einer angemessenen Wachsamkeit während des gesamten Lebenszyklus des Systems unerlässlich und nicht verhandelbar.

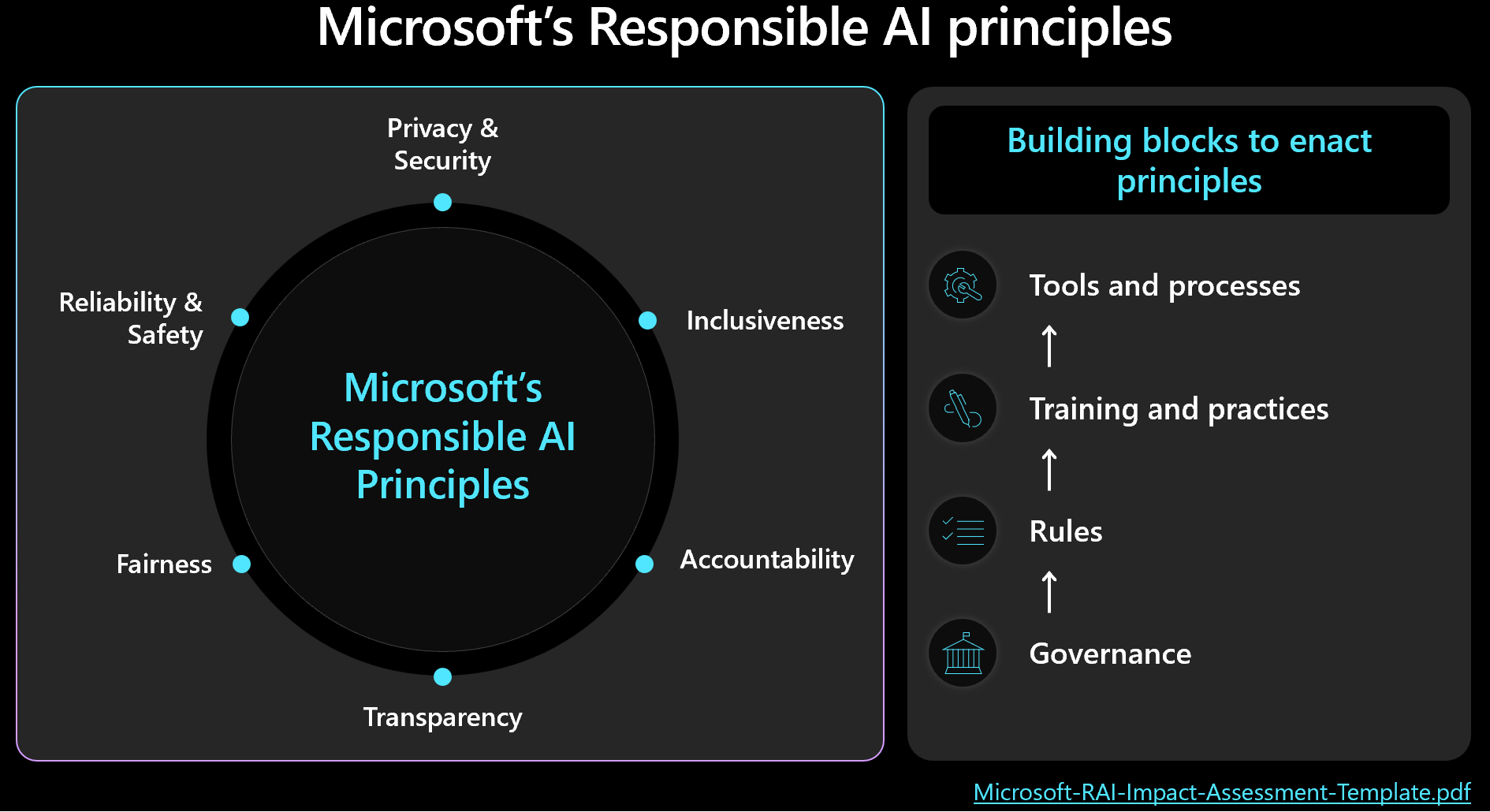

Sie sollten die Verwaltung von Sicherheit und Workload priorisieren und die menschlichen Ergebnisse berücksichtigen, wenn Sie Entwurfsentscheidungen treffen. Machen Sie sich mit dem Microsoft-Framework für verantwortungsvolle KI vertraut, und stellen Sie sicher, dass Sie die Prinzipien des Frameworks in Ihrem Design anwenden und umsetzen. Die folgende Abbildung zeigt die Kernkonzepte des Frameworks.

Wichtig

Die Genauigkeit von Vorhersagen und die Metriken für verantwortliche KI sind in der Regel miteinander verbunden. Durch die Verbesserung der Genauigkeit eines Modells können Sie seine Fairness und Ausrichtung an der Realität verbessern. Verantwortungsvolle KI richtet sich häufig an Genauigkeit, aber die Genauigkeit allein schließt nicht alle Sicherheitsaspekte ein. Es ist von entscheidender Bedeutung, diese Prinzipien verantwortungsbewusst zu überprüfen.

Dieser Artikel enthält Empfehlungen zu verantwortungsvoller Entscheidungsfindung, Überprüfung von Benutzereingaben und zur Gewährleistung einer sicheren Benutzererfahrung. Außerdem enthält sie Anleitungen zur Datensicherheit, um Benutzerdaten zu schützen.

Empfehlungen

In der folgenden Tabelle sind die Empfehlungen in diesem Artikel zusammengefasst.

| Empfehlung | Beschreibung |

|---|---|

| Entwickeln Sie Richtlinien, die moralische Praktiken in jeder Phase des Lebenszyklus durchsetzen. | Fügen Sie Checklistenelemente hinzu, die explizit Sicherheitsanforderungen angeben und auf den Workloadkontext zugeschnitten sind. Beispiele hierfür sind Transparenz der Benutzerdaten, Zustimmungskonfiguration und Verfahren zur Behandlung des Rechts auf Vergessenheit (RTBF). ▪ Entwickeln Sie Ihre Richtlinien für verantwortungsvolle KI ▪ Die Governance für Richtlinien für verantwortungsvolle KI durchsetzen |

| Schützen von Benutzerdaten mit dem Ziel, den Datenschutz zu maximieren. | Sammeln Sie nur das, was erforderlich ist und mit der richtigen Zustimmung des Benutzers. Wenden Sie technische Steuerelemente an, um die Profile von Benutzern, deren Daten und den Zugriff auf diese Daten zu schützen. ▪ Benutzerdaten angemessen behandeln ▪ Überprüfen eingehender und ausgehender Daten |

| Künstliche Intelligenz-Entscheidungen klar und verständlich halten. | Erklären Sie klar, wie Empfehlungsalgorithmen funktionieren. Bieten Sie Benutzern Einblicke in die Datennutzung und die algorithmische Entscheidungsfindung, damit sie den Prozess verstehen und vertrauen können. ▪ Sorgen Sie dafür, dass die Benutzererfahrung sicher ist |

Entwickeln von Richtlinien für verantwortungsvolle KI

Dokumentieren Sie Ihren Ansatz für die verantwortungsvolle KI-Nutzung. Geben Sie explizit Richtlinien an, die Sie in jeder Phase des Lebenszyklus anwenden, damit das Workloadteam ihre Verantwortlichkeiten versteht. Microsoft-Standards für verantwortungsvolle KI stellen Richtlinien bereit, aber Sie müssen definieren, was diese Richtlinien speziell für Ihren Kontext bedeuten.

Beispielsweise sollten die Richtlinien Prüflistenelemente für Mechanismen enthalten, die die Transparenz der Benutzerdaten und die Zustimmungskonfiguration unterstützen. Im Idealfall sollten diese Mechanismen es Benutzern ermöglichen, den Dateneinschluss abzulehnen. Datenpipelinen, Analysen, Modellschulungen und andere Phasen müssen diese Auswahl respektieren. Ein weiteres Beispiel sind Verfahren für die Behandlung von RTBF. Wenden Sie sich an die Ethikabteilung und das Rechtsteam Ihrer Organisation, um fundierte Entscheidungen zu treffen.

Erstellen Sie transparente Richtlinien für die Datennutzung und die algorithmische Entscheidungsfindung, um Den Benutzern zu helfen, den Prozess zu verstehen und zu vertrauen. Dokumentieren Sie diese Entscheidungen, um eine klare Geschichte für potenzielle zukünftige Rechtsstreitigkeiten beizubehalten.

Die verantwortungsvolle KI-Implementierung umfasst drei Schlüsselrollen: das Forschungsteam, das Richtlinienteam und das Entwicklungsteam. Die Zusammenarbeit zwischen diesen Teams sollte operationalisiert werden. Wenn Ihre Organisation über ein vorhandenes Team verfügt, verwenden Sie ihre Arbeit. Richten Sie andernfalls diese Praktiken selbst ein.

Jedes Team sollte ihre eigenen Verantwortlichkeiten haben. Zum Beispiel:

Das Forschungsteam führt Risikoermittlungen durch Beratung von Organisationsrichtlinien, Branchenstandards, Gesetzen, Vorschriften und bekannten Red-Team-Taktiken durch.

Das Richtlinienteam entwickelt Richtlinien, die für die Arbeitsauslastung spezifisch sind. Sie enthalten Richtlinien aus der übergeordneten Organisation und behördlichen Vorschriften.

Das Entwicklungsteam setzt die Richtlinien in ihre Prozesse und Ergebnisse um. Das Team überprüft und testet die Einhaltung.

Jedes Team formalisiert seine Richtlinien, aber das Workloadteam muss für seine eigenen dokumentierten Praktiken verantwortlich sein. Das Team sollte alle zusätzlichen Schritte oder absichtlichen Abweichungen eindeutig dokumentieren, um sicherzustellen, dass es keine Mehrdeutigkeit darüber gibt, was erlaubt ist. Das Team sollte auch transparent über mögliche Mängel oder unerwartete Ergebnisse in der Lösung sein.

Governance für Richtlinien für verantwortungsvolle KI durchsetzen

Entwerfen Sie Ihre Arbeitsauslastung so, dass sie die Organisations- und Regulierungsgovernance erfüllt. Wenn z. B. Transparenz eine organisationsweite Anforderung ist, bestimmen Sie, wie sie auf Ihre Arbeitsauslastung angewendet wird. Identifizieren Sie Bereiche in Ihrem Design, Lebenszyklus, Code oder anderen Komponenten, in denen Sie Transparenzfeatures einführen sollten, um diesen Standard zu erfüllen.

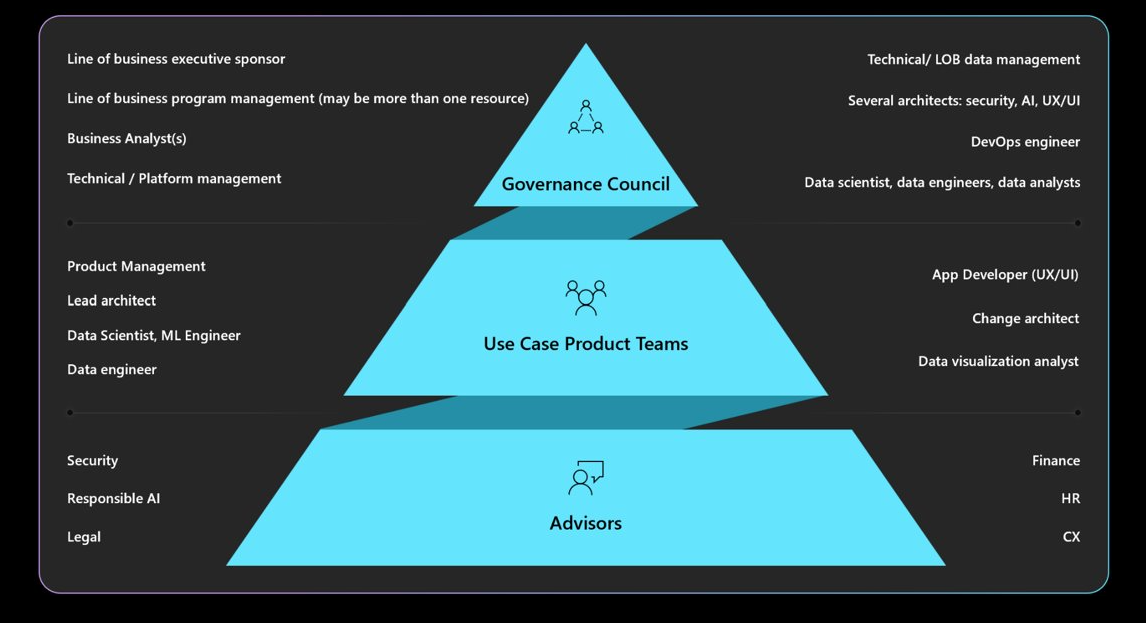

Grundlegendes zu den erforderlichen Governance-, Verantwortlichkeits-, Prüfgremien- und Berichtspflichten. Stellen Sie sicher, dass Ihr Governance-Rat die Arbeitsauslastungsdesigns genehmigt und unterzeichnet, um Neugestaltungen sowie Sicherheits- oder Datenschutzbedenken zu vermeiden. Möglicherweise müssen Sie mehrere Genehmigungsebenen durchlaufen. Das folgende Diagramm beschreibt eine typische Governancestruktur in einer Organisation.

Weitere Informationen zu Organisationsrichtlinien und Genehmigern finden Sie unter Definieren einer verantwortungsvollen KI-Strategie.

Sorgen Sie dafür, dass die Benutzererfahrung sicher ist

Benutzererfahrungen sollten auf Branchenrichtlinien basieren. Verwenden Sie die Microsoft Human-AI Experiences-Designbibliothek, die Prinzipien sowie Implementierungsrichtlinien enthält. Außerdem finden Sie Beispiele aus Microsoft-Produkten und anderen Branchenquellen.

Während des gesamten Lebenszyklus der Benutzerinteraktion bestehen Arbeitsverantwortungen. Sie beginnen mit der Absicht eines Benutzers, das System zu verwenden, und sie fahren während einer Sitzung und während jeder Unterbrechung fort, die zu Systemfehlern führen. Berücksichtigen Sie die folgenden Methoden:

Schaffen Sie Transparenz. Sorgen Sie dafür, dass Benutzer wissen, wie das System Antworten auf ihre Abfrage generiert.

Fügen Sie Links zu Datenquellen hinzu, die vom Modell für Vorhersagen verwendet werden. Diese Vorgehensweise erhöht das Vertrauen der Benutzer, indem sie die Ursprünge der Informationen anzeigen. Der Datenentwurf sollte diese Quellen in die Metadaten aufnehmen. Wenn beispielsweise der Orchestrator in einer Abruferweiterungsanwendung eine Suche durchführt, ruft er 20 Dokumentblöcke ab und sendet die obersten 10 Blöcke als Kontext an das Modell. Die obersten 10 Blöcke gehören zu drei verschiedenen Dokumenten. Die Benutzeroberfläche kann dann auf diese drei Quelldokumente verweisen, wenn sie die Antwort des Modells anzeigt. Diese Transparenz erhöht das Vertrauen der Benutzer.

Transparenz wird wichtiger, wenn Sie Agents verwenden, die als Vermittler zwischen Front-End-Schnittstellen und Back-End-Systemen fungieren. Beispielsweise interpretiert der Orchestrierungscode in einem Ticketingsystem Benutzerabsichten und führt API-Aufrufe (Application Programming Interface) an Agents aus, um erforderliche Informationen abzurufen. Wenn Sie diese Interaktionen verfügbar machen, können Sie den Benutzer auf die Aktionen des Systems aufmerksam machen.

Erstellen Sie für automatisierte Workflows, die mehrere Agents enthalten, Protokolldateien, die jeden Schritt aufzeichnen. Protokolldateien können Ihnen helfen, Fehler zu identifizieren und zu beheben. Sie geben den Benutzern auch eine Erklärung für Entscheidungen, die Transparenz operationalisieren.

Achtung

Wenn Sie Transparenzempfehlungen implementieren, vermeiden Sie es, den Benutzer mit zu viel Informationen zu überwältigen. Gehen Sie schrittweise vor, indem Sie minimal störende UI-Methoden verwenden.

Zeigen Sie beispielsweise einen Tooltip an, der eine Konfidenzbewertung aus dem Modell anzeigt. Sie können Links, z. B. Links zu Quelldokumenten, integrieren, die Benutzer für weitere Details auswählen können. Diese vom Benutzer initiierte Methode hält die Benutzeroberfläche unauffällig und ermöglicht es Benutzern, nur dann weitere Informationen abzurufen, wenn sie sich dafür entscheiden.

Sammeln Sie Feedback. Implementieren Sie Feedbackmechanismen.

Vermeiden Sie nach jeder Antwort umfassende Fragebögen, die Benutzer überwältigen. Verwenden Sie stattdessen schnelle und einfache Feedbackmechanismen, z. B. Daumen nach oben oder Daumen nach unten, oder ein Bewertungssystem für bestimmte Aspekte der Antwort auf einer Skala von 1 bis 5. Diese Methoden helfen, das System im Laufe der Zeit zu verbessern und präzises Feedback zu ermöglichen, ohne intrusiv zu sein. Berücksichtigen Sie potenzielle Fairnessprobleme im Feedback, da es möglicherweise sekundäre Gründe hinter den Antworten der Benutzer gibt.

Die Implementierung eines Feedbackmechanismus wirkt sich auf die Architektur aus, da die Datenspeicherung erforderlich ist. Behandeln Sie Feedback wie Benutzerdaten, und wenden Sie bei Bedarf Datenschutzkontrollen an.

Sammeln Sie zusätzlich zum Feedback Feedback über die Wirksamkeit der Benutzererfahrung. Sammeln Sie Metriken zur Interaktion über Ihren Monitoring Stack des Systems.

Operationalisieren von Sicherheitsmaßnahmen für Inhalte

Integrieren Sie die Inhaltssicherheit in jede Phase des KI-Lebenszyklus, indem Sie benutzerdefinierten Lösungscode, geeignete Tools und effektive Sicherheitspraktiken verwenden. Berücksichtigen Sie die folgenden Strategien:

Anonymisierte Daten. Wenn Daten von der Erfassung zur Schulung oder Auswertung übergehen, implementieren Sie unterwegs Prüfungen, um das Risiko von Lecks persönlicher Informationen zu minimieren und die Exposition von Rohdaten der Benutzer zu vermeiden.

Moderater Inhalt. Verwenden Sie die Inhaltssicherheits-API, die Anforderungen und Antworten in Echtzeit auswertet. Stellen Sie sicher, dass diese APIs erreichbar sind.

Identifizieren und Mindern von Bedrohungen. Wenden Sie bekannte Sicherheitspraktiken auf Ihre KI-Szenarien an. Führen Sie beispielsweise die Bedrohungsmodellierung durch, und dokumentieren Sie dann die Bedrohungen und wie Sie sie entschärft haben. Typische Sicherheitspraktiken wie rote Teamübungen gelten für KI-Workloads. Rote Teams können testen, ob Modelle bearbeitet werden können, um schädliche Inhalte zu generieren. Diese Aktivitäten sollten in KI-Operationen integriert werden.

Informationen finden Sie unter Planen Sie Red-Teams für große Sprachmodelle und ihre Anwendungen.

Verwenden Sie die richtigen Metriken. Verwenden Sie Metriken, die das Verhalten des Modells effektiv messen. Metriken variieren je nach Art des KI-Modells. In einigen Fällen gilt die Messung von generativen Modellen möglicherweise nicht für Regressionsmodelle. Ein Modell prognostiziert beispielsweise die Lebenserwartung, und die Ergebnisse wirken sich auf die Versicherungssätze aus. Fairnessprobleme in diesem Modell können zu fairnessbezogenen Schäden führen. Dieses Problem ergibt sich aus Abweichungen bei kernmetrischen Tests, da Fairness- und Genauigkeitsmetriken in der Regel miteinander verbunden sind. Verbessern Sie die Genauigkeit, um Schäden im Zusammenhang mit Fairness zu reduzieren.

Fügen Sie entsprechende Instrumentierung hinzu. Ki-Modellergebnisse müssen zu erklären sein. Sie müssen die Schlüsserechtfertigen und nachverfolgen, einschließlich der Schulungsdaten, der berechneten Features und der Grundlagendaten. Bei diskriminativer KI können Sie Entscheidungen schritt für Schritt rechtfertigen. Für generative Modelle kann die Erläuterung der Ergebnisse jedoch komplex sein. Dokumentieren Sie den Entscheidungsprozess , um potenzielle rechtliche Auswirkungen zu beheben und Transparenz zu schaffen.

Sie sollten diesen Erklärungsaspekt während des gesamten KI-Lebenszyklus implementieren. Datenreinigung, Linien, Auswahlkriterien und Verarbeitung sind kritische Phasen, in denen Entscheidungen nachverfolgt werden sollten.

Extras

Integrieren Sie Tools für die Sicherheit von Inhalten und die Nachverfolgbarkeit von Daten, z. B. Microsoft Purview. Azure AI Content Safety-APIs können von Ihren Tests aufgerufen werden, um Inhaltssicherheitstests zu erleichtern.

Azure AI Foundry bietet Metriken, die das Verhalten des Modells bewerten. Weitere Informationen finden Sie unter Auswertungs- und Überwachungsmetriken für generative KI.

Informationen zu Schulungsmodellen finden Sie in den Metriken, die Azure Machine Learningbereitstellt.

Überprüfen eingehender und ausgehender Daten

Eingabeaufforderungsangriffe, z. B. Jailbreaking, sind ein häufiges Problem für KI-Workloads. In diesem Fall können einige Benutzer versuchen, das Modell für unbeabsichtigte Zwecke zu missbrauchen. Um die Sicherheit zu gewährleisten, überprüfen Sie Daten, um Angriffe zu verhindern und unangemessene Inhalte herauszufiltern. Wenden Sie diese Analyse sowohl auf die Eingabe des Benutzers als auch auf die Antworten des Systems an, um eine gründliche Inhaltsmoderation in eingehenden Flüssen und ausgehenden Flüssen sicherzustellen.

In einigen Fällen müssen Sie mehrere Modellaufrufe vornehmen, z. B. über Den Azure OpenAI-Dienst, um eine einzelne Clientanforderung zu erfüllen. In diesen Szenarien kann das Anwenden von Sicherheitsüberprüfungen auf jeden Aufruf kostspielig und unnötig sein. Erwägen Sie , die Arbeit in der Architektur zu zentralisieren und gleichzeitig die Sicherheit als serverseitige Verantwortung zu behalten. Angenommen, eine Architektur verfügt über ein Gateway vor dem Modell-Inferenz-Endpunkt, um bestimmte Back-End-Funktionen auszulagern. Sie können dieses Gateway so entwerfen, dass inhaltssicherheitsprüfungen für Anforderungen und Antworten behandelt werden, die das Back-End möglicherweise nicht nativ unterstützt. Obwohl ein Gateway eine gängige Lösung ist, kann eine Orchestrierungsebene diese Aufgaben effektiv in einfacheren Architekturen verarbeiten. In beiden Fällen können Sie diese Prüfungen bei Bedarf selektiv anwenden, wodurch die Leistung und die Kosten optimiert werden.

Inspektionen sollten multimodal sein und verschiedene Formate abdecken. Wenn Sie multimodale Eingaben wie Bilder verwenden, ist es wichtig, sie auf ausgeblendete Nachrichten zu analysieren, die schädlich oder gewalttätig sein könnten. Diese Nachrichten sind möglicherweise nicht sofort sichtbar, daher ist eine sorgfältige Überprüfung erforderlich. Verwenden Sie Tools wie Inhaltssicherheits-APIs für diesen Zweck.

Um die Durchsetzung von Richtlinien zum Datenschutz und zur Datensicherheit zu unterstützen, prüfen Sie Benutzerdaten und Grunddaten auf Compliance mit Datenschutzbestimmungen. Stellen Sie sicher, dass die Daten sanitiert oder gefiltert werden, während sie über das System fließt. Beispielsweise können Daten aus früheren Kundensupport-Gesprächen als Basisdaten dienen. Diese Daten sollten vor der Wiederverwendung sanitiert werden.

Benutzerdaten angemessen behandeln

Verantwortungsvolle Praktiken beinhalten eine sorgfältige Handhabung der Benutzerdatenverwaltung. Diese Verwaltung umfasst das Wissen, wann Daten verwendet werden sollen und wann keine Benutzerdaten verwendet werden sollen.

Führen Sie Ableitungen durch, ohne Benutzerdaten weiterzugeben. Um Benutzerdaten sicher mit anderen Organisationen für Einblicke zu teilen, verwenden Sie ein Clearinghouse-Modell. In diesem Szenario stellen Organisationen Daten für einen vertrauenswürdigen Partner bereit, der das Modell mithilfe der aggregierten Daten trainiert. Dann können alle Institutionen dieses Modell verwenden und Erkenntnisse teilen, ohne einzelne Datasets offen zu legen. Das Ziel besteht darin, die Ableitungsfunktionen des Modells zu verwenden, ohne detaillierte Schulungsdaten freizuleiten.

Fördern Sie Vielfalt und Inklusivität. Wenn Benutzerdaten erforderlich sind, verwenden Sie eine breite Palette von Daten, einschließlich unterrepräsentierter Genres und Urheber, um fairnessbedingte Beeinträchtigungen zu mindern. Implementieren Sie Features, mit denen Benutzer neue und vielfältige Inhalte erkunden können. Überwachen Sie die Nutzung kontinuierlich, und passen Sie Empfehlungen an, um zu vermeiden, dass ein einzelner Inhaltstyp überrepräsentiert wird.

Respektieren Sie die RTBF. Vermeiden Sie nach Möglichkeit die Verwendung von Benutzerdaten. Tragen Sie dazu bei, die Einhaltung der RTBF zu gewährleisten, indem Sie die erforderlichen Maßnahmen ergreifen, um sicherzustellen, dass Benutzerdaten sorgfältig gelöscht werden.

Um die Compliance sicherzustellen, gibt es möglicherweise Anforderungen zum Entfernen von Benutzerdaten aus dem System. Bei kleineren Modellen können Sie Benutzerdaten entfernen, indem Sie das Modell mithilfe von Daten aktualisieren, die persönliche Informationen ausschließen. Bei größeren Modellen, die aus mehreren kleineren, unabhängig trainierten Modellen bestehen können, ist der Prozess komplexer, und die Kosten und Der Aufwand sind erheblich. Suchen Sie rechtliche und ethische Anleitungen zur Behandlung dieser Situationen und stellen Sie sicher, dass Sie die Anleitungen in Ihre Richtlinien für verantwortungsvolle KI-einschließen.

Bewahren Sie Daten verantwortungsbewusst auf. Wenn die Löschung von Daten nicht möglich ist, fordern Sie die ausdrückliche Zustimmung des Benutzers für die Datensammlung ab und stellen klare Datenschutzrichtlinien bereit. Sammeln und aufbewahren Sie Daten nur, wenn sie unbedingt erforderlich sind. Stellen Sie Vorgänge bereit, um Daten aggressiv zu entfernen, wenn sie nicht mehr benötigt werden. Löschen Sie z. B. den Chatverlauf, sobald sie praktisch sind, und anonymisieren Sie vertrauliche Daten vor der Aufbewahrung. Verwenden Sie erweiterte Verschlüsselungsmethoden für ruhende Daten.

Unterstützen Sie die Erklärbarkeit. Verfolgen Sie Entscheidungen im System, um die Erläuterungsanforderungen zu unterstützen. Entwickeln Sie klare Erläuterungen dazu, wie Empfehlungsalgorithmen funktionieren. Bieten Sie Benutzern Einblicke in die Gründe, warum ihnen bestimmte Inhalte empfohlen werden. Ziel ist es, sicherzustellen, dass KI-Workloads und ihre Ergebnisse transparent und gerechtfertigt sind, indem sie angeben, wie sie Entscheidungen treffen, welche Daten sie verwenden und wie Modelle trainiert wurden.

Verschlüsseln von Benutzerdaten. Eingabedaten müssen in jeder Phase der Datenverarbeitungspipeline verschlüsselt werden, sobald der Benutzer Daten eingibt. Diese Phasen umfassen Daten, während sie von einem Punkt zu einem anderen verschoben werden, Daten, die gespeichert sind, und Daten, die bei Bedarf abgeleitet werden. Sorgen Sie für ein Gleichgewicht zwischen Sicherheit und Funktionalität und versuchen Sie, die Daten während ihres gesamten Lebenszyklus privat zu halten.

Bereitstellen robuster Zugriffssteuerungen. Mehrere Arten von Identitäten können potenziell auf Benutzerdaten zugreifen. Implementieren Sie die rollenbasierte Zugriffssteuerung sowohl für die Steuerungsebene als auch für die Datenebene, sodass sie die Kommunikation zwischen Benutzern und Systemen abdeckt.

Sorgen Sie für eine ordnungsgemäße Benutzersegmentierung zum Schutz der Privatsphäre. Microsoft 365 Copilot kann z. B. Antworten auf der Grundlage der spezifischen Dokumente und E-Mails eines Benutzers suchen und bereitstellen und gleichzeitig sicherstellen, dass nur für diesen Benutzer relevante Inhalte zugegriffen wird.

Reduzieren Sie den Oberflächenbereich. Eine grundlegende Strategie der Well-Architected Framework Security-Säule besteht darin, die Angriffsfläche zu minimieren und Ressourcen zu härten. Sie sollten diese Strategie auf Standardmäßige Endpunktsicherheitsmethoden anwenden, indem Sie API-Endpunkte eng steuern, nur wichtige Daten verfügbar machen und überflüssige Informationen in Antworten vermeiden. Ausgewogene Gestaltungsauswahl zwischen Flexibilität und Kontrolle.

Stellen Sie sicher, dass keine anonymen Endpunkte vorhanden sind. Vermeiden Sie im Allgemeinen, den Benutzern mehr Kontrolle zu geben als nötig. In den meisten Szenarien müssen Benutzer hyperparameter außer in experimentellen Umgebungen nicht anpassen. Für typische Anwendungsfälle, z. B. die Interaktion mit einem virtuellen Agent, sollten Benutzer nur wesentliche Aspekte steuern, um die Sicherheit zu gewährleisten, indem unnötige Kontrolle eingeschränkt wird.

Weitere Informationen finden Sie unter Anwendungsdesign für AI-Workloads in Azure.