Übersicht über virtuelle Computer der HBv3-Serie

Gilt für: ✔️ Linux VMs ✔️ Windows VMs ✔️ Flexible Skalensätze ✔️ Einheitliche Skalensätze

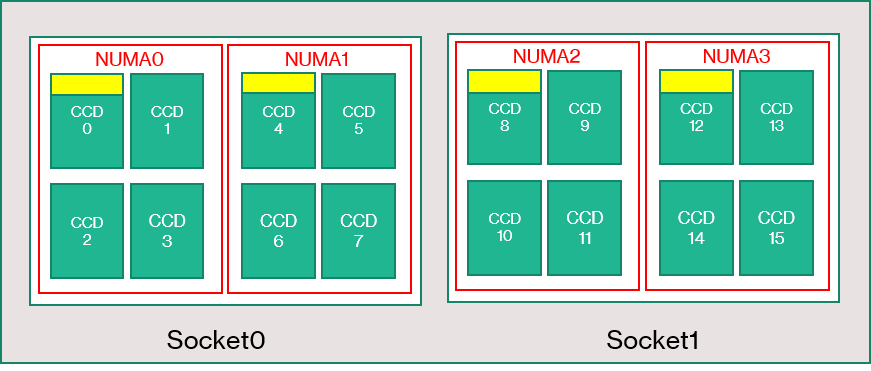

Ein Server der HBv3-Serie verfügt über 2 * 64-Core EPYC 7V73X CPUs für insgesamt 128 physische „Zen3“-Cores mit AMD 3D V-Cache. Das simultane Multithreading (SMT) ist bei HBv3 deaktiviert. Diese 128 Kerne sind in 16 Abschnitte (8 pro Socket) unterteilt, wobei jeder Abschnitt 8 Prozessorkerne mit einheitlichem Zugriff auf einen 96 MB-L3-Cache enthält. Außerdem gelten für Azure-Server der HBv3-Serie die folgenden AMD-BIOS-Einstellungen:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

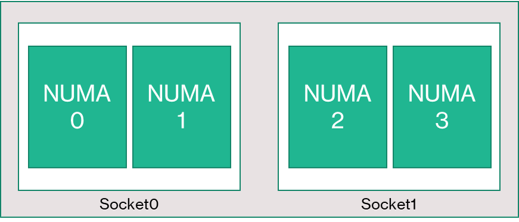

Folglich startet der Server mit vier NUMA-Domänen (2 pro Socket). Jede Domäne hat eine Größe von 32 Kernen. Jede NUMA-Domäne verfügt über direkten Zugriff auf vier Kanäle mit physischem DRAM und einer Geschwindigkeit von 3.200 MT/s.

Damit der Azure-Hypervisor über genügend Platz verfügt, um ohne Beeinträchtigung des virtuellen Computers agieren zu können, werden 8 physische Kerne pro Server reserviert.

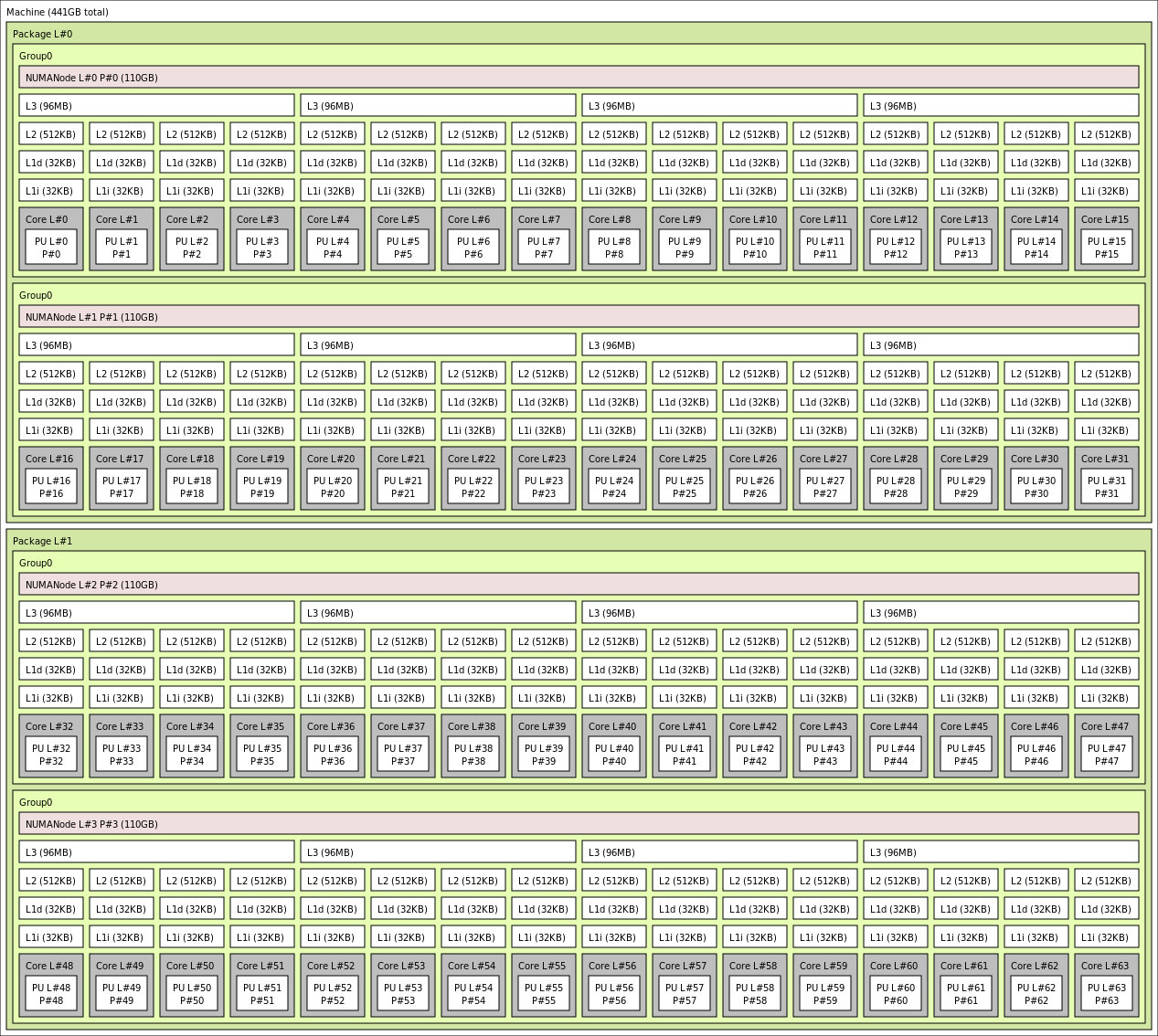

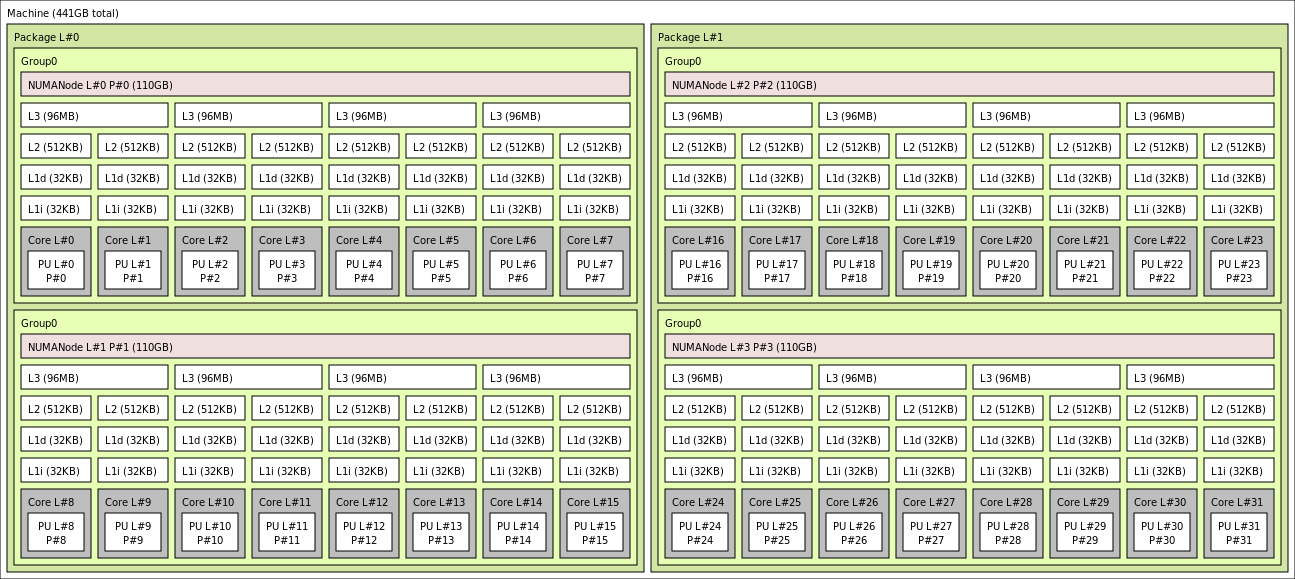

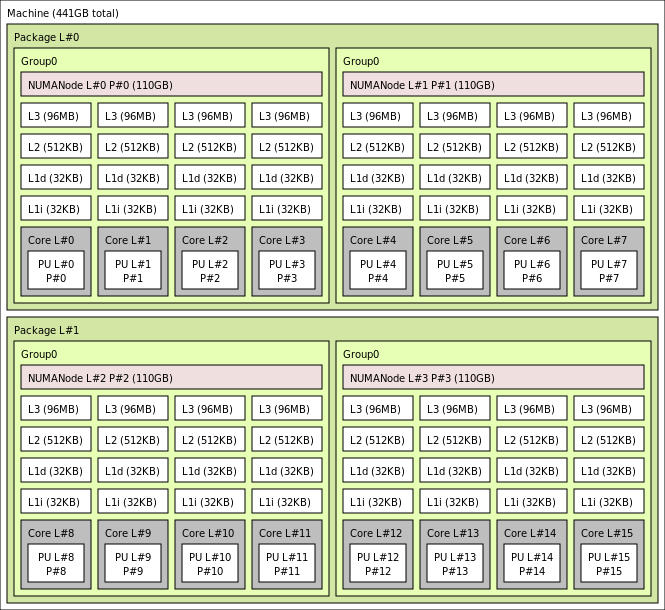

Topologie des virtuellen Computers

In der folgenden Abbildung wird die Topologie für diesen Server veranschaulicht: Wir halten diese 8 Hypervisor-Host Kerne (gelb) symmetrisch über beide CPU-Sockets hinweg frei, wobei die ersten 2 Kerne aus bestimmten Core Complex-Matrizen (CCDs) für jede NUMA-Domäne mit den verbleibenden Kernen für den virtuellen Computer der HBv3-Serie (grün) genommen werden.

Beachten Sie, dass die CCD-Grenze nicht mit einer NUMA-Grenze übereinstimmt. Auf HBv3 wird eine Gruppe von vier (4) aufeinander folgenden CCDs als NUMA-Domäne konfiguriert, sowohl auf der Hostserverebene als auch innerhalb einer Gast-VM. Daher machen alle HBv3-VM-Größen 4 NUMA-Domänen verfügbar, die einem Betriebssystem und einer Anwendung wie dargestellt angezeigt werden. 4 einheitliche NUMA-Domänen, jede mit einer unterschiedlichen Anzahl von Kernen, abhängig von der angegebenen HBv3-VM-Größe.

Jede HBv3-Größe der virtuellen Computer ähnelt dem physischen Layout, den Features und der Leistung einer anderen CPU von der AMD EPYC 7003-Serie wie folgt:

| HBv3-Serie der virtuellen Computer | NUMA-Domänen | Kerne pro NUMA-Domäne | Ähnlichkeit mit AMD EPYC |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | Dual-Socket EPYC 7773X |

| Standard_HB120-96rs_v3 | 4 | 24 | Dual-Socket EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | Dual-Socket EPYC 7573X |

| Standard_HB120-32rs_v3 | 4 | 8 | Dual-Socket EPYC 7373X |

| Standard_HB120-16rs_v3 | 4 | 4 | Dual-Socket EPYC 72F3 |

Hinweis

Bei VM-Größen mit eingeschränkten Kernen wird nur die Anzahl der physischen Kerne verringert, die für den virtuellen Computer verfügbar sind. Alle global freigegebenen Ressourcen (RAM, Arbeitsspeicher-Bandbreite, L3-Cache, GMI- und xGMI-Konnektivität, InfiniBand, Azure Ethernet-Netzwerk, lokales SSD) bleiben konstant. Dadurch können Kunden die am besten auf eine bestimmte Gruppe von Workloads oder bestimmte Softwarelizenzierungsanforderungen zugeschnittene VM-Größe auswählen.

Die virtuelle NUMA-Zuordnung der einzelnen HBv3-VM-Größen wird der zugrunde liegenden physischen NUMA-Topologie zugeordnet. Es gibt keine möglicherweise irreführende Abstraktion der Hardware-Topologie.

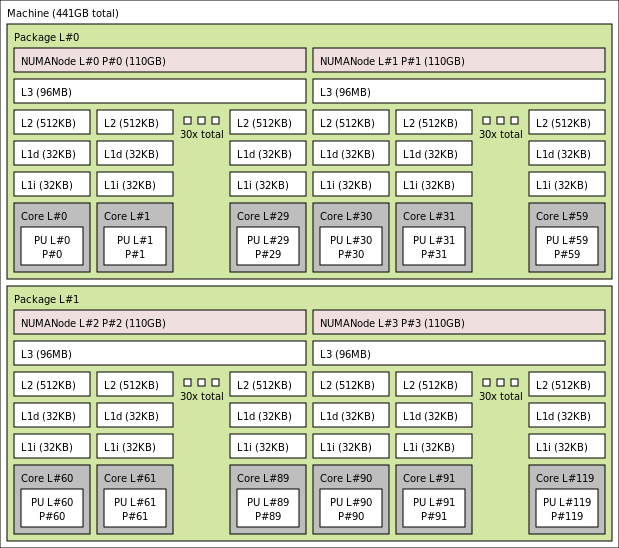

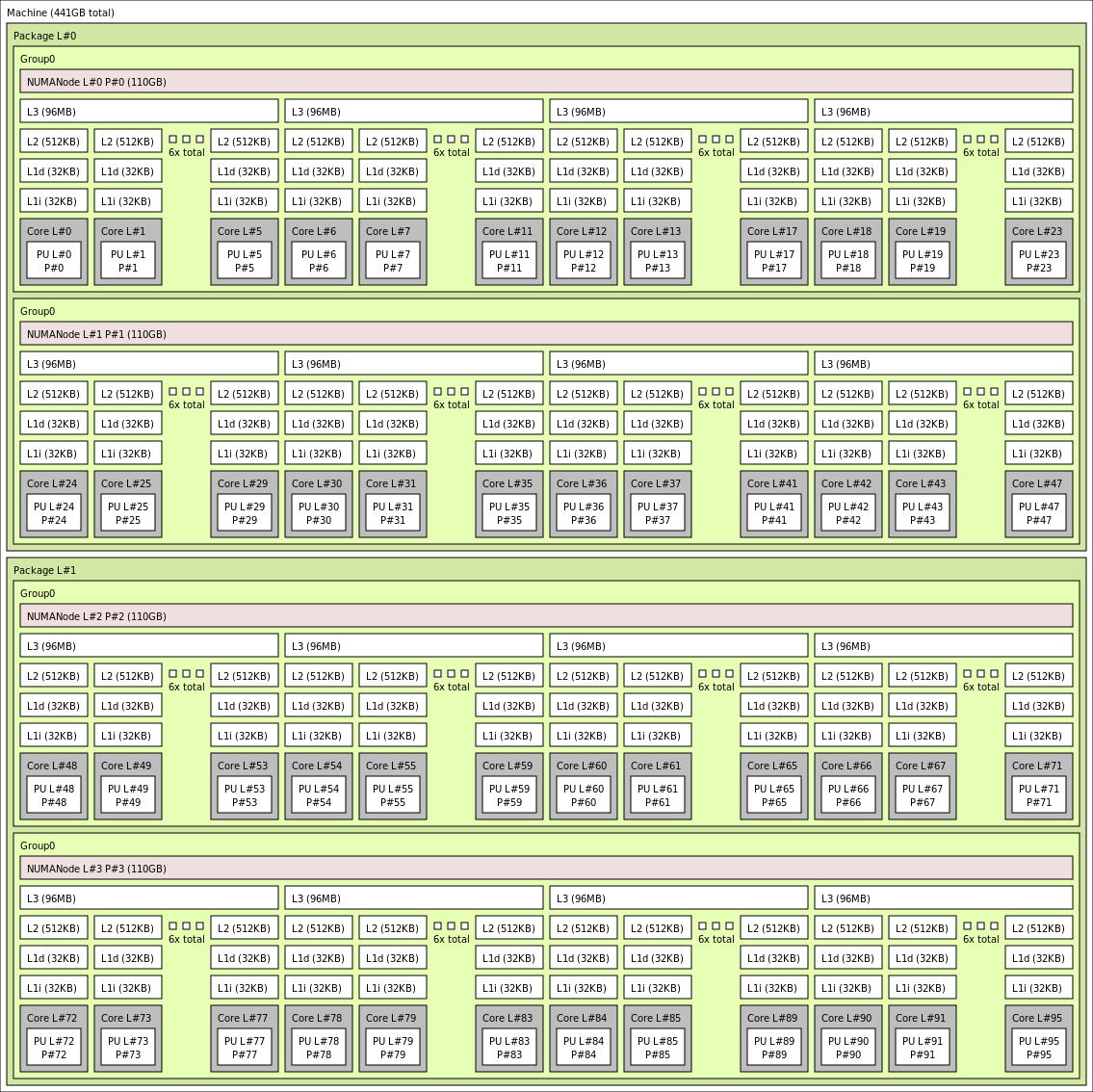

Die genaue Topologie für die verschiedenen HBv3-VM-Größen gemäß der Verwendung der Ausgabe von Istopo sieht wie folgt aus:

lstopo-no-graphics --no-io --no-legend --of txt

Klicken Sie, um die lstopo-Ausgabe für Standard_HB120rs_v3 anzuzeigen

Klicken Sie, um die lstopo-Ausgabe für Standard_HB120rs-96_v3 anzuzeigen.

Klicken Sie, um die lstopo-Ausgabe für Standard_HB120rs-64_v3 anzuzeigen.

Klicken Sie, um die lstopo-Ausgabe für Standard_HB120rs-32_v3 anzuzeigen.

Klicken Sie, um die lstopo-Ausgabe für Standard_HB120rs-16_v3 anzuzeigen.

InfiniBand-Netzwerk

HBv3-VMS verfügen auch über Nvidia Mellanox-Netzwerkadapter (ConnectX-6) mit InfiniBand (HDR) mit bis zu 200 Gigabits/Sek. Die NIC wird über SR-IOV an die VM übermittelt und ermöglicht dem Netzwerkdatenverkehr so, den Hypervisor zu umgehen. Demzufolge laden Kunden Mellanox-OFED-Standardtreiber wie eine Bare-Metal-Umgebung auf HBv3-VMs.

HBv3-VMs unterstützen adaptives Routing, DCT (Dynamic Connected Transport, zusätzlich zu RC- und UD-Standardtransporten) und die hardwarebasierte Entladung von MPI-Kollektiven auf den Onboard-Prozessor des ConnectX-6-Adapters. Diese Features verbessern die Anwendungsleistung, Skalierbarkeit und Konsistenz, und ihre Verwendung wird empfohlen.

Temporärer Speicher

HBv3-VMs verfügen über 3 physisch lokale SSD-Geräte. Ein Gerät wird vorformatiert, um als Auslagerungsdatei zu dienen, und es erscheint in Ihrer VM als generisches „SSD“-Gerät.

Zwei weitere größere SSDs werden als unformatierte NVMe-Blockgeräte über NVMeDirect bereitgestellt. Da das NVMe-Blockgerät den Hypervisor umgeht, weist es eine höhere Bandbreite, höheren IOPS und eine geringere Wartezeit pro IOP auf.

Bei einer Kombination in einem verteilten Array bietet das NVMe-SSD-Gerät bis zu 7 GB/s für Lesevorgänge und 3 GB/s für Schreibvorgänge sowie 186.000 IOPS (Lesevorgänge) und 201.000 IOPS (Schreibvorgänge) für große Warteschlangentiefen.

Hardwarespezifikationen

| Hardwarespezifikationen | VMs der HBv3-Serie |

|---|---|

| Kerne | 120, 96, 64, 32 oder 16 (SMT deaktiviert) |

| CPU | AMD EPYC 7V73X |

| CPU-Frequenz (ohne AVX) | 3,0 GHz (alle Kerne), 3,5 GHz (bis zu 10 Kerne) |

| Arbeitsspeicher | 448 GB (RAM pro Kern je nach VM-Größe) |

| Lokaler Datenträger | 2 × 960 GB NVMe (Block), 480 GB SSD (Auslagerungsdatei) |

| InfiniBand | 200 GB/s Mellanox ConnectX-6 HDR InfiniBand |

| Netzwerk | 50 GBit/s Ethernet (davon 40 GBit/s nutzbar); Azure-SmartNIC der zweiten Generation |

Softwarespezifikationen

| Softwarespezifikationen | VMs der HBv3-Serie |

|---|---|

| Maximale MPI-Auftragsgröße | 36 000 Kerne (300 VMs in einer einzelnen VM-Skalierungsgruppe mit singlePlacementGroup=true) |

| MPI-Unterstützung | HPC-X, Intel MPI, OpenMPI, MVAPICH2, MPICH |

| Zusätzliche Frameworks | UCX, libfabric und PGAS |

| Azure Storage-Unterstützung | Standard- und Premium-Datenträger (maximal 32 Datenträger) |

| Betriebssystemunterstützung für SR-IOV/RDMA | RHEL 7.9+, Ubuntu 18.04+, SLES 15.4, WinServer 2016+ |

| Empfohlenes Betriebssystem für die Leistung | Windows Server 2019 und höher |

| Orchestratorunterstützung | Azure CycleCloud, Azure Batch, AKS; Cluster-Konfigurationsoptionen |

Hinweis

Windows Server 2012 R2 wird auf HBv3 und anderen VMs mit mehr als 64 (virtuellen oder physischen) Kernen nicht unterstützt. Weitere Informationen finden Sie unter Unterstützte Windows-Gastbetriebssysteme für Hyper-V in Windows Server.

Wichtig

Dieses Dokument verweist auf eine Releaseversion von Linux, die sich dem Ende des Lebenszyklus (End of Life, EOL) nähert oder es erreicht hat. Erwägen Sie ein Update auf eine aktuellere Version.

Nächste Schritte

- Informieren Sie sich über die neuesten Ankündigungen, HPC-Workloadbeispiele und Leistungsergebnisse in den Tech Community-Blogs zu Azure Compute.

- Eine allgemeinere Übersicht über die Architektur für die Ausführung von HPC-Workloads finden Sie unter High Performance Computing (HPC) in Azure.