Schnellstart: Erstellen eines serverlosen Apache Spark-Pools mithilfe von Synapse Studio

Azure Synapse Analytics beinhaltet verschiedene Analysemodule, mit denen Sie Ihre Daten erfassen, transformieren, modellieren, analysieren und bereitstellen können. Ein Apache Spark-Pool bietet Open-Source-Computefunktionen für Big Data. Nachdem Sie einen Apache Spark-Pool in Ihrem Synapse-Arbeitsbereich erstellen, können Daten geladen, modelliert, verarbeitet und bereitgestellt werden, um Erkenntnisse zu gewinnen.

In dieser Schnellstartanleitung werden die Schritte zum Erstellen eines Apache Spark-Pools in einem Synapse-Arbeitsbereich mithilfe von Synapse Studio erläutert.

Wichtig

Die Abrechnung für Spark-Instanzen erfolgt anteilsmäßig auf Minutenbasis und ist unabhängig von der Verwendung. Fahren Sie daher Ihre Spark-Instanz herunter, wenn Sie sie nicht mehr benötigen, oder legen Sie ein kurzes Timeout fest. Weitere Informationen finden Sie im Abschnitt Bereinigen von Ressourcen in diesem Artikel.

Hinweis

Synapse Studio unterstützt weiterhin Terraform- oder Bicep-basierte Konfigurationsdateien.

Wenn Sie kein Azure-Abonnement besitzen, können Sie ein kostenloses Konto erstellen, bevor Sie beginnen.

Voraussetzungen

- Sie benötigen ein Azure-Abonnement. Erstellen Sie bei Bedarf ein kostenloses Azure-Konto

- Sie werden den Synapse-Arbeitsbereich verwenden.

Melden Sie sich beim Azure-Portal

Melden Sie sich beim Azure-Portal

Navigieren zum Synapse-Arbeitsbereich

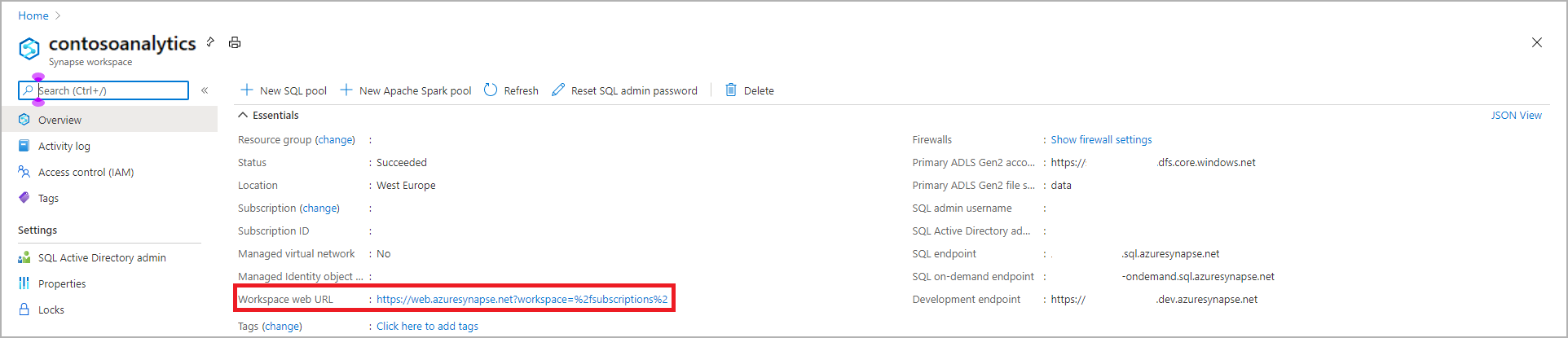

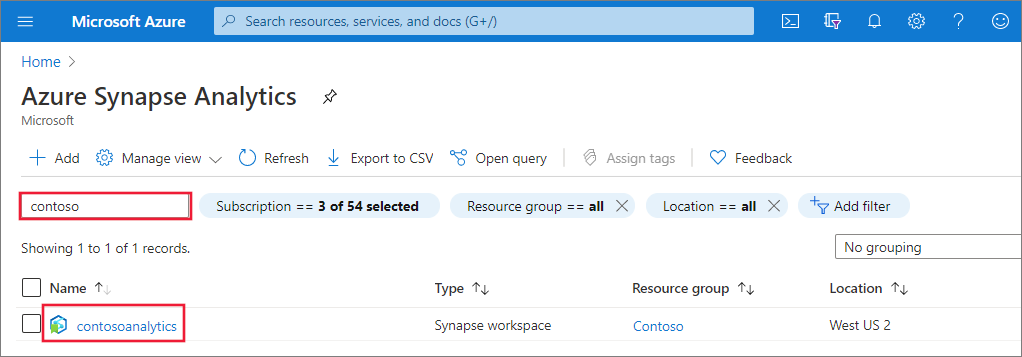

Navigieren Sie zum Synapse-Arbeitsbereich, 0in dem der Apache Spark-Pool erstellt werden soll, indem Sie den Dienstnamen (oder direkt den Ressourcennamen) in die Suchleiste eingeben.

Geben Sie in der Liste der Arbeitsbereiche den Namen (oder einen Teil des Namens) des zu öffnenden Arbeitsbereichs ein. In diesem Beispiel verwenden wir einen Arbeitsbereich namens contosoanalytics.

Starten von Synapse Studio

Wählen Sie in der Arbeitsbereichsübersicht die Web-URL für den Arbeitsbereich aus, um Synapse Studio zu öffnen.

Erstellen des Apache Spark-Pools in Synapse Studio

Wichtig

Azure Synapse-Runtime für Apache Spark 2.4 wurde veraltet und wird seit September 2023 offiziell nicht mehr unterstützt. Da für Spark 3.1 und Spark 3.2 ebenfalls das Ende des Supports angekündigt ist, empfehlen wir Kunden, zu Spark 3.3 zu migrieren.

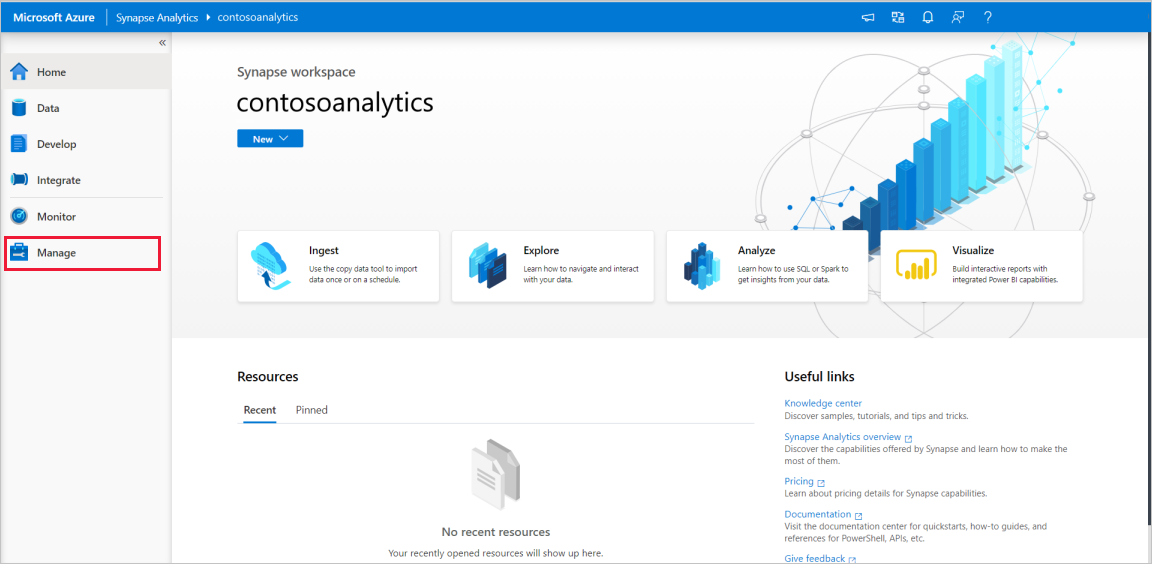

Navigieren Sie auf der Synapse Studio-Startseite im linken Navigationsbereich zum Verwaltungshub, indem Sie das Symbol Verwalten auswählen.

Navigieren Sie, nachdem Sie sich im Verwaltungshub befinden, zum Abschnitt Apache Spark-Pools, um die aktuelle Liste der Apache Spark-Pools anzuzeigen, die im Arbeitsbereich verfügbar sind.

Wählen Sie + Neu aus, und der Assistent zum Erstellen eines neuen Apache Spark-Pools wird angezeigt.

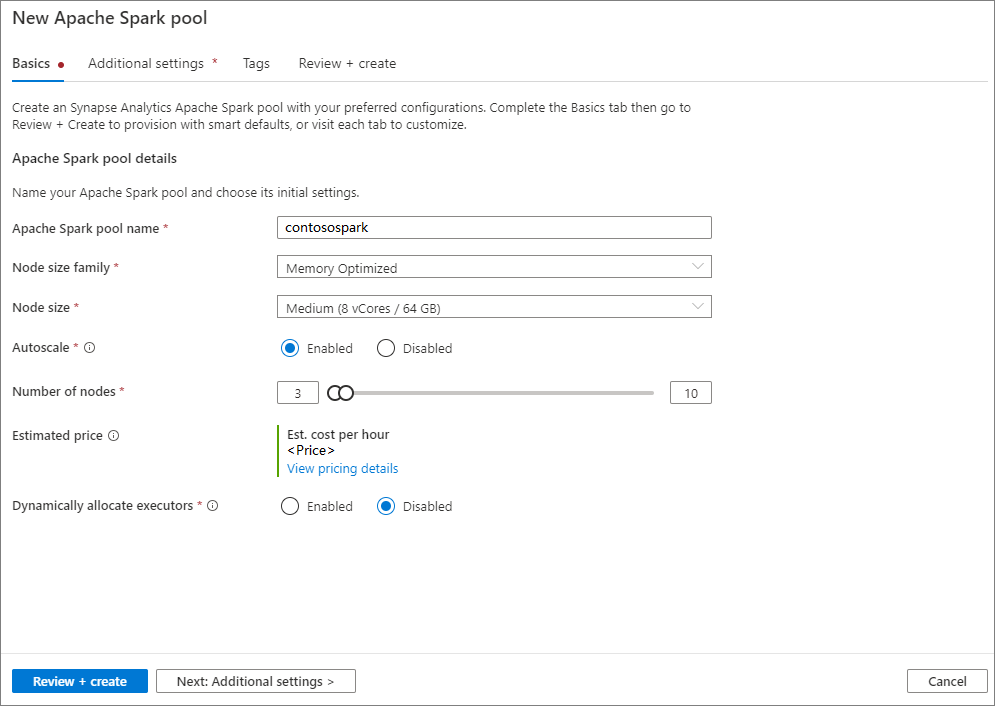

Geben Sie auf der Registerkarte Grundeinstellungen die folgenden Informationen ein:

Einstellung Vorgeschlagener Wert Beschreibung Name des Apache Spark-Pools Ein gültiger Poolname, z. B. contososparkDies ist der Name des Apache Spark-Pools. Knotengröße Klein (4 vCPUs/32 GB) Legen Sie diese Einstellung auf die kleinste Größe fest, um die Kosten für diesen Schnellstart zu senken. Automatische Skalierung Disabled Für diesen Schnellstart ist keine Autoskalierung erforderlich. Anzahl von Knoten 8 Verwenden Sie eine kleine Größe, um die Kosten in diesem Schnellstart zu begrenzen. Executors dynamisch zuordnen Disabled Diese Einstellung entspricht der dynamischen Zuordnungseigenschaft in der Spark-Konfiguration für die Executorzuteilung der Spark-Anwendung. Für diesen Schnellstart ist keine Autoskalierung erforderlich. Wichtig

Für die Namen, die Apache Spark-Pools verwendet können, gelten bestimmte Einschränkungen. Namen dürfen nur Buchstaben oder Ziffern enthalten und höchstens 15 Zeichen lang sein, müssen mit einem Buchstaben beginnen, dürfen keine reservierten Wörter enthalten und müssen im Arbeitsbereich eindeutig sein.

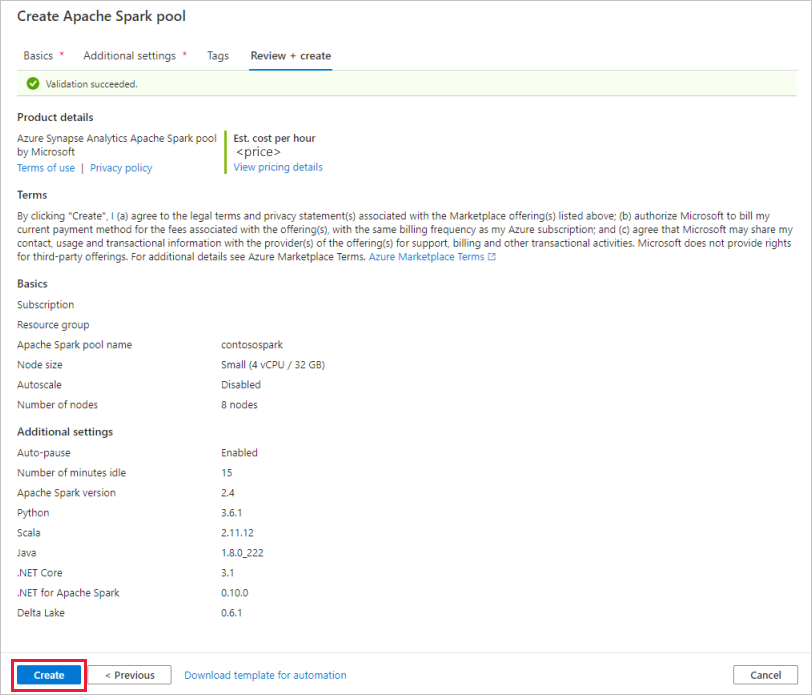

Belassen Sie auf der nächsten Registerkarte Zusätzliche Einstellungen alle Einstellungen auf den Standardwerten.

Wählen Sie Tags aus. Erwägen Sie die Verwendung von Azure-Tags. Beispielsweise das Tag „Owner“ oder „CreatedBy“, um zu identifizieren, wer die Ressource erstellt hat, und das Tag „Environment“, um zu identifizieren, ob sich diese Ressource in Produktion, Entwicklung usw. befindet. Weitere Informationen finden Sie unter Entwickeln Ihrer Benennungs- und Kennzeichnungsstrategie für Azure-Ressourcen. Wenn Sie bereit sind, wählen Sie Überprüfen + Erstellen aus.

Vergewissern Sie sich auf der Grundlage der vorherigen Eingaben auf der Registerkarte Überprüfen + erstellen, dass die Details korrekt sind, und klicken Sie auf Erstellen.

Der Apache Spark-Pool startet den Bereitstellungsprozess.

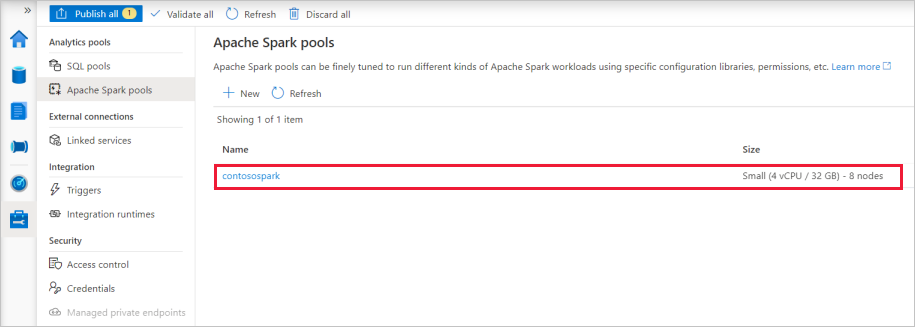

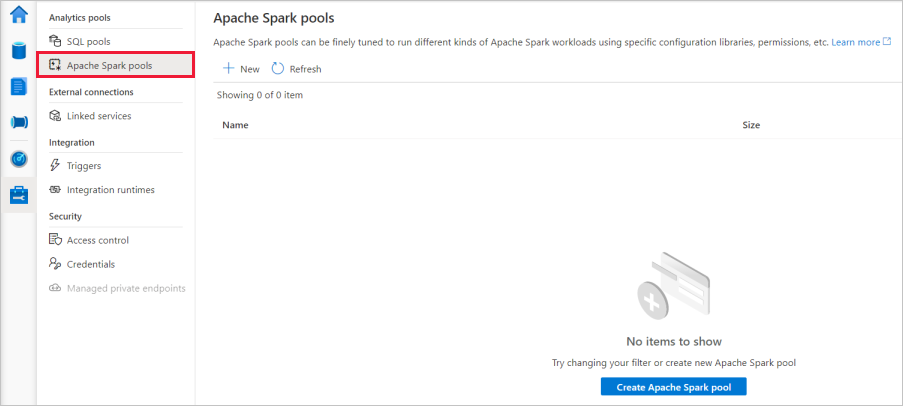

Nachdem die Bereitstellung abgeschlossen wurde, wird der neue Apache Spark-Pool in der Liste angezeigt.

Bereinigen von Apache Spark-Poolressourcen mithilfe von Synapse Studio

Die folgenden Schritte löschen den Apache Spark-Pool mithilfe von Synapse Studio aus dem Arbeitsbereich.

Warnung

Wenn Sie einen Spark-Pool löschen, wird die Analyse-Engine aus dem Arbeitsbereich entfernt. Sie können keine Verbindung mehr mit dem Pool herstellen, und Abfragen, Pipelines und Notebooks, die diesen Spark-Pool verwenden, funktionieren nicht mehr.

Wenn Sie den Apache Spark-Pool löschen wollen, führen Sie die folgenden Schritte aus:

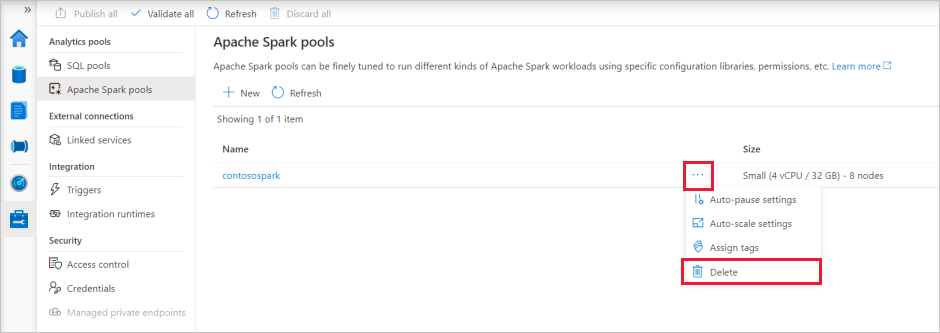

Navigieren Sie zu den Apache Spark-Pools im Verwaltungshub in Synapse Studio.

Wählen Sie das Auslassungszeichen (drei Punkte) neben dem zu löschenden Apache Spark-Pool aus (in diesem Fall contosospark), um die Befehle für den Apache Spark-Pool anzuzeigen.

Klicken Sie auf Löschen.

Bestätigen Sie den Löschvorgang, und klicken Sie auf die Schaltfläche Löschen.

Wenn der Vorgang erfolgreich abgeschlossen wurde, wird der Apache Spark-Pool nicht mehr in den Arbeitsbereichsressourcen aufgeführt.