Tools für die Migration von Netezza-Data Warehouses zu Azure Synapse Analytics

Dieser Artikel ist Teil sechs einer siebenteiligen Reihe, die Anleitungen zur Migration von Netezza zu Azure Synapse Analytics enthält. Schwerpunkt dieses Artikels sind bewährte Methoden für Microsoft- und Drittanbietertools.

Tools für die Data Warehouse-Migration

Die Migration Ihres vorhandenen Data Warehouse zu Azure Synapse hat folgende Vorteile:

Eine global sichere, skalierbare, kostengünstige, cloudnative analytische Datenbank mit nutzungsbasierter Zahlung.

Das umfassende analytische Ökosystem von Microsoft, das in Azure zur Verfügung steht. Dieses Ökosystem umfasst Technologien, die Ihnen dabei helfen, Ihr Data Warehouse nach der Migration zu modernisieren, und erweitert Ihre Analysemöglichkeiten, um einen Mehrwert zu erzielen.

Für die Migration Ihres vorhandenen Data Warehouse zu Azure Synapse stehen mehrere hilfreiche Tools von Microsoft und Drittanbietern zur Verfügung. In diesem Artikel werden die folgenden Arten von Tools behandelt:

Daten- und Datenbankmigrationstools von Microsoft

Data Warehouse-Automatisierungstools von Drittanbietern zum Automatisieren und Dokumentieren der Migration zu Azure Synapse

Data Warehouse-Migrationstools von Drittanbietern zum Migrieren des Schemas und der Daten zu Azure Synapse

Drittanbietertools zum Ausgleichen der SQL-Unterschiede zwischen Ihrem vorhandenen Data Warehouse-DBMS und Azure Synapse

Datenmigrationstools von Microsoft

Microsoft bietet verschiedene Tools, die Sie bei der Migration Ihres vorhandenen Data Warehouse zu Azure Synapse unterstützen. Hierzu zählen beispielsweise:

Microsoft-Dienste für die physische Datenübertragung

Microsoft-Dienste für die Datenerfassung

In den nächsten Abschnitten werden diese Tools ausführlicher behandelt.

Microsoft Azure Data Factory

Data Factory ist ein vollständig verwalteter, hybrider Datenintegrationsdienst mit nutzungsbasierter Zahlung für hochgradig skalierbare ETL- und ELT-Verarbeitungen. Von diesem Dienst wird Apache Spark dazu verwendet, die Daten parallel und im Arbeitsspeicher zu verarbeiten und zu analysieren und so den Durchsatz zu maximieren.

Tipp

Data Factory ermöglicht die Erstellung skalierbarer Datenintegrationspipelines ohne Code.

Data Factory-Connectors unterstützen Verbindungen mit externen Datenquellen und Datenbanken und verfügen über Vorlagen für gängige Datenintegrationsaufgaben. Dank eines visuellen Front-Ends in Form einer browserbasierten Benutzeroberfläche können Benutzer ohne Programmiererfahrung Pipelines zum Erfassen, Transformieren und Laden von Daten erstellen und ausführen. Erfahrenere Programmierer können benutzerdefinierten Code (beispielsweise Python-Programme) integrieren.

Tipp

Data Factory ermöglicht die Zusammenarbeit von Geschäfts- und IT-Experten bei der Entwicklung.

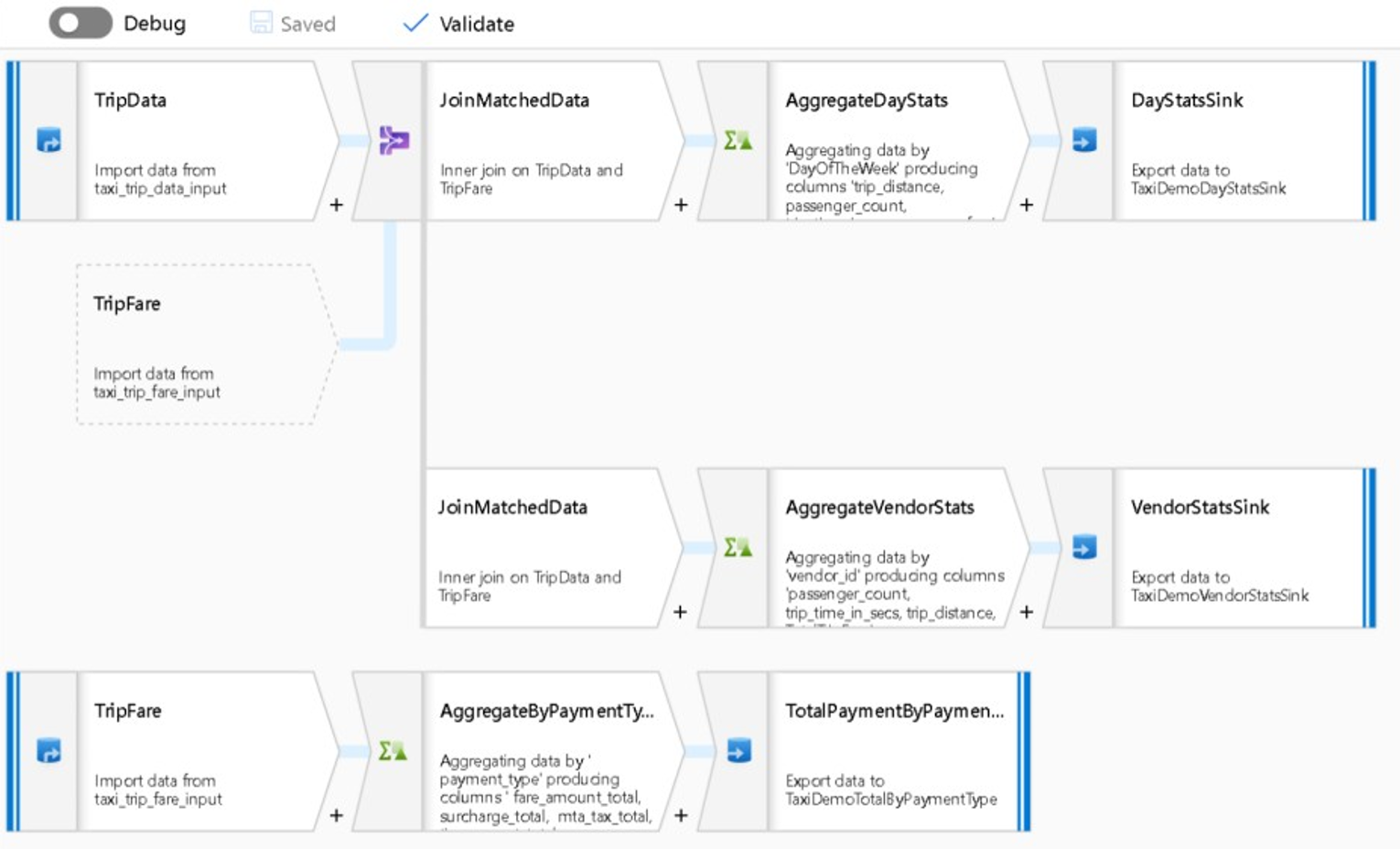

Data Factory ist auch ein Orchestrierungstool und das beste Microsoft-Tool zum Automatisieren des durchgängigen Migrationsprozesses. Durch Automatisierung werden Risiko, Aufwand und Dauer in Verbindung mit der Migration reduziert. Außerdem wird der Migrationsprozess dadurch leicht wiederholbar. Das folgende Diagramm zeigt einen Zuordnungsdatenfluss in Data Factory:

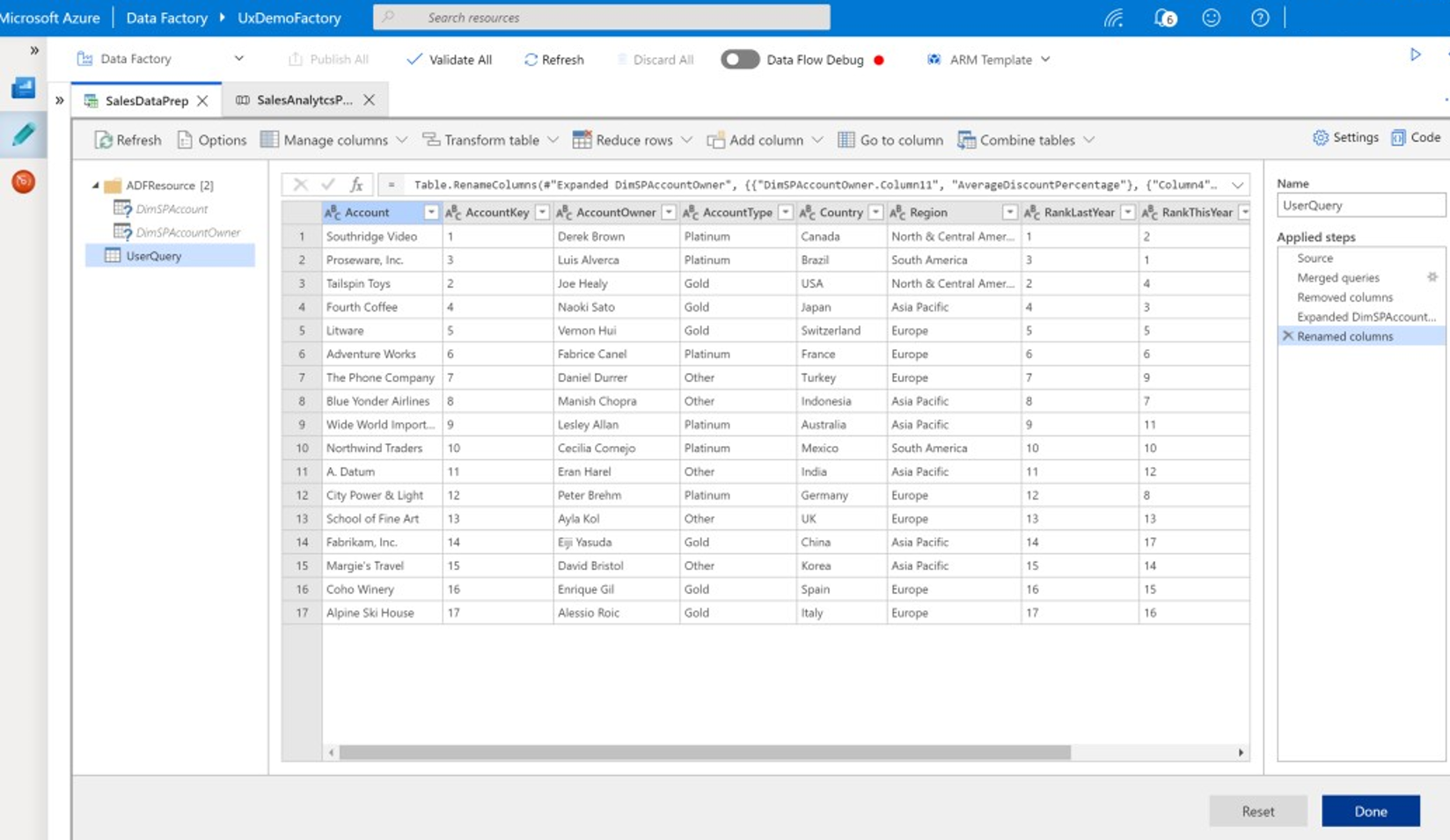

Der nächste Screenshot zeigt einen Wranglingdatenfluss in Data Factory:

In Data Factory können Sie mit wenigen Klicks und ohne Programmier- oder Wartungsaufwand einfache oder umfassende ETL- und ELT-Prozesse entwickeln. Die ETL/ELT-Prozesse beinhalten das Erfassen, Verschieben, Aufbereiten, Transformieren und Verarbeiten Ihrer Daten. Sie können in Data Factory einen Zeitplan sowie Auslöser entwerfen und verwalten, um eine Umgebung mit automatisierter Datenintegration und automatisierten Ladevorgängen zu erstellen. In Data Factory können PolyBase-Massenprozesse zum Laden von Daten definiert, verwaltet und geplant werden.

Tipp

Data Factory enthält hilfreiche Tools für die Migration Ihrer Daten und Ihres gesamten Data Warehouse zu Azure.

Sie können Data Factory verwenden, um eine hybride Umgebung mit lokalen Daten, Clouddaten, Streamingdaten und SaaS-Daten sicher und konsistent zu implementieren und zu verwalten. SaaS-Daten können aus Anwendungen wie Salesforce stammen.

Wranglingdatenflüsse sind eine neue Funktion in Data Factory. Dank dieser Funktion kann Data Factory von Benutzern aus dem Geschäftsbereich verwendet werden, die Daten visuell erkennen, erkunden und aufbereiten möchten, ohne Code zu schreiben. Diese mit Datenflüssen von Microsoft Excel, Power Query und Microsoft Power BI vergleichbaren Wranglingdatenflüsse ermöglichen Self-Service-Datenaufbereitungen. Benutzer aus dem Geschäftsbereich können Daten über eine tabellenähnliche Benutzeroberfläche mit Transformationsoptionen aus Dropdownlisten aufbereiten und integrieren.

Data Factory ist der empfohlene Ansatz für die Implementierung von Datenintegrations- und ETL-/ELT-Prozessen in der Azure Synapse-Umgebung – insbesondere, wenn Sie bereits vorhandene Legacyprozesse umgestalten möchten.

Microsoft-Dienste für die physische Datenübertragung

In den folgenden Abschnitten wird eine Reihe von Produkten und Diensten erläutert, die Microsoft anbietet, um Kunden bei der Datenübertragung zu unterstützen.

Azure ExpressRoute

Azure ExpressRoute erstellt private Verbindungen zwischen Azure-Rechenzentren und der Infrastruktur in Ihrer lokalen Umgebung oder in einer Kollokationsumgebung. ExpressRoute-Verbindungen werden nicht über das öffentliche Internet hergestellt und zeichnen sich im Vergleich zu herkömmlichen Internetverbindungen durch eine höhere Zuverlässigkeit und Geschwindigkeit sowie durch geringere Latenzen aus. In bestimmten Fällen lassen sich durch die Verwendung von ExpressRoute-Verbindungen zum Übertragen von Daten zwischen lokalen Systemen und Azure erhebliche Kosteneinsparungen erzielen.

AzCopy

AzCopy ist ein Befehlszeilenprogramm, das Dateien über eine Standardinternetverbindung in Azure Blob Storage kopiert. In einem Migrationsprojekt für Data Warehouses können Sie AzCopy verwenden, um extrahierte, komprimierte, durch Trennzeichen getrennte Textdateien hochzuladen, bevor Sie diese mithilfe von PolyBase in Azure Synapse laden. Mit AzCopy können einzelne Dateien, mehrere ausgewählte Dateien oder Dateiordner hochgeladen werden. Sollten die exportierten Dateien im Parquet-Format vorliegen, verwenden Sie stattdessen einen nativen Parquet-Leser.

Azure Data Box

Azure Data Box ist ein Microsoft-Dienst, der Ihnen ein proprietäres physisches Speichergerät bereitstellt, auf das Sie Migrationsdaten kopieren können. Anschließend senden Sie das Gerät an ein Azure-Rechenzentrum für den Datenupload in den Cloudspeicher. Dieser Dienst kann eine kosteneffiziente Option sein, wenn große Datenmengen (etwa im zwei- oder dreistelligen Terabyte-Bereich) vorliegen oder Netzwerkbandbreite nicht ohne Weiteres verfügbar ist. Azure Data Box wird in der Regel zum einmaligen Laden historischer Daten genutzt, wenn Daten zu Azure Synapse migriert werden.

Azure Data Box Gateway

Azure Data Box Gateway ist ein virtualisiertes Gatewaygerät für Cloudspeicher, das sich lokal bei Ihnen vor Ort befindet und Ihre Bilder, Medien und andere Daten an Azure sendet. Verwenden Sie Data Box-Gateway für einmalige Migrationsaufgaben oder für laufende inkrementelle Datenuploads.

Microsoft-Dienste für die Datenerfassung

In den folgenden Abschnitten werden die Produkte und Dienste erläutert, die Microsoft anbietet, um Kunden bei der Datenerfassung zu unterstützen:

COPY INTO

Die Anweisung COPY INTO bietet die größtmögliche Flexibilität für die Datenerfassung mit hohem Durchsatz in Azure Synapse. Weitere Informationen zu COPY INTO-Funktionen finden Sie unter COPY (Transact-SQL).

PolyBase

PolyBase bietet die schnellste und am besten skalierbare Methode zum Laden von Massendaten in Azure Synapse. PolyBase verwendet die MPP-Architektur (Massively Parallel Processing) von Azure Synapse zum parallelen Laden von Daten, um den bestmöglichen Durchsatz zu erzielen. Von PolyBase können Daten aus Flatfiles in Azure Blob Storage oder über Connectors direkt aus externen Datenquellen und anderen relationalen Datenbanken gelesen werden.

Tipp

PolyBase kann Daten parallel aus Azure Blob Storage in Azure Synapse laden.

PolyBase kann auch direkt aus Dateien lesen, die mit GZIP komprimiert sind. Dadurch wird das physische Volumen der Daten während des Ladevorgangs verringert. PolyBase unterstützt beliebte Datenformate wie durch Trennzeichen getrennten Text, ORC und Parquet.

Tipp

Sie können PolyBase über Data Factory im Rahmen einer Migrationspipeline aufrufen.

PolyBase ist eng in Data Factory integriert, um die schnelle Entwicklung von ETL/ELT-Prozessen zum Laden von Daten zu unterstützen. Sie können Datenladeprozesse mithilfe einer visuellen Benutzeroberfläche planen und profitieren so von höherer Produktivität und weniger Fehlern als bei handgeschriebenem Code. Microsoft empfiehlt PolyBase für die Erfassung von Daten in Azure Synapse – insbesondere bei großen Datenmengen.

Von PolyBase werden zum Laden von Daten Anweisungen vom Typ CREATE TABLE AS oder INSERT...SELECT verwendet.

CREATE TABLE AS minimiert die Protokollierung, um den höchstmöglichen Durchsatz zu erzielen. Das effizienteste Eingabeformat zum Laden von Daten sind komprimierte, durch Trennzeichen getrennte Textdateien. Teilen Sie große Eingabedateien in mehrere kleinere Dateien auf, und laden Sie sie parallel, um maximalen Durchsatz zu erzielen. Definieren Sie zum schnellstmöglichen Laden in eine Stagingtabelle die Zieltabelle als Tabelle vom Typ HEAP, und verwenden Sie die Roundrobin-Verteilung.

Für PolyBase gelten einige Einschränkungen: Die Datenzeilenlänge muss kleiner sein als 1 MB. Außerdem werden keine geschachtelten Formate mit fester Breite wie JSON und XML unterstützt.

Microsoft-Partner für Netezza-Migrationen

Microsoft-Partner bieten Tools, Dienste und Fachwissen, um Ihnen bei der Migration Ihrer lokalen Data Warehouse-Plattform zu Azure Synapse zu helfen.

Nächste Schritte

Weitere Informationen zur Implementierung moderner Data Warehouses finden Sie im nächsten Artikel dieser Reihe: Über die Netezza-Migration hinaus: Implementieren eines modernen Data Warehouse in Microsoft Azure.