Verwenden von Logstash zum Streamen von Protokollen mit Pipelinetransformationen über die auf Datensammlungsregeln basierende API

Wichtig

Datenerfassung mithilfe des Logstash-Ausgabe-Plug-Ins und von Datensammlungsregeln befindet sich zurzeit in der öffentlichen Vorschauphase. Dieses Feature wird ohne Vereinbarung zum Servicelevel bereitgestellt. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Das neue Logstash-Ausgabe-Plug-In für Microsoft Sentinel unterstützt über Datensammlungsregeln Pipelinetransformationen und eine erweiterte Konfiguration. Das Plug-In leitet beliebige Protokolltypen aus externen Datenquellen an benutzerdefinierte Tabellen oder Standardtabellen in Log Analytics oder Microsoft Sentinel weiter.

In diesem Artikel erfahren Sie, wie Sie das neue Logstash-Plug-In einrichten, um die Daten mithilfe von Datensammlungsregeln in Log Analytics oder Microsoft Sentinel zu streamen, wobei Sie die volle Kontrolle über das Ausgabeschema haben. Erfahren Sie, wie Sie das Plug-In bereitstellen.

Hinweis

Mit einer früheren Version des Logstash-Plug-Ins können Sie Datenquellen über Logstash und Datensammlungs-API miteinander verbinden.

Das neue Plug-In ermöglicht Folgendes:

- Steuern der Konfiguration der Spaltennamen und -typen

- Durchführen von Transformationen zum Zeitpunkt der Erfassung wie Filtern oder Anreichern

- Erfassen benutzerdefinierter Protokolle in einer benutzerdefinierten Tabelle oder eines Syslog-Eingabedatenstroms in der Syslog-Tabelle von Log Analytics

Die Erfassung in Standardtabellen ist nur auf Standardtabellen begrenzt, die für die Erfassung benutzerdefinierter Protokolle unterstützt werden.

Weitere Informationen zum Arbeiten mit der Logstash-Datensammlungs-Engine finden Sie unter Erste Schritte mit Logstash.

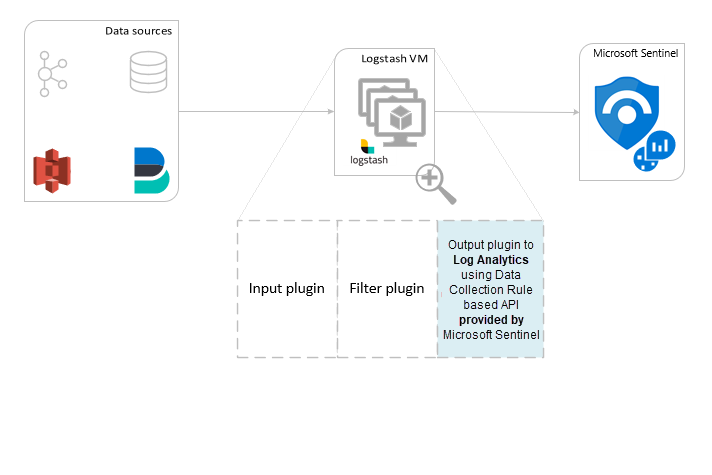

Übersicht

Architektur und Hintergrund

Die Logstash-Engine besteht aus drei Komponenten:

- Eingabe-Plug-Ins: Angepasste Sammlung von Daten aus verschiedenen Quellen.

- Filter-Plug-Ins: Bearbeitung und Normalisierung von Daten gemäß angegebener Kriterien.

- Ausgabe-Plug-Ins: Angepasstes Senden gesammelter und verarbeiteter Daten an verschiedene Ziele.

Hinweis

Microsoft unterstützt nur das von Microsoft Sentinel bereitgestellte Logstash-Ausgabe-Plug-In, das hier beschrieben wird. Das aktuelle Plug-In trägt den Namen microsoft-sentinel-log-analytics-logstash-output-plugin, v1.1.0. Für Probleme im Zusammenhang mit dem Ausgabe-Plug-In können Sie ein Supportticket erstellen.

Logstash-Ausgabe-Plug-Ins von Drittanbietern für Microsoft Sentinel, andere Logstash-Plug-Ins oder Komponenten eines anderen Typs werden von Microsoft nicht unterstützt.

Prüfen Sie die Voraussetzungen für die Unterstützung der Logstash-Version des Plug-Ins.

Das Microsoft Sentinel-Ausgabe-Plug-In für Logstash sendet JSON-formatierte Daten mithilfe der Protokollerfassungs-API von Log Analytics an Ihren Log Analytics-Arbeitsbereich. Die Daten werden in benutzerdefinierten Protokollen oder in einer Standardtabelle erfasst.

- Erfahren Sie mehr über die Protokollerfassungs-API.

Bereitstellen des Microsoft Sentinel-Ausgabe-Plug-Ins in Logstash

Führen Sie zum Einrichten des Plug-Ins die folgenden Schritte aus:

- Überprüfen der Voraussetzungen

- Installieren des Plug-Ins

- Erstellen einer Beispieldatei

- Erstellen der erforderlichen zu Datensammlungsregeln gehörigen Ressourcen

- Konfigurieren der Logstash-Konfigurationsdatei

- Neustarten von Logstash

- Anzeigen eingehender Protokolle in Microsoft Sentinel

- Überwachen der Ausgabe-Plug-In-Überwachungsprotokolle

Voraussetzungen

Installieren Sie eine unterstützte Version von Logstash. Das Plug-In unterstützt die folgenden Logstash-Versionen:

- 7.0 bis 7.17.13

- 8.0 bis 8.9

- 8.11 - 8.13

Hinweis

Wenn Sie Logstash 8 verwenden, wird empfohlen, Elastic Common Schema (ECS) in der Pipeline zu deaktivieren.

Vergewissern Sie sich, dass Sie einen Log Analytics-Arbeitsbereich und dafür mindestens Berechtigungen als Mitwirkender haben.

Vergewissern Sie sich, dass Sie über Berechtigungen zum Erstellen von Objekten für Datensammlungsregeln im Arbeitsbereich verfügen.

Installieren des Plug-Ins

Das Microsoft Sentinel-Ausgabe-Plug-In ist in der Logstash-Sammlung verfügbar.

- Befolgen Sie die Anweisungen im Logstash-Dokument zum Arbeiten mit Plug-Ins, um das Plug-In microsoft-sentinel-log-analytics-logstash-output-plugin zu installieren.

- Wenn Ihr Logstash-System keinen Internetzugriff hat, folgen Sie den Anweisungen im Logstash-Dokument zur Offline-Plug-In-Verwaltung, um ein Offline-Plug-In-Paket vorzubereiten und zu verwenden. (Dazu müssen Sie ein weiteres Logstash-System mit Internetzugriff erstellen.)

Erstellen einer Beispieldatei

In diesem Abschnitt erstellen Sie eine Beispieldatei in einem der folgenden Szenarien:

- Erstellen einer Beispieldatei für benutzerdefinierte Protokolle

- Erstellen einer Beispieldatei zum Erfassen von Protokollen in der Tabelle Syslog

Erstellen einer Beispieldatei für benutzerdefinierte Protokolle

In diesem Szenario konfigurieren Sie das Logstash-Eingabe-Plug-In für das Senden von Ereignissen an Microsoft Sentinel. In diesem Beispiel verwenden wir das Generatoreingabe-Plug-In zum Simulieren von Ereignissen. Sie können jedes andere Eingabe-Plug-In verwenden.

In diesem Beispiel sieht die Logstash-Konfigurationsdatei wie folgt aus:

input {

generator {

lines => [

"This is a test log message"

]

count => 10

}

}

Kopieren Sie die folgende Konfiguration des Ausgabe-Plug-Ins in Ihre Logstash-Konfigurationsdatei.

output { microsoft-sentinel-log-analytics-logstash-output-plugin { create_sample_file => true sample_file_path => "<enter the path to the file in which the sample data will be written>" #for example: "c:\\temp" (for windows) or "/tmp" for Linux. } }Um sicherzustellen, dass der Dateipfad, auf den verwiesen wird, vorhanden ist, ehe Sie die Beispieldatei erstellen, starten Sie Logstash.

Das Plug-In schreibt im konfigurierten Pfad zehn Datensätze in eine Beispieldatei namens

sampleFile<epoch seconds>.json. Beispiel: c:\temp\sampleFile1648453501.json. Hier sehen Sie einen Teil einer Beispieldatei, die das Plug-In erstellt:[ { "host": "logstashMachine", "sequence": 0, "message": "This is a test log message", "ls_timestamp": "2022-03-28T17:45:01.690Z", "ls_version": "1" }, { "host": "logstashMachine", "sequence": 1 ... ]Das Plug-In fügt jedem Datensatz automatisch diese Eigenschaften hinzu:

ls_timestamp: Zeitpunkt des Empfangs des Datensatzes durch das Eingabe-Plug-Inls_version: Logstash-Pipelineversion

Sie können diese Felder entfernen, wenn Sie die Datensammlungsregel erstellen.

Erstellen einer Beispieldatei zum Erfassen von Protokollen in der Tabelle Syslog

In diesem Szenario konfigurieren Sie das Logstash-Eingabe-Plug-In für das Senden von Syslog-Ereignissen an Microsoft Sentinel.

Wenn Sie noch keine Syslog-Nachrichten an Ihren Computer mit Logstash weitergeleitet haben, können Sie mit dem Befehl „logger“ Nachrichten generieren. Beispiel (für Linux):

logger -p local4.warn --rfc3164 --tcp -t CEF: "0|Microsoft|Device|cef-test|example|data|1|here is some more data for the example" -P 514 -d -n 127.0.0.1 Here is an example for the Logstash input plugin: input { syslog { port => 514 } }Kopieren Sie die folgende Konfiguration des Ausgabe-Plug-Ins in Ihre Logstash-Konfigurationsdatei.

output { microsoft-sentinel-log-analytics-logstash-output-plugin { create_sample_file => true sample_file_path => "<enter the path to the file in which the sample data will be written>" #for example: "c:\\temp" (for windows) or "/tmp" for Linux. } }Um sicherzustellen, dass der Dateipfad vorhanden ist, ehe Sie die Beispieldatei erstellen, starten Sie Logstash.

Das Plug-In schreibt im konfigurierten Pfad zehn Datensätze in eine Beispieldatei namens

sampleFile<epoch seconds>.json. Beispiel: c:\temp\sampleFile1648453501.json. Hier sehen Sie einen Teil einer Beispieldatei, die das Plug-In erstellt:[ { "logsource": "logstashMachine", "facility": 20, "severity_label": "Warning", "severity": 4, "timestamp": "Apr 7 08:26:04", "program": "CEF:", "host": "127.0.0.1", "facility_label": "local4", "priority": 164, "message": 0|Microsoft|Device|cef-test|example|data|1|here is some more data for the example", "ls_timestamp": "2022-04-07T08:26:04.000Z", "ls_version": "1" } ]Das Plug-In fügt jedem Datensatz automatisch diese Eigenschaften hinzu:

ls_timestamp: Zeitpunkt des Empfangs des Datensatzes durch das Eingabe-Plug-Inls_version: Logstash-Pipelineversion

Sie können diese Felder entfernen, wenn Sie die Datensammlungsregel erstellen.

Erstellen der erforderlichen zu Datensammlungsregeln gehörigen Ressourcen

Zum Konfigurieren des auf Datensammlungsregeln basierenden Logstash-Plug-Ins für Microsoft Sentinel müssen Sie zunächst die zu Datensammlungsregeln gehörigen Ressourcen erstellen.

In diesem Abschnitt erstellen Sie Ressourcen, die Sie für Ihre Datensammlungsregel in einem dieser Szenarien verwenden:

- Erstellen von Ressourcen für die Datensammlungsregel zur Erfassung in einer benutzerdefinierten Tabelle

- Erstellen von Ressourcen für die Datensammlungsregel zur Erfassung in einer Standardtabelle

Erstellen von Ressourcen für die Datensammlungsregel zur Erfassung in einer benutzerdefinierten Tabelle

Führen Sie zum Erfassen der Daten in einer benutzerdefinierten Tabelle die folgenden Schritte (basierend auf dem Tutorial: Senden von Daten an Azure Monitor-Protokolle mithilfe der REST-API [Azure-Portal]) aus:

Überprüfen Sie die Voraussetzungen.

Parsen und Filtern von Beispieldaten mithilfe der Beispieldatei, die Sie im vorherigen Abschnitt erstellt haben

Zuweisen von Berechtigungen zur Datensammlungsregel

Überspringen Sie den Schritt „Beispieldaten senden“.

Wenn Probleme auftreten, lesen Sie die Schritte zur Problembehandlung.

Erstellen von Ressourcen für die Datensammlungsregel zur Erfassung in einer Standardtabelle

Um die Daten in einer Standardtabelle wie Syslog oder CommonSecurityLog zu erfassen, verwenden Sie einen Prozess, der auf dem Tutorial: Senden von Daten an Azure Monitor-Protokolle mithilfe der REST-API (Resource Manager-Vorlagen) basiert. In diesem Tutorial wird zwar erklärt, wie Sie Daten in einer benutzerdefinierten Tabelle erfassen, aber Sie können den Prozess auch ganz einfach so anpassen, dass Daten in einer Standardtabelle erfasst werden. Die folgenden Schritte weisen auf relevante Änderungen in den Schritten hin.

Überprüfen Sie die Voraussetzungen.

-

Überspringen Sie den Schritt „Erstellen einer neuen Tabelle im Log Analytics-Arbeitsbereich“. Dieser Schritt ist beim Erfassen von Daten in einer Standardtabelle nicht relevant, da die Tabelle bereits in Log Analytics vorhanden ist.

Erstellen der Datensammlungsregel. Dieser Schritt sieht Folgendes vor:

- Bereitstellen der Beispieldatei, die Sie im vorherigen Abschnitt erstellt haben.

- Verwenden der von Ihnen erstellten Beispieldatei, um die

streamDeclarations-Eigenschaft festzulegen. Jedes der Felder in der Beispieldatei muss eine entsprechende Spalte mit dem gleichen Namen und dem entsprechenden Typ haben (siehe das Beispiel unten). - Konfigurieren des Werts der

outputStream-Eigenschaft mit dem Namen der Standardtabelle statt dem der benutzerdefinierten Tabelle. Im Gegensatz zu benutzerdefinierten Tabellen haben Standardtabellennamen nicht das Suffix_CL. - Das Präfix des Tabellennamens muss

Microsoft-stattCustom-lauten. In unserem Beispiel istMicrosoft-Syslogder Wert der EigenschaftoutputStream.

Zuweisen von Berechtigungen zu einer Datensammlungsregel

Überspringen Sie den Schritt „Beispieldaten senden“.

Wenn Probleme auftreten, lesen Sie die Schritte zur Problembehandlung.

Beispiel: Datensammlungsregel, die Daten in der Tabelle Syslog erfasst

Beachten Sie dabei Folgendes:

- Die Spaltennamen und -typen für

streamDeclarationsmüssen mit den Beispieldateifeldern übereinstimmen, aber nicht alle angegeben werden. In der folgenden Datensammlungsregel werden beispielsweise die FelderPRI,typeundls_versionin der SpaltestreamDeclarationsweggelassen. - Die

dataflows-Eigenschaft transformiert die Eingabe in das Format der Tabelle Syslog und legtoutputStreamaufMicrosoft-Syslogfest.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"parameters": {

"dataCollectionRuleName": {

"type": "String",

"metadata": {

"description": "Specifies the name of the Data Collection Rule to create."

}

},

"location": {

"defaultValue": "westus2",

"allowedValues": [

"westus2",

"eastus2",

"eastus2euap"

],

"type": "String",

"metadata": {

"description": "Specifies the location in which to create the Data Collection Rule."

}

},

"location": {

"defaultValue": "[resourceGroup().location]",

"type": "String",

"metadata": {

"description": "Specifies the location in which to create the Data Collection Rule."

}

},

"workspaceResourceId": {

"type": "String",

"metadata": {

"description": "Specifies the Azure resource ID of the Log Analytics workspace to use."

}

}

},

"resources": [

{

"type": "Microsoft.Insights/dataCollectionRules",

"apiVersion": "2021-09-01-preview",

"name": "[parameters('dataCollectionRuleName')]",

"location": "[parameters('location')]",

"properties": {

"streamDeclarations": {

"Custom-SyslogStream": {

"columns": [

{

"name": "ls_timestamp",

"type": "datetime"

}, {

"name": "timestamp",

"type": "datetime"

},

{

"name": "message",

"type": "string"

},

{

"name": "facility_label",

"type": "string"

},

{

"name": "severity_label",

"type": "string"

},

{

"name": "host",

"type": "string"

},

{

"name": "logsource",

"type": "string"

}

]

}

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "[parameters('workspaceResourceId')]",

"name": "clv2ws1"

}

]

},

"dataFlows": [

{

"streams": [

"Custom-SyslogStream"

],

"destinations": [

"clv2ws1"

],

"transformKql": "source | project TimeGenerated = ls_timestamp, EventTime = todatetime(timestamp), Computer = logsource, HostName = logsource, HostIP = host, SyslogMessage = message, Facility = facility_label, SeverityLevel = severity_label",

"outputStream": "Microsoft-Syslog"

}

]

}

}

],

"outputs": {

"dataCollectionRuleId": {

"type": "String",

"value": "[resourceId('Microsoft.Insights/dataCollectionRules', parameters('dataCollectionRuleName'))]"

}

}

}

Konfigurieren der Logstash-Konfigurationsdatei

Um die Logstash-Konfigurationsdatei zum Erfassen der Protokolle in einer benutzerdefinierten Tabelle zu konfigurieren, rufen Sie die folgenden Werte ab:

| Feld | Möglichkeit des Abrufs |

|---|---|

client_app_Id |

Der Wert Application (client) ID, den Sie in Schritt 3 erstellen, wenn Sie die Ressourcen für die Datensammlungsregel erstellen, entsprechend dem Tutorial, das Sie in diesem Abschnitt befolgt haben. |

client_app_secret |

Der Wert Application (client) ID, den Sie in Schritt 5 erstellen, wenn Sie die Ressourcen für die Datensammlungsregel erstellen, entsprechend dem Tutorial, das Sie in diesem Abschnitt befolgt haben. |

tenant_id |

Die Mandanten-ID Ihres Abonnements. Sie finden die Mandanten-ID unter Startseite > Microsoft Entra ID > Übersicht > Basisinformationen. |

data_collection_endpoint |

Der Wert des URI logsIngestion in Schritt 3, wenn Sie die Ressourcen für die Datensammlungsregel erstellen, entsprechend dem Tutorial, das Sie in diesem Abschnitt befolgt haben. |

dcr_immutable_id |

Der Wert der Datensammlungsregel immutableId in Schritt 6, wenn Sie die Ressourcen für die Datensammlungsregel erstellen, entsprechend dem Tutorial, das Sie in diesem Abschnitt befolgt haben. |

dcr_stream_name |

Wechseln Sie für benutzerdefinierte Tabellen, wie in Schritt 6 beim Erstellen der Ressourcen für die Datensammlungsregel erklärt, zur JSON-Ansicht der Datensammlungsregel, und kopieren Sie die Eigenschaft dataFlows>streams. Sehen Sie sich dcr_stream_name im nachstehenden Beispiel an.Für Standardtabellen ist der Wert Custom-SyslogStream. |

Nachdem Sie die erforderlichen Werte abgerufen haben:

- Ersetzen Sie den Ausgabeabschnitt der Logstash-Konfigurationsdatei, die Sie im vorherigen Schritt erstellt haben, durch das folgende Beispiel.

- Ersetzen Sie die Platzhalterzeichenfolgen im folgenden Beispiel durch die abgerufenen Werte.

- Stellen Sie sicher, dass Sie das Attribut

create_sample_fileinfalseändern.

Optionale Konfiguration

| Feld | BESCHREIBUNG | Standardwert |

|---|---|---|

azure_cloud |

Wird verwendet, um den Namen der verwendeten Azure-Cloud anzugeben. Verfügbare Werte: AzureCloud, AzureChinaCloud und AzureUSGovernment. |

AzureCloud |

key_names |

Ein Array der Zeichenfolgen. Geben Sie dieses Feld an, wenn Sie eine Teilmenge der Spalten an Log Analytics senden möchten. | Ohne (Feld ist leer) |

plugin_flush_interval |

Legt den maximalen Zeitabstand (in Sekunden) zwischen dem Senden zweier Nachrichten an Log Analytics fest. | 5 |

retransmission_time |

Legt die Zeitspanne in Sekunden für das erneute Senden von Nachrichten fest, wenn der Versand fehlgeschlagen ist. | 10 |

compress_data |

Wenn dieses Feld den Wert True hat, werden die Ereignisdaten komprimiert, ehe die API verwendet wird. Empfohlen für Pipelines mit hohem Durchsatz. |

False |

proxy |

Geben Sie an, welche Proxy-URL für alle API-Aufrufe verwendet werden soll. | Ohne (Feld ist leer) |

proxy_aad |

Geben Sie an, welche Proxy-URL für API-Aufrufe an Microsoft Entra ID verwendet werden soll. | Derselbe Wert wie „proxy“ (Feld ist leer) |

proxy_endpoint |

Geben Sie an, welche Proxy-URL für API-Aufrufe an den Datensammlungsendpunkt verwendet werden soll. | Derselbe Wert wie „proxy“ (Feld ist leer) |

Beispiel: Konfigurationsabschnitt des Ausgabe-Plug-Ins

output {

microsoft-sentinel-log-analytics-logstash-output-plugin {

client_app_Id => "<enter your client_app_id value here>"

client_app_secret => "<enter your client_app_secret value here>"

tenant_id => "<enter your tenant id here> "

data_collection_endpoint => "<enter your logsIngestion URI here> "

dcr_immutable_id => "<enter your DCR immutableId here> "

dcr_stream_name => "<enter your stream name here> "

create_sample_file=> false

sample_file_path => "c:\\temp"

proxy => "http://proxy.example.com"

}

}

Weitere Parameter für das Logstash-Ausgabe-Plug-In für Microsoft Sentinel finden Sie in der Infodatei des Ausgabe-Plug-Ins.

Hinweis

Aus Sicherheitsgründen wird empfohlen, die Attribute client_app_Id, client_app_secret, tenant_id, data_collection_endpoint und dcr_immutable_id nicht implizit in Ihrer Logstash-Konfigurationsdatei anzugeben. Es wird empfohlen, diese vertraulichen Informationen in einem Logstash-KeyStore zu speichern.

Neustarten von Logstash

Starten Sie Logstash mit der aktualisierten Konfiguration des Ausgabe Plug-Ins neu, und prüfen Sie, ob die Daten in der richtigen Tabelle entsprechend Ihrer Konfiguration von Datensammlungsregeln erfasst werden.

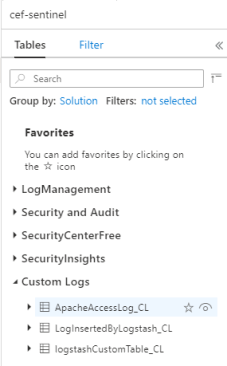

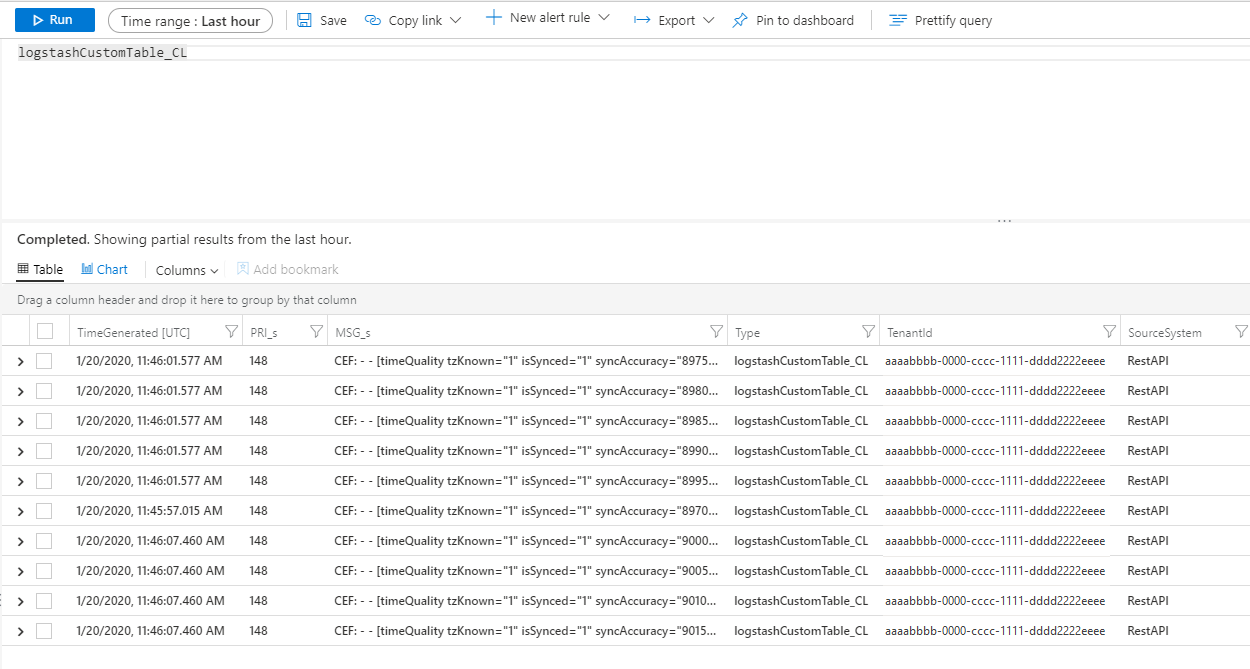

Anzeigen eingehender Protokolle in Microsoft Sentinel

Überprüfen Sie, ob Nachrichten an das Ausgabe-Plug-In gesendet werden.

Klicken Sie im Microsoft Sentinel-Navigationsmenü auf Protokolle. Erweitern Sie unter der Überschrift Tabellen die Kategorie Benutzerdefinierte Protokolle. Suchen Sie den Namen der von Ihnen in der Konfiguration angegebenen Tabelle (mit dem Suffix

_CL), und klicken Sie darauf.

Zum Anzeigen von Datensätzen in der Tabelle fragen Sie die Tabelle ab. Verwenden Sie dazu den Tabellennamen als Schema.

Überwachen der Ausgabe-Plug-In-Überwachungsprotokolle

Zum Überwachen der Konnektivität und Aktivität des Microsoft Sentinel-Ausgabe-Plug-Ins aktivieren Sie die entsprechende Logstash-Protokolldatei. Informationen zum Speicherort der Protokolldatei finden Sie im Dokument zum Logstash-Verzeichnislayout.

Wenn in dieser Protokolldatei keine Daten angegeben sind, generieren und senden Sie einige Ereignisse lokal (über die Eingabe- und Filter-Plug-Ins), um sicherzustellen, dass das Ausgabe-Plug-In Daten empfängt. Microsoft Sentinel unterstützt nur Probleme im Zusammenhang mit dem Ausgabe-Plug-In.

Netzwerksicherheit

Definieren Sie Netzwerkeinstellungen, und aktivieren Sie die Netzwerkisolation für das Microsoft Sentinel-Logstash-Ausgabe-Plug-In.

Diensttags für virtuelle Netzwerke

Das Microsoft Sentinel-Ausgabe-Plug-In unterstützt Azure Virtual Network-Diensttags. Die beiden Tags AzureMonitor und AzureActiveDirectory sind erforderlich.

Mit Azure Virtual Network-Diensttags können Netzwerkzugriffssteuerungen in Netzwerksicherheitsgruppen, Azure Firewall und benutzerdefinierten Routen definiert werden. Verwenden Sie Diensttags anstelle von bestimmten IP-Adressen, wenn Sie Sicherheitsregeln und Routen erstellen. Für Szenarien, in denen Azure Virtual Network-Diensttags nicht verwendet werden können, sind nachstehend die Firewallanforderungen aufgeführt.

Firewallanforderungen

In der folgenden Tabelle werden die Firewallanforderungen für Szenarien aufgeführt, in denen Azure Virtual Network-Diensttags nicht verwendet werden können.

| Cloud | Endpunkt | Zweck | Port | Direction | Umgehung der HTTPS-Überprüfung |

|---|---|---|---|---|---|

| Azure Commercial | https://login.microsoftonline.com | Autorisierungsserver (Microsoft Identity Platform) | Port 443 | Ausgehend | Ja |

| Azure Commercial | https://<data collection endpoint name>.<Azure cloud region>.ingest.monitor.azure.com |

Datensammlungsendpunkt | Port 443 | Ausgehend | Ja |

| Azure Government | https://login.microsoftonline.us | Autorisierungsserver (Microsoft Identity Platform) | Port 443 | Ausgehend | Ja |

| Azure Government | Ersetzen Sie „.com“ oben durch „.us“ | Datensammlungsendpunkt | Port 443 | Ausgehend | Ja |

| Microsoft Azure von 21Vianet | https://login.chinacloudapi.cn | Autorisierungsserver (Microsoft Identity Platform) | Port 443 | Ausgehend | Ja |

| Microsoft Azure von 21Vianet | Ersetzen Sie „.com“ oben durch „.cn“ | Datensammlungsendpunkt | Port 443 | Ausgehend | Ja |

Begrenzungen

- Die Erfassung in Standardtabellen ist ausschließlich auf Standardtabellen begrenzt, die für die Erfassung benutzerdefinierter Protokolle unterstützt werden.

- Die Spalten des Eingabedatenstroms in der Eigenschaft

streamDeclarationsmüssen mit einem Buchstaben beginnen. Wenn eine Spalte mit anderen Zeichen beginnt (z. B.@oder_), schlägt der Vorgang fehl. - Das datetime-Feld

TimeGeneratedist ein Pflichtfeld. Sie müssen dieses Feld in die KQL-Transformation einschließen. - Weitere mögliche Probleme finden Sie im Abschnitt zur Problembehandlung im Tutorial.

Nächste Schritte

In diesem Artikel haben Sie erfahren, wie Sie Logstash zum Verbinden externer Datenquellen mit Microsoft Sentinel verwenden. Weitere Informationen zu Microsoft Sentinel finden Sie in den folgenden Artikeln:

- Erfahren Sie, wie Sie Einblick in Ihre Daten und potenzielle Bedrohungen erhalten.

- Beginnen Sie mit Erkennung von Bedrohungen mithilfe von Microsoft Sentinel.