Open Model LLM Tool

Das Open Model LLM-Tool ermöglicht die Verwendung verschiedener Open Model- und Foundational Models, z . B. Falcon und Llama 2, für die Verarbeitung natürlicher Sprachen im Azure Machine Learning-Eingabeaufforderungsfluss.

Achtung

Veralteter Hinweis: Das Open Model LLM-Tool wurde zugunsten des LLM-Tools veraltet, das Unterstützung für alle Modelle bietet, die von der Azure AI-Modell-Ableitungs-API unterstützt werden, und somit mehr Flexibilität bietet.

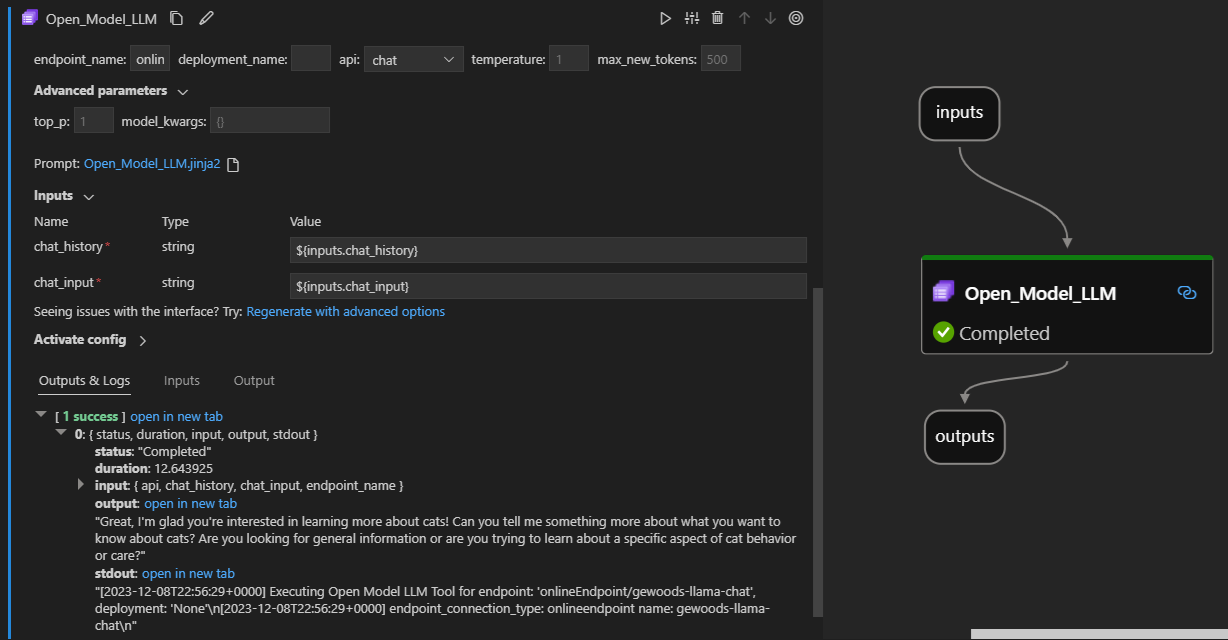

Hier sehen Sie, wie es in der Visual Studio Code Prompt Flow-Erweiterung in Aktion aussieht. In diesem Beispiel wird das Tool verwendet, um einen LlaMa-2-Chat-Endpunkt aufzurufen und „Was ist CI?“ zu fragen.

Dieses Aufforderungsflusstool unterstützt zwei verschiedene LLM-API-Typen:

- Chat: Im vorherigen Beispiel gezeigt. Die Chat-API-Funktionen ermöglichen interaktive Unterhaltungen mit textbasierten Eingaben und Antworten.

- Vervollständigung: Der Vervollständigungs-API-Typ wird verwendet, um einzelne Antworttext-Vervollständigungen auf Basis der bereitgestellten Eingabe zu generieren.

Schnellübersicht: Gewusst wie das Open Model LLM-Tool verwenden?

- Wählen Sie ein Modell aus dem Azure Machine Learning-Modellkatalog aus, und erhalten Sie es bereitgestellt.

- Stellen Sie eine Verbindung mit der Modellbereitstellung her.

- Konfigurieren Sie die Einstellungen für das geöffnete Modell für die Llm-Tools.

- Bereiten Sie die Eingabeaufforderung vor.

- Führen Sie den Flow aus.

Voraussetzungen: Modellbereitstellung

- Wählen Sie im Azure Machine Learning-Modellkatalog das Modell aus, das Ihrem Szenario entspricht.

- Verwenden Sie die Schaltfläche "Bereitstellen ", um das Modell auf einem Azure Machine Learning-Online-Ableitungsendpunkt bereitzustellen.

- Verwenden Sie eine der Zahlungsoptionen, während Sie die Bereitstellungsoptionen verwenden.

Weitere Informationen finden Sie unter Deploy foundation models to endpoints for inferencing.

Voraussetzungen: Herstellen einer Verbindung mit dem Modell

Damit der Aufforderungsfluss Ihr bereitgestelltes Modell verwenden kann, müssen Sie eine Verbindung damit herstellen. Es gibt zwei Möglichkeiten, eine Verbindung herzustellen.

Endpunktverbindungen

Sobald Ihr Fluss einem Azure Machine Learning- oder Azure AI Studio-Arbeitsbereich zugeordnet ist, kann das Open Model LLM-Tool die Endpunkte in diesem Arbeitsbereich verwenden.

Verwenden von Azure Machine Learning- oder Azure AI Studio-Arbeitsbereichen: Wenn Sie den Eingabeaufforderungsfluss in einem der webseitenbasierten Browser-Arbeitsbereiche verwenden, stehen die Onlineendpunkte für diesen Arbeitsbereich zur Verfügung, die automatisch angezeigt werden.

Verwenden von VS Code oder Code zuerst: Wenn Sie den Eingabeaufforderungsfluss in VS Code oder eines der Code First-Angebote verwenden, müssen Sie eine Verbindung mit dem Arbeitsbereich herstellen. Das Open Model LLM-Tool verwendet den Azure.identity DefaultAzureCredential-Client für die Autorisierung. Eine Möglichkeit besteht darin , Anmeldeinformationswerte für die Umgebung festzulegen.

Benutzerdefinierte Verbindungen

Das Open Model LLM-Tool verwendet die CustomConnection. Der Eingabeaufforderungsfluss unterstützt zwei Arten von Verbindungen:

Arbeitsbereichsverbindungen – Verbindungen, die als geheime Schlüssel in einem Azure Machine Learning-Arbeitsbereich gespeichert sind. Während diese Verbindungen verwendet werden können, werden diese häufig in der Studio-Benutzeroberfläche erstellt und verwaltet. Informationen zum Erstellen einer benutzerdefinierten Verbindung in der Studio-Benutzeroberfläche finden Sie unter Erstellen einer benutzerdefinierten Verbindung.

Lokale Verbindungen – Verbindungen, die lokal auf Ihrem Computer gespeichert sind. Diese Verbindungen sind in der Studio-UX nicht verfügbar, können aber mit der VS Code-Erweiterung verwendet werden. Informationen zum Erstellen einer lokalen benutzerdefinierten Verbindung finden Sie unter Erstellen einer lokalen Verbindung.

Die zum Festlegen erforderlichen Schlüssel sind:

- endpoint_url

- Dieser Wert befindet sich am zuvor erstellten Rückschlussendpunkt.

- endpoint_api_key

- Stellen Sie sicher, dass sie als geheimer Wert festgelegt wird.

- Dieser Wert befindet sich am zuvor erstellten Rückschlussendpunkt.

- model_family

- Unterstützte Werte: LLAMA, DOLLY, GPT2 oder FALCON

- Dieser Wert hängt vom Typ der Bereitstellung ab, auf die Sie abzielen.

Ausführen des Tools: Eingaben

Das Open Model LLM-Tool verfügt über viele Parameter, von denen einige erforderlich sind. Ausführliche Informationen finden Sie in der folgenden Tabelle. Sie können diese Parameter dem vorherigen Screenshot zur visuellen Übersichtlichkeit zuordnen.

| Name | Typ | Beschreibung | Erforderlich |

|---|---|---|---|

| api | Zeichenfolge | Der API-Modus, der vom verwendeten Modell und dem ausgewählten Szenario abhängt. Unterstützte Werte: (Completion | Chat) | Ja |

| endpoint_name | Zeichenfolge | Name eines Online-Inferencing-Endpunkts mit einem unterstützten Modell, das darauf bereitgestellt wird. Hat Vorrang vor der Verbindung. | Ja |

| Temperatur | float | Die Zufälligkeit des generierten Texts. Der Standardwert ist 1. | No |

| max_new_tokens | integer | Die maximale Anzahl von Token, die in der Vervollständigung generiert werden. Der Standardwert ist 500. | No |

| top_p | float | Die Wahrscheinlichkeit, dass das erste Ergebnis aus den generierten Token verwendet wird. Der Standardwert ist 1. | No |

| model_kwargs | dictionary | Diese Eingabe wird verwendet, um spezifische Konfigurationen für das verwendete Modell bereitzustellen. Beispielsweise kann das Llama-02-Modell {"temperature":0.4} verwenden. Standard: {} | Nein |

| deployment_name | Zeichenfolge | Der Name der Bereitstellung, die auf den Endpunkt für Online-Rückschlüsse ausgerichtet werden soll. Wenn kein Wert übergeben wird, werden die Rückschlusseinstellungen für den Lastenausgleichs-Datenverkehr verwendet. | Nein |

| prompt | Zeichenfolge | Die Texteingabe, die das Sprachmodell verwendet, um eine Antwort zu generieren. | Ja |

Ausgaben

| API | Rückgabetyp | BESCHREIBUNG |

|---|---|---|

| Completion | Zeichenfolge | Der Text einer vorhergesagten Vervollständigung |

| Chat | Zeichenfolge | Der Text einer Antwort der Unterhaltung |

Bereitstellen auf einem Onlineendpunkt

Wenn Sie einen Fluss mit dem Open Model LLM-Tool für einen Onlineendpunkt bereitstellen, gibt es einen zusätzlichen Schritt zum Einrichten von Berechtigungen. Während der Bereitstellung über die Webseiten gibt es eine Auswahl zwischen vom System zugewiesenen und vom Benutzer zugewiesenen Identitätstypen. Fügen Sie entweder mithilfe des Azure-Portal (oder einer ähnlichen Funktionalität) die Funktion "Leser"-Auftrag zur Identität im Azure Machine Learning-Arbeitsbereich oder ai Studio-Projekt hinzu, das den Endpunkt hosten soll. Die Bereitstellung des Eingabeaufforderungsflusses muss möglicherweise aktualisiert werden.