Einrichten des Trainings für Automated ML für Tabellendaten ohne Code über die Studio-Benutzeroberfläche

In diesem Artikel richten Sie automatisierte Machine Learning-Trainingsaufträge mithilfe von Azure Machine Learning Automated ML in Azure Machine Learning-Studio ein. Mit diesem Ansatz können Sie den Auftrag einrichten, ohne eine einzige Codezeile zu schreiben. Automated ML ist ein Prozess, bei dem Azure Machine Learning den besten maschinellen Lernalgorithmus für Ihre spezifischen Daten auswählt. Der Prozess ermöglicht Ihnen die schnelle Erstellung von Machine Learning-Modellen. Weitere Informationen finden Sie in der Übersicht über den Automated ML-Prozess.

Dieses Tutorial bietet eine allgemeine Übersicht über die Arbeit mit Automated ML im Studio. Die folgenden Artikel enthalten detaillierte Anweisungen für das Arbeiten mit bestimmten Machine Learning-Modellen:

- Klassifizierung: Tutorial: Trainieren eines Klassifizierungsmodells mit Automated ML im Studio

- Zeitreihenprognose: Tutorial: Prognosebedarf mit Automated ML im Studio

- Natural Language Processing (NLP): Einrichten von Automated ML zum Trainieren eines NLP-Modells (Azure CLI oder Python SDK)

- Maschinelles Sehen: Einrichten von AutoML zum Trainieren von Modellen für maschinelles Sehen (Azure CLI oder Python SDK)

- Regression: Trainieren eines Regressionsmodells mit Automated ML (Python SDK)

Voraussetzungen

Ein Azure-Abonnement. Sie können ein kostenloses oder kostenpflichtiges Konto für Azure Machine Learning erstellen.

Einen Azure Machine Learning-Arbeitsbereich und eine Compute-Instanz Informationen zum Vorbereiten dieser Ressourcen finden Sie unter Schnellstart Erste Schritte mit Azure Machine Learning.

Die Datenressource, die für den Automated ML-Trainingsauftrag verwendet werden soll. In diesem Tutorial wird beschrieben, wie Sie eine vorhandene Datenressource auswählen oder eine Datenressource aus einer Datenquelle erstellen, z. B. eine lokale Datei, eine Web-URL oder einen Datenspeicher. Weitere Informationen finden Sie unter Erstellen und Verwalten von Datenressourcen.

Wichtig

Es gibt zwei Anforderungen an die Trainingsdaten:

- Die Daten müssen in Tabellenform vorliegen.

- Der Wert, den Sie vorhersagen möchten (die Zielspalte), muss in den Daten vorhanden sein.

Erstellen eines Experiments

Erstellen sie ein Experiment und führen Sie es aus, indem Sie die folgenden Schritte ausführen:

Melden Sie sich bei Azure Machine Learning-Studio an und wählen Sie dann Ihr Abonnement und den Arbeitsbereich aus.

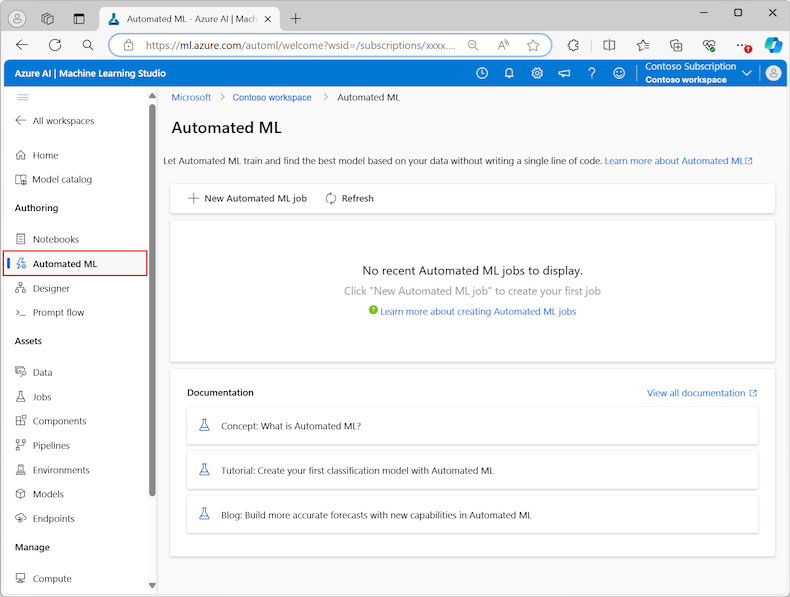

Wählen Sie im linken Menü im Abschnitt Erstellung die Option Automated ML aus:

Wenn Sie zum ersten Mal mit Experimenten im Studio arbeiten, sehen Sie eine leere Liste und Links zu Dokumentationen. Andernfalls wird eine Liste Ihrer letzten Automated ML-Experimente angezeigt, einschließlich der Elemente, die mit dem Azure Machine Learning SDK erstellt wurden.

Wählen Sie Neuer Automated ML-Auftrag aus, um den Vorgang Senden eines automatisierten ML-Auftrags zu starten.

Standardmäßig wählt der Prozess die Option Automatisch Trainieren auf der Registerkarte Trainingsmethode aus und setzt die Konfigurationseinstellungen fort.

Geben Sie auf der Registerkarte Standardeinstellungen Werte für die erforderlichen Einstellungen ein, einschließlich des Namens des Auftrags und des Experiments. Sie können wenn gewünscht auch Werte für die optionalen Einstellungen angeben.

Klicken Sie auf Weiter, um fortzufahren.

Identifizieren der Datenressource

Geben Sie auf der Registerkarte Vorgangstyp & Daten die Datenressource für das Experiment und das Machine Learning-Modell an, das zum Trainieren der Daten verwendet werden soll.

In diesem Tutorial können Sie eine vorhandene Datenressource verwenden oder eine neue Datenressource aus einer Datei auf Ihrem lokalen Computer erstellen. Die Benutzeroberflächenseiten des Studio ändern sich basierend auf Ihrer Auswahl für die Datenquelle und den Typ des Trainingsmodells.

Wenn Sie eine vorhandene Datenressource verwenden möchten, können Sie den Abschnitt Konfigurieren des Trainingsmodells fortsetzen.

Führen Sie die folgenden Schritte aus, um eine neue Datenressource zu erstellen:

Um eine neue Datenressource aus einer Datei auf Ihrem lokalen Computer zu erstellen, wählen Sie Erstellen aus.

Auf der Seite Datentyp:

- Geben Sie einen Datenobjektnamen ein.

- Wählen Sie als Typ in der Dropdownliste tabellarisch aus.

- Wählen Sie Weiter aus.

Wählen Sie auf der Seite Datenquelle Aus lokalen Dateien aus.

Machine Learning Studio fügt dem linken Menü zusätzliche Optionen hinzu, mit dem Sie die Datenquelle konfigurieren können.

Wählen Sie Weiter aus, um auf der Seite Zielspeichertyp fortzufahren, auf der Sie den Azure Storage-Speicherort angeben, um Ihre Datenressource hochzuladen.

Sie können den Standardspeichercontainer angeben, der automatisch mit Ihrem Arbeitsbereich erstellt wurde, oder einen Speichercontainer auswählen, der für das Experiment verwendet werden soll.

- Wählen Sie unter Datenspeichertyp die Option Azure Blob Storage aus.

- Wählen Sie in der Liste der Datenspeicher workspaceblobstore aus.

- Wählen Sie Weiter aus.

Verwenden Sie auf der Seite Datei- und Ordnerauswahl das Dropdownmenü Dateien oder Ordner hochladen und wählen Sie die Option Dateien hochladen oder Ordner hochladen aus.

- Navigieren Sie zum Speicherort der Hochzuladenden Daten und wählen Sie Öffnen aus.

- Wählen Sie nach dem Hochladen der Dateien Weiter aus.

Machine Learning Studio überprüft und lädt Ihre Daten hoch.

Hinweis

Wenn sich Ihre Daten hinter einem virtuellen Netzwerk befinden, müssen Sie die Funktion zum Überspringen der Überprüfung aktivieren, um sicherzustellen, dass der Arbeitsbereich auf Ihre Daten zugreifen kann. Weitere Informationen finden Sie unter Verwenden von Azure Machine Learning Studio in einem virtuellen Azure-Netzwerk.

Überprüfen Sie ihre hochgeladenen Daten auf der Seite Einstellungen auf Richtigkeit. Die Felder auf der Seite werden basierend auf dem Dateityp Ihrer Daten vorab aufgefüllt:

Feld BESCHREIBUNG Dateiformat Definiert das Layout und den Typ der in einer Datei gespeicherten Daten. Trennzeichen Identifiziert Mindestens ein Zeichen zum Angeben der Grenze zwischen separaten, unabhängigen Regionen in Nur-Text-Datenströmen oder anderen Datenströmen. Codieren Gibt an, welche Bit-zu-Zeichen-Schematabelle verwendet werden soll, um Ihr Dataset zu lesen. Spaltenüberschriften Gibt an, wie die Header des Datasets, sofern vorhanden, behandelt werden. Zeilen überspringen Gibt an, wie viele Zeilen im Dataset übersprungen werden. Wählen Sie Weiter aus, um auf der Seite Schema fortzufahren. Diese Seite wird auch basierend auf Ihren Einstellungen vorab befüllt. Sie können den Datentyp für jede Spalte konfigurieren, die Spaltennamen überprüfen und Spalten verwalten:

- Um den Datentyp für eine Spalte zu ändern, verwenden Sie das Dropdownmenü Typ, um eine Option auszuwählen.

- Um eine Spalte aus der Datenressource auszuschließen, aktivieren Sie die Option Einschließen für die Spalte.

Wählen Sie Weiter aus, um mit der Seite Überprüfen fortzufahren. Überprüfen Sie die Zusammenfassung Ihrer Konfigurationseinstellungen für den Auftrag, und wählen Sie dann Erstellen aus.

Konfigurieren des Trainingsmodells

Wenn die Datenressource bereit ist, kehrt Machine Learning Studio zur Registerkarte Vorgangstyp und Daten zurück, um den Prozess Automated ML-Auftrag zu übermitteln. Die neue Datenressource wird auf der Seite aufgelistet.

Führen Sie die folgenden Schritte aus, um die Auftragskonfiguration abzuschließen:

Erweitern Sie das Dropdownmenü Aufgabentyp auswählen und wählen Sie das für das Experiment zu verwendende Trainingsmodell aus. Zu den Optionen gehören Klassifizierung, Regression, Zeitreihenprognose, Natural Language Processing (NLP) oder maschinelles Sehen. Weitere Informationen zu diesen Optionen finden Sie in den Beschreibungen der unterstützten Aufgabentypen.

Nachdem Sie das Schulungsmodell angegeben haben, wählen Sie ihr Dataset in der Liste aus.

Wählen Sie Weiter aus, um mit der Registerkarte Vorgangseinstellungen fortzufahren.

Wählen Sie in der Dropdownliste Zielspalte die Spalte aus, die für die Modellvorhersagen verwendet werden soll.

Konfigurieren Sie je nach Trainingsmodell die folgenden erforderlichen Einstellungen:

Klassifizierung: Wählen Sie aus, ob Sie Deep Learning aktivieren möchten.

Zeitreihenprognose: Wählen Sie aus, ob Deep Learning aktiviert werden soll, und bestätigen Sie Ihre Einstellungen für die erforderlichen Einstellungen:

Verwenden Sie die Spalte „Zeit“, um die Zeitdaten anzugeben, die im Modell verwendet werden sollen.

Wählen Sie aus, ob eine oder mehrere AutoDetect-Optionen aktiviert werden sollen. Wenn Sie die Auswahl einer AutoDetectOption deaktivieren, z. B. Autodetect-Prognosehorizont, können Sie einen bestimmten Wert angeben. Der Prognosehorizontwert gibt an, wie viele Zeiteinheiten (Minuten/Stunden/Tage/Wochen/Monate/Jahre) das Modell in die Zukunft vorhersagen kann. Je weiter in die Zukunft das Modell voraussagen muss, desto ungenauer wird es.

Weitere Informationen zum Konfigurieren dieser Einstellungen finden Sie unter Verwenden von Automated ML zum Trainieren eines Zeitreihen-Prognosemodells.

Verarbeitung natürlicher Sprachen: Bestätigen Sie Ihre Einstellungen für die erforderlichen Einstellungen:

Verwenden Sie die Option Untertyp auswählen, um den Unterklassifizierungstyp für das NLP-Modell zu konfigurieren. Sie können aus der Klassifizierung mit mehreren Klassen, der Klassifizierung mit mehreren Bezeichnungen und der Benannten Entitätserkennung (Named Entity Recognition, NER) wählen.

Geben Sie im Abschnitt Einstellungen für Aufräumen Werte für den Slack-Faktor und Sampling-Algorithmus an.

Konfigurieren Sie im Abschnitt Suchbereich den Satz von Modellalgorithmus-Optionen.

Weitere Informationen zum Konfigurieren dieser Einstellungen finden Sie unter Einrichten von Automated ML, um ein NLP-Modell (Azure CLI oder Python SDK) zu trainieren.

Maschinelles Sehen: Wählen Sie aus, ob manuelles Aufräumen aktiviert werden soll, und bestätigen Sie Ihre Einstellungen für die erforderlichen Einstellungen:

- Verwenden Sie die Option Untertyp auswählen, um den Unterklassifizierungstyp für das Modell für maschinelles Sehen zu konfigurieren. Sie können aus der Imageklassifizierung (Multi-Class) oder (Multi-Label), Objekterkennung und Polygon (Instanzsegmentierung) wählen.

Weitere Informationen zum Konfigurieren dieser Einstellungen finden Sie unter Einrichten von AutoML zum Trainieren von Modellen für maschinelles Sehen (Azure CLI oder Python SDK).

Angeben optionaler Einstellungen

Machine Learning Studio bietet optionale Einstellungen, die Sie basierend auf ihrer Auswahl des Machine Learning-Modells konfigurieren können. In den folgenden Abschnitten werden die zusätzlichen Einstellungen beschrieben.

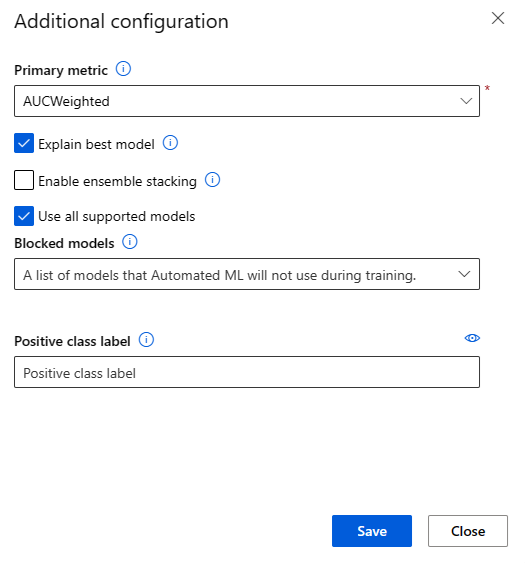

Zusätzliche Einstellungen konfigurieren

Sie können die Option Zusätzliche Konfigurationseinstellungen anzeigen auswählen, um Aktionen anzuzeigen, die für die Daten in Vorbereitung auf das Training ausgeführt werden sollen.

Auf der Seite Zusätzliche Konfiguration werden Standardwerte basierend auf ihrer Experimentauswahl und -daten angezeigt. Sie können die Standardwerte verwenden oder die folgenden Einstellungen konfigurieren:

| Einstellung | Beschreibung |

|---|---|

| Primäre Metrik | Identifizieren Sie die Hauptmetrik für die Bewertung Ihres Modells. Weitere Informationen finden Sie unter Modellmetriken. |

| Aktivieren des Ensemblestapels | Ermöglichen das Lernen mit Ensembles und verbessern Sie die Ergebnisse des maschinellen Lernens und die prädiktive Leistung, indem Sie mehrere Modelle kombinieren, anstatt einzelne Modelle zu verwenden. Weitere Informationen finden Sie unter Ensemblemodelle. |

| Verwenden aller unterstützten Modelle | Verwenden Sie diese Option, um Automated ML anzuweisen, ob alle unterstützten Modelle im Experiment verwendet werden sollen. Weitere Informationen finden Sie in den unterstützten Algorithmen für jeden Aufgabentyp. – Wählen Sie diese Option aus, um die Einstellung Blockierte Modelle zu konfigurieren. – Deaktivieren Sie diese Option, um die Einstellung für zulässige Modelle zu konfigurieren. |

| Blockierte Modelle | (Verfügbar, wenn Alle unterstützten Modelle verwenden ausgewählt ist) Verwenden Sie die Dropdownliste und wählen Sie die Modelle aus, die vom Trainingsauftrag ausgeschlossen werden sollen. |

| Zulässige Modelle | (Verfügbar, wenn nicht Alle unterstützten Modelle verwenden ausgewählt ist) Verwenden Sie die Dropdownliste und wählen Sie die Modelle aus, die für den Trainingsauftrag verwendet werden sollen. Wichtig: Nur für SDK-Experimente verfügbar. |

| Erläutern des besten Modells | Wählen Sie diese Option aus, um die Erläuterung des besten Modells, das von Automated ML erstellt wurde, automatisch anzuzeigen. |

| Positive Klassenbezeichnung | Geben Sie die Bezeichnung für Automated ML ein, die für die Berechnung binärer Metriken verwendet werden soll. |

Konfigurieren von Featurisierungseinstellungen

Sie können die Option Featurisierungseinstellungen anzeigen auswählen, um Aktionen anzuzeigen, die für die Daten in Vorbereitung auf das Training ausgeführt werden sollen.

Die Seite Featurisierung zeigt standardmäßige Featurisierungstechniken für Ihre Datenspalten an. Sie können die automatische Featurisierung aktivieren/deaktivieren und die Einstellungen für die automatische Featurisierung für Ihr Experiment anpassen.

Wählen Sie die Option Featurisierung aktivieren, um die Konfiguration zuzulassen.

Wichtig

Wenn Ihre Daten nicht numerische Spalten enthalten, ist die Featurisierung immer aktiviert.

Konfigurieren Sie jede verfügbare Spalte nach Bedarf. In der folgenden Tabelle sind die derzeit in Studio verfügbaren Anpassungen zusammengefasst:

Spalte Anpassung Featuretyp Dient zum Ändern des Werttyps für die ausgewählte Spalte. Imputation mit Dient zum Auswählen des Werts, mit dem fehlende Werte in Ihren Daten imputiert werden sollen.

Die Featurisierungseinstellungen wirken sich nicht auf die Eingabedaten aus, die für die Ableitung erforderlich sind. Wenn Sie Spalten aus dem Training ausschließen, sind die ausgeschlossenen Spalten weiterhin als Eingabe für die Ableitung des Modells erforderlich.

Konfigurieren von Grenzwerten für den Auftrag

Der Abschnitt Grenzwerte enthält Konfigurationsoptionen für die folgenden Einstellungen:

| Einstellung | BESCHREIBUNG | Wert |

|---|---|---|

| Maximale Textläufe | Geben Sie die maximale Anzahl von Versuchen während des Automated ML-Auftrags an, wobei jede Testversion eine andere Kombination aus Algorithmus und Hyperparametern aufweist. | Eine ganze Zahl zwischen 1 und 1,000 |

| Maximale Anzahl gleichzeitiger Testläufe | Geben Sie die maximale Anzahl der Testaufträge an, die parallel ausgeführt werden können. | Eine ganze Zahl zwischen 1 und 1,000 |

| Maximale Knotenanzahl | Geben Sie die maximale Anzahl der Knoten an, die dieser Auftrag aus dem ausgewählten Computeziel verwenden kann. | 1 oder mehr, je nach Computekonfiguration |

| Metrischer Bewertungsschwellenwert | Geben Sie den Schwellenwert für die Iterationsmetrik ein. Wenn die Iteration den Schwellenwert erreicht, wird der Trainingsauftrag beendet. Denken Sie daran, dass aussagekräftige Modelle eine Korrelation haben, die größer als 0 ist. Andernfalls ist das Ergebnis so zuverlässig wie eine Vermutung. | Durchschnittlicher Schwellenwert für Metriken zwischen den Grenzen [0, 10] |

| Experimenttimeout (Minuten) | Geben Sie die maximale Ausführungszeit für das gesamte Experiment an. Nachdem das Experiment die Grenze erreicht hat, bricht das System den Automated ML-Auftrag ab, einschließlich aller Versuche (Nachgeordnete Aufträge). | Anzahl der Minuten |

| Iterationstimeout (Minuten) | Geben Sie die maximale Ausführungszeit für jeden Testauftrag an. Nachdem der Testauftrag diesen Grenzwert erreicht hat, bricht das System die Testversion ab. | Anzahl der Minuten |

| Vorzeitige Beendigung aktivieren | Verwenden Sie diese Option, um den Auftrag zu beenden, wenn sie die Bewertung kurzfristig nicht verbessert. | Wählen Sie die Option aus, um das frühe Ende des Auftrags zu aktivieren |

Überprüfen und Testen

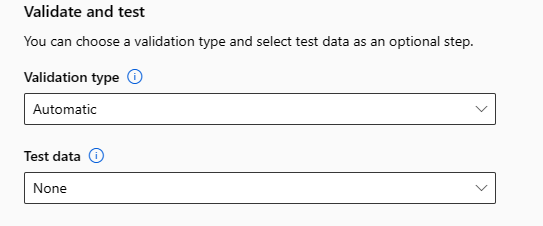

Der Abschnitt Überprüfen und Testen enthält die folgenden Konfigurationsoptionen:

Geben Sie den Überprüfungstyp an, der für Ihren Trainingsauftrag verwendet werden soll. Wenn Sie nicht explizit die Parameter

validation_dataodern_cross_validationsangeben, werden bei Automated ML Standardverfahren angewandt, die von der Anzahl der Zeilen im übergebenen einzelnen Datasettraining_dataabhängen.Umfang der Trainingsdaten Validierungsverfahren Mehr als 20.000 Zeilen Es wird eine Aufteilung in Trainings- und Validierungsdaten vorgenommen. Standardmäßig werden 10 % des ursprünglichen Trainingsdatasets als Validierungsset verwendet. Dieses Validierungsset wird seinerseits für die Metrikberechnung verwendet. Weniger als 20.000 Zeilen Der Kreuzvalidierungsansatz wird angewendet. Die Standardanzahl der Faltungen (Folds) hängt von der Zeilenanzahl ab.

- Dataset mit weniger als 1.000 Zeilen: Es werden 10 Faltungen verwendet

- Dataset mit 1.000 bis 20.000 Zeilen: Es werden drei Faltungen verwendetStellen Sie einen Testdatensatz (Vorschau) zur Verfügung, um das empfohlene Modell zu bewerten, das Automated ML am Ende Ihres Experiments erstellt. Wenn Sie den Testdatensatz bereitstellen, wird am Ende Ihres Experiments automatisch ein Testauftrag ausgelöst. Dieser Testauftrag wird nur mit dem besten Modell durchgeführt, das von Automated ML empfohlen wurde. Weitere Informationen finden Sie unter Anzeigen der Ergebnisse des Remotetestauftrags (Vorschau).

Wichtig

Die Bereitstellung eines Testdatensatzes zur Bewertung der erstellten Modelle ist eine Previewfunktion. Diese Funktion ist eine experimentelle Previewfunktion, die jederzeit geändert werden kann.

Die Testdaten werden getrennt von den Trainings- und Validierungsdaten betrachtet, und sollten die Ergebnisse des Testauftrags des empfohlenen Modells nicht verfälschen. Weitere Informationen finden Sie unter Schulungs-, Validierungs- und Testdaten.

Sie können entweder Ihren eigenen Testdatensatz zur Verfügung stellen oder sich dafür entscheiden, einen Prozentsatz Ihres Trainingsdatensatzes zu verwenden. Testdaten müssen in Form eines Azure Machine Learning-Tabellendatasets sein.

Das Schema des Testdatensatzes sollte mit dem Trainingsdatensatz übereinstimmen. Die Zielspalte ist optional, aber wenn keine Zielspalte angegeben wird, werden keine Testmetriken berechnet.

Das Test-Dataset sollte nicht dasselbe sein wie das Trainings-Dataset oder das Validierungs-Dataset.

Aufträge für Prognosen unterstützen keine Trennung von Training und Test.

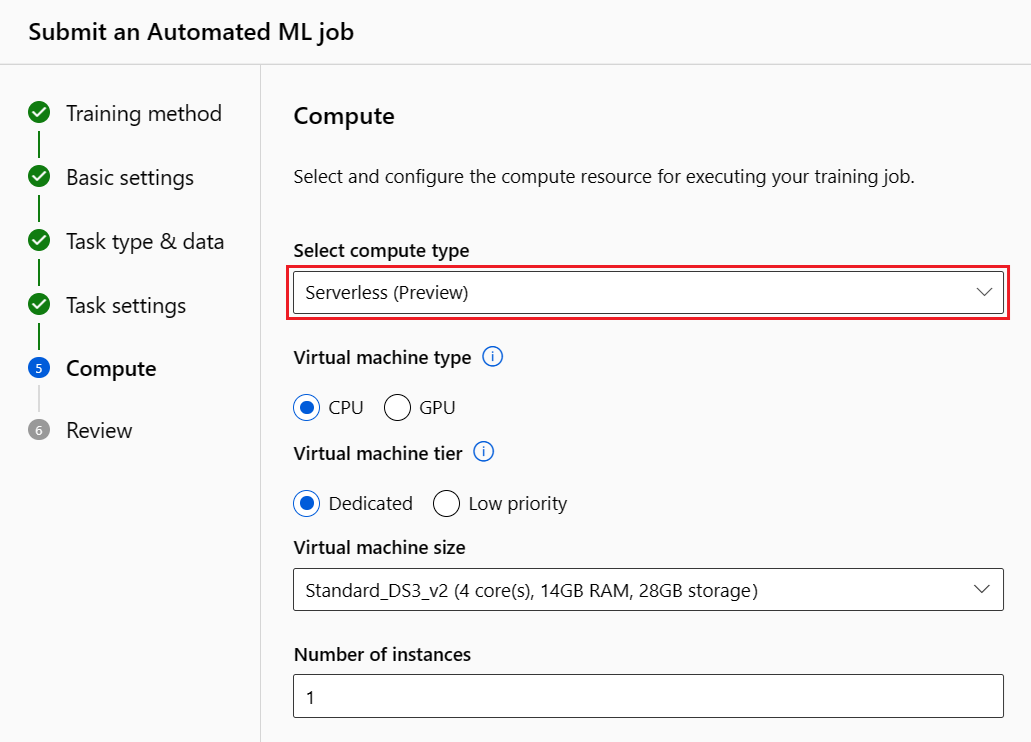

Konfigurieren des Computes

Führen Sie die folgenden Schritte aus, und konfigurieren Sie den Compute:

Wählen Sie Weiter aus, um mit der Registerkarte Compute fortzufahren.

Verwenden Sie die Dropdownliste Computetyp auswählen, um eine Option für die Datenprofilerstellung und den Trainingsauftrag auszuwählen. Die Optionen umfassen Computecluster, Computeinstanz oder serverlos.

Nachdem Sie den Computetyp ausgewählt haben, ändert sich die andere Benutzeroberfläche auf der Seite basierend auf Ihrer Auswahl:

Serverlos: Die Konfigurationseinstellungen werden auf der aktuellen Seite angezeigt. Fahren Sie mit dem nächsten Schritt fort, um Beschreibungen der zu konfigurierenden Einstellungen anzuzeigen.

Computecluster oder Computeinstanz: Wählen Sie aus den folgenden Optionen aus:

Verwenden Sie die Dropdownliste Automated ML Compute auswählen, um einen vorhandenen Compute für Ihren Arbeitsbereich auszuwählen, und wählen Sie dann Weiter aus. Fahren Sie mit dem Abschnitt Ausführen des Experiments und Anzeigen der Ergebnisse fort.

Wählen Sie Neu aus, um eine neue Compute-Instanz oder ein Cluster zu erstellen. Mit dieser Option wird die Seite Compute erstellen geöffnet. Fahren Sie mit dem nächsten Schritt fort, um Beschreibungen der zu konfigurierenden Einstellungen anzuzeigen.

Konfigurieren Sie für eine serverlose Berechnung oder einen neuen Compute alle erforderlichen (*) Einstellungen:

Die Konfigurationseinstellungen unterscheiden sich je nach Computetyp. In der folgenden Tabelle sind die verschiedenen Einstellungen zusammengefasst, die Sie möglicherweise konfigurieren müssen:

Feld BESCHREIBUNG Computename Geben Sie einen eindeutigen Namen ein, der Ihren Computekontext identifiziert. Location Geben Sie den Bereich für den Computer an. VM-Priorität Virtuelle Computer mit niedriger Priorität sind kostengünstiger, bieten jedoch keine garantierten Computeknoten. Typ des virtuellen Computers Wählen Sie CPU oder GPU als VM-Typ aus. Stufe der VM Wählen Sie die Priorität für Ihr Experiment aus. Größe des virtuellen Computers Wählen Sie die Größe für Ihren Computes aus. Min/Max.-Knoten Um ein Datenprofil zu erstellen, müssen Sie mindestens einen Knoten angeben. Geben Sie die maximale Anzahl von Knoten für Ihren Compute ein. Der Standardwert ist sechs Knoten für einen Azure Machine Learning Compute. Leerlauf in Sekunden vor dem Herunterskalieren Geben Sie den Leerlaufzeit vor dem automatischen Herunterskalieren des Clusters auf die minimale Knotenanzahl an. Erweiterte Einstellungen Mit diesen Einstellungen können Sie ein Benutzerkonto und ein vorhandenes virtuelles Netzwerk für Ihr Experiment konfigurieren. Nachdem Sie die erforderlichen Einstellungen konfiguriert haben, wählen Sie nach Bedarf Weiter oder Erstellen aus.

Das Erstellen einer neuen Computeressource kann einige Minuten dauern. Wenn die Erstellung abgeschlossen ist, wählen Sie Weiter aus.

Ausführen des Experiments und Anzeigen der Ergebnisse

Wählen Sie Fertig stellen aus, um das Experiment auszuführen. Der Vorgang zum Vorbereiten eines Experiments kann bis zu 10 Minuten dauern. Ein Ausführen von Trainingsaufträgen kann für jede Pipeline weitere 2 bis 3 Minuten beanspruchen. Wenn Sie angegeben haben, dass das RAI-Dashboard für das beste empfohlene Modell erstellt werden soll, kann dies bis zu 40 Minuten dauern.

Hinweis

Die Algorithmen, die bei Automated ML eingesetzt werden, weisen eine inhärente Zufälligkeit auf, die zu geringfügigen Abweichungen in der abschließenden metrischen Bewertung eines empfohlenen Modells führen kann, z. B. bei der Genauigkeit. Automated ML führt bei Bedarf auch Vorgänge an Daten wie Training-Test-Aufteilung, Training-Validierung-Aufteilung oder Kreuzvalidierung durch. Wenn Sie also ein Experiment mit denselben Konfigurationseinstellungen und derselben primären Metrik mehrmals durchführen, werden Sie aufgrund dieser Faktoren wahrscheinlich bei jedem Experiment eine Abweichung in der abschließenden metrischen Bewertung sehen.

Anzeigen von Details zum Experiment

Die Anzeige für Auftragsdetails wird mit der Registerkarte Details geöffnet. In dieser Anzeige wird eine Zusammenfassung des Experimentauftrags einschließlich einer Statusleiste oben neben der Auftragsnummer angezeigt.

Die Registerkarte Modelle enthält eine Liste der erstellten Modelle, wobei diese nach der Metrikbewertung (Metrikscore) geordnet sind. Standardmäßig steht das Modell, das anhand der ausgewählten Metrik die höchste Bewertung erhält, in der Liste ganz oben. Da der Trainingsauftrag weitere Modelle probiert, werden die ausgeführten Modelle der Liste hinzugefügt. Verwenden Sie diesen Ansatz, um einen schnellen Vergleich der Metriken für die bisher generierten Modelle zu erhalten.

Anzeigen der Details von Trainingsaufträgen

Lassen Sie zu jedem abgeschlossenen Modell Detailinformationen zum Trainingsauftrag anzeigen. Auf der Registerkarte Metriken können Sie Leistungsmetrikdiagramme für bestimmte Modelle anzeigen. Weitere Informationen finden Sie unter Auswerten der Ergebnisse des automatisierten Maschinellen Lernens. Auf dieser Seite finden Sie auch Details zu allen Eigenschaften des Modells sowie den zugehörigen Code, untergeordnete Aufträge und Bilder.

Ergebnisse des Remotetestauftrags anzeigen (Vorschau)

Wenn Sie bei der Einrichtung Ihres Experiments einen Testdatensatz angegeben oder sich für eine Aufteilung in Training und Test entschieden haben - im Formular Validieren und Testen -, testet Automated ML standardmäßig automatisch das empfohlene Modell. Infolgedessen berechnet die Automated ML Testmetriken, um die Qualität des empfohlenen Modells und seiner Vorhersagen zu bestimmen.

Wichtig

Das Testen Ihrer Modelle mit einem Testdatensatz zur Bewertung der generierten Modelle ist eine Previewfunktion. Diese Funktion ist eine experimentelle Previewfunktion, die jederzeit geändert werden kann.

Dieses Feature ist nicht für die folgenden Szenarien mit Automated ML verfügbar:

- Aufgaben für maschinelles Sehen

- Trainieren zahlreicher Modelle und hierarchischer Zeitreihenvorhersagen (Vorschau)

- Vorhersageaufgaben, für die neuronale Deep Learning-Netze (Deep Learning Neural Networks, DNNs) aktiviert sind

- Automatisierte ML-Aufträge von lokalen Computeressourcen oder Azure Databricks-Clustern

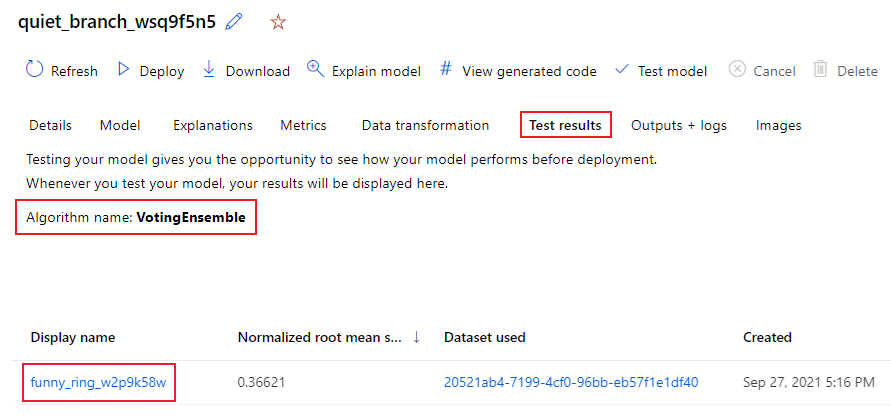

Führen Sie die folgenden Schritte aus, um die Testauftragsmetriken des empfohlenen Modells anzuzeigen:

Navigieren Sie im Studio zur Seite Modelle, und wählen Sie das beste Modell aus.

Wählen Sie die Registerkarte Testergebnisse (Vorschau) .

Wählen Sie den gewünschten Auftrag aus, und zeigen Sie die Registerkarte Metriken an:

Zeigen Sie die Testvorhersagen an, die zum Berechnen der Testmetriken verwendet werden, indem Sie die folgenden Schritte ausführen:

Am unteren Ende der Seite wählen Sie den Link unter Outputs Dataset, um den Datensatz zu öffnen.

Wählen Sie auf der Seite Datensätze die Registerkarte Durchsuchen, um die Vorhersagen des Testauftrags zu betrachten.

Die Vorhersagedatei kann auch auf der Registerkarte Ausgabe + Protokolle angezeigt und heruntergeladen werden. Erweitern Sie den Ordner Vorhersagen, um ihre prediction.csv-Datei zu suchen.

Beim Modelltestauftrag wird die Datei predictions.csv generiert, die in dem mit dem Arbeitsbereich erstellten Standarddatenspeicher gespeichert ist. Dieser Datenspeicher ist für alle Benutzer mit demselben Abonnement sichtbar. Testaufträge werden nicht für Szenarien empfohlen, in denen Informationen, die für den Testauftrag verwendet oder von diesem erstellt werden, vertraulich bleiben müssen.

Testen Sie ein bestehendes Automated ML-Modell (Vorschau)

Nach Abschluss Ihres Experiments können Sie die Modelle testen, die das Automated ML für Sie erstellt hat.

Wichtig

Das Testen Ihrer Modelle mit einem Testdatensatz zur Bewertung der generierten Modelle ist eine Previewfunktion. Diese Funktion ist eine experimentelle Previewfunktion, die jederzeit geändert werden kann.

Dieses Feature ist nicht für die folgenden Szenarien mit Automated ML verfügbar:

- Aufgaben für maschinelles Sehen

- Trainieren zahlreicher Modelle und hierarchischer Zeitreihenvorhersagen (Vorschau)

- Vorhersageaufgaben, für die neuronale Deep Learning-Netze (Deep Learning Neural Networks, DNNs) aktiviert sind

- Automatisierte ML-Aufträge von lokalen Computeressourcen oder Azure Databricks-Clustern

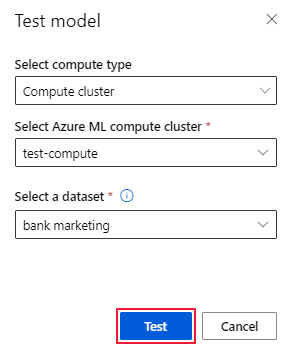

Wenn Sie ein anderes durch Automated ML generiertes Modell und nicht das empfohlene Modell testen möchten, führen Sie diese Schritte aus:

Wählen Sie einen vorhandenen Automated ML-Experimentauftrag aus.

Browsen Sie zur Registerkarte Modelle des Auftrags, und wählen Sie das fertige Modell aus, das Sie testen möchten.

Wählen Sie auf der Seite Modell Details die Option Testmodell (Vorschau), um die Fensterfläche Testmodell zu öffnen.

Wählen Sie im Bereich Testmodell den Rechencluster und einen Testdatensatz, den Sie für Ihren Testauftrag verwenden möchten.

Wählen Sie die Option Test aus. Das Schema des Testdatensatzes sollte mit dem Trainingsdatensatz übereinstimmen, aber die Zielspalte ist optional.

Nach erfolgreicher Erstellung eines Modellprüfauftrags wird auf der Seite Details eine Erfolgsmeldung angezeigt. Wählen Sie die Registerkarte Testergebnisse, um den Fortschritt des Auftrags zu sehen.

Um die Ergebnisse des Testauftrags anzuzeigen, öffnen Sie die Seite Details, und führen Sie die Schritte im Abschnitt Anzeigen von Remotetestauftragsergebnissen (Vorschau) aus.

Dashboard für verantwortungsvolle KI (Vorschau)

Um Ihr Modell besser zu verstehen, können Sie mit dem verantwortungsvollen KI-Dashboard verschiedene Einblicke in Ihr Modell erhalten. Mit dieser Benutzeroberfläche können Sie Ihr bestes Automated ML-Modell auswerten und debuggen. Das verantwortungsvolle KI-Dashboard bewertet Modellfehler und Fairnessprobleme, diagnostiziert die Gründe für diese Fehler, indem es Ihre Trainings- und/oder Testdaten auswertet und die Erklärungen des Modells beobachtet. Diese Erkenntnisse können Ihnen dabei helfen, Vertrauen in Ihr Modell aufzubauen und die Prüfungsverfahren zu bestehen. Verantwortungsvolle KI-Dashboards können nicht für ein bestehendes Automated ML-Modell erstellt werden. Das Dashboard wird nur für das am besten empfohlene Modell erstellt, wenn ein neuer Automated ML-Auftrag erstellt wird. Benutzer sollten weiterhin Modellerklärungen (Vorschau) verwenden, bis die Unterstützung für bestehende Modelle bereitgestellt wird.

Generieren Sie ein verantwortungsvolles KI-Dashboard für ein bestimmtes Modell, indem Sie die folgenden Schritte ausführen:

Wenn Sie einen Automated ML-Auftrag einreichen, gehen Sie zum Abschnitt Aufgabeneinstellungen in dem linken Menü und wählen Sie die Option Zusätzliche Konfigurationseinstellungen anzeigen aus.

Wählen Sie auf der Seite Zusätzliche Konfiguration die Option Bestes Modell erläutern aus:

Wechseln Sie zur Registerkarte Compute und wählen Sie die Option Serverless für den Compute aus:

Navigieren Sie nach Abschluss des Vorgangs zur Seite Modelle Ihres Automated ML-Auftrags, die eine Liste Ihrer trainierten Modelle enthält. Wählen Sie den Link Verantwortungsvolle KI-Dashboard anzeigen aus:

Das Dashboard „Verantwortungsvolle KI“ wird für das ausgewählte Modell angezeigt:

Auf dem Dashboard sehen Sie vier Komponenten, die für das beste Modell Ihres Automated ML aktiviert sind:

Komponente Was zeigt die Komponente an? Erläuterung zum Diagramm Fehleranalyse Verwenden Sie die Fehleranalyse, wenn Sie Folgendes erreichen müssen:

- Ein tiefes Verständnis dafür gewinnen, wie Modellfehler über ein Dataset und über mehrere Eingabe- und Featuredimensionen verteilt sind.

- Die aggregierten Leistungsmetriken aufschlüsseln, um automatisch fehlerhafte Kohorten zu erkennen und gezielte Maßnahmen zur Risikominderung zu ergreifen.Fehleranalysediagramme Modellübersicht und Fairness Verwenden Sie diese Komponente für Folgendes:

- Gewinnen Sie einen tiefen Einblick in die Leistung Ihres Modells über verschiedene Datenkohorten hinweg.

- Verstehen Sie die Probleme mit der Fairness Ihres Modells, indem Sie sich die Ungleichheitsmetriken ansehen. Mit diesen Metriken können Sie das Verhalten des Modells in Untergruppen bewerten und vergleichen, die anhand von sensitiven (oder nicht sensitiven) Merkmalen identifiziert wurden.Modellübersicht und Fairnessdiagramme Modellerklärungen Verwenden Sie die Komponente zur Modellerläuterung, um verständliche Beschreibungen der Vorhersagen eines Modells für maschinelles Lernen zu erstellen, indem Sie Folgendes betrachten:

- Globale Erläuterungen: Welche Merkmale beeinflussen beispielsweise das Gesamtverhalten eines Kreditvergabemodells?

- Lokale Erklärungen: Warum wurde beispielsweise der Kreditantrag eines Kunden genehmigt oder abgelehnt?Diagramme zur Modellerklärbarkeit Datenanalyse Verwenden Sie die Datenanalyse, wenn Sie Folgendes erreichen müssen:

- Erkunden Ihrer Datasetstatistiken durch Auswahl verschiedener Filter, um Ihre Daten in verschiedene Dimensionen zu unterteilen (auch als Kohorten bezeichnet).

- Verstehen der Verteilung Ihres Datasets auf verschiedene Kohorten und Featuregruppen.

- Ermitteln, ob Ihre Ergebnisse in Bezug auf Fairness, Fehleranalyse und Kausalität (die von anderen Dashboardkomponenten abgeleitet wurden) ein Ergebnis der Verteilung Ihres Datasets sind.

- Entscheiden, in welchen Bereichen mehr Daten gesammelt werden sollen, um Fehler aufgrund von Repräsentationsproblemen, Bezeichnungsrauschen, Featurerauschen, Bezeichnungsverzerrungen und ähnlichen Faktoren zu minimieren.Data Explorer Diagramme Sie können außerdem Kohorten erstellen (Untergruppen von Datenpunkten, die bestimmte Merkmale gemeinsam haben), um Ihre Analyse der einzelnen Komponenten auf verschiedene Kohorten zu konzentrieren. Der Name der aktuell auf das Dashboard angewendeten Kohorte wird immer oben links auf Ihrem Dashboard angezeigt. Die Standardansicht in Ihrem Dashboard ist Ihr gesamtes Dataset, mit der Überschrift Alle Daten (standardmäßig). Weitere Informationen finden Sie unter Globale Steuerelemente für Ihr Dashboard.

Bearbeiten und Übermitteln von Aufträgen (Vorschau)

In Szenarien, in denen Sie ein neues Experiment basierend auf den Einstellungen eines vorhandenen Experiments erstellen möchten, stellt Automated ML die Option Bearbeiten und Übermitteln in der Studio-Benutzeroberfläche bereit. Diese Funktionalität ist auf Experimente beschränkt, die über die Studio-Benutzeroberfläche initiiert wurden, und erfordert, dass das Datenschema für das neue Experiment mit dem des ursprünglichen Experiments übereinstimmt.

Wichtig

Die Möglichkeit, ein neues Experiment basierend auf einem vorhandenen Experiment zu kopieren, zu bearbeiten und zu übermitteln, ist eine Previewfunktion. Diese Funktion ist eine experimentelle Previewfunktion, die jederzeit geändert werden kann.

Mit der Option Bearbeiten und übermitteln wird der Assistent Erstellen eines neuen Automated ML-Auftrags geöffnet, in dem die Einstellungen für Daten, Compute und Experimente bereits ausgefüllt sind. Sie können die Optionen auf jeder Registerkarte im Assistenten konfigurieren und die Auswahl nach Bedarf für Ihr neues Experiment bearbeiten.

Bereitstellen Ihres Modells

Nachdem Sie über das beste Modell verfügen, können Sie das Modell als Webdienst bereitstellen, um neue Daten vorherzusagen.

Hinweis

Um ein Modell bereitzustellen, das über das automl-Paket mit dem Python SDK generiert wird, müssen Sie Ihr Modell für den Arbeitsbereich registrieren).

Nachdem Sie das Modell registriert haben, können Sie das Modell im Studio suchen, indem Sie im linken Menü Modelle auswählen. Auf der Modellübersichtsseite können Sie die Option Bereitstellen auswählen und in diesem Abschnitt mit Schritt 2 fortfahren.

Automated ML hilft Ihnen beim Bereitstellen des Modells, ohne Code zu schreiben.

Initiieren Sie die Bereitstellung mithilfe einer der folgenden Methoden:

Stellen Sie das beste Modell mit den von Ihnen definierten Metrikkriterien bereit:

Wählen Sie nach Abschluss des Experiments Auftrag 1 aus und navigieren Sie zur übergeordneten Auftragsseite.

Wählen Sie das im Abschnitt Beste Modellzusammenfassung aufgeführte Modell aus und wählen Sie dann Bereitstellen aus.

Bereitstellen einer bestimmten Modelliteration aus diesem Experiment:

- Wählen Sie das gewünschte Modell auf der Registerkarte Modelle aus, und wählen Sie dann Bereitstellen aus.

Füllen Sie den Bereich Modell bereitstellen auf:

Feld Wert Name Geben Sie einen eindeutigen Namen für die Bereitstellung ein. Beschreibung Geben Sie eine Beschreibung ein, um den Bereitstellungszweck besser zu identifizieren. Computetyp Wählen Sie den Typ des Endpunkts, den Sie bereitstellen möchten: Azure Kubernetes Service (AKS) oder Azure Containerinstanz (ACI). Computename (Gilt nur für AKS) Wählen Sie den Namen des AKS-Clusters aus, für das Sie bereitstellen möchten. Aktivieren der Authentifizierung Wählen Sie diese Option aus, um eine token- oder schlüsselbasierte Authentifizierung zu ermöglichen. Benutzerdefinierte Bereitstellungsressourcen verwenden Aktivieren Sie benutzerdefinierte Ressourcen, wenn Sie Ihr eigenes Bewertungsskript und Ihre eigene Umgebungsdatei hochladen möchten. Andernfalls stellt die Automated ML diese Ressourcen standardmäßig für Sie bereit. Weitere Informationen finden Sie unter Bereitstellen und Bewerten eines Machine Learning-Modells mithilfe eines Onlineendpunkts. Wichtig

Der Name muss 1-32 Zeichen umfassen. Der Name muss mit Alphanumerik beginnen und enden und kann Bindestriche, Unterstriche, Punkte und Alphanumerik dazwischen enthalten. Leerzeichen sind nicht zulässig.

Das Menü Erweitert enthält Standard-Bereitstellungsfeatures wie Datensammlung und Einstellungen für die Ressourcenauslastung. Sie können die Optionen in diesem Menü verwenden, um diese Standardwerte außer Kraft zu setzen. Weitere Informationen finden Sie unter Online-Endpunkte überwachen.

Klicken Sie auf Bereitstellen. Die Bereitstellung kann bis zu 20 Minuten dauern.

Nach dem Start der Bereitstellung wird die Registerkarte Modellzusammenfassung geöffnet. Sie können den Status der Bereitstellung im Abschnitt Bereitstellungsstatus anzeigen.

Nun haben Sie einen einsatzfähigen Webdienst, mit dem Vorhersagen generiert werden können! Sie können die Vorhersagen testen, indem Sie den Dienst aus den End-to-End-KI-Beispielen in Microsoft Fabric abfragen.