KI-App-Vorlagen

In diesem Abschnitt der Dokumentation werden die KI-App-Vorlagen und zugehörige Artikel vorgestellt, die diese Vorlagen verwenden, um zu veranschaulichen, wie wichtige Entwickleraufgaben ausgeführt werden. KI-App-Vorlagen bieten Ihnen gut gepflegte, einfach bereitzustellende Referenzimplementierungen, die helfen, einen qualitativ hochwertigen Ausgangspunkt für Ihre KI-Apps zu gewährleisten.

Es gibt zwei Kategorien von KI-App-Vorlagen, Bausteine und End-to-End-Lösungen. In den folgenden Abschnitten werden einige der wichtigsten Vorlagen in jeder Kategorie für die Programmiersprache vorgestellt, die Sie oben in diesem Artikel ausgewählt haben. Eine umfassendere Liste einschließlich dieser und anderer Vorlagen finden Sie in den KI-App-Vorlagen im KI-App-Vorlagenkatalog.

Bausteine

Bausteine sind kleinere Beispiele, die sich jeweils auf bestimmte Szenarien und Aufgaben konzentrieren. Die meisten Bausteine veranschaulichen Funktionen, die die End-to-End-Lösung für eine Chat-App nutzen, die Ihre eigenen Daten verwendet.

| Baustein | Beschreibung |

|---|---|

| Lastenausgleich mit Azure Container Apps | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Dieser Ansatz verwendet Azure-Container-Apps, um drei Azure OpenAI-Endpunkte zu erstellen, sowie einen primären Container, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

| Baustein | Beschreibung |

|---|---|

| Konfigurieren der Dokumentsicherheit für die Chat-App | Wenn Sie eine Chat-Anwendung mithilfe des RAG-Musters mit Ihren eigenen Daten erstellen, stellen Sie sicher, dass jeder Benutzer basierend auf seinen Berechtigungen eine Antwort erhält. Ein autorisierter Benutzer sollte Zugriff auf Antworten haben, die in den Dokumenten der Chat-App enthalten sind. Ein nicht autorisierter Benutzer sollte keinen Zugriff auf Antworten von gesicherten Dokumenten haben, für die er keine Anzeigeberechtigung hat. |

| Evaluieren von Antworten in Chat-Apps | Erfahren Sie, wie Sie die Antworten einer Chat-App anhand einer Reihe von korrekten oder idealen Antworten (als „Ground Truth“ bezeichnet) evaluieren können. Wenn Sie Ihre Chat-Anwendung auf eine Weise ändern, die sich auf die Antworten auswirkt, führen Sie eine Evaluierung durch, um die Änderungen zu vergleichen. Diese Demoanwendung bietet Tools, die Sie sofort verwenden können, um die Ausführung von Evaluierungen zu vereinfachen. |

| Lastenausgleich mit Azure Container Apps | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Dieser Ansatz verwendet Azure-Container-Apps, um drei Azure OpenAI-Endpunkte zu erstellen, sowie einen primären Container, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

| Lastenausgleich mit API Management | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Bei diesem Konzept wird Azure API Management verwendet, um drei Azure OpenAI-Endpunkte sowie einen primären Container zu erstellen, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

| Lasttest der Python-Chat-App mit Locust | Lernen Sie den Prozess kennen, um Lasttests für eine Python-Chat-Anwendung mithilfe des RAG-Musters mit Locust durchzuführen, einem beliebten Open-Source-Load Testing-Tool. Das Hauptziel eines Lasttests besteht darin, sicherzustellen, dass die erwartete Auslastung ihrer Chatanwendung das aktuelle Azure OpenAI Transactions Per Minute (TPM)-Kontingent nicht überschreitet. Durch die Simulation des Benutzerverhaltens unter hoher Last können Sie potenzielle Engpässe und Skalierbarkeitsprobleme in Ihrer Anwendung erkennen. |

| Sichern Ihrer KI-App mit schlüsselloser Authentifizierung | Erfahren Sie, wie Sie Ihre Python Azure OpenAI-Chatanwendung mit schlüsselloser Authentifizierung sichern können. Anwendungsanforderungen an die meisten Azure-Dienste sollten mit schlüssellosen oder kennwortlosen Verbindungen authentifiziert werden. Die schlüssellose Authentifizierung bietet verbesserte Verwaltungs- und Sicherheitsvorteile gegenüber dem Kontoschlüssel, da kein Schlüssel (und keine Verbindungszeichenfolge) zum Speichern vorhanden ist. |

| Baustein | Beschreibung |

|---|---|

| Lastenausgleich mit Azure Container Apps | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Dieser Ansatz verwendet Azure-Container-Apps, um drei Azure OpenAI-Endpunkte zu erstellen, sowie einen primären Container, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

| Baustein | Beschreibung |

|---|---|

| Evaluieren von Antworten in Chat-Apps | Erfahren Sie, wie Sie die Antworten einer Chat-App anhand einer Reihe von korrekten oder idealen Antworten (als „Ground Truth“ bezeichnet) evaluieren können. Wenn Sie Ihre Chat-Anwendung auf eine Weise ändern, die sich auf die Antworten auswirkt, führen Sie eine Evaluierung durch, um die Änderungen zu vergleichen. Diese Demoanwendung bietet Tools, die Sie sofort verwenden können, um die Ausführung von Evaluierungen zu vereinfachen. |

| Lastenausgleich mit Azure Container Apps | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Dieser Ansatz verwendet Azure-Container-Apps, um drei Azure OpenAI-Endpunkte zu erstellen, sowie einen primären Container, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

| Lastenausgleich mit API Management | Erfahren Sie, wie Sie Ihrer Anwendung einen Lastenausgleich hinzufügen, um die Chat-App über die Azure OpenAI-Token- und Modellkontingentgrenzen hinaus zu erweitern. Bei diesem Konzept wird Azure API Management verwendet, um drei Azure OpenAI-Endpunkte sowie einen primären Container zu erstellen, um eingehenden Datenverkehr an einen der drei Endpunkte zu leiten. |

End-to-End-Lösungen

End-to-End-Lösungen sind umfassende Referenzbeispiele, einschließlich Dokumentation, Quellcode und Bereitstellung, damit Sie sie für Ihre eigenen Zwecke übernehmen und erweitern können.

Chatten mit Ihren Daten mit Azure OpenAI und Azure KI-Suche mit .NET

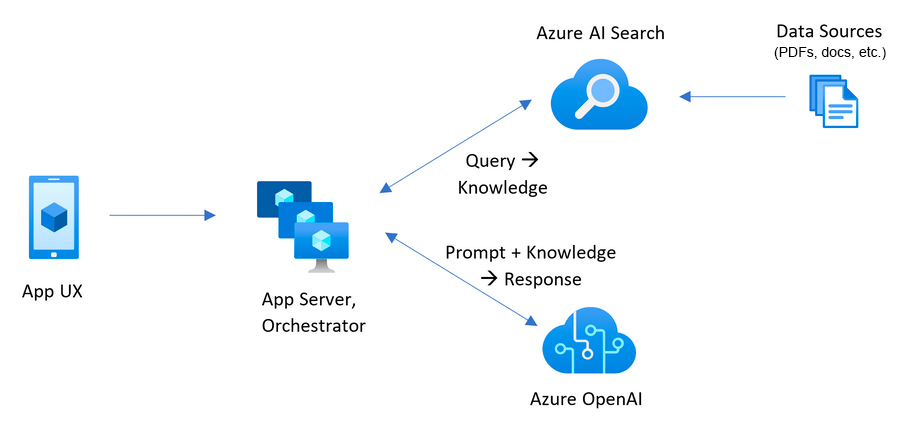

Diese Vorlage bietet eine vollständige End-to-End-Lösung, die das in Azure ausgeführte RAG-Muster (Retrieval-Augmented Generation) veranschaulicht. Sie verwendet Azure KI-Suche für das Abrufen und große Azure OpenAI-Sprachmodelle, um ChatGPT-Stil und Q&A-Umgebungen zu ermöglichen.

Informationen zu den ersten Schritten mit dieser Vorlage finden Sie unter Erste Schritte mit dem Chat mithilfe Ihres eigenen Datenbeispiels für .NET. Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository azure-search-openai-demo-csharp.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps Azure-Funktionen |

Azure OpenAI Maschinelles Sehen in Azure Azure-Formularerkennung Azure KI Cognitive Search Azure Storage |

GPT 3.5 Turbo GPT 4.0 |

Contoso Chat Retail-Copilot mit .NET und Semantic Kernel

Diese Vorlage implementiert Contoso Outdoors, einen konzeptionellen Store, der auf Outdoor-Ausrüstung für Wander- und Campingliebhaber spezialisiert ist. Dieser virtuelle Store verbessert die Kundenbindung und den Vertriebssupport durch einen intelligenten Chat-Agenten. Dieser Agent wird durch das RAG-Muster (Retrieval Augmented Generation) innerhalb des Microsoft Azure AI-Stacks unterstützt, das mit semantischer Kernel- und Prompty-Unterstützung erweitert ist.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository contoso-chat-csharp-prompty.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps |

Azure OpenAI Microsoft Entra ID Azure Managed Identity Azure Monitor Azure KI Cognitive Search Azure AI Foundry Azure SQL Azure Storage |

GPT 3.5 Turbo GPT 4.0 |

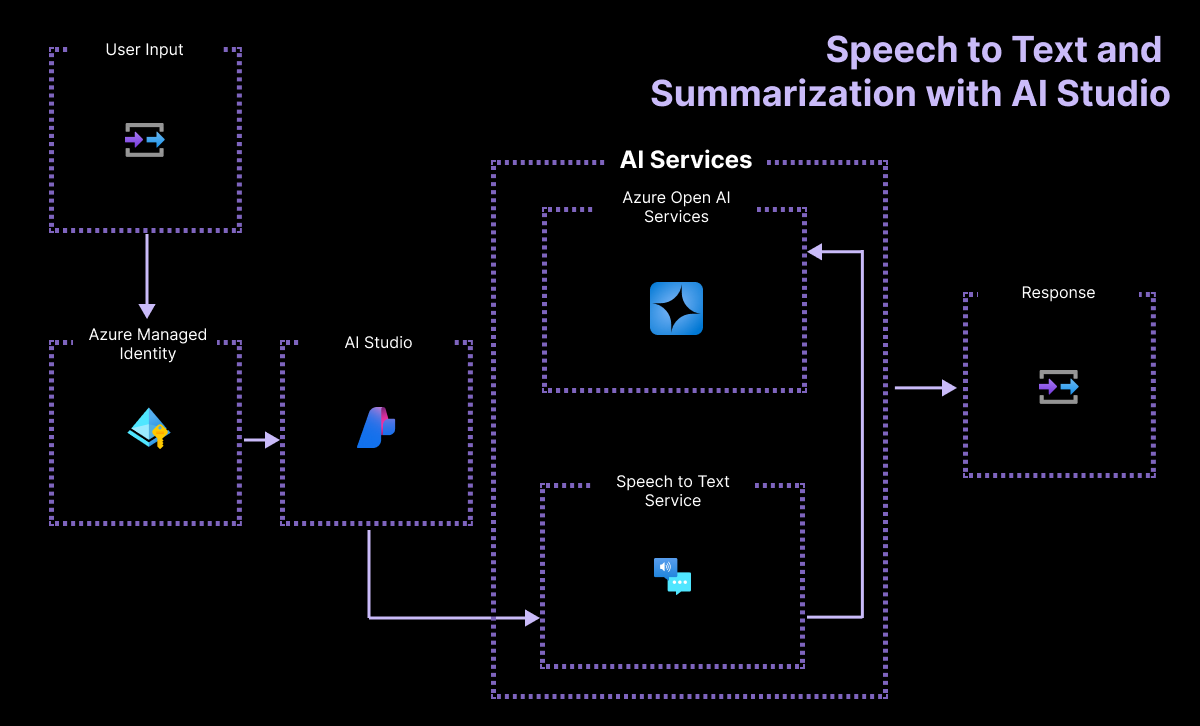

Prozessautomatisierung mit Spracherkennung und Zusammenfassung mit .NET und GPT 3.5 Turbo

Bei dieser Vorlage handelt es sich um eine Prozessautomatisierungslösung, die Probleme entgegennimmt, die von den Arbeitskräften im Außendienst und in der Fertigung eines Unternehmens namens Contoso Manufacturing, einem Hersteller von Autobatterien, geliefert werden. Die Probleme werden von den Mitarbeitern entweder per Mikrofon gemeldet oder vorab als Audiodateien aufgezeichnet. Die Lösung übersetzt Audioeingaben von Sprache zu Text und verwendet dann einen LLM- und Prompty- oder Eingabeaufforderungsfluss, um das Problem zusammenzufassen und die Ergebnisse in einem von der Lösung angegebenen Format zurückzugeben.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository summarization-openai-csharp-prompty.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps | Spracherkennung Zusammenfassung Azure OpenAI |

GPT 3.5 Turbo |

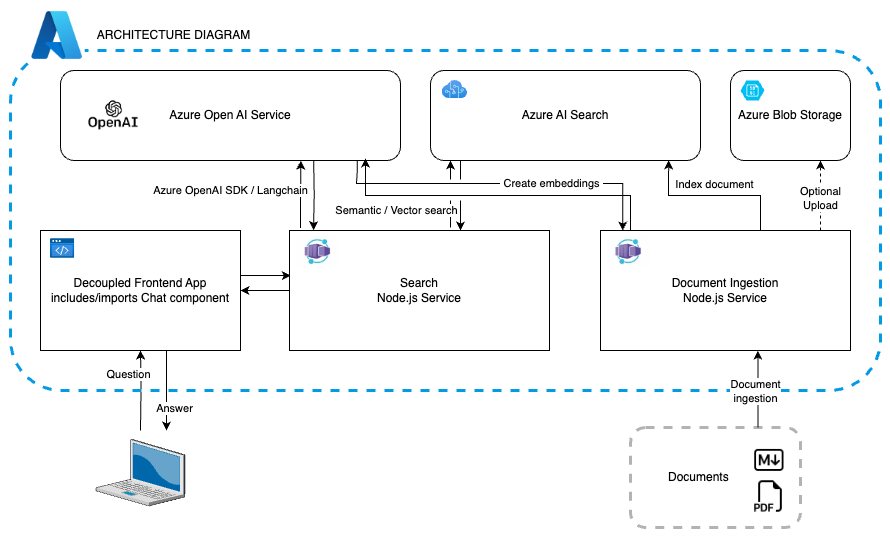

Chatten mit Ihren Daten mit Azure OpenAI und Azure KI-Suche mit Python

Diese Vorlage bietet eine vollständige End-to-End-Lösung, die das in Azure ausgeführte RAG-Muster (Retrieval-Augmented Generation) veranschaulicht. Es verwendet Azure AI Search für das Abrufen und Azure OpenAI große Sprachmodelle, um ChatGPT-Stil und Frage- und Antwortfunktionen (Q&A) zu unterstützen.

Informationen zu den ersten Schritten mit dieser Vorlage finden Sie unter Erste Schritte mit dem Chat mithilfe Ihres eigenen Datenbeispiels für Python. Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository azure-search-openai-demo.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps | Azure OpenAI Azure KI Cognitive Search Azure Blob Storage Azure Monitor Azure Dokument Intelligenz |

GPT 3.5 Turbo GPT 4 GPT 4o GPT 4o-mini |

Multi-Modal Creative Writing Copilot mit DALL-E

Diese Vorlage ist eine Multi-Agent-Lösung zum kreativen Schreiben, die Benutzern beim Schreiben von Artikeln helfen. Sie veranschaulicht, wie KI-Agenten erstellt und mit ihnen gearbeitet wird, die von Azure OpenAI unterstützt werden.

Sie hat folgenden Inhalt:

- Eine Flask-App, die einen Artikel und eine Anweisung von einem Benutzer verwendet.

- Ein Recherche-Agent, der die Bing Search-API verwendet, um den Artikel zu recherchieren.

- Ein Produkt-Agent, der Azure AI Search verwendet, um eine semantische Ähnlichkeitssuche für verwandte Produkte aus einem Vektorspeicher durchzuführen.

- Ein Writer Agent, um die Recherche- und Produktinformationen in einem hilfreichen Artikel zu kombinieren.

- Ein Editor-Agent, um den Für den Benutzer vorgestellten Artikel zu verfeinern.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository agent-openai-python-prompty.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Registry Azure Kubernetes |

Azure OpenAI Bing-Suche Azure Managed Identity Azure Monitor Azure KI Cognitive Search Azure AI Foundry |

GPT 3.5 Turbo GPT 4.0 DALL-E |

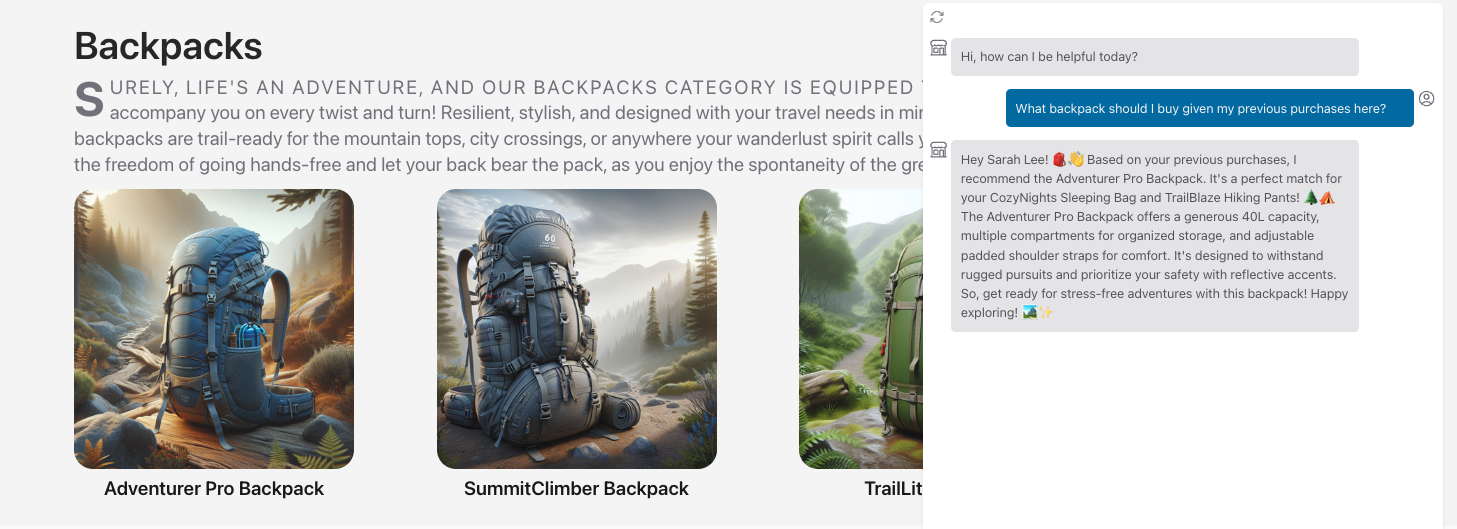

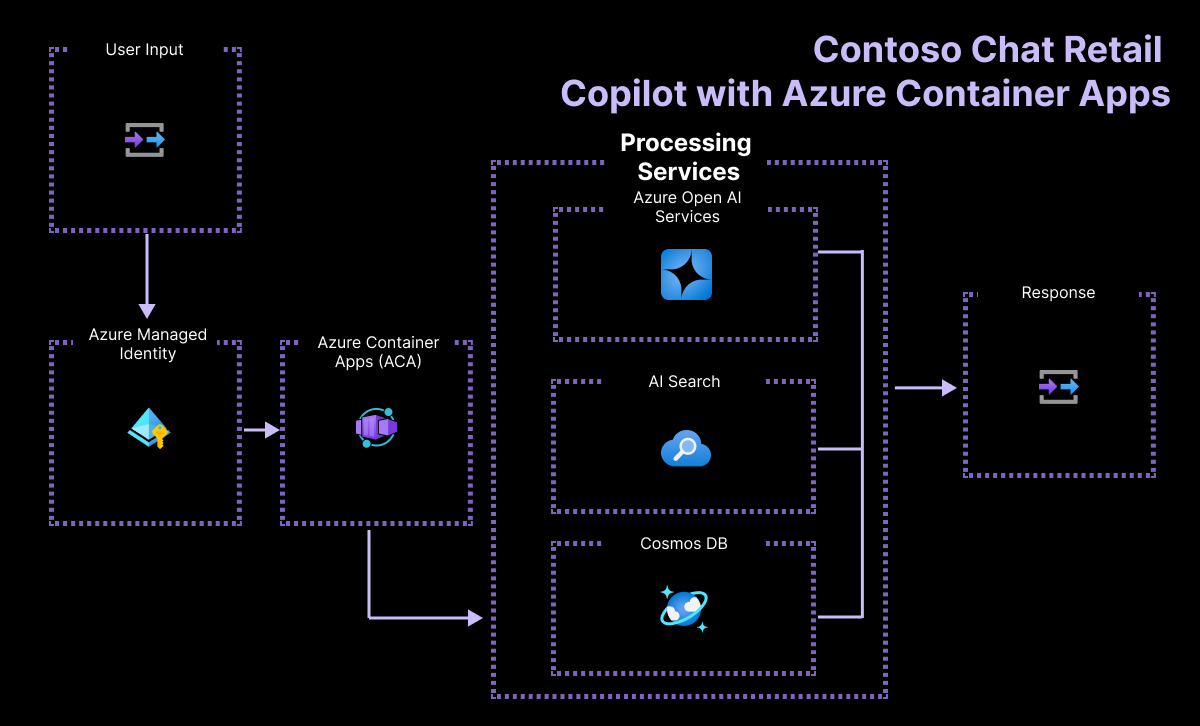

Contoso Chat Retail Copilot mit Azure AI Foundry

Diese Vorlage implementiert Contoso Chat – eine Copilot-Lösung für den Einzelhandel für Contoso Outdoor, die ein Entwurfsmuster der erweiterten Generation verwendet, um Chatbotantworten in den Produkt- und Kundendaten des Einzelhändlers zu ergründen. Kunden können Fragen von der Website in natürlicher Sprache stellen und relevante Antworten mit potenziellen Empfehlungen basierend auf ihrem Kaufverlauf erhalten – mit verantwortungsvollen KI-Praktiken, um Die Antwortqualität und -sicherheit zu gewährleisten.

Diese Vorlage veranschaulicht den End-to-End-Workflow (GenAIOps) zum Erstellen eines RAG-basierten Copilot-Codes zuerst mit Azure AI und Prompty. Wenn Sie dieses Beispiel untersuchen und bereitstellen, lernen Sie Folgendes:

- Ideen und schnelles Durchlaufen von App-Prototypen mithilfe von Prompty

- Bereitstellen und Verwenden von Azure OpenAI-Modellen für Chats, Einbettungen und Auswertungen

- Verwenden von Azure AI Search (Indizes) und Azure Cosmos DB (Datenbanken) für Ihre Daten

- Bewerten von Chatantworten zur Qualität mithilfe von KI-unterstützten Auswertungsflüssen

- Hosten der Anwendung als FastAPI-Endpunkt, der in Azure-Container-Apps bereitgestellt wird

- Bereitstellen und Bereitstellen der Lösung mithilfe der Azure Developer CLI

- Unterstützen von verantwortungsvollen KI-Praktiken mit Inhaltssicherheits- und Bewertungen

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository contoso-chat.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps |

Azure OpenAI Azure KI Cognitive Search Azure AI Foundry Aufforderung Azure Cosmos DB |

GPT 3.5 Turbo GPT 4.0 Managed Integration Runtime (MIR) |

Prozessautomatisierung mit Sprache zu Text und Zusammenfassung mit Azure AI Foundry

Diese Vorlage erstellt eine webbasierte App, mit der Mitarbeiter in einem Unternehmen namens Contoso Manufacturing Probleme über Text oder Sprache melden können. Die Audioeingabe wird in Text übersetzt und dann zusammengefasst, um wichtige Informationen hervorzuheben, und der Bericht wird an die entsprechende Abteilung gesendet.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu lesen, lesen Sie das GitHub-Repository "summaryzation-openai-python-promptflow ".

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps | Azure AI Foundry Spracherkennungsservice Aufforderung Managed Integration Runtime (MIR) |

GPT 3.5 Turbo |

Assistant API Analytics Copilot mit Python und Azure AI Foundry

Diese Vorlage ist eine Assistenten-API zum Chatten mit tabellarischen Daten und für Analysen in natürlicher Sprache.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository assistant-data-openai-python-promptflow ".

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Machine Learning-Dienst | Azure KI Cognitive Search Azure AI Foundry Managed Integration Runtime (MIR) Azure OpenAI |

GPT 3.5 Turbo GPT 4 |

Chatten mit Ihren Daten mit Azure OpenAI und Azure KI-Suche mit Java

Diese Vorlage bietet eine vollständige End-to-End-Lösung, die das in Azure ausgeführte RAG (Retrieval-Augmented Generation)-Muster veranschaulicht. Sie verwendet Azure KI-Suche für das Abrufen und große Azure OpenAI-Sprachmodelle, um ChatGPT-Stil und Q&A-Umgebungen zu ermöglichen.

Informationen zu den ersten Schritten mit dieser Vorlage finden Sie unter Erste Schritte mit dem Chat mithilfe Ihres eigenen Datenbeispiels für Java. Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository azure-search-openai-demo-java.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure App Service Azure Container Apps Azure Kubernetes Service |

Azure OpenAI Azure KI Cognitive Search Azure Dokument Intelligenz Azure Storage Azure App Insights Azure Service Bus Azure Event Grid |

gpt-35-turbo |

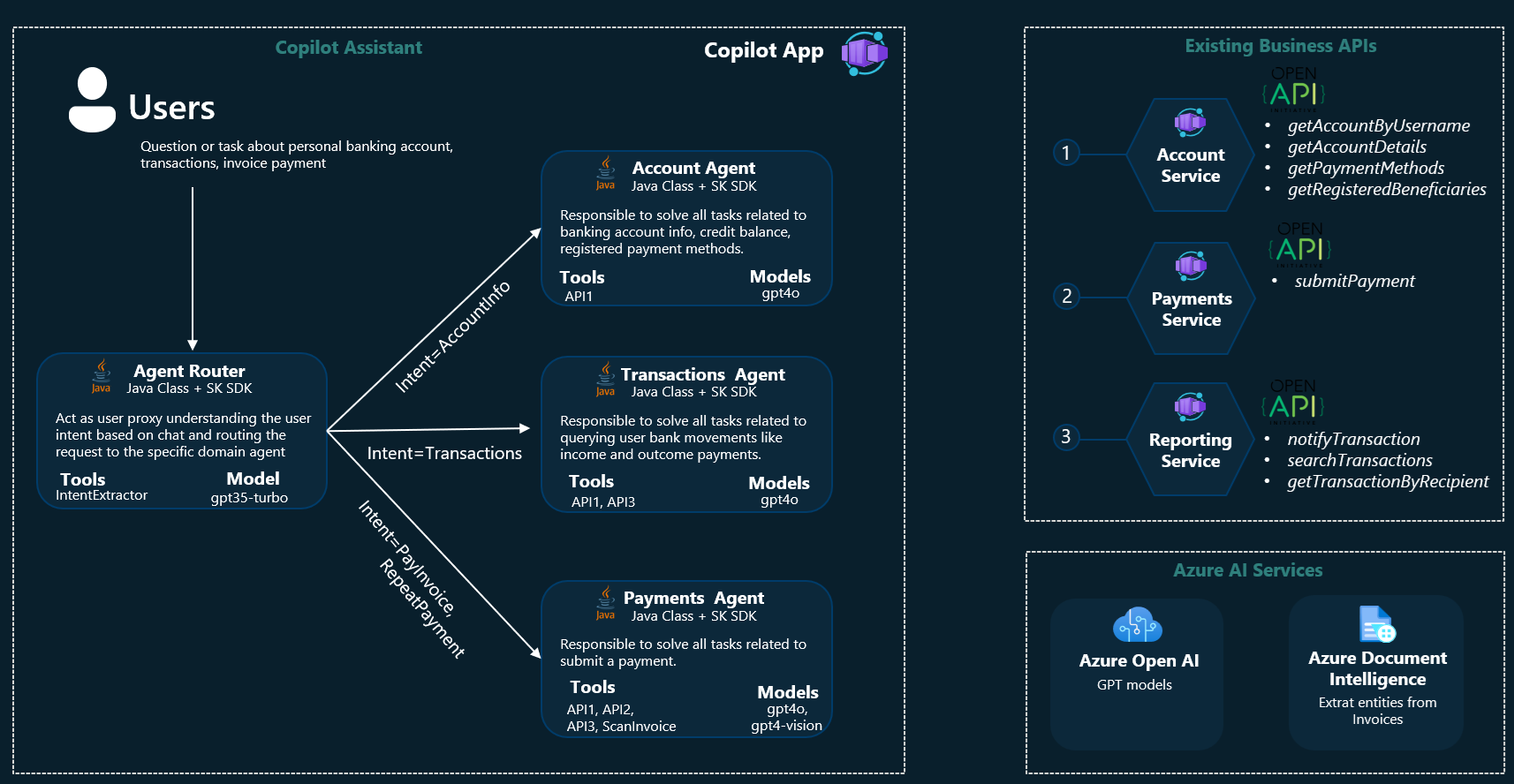

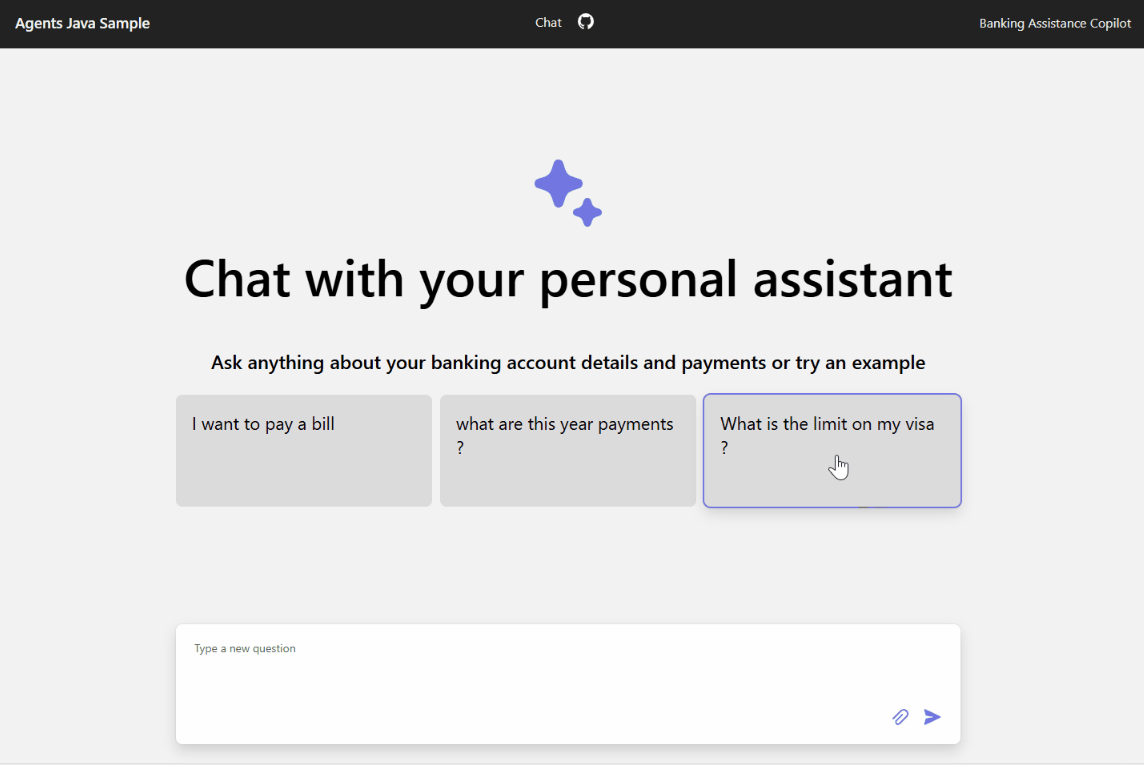

Multi Agents Banking Assistant mit Java und Semantic Kernel

Dieses Projekt ist als Proof of Concept (PoC) konzipiert, um den innovativen Bereich der generativen KI im Kontext von Multi-Agenten-Architekturen zu entdecken. Durch den Einsatz von Java und dem Microsoft Semantic Kernel KI Orchestrierung Framework wollen wir eine Chat-Web-App entwickeln, um die Machbarkeit und Zuverlässigkeit des Einsatzes von generativen KI-Agenten zur Transformation der Benutzererfahrung von Web-Klicks in natürlichsprachliche Konversationen zu demonstrieren und gleichzeitig die Wiederverwendung der vorhandenen Workload-Daten und APIs zu maximieren.

Der Hauptanwendungsfall dreht sich um einen persönlichen Bankassistenten, der die Art und Weise revolutionieren soll, wie Benutzer mit ihren Kontoinformationen, der Historie ihrer Transaktionen und den Zahlungsfunktionen interagieren. Mithilfe der Leistungsfähigkeit von generative KI in einer Multi-Agent-Architektur soll dieser Assistent eine nahtlose, konversationelle Schnittstelle bieten, über die Benutzer mühelos auf ihre Finanzdaten zugreifen und diese verwalten können.

Im Datenordner sind Beispiele für Rechnungen enthalten, damit Sie die Funktionen für Zahlungen leicht entdecken können. Der mit Tools zur optischen Zeichenerkennung (OCR) ausgestattete Zahlungsagent (Azure Document Intelligence) führt das Gespräch mit dem Benutzer, um die Rechnungsdaten zu extrahieren und den Zahlungsvorgang einzuleiten. Andere gefälschte Kontodaten - wie Transaktionsdetails, Zahlungsmethoden und Kontostände - sind ebenfalls verfügbar und können vom Benutzer abgefragt werden. Alle Daten und Dienste werden als externe REST-APIs offengelegt und von den Agenten konsumiert, um dem Benutzer die angefragten Informationen zu liefern.

Um auf den Quellcode zuzugreifen und ausführliche Details über die Vorlage zu lesen, besuchen Sie das agent-openai-java-banking-assistant GitHub-Repo.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps | Azure OpenAI Azure Dokument Intelligenz Azure Storage Azure Monitor |

gpt-4o gpt-4o-mini |

Chatten mit Ihren Daten mit Azure OpenAI und Azure KI-Suche mit JavaScript

Diese Vorlage bietet eine vollständige End-to-End-Lösung, die das in Azure ausgeführte RAG-Muster (Retrieval-Augmented Generation) veranschaulicht. Sie verwendet Azure KI-Suche für das Abrufen und große Azure OpenAI-Sprachmodelle, um ChatGPT-Stil und Q&A-Umgebungen zu ermöglichen.

Informationen zu den ersten Schritten mit dieser Vorlage finden Sie unter Erste Schritte mit dem Chat mithilfe Ihres eigenen Datenbeispiels für JavaScript. Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository azure-search-openai-javascript.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Container Apps Azure Static Web Apps |

Azure OpenAI Azure KI Cognitive Search Azure Storage Azure Monitor |

text-embedding-ada-002 |

Azure OpenAI-Chat-Front-End

Diese Vorlage ist eine minimale OpenAI-Chat-Webkomponente, die mit jeder Back-End-Implementierung als Client eingebunden werden kann.

Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository azure-openai-chat-frontend.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Static Web Apps | Azure KI Cognitive Search Azure OpenAI |

GPT 3.5 Turbo GPT4 |

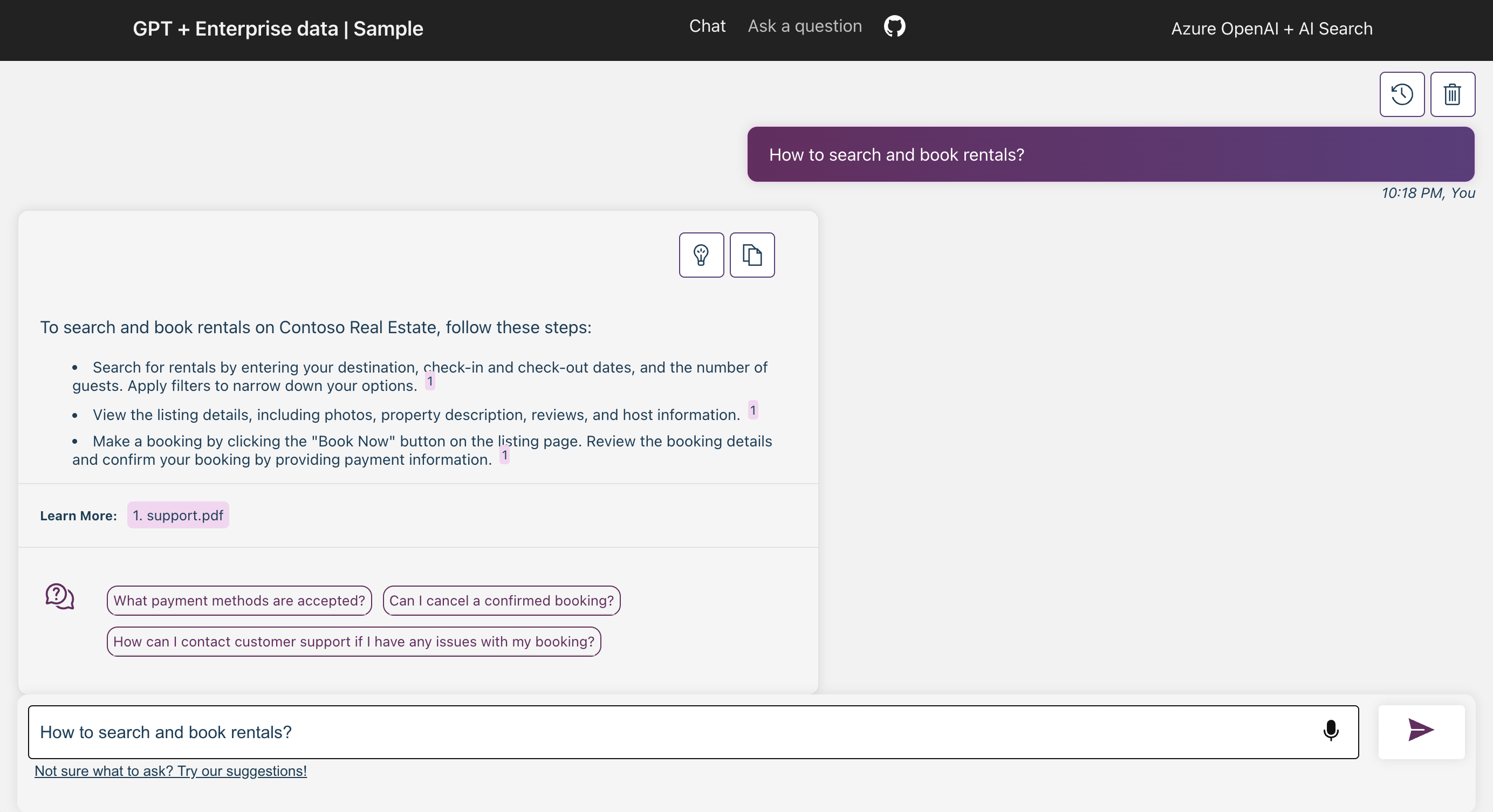

Serverloser KI-Chat mit RAG mithilfe von LangChain.js

Die Vorlage ist ein serverloser KI-Chatbot mit Retrieval Augmented Generation mit LangChain.js und Azure, der eine Reihe von Unternehmensdokumenten verwendet, um Antworten auf Benutzeranfragen zu generieren. Sie verwendet ein fiktives Unternehmen namens Contoso Real Estate, und die Umgebung ermöglicht Kunden, Supportfragen zur Nutzung der Produkte des Unternehmens zu stellen. Die Beispieldaten beinhalten eine Reihe von Dokumenten, die die Nutzungsbedingungen, die Datenschutzrichtlinie und einen Supportleitfaden beschreiben.

Informationen zum Bereitstellen und Ausführen dieser Vorlage finden Sie unter Erste Schritte mit Serverless AI Chat mit RAG und LangChain.js". Um auf den Quellcode zuzugreifen und ausführliche Details zur Vorlage zu finden, vgl. das GitHub-Repository serverless-chat-langchainjs.

Erfahren Sie, wie Sie diese JavaScript-Referenzvorlage bereitstellen und ausführen.

Diese Vorlage veranschaulicht die Verwendung dieser Features.

| Azure-Hosting-Lösung | Technologie | KI-Modelle |

|---|---|---|

| Azure Static Web Apps Azure-Funktionen |

Azure KI Cognitive Search Azure OpenAI Azure Cosmos DB Azure Storage Azure Managed Identity |

GPT4 Mistral Ollama |