Parallelisieren der Hyperopt-Hyperparameteroptimierung

Hinweis

Die Open-Source-Version von Hyperopt wird nicht mehr gepflegt.

Hyperopt wird in der nächsten haupt-DBR ML-Version entfernt. Azure Databricks empfiehlt, entweder Optuna- für die Optimierung mit einem einzelnen Knoten oder RayTune- für eine ähnliche Erfahrung wie die veraltete verteilte Hyperparameteroptimierungsfunktion von Hyperopt zu verwenden. Erfahren Sie mehr über die Verwendung von RayTune- in Azure Databricks.

In diesem Notebook wird gezeigt, wie Hyperopt zum Parallelisieren von Hyperparameter-Optimierungsberechnungen verwendet wird. Es verwendet die Klasse SparkTrials, um Berechnungen automatisch auf die Worker eines Clusters zu verteilen. Außerdem wird die automatisierte MLflow-Nachverfolgung von Hyperopt-Ausführungen veranschaulicht, damit Sie die Ergebnisse später speichern können.

Notebook: Parallelisieren der Hyperparameteroptimierung mit automatisierter MLflow-Nachverfolgung

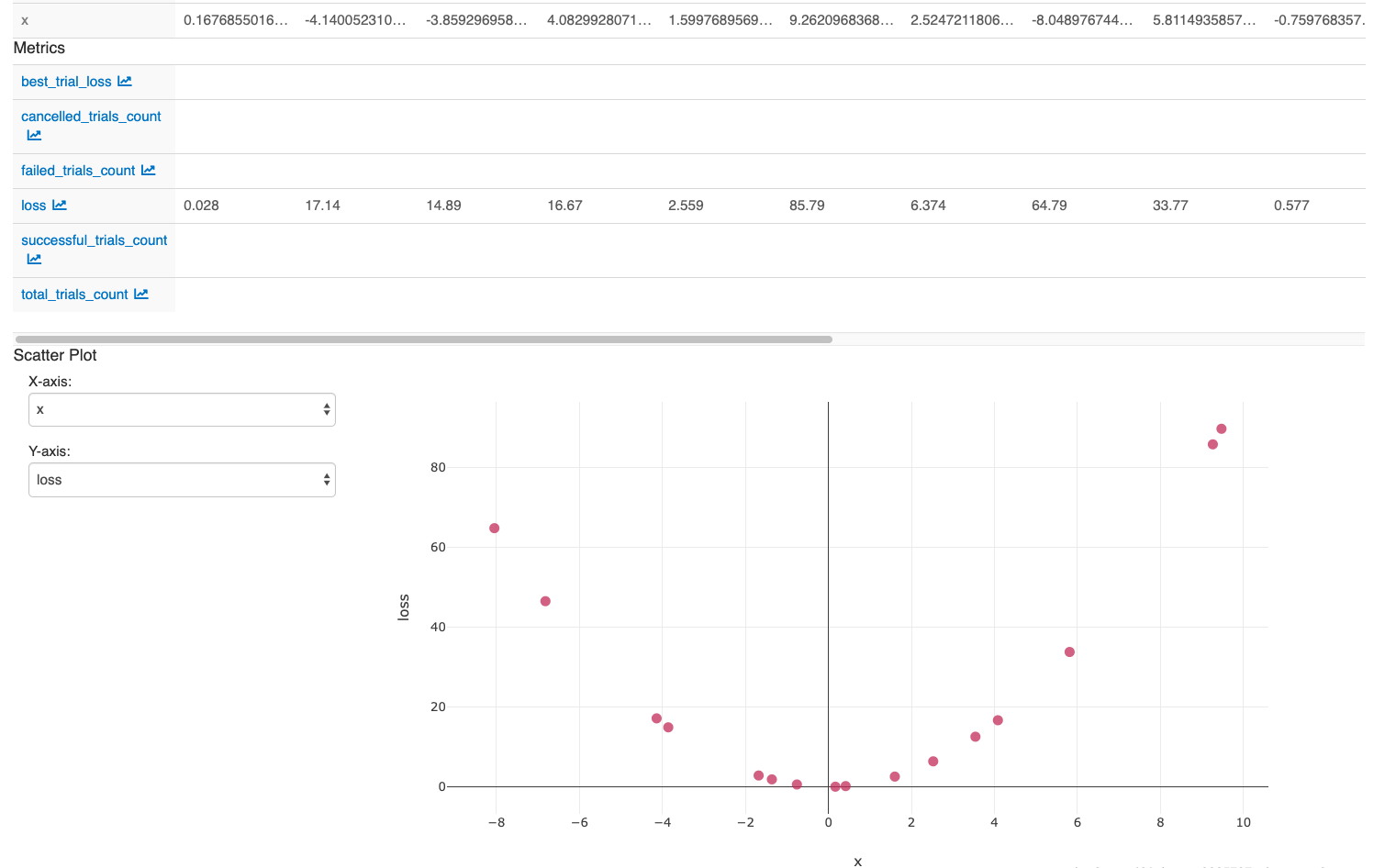

Nachdem Sie die Aktionen in der letzten Zelle des Notebooks ausgeführt haben, sollte die MLflow-Benutzeroberfläche Folgendes anzeigen: