Anzeigen, Verwalten und Analysieren von Foundation Model Fine-Tuning-Ausführungen

Wichtig

Dieses Feature ist in den folgenden Regionen als Public Preview verfügbar: centralus, eastus, eastus2, northcentralus und westus.

In diesem Artikel wird beschrieben, wie Sie Foundation Model Fine-Tuning (jetzt Teil der Mosaik AI Model Training) mit APIs oder der Benutzeroberfläche anzeigen, verwalten und analysieren.

Informationen zum Erstellen von Ausführungen finden Sie unter Erstellen eines Schulungslaufs mithilfe der Foundation Model Fine-Tuning-API und Erstellen eines Schulungslaufs mithilfe der Foundation Model Fine-Tuning-BEnutzeroberfläche.

Verwenden von Foundation Model Fine-Tuning-APIs zum Anzeigen und Verwalten von Schulungsläufen

Die Foundation Model Fine-Tuning-APIs stellen die folgenden Funktionen zum Verwalten Ihrer Schulungsläufe bereit.

Ausführung abrufen

Verwenden Sie die Funktion „get()“, um eine Ausführung nach Namen oder Ausführungsobjekt zurückzugeben, die Sie gestartet haben.

from databricks.model_training import foundation_model as fm

fm.get('<your-run-name>')

Auflisten von Ausführungen

Verwenden Sie die Funktion „list()“, um die Ausführungen anzuzeigen, die Sie gestartet haben. In der folgenden Tabelle sind die optionalen Filter aufgeführt, die Sie angeben können.

| Optionale Filter | Definition |

|---|---|

finetuning_runs |

Eine Liste der abzurufenden Ausführungen. Standardmäßig werden alle Ausführungen ausgewählt. |

user_emails |

Wenn freigegebene Ausführungen für Ihren Arbeitsbereich aktiviert sind, können Sie Ergebnisse nach Benutzer*innen filtern, die die Trainingsausführung übermittelt haben. Standardmäßig wird kein Benutzerfilter verwendet. |

before |

Eine datetime oder datetime-Zeichenfolge, vor der die Ausführungen gefiltert werden sollen. Der Standardwert lautet „Alle Ausführungen“. |

after |

Eine datetime oder datetime-Zeichenfolge, nach der die Ausführungen gefiltert werden sollen. Der Standardwert lautet „Alle Ausführungen“. |

from databricks.model_training import foundation_model as fm

fm.list()

# filtering example

fm.list(before='2023-01-01', limit=50)

Abbrechen von Trainingsausführungen

Verwenden Sie die Funktion cancel(), und übergeben Sie den Namen der Ausführung, um eine einzelne Trainingsausführung abzubrechen.

from databricks.model_training import foundation_model as fm

run_to_cancel = '<name-of-run-to-cancel>'

fm.cancel(run_to_cancel)

Übergeben Sie die spezifischen Ausführungsnamen als Liste, um mehrere Trainingsausführungen abzubrechen.

from databricks.model_training import foundation_model as fm

runs_to_cancel = ['<run_1>, <run_2>, <run_3>']

fm.cancel(runs=runs_to_cancel)

Übergeben Sie die Experiment-ID, um alle Trainingsausführungen in einem Experiment abzubrechen.

from databricks.model_training import foundation_model as fm

experiment_to_cancel = '<experiment-id-to-cancel>'

fm.cancel(experiment_id=experiment_to_cancel)

Überprüfen des Status von Trainingsausführungen

In der folgenden Tabelle sind die Ereignisse aufgeführt, die von einer Trainingsausführung erstellt wurden. Verwenden Sie die Funktion „get_events()“ jederzeit während der Ausführung, um den Fortschritt ihrer Ausführung anzuzeigen.

Hinweis

Foundation Model Fine-Tuning erzwingt eine Beschränkung von 10 aktiven Läufen. Diese Ausführungen befinden sich entweder in der Warteschlange, werden ausgeführt oder werden beendet. Ausführungen werden nicht mehr als aktiv betrachtet, wenn sie sich im Status ABGESCHLOSSEN, FEHLERHAFT oder GESTOPPT befinden.

| Ereignistyp | Beispielereignisnachricht | Definition |

|---|---|---|

CREATED |

Ausführung erstellt. | Die Trainingsausführung wurde erstellt. Wenn Ressourcen verfügbar sind, wird die Ausführung gestartet. Andernfalls wechselt sie in den Zustand „Pending“. |

STARTED |

Ausführung gestartet. | Ressourcen wurden zugewiesen, und die Ausführung wurde gestartet. |

DATA_VALIDATED |

Trainingsdaten überprüft. | Überprüft, dass Trainingsdaten korrekt formatiert sind. |

MODEL_INITIALIZED |

Modelldaten, die für das Basismodell „meta-llama/Llama-2-7b-chat-hf“ heruntergeladen und initialisiert wurden. |

Gewichtungen für das Basismodell wurden heruntergeladen, und das Training kann beginnen. |

TRAIN_UPDATED |

[epoch=1/1][batch=50/56][ETA=5min] Train loss: 1.71 | Meldet den aktuellen Trainingsbatch, die Epoche oder das Token, die geschätzte Zeit für den Abschluss des Trainings (ohne Prüfpunktuploadzeit) und den Verlust des Trainings. Dieses Ereignis wird aktualisiert, wenn jeder Batch endet. Wenn die Ausführungskonfiguration max_duration in tok Einheiten angibt, wird der Fortschritt in Token gemeldet. |

TRAIN_FINISHED |

Training abgeschlossen. | Das Training wurde abgeschlossen. Der Prüfpunktupload beginnt. |

COMPLETED |

Ausführung abgeschlossen. Endgültige Gewichtungen hochgeladen. | Der Prüfpunkt wurde hochgeladen, und die Ausführung wurde abgeschlossen. |

CANCELED |

Ausführung abgebrochen. | Die Ausführung wird abgebrochen, wenn fm.cancel() auf ihr aufgerufen wird. |

FAILED |

Mindestens ein Trainings-Dataset-Beispiel weist unbekannte Schlüssel auf. Überprüfen Sie die Dokumentation auf unterstützte Datenformate. | Fehler bei der Ausführung. Überprüfen Sie event_message auf handlungsrelevanten Details, oder wenden Sie sich an den Support. |

from databricks.model_training import foundation_model as fm

fm.get_events()

Verwenden der Benutzeroberfläche zum Anzeigen und Verwalten von Ausführungen

So zeigen Sie die Ausführung auf der Benutzeroberfläche an:

Klicken Sie auf Experimente in der linken Navigationsleiste, um die Seite „Experimente“ anzuzeigen.

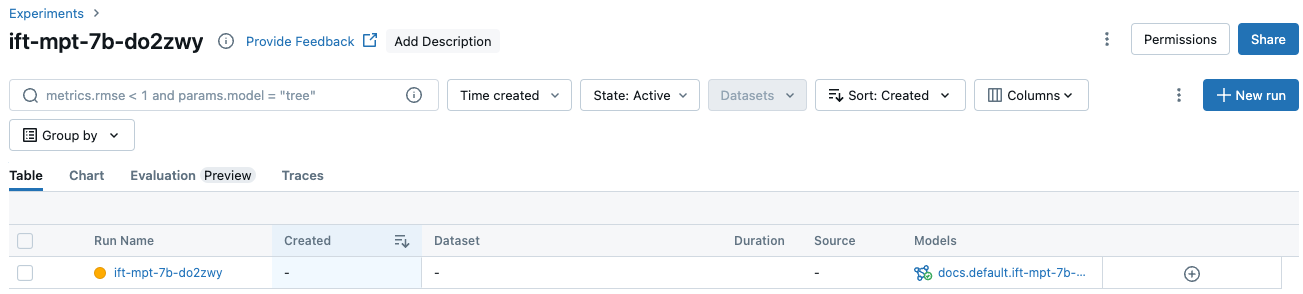

Klicken Sie in der Tabelle auf den Namen ihres Experiments, um die Experimentseite anzuzeigen. Auf der Seite „Experiment“ werden alle dem Experiment zugeordneten Ausführungen aufgeführt.

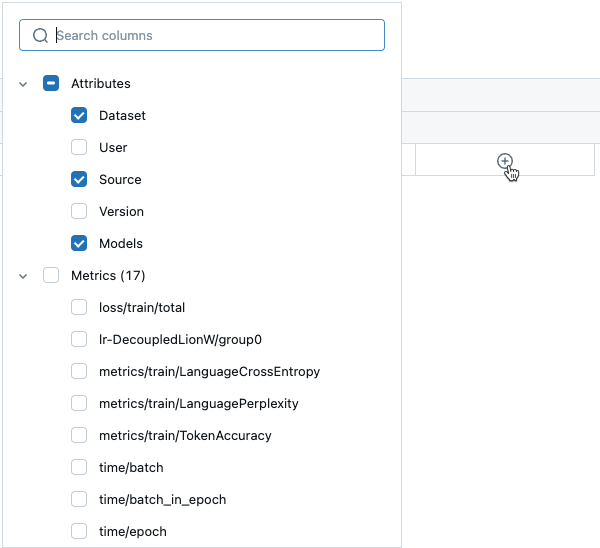

Wenn Sie zusätzliche Informationen oder Metriken in der Tabelle anzeigen möchten, klicken Sie auf

, und wählen Sie die im Menü anzuzeigenden Elemente aus:

, und wählen Sie die im Menü anzuzeigenden Elemente aus:

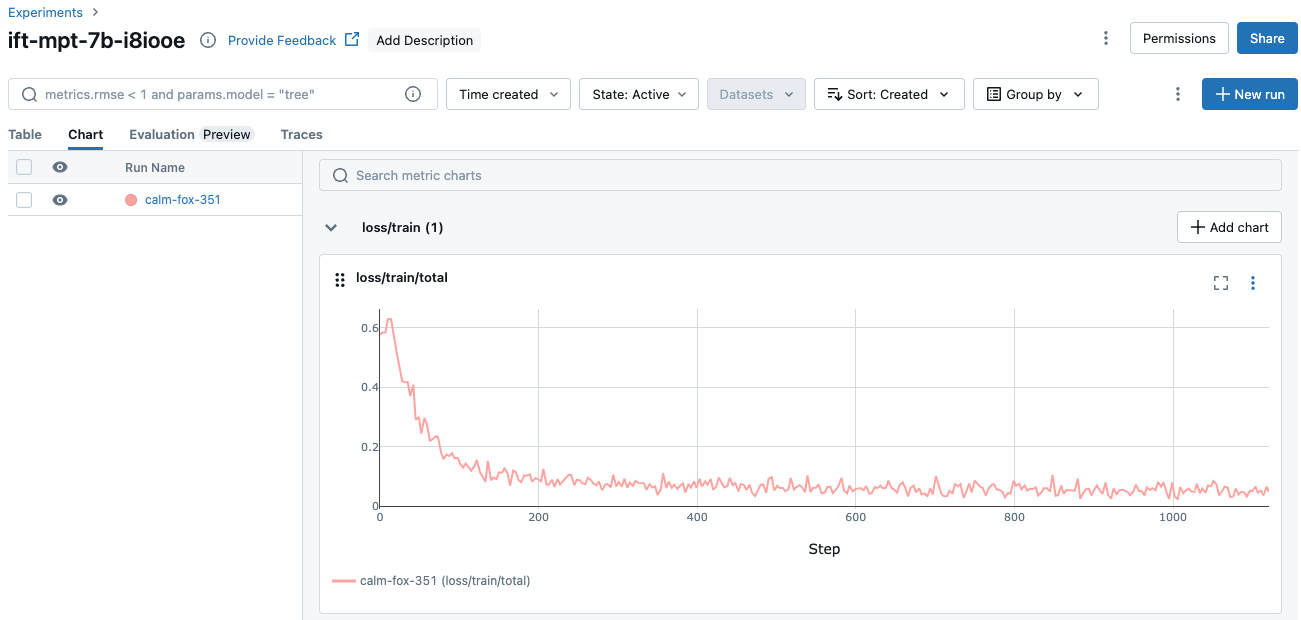

Weitere Ausführungsinformationen sind auf der Registerkarte Diagramm verfügbar:

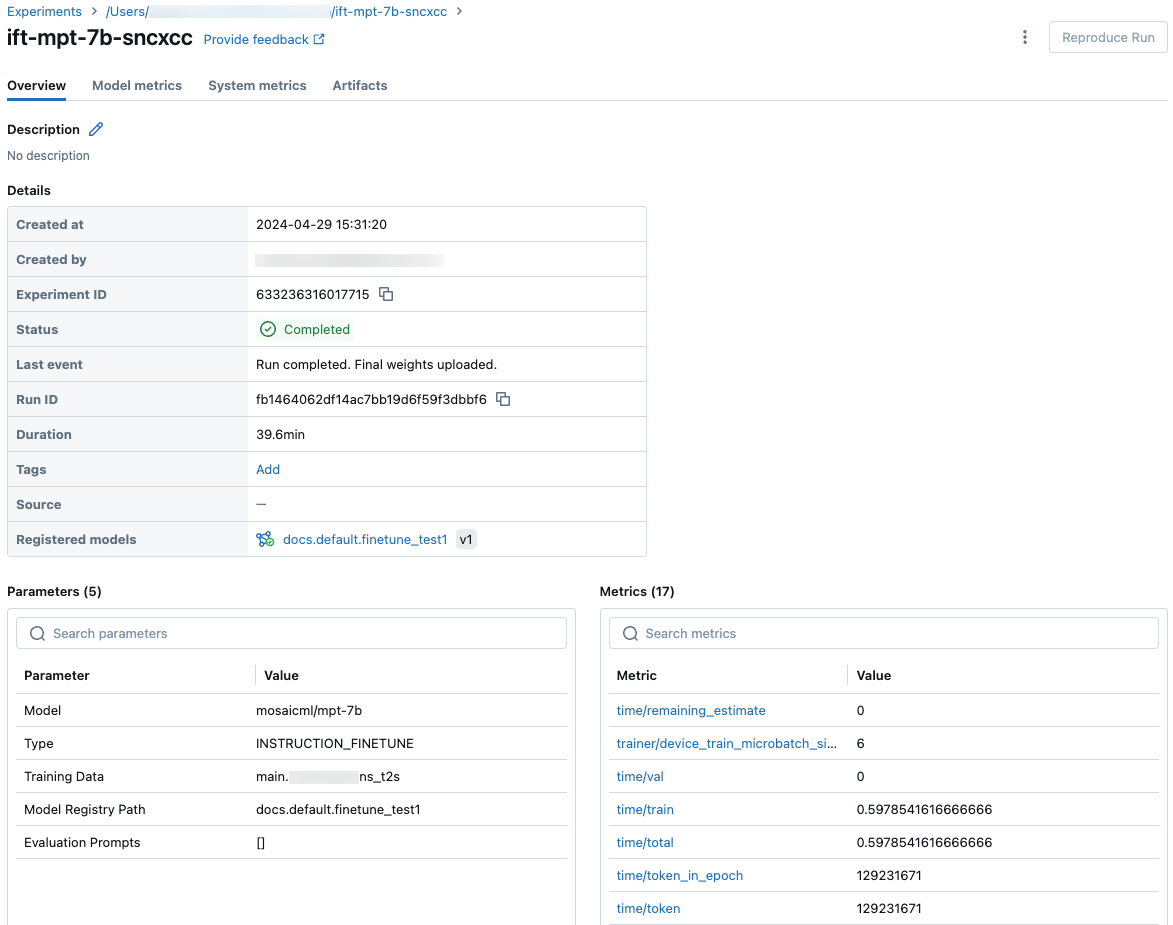

Sie können auch auf den Namen der Ausführung klicken, um den Ausführungsbildschirm anzuzeigen. Auf diesem Bildschirm erhalten Sie Zugriff auf weitere Details zur Ausführung.

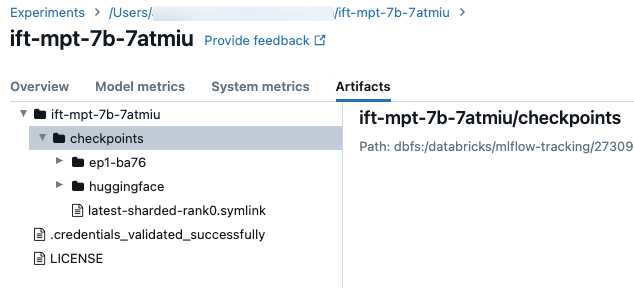

Prüfpunkte

Um auf den Prüfpunktordner zuzugreifen, klicken Sie auf der Registerkarte Artefakte auf dem Ausführungsbildschirm. Öffnen Sie den Namen des Experiments, und öffnen Sie dann den Ordner Prüfpunkte. Diese Artefaktprüfpunkte sind nicht mit dem registrierten Modell am Ende einer Trainingsausführung identisch.

In diesem Ordner befinden sich einige Verzeichnisse:

- Die Epochenordner (namens

ep<n>-xxx) enthalten die Gewichtungen und Modellzustände an jedem Composer-Prüfpunkt. Composer-Prüfpunkte werden in regelmäßigen Abständen durch Training gespeichert, diese werden zum Fortsetzen eines Feinabstimmungstrainings und für weitere Feinabstimmung verwendet. Dieser Prüfpunkt ist der Prüfpunkt, den Sie alscustom_weights_pathübergeben, um eine weitere Trainingsausführung mit diesen Gewichtungen zu starten. Siehe Erstellen von benutzerdefinierten Modellgewichtungen. - Im Ordner

huggingfacewerden Hugging Face-Prüfpunkte auch regelmäßig durch Training gespeichert. Nachdem Sie den Inhalt in diesem Ordner heruntergeladen haben, können Sie diese Prüfpunkte wie jeden anderen Hugging Face-Prüfpunkt mitAutoModelForCausalLM.from_pretrained(<downloaded folder>)laden. checkpoints/latest-sharded-rank0.symlinkist eine Datei, die den Pfad zum neuesten Prüfpunkt enthält, den Sie zum Fortsetzen des Trainings verwenden können.

Sie können auch die Composer-Prüfpunkte für eine Ausführung abrufen, nachdem sie mit get_checkpoints(run) gespeichert wurden. Diese Funktion verwendet das Ausführungsobjekt als Eingabe. Wenn noch keine Prüfpunkte vorhanden sind, werden Sie aufgefordert, den Vorgang nach dem Speichern der Prüfpunkte erneut auszuführen.