Überwachen einer Integration Runtime in einem verwalteten virtuellen Netzwerk

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

Sie können ein verwaltetes virtuelles Netzwerk in Azure Data Factory verwenden, um Ihre Datenquellen sicher mit einem vom Azure Data Factory-Dienst verwalteten virtuellen Netzwerk zu verbinden. Mithilfe dieser Funktion können Sie eine private und isolierte Umgebung für Ihre Datenintegrations- und Orchestrierungsprozesse einrichten.

Wenn Sie ein verwaltetes virtuelles Netzwerk verwenden, kombinieren Sie die Datenintegrations- und Orchestrierungsfunktionen in Data Factory mit der Sicherheit und Flexibilität virtueller Azure-Netzwerke. Es ermöglicht Ihnen, stabile, skalierbare und sichere Datenintegrationspipelines zu erstellen, die nahtlos mit Ihren Netzwerkressourcen verbunden werden können, unabhängig davon, ob sie sich lokal oder in der Cloud befinden.

Ein häufiges Problem bei verwalteten Computeressourcen besteht in der fehlenden Transparenz der Leistung und Integrität, insbesondere in einer Umgebung mit einem verwalteten virtuellen Netzwerk. Ohne ordnungsgemäße Überwachung wird das Identifizieren und Beheben von Problemen zu einer Herausforderung und kann zu potenziellen Verzögerungen, Fehlern und Leistungsbeeinträchtigungen führen.

Durch die Verwendung der erweiterten Überwachung in Data Factory können Sie wertvolle Erkenntnisse über Ihre Datenintegrationsprozesse gewinnen. Diese Erkenntnisse können zu einer höheren Effizienz, einer besseren Ressourcennutzung und einer verbesserten Gesamtleistung führen. Mit proaktiver Überwachung und rechtzeitigen Warnungen können Sie Probleme angehen, Workflows optimieren und die reibungslose Ausführung ihrer Datenintegrationspipelines in der Umgebung mit dem verwalteten Netzwerk sicherstellen.

Neue Metriken

Durch die Einführung neuer Metriken werden die Sichtbarkeits- und Überwachungsfunktionen in verwalteten virtuellen Netzwerkumgebungen verbessert.

Azure Data Factory bietet drei verschiedene Typen von Computepools:

- Compute für eine Kopieraktivität

- Compute für Pipelineaktivitäten wie Lookups

- Compute für externe Aktivitäten wie ein Azure Databricks-Notebook

Diese Computepools bieten Flexibilität und Skalierbarkeit, um verschiedene Workloads aufzunehmen und Ressourcen optimal zuzuordnen. Jeder Typ ist auf bestimmte Aktivitätsausführungsanforderungen zugeschnitten.

Um eine konsistente und umfassende Überwachung über alle Computepools hinweg sicherstellen zu können, haben wir dieselben Überwachungsmetriken implementiert:

- Kapazitätsauslastung

- Prozentsatz der verfügbaren Kapazität

- Warteschlangenlänge

Unabhängig von der Art des verwendeten Computepools können Sie auf einen standardisierten Satz von Metriken zugreifen und diese analysieren, um Einblicke in die Leistung und Integrität Ihrer Datenintegrationsaktivitäten zu erhalten.

Hinweis

Diese Metriken sind nur gültig, wenn Sie die Gültigkeitsdauer (Time to Live, TTL) in einer Integration Runtime in einem verwalteten virtuellen Netzwerk aktivieren.

| Metrik | Einheit | BESCHREIBUNG |

|---|---|---|

| Kopieren der Kapazitätsauslastung der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der DIU-Auslastung (Data Integration Unit, Datenintegrationseinheit) für TTL-Kopieraktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Verfügbare Kopierkapazität (Prozentsatz) der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der verfügbaren DIU für TTL-Kopieraktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Warteschlangenlänge der MVNet-Integration Runtime kopieren | Anzahl | Die Warteschlangenlänge der TTL-Kopieraktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

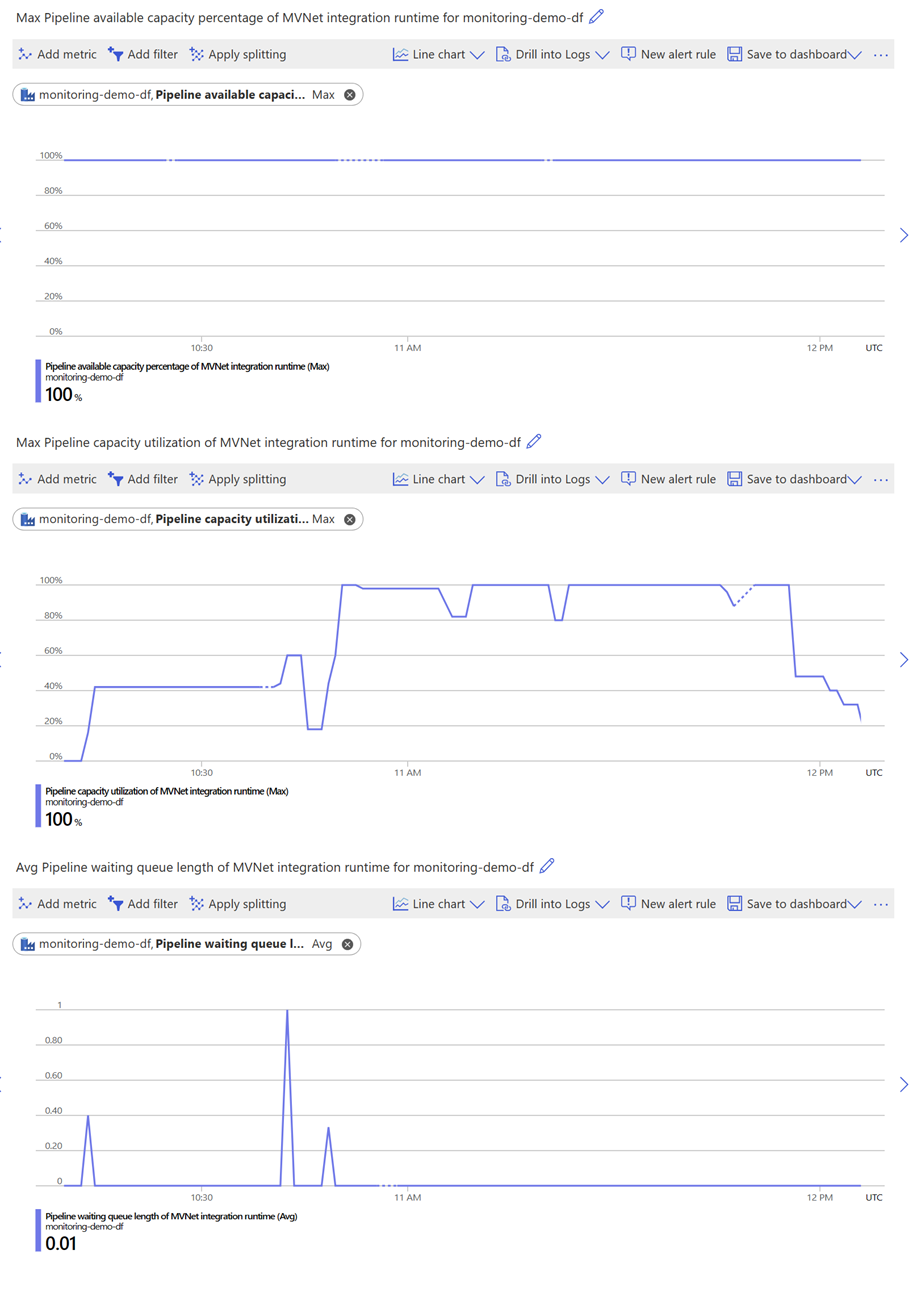

| Auslastung der Pipelinekapazität der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der DIU-Auslastung für Pipelineaktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Verfügbare Pipelinekapazität (Prozentsatz) der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der verfügbaren DIU für Pipelineaktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Länge der Pipelinewarteschlange der MVNet-Integration Runtime | Anzahl | Die Warteschlangenlänge der Pipelineaktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Externe Kapazitätsauslastung der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der DIU-Auslastung für externe Aktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Extern verfügbare Kopierkapazität (Prozentsatz) der MVNET-Integration Runtime | Percent | Der maximale Prozentsatz der verfügbaren DIU für externe Aktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

| Externe Warteschlangenlänge der MVNet-Integration Runtime | Anzahl | Die Warteschlangenlänge der externen Aktivitäten in der Integration Runtime eines verwalteten virtuellen Netzwerks innerhalb eines Zeitfensters von 1 Minute. |

Weitere Informationen zu diesen Metriken finden Sie unter Unterstützte Metriken für Microsoft.DataFactory/factories.

Verwenden von Metriken für die Leistungsoptimierung

Mithilfe dieser Metriken können Sie die Leistung und Robustheit Ihrer Integration Runtime in einem verwalteten virtuellen Netzwerk nahtlos nachverfolgen und bewerten. Zudem können Sie potenzielle Bereiche für kontinuierliche Verbesserungen aufdecken, indem Sie die Computeeinstellungen und den Workflow optimieren, um die Effizienz zu maximieren.

Im Anschluss finden Sie einige Beispielszenarien, in denen die praktische Anwendung dieser Metriken näher erläutert wird.

Balanced

Wenn Sie feststellen, dass die Kapazitätsauslastung unter 100 % liegt und der Prozentsatz der verfügbaren Kapazität hoch ist, werden die von Ihnen reservierten Computeressourcen effizient genutzt.

Wenn die Länge der Warteschlange gleichbleibend niedrig ist oder gelegentlich kurze Spitzen aufweist, ist es ratsam, andere Aktivitäten in die Warteschlange zu stellen, bis die Kapazitätsauslastung 100 % erreicht. Dieser Ansatz stellt eine optimale Auslastung der Ressourcen sicher und trägt zu einem reibungslosen Workflow mit minimalen Verzögerungen bei.

Leistungsorientiert

Wenn Sie feststellen, dass die Kapazitätsauslastung konstant niedrig ist und die Warteschlangenlänge gleichbleibend niedrig ist oder gelegentlich kurze Spitzen aufweist, sind die von Ihnen reservierten Computeressourcen umfangreicher als der tatsächliche Bedarf der Aktivitäten.

In solchen Fällen empfehlen wir, unabhängig davon, ob der Prozentsatz der verfügbaren Kapazität hoch oder niedrig ist, die zugewiesenen Computeressourcen zu reduzieren, um Ihre Kosten zu senken. Durch die Anpassung der Computeleistung an die Workloadanforderungen können Sie Ihre Ressourcennutzung optimieren und Kosten einsparen, ohne die Effizienz Ihres Betriebs zu beeinträchtigen.

Kostenorientiert

Wenn Sie feststellen, dass alle Metriken (einschließlich „Kapazitätsauslastung“, „Prozentsatz der verfügbaren Kapazität“ und „Warteschlangenlänge“) hoch sind, reichen die von Ihnen reservierten Computeressourcen wahrscheinlich für Ihre Aktivitäten nicht aus.

In diesem Szenario wird empfohlen, die Menge zugewiesener Computeressourcen zu erhöhen, um die Wartezeit in der Warteschlange zu verkürzen. Durch das Hinzufügen von mehr Computekapazität können Sie sicherstellen, dass Ihre Aktivitäten über ausreichende Ressourcen verfügen, um effizient ausgeführt zu werden. Dadurch werden alle Verzögerungen minimiert, die eine überfüllte Warteschlange verursacht.

Zeitweilige Aktivitätsausführung

Wenn Sie feststellen, dass der Prozentsatz der verfügbaren Kapazität innerhalb eines bestimmten Zeitraums zwischen niedrig und hoch schwankt, liegt dies wahrscheinlich an der zeitweiligen Ausführung Ihrer Aktivitäten, bei der der von Ihnen konfigurierte Zeitraum für die Gültigkeit (Time-To-Live, TTL) kürzer ist als das Intervall zwischen Ihren Aktivitäten. Dies kann erhebliche Auswirkungen auf die Leistung Ihres Workflows haben. Es gibt zwei mögliche Lösungen für dieses Problem. Sie können mehr Aktivitäten in die Warteschlange stellen, um eine konsistente Workload aufrechtzuerhalten und die verfügbaren Computeressourcen effektiver zu nutzen. Wenn Sie die Computeressource kontinuierlich in Betrieb halten, können Sie die Aufwärmphase vermeiden und eine bessere Leistung erzielen. Alternativ können Sie erwägen, den TTL-Zeitraum zu verlängern, um ihn an das Intervall zwischen Ihren Aktivitäten anzupassen. Dadurch wird sichergestellt, dass die Computeressourcen länger verfügbar bleiben, was die Häufigkeit von Aufwärmzeiten reduziert und die Kosteneffizienz optimiert.

Durch die Implementierung einer dieser Lösungen können Sie die Leistung Ihres Workflows verbessern, Kostenauswirkungen minimieren und eine reibungslosere Ausführung Ihrer zeitweiligen Aktivitäten sicherstellen.

Zugehöriger Inhalt

Fahren Sie mit dem folgenden Tutorial fort, um mehr über verwaltete virtuelle Netzwerke zu erfahren: In Azure Data Factory verwaltetes virtuelles Netzwerk.