Wie funktioniert Workflow Orchestration Manager von Azure Data Factory?

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

Hinweis

Workflow Orchestration Manager wird von Apache Airflow unterstützt.

Hinweis

Workflow Orchestration Manager für Azure Data Factory basiert auf der Open-Source-Anwendung Apache Airflow. Die Dokumentation und weitere Tutorials zu Airflow finden Sie in der Dokumentation zu Apache Airflow oder auf den Communityseiten.

Workflow Orchestration Manager in Azure Data Factory verwendet Python-basierte gerichtete azyklische Graphen (Directed Acyclic Graphs, DAGs) zum Ausführen Ihrer Orchestrierungsworkflows. Um dieses Feature verwenden zu können, müssen Sie Ihre DAGs und Plug-Ins in Azure Blob Storage bereitstellen. Sie können die Airflow-Benutzeroberfläche von ADF aus über eine Befehlszeilenschnittstelle (CLI) oder ein Software Development Kit (SDK) starten, um Ihre DAGs zu verwalten.

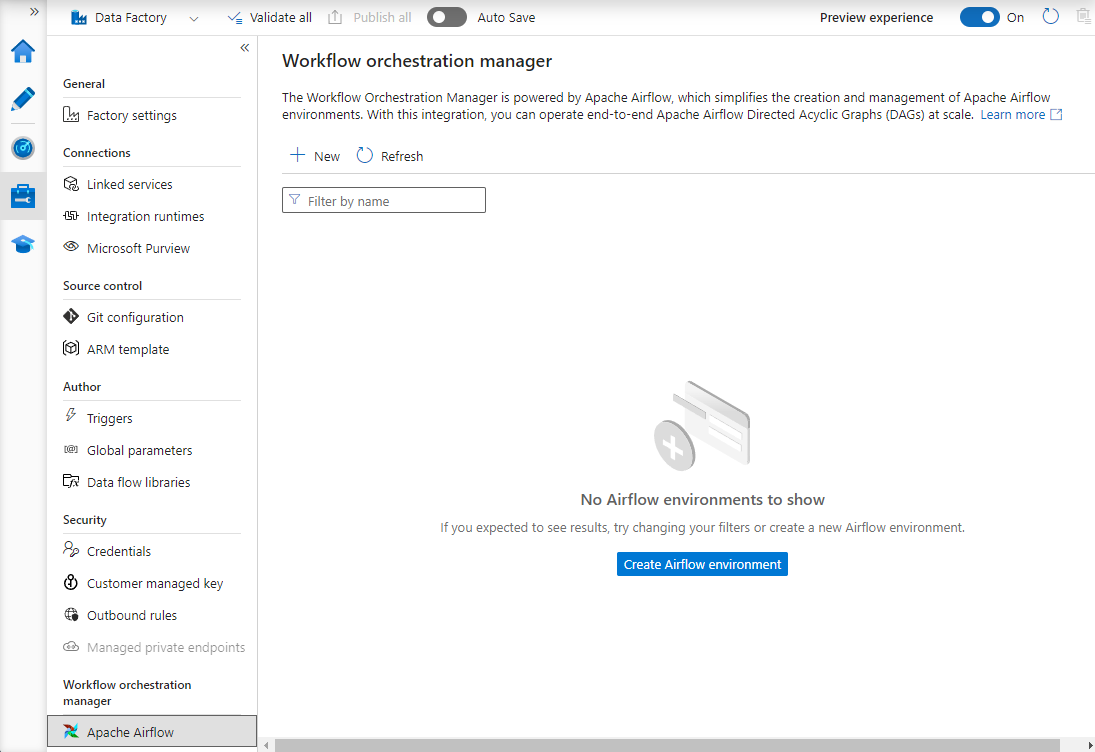

Erstellen einer Workflow Orchestration Manager-Umgebung

Mit den folgenden Schritten richten Sie Ihre Workflow Orchestration Manager-Umgebung ein und konfigurieren sie.

Voraussetzungen

Azure-Abonnement: Wenn Sie kein Azure-Abonnement besitzen, können Sie ein kostenloses Konto erstellen, bevor Sie beginnen. Erstellen Sie eine Data Factory-Instanz in der Region, in der die Vorschau von Workflow Orchestration Manager unterstützt wird, oder wählen Sie eine vorhandene aus.

Schritte zum Erstellen der Umgebung

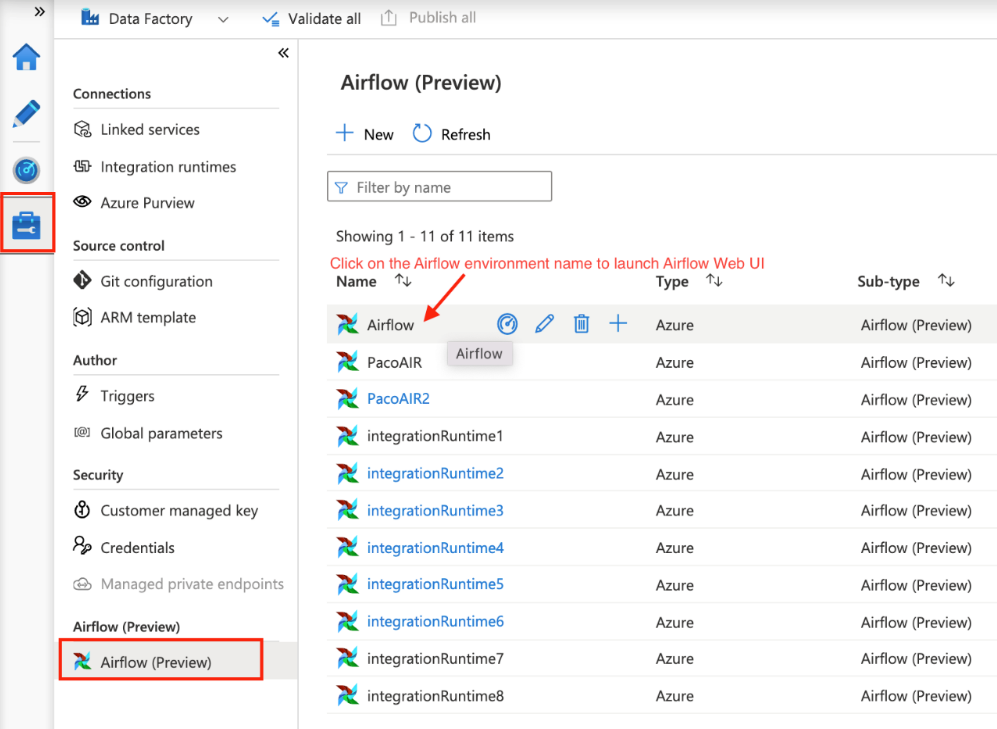

Erstellen Sie eine Workflow Orchestration Manager-Umgebung. Wechseln Sie zu Hub verwalten ->Airflow (Vorschau) ->+Neu, um eine neue Airflow-Umgebung zu erstellen.

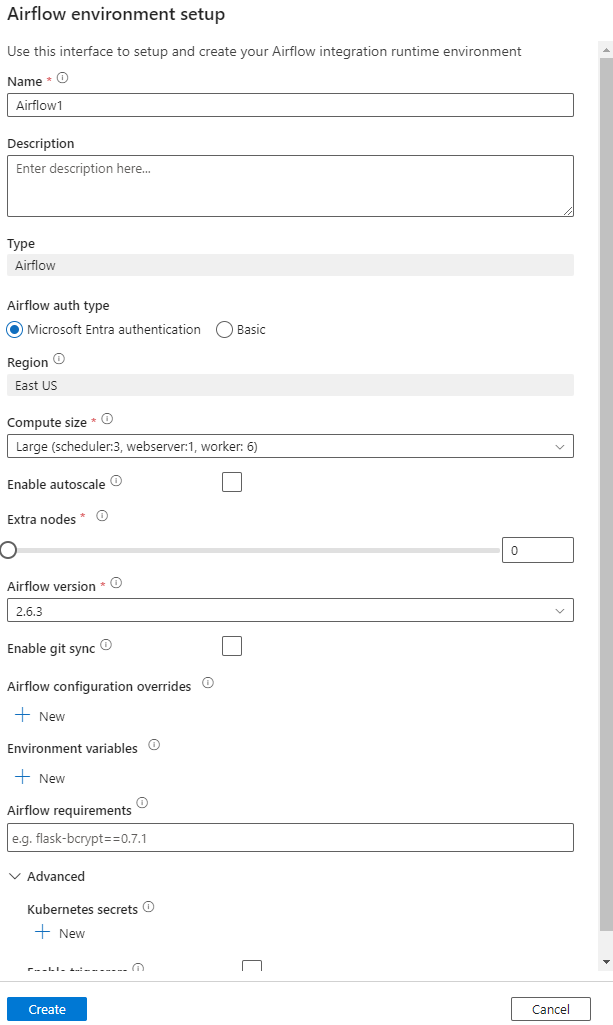

Angeben der Details (Airflow-Konfiguration)

Wichtig

Wenn Sie die Standardauthentifizierung verwenden, merken Sie sich den Benutzernamen und das Kennwort, die auf diesem Bildschirm angegeben sind. Sie benötigen diese Informationen später, um sich auf der Benutzeroberfläche von Workflow Orchestration Manager anzumelden. Die Standardoption ist Microsoft Entra AD, für die es nicht erforderlich ist, einen Benutzernamen/ein Kennwort für Ihre Airflow-Umgebung zu erstellen; stattdessen werden die Anmeldeinformationen der bei Azure Data Factory angemeldeten Benutzer*innen verwendet, um DAGs anzumelden/zu überwachen.

Umgebungsvariablen ein einfacher Schlüsselwertspeicher in Airflow zum Speichern und Abrufen beliebiger Inhalte oder Einstellungen.

Anforderungen können verwendet werden, um Python-Bibliotheken vorzuinstallieren. Sie können diese auch später aktualisieren.

Importieren von DAGs

In den folgenden Schritten wird beschrieben, wie gerichtete azyklische Graphen (DAGs) in Workflow Orchestration Manager importiert werden.

Voraussetzungen

Sie müssen einen Beispiel-DAG in ein barrierefreies Speicherkonto hochladen. Dieses sollte sich unter dem DAGs-Ordner befinden.

Hinweis

Blob Storage hinter dem VNET wird während der Vorschau nicht unterstützt.

Die KeyVault-Konfiguration in storageLinkedServices wird zum Importieren von DAGs nicht unterstützt.

Beispiel für einen Apache Airflow v2.x-DAG. Beispiel für einen Apache Airflow v1.10-DAG.

Schritte zum Importieren

Kopieren Sie den Inhalt (entweder v2.x oder v1.10 basierend auf der von Ihnen eingerichteten Airflow-Umgebung) in eine neue Datei mit dem Namen tutorial.py.

Laden Sie die Datei tutorial.py in einen Blobspeicher hoch. (So laden Sie eine Datei in einen Blobspeicher hoch)

Hinweis

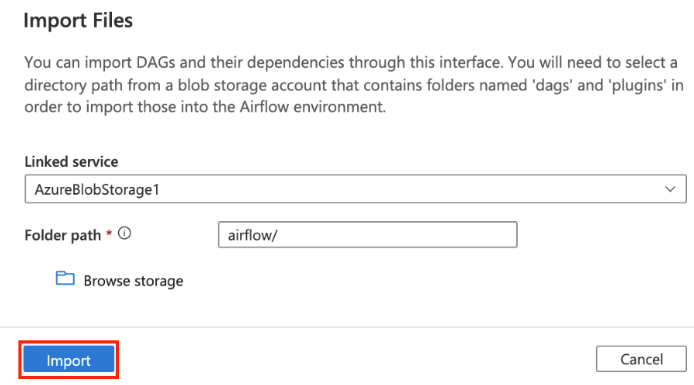

Sie müssen einen Verzeichnispfad aus einem Blobspeicherkonto auswählen, das Ordner mit dem Namen dags und Plugins enthält, um diese in die Airflow-Umgebung zu importieren. Plugins sind nicht obligatorisch. Sie können auch einen Container mit dem Namen dags verwenden und alle Airflow-Dateien in ihn hochladen.

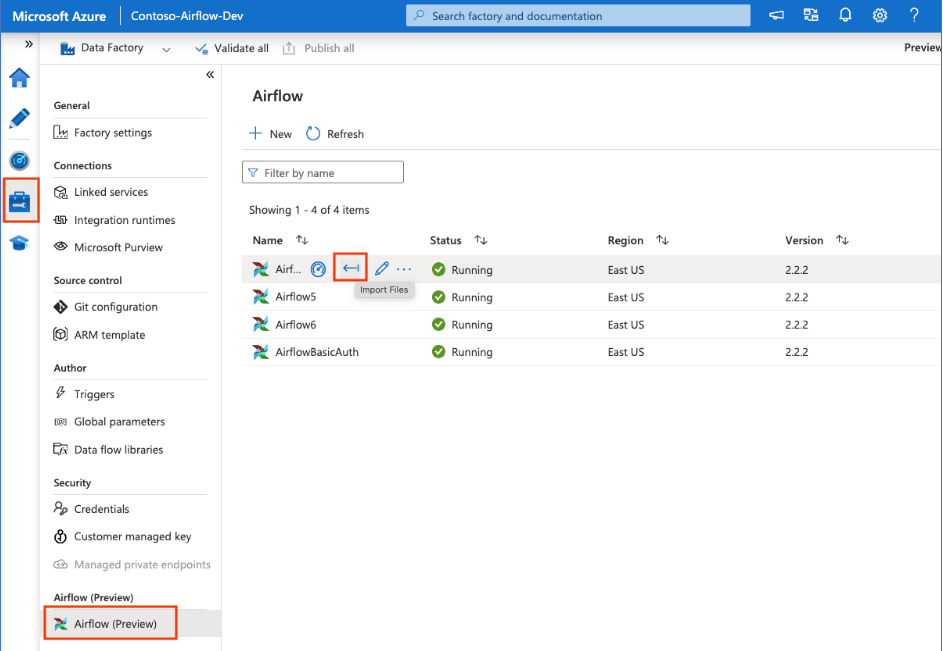

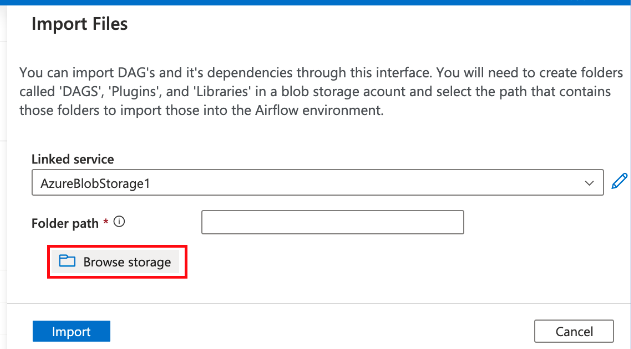

Wählen Sie unter Verwaltungshub die Option Airflow (Vorschau) aus. Zeigen Sie dann auf die zuvor erstellte Airflow-Umgebung, und wählen Sie Dateien importieren aus, um alle DAGs und Abhängigkeiten in die Airflow-Umgebung zu importieren.

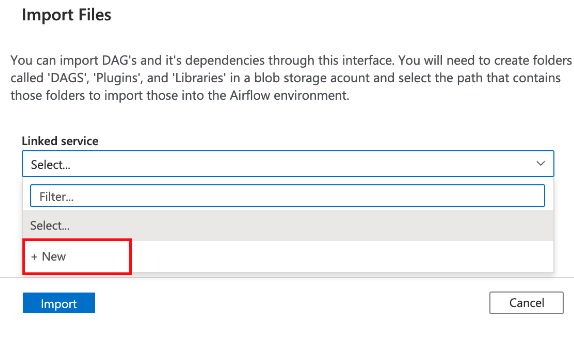

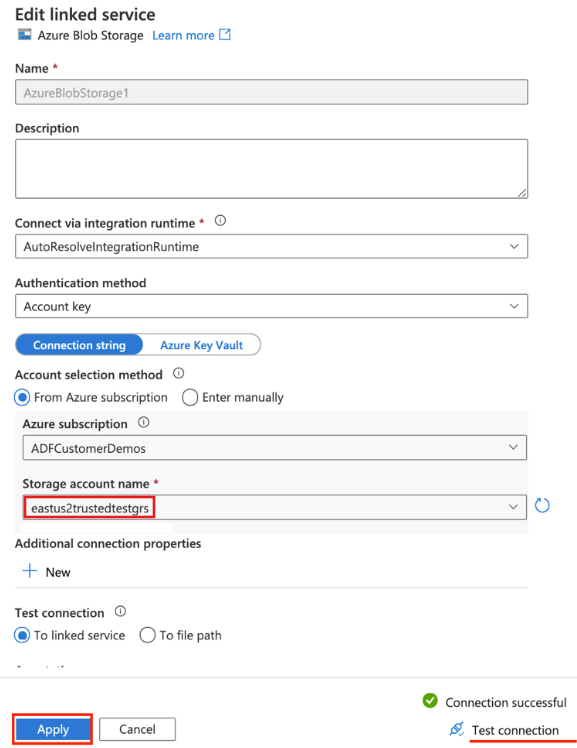

Erstellen Sie einen neuen verknüpften Dienst für das in der Voraussetzung genannte barrierefreie Speicherkonto (oder verwenden Sie einen vorhandenen Dienst, wenn Sie bereits über eigene DAGs verfügen).

Verwenden Sie das Speicherkonto, in das Sie den DAG hochgeladen haben (überprüfen Sie die Voraussetzung). Testen Sie die Verbindung, und wählen Sie Erstellen aus.

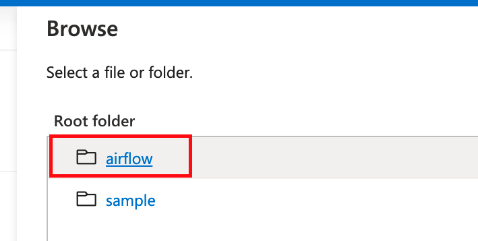

Navigieren Sie zu Airflow und wählen Sie die Option aus, wenn Sie die SAS-Beispiel-URL verwenden, oder wählen Sie den Ordner aus, der dags-Ordner mit DAG-Dateien enthält.

Hinweis

Sie können DAGs und deren Abhängigkeiten über diese Schnittstelle importieren. Sie müssen einen Verzeichnispfad aus einem Blobspeicherkonto auswählen, das Ordner mit dem Namen dags und Plugins enthält, um diese in die Airflow-Umgebung zu importieren. Plugins sind nicht obligatorisch.

Hinweis

Das Importieren von DAGs kann während der Vorschau einige Minuten dauern. Mithilfe der Benachrichtigungszentrale (Glockensymbol auf der ADF-Benutzeroberfläche) können Sie die Aktualisierungen des Importstatus nachverfolgen.

Behandeln von Problemen mit DAG-Importen

Problem: DAG-Import dauert mehr als 5 Minuten. Entschärfung: Reduzieren Sie die Größe der in einem einzigen Importvorgang importierten DAGs. Eine Möglichkeit, dies zu erreichen, besteht darin, mehrere DAG-Ordner mit weniger DAGs in mehreren Containern zu erstellen.

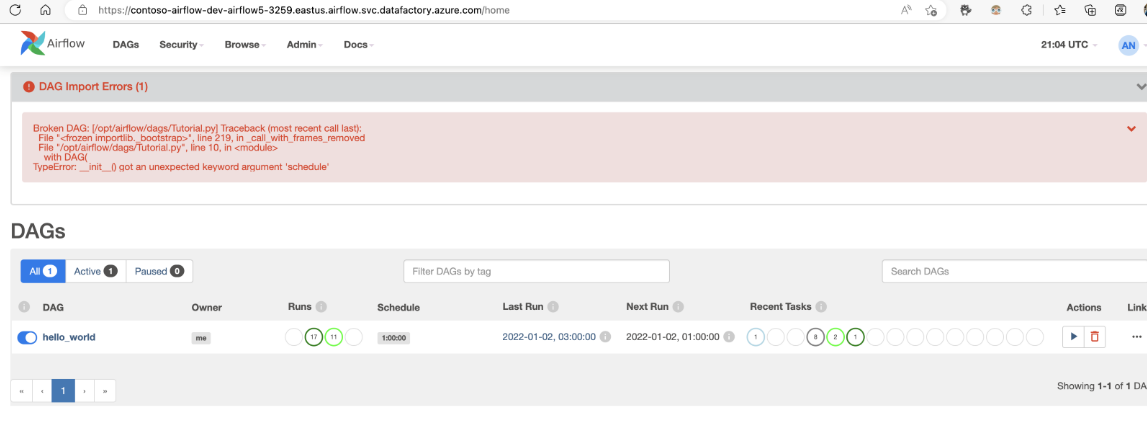

Problem: Importierte DAGs werden nicht angezeigt, wenn Sie sich bei der Airflow-Benutzeroberfläche anmelden. Entschärfung: Melden Sie sich bei der Airflow-Benutzeroberfläche an, und überprüfen Sie, ob DAG-Analysefehler vorliegen. Dies kann passieren, wenn die DAG-Dateien inkompatiblen Code enthalten. Sie finden die genauen Zeilennummern und die Dateien, die das Problem haben, über die Airflow-Benutzeroberfläche.

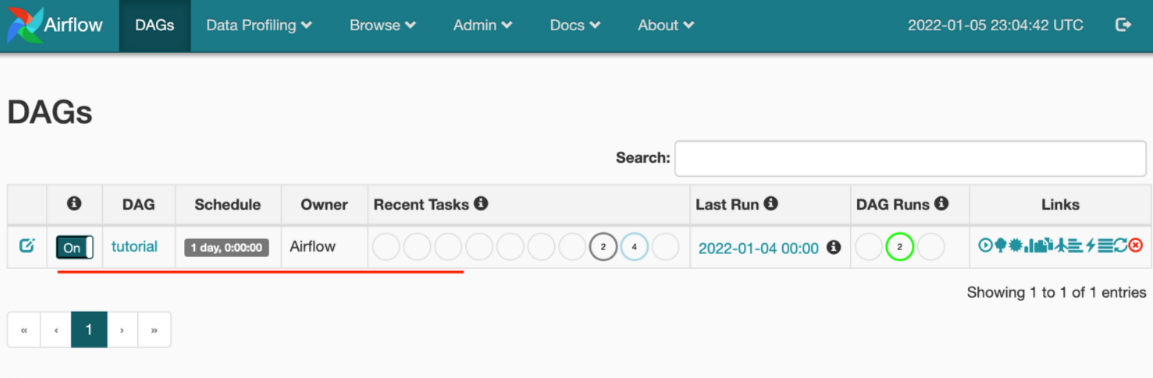

Überwachen von DAG-Ausführungen

Um die Airflow-DAGs zu überwachen, melden Sie sich bei der Airflow-Benutzeroberfläche mit dem zuvor erstellten Benutzernamen und Kennwort an.

Wählen Sie die erstellte Airflow-Umgebung aus.

Melden Sie sich mit dem Benutzernamen und dem Kennwort an, die während der Erstellung der Airflow Integration Runtime angegeben wurden. (Sie können den Benutzernamen oder das Kennwort zurücksetzen, indem Sie bei Bedarf die Airflow Integration Runtime bearbeiten.)

Entfernen von DAGs aus der Airflow-Umgebung

Wenn Sie Airflow Version 1.x verwenden, löschen Sie die DAGs, die in einer beliebigen Airflow-Umgebung (IR) bereitgestellt wurden. Sie müssen die DAGs an zwei verschiedenen Stellen löschen.

- Löschen der DAGs von der Airflow-Benutzeroberfläche

- Löschen der DAGs von der ADF-Benutzeroberfläche

Hinweis

So erfolgt dies aktuell in der Public Preview. Dies wird noch verbessert werden.