Auswerten generativer KI-Modelle und -Anwendungen mit Azure KI Foundry

Um die Leistung Ihrer generativen KI-Modelle und -Apps beim Anwenden auf einen umfangreichen Datensatz gründlich zu bewerten, können Sie einen Auswertungsprozess einleiten. Während dieser Auswertung wird Ihr Modell bzw. Ihre Anwendung mit dem angegebenen Dataset getestet und die Leistung quantitativ mit sowohl auf Mathematik basierten als auch mit KI-gestützten Metriken gemessen. Dieser Auswertungslauf bietet Ihnen umfassende Einblicke in die Funktionen und Einschränkungen der Anwendung.

Um diese Auswertung durchzuführen, können Sie die Auswertungsfunktionalität im Azure KI Foundry-Portal nutzen, eine umfassende Plattform, die Tools und Features zum Bewerten der Leistung und Sicherheit für Ihr generatives KI-Modell bietet. Im Azure KI Foundry-Portal können Sie detaillierte Auswertungsmetriken protokollieren, anzeigen und analysieren.

In diesem Artikel erfahren Sie, wie Sie eine Auswertungsausführung für ein Modell in einem Testdataset oder einem Flow mit integrierten Auswertungsmetriken auf der Azure KI Foundry-Benutzeroberfläche erstellen. Für eine größere Flexibilität können Sie einen benutzerdefinierten Auswertungsflow einrichten und das benutzerdefinierte Auswertungsfeature verwenden. Wenn Ihr Ziel darin besteht, einen Batchlauf ohne Auswertung durchzuführen, können Sie auch das benutzerdefinierte Auswertungsfeature nutzen.

Voraussetzungen

Um eine Auswertung mit KI-unterstützten Metriken auszuführen, müssen Sie Folgendes bereithalten:

- Ein Test-Dataset in einem der folgenden Formate:

csvoderjsonl. - Eine Azure OpenAI-Verbindung. Eine Bereitstellung eines dieser Modelle: GPT 3.5-Modelle, GPT 4-Modelle oder Davinci-Modelle. Dies ist nur erforderlich, wenn Sie KI-gestützte Qualitätsauswertungen ausführen.

Erstellen einer Auswertung mit integrierten Auswertungsmetriken

Mit einem Auswertungslauf können Sie Metrikausgaben für jede Datenzeile in Ihrem Testdatensatz generieren. Sie können eine oder mehrere Auswertungsmetriken auswählen, um die Ausgabe aus verschiedenen Aspekten zu bewerten. Sie können eine Auswertungsausführung über die Auswertungs-, Modellkatalog- oder Promptflowseiten im Azure KI Foundry-Portal erstellen. Anschließend wird ein Auswertungserstellungs-Assistent angezeigt, der Sie durch den Prozess der Einrichtung eines Auswertungslaufs führt.

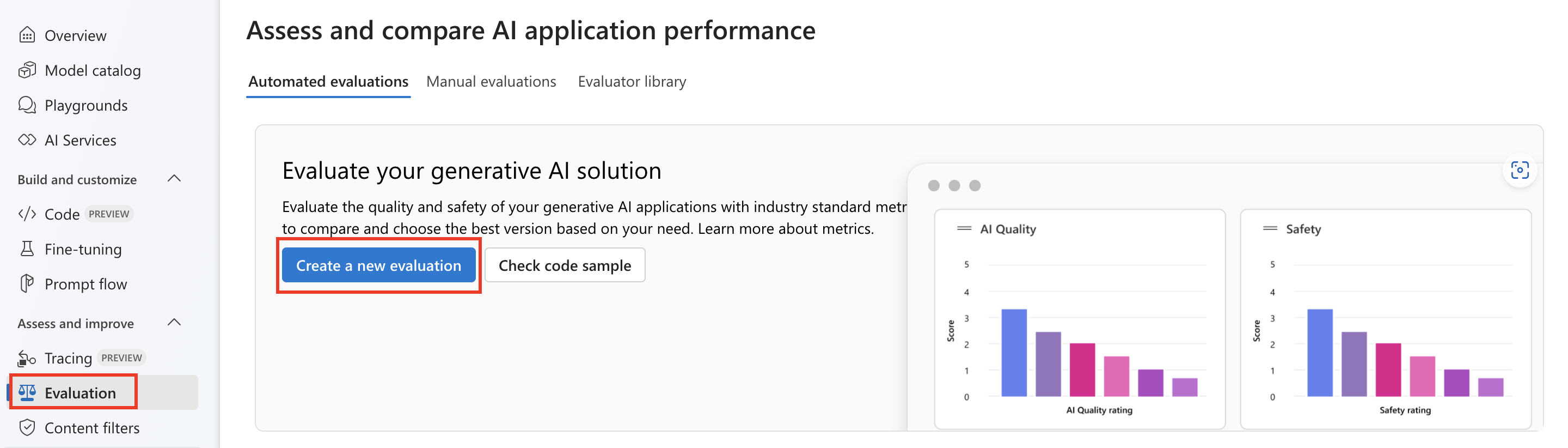

Von der Seite Auswerten

Wählen Sie im reduzierbaren linken Menü Auswertung>+ Neue Auswertung erstellen aus.

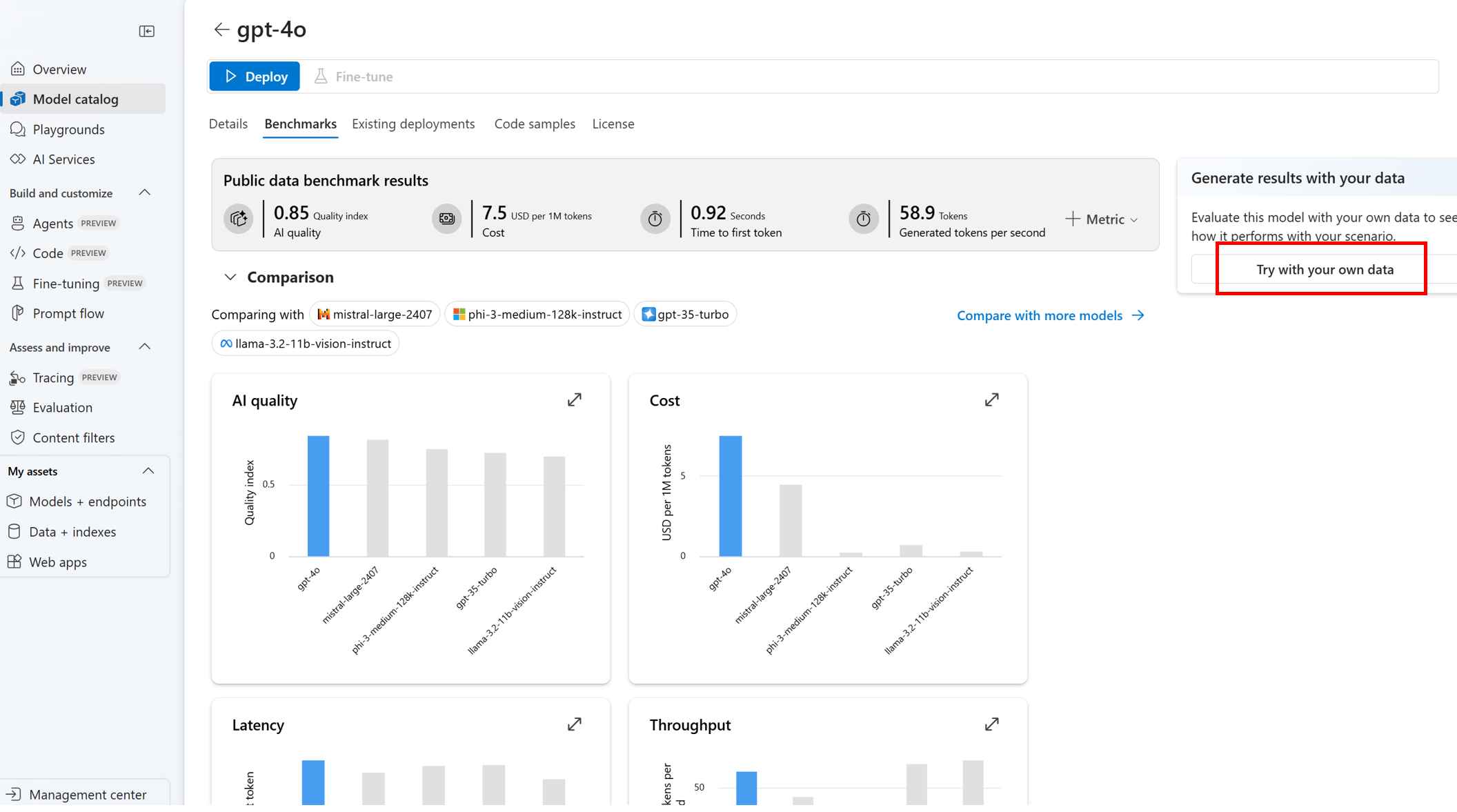

Auf der Modellkatalogseite

Wählen Sie im reduzierbaren linken Menü Folgendes aus: Modellkatalog> Zu einem bestimmten Modell wechseln > Zur Registerkarte „Benchmark“ navigieren > Mit eigenen Daten testen. Dadurch wird der Modellauswertungspanel geöffnet, in dem Sie eine Auswertungsausführung für Ihr ausgewähltes Modell erstellen können.

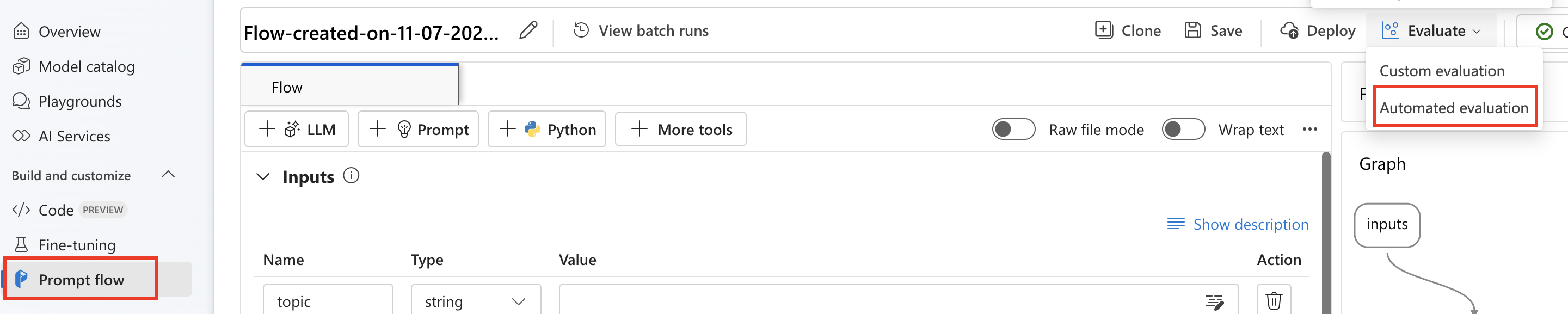

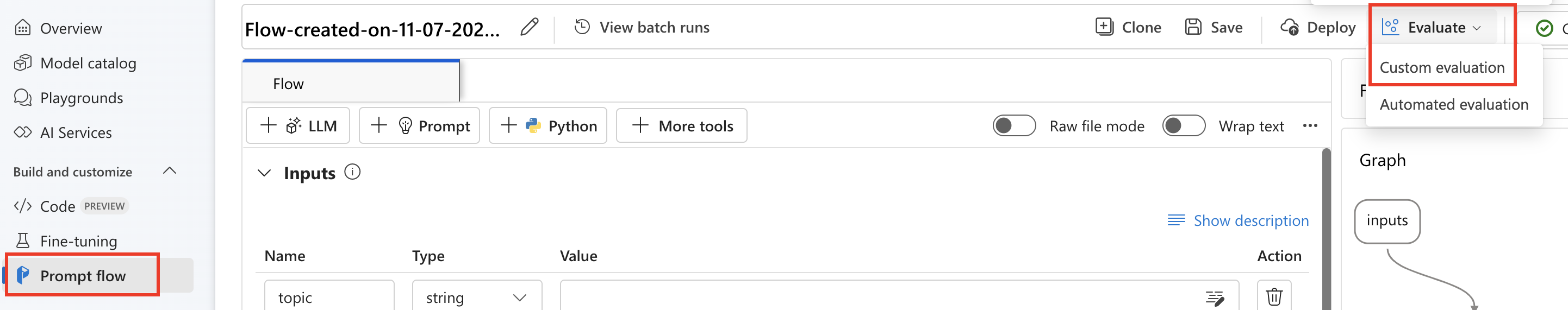

Von der Flowseite

Wählen Sie im reduzierbaren linken Menü Promptflow>Auswerten>Automatisierte Auswertung aus.

Auswertungsziel

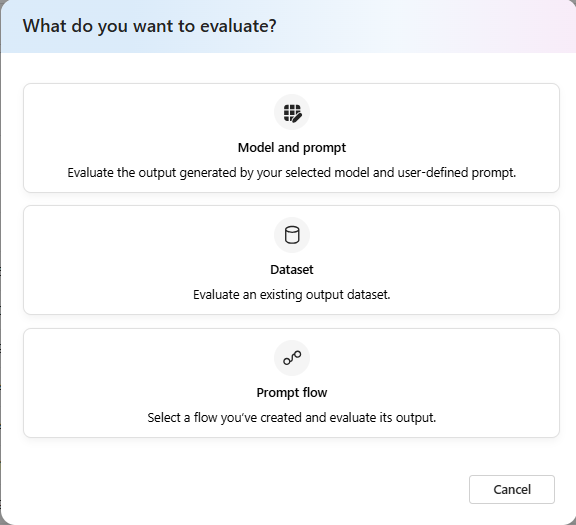

Wenn Sie eine Auswertung von der Seite „Auswerten” starten, müssen Sie zuerst entscheiden, was das Auswertungsziel ist. Durch die Angabe des geeigneten Auswertungsziels können wir die Auswertung auf die spezifische Art Ihrer Anwendung anpassen und dabei genaue und relevante Metriken sicherstellen. Es werden drei Arten von Auswertungszielen unterstützt:

- Modell und Prompt: Sie möchten die von Ihrem ausgewählten Modell und dem benutzerdefinierten Prompt generierte Ausgabe auswerten.

- Dataset: Sie haben bereits über das Modell generierte Ausgaben in einem Test-Dataset.

- Prompt Flow: Sie haben einen Flow erstellt und möchten die Ausgabe aus dem Flow auswerten.

Dataset- oder Promptflowauswertung

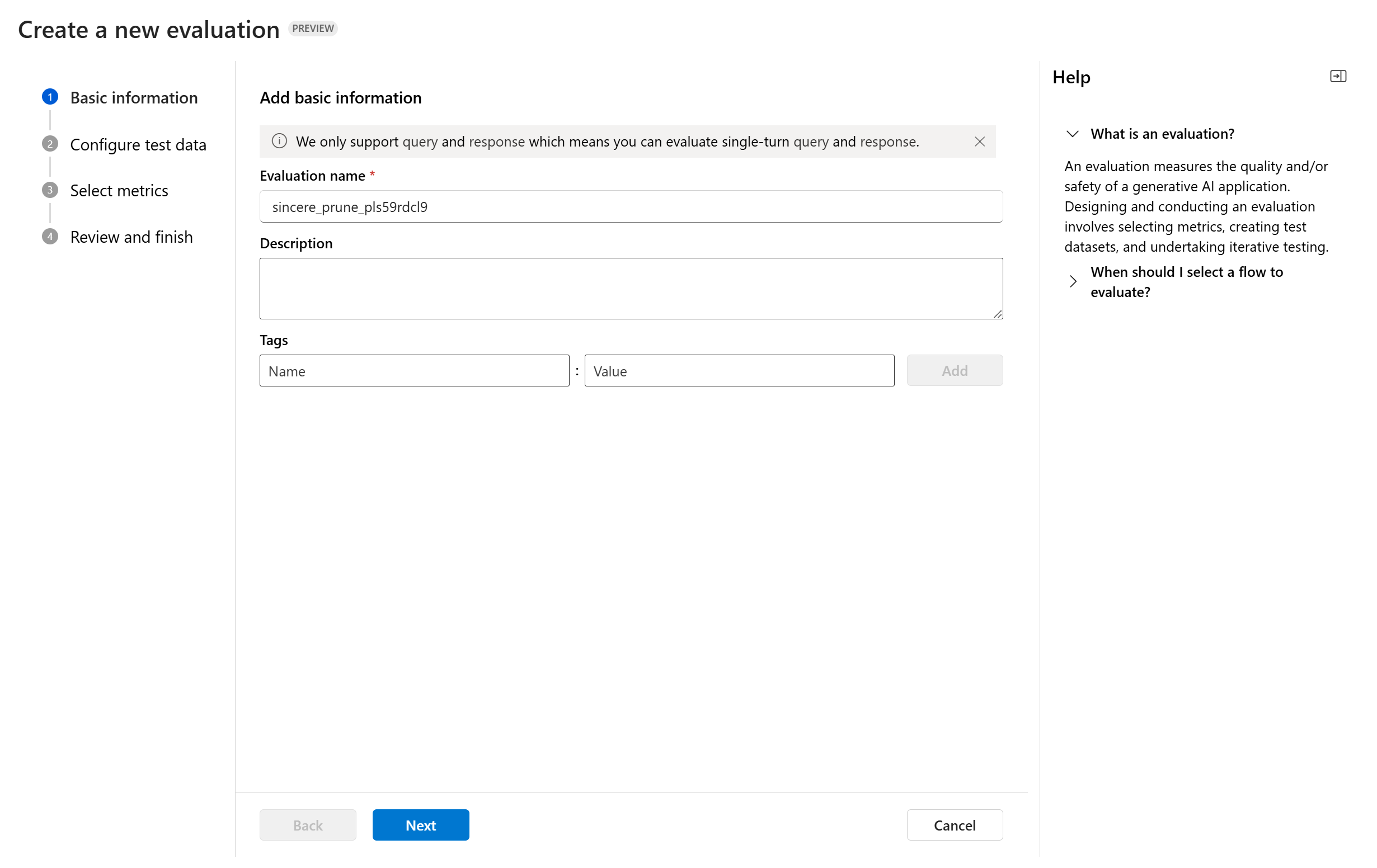

Im Auswertungserstellungs-Assistenten können Sie einen optionalen Namen für die Auswertungsausführung angeben. Derzeit wird Unterstützung für das Abfrage- und Antwortszenario angeboten, das für Anwendungen entwickelt wurde, die das Beantworten von Benutzerabfragen und das Bereitstellen von Antworten mit oder ohne Kontextinformationen umfassen.

Sie können optional Beschreibungen und Tags zu Auswertungsausführungen, um Organisation, Kontext und einfaches Abrufen zu verbessern.

Sie können das Hilfepanel verwenden, um die häufig gestellten Fragen zu lesen und sich die Abläufe des Assistenten erläutern zu lassen.

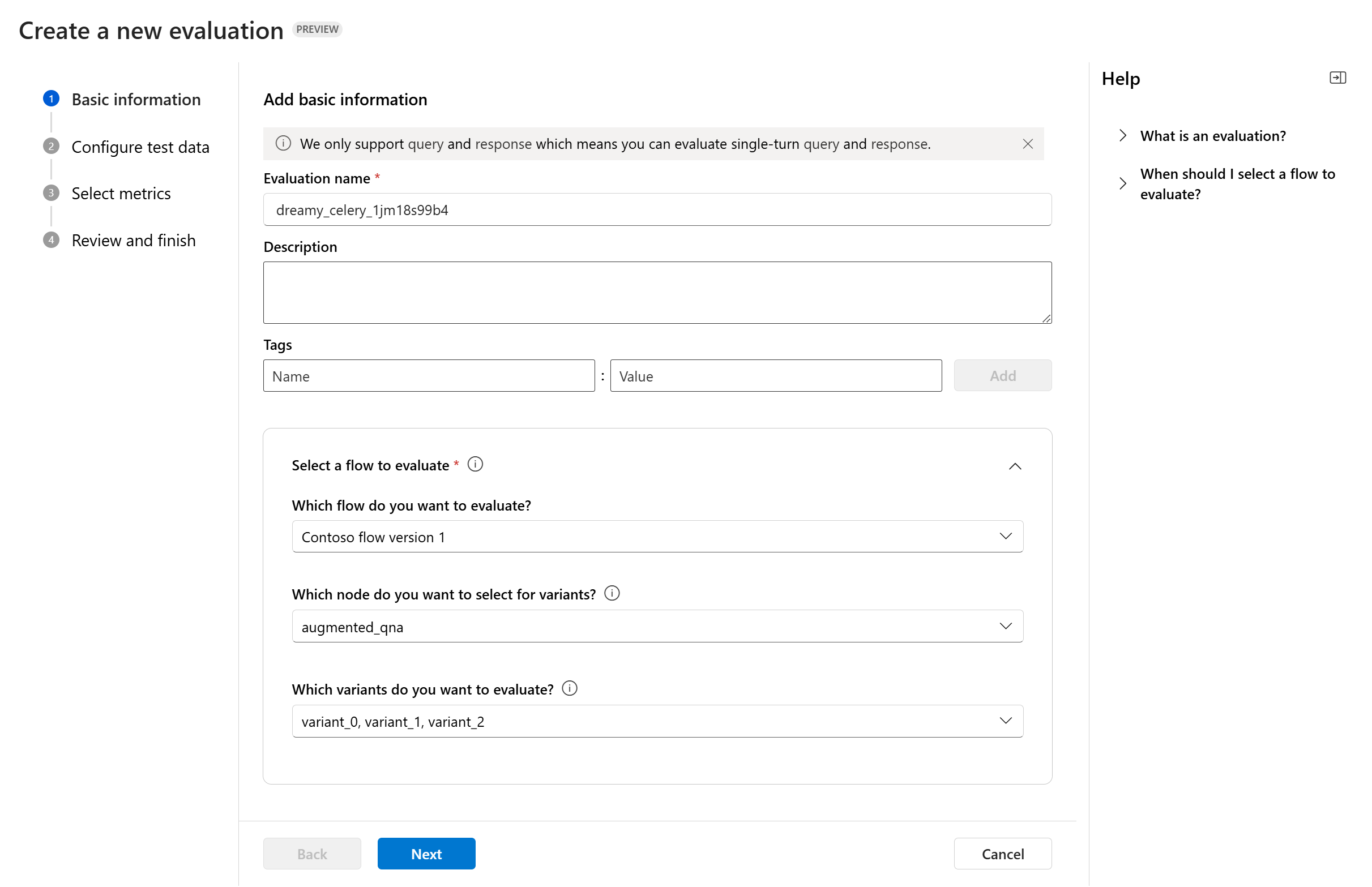

Wenn Sie einen Promptflow auswerten, können Sie den gewünschten Flow auswählen. Wenn Sie die Auswertung auf der Seite „Flow” initiieren, wählen wir automatisch Ihren Auswertungsflow aus. Wenn Sie einen anderen Flow auswerten möchten, können Sie einen anderen auswählen. Es ist wichtig zu beachten, dass innerhalb eines Flows möglicherweise mehrere Knoten vorhanden sind, von denen jeder über einen eigenen Satz von Varianten verfügen könnte. In solchen Fällen müssen Sie den Knoten und die Varianten angeben, die Sie während des Auswertungsprozesses bewerten möchten.

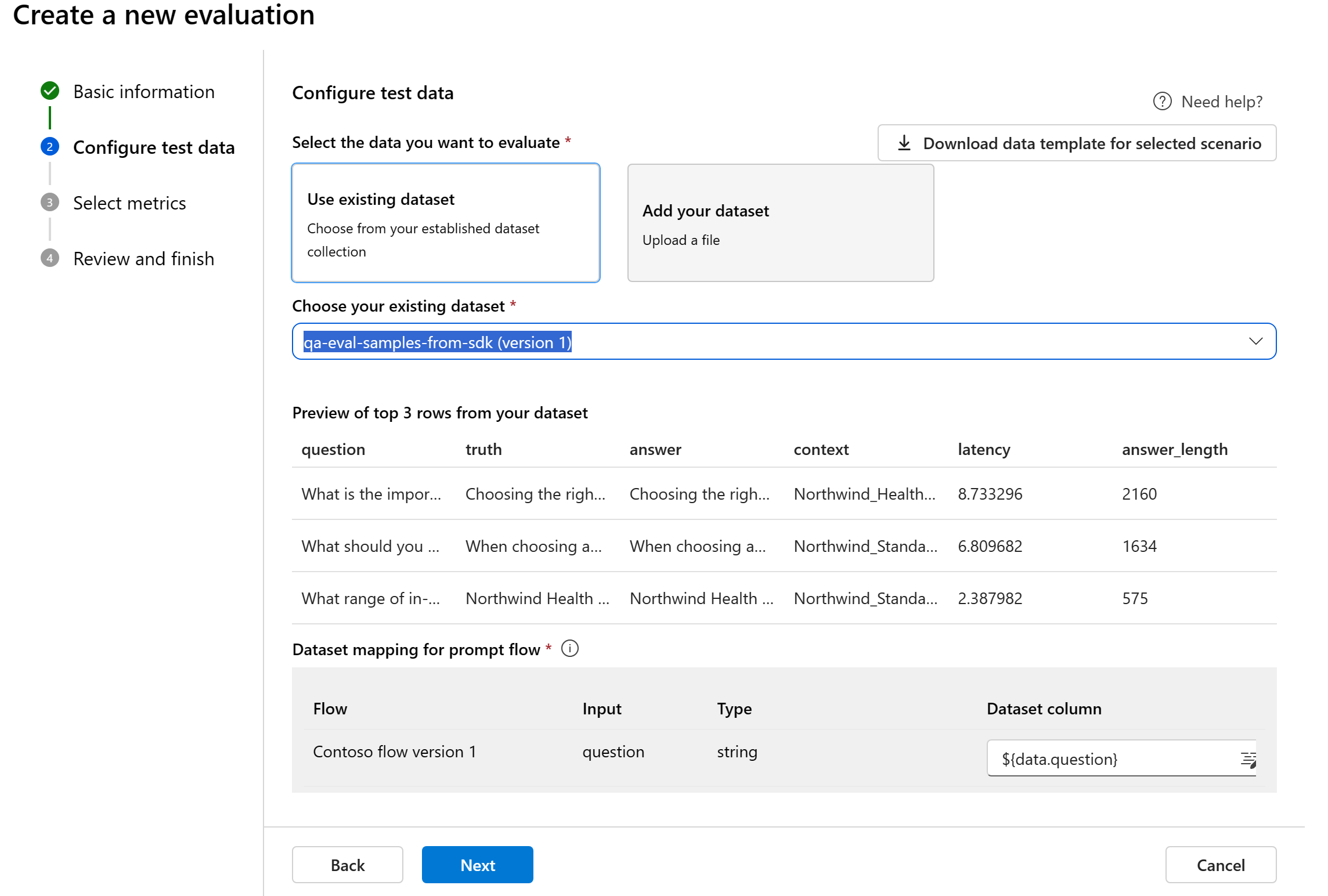

Testdaten konfigurieren

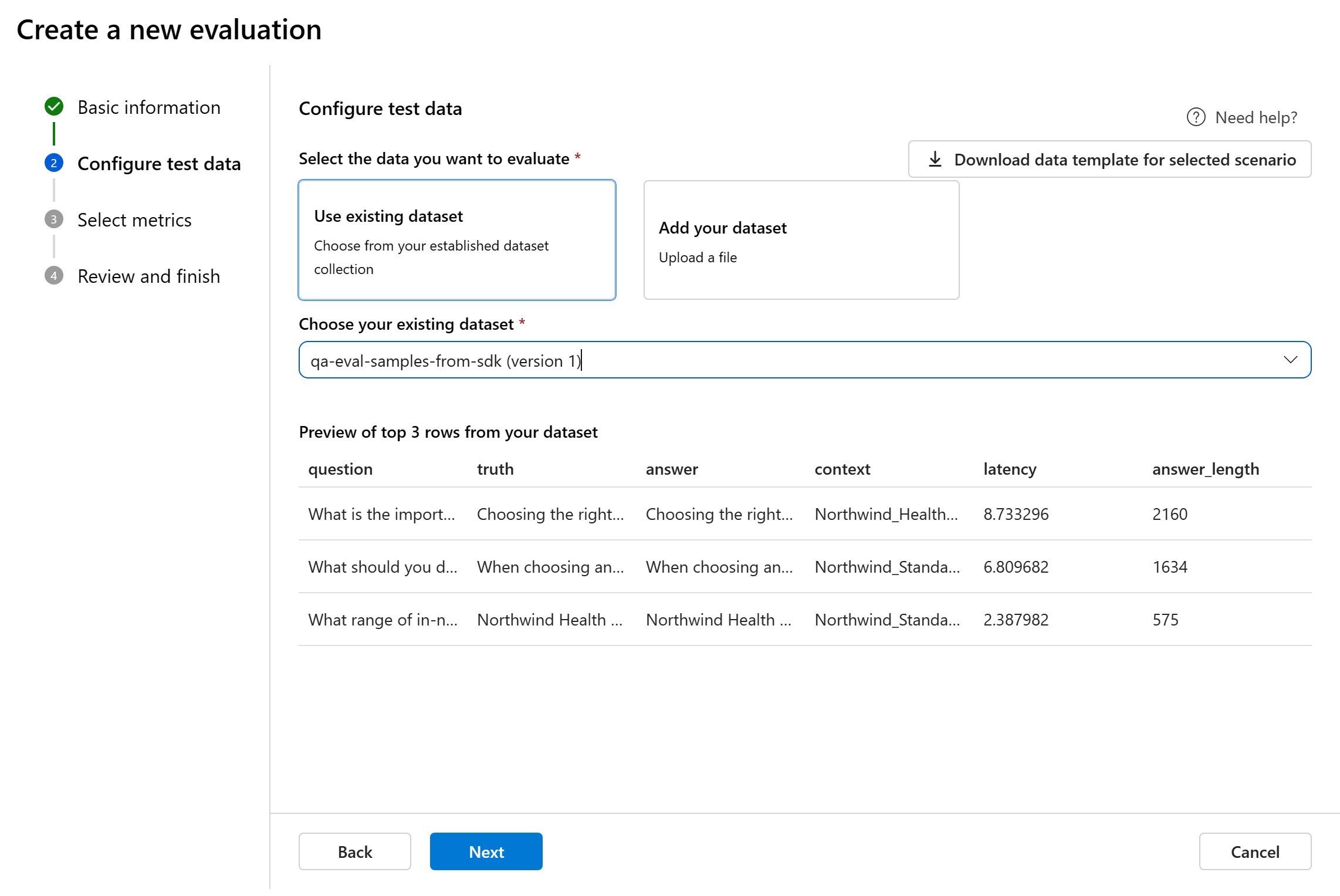

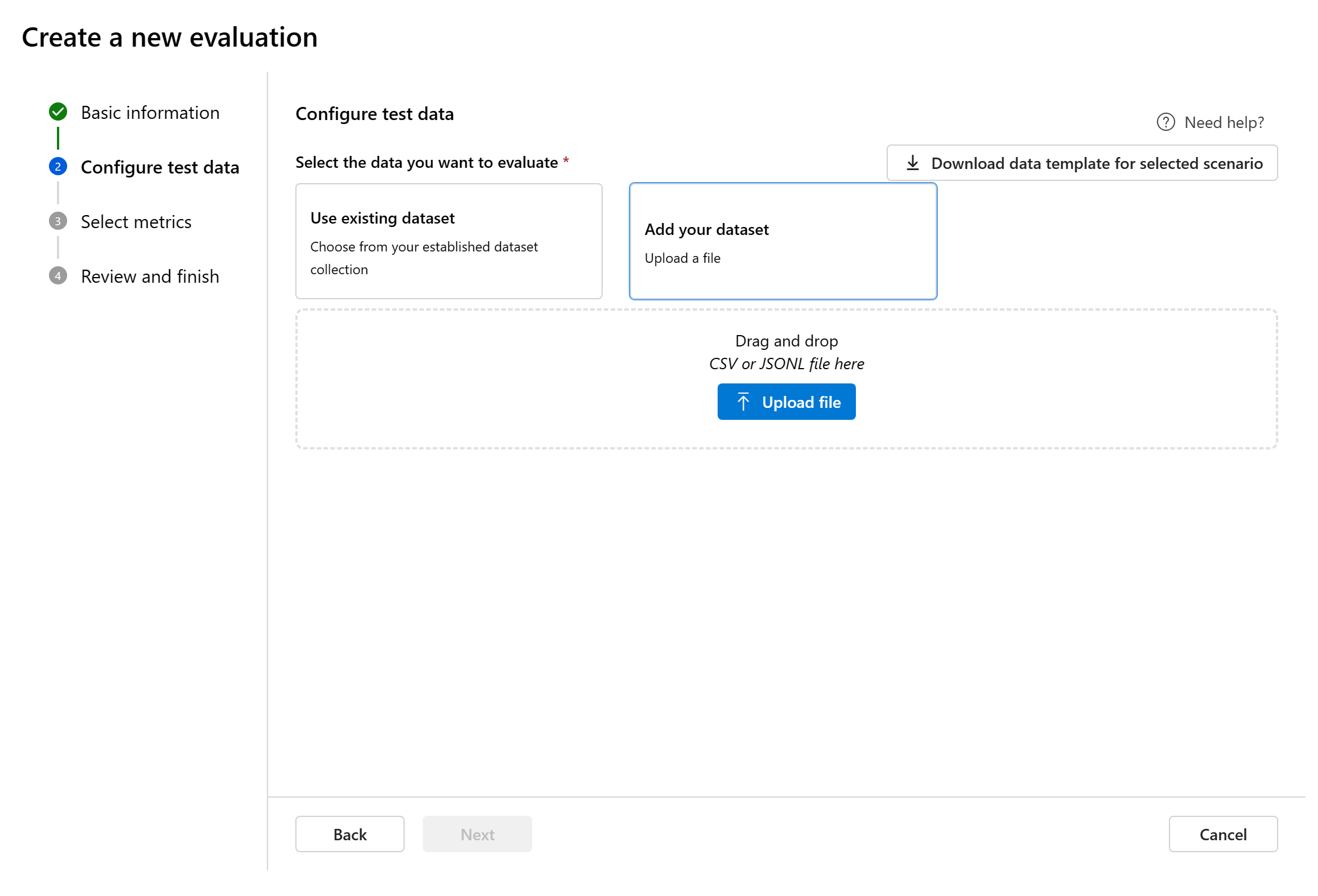

Sie können aus bereits vorhandenen Datasets auswählen oder ein neues Dataset hochladen, das ausgewertet werden soll. Das Test-Dataset muss über die vom Modell generierten Ausgaben für die Auswertung verfügen, wenn im vorherigen Schritt kein Flow ausgewählt wurde.

Wählen Sie ein vorhandenes Dataset aus: Sie können das Test-Dataset aus Ihrer etablierten Dataset-Sammlung auswählen.

Hinzufügen eines neuen Datasets: Sie können Dateien aus Ihrem lokalen Speicher hochladen. Es werden nur die Dateiformate

.csvund.jsonlunterstützt.Datenzuordnungen für Flows: Wenn Sie einen zu bewertenden Flow auswählen, stellen Sie sicher, dass Ihre Datenspalten so konfiguriert sind, dass sie mit den erforderlichen Eingaben für den Flow zum Ausführen einer Batchausführung übereinstimmen und die Ausgabe für die Bewertung generieren. Die Auswertung erfolgt dann mithilfe der Ausgabe des Flows. Konfigurieren Sie anschließend im nächsten Schritt die Datenzuordnung für Auswertungseingaben.

Metriken auswählen

Es werden drei von Microsoft kuratierte Arten von Metriken unterstützt, um eine umfassende Auswertung Ihrer Anwendung zu ermöglichen:

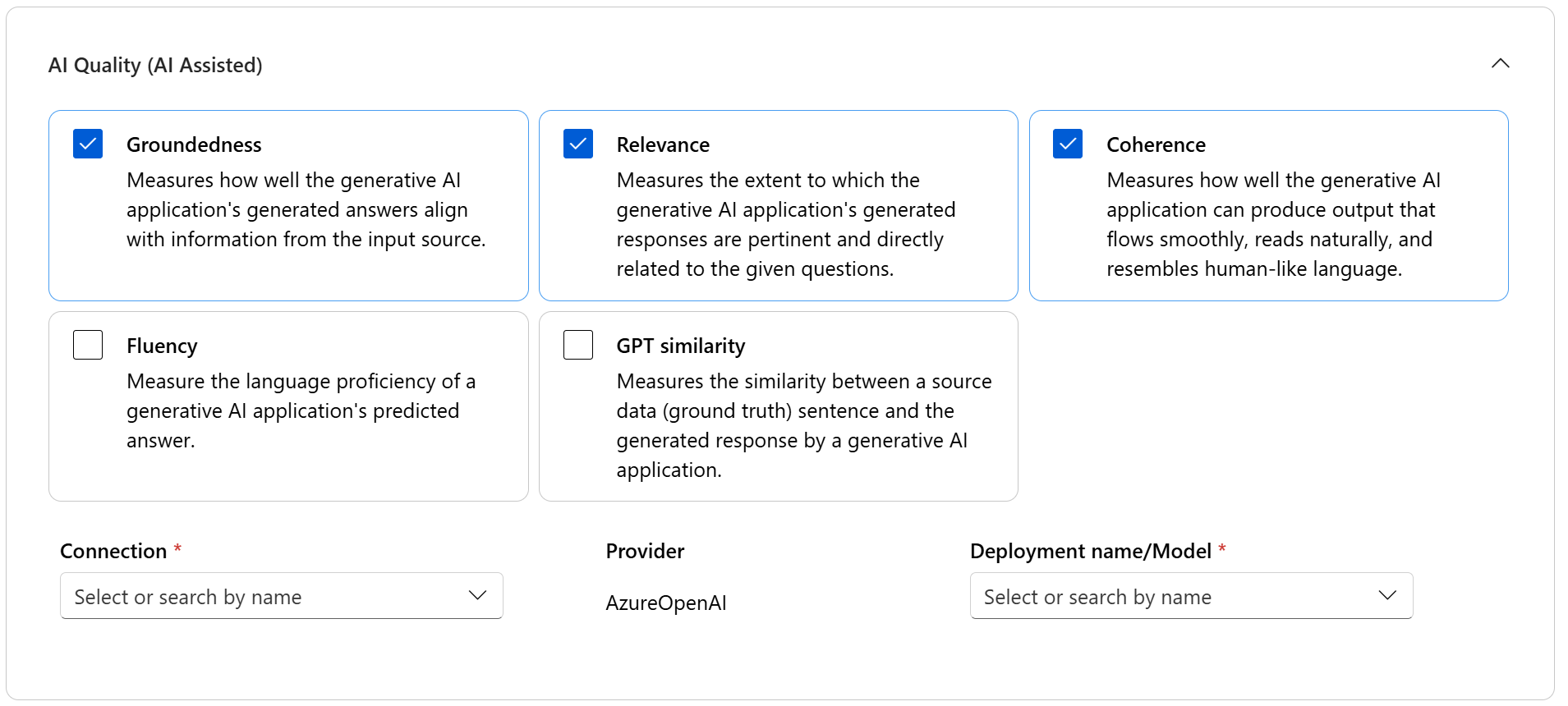

- KI-Qualität (KI-gestützt): Mit diesen Metriken wird die allgemeine Qualität und Kohärenz des generierten Inhalts auswertet. Um diese Metriken zu nutzen, muss eine Modellimplementierung als Richter fungieren.

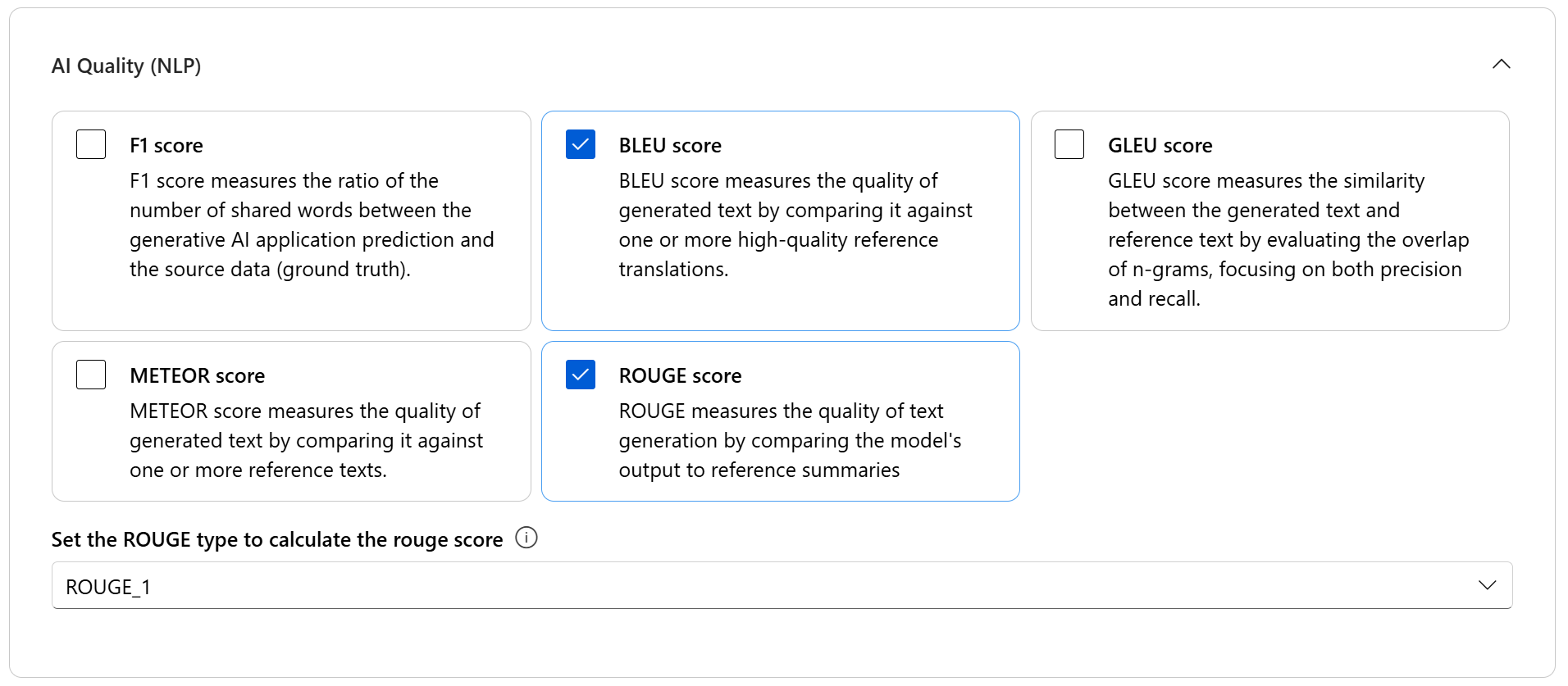

- KI-Qualität (NLP): Diese NLP-Metriken basieren auf Mathematik. Mit ihnen wird auch die allgemeine Qualität des generierten Inhalts ausgewertet. Sie erfordern häufig Ground Truth, aber keine Modellimplementierung als Richter.

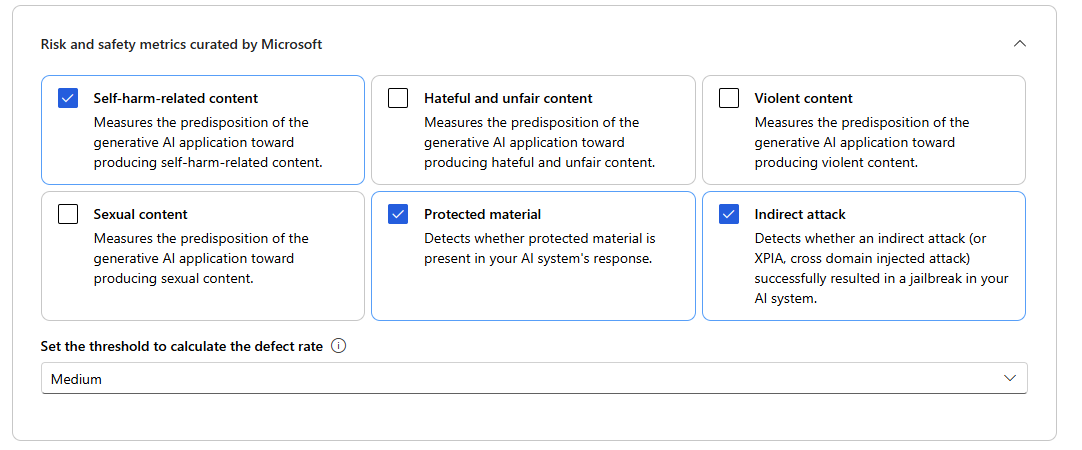

- Risiko- und Sicherheitsmetriken: Diese Metriken konzentrieren sich auf die Identifizierung potenzieller Inhaltrisiken und die Gewährleistung der Sicherheit der generierten Inhalte.

In der Tabelle finden Sie die vollständige Liste der Metriken, die für jedes Szenario unterstützt werden. Ausführlichere Informationen zu den einzelnen Metrikdefinitionen und deren Berechnung finden Sie unterAuswertungs- und Überwachungsmetriken.

| KI-Qualität (KI-gestützt) | KI-Qualität (NLP) | Risiko- und Sicherheitsmetriken |

|---|---|---|

| Groundedness, Relevanz, Kohärenz, Fluss, GPT-Ähnlichkeit | F1-Score, ROUGE-Score, BLEU-Score, GLEU-Score, METEOR-Score | Selbstverletzte Inhalte, Hass und unfaire Inhalte, gewalttätige Inhalte, sexuelle Inhalte, geschütztes Material, indirekte Angriffe |

Beim Ausführen einer KI-gestützten Qualitätsauswertung müssen Sie ein GPT-Modell für den Berechnungsprozess angeben. Wählen Sie eine Azure OpenAI-Verbindung und eine Bereitstellung mit GPT-3.5, GPT-4 oder dem Davinci-Modell für unsere Berechnungen aus.

KI-Qualität-Metriken (NLP) sind auf Mathematik basierende Messungen, mit denen die Leistung Ihrer Anwendung bewertet wird. Sie benötigen oft Ground Truth für die Berechnung. ROUGE ist eine Metrikfamilie. Sie können den ROUGE-Typ auswählen, um die Scores zu berechnen. Verschiedene Arten von ROUGE-Metriken bieten Möglichkeiten, die Qualität der Textgenerierung auszuwerten. ROUGE-N misst die Überlappung von N-Grammen zwischen Kandidat- und Referenztext.

Für Risiko- und Sicherheitsmetriken müssen Sie keine Verbindung und Bereitstellung bereitstellen. Der Back-End-Dienst für Sicherheitsbewertungen im Azure KI Foundry-Portal stellt ein GPT-4-Modell bereit, das Scores für den Schweregrad des Inhaltsrisikos und Argumente generieren kann, die es Ihnen ermöglichen, Ihre Anwendung auf Inhaltsschäden zu überprüfen.

Sie können den Schwellenwert festlegen, um die Fehlerrate für die Metriken für schädliche Inhalte zu berechnen (selbstverletzende Inhalte, Hass und unfaire Inhalte, gewalttätige Inhalte, sexuelle Inhalte). Die Fehlerrate wird berechnet, indem ein Prozentsatz der Instanzen mit Schweregraden (Sehr niedrig, Niedrig, Mittel, Hoch) über einem Schwellenwert berechnet wird. Standardmäßig legen wir den Schwellenwert auf „Mittel“ fest.

Bei geschützten Materialien und indirekten Angriffen wird die Fehlerrate als Prozentsatz der Instanzen berechnet, in denen die Ausgabe „true“ ist (Fehlerrate = (#trues / #instances) × 100).

Hinweis

KI-unterstützte Risiko- und Sicherheitsmetriken werden vom Back-End-Dienst für Sicherheitsbewertungen von Azure KI Foundry gehostet und sind nur in den folgenden Regionen verfügbar: USA, Osten 2, Frankreich, Mitte, Vereinigtes Königreich, Süden, Schweden, Mitte

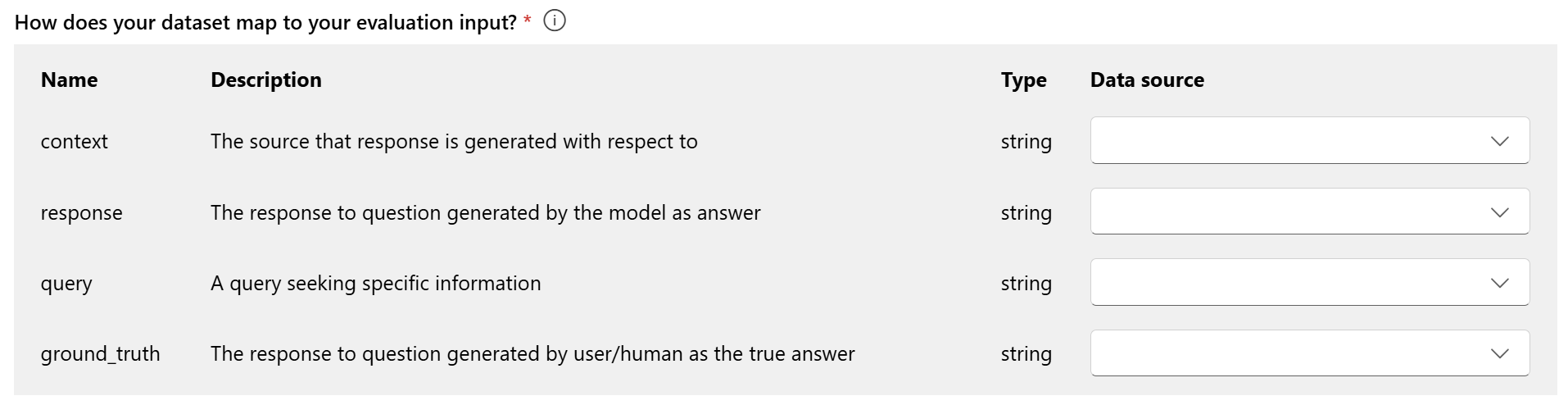

Datenzuordnung für die Auswertung: Sie müssen angeben, welche Datenspalten in Ihrem Dataset den Eingaben entsprechen, die in der Auswertung erforderlich sind. Verschiedene Auswertungsmetriken erfordern unterschiedliche Arten von Dateneingaben für genaue Berechnungen.

Hinweis

Wenn Sie Daten auswerten, sollte „Antwort“ der Antwortspalte in Ihrem Dataset ${data$response} zugeordnet sein. Wenn Sie einen Flow auswerten, sollte „Antwort“ aus der Flowausgabe ${run.outputs.response} stammen.

Einen Leitfaden zu den spezifischen Datenzuordnungsanforderungen für jede Metrik finden Sie in den Informationen in der Tabelle:

Anforderungen an die Abfrage- und Antwortmetriken

| Metrik | Abfrage | Antwort | Kontext | Grundwahrheit |

|---|---|---|---|---|

| Quellenübereinstimmung | Erforderlich: Str | Erforderlich: Str | Erforderlich: Str | Nicht zutreffend |

| Kohärenz | Erforderlich: Str | Erforderlich: Str | – | – |

| Geläufigkeit | Erforderlich: Str | Erforderlich: Str | – | – |

| Relevance | Erforderlich: Str | Erforderlich: Str | Erforderlich: Str | Nicht zutreffend |

| GPT-Ähnlichkeit | Erforderlich: Str | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| F1-Score | N/V | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| BLEU-Bewertung | N/V | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| GLEU-Score | N/V | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| METEOR Score | N/V | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| ROUGE-Score | N/V | Erforderlich: Str | Nicht zutreffend | Erforderlich: Str |

| Inhalte mit Bezug auf Selbstverletzung | Erforderlich: Str | Erforderlich: Str | – | – |

| Hasserfüllte und unfaire Inhalte | Erforderlich: Str | Erforderlich: Str | – | – |

| Gewalttätige Inhalte | Erforderlich: Str | Erforderlich: Str | – | – |

| Sexuelle Inhalte | Erforderlich: Str | Erforderlich: Str | – | – |

| Geschütztes Material | Erforderlich: Str | Erforderlich: Str | – | – |

| Indirekter Angriff | Erforderlich: Str | Erforderlich: Str | – | – |

- Abfrage: eine Frage nach bestimmten Informationen

- Antwort: die vom Modell generierte Antwort auf die Frage

- Kontext: die Quelle, in Bezug auf die die Antwort generiert wird, d. h. die Grounding-Dokumente

- Ground Truth: die Antwort auf die Abfrage, die vom Benutzer/Menschen als die tatsächliche Antwort generiert wurde

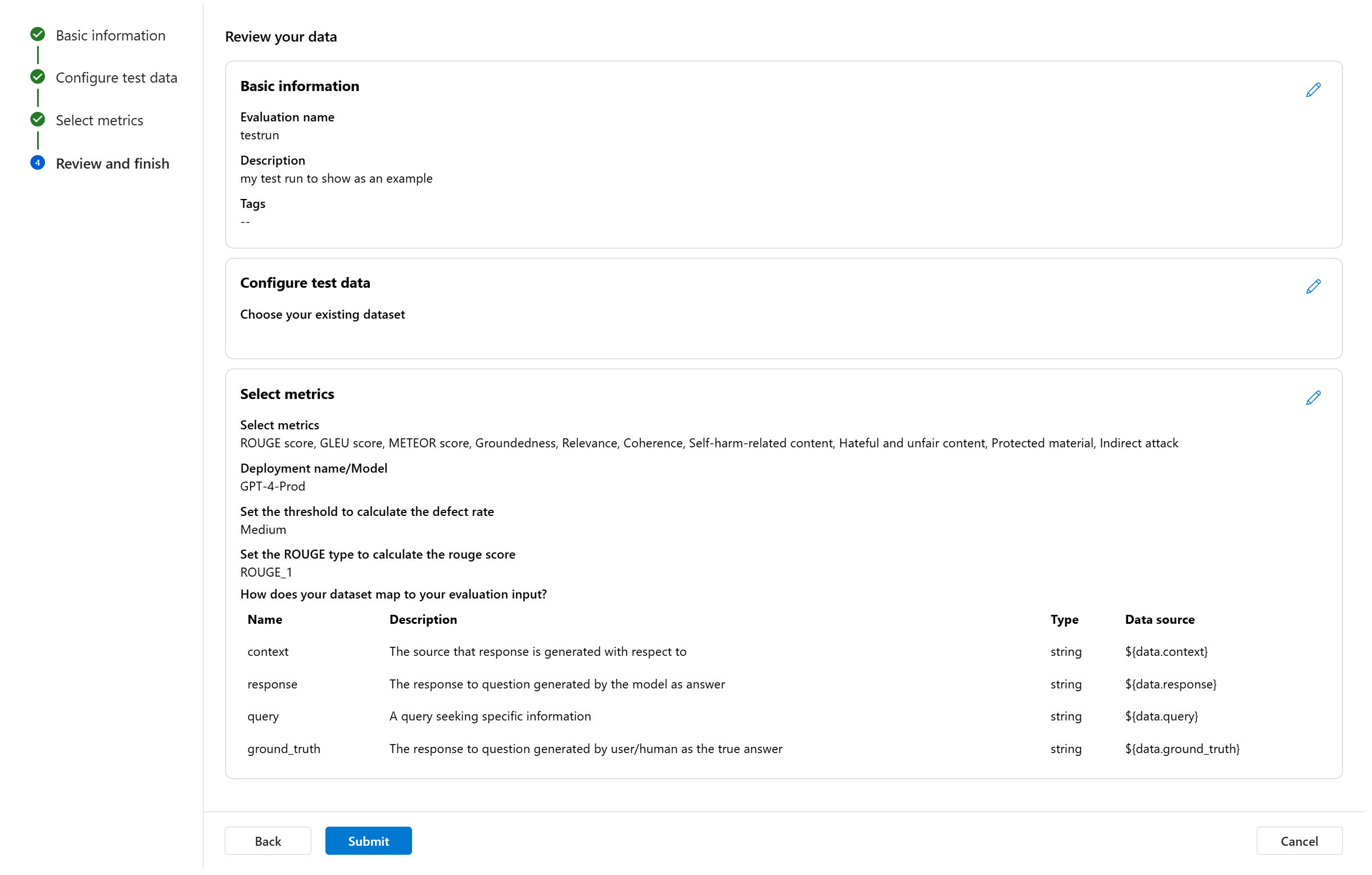

Prüfen und fertigstellen

Nachdem Sie alle erforderlichen Konfigurationen abgeschlossen haben, können Sie alles überprüfen und „Senden“ auswählen, um den Auswertungslauf zu übermitteln.

Modell- und Promptauswertung

Verwenden Sie das vereinfachte Modellauswertungspanel, um eine neue Auswertung für die ausgewählte Modellimplementierung und den definierten Prompt zu erstellen. Mit dieser optimierten Schnittstelle können Sie Auswertungen in einem einzigen konsolidierten Panels konfigurieren und initiieren.

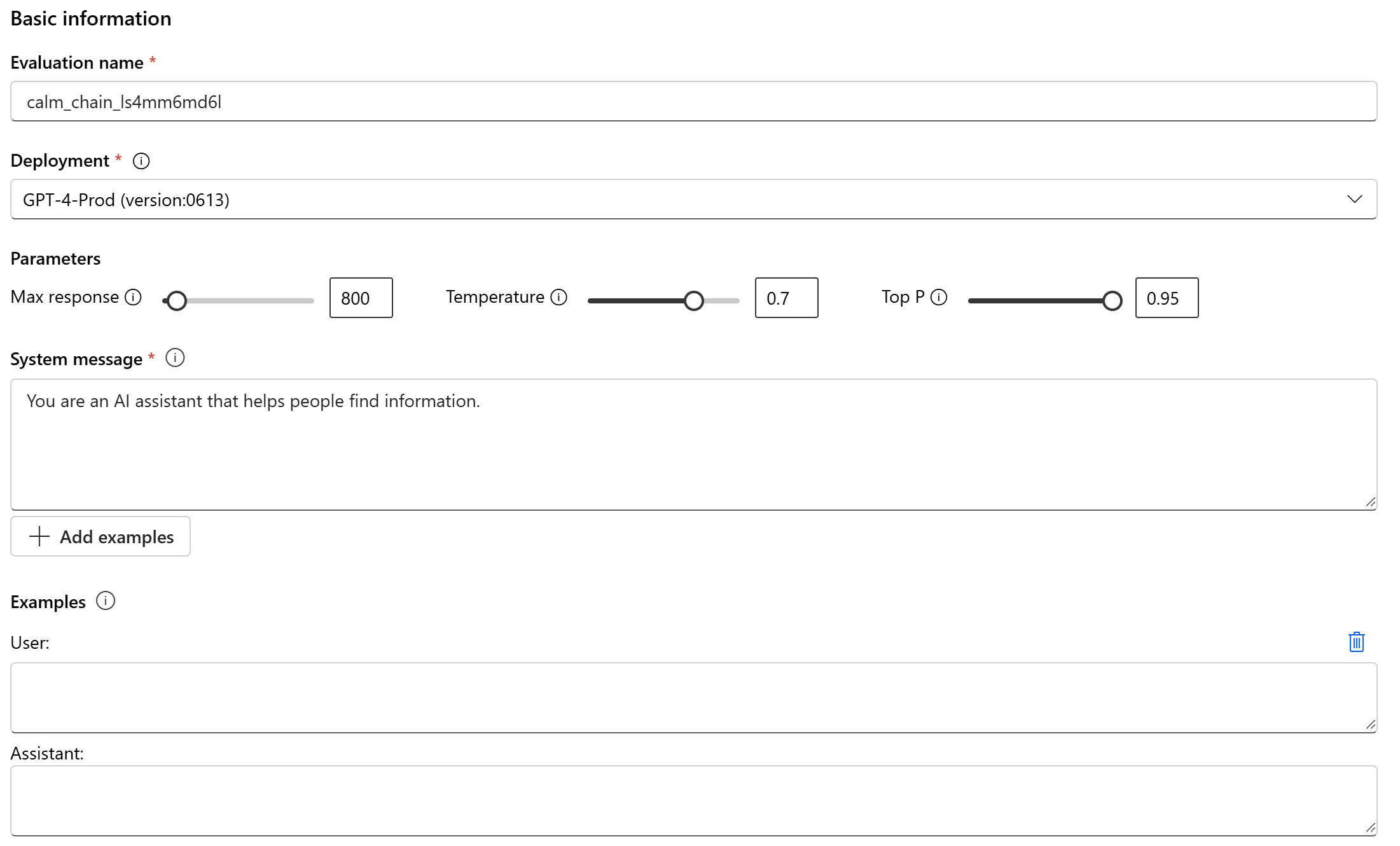

Grundlegende Informationen

Zunächst können Sie den Namen für die Auswertungsausführung angeben. Wählen Sie dann die Modellimplementierung aus, die Sie auswerten möchten. Es werden sowohl Azure OpenAI-Modelle als auch andere offene Modelle unterstützt, die mit Model-as-a-Service (MaaS) kompatibel sind, z. B. Meta Llama- und Modelle der Phi-3-Familie. Optional können Sie die Modellparameter wie maximale Antwort, Temperatur und Top P nach Ihrem Bedarf anpassen.

Geben Sie ins Textfeld „Systemnachricht“ den Prompt für Ihr Szenario ein. Weitere Informationen zum Erstellen Ihres Prompts finden Sie im Promptkatalog. Sie können ein Beispiel hinzufügen, an dem sich der Chat bei Antworten orientieren kann. Es wird versucht, alle Antworten nachzuahmen, die Sie hier hinzufügen. Damit soll sichergestellt werden, dass sie den Regeln entsprechen, die Sie in der Systemnachricht angegeben haben.

Testdaten konfigurieren

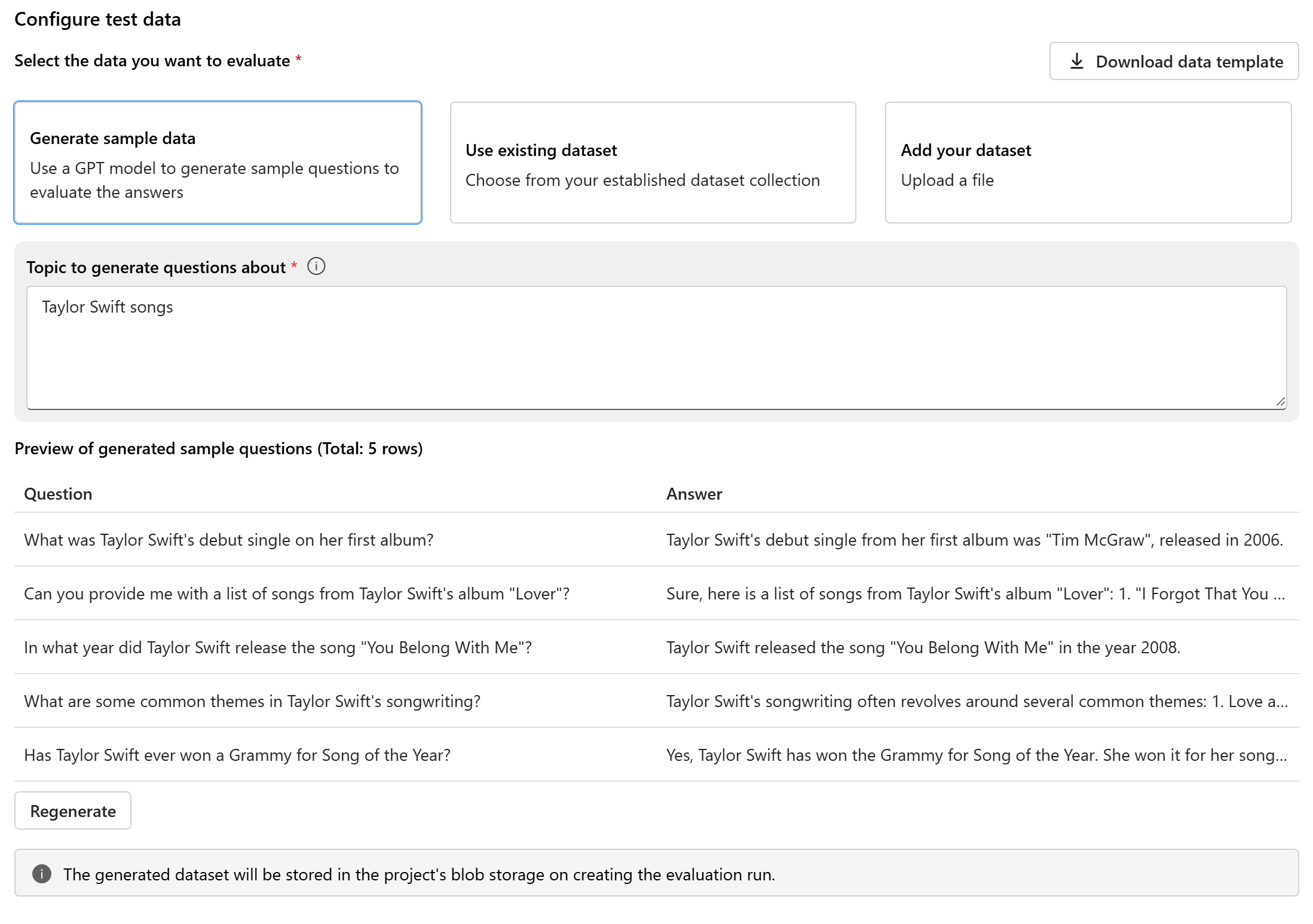

Nachdem Sie das Modell und den Prompt konfiguriert haben, richten Sie das Testdataset ein, das für die Auswertung verwendet wird. Dieses Dataset wird an das Modell gesendet, um Antworten für die Bewertung zu generieren. Sie haben drei Optionen zum Konfigurieren Ihrer Testdaten:

- Generieren von Beispieldaten

- Verwenden eines vorhandenen Datasets

- Hinzufügen Ihres Datasets

Wenn Ihnen kein Dataset zur Verfügung steht und Sie eine Auswertung mit kleiner Beispielgröße ausführen möchten, können Sie ein GPT-Modell verwenden, um Beispielfragen basierend auf Ihrem ausgewählten Thema zu generieren. Das Thema hilft dabei, die generierten Inhalte an Ihren Interessenbereich anzupassen. Die Abfragen und Antworten werden in Echtzeit generiert, und Sie haben die Möglichkeit, sie nach Bedarf neu zu generieren.

Hinweis

Das generierte Dataset wird im BLOB-Speicher des Projekts gespeichert, sobald die Auswertung erstellt wurde.

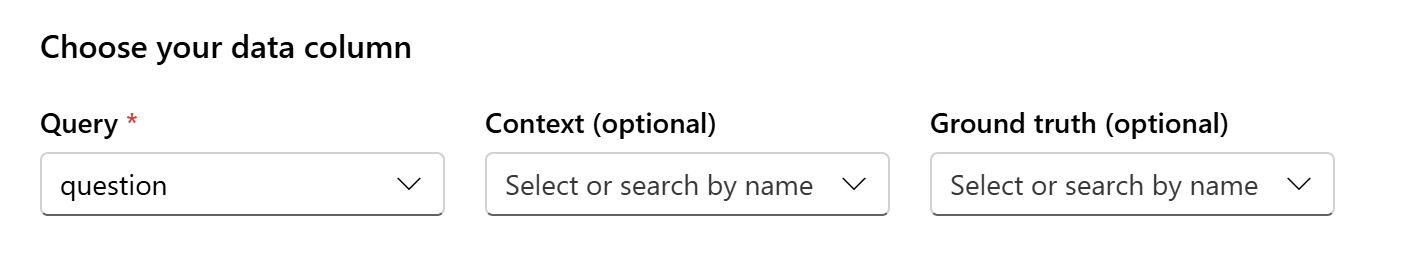

Datenzuordnung

Wenn Sie ein vorhandenes Dataset verwenden oder ein neues Dataset hochladen möchten, müssen Sie die Spalten des Datasets den für die Auswertung erforderlichen Feldern zuordnen. Während der Auswertung wird die Antwort des Modells anhand der wichtigsten Eingaben ausgewertet, z. B.:

- Abfrage: für alle Metriken erforderlich

- Kontext: optional

- Ground Truth: optional, erforderlich für KI-Qualitätsmetriken (NLP)

Diese Zuordnungen stellen eine genaue Harmonisierung zwischen Ihren Daten und den Auswertungskriterien sicher.

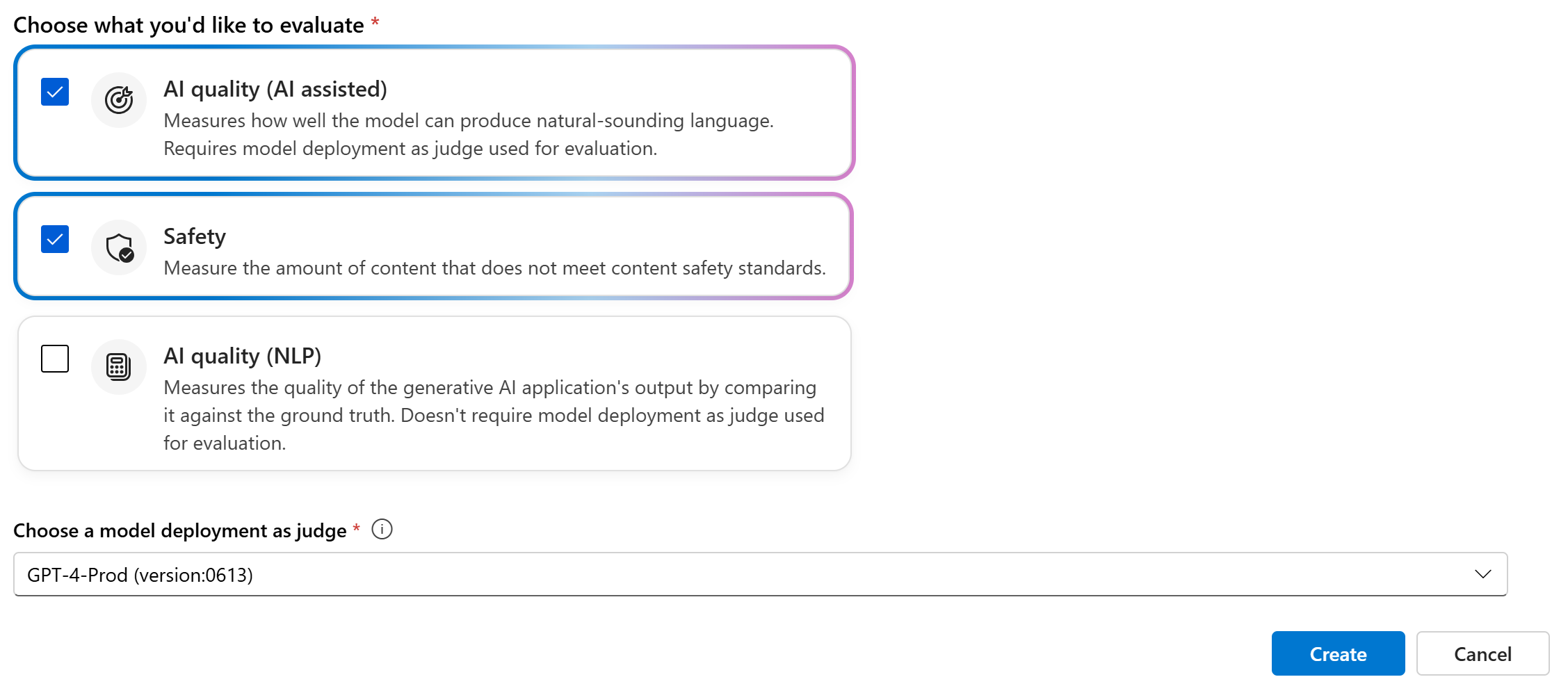

Auswählen von Auswertungsmetriken

Der letzte Schritt besteht im Auswählen, was Sie auswerten möchten. Anstatt einzelne Metriken auszuwählen und sich mit allen verfügbaren Optionen vertraut zu machen, können Sie den Prozess vereinfachen, indem Sie Metrikkategorien auswählen, die Ihren Anforderungen am meisten entsprechen. Wenn Sie eine Kategorie auswählen, werden alle relevanten Metriken in dieser Kategorie basierend auf den Datenspalten berechnet, die Sie im vorherigen Schritt angegeben haben. Nachdem Sie die Metrikkategorien ausgewählt haben, können Sie „Erstellen“, um die Auswertungsausführung zu übermitteln, und zur Auswertungsseite wechseln, um die Ergebnisse anzuzeigen.

Drei Kategorien werden unterstützt:

- KI-Qualität (KI-gestützt): Sie müssen eine Azure OpenAI-Modellimplementierung als Richter bereitstellen, um die KI-gestützten Metriken zu berechnen.

- KI-Qualität (NLP)

- Sicherheit

| KI-Qualität (KI-gestützt) | KI-Qualität (NLP) | Sicherheit |

|---|---|---|

| Groundedness (erfordert Kontext), Relevanz (erfordert Kontext), Kohärenz, Fluss | F1-Score, ROUGE-Score, BLEU-Score, GLEU-Score, METEOR-Score | Selbstverletzte Inhalte, Hass und unfaire Inhalte, gewalttätige Inhalte, sexuelle Inhalte, geschütztes Material, indirekte Angriffe |

Erstellen einer Auswertung mit benutzerdefiniertem Auswertungsflow

Sie können eigene Auswertungsmethoden entwickeln:

Auf der Flowseite: Wählen Sie im einklappbaren linken Menü Prompt flow>Auswerten>Benutzerdefinierte Auswertung aus.

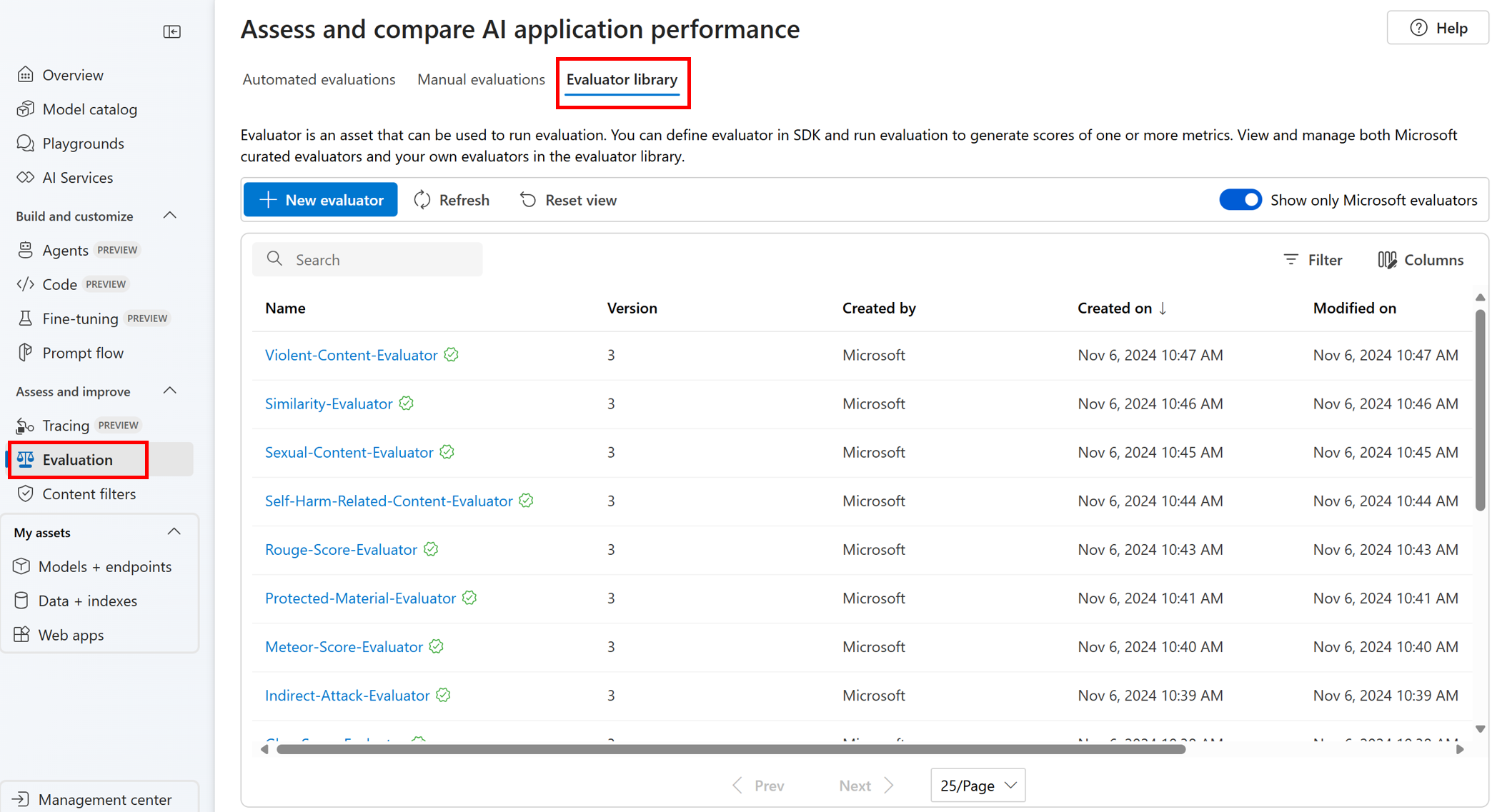

Anzeigen und Verwalten der Auswertungen in der Auswertungsbibliothek

Die Auswertungsbibliothek ist ein zentraler Ort, an dem Sie die Details und den Status Ihrer Auswertungen anzeigen können. Sie können von Microsoft kuratierte Auswertungen anzeigen und verwalten.

Tipp

Sie können benutzerdefinierte Auswertungen über das prompt flow SDK verwenden. Weitere Informationen finden Sie unter Bewerten mit dem prompt flow-SDK.

Die Auswertungsbibliothek ermöglicht auch die Versionsverwaltung. Sie können unterschiedliche Versionen Ihrer Arbeit vergleichen, bei Bedarf frühere Versionen wiederherstellen und einfacher mit anderen Personen zusammenarbeiten.

Um die Auswertungsbibliothek im Azure KI Foundry-Portal zu verwenden, wechseln Sie zur Seite Auswertung Ihres Projekts, und wählen Sie die Registerkarte Auswertungsbibliothek aus.

Sie können den Namen der Auswertung auswählen, um weitere Details anzuzeigen. Sie können den Namen, die Beschreibung und Parameter anzeigen und die der Auswertung zugeordneten Dateien überprüfen. Im Anschluss folgen einige Beispiele für von Microsoft kuratierte Ressourcen:

- Für von Microsoft kuratierte Leistungs- und Qualitätsauswertungen können Sie den Prompt für Anmerkungen auf der Detailseite anzeigen. Sie können diese Prompts mit dem Azure KI Evaluation-SDK an Ihren eigenen Anwendungsfall anpassen, indem Sie die Parameter oder Kriterien entsprechend Ihren Daten und Zielen ändern. Sie können z. B. Groundedness-Evaluator auswählen und die Prompt-Datei überprüfen, die zeigt, wie die Metrik berechnet wird.

- Für von Microsoft kuratierte Risiko- und Sicherheitsauswertungen können Sie die Definition der Metriken anzeigen. Sie können z. B. Self-Harm-Related-Content-Evaluator auswählen und erfahren, was dies bedeutet und wie Microsoft die verschiedenen Schweregrade für diese Sicherheitsmetrik festlegt.

Nächste Schritte

Erfahren Sie mehr darüber, wie Sie Ihre generativen KI-Anwendungen auswerten: