Worum handelt es sich beim Speech-Dienst?

Der Speech-Dienst bietet mit einer Speech-Ressource Funktionen für die Spracherkennung und Sprachsynthese. Sie können Sprache mit hoher Genauigkeit in Text transkribieren, Text in natürlich klingende Sprache konvertieren, gesprochene Audiodaten übersetzen und bei Konversationen die Sprechererkennung verwenden.

Erstellen Sie benutzerdefinierte Stimmen, fügen Sie Ihrem Basisvokabular bestimmte Wörter hinzu, oder erstellen Sie eigene Modelle. Sie können Speech überall ausführen – in der Cloud oder am Edge in Containern. Mithilfe der Speech-CLI, des Speech-SDK und der REST-APIs können Sie Ihre Anwendungen komfortabel mit Sprachfunktionen ausstatten.

Speech ist für viele Sprachen und Regionen sowie zu unterschiedlichen Preisen verfügbar.

Speech-Szenarien

Gängige Szenarien für die Verwendung von Speech sind z. B.:

- Untertitelung: Sie können Untertitel mit Ihrer Audioeingabe synchronisieren, Filter für anstößige Ausdrücke anwenden, Teilergebnisse abrufen, Anpassungen vornehmen und gesprochene Sprachen in mehrsprachigen Szenarien identifizieren.

- Audioinhaltserstellung: Gestalten Sie mit neuronalen Stimmen Interaktionen mit Chatbots und Sprach-Assistenten noch natürlicher und einladender, konvertieren Sie digitale Texte wie E-Books in Audiobooks, und verbessern Sie Navigationssysteme im Auto.

- Callcenter: Transkribieren Sie Anrufe in Echtzeit, verarbeiten Sie einen Batch von Anrufen, redigieren Sie personenbezogene Informationen, und extrahieren Sie Erkenntnisse wie die Stimmung, um die Arbeit in Ihrem Callcenter effizienter und einfacher zu gestalten.

- Sprachlernen: Geben Sie Sprachlernern Feedback in Form von Aussprachebewertung, unterstützen Sie die Echtzeittranskription für Unterhaltungen im Fernunterricht, und lassen Sie Unterrichtsmaterialien mit neuronalen Stimmen laut vorlesen.

- Sprach-Assistenten: Erstellen Sie natürliche Konversationsschnittstellen für Ihre Anwendungen und Umgebungen, die der menschlichen Sprache nahekommen. Die Funktion für den Sprach-Assistenten ermöglicht die schnelle, zuverlässige Interaktion zwischen einem Gerät und einer Assistentenimplementierung.

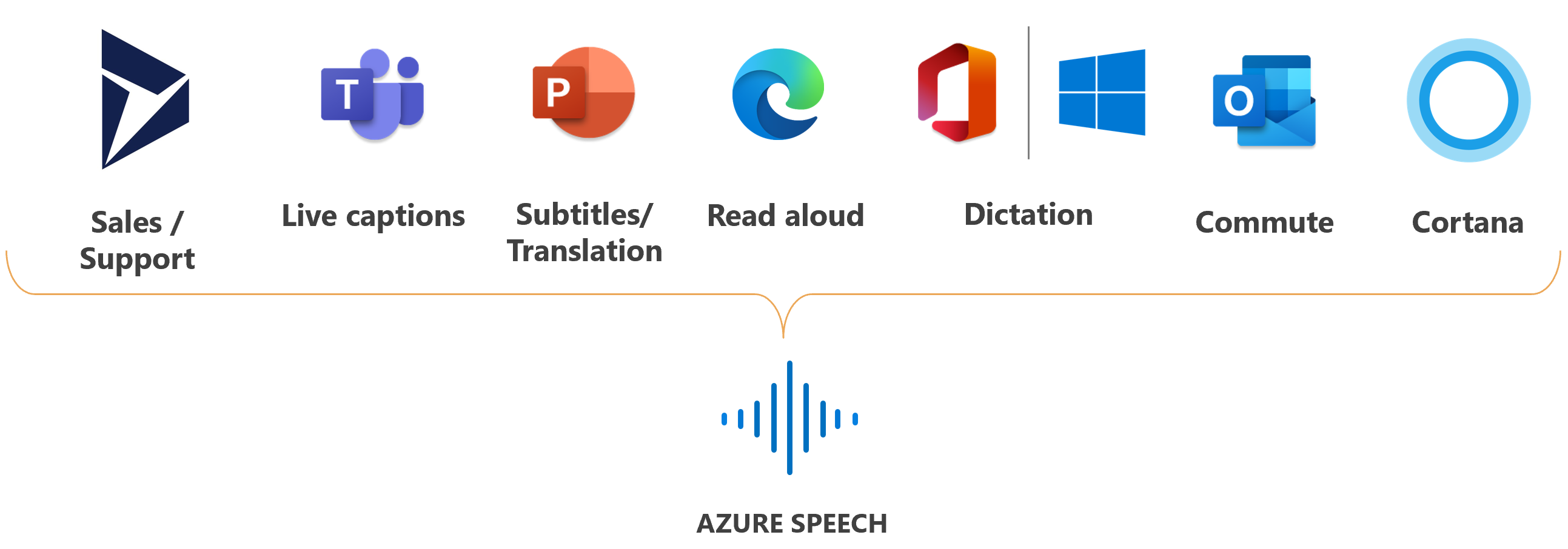

Microsoft verwendet Speech für viele Szenarien, z. B. zum Erstellen von Untertiteln in Teams, Diktieren in Office 365 und Vorlesen im Microsoft Edge-Browser.

Sprachfunktionen

In diesen Abschnitten werden Speech-Funktionen mit Links zusammengefasst, unter denen Sie weitere Informationen finden.

Spracherkennung

Verwenden Sie die Spracherkennung, um Audio in Text zu transkribieren, entweder in Echtzeit oder asynchron mithilfe von Batchtranskription.

Tipp

Sie können Spracherkennung in Echtzeit in Speech Studio ausprobieren, ohne sich zu registrieren oder Code zu schreiben.

Konvertieren Sie Audio aus einer Reihe von Quellen (darunter Mikrofone, Audiodateien und Blobspeicher) in Text. Verwenden Sie die Sprecherdiarisierung (Sprechertrennung), um zu bestimmen, wer was wann gesagt hat. Erstellen Sie lesbare Transkripts mit automatischer Formatierung und Interpunktion.

Das Basismodell reicht möglicherweise nicht aus, wenn die Audiodaten Umgebungsgeräusche oder umfassenden branchen- und domänenspezifischen Jargon enthalten. In diesen Fällen können Sie benutzerdefinierte Sprachmodelle mit Akustik-, Sprach- und Aussprachedaten erstellen und trainieren. Benutzerdefinierte Sprachmodelle sind privat und können einen Wettbewerbsvorteil bieten.

Spracherkennung in Echtzeit

Bei der Spracherkennung in Echtzeit wird das Audiomaterial transkribiert, während die Sprache von einem Mikrofon oder einer Datei erkannt wird. Verwenden Sie Spracherkennung in Echtzeit für Anwendungen, die Audiodaten in Echtzeit transkribieren müssen, z. B.:

- Transkriptionen, Untertitel für Hörgeschädigte oder Untertitel für Livebesprechungen

- Diarisierung (Sprechertrennung)

- Aussprachebewertung

- Contact Center-Agenten-Unterstützung

- Diktieren

- Sprach-Agents

API für schnelle Transkription

Die API für schnelle Transkription wird verwendet, um Audiodateien synchron und viel schneller als Echtzeitaudio zu transkribieren. Verwenden Sie schnelle Transkription in den Szenarien, in denen Sie die Transkription einer Audioaufzeichnung so schnell wie möglich mit vorhersagbarer Latenz benötigen, z. B.:

- Schnelle Audio- oder Videotranskription, Untertitel und Bearbeitung.

- Videoübersetzung

Weitere Informationen zu den ersten Schritten mit der schnellen Transkription finden Sie unter Verwenden der API für schnelle Transkription.

Batch-Transkription

Die Batch-Transkription wird für die Transkription großer Mengen an Audiomaterial im Speicher verwendet. Sie können per SAS-URI (Shared Access Signature) auf Audiodateien verweisen und Transkriptionsergebnisse asynchron empfangen. Verwenden Sie die Batchtranskription für Anwendungen, die Audiodaten in einem Massenvorgang transkribieren müssen, z. B.:

- Transkriptionen, Untertitel für Hörgeschädigte oder Untertitel für vorab aufgezeichnete Audiodaten

- Contact Center-Post-Call-Analysen

- Diarisierung (Sprechertrennung)

Sprachsynthese

Mit der Sprachsynthese können Sie Eingabetext in menschlich klingende synthetische Sprache konvertieren. Verwenden Sie neuronale Stimmen. Dabei handelt es sich um menschenähnliche Stimmen, die von Deep Neural Networks unterstützt werden. Verwenden Sie die Markupsprache für Sprachsynthese (Speech Synthesis Markup Language, SSML), um Tonhöhe, Aussprache, Sprechgeschwindigkeit, Lautstärke usw. anzupassen und zu optimieren.

- Vordefinierte neuronale Stimme: Äußerst natürliche, sofort einsetzbare Stimmen. Hören Sie sich die vordefinierten neuronalen Stimmbeispiele im Stimmkatalog an, und wählen Sie die für Ihre Geschäftsanforderungen geeignete Stimme aus.

- Benutzerdefinierte neuronale Stimme: Neben den vordefinierten neuronalen Stimmen können Sie auch eine wiedererkennbare und einzigartige benutzerdefinierte neuronale Stimme für Ihre Marke oder Ihr Produkt erstellen. Benutzerdefinierte neuronale Stimmen sind privat und können einen Wettbewerbsvorteil bieten. Hören Sie sich die benutzerdefinierten neuronalen Stimmbeispiele an.

Sprachübersetzung

Die Sprachübersetzung ermöglicht Echtzeitübersetzungen in mehreren Sprachen für Ihre Anwendungen, Tools und Geräte. Verwenden Sie dieses Feature für die Übersetzung von Sprache in Sprache und Sprache in Text.

Sprachenerkennung

Bei der Sprachenerkennung werden anhand einer Liste unterstützter Sprachen die in der Audioquelle gesprochenen Sprachen identifiziert. Die Sprachenerkennung kann eigenständig oder in Kombination mit der Spracherkennung oder Sprachübersetzung verwendet werden.

Sprechererkennung

Die Sprechererkennung bietet Algorithmen, mit denen Sprecher anhand ihrer individuellen Stimmmerkmale überprüft und identifiziert werden. Die Sprechererkennung wird verwendet, um zu ermitteln, wer spricht.

Aussprachebewertung

Die Aussprachebewertung bewertet die Aussprache und gibt den Rednern Feedback zur Genauigkeit und zum Redefluss der gesprochenen Audioinformationen. Mit dieser Aussprachebewertung erhalten Menschen, die Fremdsprachen lernen, direktes Feedback und können ihre Aussprache verbessern, sodass sie selbstbewusst sprechen und sich präsentieren können.

Absichtserkennung

Absichtserkennung: Verwenden Sie die Spracherkennung mit Conversational Language Understanding (CLU), um Benutzerabsichten aus transkribierter Sprache abzuleiten und auf Sprachbefehle zu reagieren.

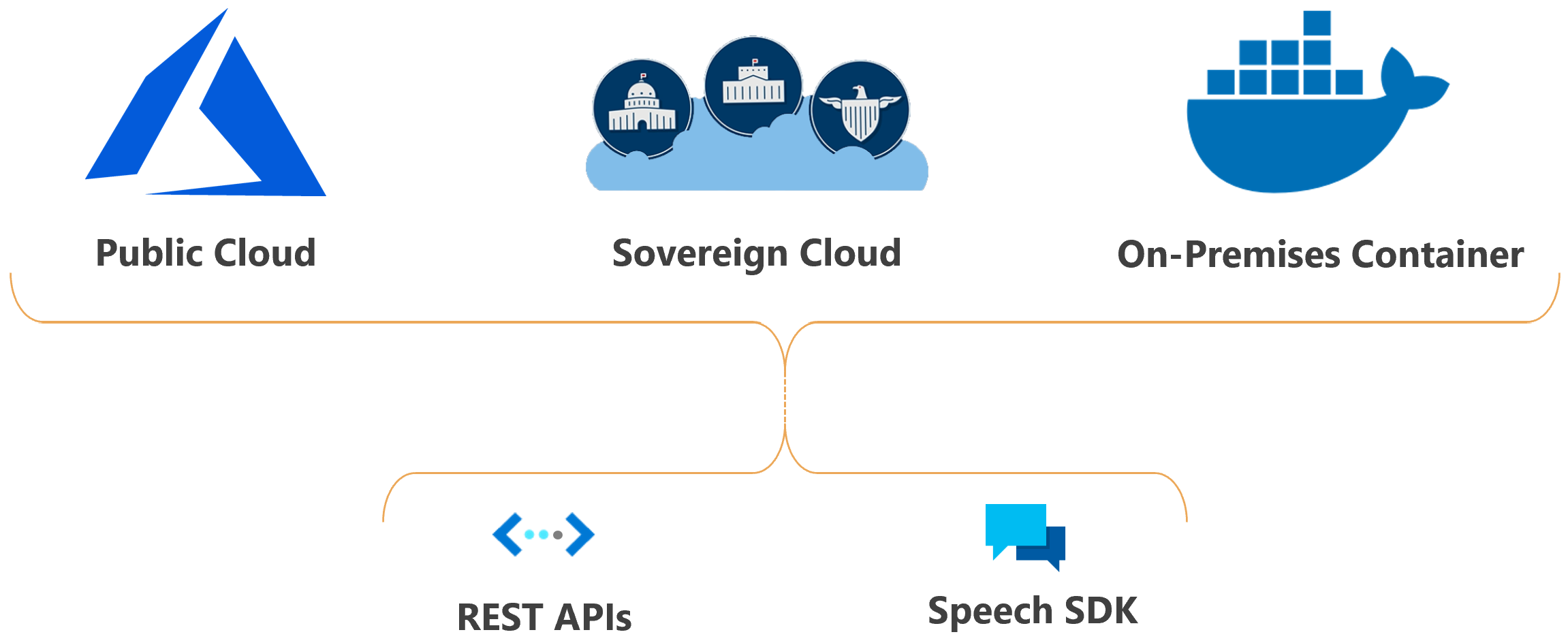

Bereitstellung und Präsenz

Sie können Azure KI Speech-Features in der Cloud oder lokal bereitstellen.

Mithilfe von Containern können Sie den Dienst näher an Ihre Daten heranbringen, um Compliance- und Sicherheitsanforderungen zu erfüllen oder anderen betrieblichen Anforderungen gerecht zu werden.

Die Bereitstellung des Speech-Diensts in Sovereign Clouds ist für einige Behörden und ihre Partner verfügbar. Die Azure Government-Cloud steht beispielsweise für US-Behörden und deren Partner zur Verfügung. Microsoft Azure, betrieben von 21Vianet, Cloud steht für Organisationen mit einer Geschäftspräsenz in China zur Verfügung. Weitere Informationen finden Sie unter Sovereign Clouds.

Verwenden von Speech in Ihrer Anwendung

Speech Studio besteht aus einer Reihe von benutzeroberflächenbasierten Tools zum Erstellen und Integrieren von Features aus dem Azure KI Speech-Dienst in Ihre Anwendungen. Sie erstellen Projekte in Speech Studio mithilfe eines Ansatzes ohne Code und verweisen dann mithilfe des Speech SDK, der Speech CLI oder verschiedener REST-APIs auf die Ressourcen in Ihren Anwendungen.

Die Speech-Befehlszeilenschnittstelle ist ein Befehlszeilentool, mit dem der Speech-Dienst verwendet werden kann, ohne Code zu schreiben. Über die Speech-Befehlszeilenschnittstelle stehen die meisten Features des Speech SDK zur Verfügung, und einige erweiterte Features und Anpassungen sind in der Speech-Befehlszeilenschnittstelle vereinfacht.

Das Speech SDK (Software Development Kit) macht viele der Funktionen des Speech-Dienstes verfügbar, die Ihnen das Entwickeln sprachaktivierter Anwendungen ermöglichen. Das Speech SDK ist in vielen Programmiersprachen und für alle Plattformen verfügbar.

In einigen Fällen können oder sollten Sie das Speech SDK nicht verwenden. In diesen Fällen können Sie mithilfe der REST-APIs auf den Speech-Dienst zugreifen. Verwenden Sie z. B. die REST-APIs für die Batch-Transkription und Sprechererkennung.

Erste Schritte

Wir bieten Schnellstarts für viele gängige Programmiersprachen an. Jede Schnellstartanleitung enthält Informationen zu grundlegenden Entwurfsmustern und ist jeweils so konzipiert, dass Sie in weniger als zehn Minuten über ausführbaren Code verfügen. Die folgende Liste enthält Schnellstartanleitungen zu den einzelnen Features:

- Schnellstart Spracherkennung

- Schnellstartanleitung zur Sprachsynthese

- Grundlegendes zur Sprachübersetzung

Codebeispiele

Beispielcode für den Speech-Dienst finden Sie auf GitHub. In den Beispielen werden gängige Szenarios wie etwa das Lesen von Audiodaten aus einer Datei oder einem Stream, die kontinuierliche und einmalige Erkennung oder die Verwendung benutzerdefinierter Modelle behandelt. Über die folgenden Links gelangen Sie zu den SDK- und REST-Beispielen:

- Beispiele für Spracherkennung, Sprachsynthese und Sprachübersetzung (SDK)

- Batch transcription samples (REST) (Batchtranskriptionsbeispiele (REST))

- Beispiele für die Sprachsynthese (REST)

- Beispiele für Sprachassistenten (SDK)

Verantwortungsvolle KI

Zu einem KI-System gehört nicht nur die Technologie, sondern auch die Personen, die das System verwenden, sowie die davon betroffenen Personen und die Umgebung, in der es bereitgestellt wird. Lesen Sie die Transparenzhinweise, um mehr über die verantwortungsvolle Nutzung und den Einsatz von KI in Ihren Systemen zu erfahren.

Spracherkennung

- Transparenzhinweis und Anwendungsfälle

- Merkmale und Einschränkungen

- Integration und verantwortungsvolle Verwendung

- Daten, Datenschutz und Sicherheit

Aussprachebewertung

Benutzerdefinierte neuronale Stimme

- Transparenzhinweis und Anwendungsfälle

- Merkmale und Einschränkungen

- Eingeschränkter Zugriff

- Verantwortungsvolle Bereitstellung synthetischer Sprache

- Offenlegung von Sprechern

- Offenlegung von Entwurfsrichtlinien

- Offenlegung von Entwurfsmustern

- Verhaltenskodex

- Daten, Datenschutz und Sicherheit

Sprechererkennung

- Transparenzhinweis und Anwendungsfälle

- Merkmale und Einschränkungen

- Eingeschränkter Zugriff

- Allgemeine Richtlinien

- Daten, Datenschutz und Sicherheit