Von Azure KI Agent Service unterstützte Modelle

Agents werden von einer Vielzahl von Modellen mit unterschiedlichen Funktionen und Preispunkten unterstützt. Die Modellverfügbarkeit variiert je nach Region und Cloud. Für bestimmte Tools und Funktionen sind die neuesten Modelle erforderlich. Die folgenden Modelle sind in den verfügbaren SDKs verfügbar. Die folgende Tabelle ist für die nutzungsbasierte Bezahlung. Informationen zur Verfügbarkeit der bereitgestellten Durchsatzeinheit (Provisioned Throughput Unit, PTU) finden Sie unter bereitgestelltem Durchsatz in der Azure OpenAI-Dokumentation. Sie können globale Standardmodelle verwenden, wenn sie in den hier aufgeführten Regionen unterstützt werden.

Azure OpenAI-Modelle

Azure KI Agent Service unterstützt dieselben Modelle wie die Chatabschluss-API in Azure OpenAI in den folgenden Regionen.

| Region | gpt-4o, 2024-05-13 | gpt-4o, 2024-08-06 | gpt-4o-mini, 2024-07-18 | gpt-4, 0613 | gpt-4, 1106-Preview | gpt-4, 0125-Preview | gpt-4, turbo-2024-04-09 | gpt-4-32k, 0613 | gpt-35-turbo, 0613 | gpt-35-turbo, 1106 | gpt-35-turbo, 0125 | gpt-35-turbo-16k, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| japaneast | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

Weitere Modelle

Der Azure KI Agent Service unterstützt auch die folgenden Modelle aus dem Azure KI Foundry-Modellkatalog.

- Llama-3.1-70B-instruct

- Mistral-large-2407

- Cohere Command R+

Um diese Modelle zu verwenden, können Sie das Azure KI Foundry-Portal verwenden, um eine Bereitstellung vorzunehmen, und dann in Ihrem Agent darauf zu verweisen.

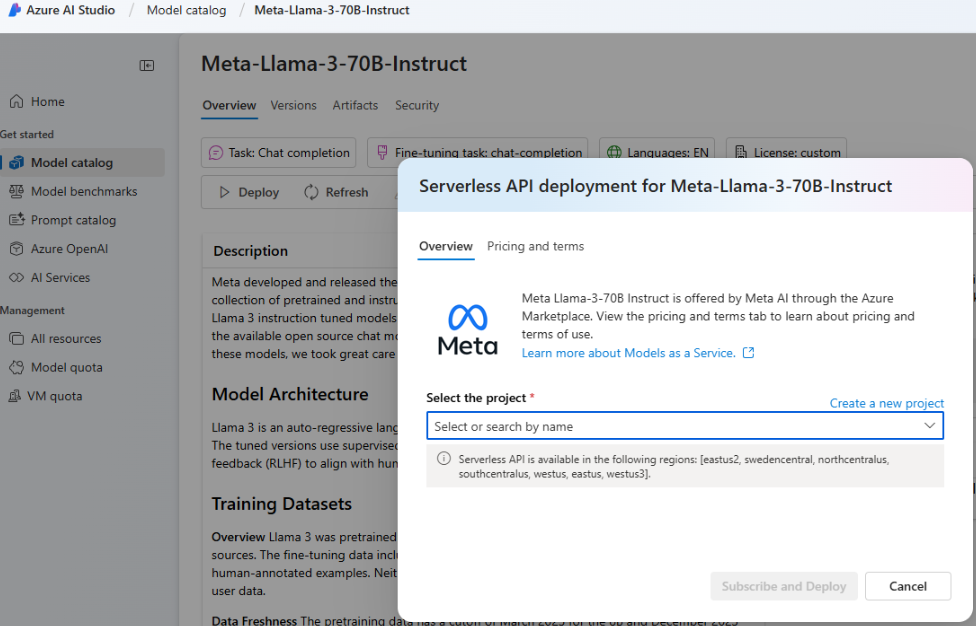

Wechseln Sie zum Azure KI Foundry-Portal, und wählen Sie im linken Navigationsmenü Modellkatalog aus, und scrollen Sie nach unten zu Meta-Llama-3-70B-Instruct. Sie können auch eines der zuvor aufgeführten Modelle finden und verwenden.

Klicken Sie auf Bereitstellen.

Wählen Sie im daraufhin angezeigten Bildschirm "Bereitstellungsoptionen" serverlose API mit Azure KI Inhaltssicherheit aus.

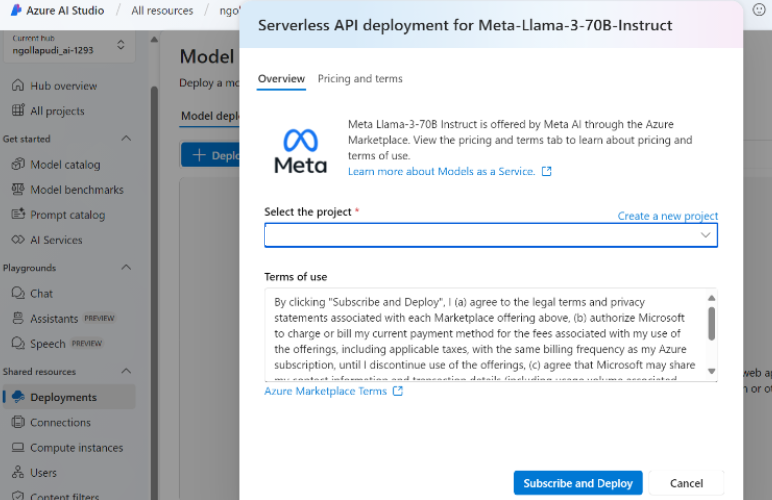

Wählen Sie Ihr Projekt und dann Abonnieren und Bereitstellen aus.

Fügen Sie die serverlose Verbindung zu Ihrem Hub/Projekt hinzu. Der von Ihnen ausgewählte Bereitstellungsname ist der Name, auf den Sie im Code verweisen.

Legen Sie beim Aufrufen der Agenterstellungs-API den

models-Parameter auf Ihren Bereitstellungsnamen fest. Zum Beispiel: