Arbeitsbereichspakete

Arbeitsbereichspakete können benutzerdefinierte oder private Wheel-Dateien (Python), JAR-Dateien (Scala/Java) oder TAR.GZ-Dateien (R) sein. Sie können diese Pakete in Ihren Arbeitsbereich hochladen und später einem bestimmten Spark-Pool zuweisen.

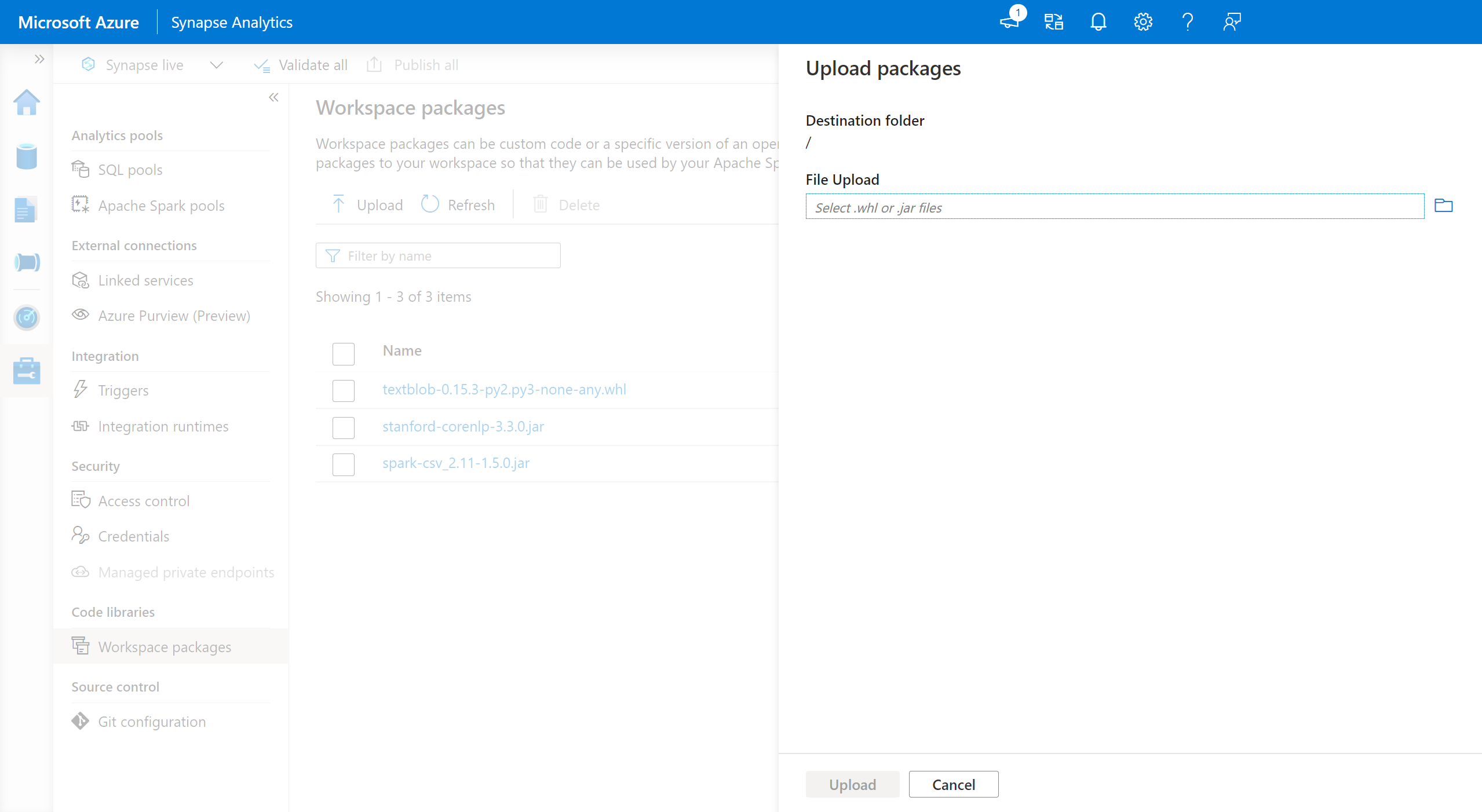

So fügen Sie Arbeitsbereichspakete hinzu

- Navigieren Sie zu Verwalten>Registerkarte Arbeitsbereichspakete.

- Laden Sie Ihre Dateien mithilfe der Dateiauswahl hoch.

- Nachdem die Dateien in den Azure Synapse-Arbeitsbereich hochgeladen wurden, können Sie diese Pakete einem Apache Spark-Pool hinzufügen.

Warnung

Innerhalb von Azure Synapse kann ein Apache Spark-Pool benutzerdefinierte Bibliotheken nutzen, die entweder als Workspace-Pakete oder innerhalb eines bekannten Azure Data Lake Storage-Pfads hochgeladen werden. Allerdings können diese beiden Optionen nicht gleichzeitig innerhalb desselben Apache Spark-Pools verwendet werden. Bei Bereitstellung von Paketen mit beiden Methoden werden nur die in der Liste der Arbeitsbereichspakete angegebenen Wheel-Dateien installiert.

Sobald Arbeitsbereichspakete verwendet werden, um Pakete in einem bestimmten Apache Spark-Pool zu installieren, gibt es die Einschränkung, dass Sie keine Pakete mehr mit dem Pfad des Speicherkontos in demselben Pool angeben können.

Hinweis

Es wird empfohlen, dass Sie nicht über mehrere Paketen mit demselben Namen in einem Arbeitsbereich verfügen. Wenn Sie eine andere Version desselben Pakets verwenden möchten, müssen Sie die vorhandene Version löschen und die neue hochladen.

Speicherkonto

Benutzerdefiniert erstellte Pakete können im Apache Spark-Pool installiert werden, indem alle Dateien in Azure Data Lake Storage (Gen2)-Konto hochgeladen werden, das mit dem Synapse-Arbeitsbereich verknüpft ist.

Die Dateien sollten in den folgenden Pfad im Standardcontainer des Speicherkontos hochgeladen werden:

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

Warnung

- In manchen Fällen müssen Sie den Dateipfad anhand der obigen Struktur erstellen, wenn er nicht bereits vorhanden ist. Als Beispiel müssen Sie möglicherweise den Ordner

pythoninnerhalb des Ordnerslibrarieshinzufügen, wenn er nicht bereits vorhanden ist. - Diese Methode zum Verwalten von benutzerdefinierten Dateien wird in der Azure Synapse-Runtime für Apache Spark 3.0 nicht unterstützt. Informationen zum Verwalten benutzerdefinierter Dateien finden Sie unter dem Feature Arbeitsbereichspakete.

Wichtig

Um benutzerdefinierte Bibliotheken über die Azure Data Lake Storage-Methode zu installieren, müssen Sie über die Berechtigung Mitwirkender an Storage-Blobdaten oder Besitzer von Speicherblobdaten für das primäre Gen2-Speicherkonto verfügen, das mit dem Azure Synapse Analytics-Arbeitsbereich verknüpft ist.

Nächste Schritte

- Anzeigen der Standardbibliotheken: Versionsunterstützung für Apache Spark

- Beheben von Fehler bei der Bibliotheksinstallation: Beheben von Fehlern bei der Bibliotheksinstallation

- Erstellen eines privaten Conda-Kanals mit Ihrem Azure Data Lake Storage-Konto: Erstellen eines benutzerdefinierten Conda-Kanals für die Paketverwaltung.