Erfolgreiche Synapse-Implementierungsmethodik: Auswerten des Datenintegrationsentwurfs

Hinweis

Dieser Artikel gehört zu der Artikelserie Erfolg der Azure Synapse-Implementierung nach Design. Eine Übersicht über diese Serie finden Sie unter Azure Synapse-Implementierungserfolg nach Design.

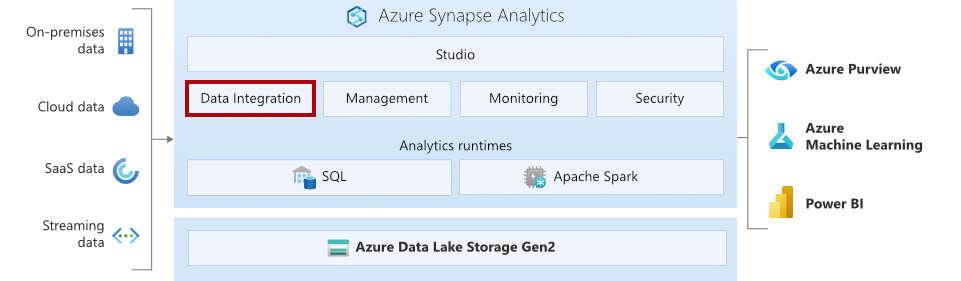

In Azure Synapse Analytics sind die gleiche Datenintegrationsengine und die gleichen Umgebungen integriert wie in Azure Data Factory (ADF), was die Erstellung umfangreicher bedarfsorientierter ETL-Pipelines ermöglicht, ohne Azure Synapse Analytics zu verlassen.

In diesem Artikel wird beschrieben, wie Sie den Entwurf der Datenintegrationskomponenten für Ihr Projekt auswerten. Insbesondere hilft er Ihnen festzustellen, ob Azure Synapse-Pipelines die beste Lösung für Ihre Datenintegrationsanforderungen sind. Die Zeit, die Sie in die Auswertung des Entwurfs vor der Entwicklung der Lösung investieren, kann dazu beitragen, unerwartete Entwurfsänderungen zu vermeiden, die sich auf den Zeitplan oder die Kosten Ihres Projekts auswirken könnten.

Fit/GAP-Analyse

Sie sollten eine gründliche Analyse der Fit/GAP-Analyse Ihrer Datenintegrationsstrategie durchführen. Wenn Sie sich für Azure Synapse-Pipelines als Datenintegrationstool entscheiden, sollten Sie die folgenden Punkte prüfen, um sicherzustellen, dass sie für Ihre Anforderungen an die Datenintegration und die Orchestrierung am besten geeignet sind. Auch wenn Sie sich für verschiedene Datenintegrationstools entscheiden, sollten Sie die folgenden Punkte überprüfen, um sicherzustellen, dass alle wichtigen Entwurfspunkte berücksichtigt wurden und dass das von Ihnen gewählte Tool Ihre Lösungsanforderungen unterstützt. Diese Informationen sollten bei Ihrer Bewertung, die Sie zuvor im Rahmen dieser Methodik durchgeführt haben, erfasst worden sein.

- Überprüfen Sie Ihre Datenquellen und -ziele (Zielvorgaben):

- Überprüfen Sie, ob Quell- und Zielspeicher unterstützte Datenspeicher sind.

- Wenn sie nicht unterstützt werden, prüfen Sie, ob Sie die erweiterbaren Optionen verwenden können.

- Überprüfen Sie die Auslösepunkte Ihrer Datenintegration und die Frequenz:

- Azure Synapse-Pipelines unterstützen Trigger für Zeitplan, rollierende Fenster und Speicherereignisse.

- Überprüfen Sie das minimale Wiederholungsintervall und die unterstützten Speicherereignisse anhand Ihrer Anforderungen.

- Überprüfen Sie die erforderlichen Modi der Datenintegration:

- Geplante, periodische und ausgelöste Batchverarbeitung können in Azure Synapse-Pipelines effektiv gestaltet werden.

- Verwenden Sie zur Implementierung von Change Data Capture (CDC) Produkte von Drittanbietern, oder erstellen Sie eine benutzerdefinierte Lösung.

- Um Streaming in Echtzeit zu unterstützen, verwenden Sie Azure Event Hubs, Azure Event Hubs von Apache Kafka oder Azure IoT Hub.

- Um SSIS-Pakete (Microsoft SQL Server Integration Services) auszuführen, können Sie SSIS-Workloads per Lift & Shift in die Cloud verschieben lassen.

- Überprüfen Sie den Computeentwurf:

- Muss der für die Pipelines benötigte Compute serverlos oder bereitgestellt sein?

- Azure Synapse-Pipelines unterstützen beide Arten von Integration Runtime (IR): serverlos oder selbstgehostet auf einem Windows-Computer.

- Überprüfen Sie Ports und Firewalls und Proxyeinstellungen, wenn Sie die selbstgehostete IR (bereitgestellt) verwenden.

- Überprüfen Sie die Sicherheitsanforderungen, die Netzwerk- und Firewallkonfiguration der Umgebung, und vergleichen Sie sie mit dem Entwurf der Sicherheits-, Netzwerk- und Firewallkonfiguration:

- Überprüfen Sie, wie die Datenquellen gesichert und vernetzt sind.

- Überprüfen Sie, wie die Zieldatenspeicher gesichert und vernetzt sind. Azure Synapse-Pipelines verfügen über verschiedene Datenzugriffsstrategien, die einen sicheren Weg zur Verbindung von Datenspeichern über private Endpunkte oder virtuelle Netzwerke bieten.

- Verwenden Sie Azure Key Vault, um Anmeldeinformationen zu speichern, wann immer dies möglich ist.

- Verwenden Sie ADF für die Verschlüsselung von Anmeldeinformationen mit kundenseitig verwalteten Schlüsseln (CMK), und speichern Sie diese in der selbstgehosteten IR.

- Überprüfen Sie den Entwurf für die fortlaufende Überwachung aller Datenintegrationskomponenten.

Überlegungen zur Architektur

Berücksichtigen Sie bei der Überprüfung des Datenintegrationsdesigns die folgenden Empfehlungen und Richtlinien, um sicherzustellen, dass die Datenintegrationskomponenten Ihrer Lösung kontinuierlich hervorragende Betriebsleistungen, Leistungseffizienz, Zuverlässigkeit und Sicherheit bieten.

Optimaler Betrieb

Für erstklassige Betriebsprozesse bewerten Sie die folgenden Punkte.

- Umgebung: Bei der Planung Ihrer Umgebungen sollten Sie diese nach Entwicklung/Test, Benutzerakzeptanztests (UAT) und Produktion unterteilen. Verwenden Sie den Ordner für Organisationsoptionen, um Ihre Pipelines und Datasets nach Geschäfts-/ETL-Aufträgen zu organisieren und so die Wartbarkeit zu verbessern. Verwenden Sie Anmerkungen, um Ihre Pipelines zu kennzeichnen, sodass Sie sie leicht überwachen können. Erstellen Sie wiederverwendbare Pipelines mithilfe von Parametern, Iterationen und bedingten Aktivitäten.

- Überwachung und Warnung: Die Synapse-Arbeitsbereiche enthalten den Hub „Überwachen“, der über umfangreiche Überwachungsinformationen zu jeder ausgeführten Pipeline verfügt. Er lässt sich auch mit Log Analytics für weitere Protokollanalysen und Warnungen integrieren. Sie sollten diese Features implementieren, um proaktive Fehlerbenachrichtigungen bereitzustellen. Verwenden Sie außerdem Pfade vom Typ Bei Fehler, um eine individuelle Fehlerbehandlung zu implementieren.

- Automatisierte Bereitstellung und Tests: Azure Synapse-Pipelines sind in den Synapse-Arbeitsbereich integriert, sodass Sie die Vorteile der Automatisierung und Bereitstellung des Arbeitsbereichs nutzen können. Verwenden Sie ARM-Vorlagen, um die manuellen Tätigkeiten beim Erstellen von Synapse-Arbeitsbereichen zu minimieren. Integrieren Sie außerdem Synapse-Arbeitsbereiche mit Azure DevOps, um eine Codeversionsverwaltung zu erstellen und die Veröffentlichung zu automatisieren.

Effiziente Leistung

Bewerten Sie für die Leistungseffizienz die folgenden Punkte.

- Beachten Sie die Leistungshinweise und Optimierungsfeatures, wenn Sie mit der Kopieraktivität arbeiten.

- Wählen Sie optimierte Connectors für die Datenübertragung anstelle von generischen Connectors aus. Verwenden Sie z. B. PolyBase anstelle der Masseneinfügung, wenn Sie Daten aus Azure Data Lake Storage Gen2 (ALDS Gen2) in einen dedizierten SQL-Pool verschieben.

- Wenn Sie eine neue Azure IR erstellen, legen Sie den Standort der Region als auto-resolve (automatisch auflösen) fest, oder wählen Sie die gleiche Region wie für die Datenspeicher aus.

- Für die selbstgehostete IR wählen Sie die Größe des virtuellen Azure-Computers (VM) auf der Grundlage der Integrationsanforderungen aus.

- Wählen Sie eine stabile Netzwerkverbindung wie Azure ExpressRoute für eine schnelle und konstante Bandbreite aus.

Zuverlässigkeit

Wenn Sie eine Pipeline mithilfe von Azure IR ausführen, ist sie von Natur aus serverlos und bietet daher von Anfang an Resilienz. Der Verwaltungsaufwand für Kunden ist sehr gering. Wenn eine Pipeline jedoch in einer selbstgehosteten IR ausgeführt wird, empfehlen wir, dass Sie sie mithilfe einer Hochverfügbarkeitskonfiguration in Azure-VMs ausführen. Diese Konfiguration stellt sicher, dass die Integrationspipelines nicht unterbrochen werden, selbst wenn eine VM offline geht. Wir empfehlen Ihnen außerdem, Azure ExpressRoute für eine schnelle und zuverlässige Netzwerkkonnektivität zwischen einem lokalen Standort und Azure zu verwenden.

Sicherheit

Eine gesicherte Datenplattform ist eine der wichtigsten Voraussetzungen für jedes Unternehmen. Sie sollten die Sicherheit für die gesamte Plattform gründlich planen und nicht nur für einzelne Komponenten. Hier finden Sie einige Sicherheitsrichtlinien für Azure Synapse Pipeline-Lösungen.

- Sichere Datenverschiebung in die Cloud mithilfe der privaten Endpunkte von Azure Synapse.

- Verwenden Sie verwaltete Microsoft Entra-Identitäten für die Authentifizierung.

- Verwenden der rollenbasierten Zugriffssteuerung (RBAC) von Azure und von Synapse RBAC für die Autorisierung.

- Speichern von Anmeldeinformationen, Geheimnissen und Schlüsseln in Azure Key Vault und nicht in der Pipeline. Weitere Informationen finden Sie unter Verwenden von Azure Key Vault-Geheimnissen in Pipelineaktivitäten.

- Stellen Sie eine Verbindung mit lokalen Ressourcen über Azure ExpressRoute oder VPN über private Endpunkte her.

- Aktivieren Sie die Optionen Sichere Ausgabe und Sichere Eingabe in Pipelineaktivitäten, wenn Parameter Geheimnisse oder Kennwörter speichern.

Nächste Schritte

Im nächsten Artikel in der Serie Azure Synapse-Erfolg nach Design erfahren Sie, wie Sie Ihren Entwurf für SQL-Pools bewerten, um Probleme zu erkennen und zu überprüfen, ob es Richtlinien und Anforderungen erfüllt.