Erfassen von Beispieldaten und Erstellen von Objekten und Daten

Gilt für:✅SQL-Datenbank in Microsoft Fabric

Sie können Daten mithilfe von Transact-SQL (T-SQL)-Anweisungen in die SQL-Datenbank in Fabric eingeben und Daten auch mithilfe anderer Microsoft Fabric-Komponenten, wie z. B. der Dataflow Gen2-Funktion oder Datenpipelines, in Ihre Datenbank importieren. Für die Entwicklung können Sie die Verbindung mit jedem Tool, das das TDS-Protokoll (Tabular Data Stream) unterstützt, wie z. B. Visual Studio Code oder SQL Server Management Studio.

Zu Beginn dieses Abschnitts können Sie die als Ausgangspunkt bereitgestellten SalesLT-Beispieldaten verwenden.

Voraussetzungen

- Führen Sie alle vorherigen Schritte in diesem Tutorial aus.

Öffnen Sie den Abfrage-Editor im Fabric-Portal.

Öffnen Sie die SQL-Datenbank in der Fabric-Datenbank, die Sie im letzten Tutorial-Schritt erstellt haben. Sie finden es in der Navigationsleiste des Fabric-Portals oder in Ihrem Arbeitsbereich für dieses Tutorial.

Wählen Sie die Schaltfläche Beispieldaten aus. Dies dauert einen Moment, um Ihre Tutorial-Datenbank mit den SalesLT-Beispieldaten zu füllen.

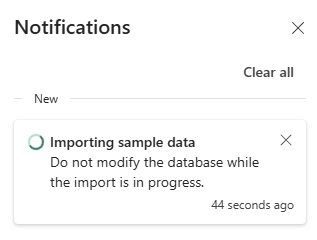

Überprüfen Sie den Bereich Benachrichtigungen, um sicherzustellen, dass der Import abgeschlossen ist, bevor Sie fortfahren.

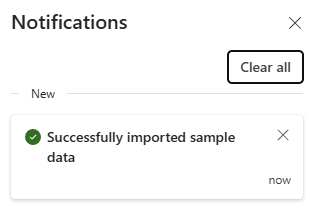

Benachrichtigungen zeigen Ihnen an, wenn der Import der Beispieldaten abgeschlossen ist. Ihre SQL-Datenbank in Fabric enthält jetzt das Schema

SalesLTund die zugehörigen Tabellen.

Verwenden Sie die SQL-Datenbank im SQL-Editor

Der webbasierte SQL-Editor für die SQL-Datenbank in Fabric bietet eine grundlegende Objekterkundungs- und Abfrageausführungsschnittstelle. Eine neue SQL-Datenbank in Fabric wird automatisch im SQL-Editor geöffnet, und eine vorhandene Datenbank kann im SQL-Editor geöffnet werden, indem sie im Fabric-Portal geöffnet wird.

Die Symbolleiste des Web-Editors enthält mehrere Elemente, darunter Aktualisieren, Einstellungen, eine Abfragefunktion und die Möglichkeit, Leistungsinformationen abzurufen. Diese Funktionen werden Sie im Verlauf dieses Tutorials verwenden.

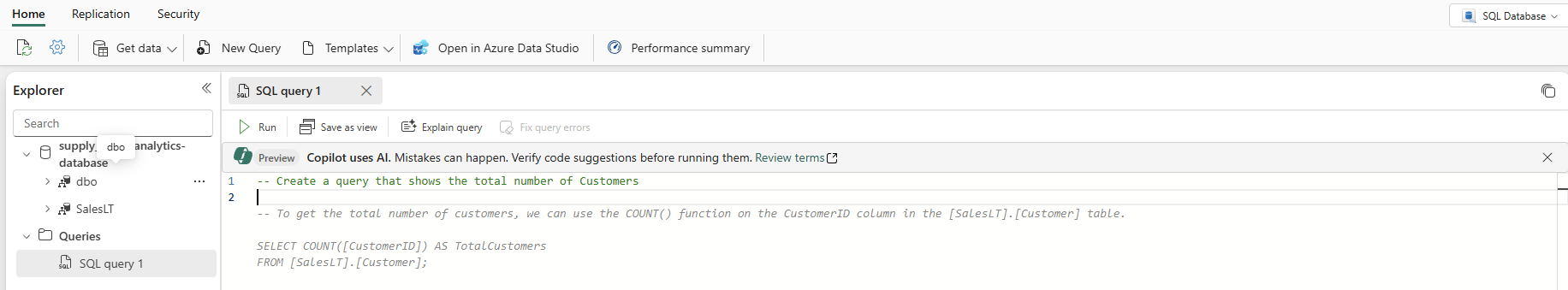

Wählen Sie in Ihrer Datenbankansicht zunächst Neue Abfrage aus der Symbolleiste aus. Daraufhin wird ein Abfrage-Editor mit der KI-Funktion Copilot geöffnet, die Sie beim Schreiben Ihres Codes unterstützt. Der Copilot für SQL-Datenbanken kann Ihnen bei der Fertigstellung oder Erstellung einer Abfrage helfen.

Geben Sie oben in der Abfrage einen T-SQL-Kommentar ein, z. B.

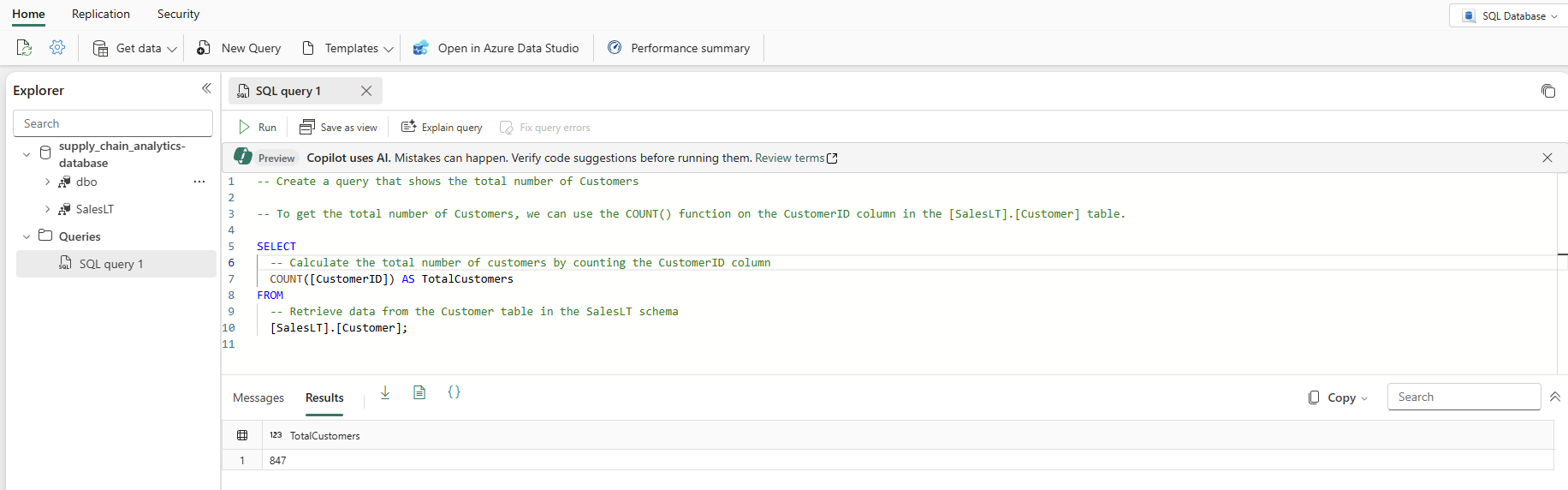

-- Create a query that shows the total number of customers, und drücken Sie die Eingabetaste. Sie erhalten ein Ergebnis, das in etwa wie folgt aussieht:Durch Drücken der Tabulatortaste wird der vorgeschlagene Code übernommen:

Wählen Sie Abfrage erklären in der Symbolleiste des Abfrage-Editors aus, um Kommentare in Ihren Code einzufügen, die jeden wichtigen Schritt erklären:

Hinweis

Copilot versucht sein Bestes, um Ihre Absicht zu verstehen, aber Sie sollten den von ihm erstellten Code immer überprüfen, bevor Sie ihn ausführen, und immer in einer von der Produktion getrennten Umgebung testen.

In einer Produktionsumgebung haben Sie möglicherweise Daten, die bereits in einem für den täglichen Anwendungsbetrieb normalisierten Format vorliegen, das Sie hier mit den SalesLT-Daten simuliert haben. Wenn Sie eine Abfrage erstellen, wird diese automatisch im Element Abfragen im Explorer-Fenster gespeichert. Sie sollten Ihre Abfrage als „SQL query 1“ sehen. Standardmäßig nummeriert das System die Abfragen wie „SQL query 1“, aber Sie können die Ellipse neben dem Abfragenamen auswählen, um die Abfrage zu duplizieren, umzubenennen oder zu löschen.

Einfügen von Daten mithilfe von Transact-SQL

Sie wurden gebeten, neue Objekte zu erstellen, um die Lieferkette der Organisation zu verfolgen. Sie müssen also eine Reihe von Objekten für Ihre Anwendung hinzufügen. In diesem Beispiel erstellen Sie ein einzelnes Objekt in einem neuen Schema. Sie können weitere Tabellen hinzufügen, um die Anwendung vollständig zu normalisieren. Sie können weitere Daten hinzufügen, z. B. mehrere Komponenten pro Produkt, mehr Lieferanteninformationen usw. Später in diesem Tutorial erfahren Sie, wie die Daten auf den SQL-Analyse-Endpunkt gespiegelt werden und wie Sie die Daten mit einer GraphQL-API abfragen können, um sie automatisch anzupassen, wenn Objekte hinzugefügt oder geändert werden.

In den folgenden Schritten wird ein T-SQL-Skript verwendet, um ein Schema, eine Tabelle und Daten für die simulierten Daten für die Lieferkettenanalyse zu erstellen.

Wählen Sie in der Symbolleiste der SQL-Datenbank die Schaltfläche Neue Abfrage aus, um eine neue Abfrage zu erstellen.

Fügen Sie das folgende Skript in den Abfrage-Bereich ein und wählen Sie Ausführen aus, um es auszuführen. Das folgende T-SQL-Skript:

- Erstellt ein Schema mit dem Namen

SupplyChain. - Erstellt eine Tabelle mit dem Namen

SupplyChain.Warehouse. - Füllt die Tabelle

SupplyChain.Warehousemit einigen zufällig erstellten Produktdaten ausSalesLT.Productauf.

/* Create the Tutorial Schema called SupplyChain for all tutorial objects */ CREATE SCHEMA SupplyChain; GO /* Create a Warehouse table in the Tutorial Schema NOTE: This table is just a set of INT's as Keys, tertiary tables will be added later */ CREATE TABLE SupplyChain.Warehouse ( ProductID INT PRIMARY KEY -- ProductID to link to Products and Sales tables , ComponentID INT -- Component Identifier, for this tutorial we assume one per product, would normalize into more tables , SupplierID INT -- Supplier Identifier, would normalize into more tables , SupplierLocationID INT -- Supplier Location Identifier, would normalize into more tables , QuantityOnHand INT); -- Current amount of components in warehouse GO /* Insert data from the Products table into the Warehouse table. Generate other data for this tutorial */ INSERT INTO SupplyChain.Warehouse (ProductID, ComponentID, SupplierID, SupplierLocationID, QuantityOnHand) SELECT p.ProductID, ABS(CHECKSUM(NEWID())) % 10 + 1 AS ComponentID, ABS(CHECKSUM(NEWID())) % 10 + 1 AS SupplierID, ABS(CHECKSUM(NEWID())) % 10 + 1 AS SupplierLocationID, ABS(CHECKSUM(NEWID())) % 100 + 1 AS QuantityOnHand FROM [SalesLT].[Product] AS p; GOIhre SQL-Datenbank in der Fabric-Datenbank enthält jetzt Warehouse-Informationen. Sie werden diese Daten in einem späteren Schritt in diesem Tutorial verwenden.

- Erstellt ein Schema mit dem Namen

Sie können diese Tabellen im Explorer-Fenster auswählen. Dann werden die Tabellendaten angezeigt – Sie müssen keine Abfrage schreiben, um sie zu sehen.

Einfügen von Daten mithilfe einer Microsoft Fabric-Pipeline

Eine weitere Möglichkeit, Daten in Ihre SQL-Datenbank in Fabric zu importieren und aus dieser zu exportieren, ist die Verwendung einer Microsoft Fabric Data Pipeline. Datenpipelines bieten eine Alternative zur Verwendung von Befehlen, indem stattdessen eine grafische Benutzeroberfläche verwendet wird. Eine Datenpipeline ist eine logische Gruppierung von Aktivitäten, die zusammen eine Datenerfassungsaufgabe bilden. Mit Pipelines können Sie ETL-Aktivitäten (Extrahieren, Transformieren und Laden) verwalten, anstatt sie einzeln zu koordinieren.

Microsoft Fabric Pipelines können einen Datenfluss enthalten. Dataflow Gen2 verwendet eine Power-Query-Schnittstelle, mit der Sie Transformationen und andere Operationen an den Daten durchführen können. Über diese Schnittstelle werden Sie Daten von dem Unternehmen Northwind Traders einspielen, mit dem Contoso zusammenarbeitet. Sie verwenden derzeit dieselben Lieferanten, sodass Sie deren Daten importieren und die Namen dieser Lieferanten in einer Ansicht anzeigen, die Sie in einem anderen Schritt in diesem Tutorial erstellen werden.

Öffnen Sie zunächst die SQL-Datenbankansicht der Beispieldatenbank im Fabric-Portal, falls dies noch nicht geschehen ist.

Wählen Sie die Schaltfläche Daten abrufen in der Menüleiste aus.

Wählen Sie New Dataflow Gen2 aus.

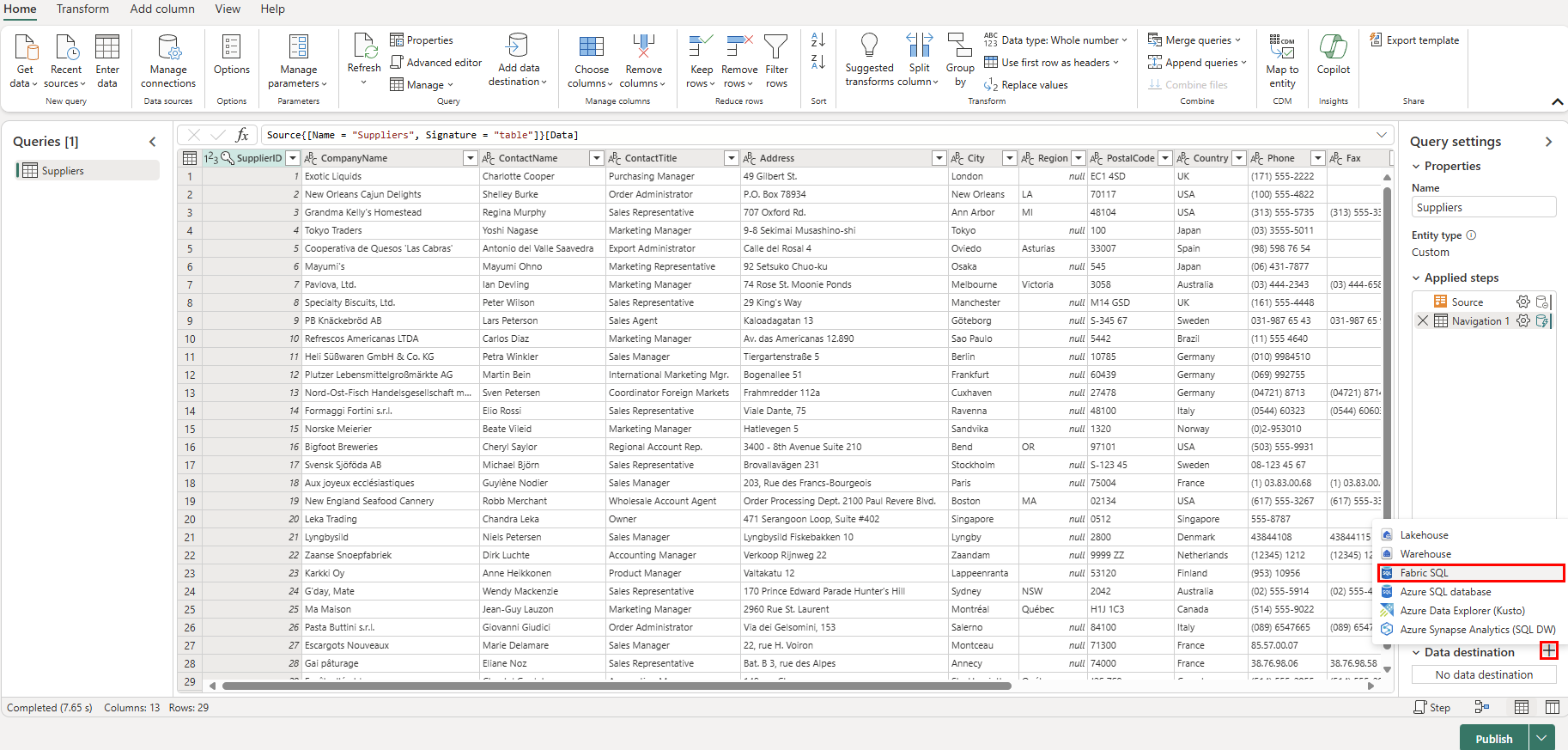

Wählen Sie in der Ansicht „Power Query“ die Schaltfläche Daten abrufen aus. Dies leitet einen geführten Prozess ein, anstatt direkt zu einem bestimmten Datenbereich zu springen.

Geben Sie im Suchfeld der Datenquelle auswählen den Ansichtstyp odata ein.

Wählen Sie OData aus den Neue Quellen-Ergebnissen aus.

Geben Sie in das URL-Textfeld der Ansicht Mit Datenquelle verbinden den Text „

https://services.odata.org/v4/northwind/northwind.svc/“ für den Open Data-Feed der BeispieldatenbankNorthwindein. Klicken Sie auf die Schaltfläche Weiter, um fortzufahren.Scrollen Sie im OData-Feed nach unten zur Tabelle Suppliers und aktivieren Sie das Kontrollkästchen daneben. Wählen Sie dann die Schaltfläche Erstellen aus.

Wählen Sie nun das Pluszeichen + neben dem Abschnitt Datenziel der Abfrageeinstellungen und wählen Sie SQL-Datenbank aus der Liste aus.

Stellen Sie auf der Seite Verbindung mit Datenziel herstellen sicher, dass die Authentifizierungsart auf Organisationskonto eingestellt ist. Wählen Sie Anmelden aus und geben Sie Ihre Microsoft Entra ID-Anmeldedaten in die Datenbank ein.

Sobald Sie erfolgreich verbunden sind, wählen Sie die Schaltfläche Weiter aus.

Wählen Sie den Namen des Arbeitsbereichs aus, den Sie im ersten Schritt dieses Tutorials im Abschnitt Ziel auswählen erstellt haben.

Wählen Sie die darunter angezeigte Datenbank aus. Stellen Sie sicher, dass die Optionsschaltfläche Neue Tabelle ausgewählt ist, und belassen Sie den Namen der Tabelle bei Suppliers. Wählen Sie die Schaltfläche Weiter aus.

Lassen Sie den Schieberegler Automatische Einstellungen verwenden auf der Ansicht Zieleinstellungen auswählen eingestellt und wählen Sie die Schaltfläche Einstellungen speichern.

Wählen Sie die Schaltfläche Veröffentlichen aus, um die Datenübertragung zu starten.

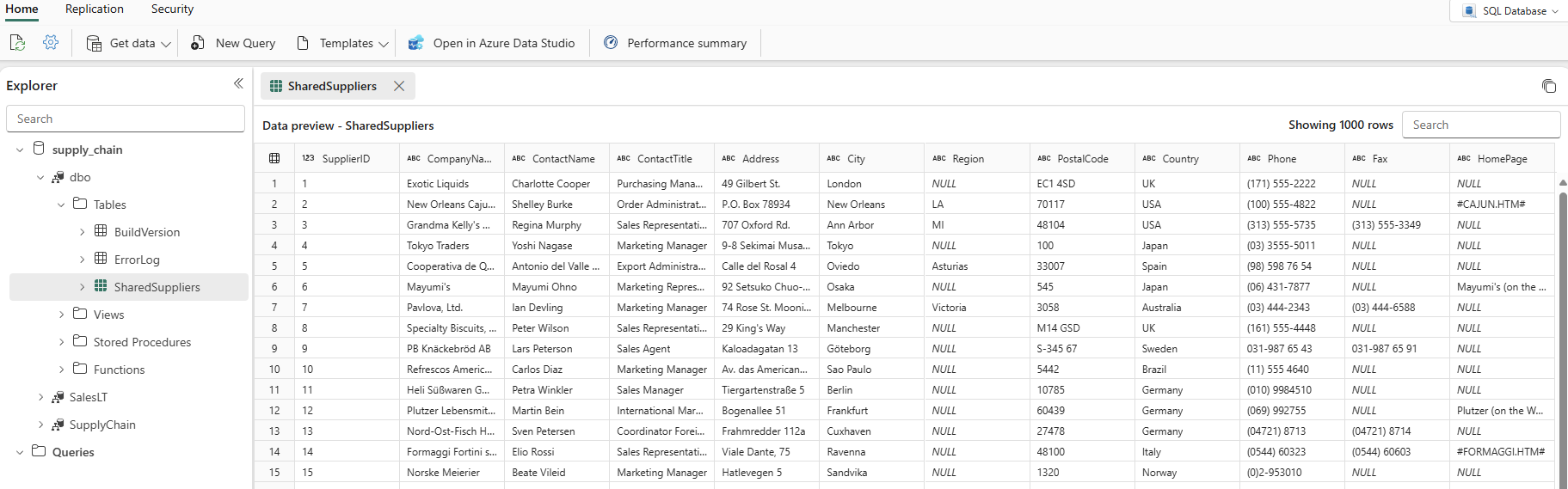

Sie kehren zur Ansicht „Arbeitsbereich“ zurück, wo Sie das neue Datenflusselement finden.

Wenn in der Spalte Aktualisiert das aktuelle Datum und die aktuelle Uhrzeit angezeigt werden, können Sie Ihren Datenbanknamen im Explorer auswählen und dann das Schema

dboerweitern, um die neue Tabelle anzuzeigen. (Möglicherweise müssen Sie das Symbol Aktualisieren in der Symbolleiste auswählen.)

Die Daten werden jetzt in Ihre Datenbank aufgenommen. Sie können nun eine Abfrage erstellen, die die Daten aus der Tabelle Suppliers mithilfe dieser tertiären Tabelle kombiniert. Das machen Sie später in unserem Tutorial.