Überwachung von bereitgestellten Modellen mithilfe von KI-Gateway-aktivierten Inferrenztabellen

Wichtig

Dieses Feature befindet sich in Public Preview.

Wichtig

In diesem Artikel werden Themen beschrieben, die auf Rückschlusstabellen für externe Modelle, bereitgestellte Durchsatzarbeitslasten oder Agentmodelle angewendet werden. Informationen zu benutzerdefinierten Modellenfinden Sie in Inference-Tabellen zum Überwachen und Debuggen von Modellen.

In diesem Artikel werden KI-Gateway-fähige Inferenztabellen zur Überwachung bereitgestellter Modelle beschrieben. Die Ableitungstabelle erfasst automatisch eingehende Anforderungen und ausgehende Antworten für einen Endpunkt und protokolliert sie als Unity Catalog Delta-Tabelle. Sie können die Daten in dieser Tabelle verwenden, um Machine Learning-Modelle zu überwachen, auszuwerten, zu vergleichen und zu optimieren.

Was sind KI-Gateway-fähige Ableitungstabellen?

AI-Gateway-fähige Inferenztabellen vereinfachen die Überwachung und Diagnose von Modellen, indem sie kontinuierlich die Anforderungseingaben und -antworten (Vorhersagen) von Mosaic AI Model Serving-Endpunkten protokollieren und in einer Delta-Tabelle im Unity-Katalog speichern. Anschließend können Sie alle Funktionen der Databricks-Plattform wie Databricks SQL-Abfragen und -Notizbücher verwenden, um Ihre Modelle zu überwachen, zu debuggen und zu optimieren.

Sie können Schlussfolgerungstabellen für vorhandene oder neu erstellte Modellbereitstellungsendpunkt aktivieren, und Anforderungen an diesen Endpunkt werden dann automatisch in einer Tabelle im Unity-Katalog protokolliert.

Einige gängige Anwendungen für Rückschlusstabellen sind die folgenden:

- Erstellen Sie einen Schulungskorpus. Indem Sie Schlussfolgerungstabellen mit Boden-Wahrheitsbezeichnungen verknüpfen, können Sie einen Trainingskorpus erstellen, mit dem Sie Ihr Modell neu trainieren oder optimieren und verbessern können. Mithilfe von Databricks-Aufträgen können Sie eine kontinuierliche Feedbackschleife einrichten und die Neuschulung automatisieren.

- Überwachen sie die Daten- und Modellqualität. Sie können ihre Modellleistung und Datenabweichung kontinuierlich mit Lakehouse Monitoring überwachen. Lakehouse Monitoring generiert automatisch Daten- und Modellqualitätsdashboards, die Sie mit Projektbeteiligten teilen können. Darüber hinaus können Sie Benachrichtigungen aktivieren, um zu wissen, wann Sie Ihr Modell basierend auf Veränderungen in den eingehenden Daten oder einer Abnahme der Modellleistung neu trainieren müssen.

- Debuggen von Produktionsproblemen. Rückschlusstabellen protokollieren Daten wie HTTP-Statuscodes, JSON-Codes für Anforderungen und Antworten, Modelllaufzeiten sowie die Ausgabe von Ablaufverfolgungen während der Modelllaufzeiten. Sie können diese Leistungsdaten für Debuggingzwecke verwenden. Sie können auch die verlaufsgeschichtlichen Daten in Schlussfolgerungstabellen verwenden, um die Modellleistung für historische Anforderungen zu vergleichen.

Anforderungen

AI Gateway-fähige Rückschlusstabellen werden nur für Endpunkte unterstützt, die entweder einen bereitgestellten Durchsatz oder externe Modelle verwenden.

Ein Databricks-Arbeitsbereich in einer der folgenden:

Für Arbeitsbereiche, bei denen die private Konnektivität für das Unity Catalog-Speicherkonto konfiguriert ist, befolgen Sie die Schritte unter Konfigurieren der privaten Konnektivität von serverlosem Computing.

Databricks empfiehlt, dass Sie predictive optimization für eine optimierte Leistung Ihrer Ableitungstabellen aktivieren.

Ihr Arbeitsbereich muss Unity-Katalog aktiviert haben.

Sowohl der Ersteller des Endpunkts als auch der Modifizierer müssen über die Berechtigung Kann Verwalten für den Endpunkt verfügen. Siehe Zugriffssteuerungslisten.

Sowohl der Ersteller des Endpunkts als auch der Modifizierer müssen über die folgenden Berechtigungen im Unity-Katalog verfügen:

USE CATALOG-Berechtigungen für den angegebenen Katalog.USE SCHEMA-Berechtigungen für das angegebene Schema.CREATE TABLE-Berechtigungen im Schema.

Warnung

Die Ableitungstabelle könnte die Protokollierung von Daten beenden oder beschädigt werden, wenn Sie eine der folgenden Aktionen ausführen:

- Ändern Sie das Tabellenschema.

- Ändern Sie den Tabellennamen.

- Löschen Sie die Tabelle.

- Berechtigungen für Unity Catalog oder das Unity Catalog-Schema gehen verloren.

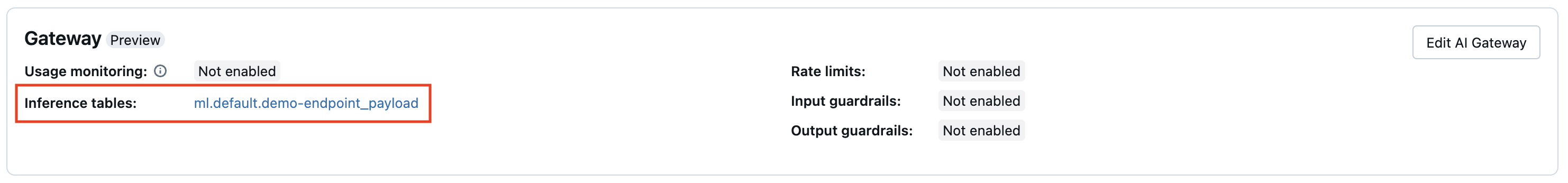

Aktivieren und Deaktivieren von Rückschlusstabellen

In diesem Abschnitt erfahren Sie, wie Sie Mithilfe der Benutzeroberfläche "Bereitstellen" Schlussfolgerungstabellen aktivieren oder deaktivieren. Der Besitzer der Ableitungstabellen ist der Benutzer, der den Endpunkt erstellt hat. Alle Zugriffssteuerungslisten (ACCESS Control Lists, ACLs) in der Tabelle folgen den Standardberechtigungen des Unity-Katalogs und können vom Tabellenbesitzer geändert werden.

Führen Sie die folgenden Schritte aus, um die Rückschlusstabellen während der Endpunkterstellung zu aktivieren:

- Klicken Sie auf Serving in der UI „Databricks Mosaic AI“.

- Klicken Sie auf Bereitstellungsendpunkt erstellen.

- Wählen Sie im Abschnitt „AI Gateway“ Rückschlusstabellen aktivieren aus.

Sie können auch Rückschlusstabellen für einen vorhandenen Endpunkt aktivieren. Gehen Sie wie folgt vor, um eine vorhandene Endpunktkonfiguration zu bearbeiten:

- Klicken Sie im Abschnitt „AI Gateway“ auf AI Gateway bearbeiten.

- Wählen Sie Rückschlusstabelle aktivieren aus.

Führen Sie die folgenden Anweisungen aus, um Rückschlusstabellen zu deaktivieren:

- Navigieren Sie zu Ihrer Endpunktseite.

- Klicken Sie auf AI Gateway bearbeiten.

- Klicken Sie auf "Rückschlusstabelle aktivieren",, um das Häkchen zu entfernen.

- Nachdem Sie mit den AI-Gateway-Spezifikationen zufrieden sind, klicken Sie auf Aktualisieren.

Abfragen und Analysieren von Ergebnissen in der Ableitungstabelle

Nachdem Ihre bereitgestellten Modelle bereit sind, werden alle Anforderungen, die an Ihre Modelle vorgenommen wurden, automatisch in der Ableitungstabelle sowie in den Antworten protokolliert. Sie können die Tabelle auf der Benutzeroberfläche anzeigen, die Tabelle aus Databricks SQL oder einem Notizbuch abfragen oder die Tabelle mithilfe der REST-API abfragen.

Zum Anzeigen der Tabelle auf der Benutzeroberfläche: Klicken Sie auf der Endpunktseite auf den Namen der Ableitungstabelle, um die Tabelle im Katalog-Explorer zu öffnen.

So fragen Sie die Tabelle aus Databricks SQL oder einem Databricks-Notizbuch ab: Sie können Code wie folgt ausführen, um die Ableitungstabelle abzufragen.

SELECT * FROM <catalog>.<schema>.<payload_table>

** Um Ihre Rückschlusstabellendaten mit Details zum zugrunde liegenden Foundation-Modell zu verknüpfen, das auf Ihrem Endpunkt bereitgestellt wird:** Foundation-Modelldetails werden in der system.serving.served_entities Systemtabelle erfasst.

SELECT * FROM <catalog>.<schema>.<payload_table> payload

JOIN system.serving.served_entities se on payload.served_entity_id = se.served_entity_id

KI-Gateway-fähiges Ableitungstabellenschema

Inference-Tabellen, die mithilfe des AI-Gateways aktiviert sind, weisen das folgende Schema auf:

| Spaltenname | Beschreibung | Typ |

|---|---|---|

request_date |

Das UTC-Datum, an dem die Modellbereitstellungsanforderung empfangen wurde. | DATE |

databricks_request_id |

Ein von Azure Databricks generierter Anforderungsbezeichner, der an alle Modellbereitstellungsanforderungen angefügt ist. | STRING |

request_time |

Der Zeitstempel, zu dem die Anforderung eingegangen ist. | TIMESTAMP |

status_code |

Der HTTP-Statuscode, der vom Modell zurückgegeben wurde. | INT |

sampling_fraction |

Der Stichprobenanteil, der verwendet wird, falls die Anforderung heruntergesampelt wurde. Dieser Wert liegt zwischen 0 und 1, wobei 1 bedeutet, dass 100% der eingehenden Anfragen einbezogen wurden. | DOUBLE |

execution_duration_ms |

Die Zeit in Millisekunden, für die das Modell Rückschlüsse ausgeführt hat. Dies schließt keine Overhead-Netzwerklatenz ein und stellt nur die Zeit dar, die für das Modell zum Generieren von Vorhersagen benötigt wurde. | bigint |

request |

Der JSON-Textkörper der unformatierten Anforderung, der an den Modellbereitstellungsendpunkt gesendet wurde. | STRING |

response |

Der JSON-Textkörper der unformatierten Antwort, der vom Modellbereitstellungsendpunkt zurückgegeben wurde | STRING |

served_entity_id |

Die eindeutige ID der bereitgestellten Entität. | STRING |

logging_error_codes |

Die Fehler, die aufgetreten sind, wenn die Daten nicht protokolliert werden konnten. Fehlercodes umfassen MAX_REQUEST_SIZE_EXCEEDED und MAX_RESPONSE_SIZE_EXCEEDED. |

ARRAY |

requester |

Die ID des Benutzer- oder Dienstprinzipals, dessen Berechtigungen für die Aufrufanforderung des bereitstellenden Endpunkts verwendet werden. | STRING |

Einschränkungen

Bereitgestellte Durchsatzarbeitslasten:

- Wenn Sie einen neuen Modellbereitstellung-Endpunkt erstellen, der den bereitgestellten Durchsatz verwendet, werden nur KI-Gateway-fähige Inferenztabellen unterstützt.

- Wenn Sie über einen modellbasierten Endpunkt verfügen, der den bereitgestellten Durchsatz verwendet, der noch nie Schlussfolgerungstabellen hatte, die zuvor konfiguriert wurden, können Sie ihn aktualisieren, um AI Gateway-fähige Rückschlusstabellen zu verwenden.

- Wenn Sie über einen modellbasierten Endpunkt verfügen, der den bereitgestellten Durchsatz verwendet, der derzeit Schlussfolgerungstabellen hat oder die zuvor konfiguriert wurden, können Sie ihn nicht aktualisieren, um AI Gateway-fähige Rückschlusstabellen zu verwenden.

- Bei Antwortprotokollen von Streaming-AI-Agenten werden nur mit ChatCompletion kompatible Felder und Spuren aggregiert.

Die Bereitstellung von Protokollen der Inferenztabellen erfolgt derzeit nach dem Best-Effort-Prinzip, aber Sie können erwarten, dass die Protokolle innerhalb von 1 Stunde nach einer Anforderung verfügbar sind. Wenden Sie sich an Ihr Databricks-Kontoteam, um weitere Informationen zu erfahren.

Die maximale Anforderungs- und Antwortgröße, die protokolliert wird, beträgt 1 MiB (1.048.576 Bytes). Anforderungs- und Antwortnutzlasten, die dies überschreiten, werden als

nullprotokolliert, undlogging_error_codeswerden mitMAX_REQUEST_SIZE_EXCEEDEDoderMAX_RESPONSE_SIZE_EXCEEDEDaufgefüllt.

Einschränkungen für AI Gateways finden Sie unter Einschränkungen. Allgemeine Endpunkteinschränkungen finden Sie unter Modellbereitstellungseinschränkungen und Regionen.