Forståelse af forskellene mellem dataflowtyper

Dataflow bruges til at udtrække, transformere og indlæse data til en lagerdestination, hvor de kan bruges til forskellige scenarier. Da det ikke er alle lagerdestinationer, der har de samme egenskaber, varierer nogle funktioner og funktionsmåder for dataflowet afhængigt af den lagerdestination, som dataflowet indlæser data i. Før du opretter et dataflow, er det vigtigt at forstå, hvordan dataene skal bruges, og vælge lagerdestinationen i henhold til kravene i din løsning.

Valg af en lagerdestination for et dataflow bestemmer dataflowets type. Et dataflow, der indlæser data i Dataverse-tabeller, er kategoriseret som et standarddataflow. Dataflow, der indlæser data i analysetabeller, er kategoriseret som et analytisk dataflow.

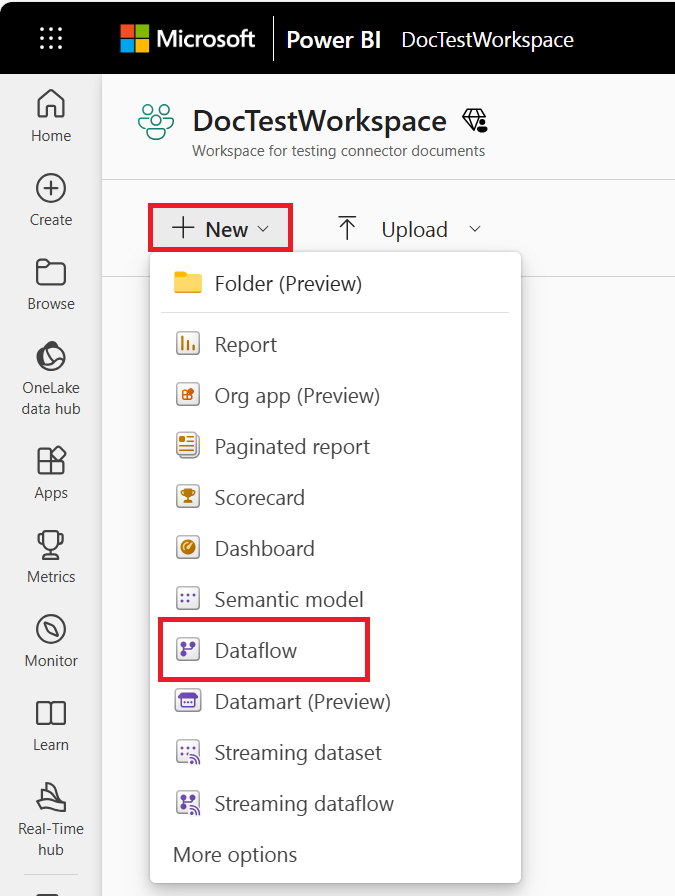

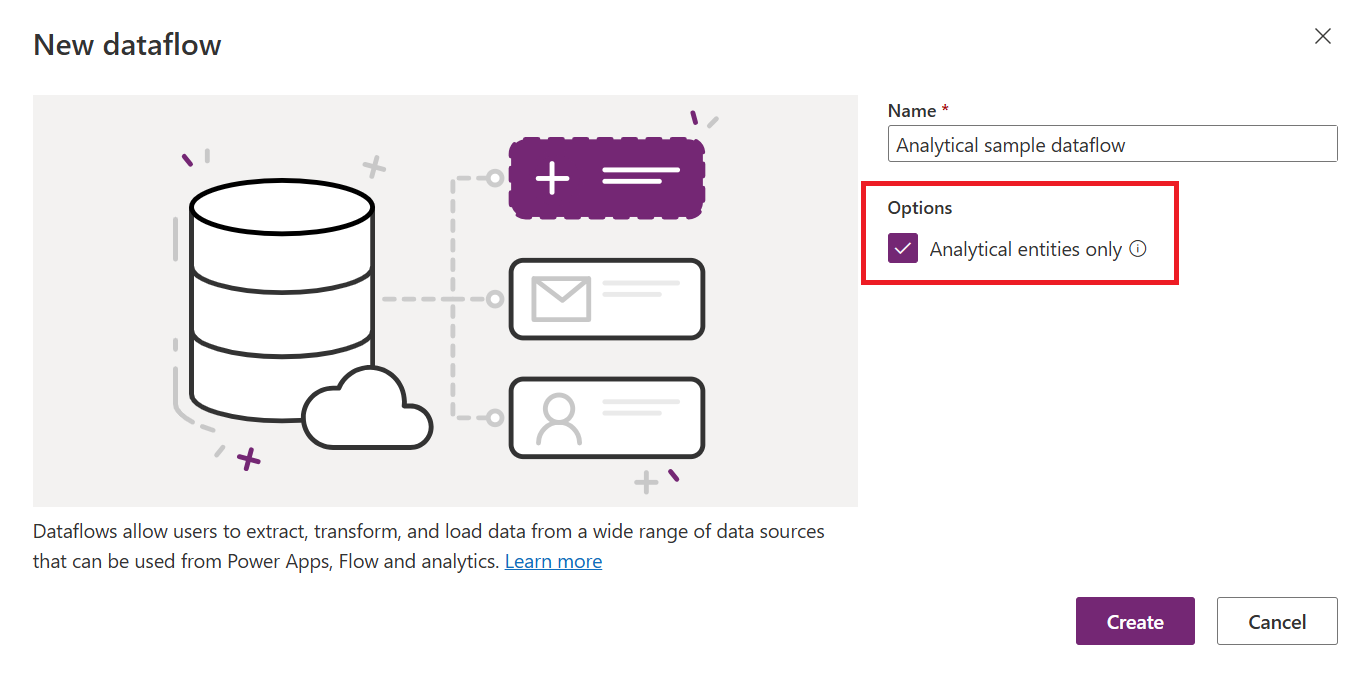

Dataflow, der er oprettet i Power BI, er altid analytiske dataflow. Dataflow, der er oprettet i Power Apps, kan enten være standard eller analytiske, afhængigt af dit valg, når du opretter dataflowet.

Standarddataflow

Et standarddataflow indlæser data i Dataverse-tabeller. Standarddataflow kan kun oprettes i Power Apps. En af fordelene ved at oprette denne type dataflow er, at alle programmer, der afhænger af data i Dataverse, kan arbejde med de data, der er oprettet af standarddataflow. Typiske programmer, der bruger Dataverse-tabeller, er Power Apps, Power Automate, AI Builder og Power Virtual Agents.

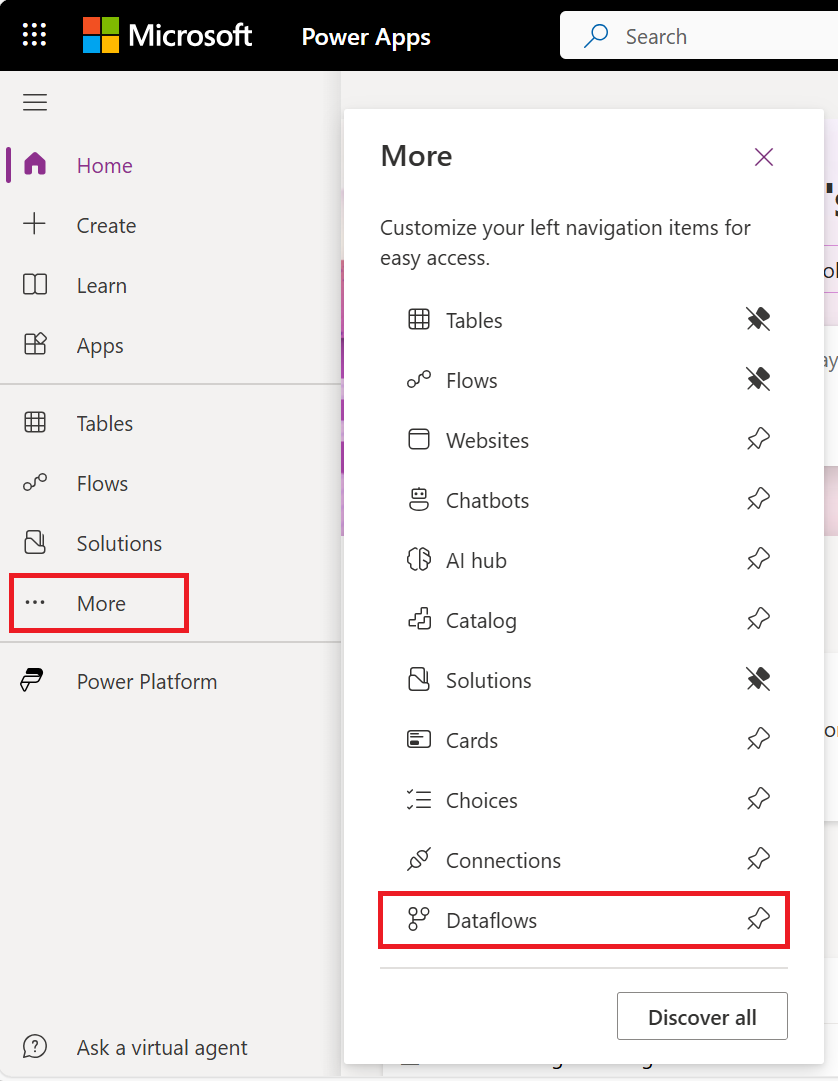

Sådan opretter du et dataflow i Power Apps:

Vælg Mere under fanerne i Power Apps.

Vælg Dataflow.

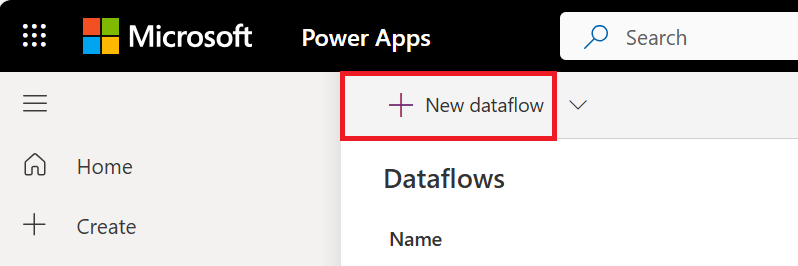

Vælg Nyt dataflow.

Hvis du opretter dit første dataflow, kan du også vælge knappen Opret et dataflow .

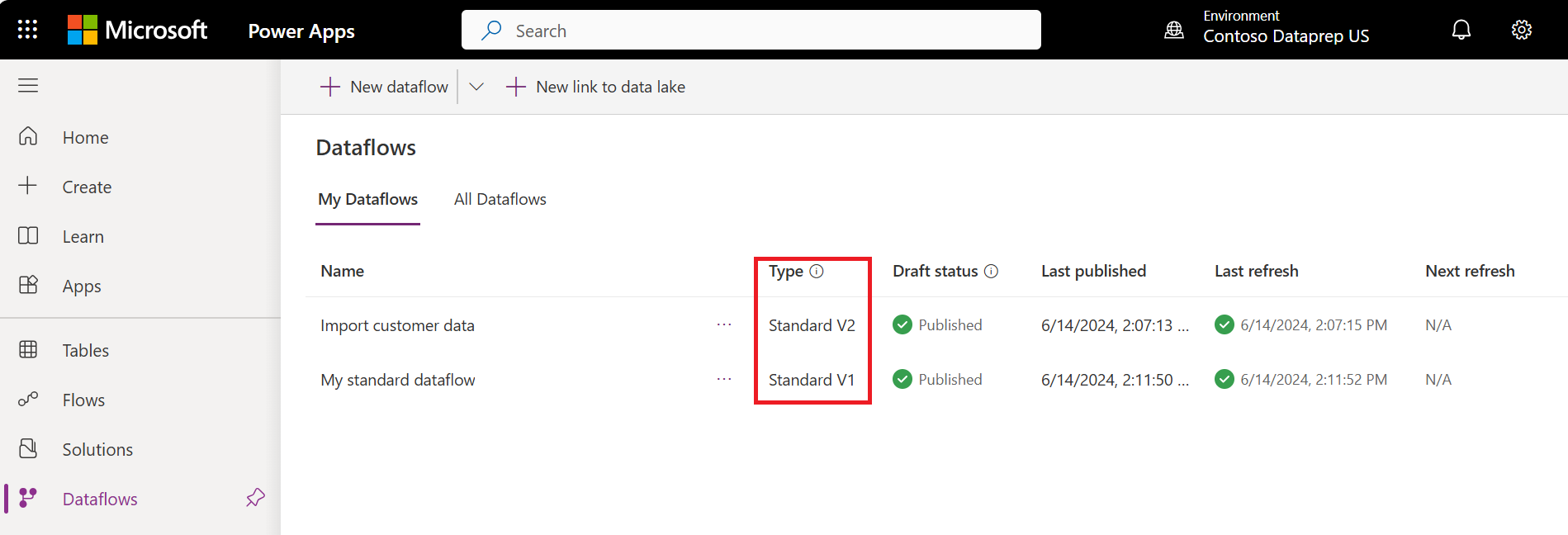

Standardversioner af dataflow

Bemærk

Vi opfordrer brugere af Power Platform-dataflow til at migrere fra standard V1-dataflow til standard V2-dataflow. Standard V1-dataflow er på vej til ophør af support i den nærmeste fremtid. Du kan få flere oplysninger om overførsel til standard V2-dataflow ved at gå til Overfør et standard V1-dataflow til et standard V2-dataflow.

Vi har arbejdet på betydelige opdateringer af standarddataflow for at forbedre deres ydeevne og pålidelighed. Disse forbedringer vil til sidst være tilgængelige for alle standarddataflow. Men i mellemtiden skelner vi mellem eksisterende standarddataflow (version 1) og nye standarddataflow (version 2) ved at tilføje en versionsindikator i Power Apps.

Sammenligning af standarddataflowversioner

I følgende tabel vises de overordnede funktioners forskelle mellem standarddataflow V1 og V2 og indeholder oplysninger om hver funktions funktionsmåde i hver version.

| Funktion | Standard V1 | Standard V2 |

|---|---|---|

| Maksimalt antal dataflow, der kan gemmes med automatisk tidsplan pr. kundelejer | 50 | Ubegrænset |

| Maksimalt antal poster, der er indtaget pr. forespørgsel/tabel | 500,000 | Ubegrænset. Det maksimale antal poster, der kan indtages pr. forespørgsel eller tabel, afhænger nu af beskyttelsesgrænserne for Dataverse-tjenesten på indtagelsestidspunktet. |

| Indtagelseshastighed i dataverse | Oprindelig ydeevne | Forbedret ydeevne med nogle få faktorer. De faktiske resultater kan variere og afhænge af egenskaberne for de data, der indtages, og indlæsningen af dataversetjenesten på indtagelsestidspunktet. |

| Politik for trinvis opdatering | Ikke understøttet | Understøttet |

| Robusthed | Når der registreres grænser for beskyttelse af Dataverse-tjenesten, gøres der forsøg på en post op til tre gange. | Når der registreres grænser for beskyttelse af Dataverse-tjenesten, gøres der forsøg på en post op til tre gange. |

| Power Automate integration | Ikke understøttet | Understøttet |

Analytiske dataflow

Et analysedataflow indlæser data til lagertyper, der er optimeret til analyse – Azure Data Lake Storage. Microsoft Power Platform-miljøer og Power BI-arbejdsområder giver kunderne en administreret lagringsplacering med disse produktlicenser. Derudover kan kunder knytte deres organisations Azure Data Lake-lagerkonto til en destination for dataflow.

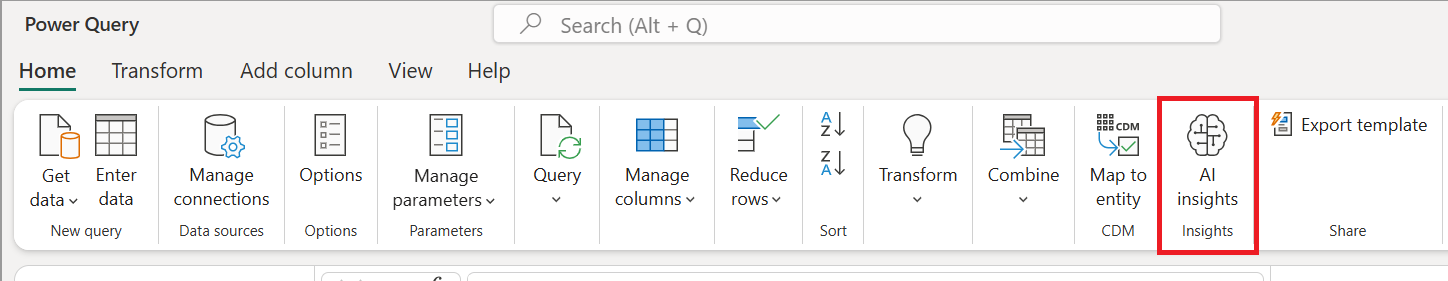

Analytiske dataflow er i stand til yderligere analysefunktioner. Integration med Power BI's AI-funktioner eller brug af beregnede tabeller, som beskrives senere.

Du kan oprette analytiske dataflow i Power BI. De indlæser som standard data til Power BI's administrerede lager. Men du kan også konfigurere Power BI til at gemme dataene i organisationens Azure Data Lake Storage.

Du kan også oprette analytiske dataflows i Power Apps- og Dynamics 365 Customer Insights-portaler. Når du opretter et dataflow i Power Apps-portalen, kan du vælge mellem Dataverse-administreret analyselager eller på din organisations Azure Data Lake Storage-konto.

AI-integration

Nogle gange kan det, afhængigt af kravet, være nødvendigt at anvende nogle AI- og machine learning-funktioner på dataene via dataflowet. Disse funktioner er tilgængelige i Power BI-dataflow og kræver et Premium-arbejdsområde.

I følgende artikler beskrives det, hvordan du bruger AI-funktioner i et dataflow:

- Azure Machine Learning-integration i Power BI

- Cognitive Services i Power BI

- Automatiseret maskinel indlæring i Power BI

De funktioner, der er angivet i de forrige to afsnit, er Power BI-specifikke og er ikke tilgængelige, når du opretter et dataflow i Power Apps- eller Dynamics 365 Customer Insights-portalerne.

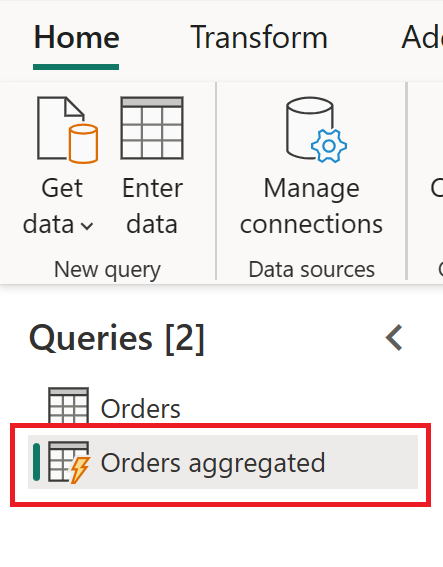

Beregnede tabeller

En af grundene til at bruge en beregnet tabel er muligheden for at behandle store mængder data. Den beregnede tabel hjælper i disse scenarier. Hvis du har en tabel i et dataflow, og en anden tabel i det samme dataflow bruger den første tabels output, opretter denne handling en beregnet tabel.

Den beregnede tabel hjælper med ydeevnen af datatransformationerne. I stedet for at gentage de transformationer, der er nødvendige i den første tabel flere gange, udføres transformationen kun én gang i den beregnede tabel. Derefter bruges resultatet flere gange i andre tabeller.

Hvis du vil vide mere om beregnede tabeller, skal du gå til Oprettelse af beregnede tabeller i dataflow.

Beregnede tabeller er kun tilgængelige i et analytisk dataflow.

Standarddataflow i forhold til analytiske dataflow

I følgende tabel vises nogle forskelle mellem en standardtabel og en analysetabel.

| Handling | Standard | Analytisk |

|---|---|---|

| Sådan opretter du | Power Platform-dataflow | Power BI-dataflow Power Platform-dataflow ved at markere afkrydsningsfeltet Kun analytiske enheder, når du opretter dataflowet |

| Lagermuligheder | Dataverse | Power BI leverede Azure Data Lake-lager til Power BI-dataflow, Dataverse leverede Azure Data Lake-lager til Power Platform-dataflow eller kundeindgivne Azure Data Lake-lager |

| Power Query-transformationer | Ja | Ja |

| AI-funktioner | Nej | Ja |

| Beregnet tabel | Nej | Ja |

| Kan bruges i andre programmer | Ja, via Dataverse | Power BI-dataflow: Kun i Power BI Power Platform-dataflow eller eksterne Power BI-dataflow: Ja via Azure Data Lake Storage |

| Tilknytning til standardtabel | Ja | Ja |

| Trinvis indlæsning | Standardindlæsning Det er muligt at ændre ved hjælp af afkrydsningsfeltet Slet rækker, der ikke længere findes i forespørgselsoutputtet ved indlæsningsindstillingerne |

Standard for fuld indlæsning Det er muligt at konfigurere trinvis opdatering ved at konfigurere den trinvise opdatering i indstillingerne for dataflowet |

| Planlagt opdatering | Ja | Ja, muligheden for at give ejerne af dataflowet besked om fejlen |

Scenarier, hvor hver dataflowtype skal bruges

Her er nogle eksempelscenarier og anbefalinger til bedste praksis for hver type dataflow.

Brug på tværs af platforme – standarddataflow

Hvis din plan for oprettelse af dataflow er at bruge gemte data på flere platforme (ikke kun Power BI, men også andre Microsoft Power Platform-tjenester, Dynamics 365 osv.), er et standarddataflow et godt valg. Standarddataflow gemmer dataene i Dataverse, som du kan få adgang til via mange andre platforme og tjenester.

Tunge datatransformationer i store datatabeller – analysedataflow

Analytiske dataflow er en fremragende mulighed for at behandle store mængder data. Analytiske dataflow forbedrer også beregningskraften bag transformationen. Hvis dataene gemmes i Azure Data Lake Storage, øges skrivehastigheden til en destination. Sammenlignet med Dataverse (som kan have mange regler, der skal kontrolleres på tidspunktet for datalageret), er Azure Data Lake Storage hurtigere til læse-/skrivetransaktioner på en stor mængde data.

AI-funktioner – analysedataflow

Hvis du planlægger at bruge ai-funktionalitet via datatransformationsfasen, er det nyttigt at bruge et analytisk dataflow, fordi du kan bruge alle understøttede AI-funktioner med denne type dataflow.