Overvejelser i forbindelse med datagateway i det lokale miljø for datadestinationer i Dataflow Gen2

Denne artikel indeholder en liste over begrænsninger og overvejelser, når du bruger datagatewayen med datadestinationsscenarier i Dataflow Gen2.

Netværksproblemer med port 1433

Når du bruger Microsoft Fabric Dataflow Gen2 med en datagateway i det lokale miljø, kan der opstå problemer med opdateringsprocessen for dataflowet. Det underliggende problem opstår, når gatewayen ikke kan oprette forbindelse til den midlertidige Lakehouse-dataflow for at læse dataene, før den kopieres til den ønskede datadestination. Dette problem kan opstå, uanset hvilken type datadestination der bruges.

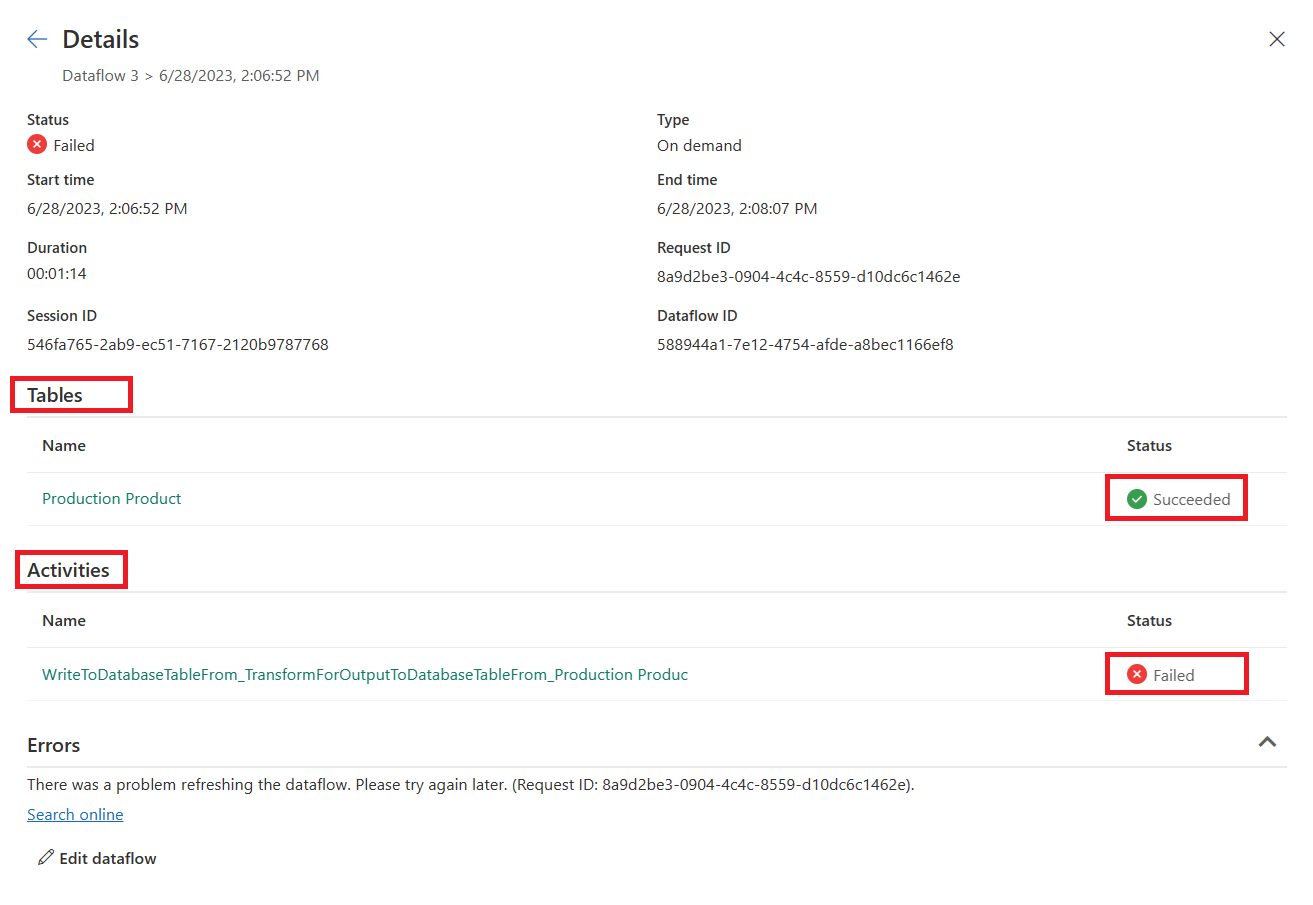

Under den overordnede opdatering af dataflowet kan opdatering af tabeller vises som "Lykkedes", men aktivitetsafsnittet vises som "Mislykket". Fejldetaljerne for aktiviteten WriteToDatabaseTableFrom_... angiver følgende fejl:

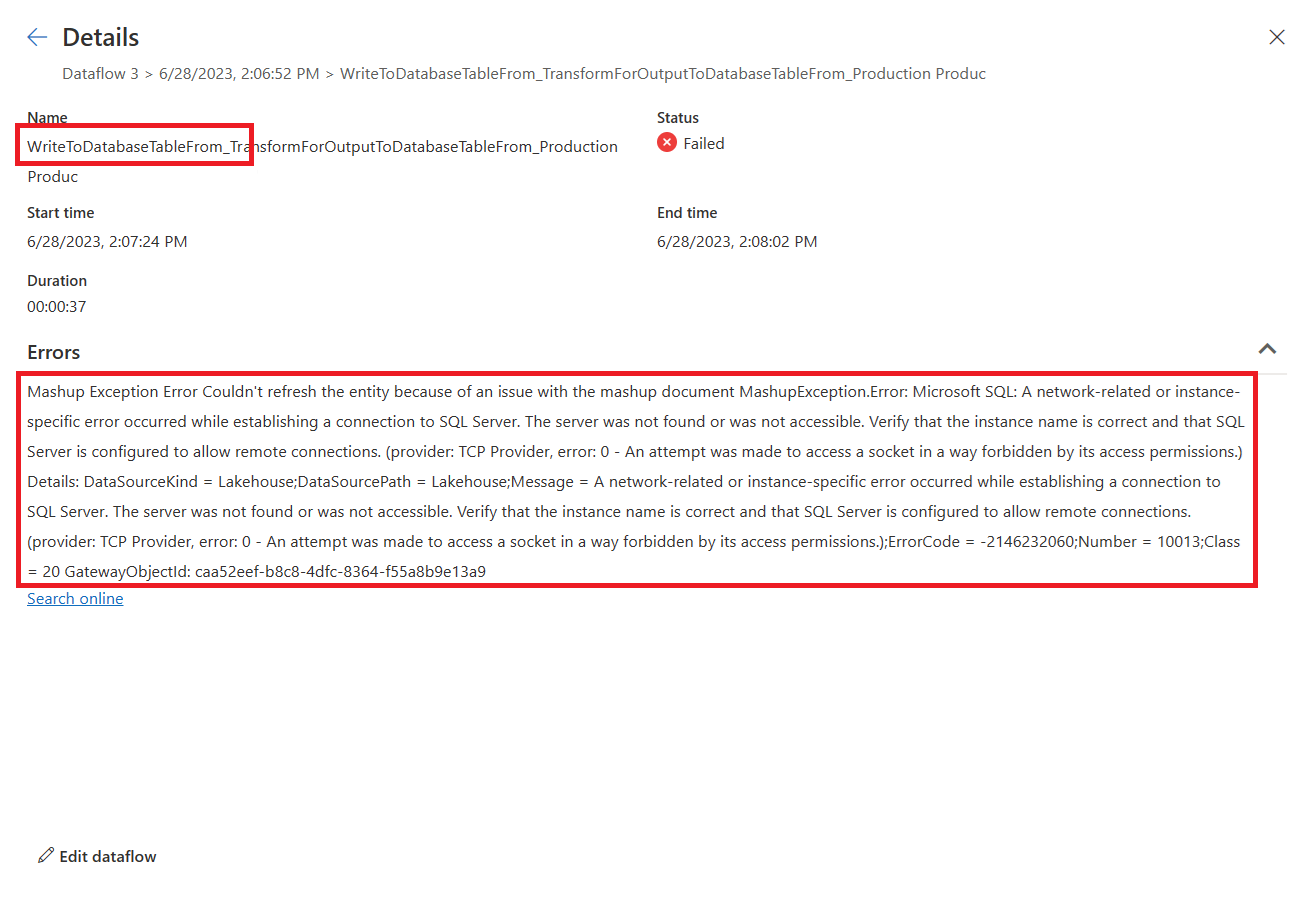

Mashup Exception Error: Couldn't refresh the entity because of an issue with the mashup document MashupException.Error: Microsoft SQL: A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.) Details: DataSourceKind = Lakehouse;DataSourcePath = Lakehouse;Message = A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.);ErrorCode = -2146232060;Number = 10013

Bemærk

Fra et arkitektonisk perspektiv bruger dataflowprogrammet et udgående HTTPS-slutpunkt (port 443) til at skrive data til et Lakehouse. Læsning af data fra Lakehouse kræver dog brug af TDS-protokollen (TCP over port 1433). Denne protokol bruges til at kopiere dataene fra det midlertidige lakehouse til datadestinationen. Dette forklarer, hvorfor trinnet Indlæsning af tabeller lykkes, mens datadestinationsaktiviteten mislykkes, selvom begge lakehouses er i den samme OneLake-forekomst.

Fejlfinding

Følg disse trin for at foretage fejlfinding af problemet:

Bekræft, at dataflowet er konfigureret med en datadestination.

Kontrollér, at opdateringen af dataflowet mislykkes, og at opdatering af tabeller vises som "Lykkedes" , og at aktiviteter vises som "Mislykkedes".

Gennemse fejldetaljerne for Activity

WriteToDatabaseTableFrom_..., som indeholder oplysninger om den registrerede fejl.

Løsning: Angiv nye firewallregler på den server, der kører gatewayen

Firewallreglerne på gatewayserveren og/eller kundens proxyservere skal opdateres for at tillade udgående trafik fra gatewayserveren til nedenstående slutpunkter. Hvis din firewall ikke understøtter jokertegn, skal du bruge IP-adresserne fra Azure IP Ranges og Service Tags. De skal holdes synkroniseret hver måned.

- Protokol: TCP

- Slutpunkter: *.datawarehouse.pbidedicated.windows.net, *.datawarehouse.fabric.microsoft.com, *.dfs.fabric.microsoft.com

- Port: 1433

Bemærk

I visse scenarier, især når kapaciteten er placeret i et område, der ikke er tættest på gatewayen, kan det være nødvendigt at konfigurere firewallen til at give adgang til flere slutpunkter (*cloudapp.azure.com). Denne justering er påkrævet for at imødekomme omdirigeringer, der kan forekomme under disse betingelser. Hvis den trafik, der er bestemt til *.cloudapp.azure.com ikke opfanges af reglen, kan du alternativt tillade IP-adresserne for dit dataområde i din firewall.

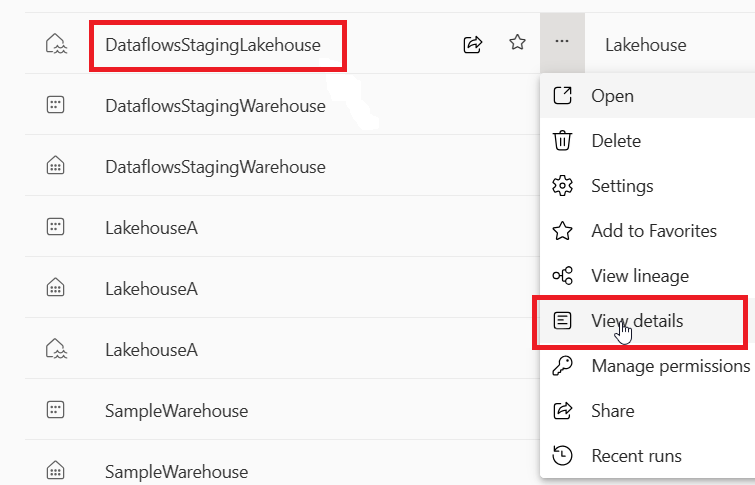

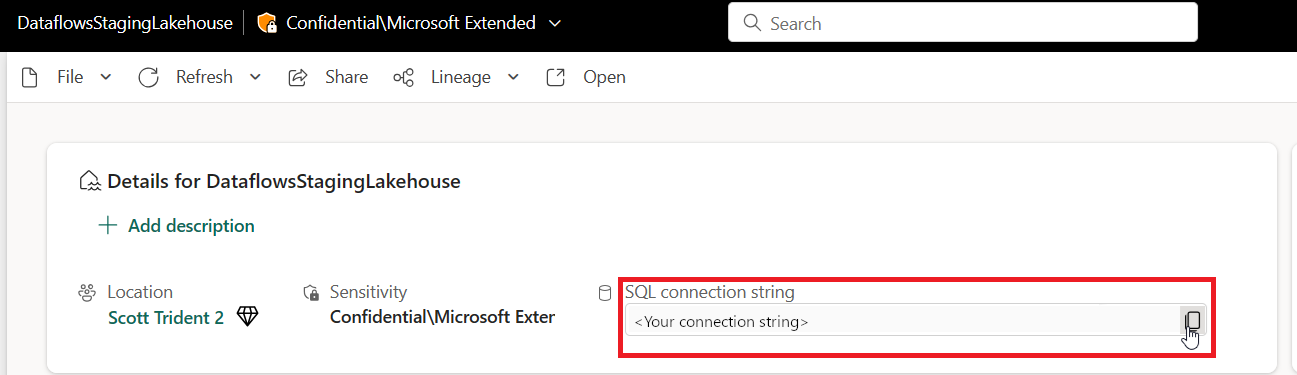

Hvis du vil begrænse omfanget af slutpunktet til den faktiske OneLake-forekomst i et arbejdsområde (i stedet for jokertegnet *.datawarehouse.pbidedicated.windows.net), kan du finde denne URL-adresse ved at gå til arbejdsområdet Fabric, finde DataflowsStagingLakehouseog vælge Vis detaljer. Kopiér og indsæt derefter SQL-forbindelsesstreng.

Hele slutpunktnavnet ligner følgende eksempel:

x6eps4xrq2xudenlfv6naeo3i4-l27nd6wdk4oephe4gz4j7mdzka.datawarehouse.pbidedicated.windows.net

Løsning: Opdel dataflow i en separat indfødning og indlæs dataflow

Hvis du ikke kan opdatere firewallreglerne, kan du opdele dataflowet i to separate dataflow. Det første dataflow er ansvarligt for at indtage dataene i det midlertidige lakehouse. Det andet dataflow er ansvarligt for at indlæse dataene fra det midlertidige lakehouse til datadestinationen. Denne løsning er ikke ideel, da den kræver brug af to separate dataflow, men den kan bruges som en midlertidig løsning, indtil firewallreglerne kan opdateres.

Følg disse trin for at implementere denne løsning:

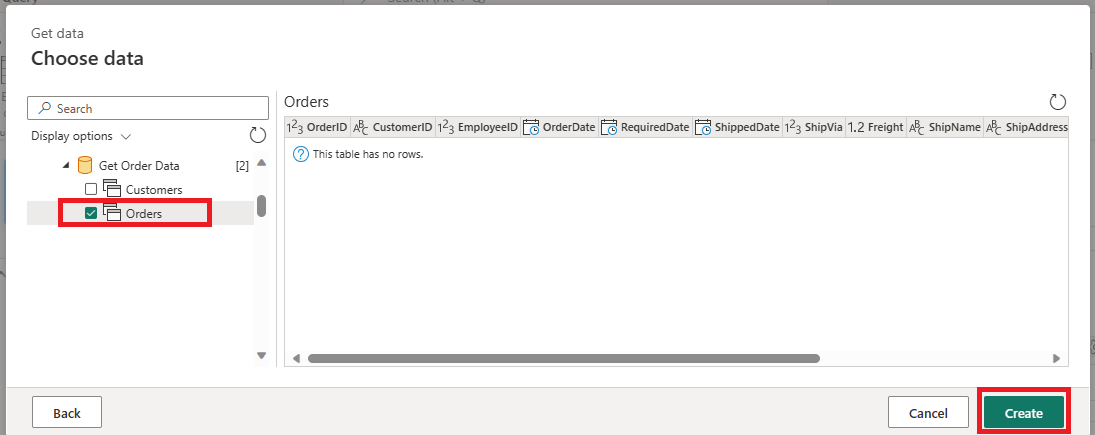

Fjern datadestinationen fra dit aktuelle dataflow, der henter data via din gateway.

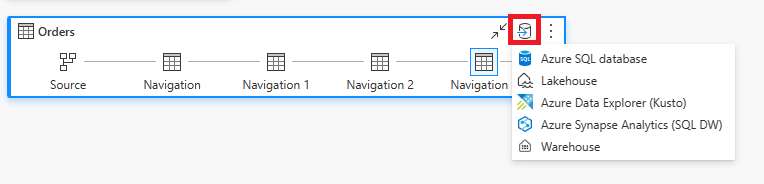

Opret et nyt dataflow, der bruger dataflowconnectoren til at oprette forbindelse til det indtagne dataflow. Dette dataflow er ansvarligt for at indtage dataene fra midlertidig lagring til datadestinationen.

Angiv datadestinationen som den datadestination, du vælger for dette nye dataflow.

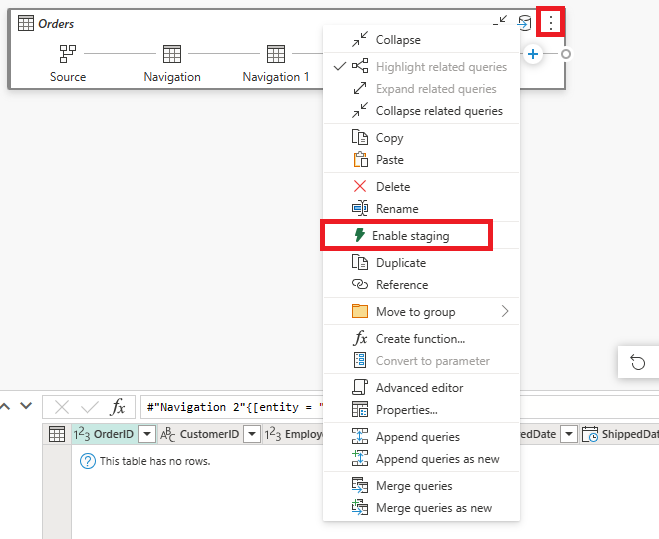

Du kan eventuelt deaktivere midlertidig lagring for dette nye dataflow. Denne ændring forhindrer, at dataene kopieres til det midlertidige lakehouse igen og kopierer i stedet dataene direkte fra det indtagne dataflow til datadestinationen.