Muligheder for at hente data ind i Fabric Lakehouse

Hent data-oplevelsen dækker alle brugerscenarier for at hente data ind i lakehouse, f.eks.:

- Opretter forbindelse til eksisterende SQL Server og kopierer data til Delta-tabellen i lakehouse.

- Overfører filer fra computeren.

- Kopierer og fletter flere tabeller fra andre lakehouses til en ny Delta-tabel.

- Oprettelse af forbindelse til en streamingkilde til landdata i et lakehouse.

- Referer til data uden at kopiere dem fra andre interne lakehouses eller eksterne kilder.

Forskellige måder at indlæse data på i et lakehouse

I Microsoft Fabric er der et par måder, hvorpå du kan hente data ind i et lakehouse:

- Filoverførsel fra lokal computer

- Kør et kopiværktøj i pipelines

- Konfigurer et dataflow

- Apache Spark-biblioteker i notesbogkode

- Stream-hændelser i realtid med Eventstream

- Hent data fra Eventhouse

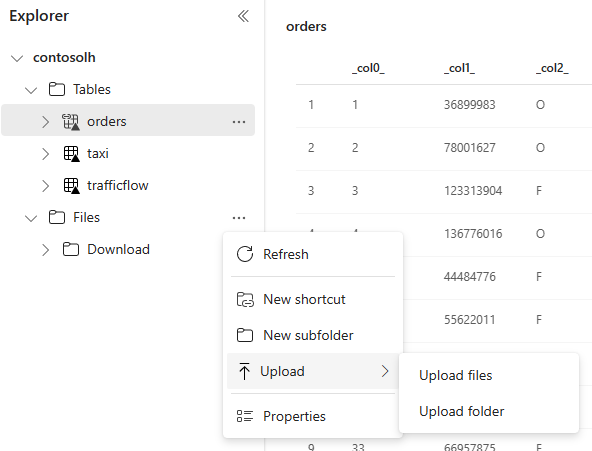

Overførsel af lokal fil

Du kan også uploade data, der er gemt på din lokale computer. Du kan gøre det direkte i Lakehouse explorer.

Kopiér værktøj i pipelines

Kopiér-værktøjet er en yderst skalerbar dataintegrationsløsning, der giver dig mulighed for at oprette forbindelse til forskellige datakilder og indlæse dataene enten i det oprindelige format eller konvertere dem til en Delta-tabel. Kopiér værktøj er en del af pipelineaktiviteter, som du kan ændre på flere måder, f.eks. planlægning eller udløsning baseret på en hændelse. Du kan få flere oplysninger under Sådan kopierer du data ved hjælp af kopieringsaktivitet.

Dataflows

For brugere, der kender Power BI-dataflow, er det samme værktøj tilgængeligt til indlæsning af data i dit lakehouse. Du kan hurtigt få adgang til den fra Lakehouse-stifinderindstillingen "Hent data" og indlæse data fra mere end 200 connectors. Du kan få flere oplysninger under Hurtig start: Opret dit første dataflow for at hente og transformere data.

Notesbogkode

Du kan bruge tilgængelige Spark-biblioteker til at oprette direkte forbindelse til en datakilde, indlæse data i en dataramme og derefter gemme dem i et lakehouse. Denne metode er den mest åbne måde at indlæse data på i det lakehouse, som brugerkoden administrerer fuldt ud.

Bemærk

Eksterne Delta-tabeller, der er oprettet med Spark-kode, vil ikke være synlige for et SQL Analytics-slutpunkt. Brug genveje i Tabelområde til at gøre eksterne Delta-tabeller synlige for et SQL Analytics-slutpunkt. Du kan få mere at vide om, hvordan du opretter en genvej, under Opret en genvej til filer eller tabeller.

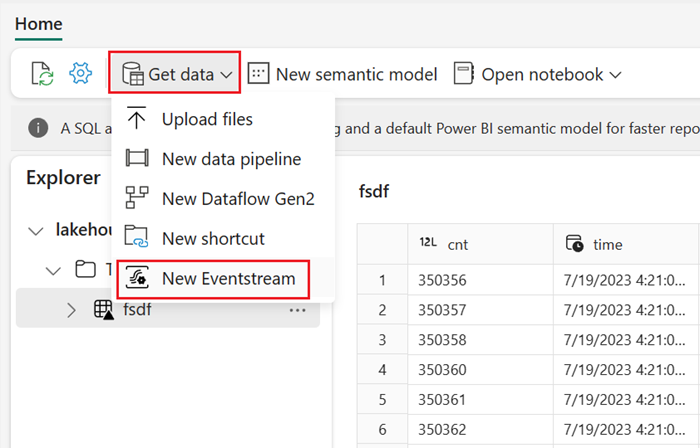

Stream-hændelser i realtid med Eventstream

Med Eventstream kan du hente, behandle og distribuere store mængder hændelser i realtid fra en lang række kilder.

Hvis du vil se, hvordan du tilføjer lakehouse som destination for Eventstream, skal du se Hent data fra Eventstream i et lakehouse.

For at opnå optimal streamingydeevne kan du streame data fra Eventstream til et Eventhouse og derefter aktivere OneLake-tilgængelighed.

Hent data fra Eventhouse

Når du aktiverer OneLake-tilgængelighed for data i et Eventhouse, oprettes der en Delta-tabel i OneLake. En lakehouse kan få adgang til denne Delta-tabel ved hjælp af en genvej. Du kan få flere oplysninger under OneLake-genveje. Du kan få flere oplysninger under Tilgængelighed af Eventhouse OneLake.

Overvejelser ved valg af tilgang til indlæsning af data

| Use case | Anbefaling |

|---|---|

| Overførsel af små filer fra lokal computer | Brug lokal filoverførsel |

| Små data eller en bestemt connector | Brug dataflow |

| Stor datakilde | Brug kopiværktøjet i pipelines |

| Komplekse datatransformationer | Brug notesbogkode |

| Streamingdata | Brug Eventstream til at streame data til Eventhouse. aktivér OneLake-tilgængelighed, og opret en genvej fra Lakehouse |

| Tidsseriedata | Hent data fra Eventhouse |

Relateret indhold

- Udforsk dataene i dit lakehouse med en notesbog

- Hurtig start: Opret din første pipeline for at kopiere data

- Sådan kopierer du data ved hjælp af kopiaktivitet

- Flyt data fra Azure SQL DB til Lakehouse via kopiassistent

- Føj en lakehouse-destination til en eventstream

- Tilgængelighed af Eventhouse OneLake